基于Transformer网络的气胸图像分类方法*

2022-11-10王剑,樊敏

王 剑,樊 敏

(山西医科大学汾阳学院,山西 汾阳 032200)

0 引言

伴随着卷积网络的不断发展,卷积网络在医学领域得到了广泛的应用,在气胸分类方面取得了较好的分类结果。其中2017年NIH[2]的研究人员使用自然语言处理的方法构建了一个医学图像数据集,并命名为Chest X-ray 14,该团队使用在ImageNet 上预训练好的深度学习框架在该数据集上完成气胸分类的训练,最终获得了80.6%的AUC 分数。Jun[3]等提出了一种基于CNN 网络的集成框架来诊断正常X 射线照片和含有气胸的X 射线照片,该方法使用了不同的数据分辨率进行网络的训练,使得最后获得了91.1%的AUC分数。该实验使用的是NIH 胸部数据集,正常胸片样本和气胸样本之间存在着较大的数据不平衡问题。吴恩达[4]团队利用CheXNet 网络在Chest X-Ray 14数据集上进行了训练,其模型在肺炎诊断中表现优异,但是在气胸分类上的AUC 值只有88.7%。Sze[5]等提出了一种基于CheXNet 网络的气胸检测模型,利用二元交叉熵损失函数解决数据不平衡的问题,最终在包含7 个气胸数据集以及195 个正常胸片的测试集上达到了70.8%的AUC 分数。Park[6]等基于预训练的YOLO Darknet-19网络,采用SGD优化器在气胸数据集上进行微调,并且保持输入分辨率为1024×1024。经过训练在内部测试数据集上的AUC 分数为98.4%。Geva[7]等基于纹理分析技术和监督学习技术,提出了一种面向胸部X 射线照片自动诊断气胸的专用框架。该框架使用了局部二值模式(LBP)和最大响应滤波器(MR)算法,并且使用AdaBoost 分类器和KNN 分类器进行训练,最终在含有108 例病例,其中48 例为气胸病例的本地数据集上获得了81%的敏感性和87%的特异性值。

VisionTransformer 网络是由Transformer 网络发展而来的,目前VIT 网络在图像处理的各个领域包括分类、检测、分割中都展现出了较好的性能,本文将基于Transformer网络完成气胸图像的分类任务。

1 数据集介绍

1.1 Chestx-ray 14数据集

Chest X-ray 14 数据集含有12 万张分辨率为1024×1024 的图像,数据的格式为png。该数据集包含有3 万例病例信息,由专业的医生对14 种常见的肺部疾病进行筛选和标注,筛选之后气胸数据集为5298张,其他疾病数据为28774 张,正常图像为60412 张,其准确率超过了90%。

1.2 CheXpert数据集

CheXpert 数据集包含了2002 年10 月到2017 年7月之间,斯坦福医院的22万张胸片数据。该数据来自65240 个就医者,该数据集被标记为14 个标签,其中12 个为常见的肺部疾病,另外两个,一个是健康标签,一个是辅助设备标签。其中气胸数据为17313 张,非气胸数据为167665张。

CheXpert 数据集与Chest X-ray 14 集最大不同点在于,CheXpert 数据集含有侧体位胸片,但是侧体位胸片一般是用来做辅助分析的,而不直接用于疾病诊断。因此当我们使用图像做气胸分类任务时,只选择正位胸片即可。

1.3 MIMIC-CXR-JPG数据集

MIMIC-CXR 数据集是由斯坦福大学发布的,该原始数据集中包含了65379 例就诊者的胸片,共计377110张胸部X光片。该数据集也有14个标签,每张图片被标记为,阳性、阴性或不确定。MIMIC-CXRJPG数据集是由原始数据集转换为JPG格式的数据集,共计222750张数据集,其中气胸数据集为9317张。该数据集和CheXpert数据集一样,也存在侧体位胸片。

2 图像增强

由于医学图像数据采集的特殊性,医学图像往往样本数量偏少并且图像质量参差不齐,然而数据集的多少以及图像质量的高低对深度学习起着至关重要的作用。针对图像质量,本文通过对四种常用的图像增强技术进行实验,最终选用了效果较好的直方图均衡化方法,实验证明利用该方法对气胸数据进行处理可以提高气胸分类的结果。

4.外归因思想。十年间,很多协解人员思想和行为在现实自愿和心理非自愿的情况下长期交互游离。协解人员普遍将矛头指向油田和各二级单位,将协解问题归因于政策不合理、执行欠公正、人情太冷漠、命运多坎坷等外部因素,而很少在自我的性格特征、主观思想、行为习惯上找根源。如有些人协解前工作不勤奋、规章不遵守、人际不协调;有些人协解时总想获自由闯事业,贪图大额补偿,躲避工作压力。但是真正到协解后又开始创业嫌艰难、择业怨机遇、再就业挑岗位讲待遇,所以总是将自己困在一个周而复始的消极循环里,造成工作生活中的挫败感、自卑感和不愉悦感。

2.1 直方图均衡化(HE)

直方图均衡化(HE)技术[8]是图像处理中常用的图像增强技术,高对比度的图像具有近似均匀分布的直方图,即每个灰色级别都有相同的概率出现。为了创建更均匀分布的直方图,可以对较暗的图像区域进行灰度的重新分布,这可以使图像更加清晰。假设一幅图像M×N 的灰度值在[0,L]范围内,那么它的直方图计算公式如下:

其中,rk的取值范围为[0,L],代表像素的灰度值,nk表示该灰度值所包含的像素个数。M×N 代表图像的总像素个数,p(rk) 即概率论中所说的频率。在直角坐标系中画出rk与p(rk) 的关系图形,即为直方图。

2.2 图像反转

图像反转是图像处理中常用的图像增强技术之一,在二进制的图像中,像素值由0变为1,由1变为0,图像会黑白反转。对于8Bite 的灰度图像,则会使用255 减去原始像素,得到的差值为新图像的像素值。对于X 光图像,该操作会使暗点变亮,亮点变暗,具体计算公式如下:

其中,x和y是原始图像和转换后的图像像素值。通过该操作,胸片中的感兴趣区域(肺部区域)会变得更亮,骨骼会更暗。在临床中,该方法得到了放射科医生的青睐。

2.3 平衡对比度增强技术(BCET)

平衡对比度增强技术(BCET)[9]可以在不改变图像数据直方图模式的情况下拉伸或压缩图像的对比度。该方法的解是基于从图像数据中获取的抛物线函数,具体公式如下:

其中,y表示最终的输出图像,x表示输入图像。该抛物线包含三个系数a,b和c,该系数由输入和输出图像的最小值和最大值获得。具体公式如下:

其中,l表示输入图像的最小值,h表示输入图像的最大值,e表示输入图像的平均值,L表示输出图像的最小值,H表示输出图像的最大值,E表示输出图像的平均值,s为图像的均方和。

2.4 Gamma校正

摄像设备在获取图像的过程中,会对图像产生非线性转化。公式如下:

其中,g(u)为变化后的像素值,r即Gamma 值,可见该变化会对图像造成非线性的影像。理想状态下,即如果知道r的值,那么就可以进行还原其真实值,具体公式如下:

当r值大于1 时,图像的整体亮度会下降,图片会变暗,原因是图像的灰度级经过变换后整体向低灰度级延展。当r值小于1时,经过变换后的图像整体亮度会上升,图像会变亮,原因是图像经过变换后灰度级整体向高灰度级延展。Gamma 校正的效果如图1 所示。当r值小于1 时,图像亮度会增强,图像整体效果会变白。当r值大于1 时,图像亮度会减弱,图像整体效果会变暗。

图1 r参数值对图像增强效果的对比

如图2 所示,将原始气胸图像分别利用直方图均衡化、图像反转、BCET、gamma 校正进行处理后,可以看出直方图均衡化操作要好于图像反转、ECET 方法及Gamma 校正,更能突出气胸病兆的区域特征,所以本文选取了直方图均衡化操作作为图像增强的方法。

图2

3 模型方法

基于VIT 网络的气胸图像分类框架如图3 所示,首先从Chestx-ray 14 数据集、CheXpert 数据集和MIMIC-CXR 数据集中随机抽取气胸样例,经过筛选剔除侧位胸片,最终获得2万张气胸数据,为了使数据集保存平衡,从非气胸数据集中以1:1的比例抽取2万张非气胸数据集,然后调整图像大小、并使用直方图均衡化方法进行图像增强,最后经过图像切块即可输入到VIT 网络当中,VIT 网络选用VIT-L/16 版本,将MLP 模块中的网络进行修改,最后一层网络改为二分类网络即可。

图3 基于Transformer网络的气胸分类框架

4 实验及结果

4.1 实验细节

将所选的4万张图像进行分类标记,并进行划分,具体的94%的数据集为训练集,3%的数据集为验证集,3%的数据集为测试集,梯度优化采用SGD 优化器,损失函数使用交叉熵函数,学习速率设置为0.001,设置批量大小为24,epoch为30,使用ImageNet数据集的预训练权重进行初始化。

4.2 评价指标

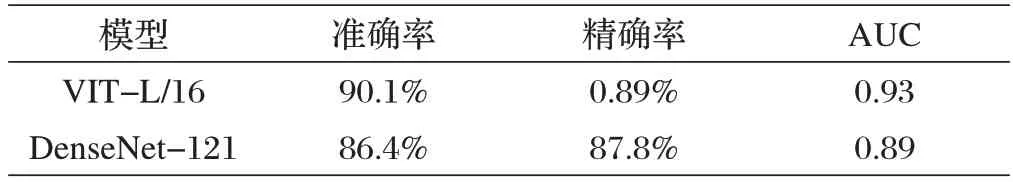

图像分类的评价指标很多,但是对于医学图像分类辅助诊断的问题,分类模型的准确率、精确率及AUC 值起着最为重要的作用。因此本文选择准确率和精确率作为评价所提模型的指标。

准确率定义为正确识别的正样本和负样本占总样本的比例。公式如下:

精确率是所有正确识别的正样本与所有网络认为是正样本的比率,公式如下:

AUC 值为ROC 曲线下的面积,作为评估指标,AUC 值越大,说明模型越好,AUC 值更加看重正样本的比率。

式⑺、式⑻中,TP 表示正样本中预测为正样本的样本数,TN 表示负样本中预测为负样本的样本数,FP 为负样本中预测为正样本的样本数,FN 为正样本中预测为负样本的样本数。

4.3 实验结果与分析

如图4 所示为VIT 网络的训练集误差、验证集误差与验证集分类准确率,表1 为网络在测试集上的准确率、精确率、AUC值,从表1可以看出,DenseNet-121网络的准确率为86.4%,比VIT 网络低3.6%,其中VIT网络的AUC 值达到了0.93,而DenseNet-121 的AUC值为0.89。由此验证了本文所提方法的有效性。

图4 训练集损失和验证集准确率

表1 测试集气胸分类结果

5 结论

本文充分利用了直方图均衡化进行图像增强改变图像质量以及VisionTransformer网络在特征提取方面的优势,并且为了使模型具有更好的泛化性,从三个开源胸部数据集中选取了训练数据集,同时为了使模型有更好的分类效果,在训练时采用了SGD 优化器,调整了MLP的结构,使用了迁移学习的思想,实验结果表明,所提方法的准确率达到了90.1%,AUC值达到了0.93,优于DenseNet-121 卷积网络,为临床诊断提供了可靠的依据。如何利用Transformer 网络进行多分类任务,将是下一步的研究方向。