微铣削刀具磨损图像的超分辨率重建研究*

2022-11-09朱锟鹏

孙 剑,郭 浩,朱锟鹏

(1.中国科学院合肥物质科学研究院智能机械研究所,合肥 230031;2.中国科学技术大学,合肥 230026)

0 引言

微铣削是一种微量去除工件材料的机械切削加工方式[1]。与传统的铣削方式相比,微铣削使用的刀具直径通常小于1 mm,每齿进给量小,表现出了切削过程的尺寸效应和最小切削厚度等新的切削特性[2]。微铣削的加工机理更加复杂,刀具很容易发生磨损。刀具磨损程度的加重会影响加工精度,造成加工零件质量下降[3]。因此在微铣削加工中监测刀具状态是非常有必要的[4]。

刀具监测方法分为直接监测方法和间接监测方法[5]。基于计算机视觉的直接监测方法通过采集加工过程中的刀具磨损图像对磨损状态进行监测,受到加工状况变化的影响小,刀具磨损程度的监测精度高,克服了间接监测方法中存在的不足[6]。直接监测方法中对采集图像分辨率不高导致刀具分割结果不理想的情况,几乎都是在刀具磨损图像的获取方式上对方法进行改进的,这不仅增加了硬件设计的复杂性,也提高了设计成本。高分辨率的刀具磨损图像难以采集是阻碍计算机视觉方法在刀具磨损状态监测中进行应用的主要原因[7]。

基于单幅图像的超分辨率重建(single image super-resolution,SISR)方法在高低分辨率图像的像素间建立确定的内在关系,并以该内在关系对图像重建过程施加规范性的约束,可以将低分辨率的刀具磨损图像重建为高分辨率的图像[8]。SISR算法主要分为3类,分别基于插值、建模和学习。基于学习的方法比基于插值和建模的方法获得了更好的图像重建质量[9]。

随着深度学习的发展,它作为一种基于学习方法的分支被广泛应用在超分辨率重建领域中。SRCNN模型[10]首次将深度学习应用在图像超分辨率重建领域,解决了浅层学习需要人工提取特征的问题,模型表达能力更好。VDSR模型[11]采用残差学习加深了网络深度,可以获得更大的感受野。FRCNN模型[12]对卷积层通道数进行收缩,使用更小的卷积核但可以增加更多的非线性映射层。SRGAN模型[13]提出了生成对抗的模型结构,可以保留图像更多的高频细节。目前在刀具磨损图像领域内的超分辨率重建研究很少,由于刀具磨损图像之间具有很大的相似性,通过深度学习的方法进行重建可以利用不同刀具磨损图像之间的共同特征,故本文基于深度学习的超分辨率重建方法对微铣削刀具磨损图像进行超分辨率重建研究。

1 超分辨率重建模型介绍

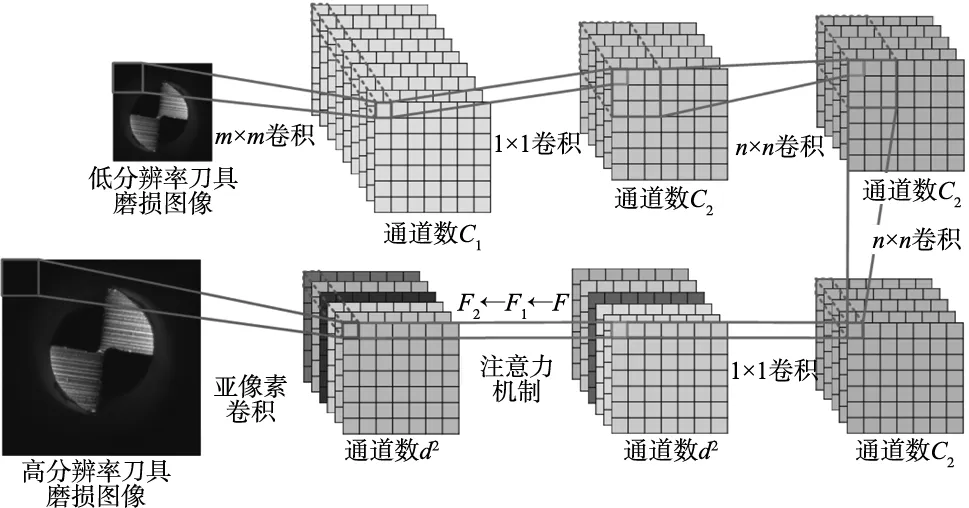

本文提出模型为注意力亚像素超分辨率卷积神经网络(attention subpixel super-resolution convolutional neural network,AS-SRCNN),模型结构如图1所示。特征提取层先由m×m卷积核提取多通道特征图,利用1×1卷积核收缩特征维数,由n×n卷积核实现两个非线性映射层增加网络深度,再利用1×1卷积核改变特征维数生成上采样特征图。特征提取层后应用注意力机制依次计算上采样特征图的通道特征权重和空间特征权重,对提取特征进行重新分配。由于采用亚像素卷积方法进行上采样,故需生成重建尺度d的平方个通道的上采样特征图。

图1 刀具磨损图像的超分辨率重建模型

1.1 注意力机制

注意力机制是一种对人类视觉处理图像信号方法的借鉴,当人脑接受到一幅图像时,在扫描完整幅图像后会对感兴趣的区域给予更多的关注,快速获取到需要信息。刀具磨损图像超分辨率重建的目的是要通过重建的高分辨率刀具磨损图像来实现刀具分割,从而能对刀具状态进行更好的监测。故刀具磨损图像重建中模型的感兴趣区域就是刀具区域,刀具区域的特征对于图像重建是更有意义的。AS-SRCNN模型在生成上采样特征图后添加了卷积块注意力模块(convolutional block attention module,CBAM)[14],计算上采样特征图的特征权重后重新作用在上采样特征图上。设注意力机制的输入特征图为F∈RC×H×W,C、W和H分别表示输入特征图的通道数、高度和宽度。

由通道注意力模型和空间注意力模型依次计算出通道权重MC∈RC×1×1和空间权重MS∈R1×H×W。将权重重新作用在输入特征图上,计算过程为:

F1=MC(F)⊗F

(1)

F2=MS(F1)⊗F1

(2)

式中,⊗为对应元素相乘;F1为通道注意力机制调整后的特征图;F2为空间注意力机制调整后的特征图。

1.1.1 通道注意力

图2 通道注意力机制

(3)

式中,σ为sigmoid函数;Conv1和Conv2为两个卷积核为1×1的卷积操作;R为Relu激活函数。Conv1输出的通道数为1,Conv2输出的通道数为C。双卷积层的输出即为通道权重值。

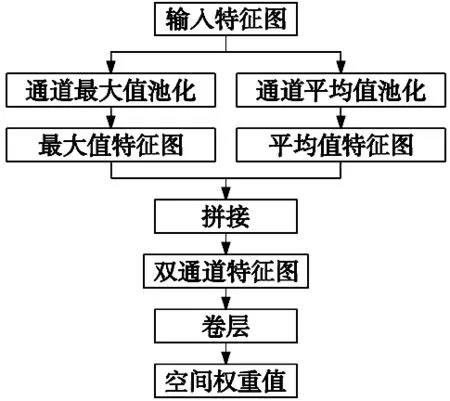

1.1.2 空间注意力

(4)

式中,f7×7为卷积核大小为7×7的卷积操作。

图3 空间注意力机制

1.2 亚像素卷积

为将一张低分辨率的刀具磨损图像恢复成一张高分辨率的刀具磨损图像,深度学习模型提取图像特征图后需对其进行上采样生成高分辨率图像。常用的上采样方法为反卷积[15]和亚像素卷积。

图4 亚像素卷积上采样

一幅图像是由许多个像素点组成的,而每个像素也可以由更小的元素组成,这些元素称为亚像素。亚像素在实际中不能直接被检测出来,但在神经网络中可以通过映射的方式将其表示出来。如图4所示是一个2倍上采样的亚像素卷积过程。对于一幅需要上采样d倍的图像,先通过模型的学习自动生成d2个与低分辨率图像相同大小的特征图,然后将这d2个通道的特征图中相同位置的像素按照一定的顺序填充至上采样图像中对应的d×d区域。特征图上的像素就相当于是上采样图像的亚像素。在亚像素卷积的过程中通过不断调整d2个通道的权重优化生成的高分辨率图像。

2 实验与分析

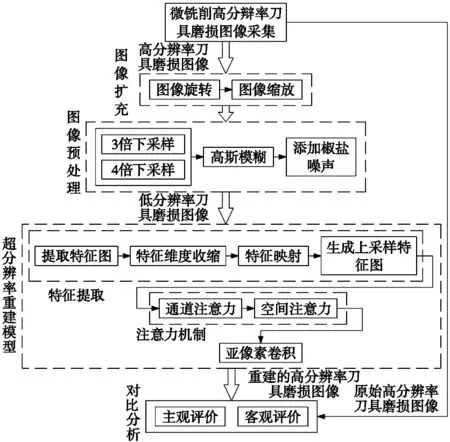

2.1 实验设计

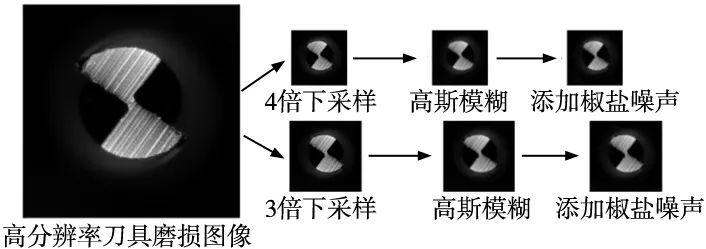

本文实验路线如图5所示。在微铣削加工中通过显微相机拍摄高分辨率的刀具磨损图像作为标签,并选择3倍和4倍两个尺度进行超分辨率重建。图像扩充后对刀具磨损图像进行预处理生成待重建的低分辨率图像。刀具在整幅图像中只占据了部分区域,而背景是重复且特征单一的区域。为了更好地提取刀具区域特征,通过特征提取层生成上采样需要的特征图后,由注意力机制对提取特征进行调整。最后通过亚像素卷积上采样来完成重建,并将重建图像与标签图像进行对比。

图5 微铣削刀具磨损图像的超分辨率重建

2.2 刀具磨损图像数据集

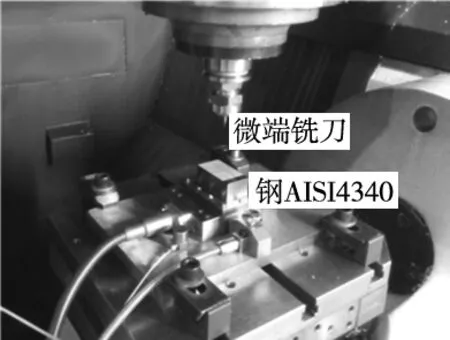

图6 微铣削实验

实验加工平台为HSM600U高速加工机床。采用日本佑能生产的同一批次两刃硬质合金微端铣刀进行微铣削实验,可以避免刀具品质对实验造成的影响。加工材料为钢AISI4340。图6为机床内微铣削实验。每使用铣刀在钢上铣削一个30 mm长的槽后便从加工台上取下刀具,并使用显微相机拍摄一张高分辨率的刀具磨损图像。

训练集选取了11把刀具142张不同磨损程度的刀具图像,测试集为同1把刀具11张不同磨损程度的刀具图像。对训练集进行数据扩充,按照0.6、0.8、1.2、1.4共4个比例进行图像缩放,并按照90°、180°、270°共3个角度旋转图像。由于在机床内直接拍摄刀具磨损图像时受到光照以及粉尘等因素的影响,会造成获取图像亮度不均匀的现象,故对图像进行高斯模糊处理。在图像传输的过程中,受到传感器自身、信号传输、图像解码等影响会产生黑白相间的亮暗点,所以对刀具磨损图像添加了椒盐噪声。数据预处理如图7所示,依次完成图像下采样、高斯模糊和添加椒盐噪声。

图7 刀具磨损图像预处理

2.3 模型参数选择

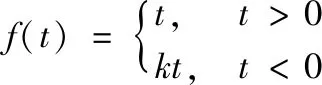

本文实验在Windows10操作系统下完成,支撑软件平台为PyCharm(Python3.6.0),使用的深度学习框架为pytorch。特征提取层中卷积层采用的激活函数均为PReLU,函数定义为:

(5)

参数k在模型中对于不同的通道单独进行学习。PReLU函数中没有指数操作运算比较简单,线性以及非饱和的函数特点使得模型能够快速收敛,可以有效缓解梯度消失问题。优化器设置为Adam,能够适应计算机视觉深度模型中的稀疏梯度问题,同时也能缓解梯度震荡的问题。经实验证明,特征提取层的参数为m=5、n=3、C1=100和C2=12时模型的重建结果最好。

2.4 实验结果与分析

超分辨率重建的评价指标结合主观评价和客观评价两个角度,衡量模型重建的高分辨率刀具磨损图像与作为标签的高分辨率刀具磨损图像之间的差异。并且本文将AS-SRCNN方法与双三次插值[16]、迭代反投影法[17]以及两种深度学习模型SRCNN[10]和FSRCNN[12]进行了对比。

2.4.1 主观评价

图8 刀具磨损图像4倍超分辨率重建结果

主观评价直接通过人眼观察图像之间的差异,尺度为4时刀具磨损图像的超分辨率重建结果如图8所示。双三次插值重建方法使得刀具磨损图像中刀具边缘部分变得模糊,这是由于该方法是人工设计插值公式,当刀具边缘位置相邻像素点的灰度值发生突变时,会丢失图像部分区域的高频信息。并且双三次插值没有去除掉椒盐噪声。迭代反投影法对刀具磨损图像进行了去噪,重建出的刀具磨损图像中椒盐噪声较少,但刀具的边缘位置也不够清晰。通过图8中深度学习方法与双三次插值和迭代反投影法重建结果的对比,可以看出深度学习方法保留了刀具磨损图像中更多刀具边缘的细节特征,刀具边缘更加清晰,椒盐噪声也得到有效去除。

图9 重建模型中两种不同的上采样结果

FSRCNN方法中采用反卷积进行上采样,而AS-SRCNN方法是采用亚像素卷积进行上采样。图9显示了采用两种不同上采样方法超分辨率重建后,刀具磨损图像部分区域放大的对比。反卷积上采样的方法产生了很明显的混叠现象,这是由于当反卷积核的大小无法被设置的步长整除时,也就是上采样不均匀时,重建的图像会产生棋盘效应。同时,反卷积的实现在对卷积核矩阵重新排列时需要进行大量的零填充操作,这些新添加的区域是无效的信息,并且不利于神经网络训练时梯度的优化,上采样的速度慢。故本文最终选择亚像素卷积进行上采样。

2.4.2 客观评价

客观评价指标选择的是峰值信噪比PSNR(peak signal-to-noise ratio)和结构相似性SSIM(structural similarity)。

PSNR是计算均方误差相对于信号最大值平方的对数值,单位为分贝(dB),峰值信噪比的值越大则代表超分辨率模型重建处理后的图像的失真越小。PSNR实验结果如表1所示。为方便展示实验数据,在测试集11张刀具磨损图像中,除去1张新刀具图像,按照采集顺序将前3张作为磨损初期图像,中间4张作为磨损中期图像,后3张作为磨损后期图像。

表1 刀具不同磨损程度图像3/4倍重建PSNR (dB)

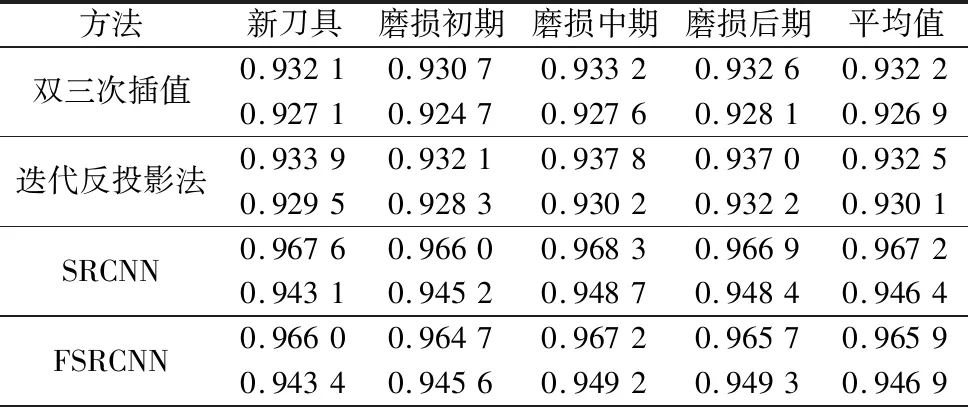

SSIM由亮度对比、对比度对比和结构对比三部分组成,SSIM值越接近1,表示两幅图像越相似。SSIM实验结果如表2所示。

表2 刀具不同磨损程度图像3/4倍重建SSIM

续表

从PSNR和SSIM的结果可以看出,基于深度学习的重建方法与双三次插值和迭代反投影法相比,客观评价指标取得了很大提升。表3中展示了SRCNN、FSRCNN和AS-SRCNN的网络结构对比,Conv和DeConv分别表示卷积和反卷积操作,3个参数分别为卷积核大小、输出通道数和输入通道数。AS-SRCNN与SRCNN、FSRCNN相比,网络训练的参数更少,但PSNR和SSIM值更高。

表3 深度学习模型结构对比

对AS-SRCNN中没有添加注意力机制单独进行了实验,并与AS-SRCNN进行了对比。图10、图11给出了两种情况下在测试集11张不同磨损程度刀具图像上的重建表现。注意力机制的使用在刀具磨损图像3倍和4倍两个尺度的超分辨率重建中对PSNR和SSIM两个指标的值都有很大提升。通过注意力机制对上采样特征图进行调整,可以更加关注对重建刀具区域更有用的特征,给模型的图像重建提供更优的特征选择,模型的学习能力更强。

图10 注意力机制对PSNR的优化 图11 注意力机制对SSIM的优化

3 结论

本文提出了一个基于深度学习的单幅图像超分辨率重建方法AS-SRCNN,可以将微铣削加工中采集的低分辨率刀具磨损图像重建为高分辨率的图像。模型先由特征提取层提取出低分辨率刀具磨损图像的特征图,通过注意力机制对其进行特征选择后,再基于亚像素卷积对其进行上采样完成刀具磨损图像重建。实验表明与双三次插值和迭代反投影法两个传统重建方法相比,AS-SRCNN重建的刀具磨损图像中刀具边缘更加清晰。与SRCNN和FSRCNN相比,AS-SRCNN模型参数更少、网络结构更小。并且AS-SRCNN在所有实验方法中取得了最高的PSNR和SSIM指标值。