一种采用Transformer网络的视觉人格识别方法

2022-11-04唐志伟张石清赵小明

唐志伟,张石清,赵小明,

(1.浙江理工大学机械与自动控制学院,浙江 杭州 310018;2.台州学院智能信息处理研究所,浙江 台州 318000)

1456792435@qq.com;tzczsq@163.com;tzxyzxm@163.com

1 引言(Introduction)

自动人格识别技术是指通过计算机等辅助工具,对人们第一印象的行为数据(如听觉、视觉等)进行自动识别的过程。目前心理学中最具影响力的人格评估模型为美国心理学家MCCRAE等提出的大五类(Big-Five)因素模型。该模型包括开放性(Openness,O)、尽责性(Conscientiousness,C)、外向性(Extroversion,E)、宜人性(Agreeableness,A)和神经质(Neuroticism,N),这五个维度代表了人类的人格特征。自动人格识别的研究已成为心理学、计算机科学等相关领域的研究热点。

早期的视觉人格识别方法主要是基于手工设计的视觉人格特征,然后将特征输入支持向量机(Support Vector Machine,SVM)等经典的分类器,用于实现视觉人格识别。在面向动态视频序列的手工视觉人格特征中,动态视频序列是由一系列视频图像帧组成,包含了时间信息和场景动态。面向三个正交平面的局部Gabor二值模式(Local Gabor Binary Patterns from Three Orthogonal Planes,LGBPTOP)是其中一种代表性的手工动态视频描述符。KAYA等利用18 个Gabor滤波器对动态视频序列人脸图像提取手工特征LGBP-TOP,进一步输入核极限学习机(Kernel Extreme Learning Machine,KELM)中预测大五人格特质。

随着深度学习技术的不断发展,一系列深度学习网络模型被用于识别显著视觉人格特征,包括卷积神经网络(Convolutional Neural Network,CNN)、长短时记忆(Long Short Term Memory,LSTM)网络等。BEYAN等通过采用CNN+LSTM模型学习关键动态图像的空间和时间信息,最后利用SVM分类器实现自动人格识别。现有的视觉人格识别模型忽略了视频序列中每帧图像对人格识别的影响,为了有效利用视频中的视觉信息,本文提出一种基于Transformer的视觉人格识别方法。首先采用预训练好的人脸卷积神经网络模型VGG-Face提取出视频序列中的每帧图像的深度帧级特征,包括视觉场景图像和视觉人脸图像。然后将提取出的两种帧级视觉特征输入到双向长短时记忆网络(Bidirectional Long Short Term Memory Network,Bi-LSTM)和Transformer网络分别进行时间信息和注意力信息的建模。最后,将视觉全局特征级联并输入一个线性回归层网络,融合视觉特征信息,从而实现特征层的视觉大五人格预测得分。在公开数据集ChaLearn First Impressions V2上对所提出的模型进行了评估,实验表明,本文所提出的方法能够有效提升视觉人格识别效果。

2 本文方法(The proposed method)

图1给出了本文提出的一种采用CNN+Bi-LSTM+Transformer的视觉模态人格识别模型框架,该方法采用两种视觉模态信号:全局场景图像信号与局部人脸图像信号,具体包括三个步骤:数据预处理、特征提取和特征层融合,细节如图1所示。

图1 CNN+Bi-LSTM+Transformer模型框架示意图Fig.1 Schematic diagram of CNN+Bi-LSTM+Transformer model framework

2.1 数据预处理

对视频中的视觉图像信号进行采样处理。对于视频中的场景图像,在每个原始视频中等间隔选择100 帧场景图像,并将每帧场景图像的分辨率从原来的1280×720 像素重新采样到224×224 像素,进而输入VGG-Face模型中。视频中的人脸图像采用多任务卷积神经网络(Multi-Task Convolutional Neural Network,MTCNN)进行人脸检测。MTCNN使用三个子网和非极大值抑制(Non-Maximum Suppression,NMS)生成边界框,并将它们组合输出面部区域和关键点。采集的人脸图像分辨率为224×224。针对部分视频受光照等环境影响,导致采用MTCNN方法截取人脸成功率较低,最后选取30 帧截取后的人脸图像用于后续人脸图像特征提取。对于采用MTCNN方法截取人脸图像多余30 帧的视频,进行等间隔选取30 帧人脸图像。对于采用MTCNN方法截取人脸图像少于30 帧的视频,重复插入第一帧和最后一帧的人脸图像,直到获得大小为30 帧的人脸视频。

2.2 特征提取

特征提取是对视频中视觉信号的局部特征和全局特征进行提取。

(1)视觉局部特征提取

对于视频序列中的每帧预处理图像(包括场景图像和人脸图像),使用在ImageNet数据集上预训练好的VGG-Face模型来学习深度视觉场景图像特征和人脸图像特征的高层次特征。VGG-Face网络由13 个卷积层、5 个池化层和2 个全连接层组成。由于VGG-Face网络最后一个全连接层的神经元数为4,096,VGG-Face网络学习到的视觉帧级特征的维度为4,096。

(2)视觉全局特征提取

当完成对视频中视觉局部特征任务之后,需要学习与时间和帧级注意力相关的全局视觉场景特征和视觉人脸图像特征,进一步用于完成面向整个视频序列的人格预测任务。为此,拟采用Bi-LSTM与Transformer网络分别对视频序列中提取的视觉局部特征进行时间与帧级注意力信息的建模。

①Bi-LSTM方法:给定一个视频片段序列e=(,,…,e),时间步长∈[1,],Bi-LSTM由前向传播算法和反向传播算法叠加组成,输出则由这两种算法的隐藏层的状态决定。

给定输入序列e,输入Bi-LSTM网络中,相应的学习过程为

②Transformer方法:如图2所示,采用的Transformer模块包括位置嵌入编码、Transformer编码层及编码层内置的多头注意力机制。

图2 Transformer模型结构示意图Fig.2 Schematic diagram of Transformer model structure

(a)位置嵌入编码:本文采用位置嵌入(Position Embedding)编码方法为输入的语音片段和每帧图像特征添加相应的位置信息。以图像片段特征为例,给定一个片段特征∈R,随机生成一个位置矩阵∈R,位置编码公式如下。

式中,∈[1,] ,∈[1,];位置矩阵P在训练过程中更新;∈R是包含位置信息的片段特征;⊕表示元素相加。

(b)Transformer编码层:该模块由多头自注意力(Multi-Head Self-Attention,MHA)层,残差(Residual)块和层归一化(LayerNorm),一个由两个全连接层和两个GELU(Gaussian Error Linear Unit)激活函数组成的多层感知机(Multi-Layer Perceptron,MLP)网络组成,最后输出一个片段帧注意力特征∈R,计算过程如下。

(c)多头注意力机制:多头注意力机制是自注意力机制的一个变种,最早在自然语言处理领域中用来处理文本序列数据。

2.3 特征层融合

为了有效融合学习到的视觉场景图像特征与视觉人脸图像特征,需要将这两种视觉模态信息进行融合,以实现不同视觉模态的人格识别。本文采用特征层融合方法进行不同视觉信息的融合,并与决策层融合方法进行比较。这两种多模态信息融合方法主要内容如下。

决策层融合被称为后期融合(Late Fusion,LF)。首先对每个模态先进行单独的人格预测,然后通过某种决策规则将各个单模态的预测结果进行结合,并得到最终的融合结果,因此本文对两个视觉模态进行加权决策融合。拟采用XU等提出的均方误差(Mean Squared Error,MSE)最小化的思想,得到了各个模态的最优权重值。

特征层融合被称为早期融合(Early Fusion,EF),是将提取的多种特征直接级联成一个总的特征向量。本文将提取的全局性的视觉场景特征和视觉人脸图像特征级联到一个线性回归层(Linear Regresion Layer),实现大五人格预测。

3 实验(Experiment)

3.1 数据集

实验采用的人格识别数据集为ChaLearn First Impression V2,由YouTube视频中的10,000 个短视频组成,每个视频分辨率为1280×720,时长约15 s,面对摄像机说话的人使用英文。视频所涉及的人具有不同的性别、年龄、种族等,其中6,000 个用于训练,2,000 个用于验证,2,000 个用于测试。因为测试集只对参加竞赛者开放,本文实验只使用训练集和验证集。这些视频剪辑使用大五人格特质进行注释,每个特质都用范围[0,1]之间的值表示。

3.2 实验参数设置

模型在训练过程中,样本的批处理大小(Batch Size)设为32,初始学习率设为1×e,每一个轮次(Epoch)后都会变为原来的一半。最大循环次数设为30,使用自适应矩估计(Adaptive Moment Estimatio,Adam)优化器进行优化,采用均方误差损失函数(Mean Squared Error Loss,MSEloss),实验平台为显存24 GB的NVIDIA GPU Quadro M6000。

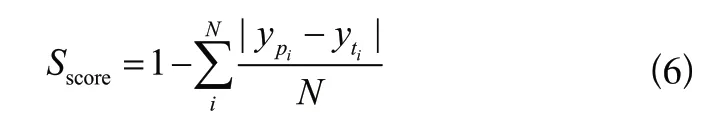

本文使用如下公式作为评价指标用来评估预测的人格特质分数:

3.3 实验结果及分析

(1)消融实验

本文模型主要由Bi-LSTM和Transformer模块组成,在第一印象数据集上进行三组实验,验证各模块的有效性。

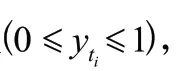

表1为消融实验结果。如表1所示Bi-LSTM模型在ChaLearn First Impression V2人格数据集中的大五人格平均分数为0.9136,而Transformer模型在人格数据集取得的大五人格平均分数为0.9022,Bi-LSTM表现更好,可知Bi-LSTM模型学习的时间维度特征比Tansformer模型学习的帧注意力特征更重要。Transformer与Bi-LSTM相结合后的模型BL+Tran取得了最好的分数。这说明Transformer学习到的帧注意力特征与Bi-LSTM学习到的时间维度特征存在互补性,两者相结合能够明显提升多模态人格识别性能。

表1 消融实验对比结果Tab.1 Comparison results of ablation experiments

(2)单视觉模态人格识别结果及分析

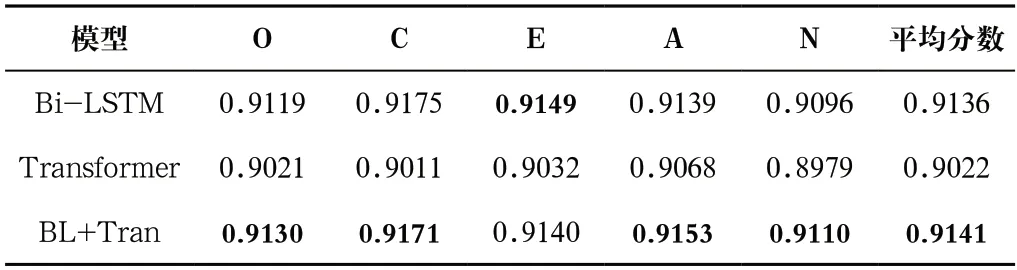

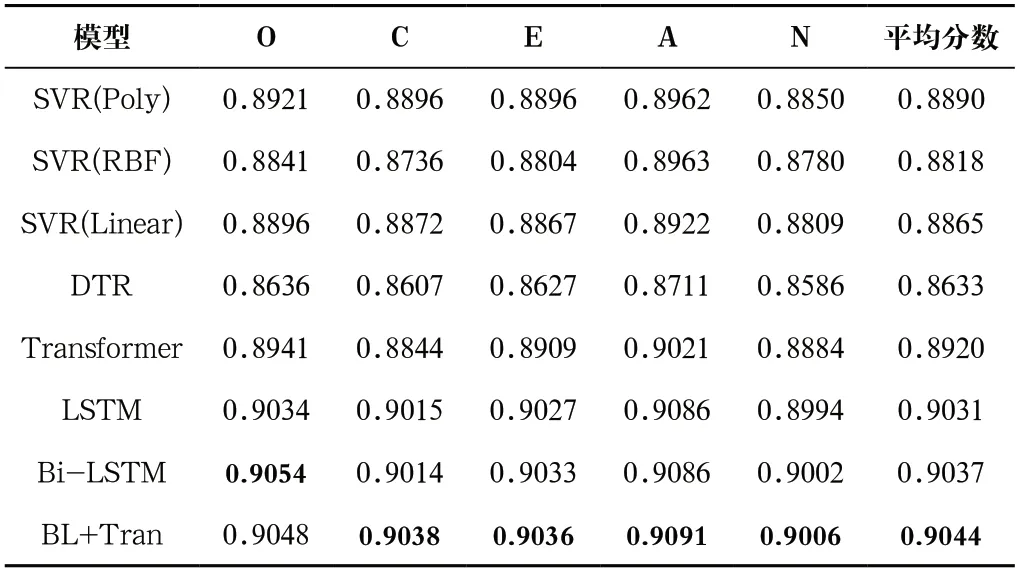

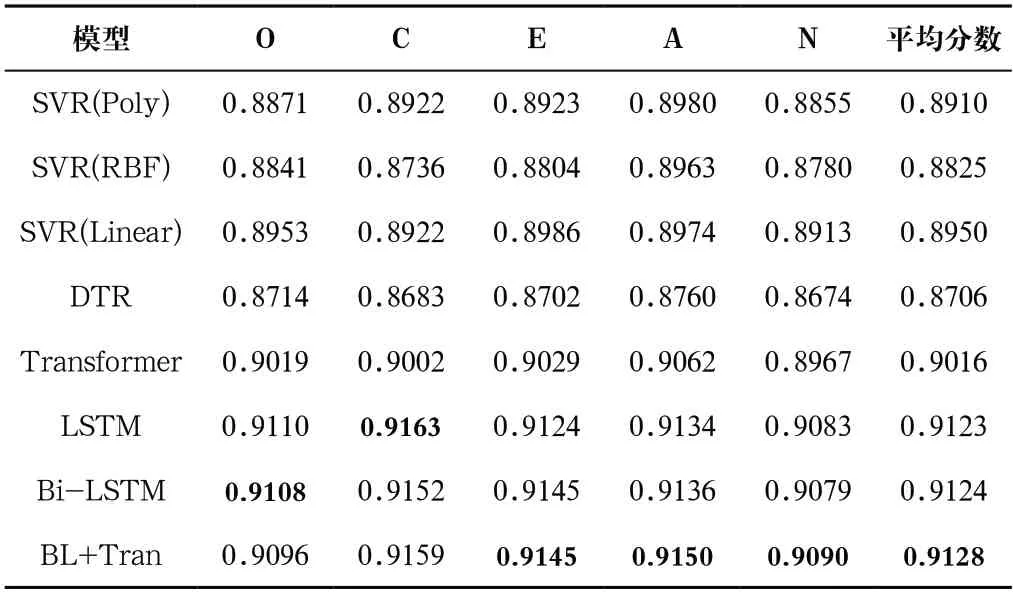

本文将支持向量回归(Support Vector Regression,SVR)和决策树回归(Decision Tree Regression,DTR)经典回归模型用于单视觉模态人格识别实验。其中SVR采用了多项式(Poly)函数、径向基函数(Radical Basis Function,RBF)和线性(Linear)函数三种核函数,核函数的阶数degree=3,惩罚因子C=2.0,参数gamma=0.5。这些回归模型使用的输入特征是对提取的视觉局部特征经过平均池化后得到的全局特征。深度学习模型LSTM和Bi-LSTM,均使用两层结构,且最后一层均输出2,048 维特征。对于基于注意力机制的Transformer模型,使用六层编码层,最后一层输出1,024 维特征。对于Bi-LSTM+Transformer,级联后最后一层输出3,072 维特征。

表2和表3分别是对深度视觉场景图像特征与深度视觉人脸图像特征采用预训练好的VGG-Face提取后从不同模型学习得到的人格预测结果。由表2和表3可见,深度视觉场景图像特征与深度视觉人脸图像特征在深度学习模型Bi-LSTM+Transformer中分别获得0.9044和0.9128的最高大五人格平均分数,表明该模型在视觉模态人格识别中具有一定的优势,传统回归模型DTR、SVR与深度学习模型Transformer、LSTM和Bi-LSTM在视觉模态人格预测分数上相比,劣势明显,其中DTR表现最差。这两种单视觉模态特征在人格预测中,深度视觉人脸图像特征表现优于深度视觉场景图像特征,这表明人脸图像特征在人格识别任务中包含更多的识别信息。

表2 不同方法下深度视觉场景图像特征的人格预测结果Tab.2 Personality prediction results of image features of deep vision scene under different methods

表3 不同方法下深度视觉人脸图像特征的人格预测结果Tab.3 Personality prediction results of image features of deep vision face under different methods

(3)融合场景与人脸图像的视觉人格识别结果及分析

在视觉模态人格识别任务中分别使用特征层与决策层融合方法进行实验。

表4列出了单视觉模态和两种视觉模态在特征层融合和决策层融合方法取得的人格识别结果比较,其中Scene指场景图像,Face指人脸图像。特征层融合是对Transformer与Bi-LSTM学习到的视觉全局特征(6,144 维)进行级联,然后输入一个线性回归层而获得的结果。决策层融合是对Bi-LSTM+Transformer在两种视觉模态获得的大五人格分数采用XU等最优加权策略融合得到的。

表4 特征层融合和决策层融合方法取得的人格识别结果比较Tab.4 Comparison of personality recognition results obtained by feature-level fusion and decision-level fusion methods

由表4可见,两种视觉模态融合时,使用特征层融合方法效果优于决策层融合方法,大五人格平均分数为0.9141。

4 结论(Conclusion)

本文提出了一种基于Transformer的视频序列的人格识别方法。该方法将VGG-Face、Bi-LSTM和Transformer模型结合,分别用于学习对应更高层次的视觉全局特征。最后比较了特征层与决策层的视觉人格预测结果。在ChaLearn First Impression V2公开人格数据集上的实验表明,本文方法能有效提升视觉模态人格识别模型的性能。由于当前工作中只考虑了视觉模态,在未来工作中应考虑增加文本、听觉、生理信号等更多与人格特质相关的模态信息,尝试更多先进的融合方法,以便更好地提升人格识别效果。