美国白蛾幼虫网幕图像识别算法及其视觉伺服系统研究*

2022-10-27魏晨国树金荆茂焱朱鸿瑞赵颖

魏晨,国树金,荆茂焱,朱鸿瑞,赵颖

(聊城大学机械与汽车工程学院,山东聊城,252000)

0 引言

美国白蛾又名美国灯蛾,是一种世界性检疫害虫[1]。美国白蛾繁殖力强,危害300多种植物,对园林树木造成严重的危害[2]。美国白蛾生长期分为卵、幼虫、蛹、成虫四个阶段[3],其在幼虫期危害树木最为严重,幼虫聚集叶片上吐丝结网,形成网幕,取食寄主的叶肉[4]。美国白蛾整个幼虫期间取食量极大,造成植物长势衰弱,甚至整株死亡[5]。目前防治方法主要是人工大面积喷洒化学药剂,该方法环境污染严重且对人体健康不利[6]。

目前,国内外专家学者在精准对靶喷药方面做了许多研究。2022年蒋顺勇等[7]提出了一种精确的农药喷洒装置。结合机器视觉和喷嘴对靶的原理,各类植保无人机也得到了大规模的应用[8]。目前国内外在利用精准对靶喷药技术实现防治美国白蛾的研究相对较少。通过机器视觉技术获取靶标位置信息,使用自动化设备实现精准对靶喷药,可有效解决上述不足[9]。

1 系统工作基础与工作流程

1.1 工作场景介绍

因喷药对象植株巨大,因此将喷药机器人设置在可升降的小车上,在小车驱动下沿植株做圆周运动,并在圆周的定点位置实施喷药。在每一定点位置处,升降装置根据植株具体高度升高到一定位置,手眼协调式执行机构在喷药支架上首先做深度调节,到达合适深度距离时,开始按照既定路径做局部运动,覆盖一定的树冠面积,然后手眼机构复位,通过升降装置的进一步升高,重复上述作业使喷药范围覆盖到树顶。

1.2 空间四自由度智能喷药机器人机械本体介绍

算法基于空间四自由度喷药机器人,如图1所示。机器人主要由行走机构、喷药系统、四自由度空间移动系统及框架结构组成,图为室内仿真试验设计故省略了升降部分。

图1 喷药机器人结构示意图

喷药系统由摄像头喷头和深度传感器组成,其中摄像头和深度传感器安装在一个平面上,喷头与之相隔180°安装。空间四自由度移动机构由上下移动机构、左右移动机构、前后(深度)移动机构和相机喷头旋转运动机构组成。初始位置时摄像头在前,喷头在后,当检测到进入最佳喷药位置时,步进电机带动旋转机构旋转180°使得喷头在前,摄像头在后,喷头占据原摄像头位置,开始喷药。

1.3 系统工作流程说明

系统工作流程如下:(1)流程开始:机器复位,手眼执行机构回复在最下端开始位置,通过深度传感器读数调整与目标物的距离后,执行机构开始按照既定路线运动。(2)摄像头获取图像:执行机构开始运动后,摄像头自动开启,拍下图片存入存储器中。(3)阈值处理:对图像进行基于色差的改进阈值处理,并判断图像是否为合格的图像,图像不合格时,执行机构按既定路线到下一位置,继续采集图像。(4)卷积处理:当图像判定为合格时,送入卷积神经网络中进行精确处理,并标出轮廓框,为对靶喷药做准备。(5)最佳喷药位置判断:判断是否进入最佳喷药位置,是则执行机构停止运动,旋转机构旋转180°,开始喷药,不是则按既定路线运动到下一位置,重复过程(3)。(6)本次喷药完成后,旋转机构回旋180°,摄像头回复原始位置,执行机构按既定路线运动到下一位置,重复过程(3)。(7)重复上述过程直至人工结束本次行程。系统工作流程如图2所示。

图2 美国白蛾幼虫网幕自动化识别算法流程图

2 图像采集及预处理

2.1 图像采集

识别所需图片为2018年5月中上旬使用佳能600D数码相机采集于聊城市市内道旁树,采集1 327幅图片作为识别样本库,RGB格式,图片分辨率960 ppi×720 ppi。因样本库过大,本文选取样本库中4幅图片作为代表以此说明识别过程,样本图片如图3所示。

(a) 原始图像1 (b) 原始图像2

2.2 图像预处理

2.2.1 图像通道的确定

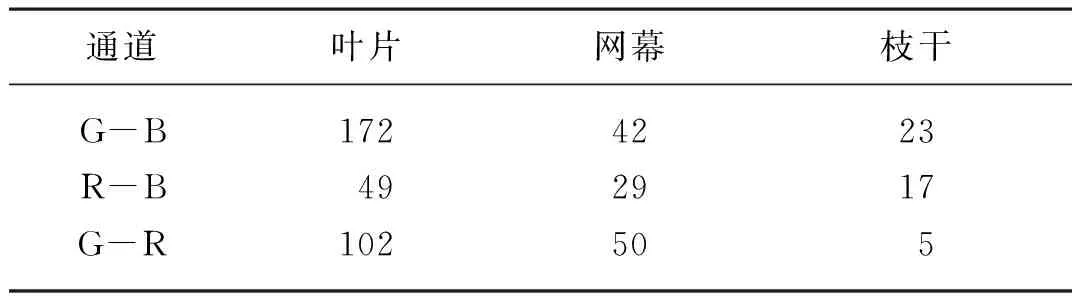

由于美国白蛾幼虫网幕紧密分布在枝叶之中,本身具有一定的透光性,使用单一颜色通道很难将其识别,本例在G-B、R-B、G-R三个单通道的图像上提取多个叶片、网幕及枝干的像素求平均值,提取结果如表1所示。

表1 像素值结果Tab. 1 Pixel value result dpi

比较结果发现在G-R的单通道图像中,网幕与其余干扰的色差值最大,故选用G-R通道作为预处理的通道。

2.2.2 图像的阈值化处理及优化

使用最大类间方差来确定G-R单通道的自适应阈值,其过程描述如下[10]。

1) 记录图像原始的G-R值。

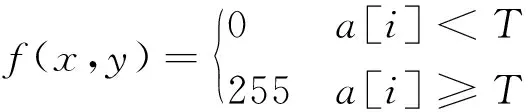

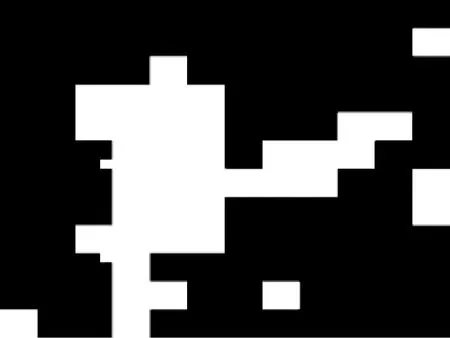

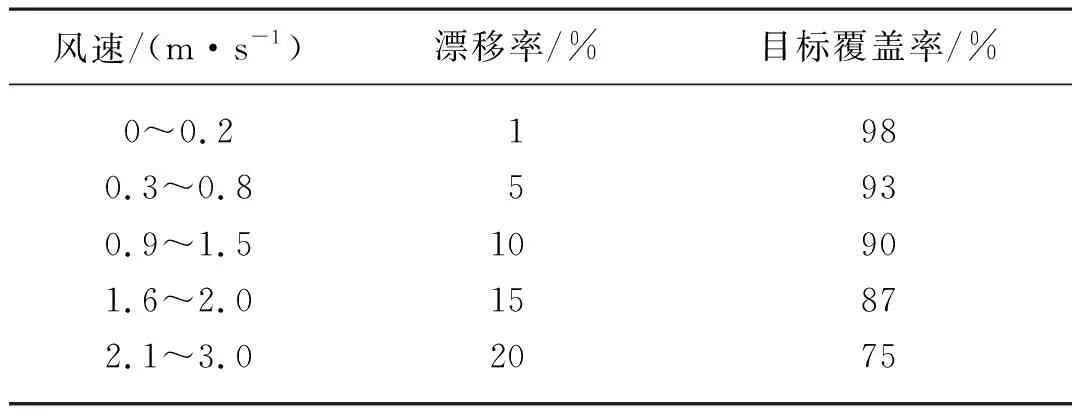

2) 将此值按照升序顺序排列,放入数组a[i]中(0 3) 按照式(1)计算阈值。 T=μ1Dmax+μ2Dmid (1) 式中:T——阈值; m——差值小于中值的像素数; n——所有像素数。 按照式(2)对图像进行阈值处理。得到二值化图像,结果如图4所示。 (2) (a) 二值化图像1 (b) 二值化图像2 二值化图像中仍含有大量白色噪音点,为了后期计算合格率的便利,这里再利用轮廓面积信息优化二值图像。提取图像中每一部分白色区域的外轮廓信息,提取每一部分的面积,将其放入一个数组中。设定一个阈值,并新建一个与原图像大小相同的黑色三通道图像,当某一部分面积大于阈值时,将该轮廓在黑色三通道图像上的相同位置描绘出来,并用(255, 255, 255)进行泛洪填充;当轮廓面积小于阈值时,用(0, 0, 0)进行泛洪填充,如图5所示。经试验,面积阈值定为面积数组中的第10位的值。 (a) 优化后的二值图像1 (b) 优化后的二值图像2 从图5可以看出,优化后的图像中白色噪音点明显减少,且每个轮廓内部不再具有空缺的黑色部分,为合格候选框的提取提供了便利。 将处理好的二值化图像提取出白色区域所占的像素点与全部的像素点做比,会产生一个比率,该比率即为判断图像是否合格的合格率。 设定一个阈值,当图像的合格率大于该阈值时,图像即为合格图像,否则即为不合格的图像。经过试验,阈值设为10%,可以很好的选择出合格的网幕图片,进行下一步处理。不合格的图片则直接跳过,继续采集下一帧。 图像的阈值化处理实时性高,但美国白蛾幼虫网幕分布较为复杂,图片中存在干扰信息多,单一使用该方法目标物的识别准确率较低,不能满足精准喷药的要求,针对这一问题,研究引入了卷积神经网络。 确定深度神经网络整体架构:网络第一层是卷积层,从截断的正态分布中输出随机值为卷积核的权重赋初始值。卷积后得到的特征图用Relu函数激活,减少计算量。网络的第二层是池化层,对池化窗口中的数值取最大值[11]。为了防止数据过拟合,对池化后得到特征图进行局部响应标准化处理(Local Response Normalization,LRN)。网络的第三层是卷积层,该层的设置与第一层相同。网络的第四层是池化层,池化前,用LRN函数对特征图进行处理[12]。网络前四层的整体作用是通过特征图来提取出各种不同的图像特征信息[13]。网络的第五层和第六层是全连接层,这两层输出数据前用Relu函数进行激活[14]。试验表明,两层全连接层可以近似于其他任何形式函数的作用。网络的最后一层也是全连接层,使用Softmax函数激活,输出有幼虫网幕和无幼虫网幕的概率[15]。利用建立的数据集训练CNN模型,每次训练完一次后,将预测值与正确值相比较求取误差,在网络中反向传播该误差,逐层求导,更新权重,再多次训练,不断减小误差,直至达到精度要求[16]。 由于美国白蛾幼虫网幕分布无规律,全图像范围内直接识别输出结果差别较大不易控制,故采用了候选框和卷积神经网络相结合的不重合遍历滑动窗口法。 首先确定一个合适的滑动窗口尺寸,窗口以其宽和高为x轴和y轴方向上的步长在整幅图像上滑动以提取候选框,候选框中的区域互不重叠;对每一候选框进行CNN处理,输出该候选框内存在美国白蛾幼虫网幕的概率(grade),设置两个阈值E和Q,当grade>E时,认为该候选框优秀,其中绝大部分区域是目标区域;当Q 设定概率高于90%为优秀,低于10%的为不合格,中间为合格,经过CNN模型多次筛选后得到多个优秀候选框。对所有优秀候选框进行融合处理:设置一个与原始图像同等大小的纯黑图像,将所有优秀候选框的大小复制在该图像上并设置其为白色,如图6所示。 (a) 融合结果1 (b) 融合结果2 最后提取该白色轮廓框并将其绘制在原图像上,如图7所示,即可得到最终的处理结果。 该算法在不同的场景中,均可得到较为理想的结果,单幅图片识别率、误判率及处理时间如表2所示。其中识别率指被识别出的网幕面积与全部网幕面积的比值,误判率指被划定在目标区域中但不是网幕的面积与全部网幕面积的比值。可以看出识别率在95%以上,处理时间均小于200 ms。与单一使用图像的阈值化处理方法(文献[10])相比,该算法极大提高了目标的识别率。与单一使用改进的卷积神经网络方法相比,该算法在完整处理一幅图片的时间上虽有一点增加,但执行机构在行进过程中,实时采集的大多数图片都仅需要图像的阈值化处理这一步就已经提前被剔除了,能够进入卷积神经网络的都是带有目标的图片,因此系统整体的实时性实际得到了提高,同时进一步保证了卷积神经网络的准确率。由于美国白蛾幼虫网幕的分布极不规则,且呈现半透明状态,因此识别过程中极易受到干扰,很难像识别有规则形状和颜色的目标物(例如水果蔬菜等)那样达到极高的识别率,经试验95%以上的识别率能够满足工作需要。算法存在一定的误判率,但由于网幕轮廓本身存在不规则性,喷药操作会以一定的覆盖面无差别的喷射过去,因此该误判率不影响正常工作的进行。 (a) 定位结果1 (b) 定位结果2 表2 单幅图片识别结果分析Tab. 2 Single image recognition results analysis 基于美国白蛾幼虫网幕识别结果,研究了一种智能喷药机器人视觉伺服系统模型[17],搭建了系统控制平台,并提出了一种喷药路径规划方法和最佳喷药位置识别算法。 视觉伺服控制系统模型,如图8所示。由图像采集模块、超声波测距模块、控制器等构成信息获取与处理系统,实时获取喷药目标的位置并判断是否达到最佳喷药位置。由多个电机控制器和步进电机构成运动控制系统,用于控制空间四自由度喷药机器人执行机构按照规划路径运动。压力流量控制系统用以控制作业过程中保持一定的喷药压力和流量。三者相互配合协同作业,共同完成喷药任务。 图8 视觉伺服系统模型 对于喷药深度的控制,由于美国白蛾幼虫网幕往往分布于枝叶表面且连续分布,因此可以假设执行机构运动过程中网幕与其之间的距离是固定的。经试验,取深度值为1.5 m,此时镜头畸变较小,有效喷药覆盖面积较大,喷药效果比较稳定,执行机构运动过程中与目标物保持这一距离不变。 考虑到重力导致液滴下垂等情况,喷药覆盖面的真实形状不规则,取其内接正四边形为有效喷药区域,且假设在工作过程中该面积保持不变。喷药范围与摄像头视野范围关系如图9所示,其中外框为摄像头视野区域(其实际高度为b),内框为有效喷药区域,通过控制喷药压强,使得喷药范围略小于视野区域。在此基础之上设计行走路径以控制执行机构的运动,如图10所示。其中,h表示每个扫描行之间的距离,由喷药范围的高度b决定,为避免漏喷选择一定重合度,h=0.8b。 图9 执行机构局部运动轨迹示意图 以执行机构向左或向上运动为例,标记喷药区域中右侧和下侧各1/4边长区域,命名为区域A、B,如图9斜线区域所示,设变量Right、Down初值为零,用来标记A、B是否有未喷药的目标。执行结构向左运动时,滑动窗口定位的可疑目标将首先出现在视野的最左端,随着机构的运动,当目标物进入A区域时,将Right设置为true,执行结构向上运动时,若可疑目标进入B区域时,将Down设置为true。若Right、Down中有一个为true,则判定目标进入最佳喷药位置,系统停止运动,开始喷药。 图10 喷药区域与摄像头视野区域示意图 由于实际的树木往往植株巨大枝叶复杂,试验结果很难进行精确测量,因此,研究定制了仿真法国梧桐树,仿真树高1.5 m,树冠宽1.5 m,模拟网幕使用丝绵拉伸形成。试验选用格强子弹喷头,喷头的孔径为1 mm,推荐工作压力在0.35 MPa(3.5 kg)到2.5 MPa(25 kg)之间,喷药系统上装有压力传感器和流量传感器,试验样机与仿真树如图11所示。试验使用大恒工业摄像机DH-HV3151UC-ML,M1214-MP2定焦镜头,分辨率1 280 ppi×1 024 ppi,15 fps帧率,深度传感器采用HC-SR04超声波模块。 (a) 试验样机 调整模拟网幕实际大小使网幕面积与视野面积比例不断变化进行喷药试验,结果显示算法完整处理一帧图像所需时间不超过200 ms,满足实际工作要求。试验阶段无漏喷,有一定过喷,过喷率P的计算公式如式(3)所示。 (3) 式中:WA——网幕面积; VA——视野面积; PA——实际喷药面积。 VA值一定,WA/VA表现为不同值时的过喷率如表3所示。 表3 不同网幕面积下的过喷率Tab. 3 Overspray rate under different screen area 由表3可知,网幕面积较小时,过喷率较大,当WA/VA为1时,过喷率最小,网幕面积进一步增大时,过喷率略有一点增大,但总体变化较平稳。 在实际工作中喷药经常会受到风力的影响,因此补充了风速试验:设定高压水泵提供1.5 MPa压力,喷头有效喷药距离为1.5 m,利用小型无级变速风扇模拟自然环境下的风速,横向正面吹动喷雾。用希玛A7356分体式测风仪(测量误差±1%)测量目标处的风速。经多次试验喷药系统的漂移率和覆盖率见表4。表中漂移率指液滴受风后中心偏移的距离与喷药直径的比率,目标覆盖率指受风后目标物上喷药剩余覆盖面与无风时理想喷药覆盖面的比率。 表4 不同风速下的漂移率与覆盖率Tab. 4 Drift rate and coverage under different wind speeds 经分析可看出,喷药系统的漂移率和覆盖率与风的大小密切相关,风速较小时漂移率低覆盖率高,反之较低。当风速大于2.1 m/s时,覆盖率只有75%,故建议喷药工作在风速较小的气候环境下进行。 本文以美国白蛾幼虫网幕为靶标,提出一种基于图像阈值化和卷积神经网络相结合的美国白蛾幼虫网幕自动化识别算法。首先使用最大类间方差法对图像进行预处理,对图像中是否有可疑目标进行初判。将存在可疑目标的合格图像喂入卷积神经网络并结合不重合滑动窗口法对图像的框架进行识别。对美国白蛾幼虫网幕喷药机器人的工作场景和机器人本体进行了介绍。规划了机器人喷药执行机构的运动路径,对最佳喷药位置的判定方法进行了研究。 通过基于色差的阈值分割方法与改进卷积神经网络(CNN)相结合的网幕图像快速识别算法识别结果证明,单幅图像的识别时间在200 ms左右,网幕识别的准确率在95%以上,满足实际工作要求。该识别方法既减少了识别时间,又提高了图像识别的准确率。识别时间的减少也使执行机构的运行更加连贯,机器执行过程中无漏喷现象。

2.3 图片合格率的计算以及合格图片判断方法

3 改进卷积神经网络

3.1 卷积神经网络建立

3.2 不重合遍历滑动窗口法实现轮廓提取

3.3 定位过程与结果

4 视觉伺服系统

4.1 视觉伺服系统构建

4.2 执行机构路径规划和最佳喷药位置判断

5 试验结果与分析

6 结论