不同特征提取策略的场景变化检测性能评估

2022-10-11黄宇鸿周维勋

黄宇鸿 周维勋

(南京信息工程大学 遥感与测绘工程学院, 江苏 南京 210044)

0 引言

遥感影像场景级变化检测是近年遥感影像变化检测的一个重要发展方向,从语义层次分析场景的类别变化,其中高分辨率遥感影像具有空间分辨率高、地物细节信息丰富的特点,是一种重要的变化检测数据源,在土地利用监测、违法用地监测、生态环境监测等领域应用广泛。

目前场景变化检测方法按是否分类可分为分类后比较法以及直接比较法。直接比较法是直接对同一区域不同时相影像的光谱信息差异进行比较,确定发生变化的位置与范围,一大缺陷在于其无法给出明确的变化类型;而分类后比较法先对每一时相影像以相同的分类标准单独分类,然后比较分类结果以确定变化信息,操作简单且可明确变化类型,但其检测精度也因此大大受限于两时相影像分类的精度,故提高各时相影像分类的精度是提高分类后比较变化检测精度的关键。

在影像分类中,如何对影像进行特征提取及提取影像的哪些特征影响着分类的准确性。传统常用的特征包括纹理特征和颜色特征,如胡玉福等利用影像的纹理特征实现了高效的高分辨率遥感影像土地利用分类;陈善静等提出一种基于滑坡区域颜色特征模型的支持向量机(support vector machine,SVM)遥感检测方法,对滑坡区域进行了目标精确分类与识别。但是,这类特征的表达能力有限,往往无法全面反映高分辨率遥感影像复杂的深层语义信息。

随着深度学习技术的日渐成熟,一些深度学习模型开始被应用于遥感影像变化检测的分类后比较法中。其应用的特征主要有以下三大类:深度置信网络特征、栈式编码器网络特征以及卷积神经网络(convolutional neural networks,CNN)特征。其中,CNN特征具有很强的表达能力和泛化能力,近年来在遥感图像分类问题上受到了广泛的使用并取得了较好的分类精度。徐真等提出了一种基于CNN特征的合成孔径雷达(synthetic aperture radar,SAR)图像变化检测方法并验证了该方法的准确性和有效性,王艳恒等结合深度学习和超像元分割实现对同物异谱的区域做出有效判决,提升了变化检测精度。

对于场景变化检测,现有方法大多采用传统图像特征如颜色和纹理特征,或采用单一CNN特征进行分类器训练,没有对不同特征的变化检测性能进行综合性评估。因此,与现有研究不同,本文利用公开的标准数据集,对比分析了颜色特征、纹理特征以及8种CNN特征对高分辨率遥感影像变化检测的效果,以评估不同特征提取策略对变化检测结果的影响。

1 实验方法

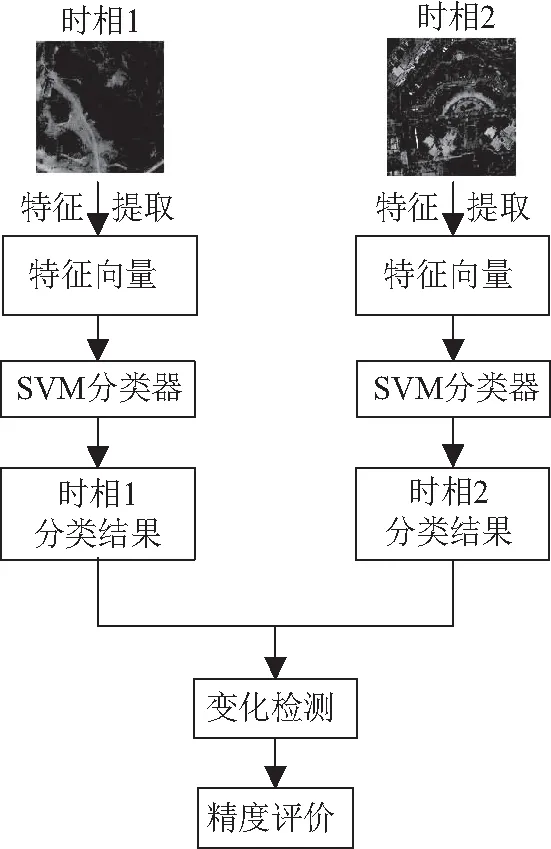

本文实验方法的流程如图1所示。

图1 实验方法流程

1.1 特征提取

本文采用两种策略提取遥感影像的场景特征,包括传统的纹理特征和颜色特征,以及基于艾历克斯网络(AlexNet)、视觉几何图形小组十六层网络(visual geometry group16,VGG16)、视觉几何图形小组十九层网络(visual geometry group19,VGG19)、谷歌模块组装型网络(Google inception net,GoogLeNet)、十八层残差网络(residual network18,ResNet18)、五十层残差网络(residual network50,ResNet50)、压缩型网络(SqueezeNet)和十九层黑暗网络(DarkNet19)等网络提取的CNN特征。

1.1.1

纹理特征纹理是图像中某种局部序列性不断重复的非随机排列的视觉特征,可由像素及其邻域的灰度分布来表现。本文对输入图像做小波分解后,用每个分解层上能量分布的均值和标准方差构成一个6×2的向量来表示其纹理特征。

1.1.2

颜色特征颜色特征是一种全局特征,描述了图像所对应的地物表面性质。其中颜色直方图是最常用的表达方法,它不易受图像旋转和平移的影响,且对尺度变换不敏感。本文首先将输入图像从RGB颜色空间转换至HSV空间,后对H、S分量按16个等间隔区间进行量化,经归一化后得到一个16×2的向量来表示其颜色特征。

1.1.3

CNN

特征CNN基本结构通常包括卷积层、池化层和全连接层。本文分别采用AlexNet、VGG16、VGG19、GoogLeNet、ResNet18、ResNet50、SqueezeNet和DarkNet19共8种预训练深度学习模型对数据集图像做特征提取。

Alexnet采用8层神经网络结构,包括5个卷积层、3个池化层和3个全连接层,采用Relu作为激活函数并使用Dropout代替正则以降低过拟合。本文选取Alexnet的“fc8”(最后一个全连接层特征)用于后续分类。VGGNet最早由牛津大学计算机视觉实验室提出,VGG16是其中较为典型的一个,共有16个带参数的网络层(不包括激活层),即13个卷积层、3个全连接层。而VGG19共19个参数层,包括16个卷积层和最后的3个全连接层。本文选取VGG16和VGG19的“fc8”(最后一个全连接层特征)用于后续分类。

GoogLeNet引进了Inception结构,深度达到22层。本文选取GoogLeNet的“loss3-classifier”(最后一个全连接层特征)用于后续分类。

ResNet网络在结构中增加了直连通道,神经网络学习的是上一个网络输出的残差,其中ResNet18和ResNet50的深度分别为18和50,本文选取ResNet18和ResNet50的“fc1000”(最后一个全连接层特征)用于后续分类。

SqueezeNet是一种超轻量CNN模型,由AlexNet网络发展而来,包含若干个Fire模块结合卷积层、降采样层、全连接层,网络深度达到18层。本文选取SqueezeNet的“pool10”(平均池化层特征)用于后续分类。

DarkNet19是一个深度为19的卷积神经网络,包含有19个卷积层、5个最大值池化层和1个全局平均池化层。本文选取DarkNet19的“avg1”(全局平均池化层特征)用于后续分类。

1.2 分类及变化检测

SVM是一种基于统计学习理论的机器学习算法,它通过最优化问题解算确定出特征空间的最优分类超平面,能处理复杂的数据分类问题。本文依次提取训练集和测试集图像的上述6种特征后,分别将训练集的各类特征向量输入SVM分类器内,选择线性核函数进行训练,将得到的训练模型应用到测试集上进行分类测试,生成类别预测结果。若预测结果中两时相的类别相同,则判断该区域未发生变化;若预测结果中两时相的类别不同,则判断该区域发生变化。

2 实验结果与分析

2.1 研究数据

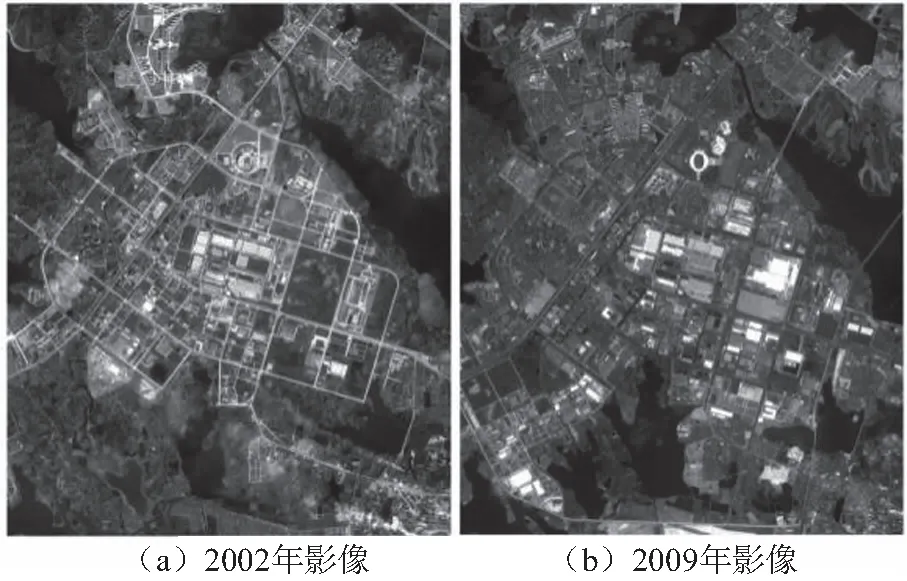

实验采用的数据集为MtS-WH,该数据集主要用于场景变化检测方法的理论研究与验证,包括武汉市汉阳区的两幅伊科诺斯(IKONOS,世界上第一颗提供高分辨率卫星影像的商业遥感卫星)影像,大小为7 200×6 000像素,共红、绿、蓝和近红外4个波段,空间分辨率为1m。两幅影像分别获取于2002年2月和2009年6月,分别如图2(a)和图2(b)所示。

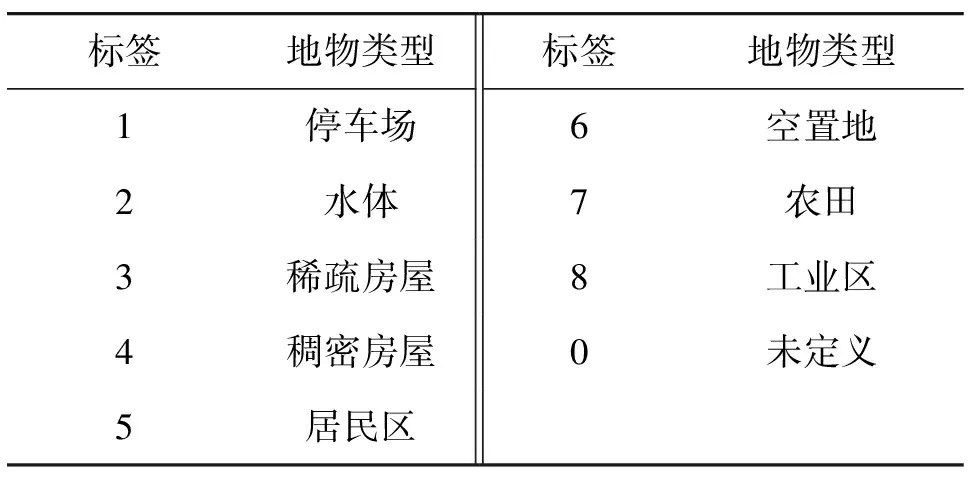

本文选取红、绿、蓝三波段真彩色合成的影像进行实验,标签与地物类型的对应关系如表1所示。其中0类为未定义类,故0类不参与精度评价。

为评估各特征在场景变化检测中的性能,本文分别将两个时相的影像裁切为1 920幅150×150像素的场景对,去除标签为0的场景后得到1 050对非0类场景对;然后将非0类场景对按4∶1的比例随机划分为训练集和测试集。其中,训练集用于训练SVM分类器,而测试集用于评价基于各类特征的检测精度。

表1 MtS-WH数据标签与相应的地物类型

图2 MtS-WH数据集

2.2 评价指标

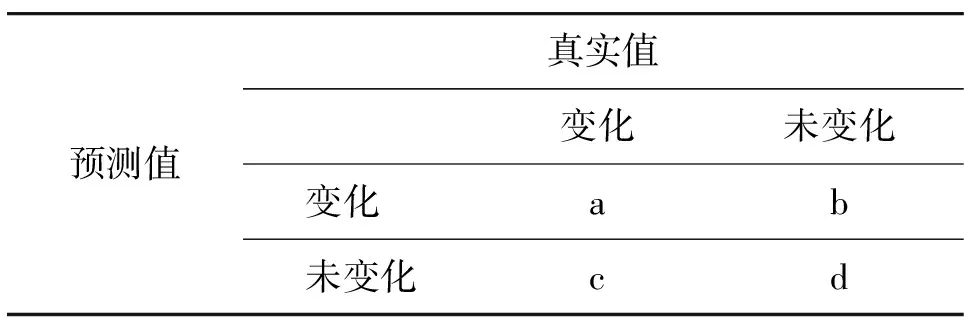

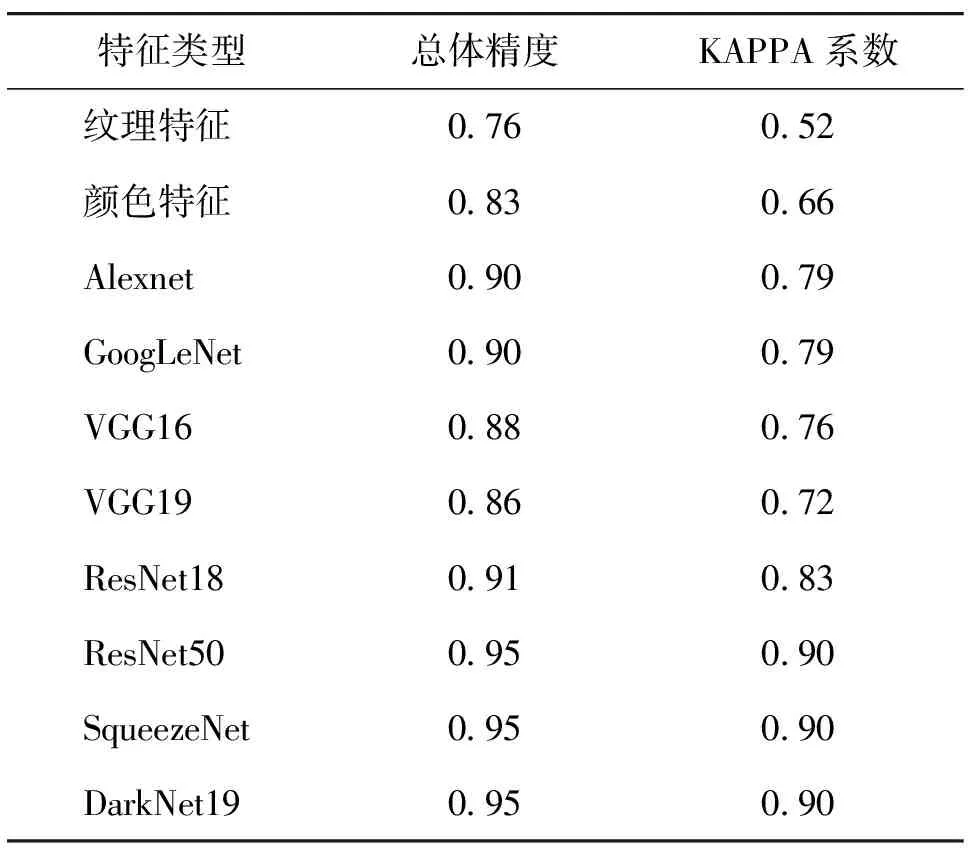

本文使用基于二分类混淆矩阵计算的总体精度(overall accuracy,OA)和Kappa系数作为评价指标,如表2所示。

表2 二分类混淆矩阵

总体精度是指对每一个随机测试样本,所分类的结果与检验数据类型相一致的概率。Kappa系数用于评估模型预测结果和实际分类结果的一致性。计算公式分别为

(1)

(2)

其中,p

即总体分类精度P

,p

计算公式为

(3)

其中,A

1=a

+b

,A

2=c

+d

,B

1=a

+c

,B

2=b

+d

,n

=A

1+A

2+B

1+B

2。2.3 基于不同特征的变化检测结果对比

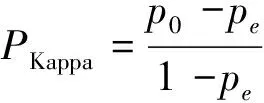

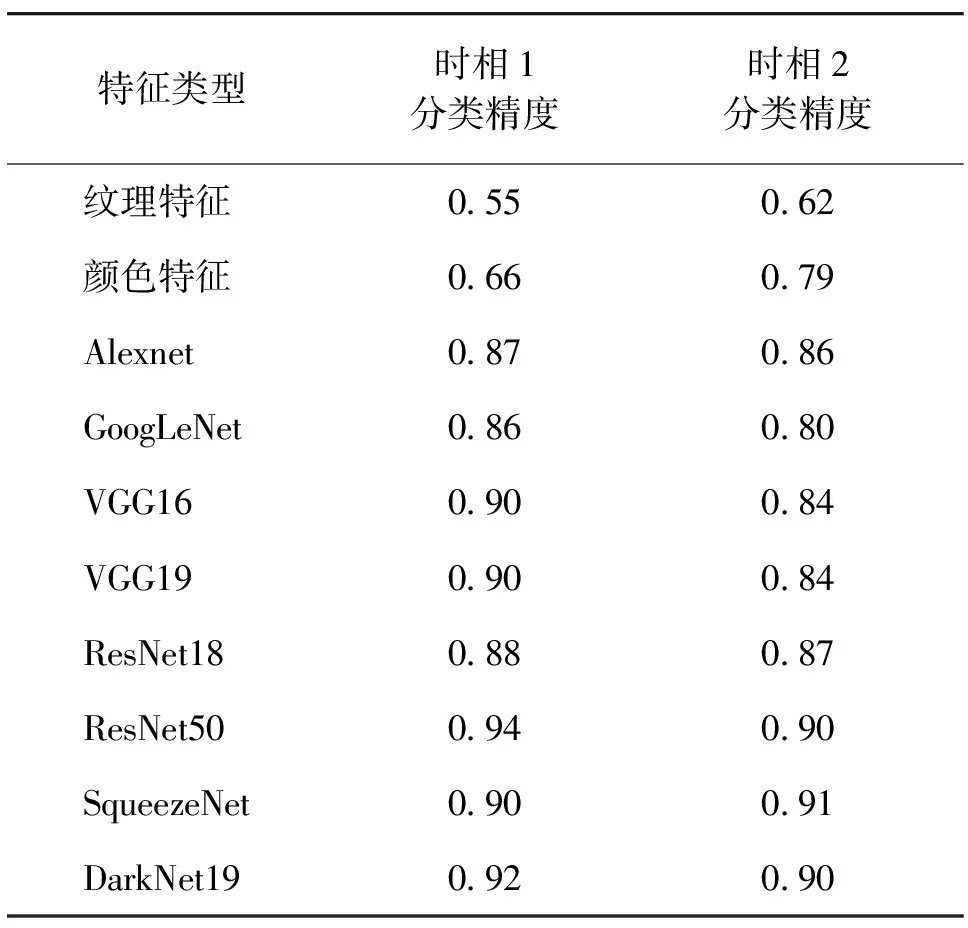

基于不同特征的SVM分类精度和变化检测结果对比如表3、表4所示。

表3 基于不同特征的SVM分类精度

表4 基于不同特征的变化检测精度

结合表3、表4可知,变化检测性能明显与分类精度密切相关,尤其受时相2分类精度的影响。时相2分类精度大于0.86的几种CNN特征在后续变化检测中均表现良好。综合分类精度和检测精度来看,最优的是SqueezeNet、DarkNet19和ResNet50,三者在场景分类精度上分列前三且变化检测性能是所有实验特征中的最佳,总体精度均达0.95且Kappa达0.90,而检测精度最差的是VGG19,其在时相2分类中的表现尤其偏差。对于时相2的分类精度,前三者分别比VGG19高出8%、7%和7%,前三者总体精度和Kappa系数分别比VGG19高出11%和25%。根据CNN特征之间的精度对比可以发现,可见分类精度越高,变化检测的精度就越高,在Kappa系数上这种依赖关系表现得尤其明显。

而传统的纹理和颜色特征在分类精度和变化检测精度上都远逊于CNN特征,相比CNN特征中表现最差的VGG19特征,基于纹理特征进行的两时相分类精度分别低39%和26%,变化检测总体精度低了12%、Kappa系数低了28%,;而基于颜色特征进行的两时相分类精度分别低27%和6%,变化检测总体精度和Kappa系数则分别低了4%和8%。可以说,分类精度的差距带来了最终的变化检测精度差距。传统特征只能提取图像的浅层特征,未能充分利用高分辨率遥感影像提供的复杂的深层信息,在SVM分类中更容易出现误判而导致最终的变化检测精度偏低。

3 结束语

本文选取AlexNet、VGG16、VGG19、GoogLeNet、ResNet18、ResNet50、SqueezeNet和DarkNet19共8种CNN特征与传统影像特征(纹理特征和颜色特征)分别对Mts-WH数据集进行了分类后比较的变化检测实验。对比实验结果可以发现,由于缺少对深层语义信息的利用,传统特征在高分辨率遥感影像的场景分类中表现不佳,导致其变化检测总体精度不足0.85且Kappa系数不足0.7,较CNN特征中表现最差的VGG19特征还要逊色;能反映图像深层语义信息的CNN特征则更加适合高分遥感场景变化检测。其中,SqueezeNet、DarkNet19和ResNet50在场景分类中拥有最出色的表现,使得三者在变化检测中的应用效果最好,总体精度均高达0.95,且Kappa系数达0.90。

由于本文实验所选的数据集相对较小,各CNN特征与传统影像特征的提取耗时差异不明显,因此不同特征提取策略在时间效率上的性能尚未评估。下一步研究中,将选用规模更大、场景类别更丰富的数据集,结合运行耗时来对不同特征提取策略做出更为全面的性能评估。