不确定性环境下基于深度强化学习的综合能源系统动态调度

2022-09-28蔺伟山王小君孙庆凯和敬涵蒲天骄

蔺伟山,王小君,孙庆凯,刘 曌,和敬涵,蒲天骄

不确定性环境下基于深度强化学习的综合能源系统动态调度

蔺伟山1,王小君1,孙庆凯1,刘 曌1,和敬涵1,蒲天骄2

(1.北京交通大学电气工程学院,北京 100044;2.中国电力科学研究院有限公司,北京 100192)

随着综合能源系统中间歇性能源和负荷不确定性的逐步增强,传统的调度方法局限于固定物理模型及参数设定,难以较好地动态响应源荷的随机波动。针对这一问题,提出了一种基于深度强化学习的综合能源系统动态调度方法。首先,以数据驱动方式构建面向综合能源系统的深度强化学习模型,通过智能体与综合能源系统的持续交互,自适应学习调度策略,降低对物理模型的依赖程度。其次,通过添加随机扰动的方式表征源荷不确定性变化特征,针对不确定性变化特征改进深度强化学习模型的状态空间、动作空间、奖励机制以及训练流程等关键环节,并经由近端策略优化算法优化求解,实现了综合能源系统的动态调度决策。最后,通过算例仿真验证了所提方法在不同时间尺度以及不确定性环境下的可行性和有效性。

综合能源系统;动态调度;不确定性;深度强化学习;近端策略优化

0 引言

随着全球传统化石能源的日渐枯竭和环境问题的日益突出,世界各国正积极调整能源结构,通过开发和利用可再生能源,以减少对传统化石能源的依赖[1-2]。近年来,通过构建综合能源系统(Integrated Energy System, IES),将多种异质能源互联融合、互补利用,为提高能源的利用效率和缓解全球的环境压力提供了重要的解决方案[3]。

IES能实现对多种能源的综合管理和经济调度,但随着多种能源之间的耦合程度不断提升以及可再生能源和负荷的不确定性逐渐增强,如何实现IES的实时、准确、动态调度成为亟待解决的问题[4-5]。对于IES调度问题,文献[6]研究了IES“源-网-荷-储”协调优化调度问题,并采用商业求解器Cplex进行求解。文献[7]采用改进的粒子群算法对电-热综合能源系统的经济调度模型进行求解。文献[8]提出一种含电转气两阶段运行的热电耦合IES优化调度模型。以上研究在IES优化调度方面取得一定的成果,但多依赖于详细的物理模型,局限于固定调度计划,未对源荷的不确定性问题做深入研究。

为应对源荷不确定性问题,文献[9]基于源荷不确定性客观规律和偏差预控提出一种多时间尺度滚动优化调度模型。文献[10]采用场景分析法对风电、光伏出力随机性进行建模求解。文献[11]考虑不确定性负荷和风电出力的极端场景,构建了两阶段鲁棒优化调度模型。文献[12]采用随机场景和鲁棒优化两种方法对风光出力和需求响应的不确定性因素进行了精细化建模。以上研究方法在系统实际运行时无法对源荷进行动态调整,而模型预测控制基于反馈校正的思想可以对调度结果进行滚动优化。文献[13]基于模型预测控制构建了IES多时间尺度优化调度模型。上述研究对解决考虑源荷不确定性的IES优化调度问题提供了良好的思路,但调度决策仍对源荷的精准预测过分依赖。

近年来,强化学习理论的不断发展为解决含不确定性因素的优化决策问题提供了新的思路。强化学习是一种数据驱动的方法,可经由智能体与环境的持续交互来不断改进策略。将深度学习的非线性拟合能力与强化学习的决策能力相结合的深度强化学习是解决高维复杂问题的有效手段[14],可以避免对精细化物理模型的过分依赖。训练完成的深度强化学习模型可以进行短时间尺度的实时决策,满足算法实时性的需求,同时模型可以根据实际运行结果数据进行自我更新并对决策结果进行持续修正。目前已有研究将深度强化学习用于IES的经济调度和能量管理中。文献[15]提出了一种基于深度Q学习的IES能量管理模型,该模型将状态量和动作量进行了离散化,但离散程度精细化会造成维数灾难问题。文献[16-17]采用深度确定性策略梯度(Deep Deterministic Policy Gradient, DDPG)算法求解IES经济调度问题,该算法过分依赖超参数,收敛不稳定。

本文在现有研究的基础上采用近端策略优化(Proximal Policy Optimization, PPO)算法,提出不确定性环境下基于深度强化学习的IES动态调度方法,具体做法为:(1) 本文以数据驱动的方式构建IES动态调度模型,通过与IES环境的交互训练实现调度计划的自适应寻优,降低在处理IES调度问题时对固定物理模型的依赖程度;(2) 针对源荷的不确定性问题,通过将训练数据随机抽样、为状态与动作空间添加扰动以及为奖励函数添加惩罚的方式改进深度强化学习模型,充分挖掘源荷的不确定性变化特征,实现IES在不确定性条件下的动态调度决策。

1 IES动态调度问题

1.1 IES介绍

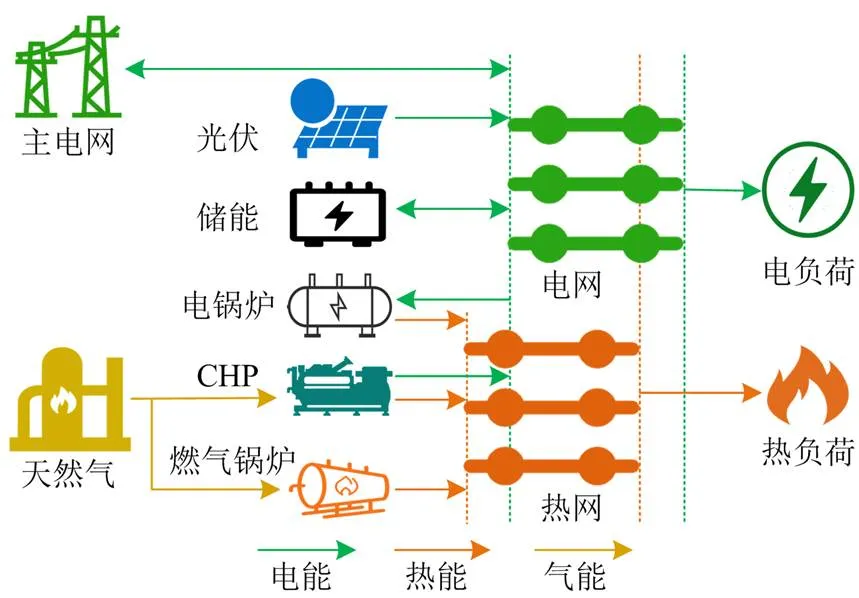

IES一般包括能源转换设备、能源存储设备、能源传输网络和负荷。本文对如图1所示的IES进行研究,系统中的能源转换设备包括热电联产机组(Combined Heat and Power, CHP)、电锅炉(Electric Boiler, EB)、燃气锅炉(Gas Boiler, GB)和光伏阵列(Photovoltaic, PV),能源存储设备为电储能(Battery Energy Storage, BES),负荷包括电负荷和热负荷。IES能够与上级主电网和天然气供应商进行能量交互,同时利用协调优化控制方法对系统内多种能源进行综合使用,以提高能源的使用效率。

图1 IES结构示意图

系统中各设备的运行特性介绍如下。

1.1.1热电联产机组

热电联产机组消耗天然气产生电能和热能。时刻热电联产机组输出的电功率为

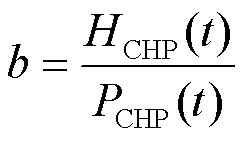

热电联产机组输出的热功率与电功率之间的耦合关系称为“电热特性”,通常分为定热电比和变热电比两种类型,一般采用定热电比[18],表示为

1.1.2电锅炉

电锅炉消耗电能产生热能,时刻电锅炉输出的热功率为

1.1.3燃气锅炉

燃气锅炉消耗天然气产生热能,时刻燃气锅炉输出的热功率为

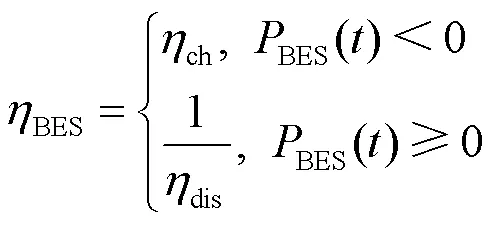

1.1.4电储能

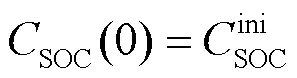

时刻电储能的荷电状态(State of Charge, SOC)为

1.2 动态调度问题的数学描述

IES的动态调度问题是在满足负荷需求的前提下,以经济运行最优为目标,有效协调系统中各设备在每个时段的出力,以此来提升系统的经济效益。

1.2.1目标函数

IES的运行总成本包括常规成本和随机性成本两部分。

1) 常规成本

常规成本包括与主电网的电能交互成本、购买天然气的成本、电储能的充放电折旧成本和设备维护成本。由于设备维护成本相对其他成本较小,故未考虑在常规成本中。因此常规成本表示为[19]

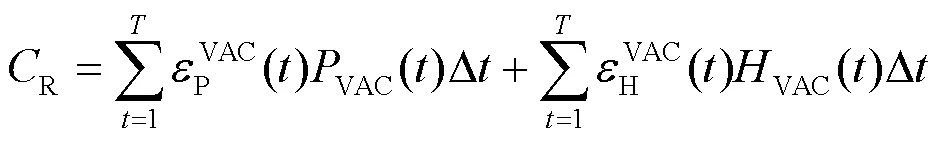

2) 随机性成本

由于IES中电负荷、热负荷以及光伏出力具有不确定性,系统在运行过程中会有小概率出现源荷供需不平衡的情况,对供需不平衡设置随机性成本,如式(10)所示。

因此,系统运行的总成本表示为

1.2.2约束条件

IES动态调度问题的约束包括电功率平衡约束、热功率平衡约束、外部能源供应约束和各设备运行约束。

1) 电功率平衡约束

2) 热功率平衡约束

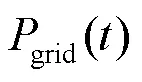

3) 能源交互约束

为保证系统能安全稳定地运行,需对系统与主电网交互的电功率和系统天然气的购买总量进行约束,具体约束为

4) 设备运行约束

系统中各设备均有设备运行的上、下限范围,对于热电联产机组输出电功率、电锅炉和燃气锅炉输出热功率、电储能设备充放电功率,运行约束分别为

对于电储能设备,为避免过度充放电对电储能设备造成损害,需要对电储能设备的荷电状态进行约束,如式(20)所示。

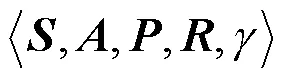

2 基于深度强化学习的IES动态调度模型

本节采用深度强化学习方法构建IES动态调度模型,包括定义状态空间、动作空间和奖励函数。同时,为灵活应对源荷的不确定性以及考虑模型求解的便捷性和训练过程的稳定性,对状态空间、动作空间以及奖励函数进行了改进。

2.1 改进状态空间

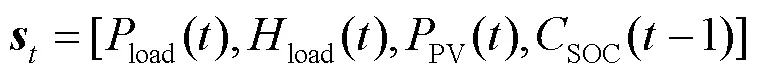

因此状态空间可表示为

2.2 改进动作空间

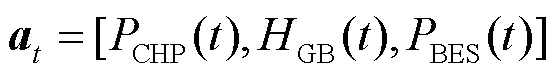

为进一步提升对环境的探索能力,训练过程中同样对动作空间添加随机扰动,改进后的动作空间为

2.3 改进奖励函数

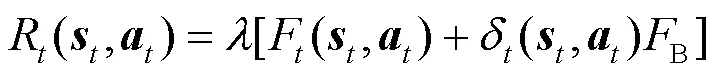

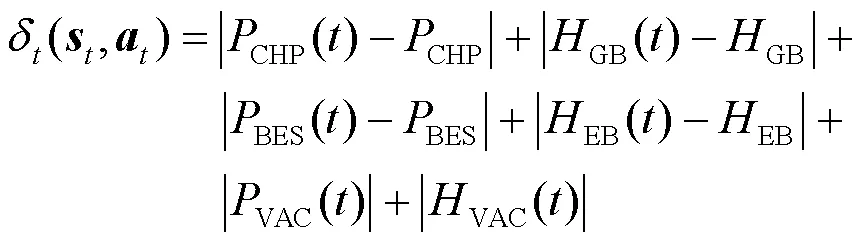

IES动态调度的目标是最小化运行总成本,将该目标转化为强化学习奖励最大化的形式;另外,对于智能体的决策动作,即各设备出力应满足设备运行约束,对违反约束的动作添加惩罚项,同时要对源荷功率不平衡造成的功率误差添加惩罚项。因此,奖励函数可以表示为

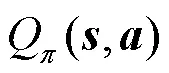

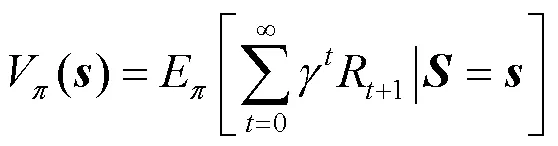

2.4 最优策略

3 基于深度强化学习的IES动态调度问题求解方法

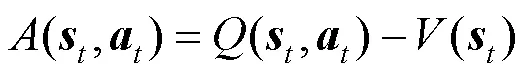

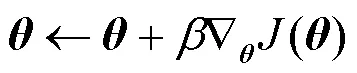

为此本文采用具有连续决策能力的深度强化学习求解IES动态调度问题,具体算法采用PPO算法,该算法基于Actor-Critic网络架构。由于使用深度神经网络对强化学习进行函数拟合,维数灾难和信息丢失问题被很好地解决。PPO算法为On-Policy方法,网络更新之后的原始数据会被废弃,导致训练过程需要多次采样,降低了数据使用率。针对这一问题,本文在训练过程中使用经验回放机制,利用重要性采样技术限制新旧策略的概率分布差异,将PPO算法由On-Policy方法转换为Off-Policy方法,提高了数据利用率,加快了训练速度。

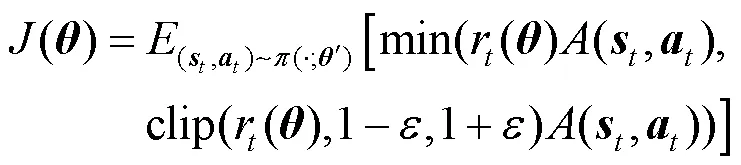

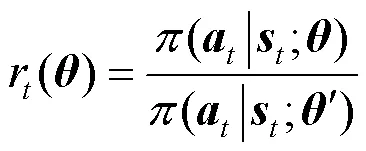

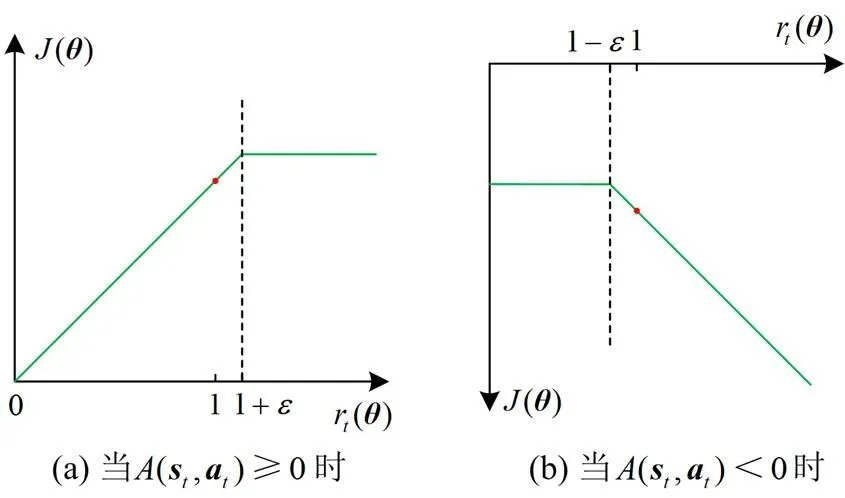

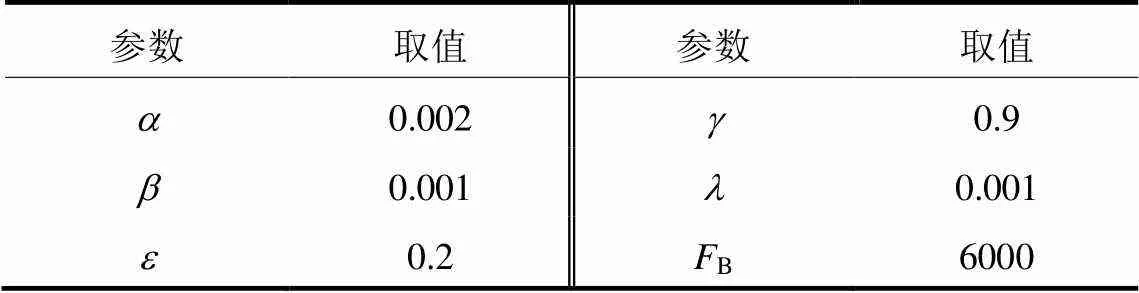

3.1 PPO算法原理

PPO算法的Actor网络和Critic网络相互独立,拥有不同的损失函数和权重更新方式,其训练过程如图2所示。算法训练过程主要包括3部分内容:一是Actor网络与环境进行交互并将获得的关键信息存储在经验池内;二是利用Critic网络计算状态价值和折扣奖励,进而计算优势函数并对Critic网络进行权重更新;三是利用采样网络计算重要性采样比,从而对Actor网络进行权重更新。其中采样网络权重与Actor网络权重完全一致,但更新滞后于Actor网络。

3.1.1 Critic网络训练

根据梯度下降算法更新Critic网络权重,更新方式为

3.1.2 Actor网络训练

图3 损失函数与重要性采样比的函数示意图

根据梯度上升算法更新Actor网络权重,更新方式为

3.2 应用流程

利用深度强化学习方法求解IES动态调度问题的框架如图4所示。

图4 动态调度问题求解流程

深度强化学习模型的训练结果与环境的初始状态关系密切,为降低利用训练完成的模型获得调度结果的偶然性,同时为进一步提升模型在应对源荷不确定性时的适用性,将模型训练过程中每轮训练的初始状态以随机抽样的方式获得,并从经验池随机抽样小批量样本对智能体的网络权重进行训练更新。利用训练数据对基于PPO算法的深度强化学习模型完成离线训练后将模型保存并应用于IES的动态调度决策。

4 算例仿真与分析

本节以图1所示的IES作为算例进行仿真研究,通过对比分析不同时间尺度和不同调度方法下的求解结果,验证本文所提方法的有效性。

4.1 算例仿真设置

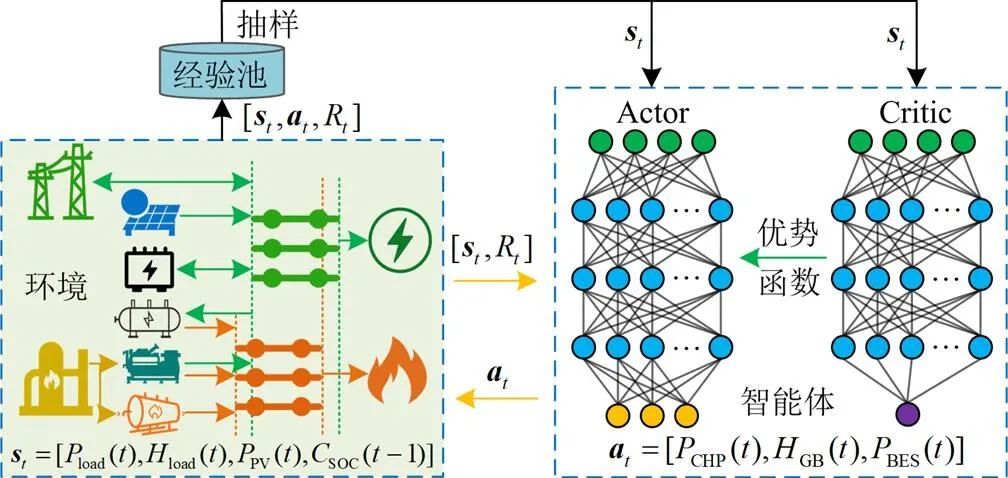

IES中的电负荷、热负荷和光伏出力数据来源于国内某重点项目园区,该数据包含随机性,能充分体现IES中源与荷的不确定性。系统内设备的运行参数见表1,设备的其他参数见表2[22-23]。

IES与主电网交互功率范围为[-2.5, 2.5] MW,天然气购买量的范围为[0, 400] m3,电储能的容量为2 MWh。系统电价采用如表3所示的分时电价,其中谷时段为23:00—07:00,平时段为07:00—12:00、19:00—23:00,峰时段为12:00—19:00。天然气单价为固定价格3.95元/m3,天然气热值为9.88 kW/m3,电功率和热功率的供需不平衡单价均为固定价格0.3元/kWh。

表1 IES设备的运行参数

表2 IES设备的其他参数

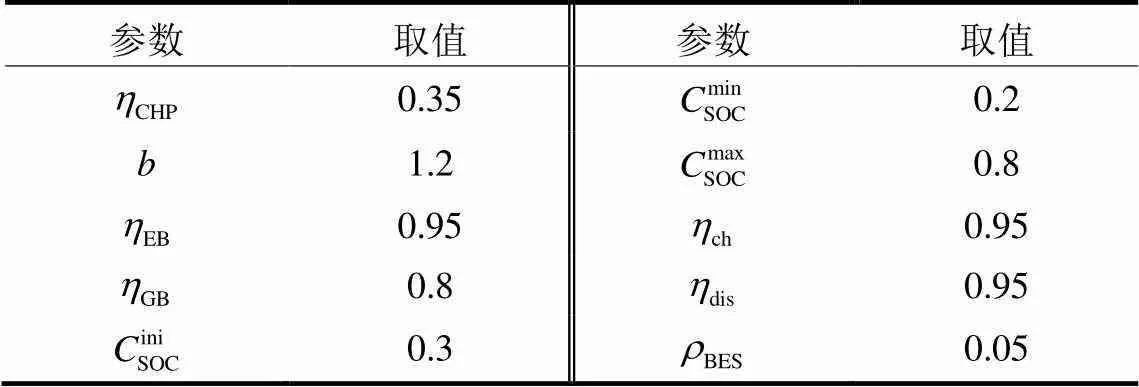

本文提出的深度强化学习方法通过TensorFlow平台实现。智能体接收电负荷、热负荷和光伏出力的训练数据后对深度强化学习模型进行训练,训练过程中的超参数依据经验值选取,并根据参考文献和训练过程做动态调整,直至算法收敛至最大奖励值。深度强化学习模型Actor网络和Critic网络的隐藏层层数均为3,每层含有64个神经元,隐藏层的激活函数均为ReLU,网络权重更新采用Adam优化器。经验池的大小为1000,小批量样本数为96,模型训练轮数为10 000,剩余的其他超参数见表4。

表4 其他超参数

4.2 动态调度结果分析

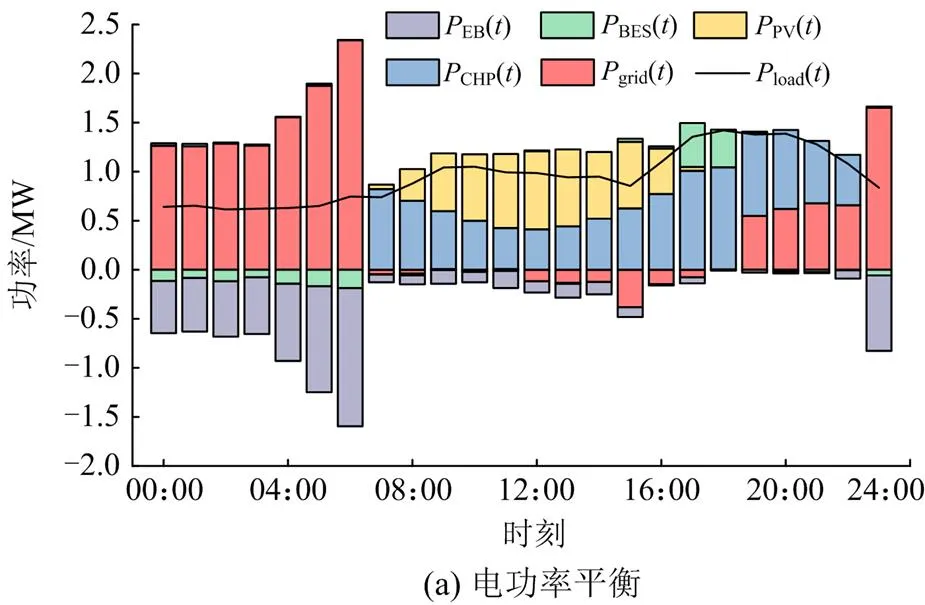

首先选取系统调度总时段为24 h、时间尺度大小为1 h的测试数据进行求解分析,求解结果如图5和图6所示。

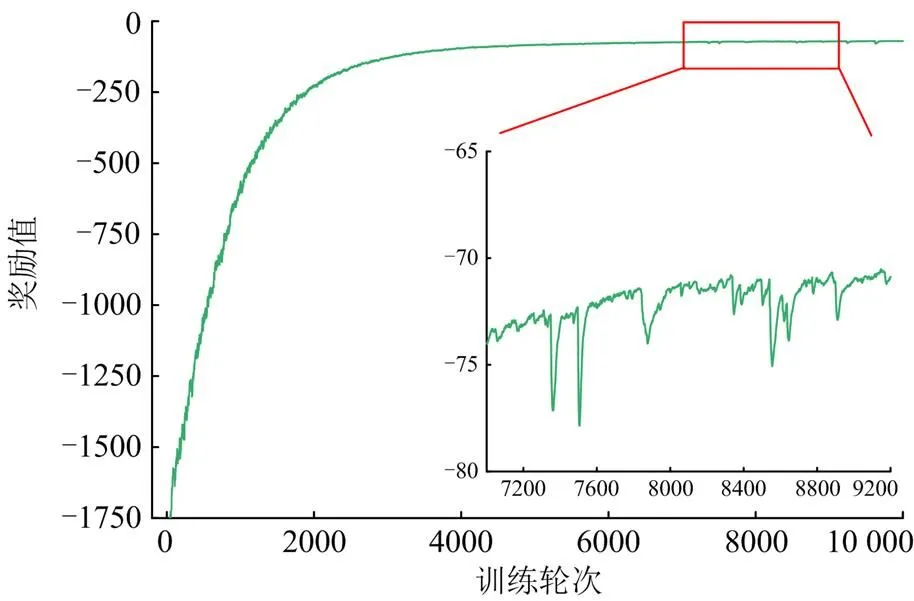

图5是模型训练过程中智能体奖励值随训练轮数的变化曲线。从图5中可以看出该模型经过约7000轮训练后收敛,训练初期智能体对环境不熟悉,智能体做出调度决策时获得的奖励值较小。随着训练的进行,智能体与环境不断交互并积累经验从而更新网络权重,因此智能体的奖励值会逐渐增大直至收敛,训练过程中奖励值的波动性来自于源荷的不确定性。

图5 智能体训练过程的奖励值变化

图6是时间尺度大小为1 h时系统电功率和热功率的动态调度结果。从图6(a)可以看出,系统与主电网交互的电功率是跟随电价变化的。在电价的谷时段,系统从主电网购电满足电负荷需求;在电价的平时段和峰时段,电负荷主要由热电联产机组和光伏出力满足,而且在峰时段系统将热电联产机组多产生的电能售给主电网,如12:00—15:00时段等。电储能设备通过在电价谷时段充电并在电价峰时段放电来降低系统运行成本,如04:00—07:00时段和17:00—18:00时段。从图6(b)可以看出,电锅炉输出的热功率同样跟随电价变化,在电价谷时段,系统热负荷主要通过电锅炉购电制热来满足;在电价平时段和峰时段,系统热负荷主要由热电联产机组和燃气锅炉满足。

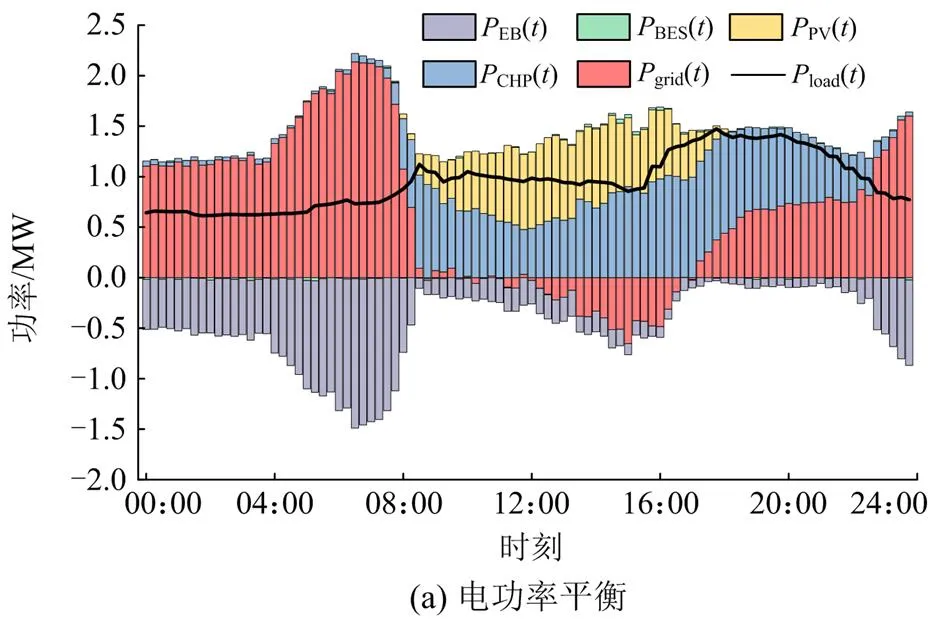

本文所构建的深度强化学习模型具有良好的扩展性和适应性,可以方便地应用至不同时间尺度的动态调度问题,只需在模型训练时调整与环境的交互步长。图7展示的是时间尺度为15 min时相应的动态调度结果。

从图7可以看出,系统与主电网交互的电功率和电储能设备的充放电情况基本跟随电价变化。在电价的谷时段,系统从主电网购电满足电负荷需求,同时利用电锅炉购电制热满足热负荷需求。在电价的峰时段和光伏出力较大的时段,系统通过向主电网售电来降低系统运行成本。

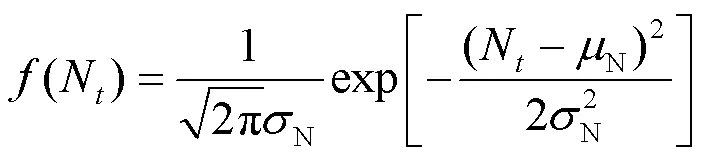

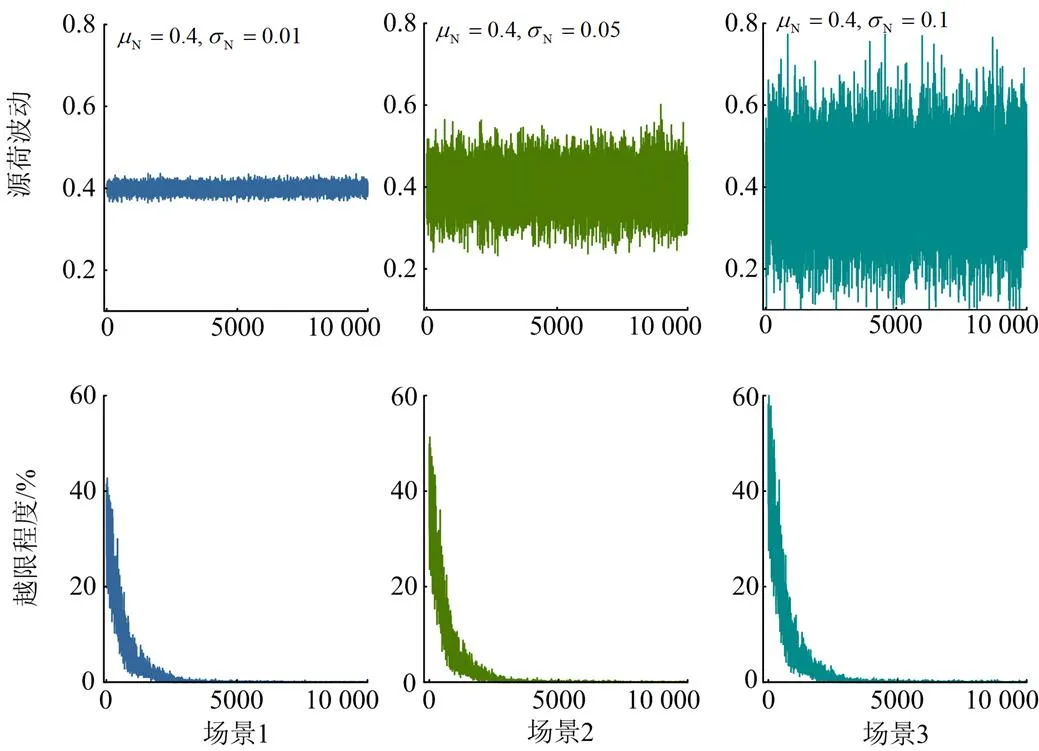

图8 不同场景下训练过程智能体的动作越限变化

场景1:将电负荷、热负荷和光伏出力功率波动偏差的期望均设置为0.4,标准差均设置为0.01。

场景2:将电负荷、热负荷和光伏出力功率波动偏差的期望均设置为0.4,标准差均设置为0.05。

场景3:将电负荷、热负荷和光伏出力功率波动偏差的期望均设置为0.4,标准差均设置为0.1。

从图8可以看出,随着源荷不确定性增加,训练过程中智能体动作均被约束在限定范围内,从而说明深度强化学习模型能够自适应学习系统中源荷的不确定性,而无需在模型中进行人为假定。

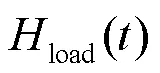

图9 部分设备的热功率变化

由图9可知,考虑热力损耗之后各类设备能够自适应调整输出功率以满足园区的负荷需求,在电价的平时段和峰时段,热电联产机组和燃气锅炉输出热功率的变化较为明显;在电价的谷时段,电锅炉输出热功率的变化较为明显,因此本文提出的方法对实际运行系统具有较好的跟踪学习能力。

4.3 敏感性分析

为分析奖励函数的关键参数对本文所提方法的影响,选取6组典型参数对模型进行训练并求解,图10展示了不同参数下智能体在训练过程中奖励值的变化情况,图11展示了不同参数下热电联产机组电功率的调度结果。

图10 不同参数下训练过程智能体的奖励值变化

图11 不同参数下热电联产机组电功率的调度结果

由图10可知,智能体的奖励值在不同参数下均可以实现较好的收敛。奖励函数的缩放系数会影响训练过程收敛值的大小,但不会影响收敛速度;而奖励函数的惩罚基值B会影响训练过程的收敛速度,但不会影响收敛值的大小。

由图11可知,热电联产机组输出的电功率跟随购电电价的变化而变化。在购电电价的谷时段,热电联产机组输出的电功率较小,缩放系数和惩罚基值B对输出功率的影响较小;在购电电价的平时段和峰时段由于电价的提高和光伏对系统电功率的补充,热电联产机组输出电功率的变化情况如图中所示,缩放系数和惩罚基值B会影响热电联产机组输出电功率在各时段的协调,但对系统运行总成本维持在较低水平的目标影响较小。

4.4 对比结果分析

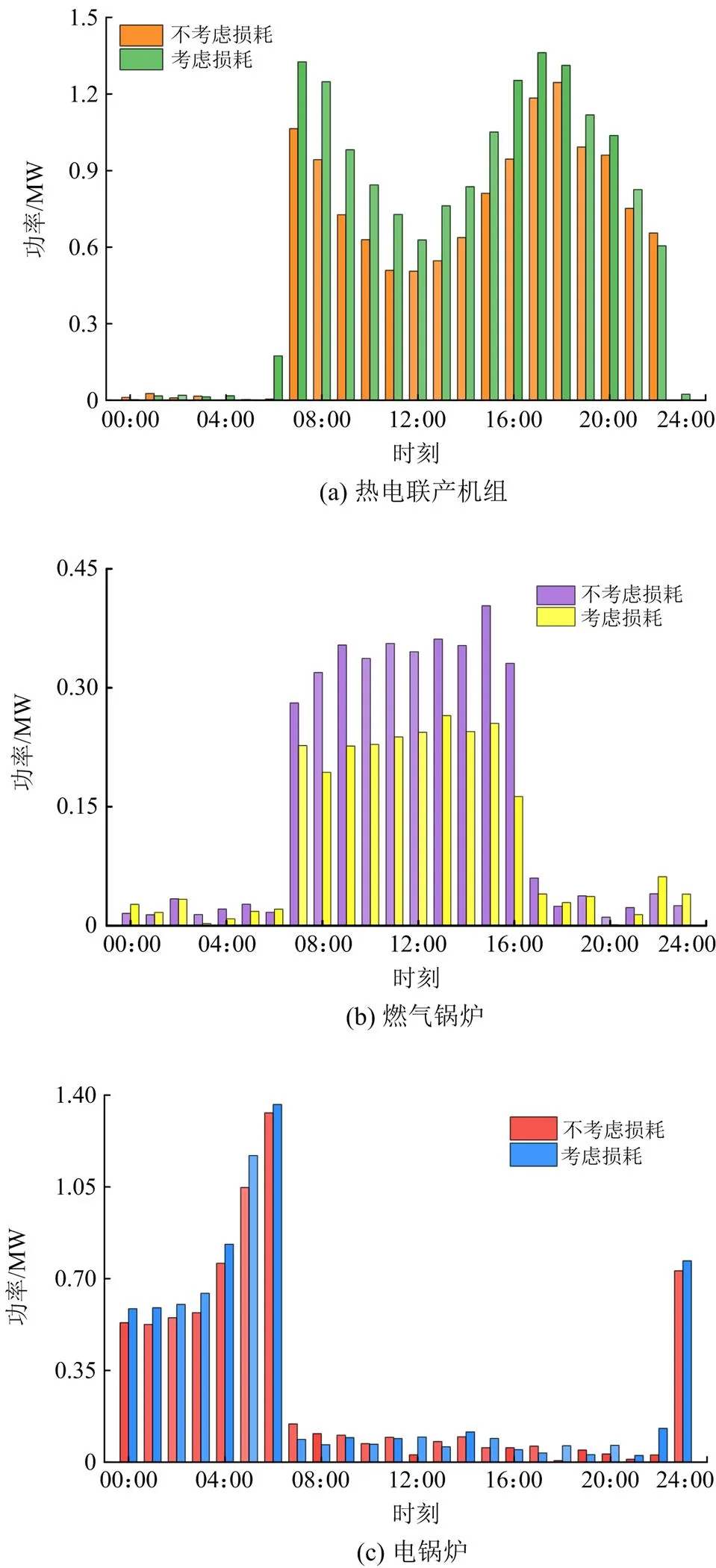

为进一步比较本文所提方法与其他调度方法的性能,将本文所提方法与基于DDPG算法的动态调度方法以及传统场景分析方法进行比较。从测试数据集中随机选取7个测试日并采用上述3种方法对得到的系统运行成本进行对比分析。其中调度总时段为24 h,时间尺度大小为1 h,传统场景分析方法采用求解软件进行求解,运行成本的统计结果如表5所示。

表5 不同调度方法的运行成本

从表5可以看出,基于PPO算法的平均日运行成本为31 222元;基于DDPG算法的平均日运行成本为31 778元,较PPO算法增加了1.78%;基于传统场景分析方法的平均日运行成本为32 327元,较PPO算法增加了3.54%。从日运行成本的最大值、最小值以及平均值来看,基于PPO算法的动态调度方法较其他两种调度方法获得了更好的经济性能,能有效地降低系统运行成本。

5 结论

本文提出了一种基于深度强化学习的IES动态调度方法,该方法将IES动态调度问题转化为具有连续状态和连续动作的强化学习问题来处理,有效解决了维数灾难和信息缺失而造成的模型求解困难问题,同时避免了对源荷的不确定性进行详细建模分析。

算例结果表明,本文所提方法能够较好地应对不确定性环境造成光伏出力和负荷变化的随机性;同时所构建的深度强化学习模型在不同时间尺度下具有较好的扩展性和适应性。与其他优化调度方法对比,本文所提方法在收敛性和经济性方面均具有较好的表现。

本文的研究重点在于满足能源供需平衡的前提下合理安排机组出力以保证IES的经济性,缺乏对实现调度决策机理的解释,未来将以数据驱动与物理模型相融合的方式对决策机理做进一步研究。

[1] 余晓丹, 徐宪东, 陈硕翼, 等. 综合能源系统与能源互联网简述[J]. 电工技术学报, 2016, 31(1): 1-13.

YU Xiaodan, XU Xiandong, CHEN Shuoyi, et al. A brief review to integrated energy system and energy internet[J]. Transactions of China Electrotechnical Society, 2016, 31(1): 1-13.

[2] WANG Y L, WANG Y D, HUANG Y J, et al. Optimal scheduling of the regional integrated energy system considering economy and environment[J]. IEEE Transactions on Sustainable Energy, 2019, 10(4): 1939-1949.

[3] 贾宏杰, 穆云飞, 余晓丹. 对我国综合能源系统发展的思考[J]. 电力建设, 2015, 36(1): 16-25.

JIA Hongjie, MU Yunfei, YU Xiaodan. Thought about the integrated energy system in China[J]. Electric Power Construction, 2015, 36(1): 16-25.

[4] KESHAVARZZADEH A H, AHMADI P. Multi-objective techno-economic optimization of a solar based integrated energy system using various optimization methods[J]. Energy Conversion and Management, 2019, 196: 196-210.

[5] 郑国太, 李昊, 赵宝国, 等. 基于供需能量平衡的用户侧综合能源系统电/热储能设备综合优化配置[J]. 电力系统保护与控制, 2018, 46(16): 8-18.

ZHNEG Guotai, LI Hao, ZHAO Baoguo, et al. Comprehensive optimization of electrical/thermal energy storage equipments for integrated energy system near user side based on energy supply and demand balance[J]. Power System Protection and Control, 2018, 46(16): 8-18.

[6] 帅挽澜, 朱自伟, 李雪萌, 等. 考虑风电消纳的综合能源系统“源-网-荷-储”协同优化运行[J]. 电力系统保护与控制, 2021, 49(19): 18-26.

SHUAI Wanlan, ZHU Ziwei, LI Xuemeng, et al. “Source-network-load-storage” coordinated optimization operation for an integrated energy system considering wind power consumption[J]. Power System Protection and Control, 2021, 49(19): 18-26.

[7] 刘洪, 陈星屹, 李吉峰, 等. 基于改进CPSO算法的区域电热综合能源系统经济调度[J]. 电力自动化设备, 2017, 37(6): 193-200.

LIU Hong, CHEN Xingyi, LI Jifeng, et al. Economic dispatch based on improved CPSO algorithm for regional power-heat integrated energy system[J]. Electric Power Automation Equipment, 2017, 37(6): 193-200.

[8] 崔杨, 闫石, 仲悟之, 等. 含电转气的区域综合能源系统热电优化调度[J]. 电网技术, 2020, 44(11): 4254-4264.

CUI Yang, YAN Shi, ZHONG Wuzhi, et al. Optimal thermoelectric dispatching of regional integrated energy system with power-to-gas[J]. Power System Technology, 2020, 44(11): 4254-4264.

[9] 袁泉, 吴云亮, 李豹, 等. 计及源荷不确定性的多时间尺度滚动调度计划模型与方法[J]. 电力系统保护与控制, 2019, 47(16): 8-16.

YUAN Quan, WU Yunliang, LI Bao, et al. Multi- timescale coordinated dispatch model and approach considering generation and load uncertainty[J]. Power System Protection and Control, 2019, 47(16): 8-16.

[10] 张大海, 贠韫韵, 王小君, 等. 考虑广义储能及光热电站的电热气互联综合能源系统经济调度[J]. 电力系统自动化, 2021, 45(19): 33-42.

ZHANG Dahai, YUN Yunyun, WANG Xiaojun, et al. Economic dispatch of integrated electricity-heat-gas energy system considering generalized energy storage and concentrating solar power plant[J]. Automation of Electric Power Systems, 2021, 45(19): 33-42.

[11] 郭尊, 李庚银, 周明, 等. 考虑网络约束和源荷不确定性的区域综合能源系统两阶段鲁棒优化调度[J]. 电网技术, 2019, 43(9): 3090-3100.

GUO Zun, LI Gengyin, ZHOU Ming, et al. Two-stage robust optimal scheduling of regional integrated energy system considering network constraints and uncertainties in source and load[J]. Power System Technology, 2019, 43(9): 3090-3100.

[12] 马国真, 林毓军, 张泽亚, 等. 计及源荷多重不确定性的综合能源系统鲁棒经济调度方法[J]. 电力系统保护与控制, 2021, 49(20): 43-52.

MA Guozhen, LIN Yujun, ZHANG Zeya, et al. A robust economic dispatch method for an integrated energy system considering multiple uncertainties of source and load[J]. Power System Protection and Control, 2021, 49(20): 43-52.

[13] 王成山, 吕超贤, 李鹏, 等. 园区型综合能源系统多时间尺度模型预测优化调度[J]. 中国电机工程学报, 2019, 39(23): 6791-6803, 7093.

WANG Chengshan, LÜ Chaoxian, LI Peng, et al. Multiple time-scale optimal scheduling of community integrated energy system based on model predictive control[J]. Proceedings of the CSEE, 2019, 39(23): 6791-6803, 7093.

[14] 乔骥, 王新迎, 张擎, 等. 基于柔性行动器-评判器深度强化学习的电-气综合能源系统优化调度[J]. 中国电机工程学报, 2021, 41(3): 819-833.

QIAO Ji, WANG Xinying, ZHANG Qing, et al. Optimal dispatch of integrated electricity-gas system with soft actor-critic deep reinforcement learning[J]. Proceedings of the CSEE, 2021, 41(3): 819-833.

[15] 王新迎, 赵琦, 赵黎媛, 等. 基于深度Q学习的电热综合能源系统能量管理[J]. 电力建设, 2021, 42(3): 10-18.

WANG Xinying, ZHAO Qi, ZHAO Liyuan, et al. Energy management approach for integrated electricity-heat energy system based on deep Q-learning network[J]. Electric Power Construction, 2021, 42(3): 10-18.

[16] NAUG A, AHMED I, BISWAS G. Online energy management in commercial buildings using deep reinforcement learning[C] // 2019 IEEE International Conference on Smart Computing (SMARTCOMP), June 12-15, 2019, Washington DC, USA: 249-257.

[17] SCHREIBER T, ESCHWEILER S, BARANSKI M, et al. Application of two promising reinforcement learning algorithms for load shifting in a cooling supply system[J]. Energy and Buildings, 2020, 229.

[18] 王磊, 姜涛, 宋丹, 等. 基于灵活热电比的区域综合能源系统多目标优化调度[J]. 电力系统保护与控制, 2021, 49(8): 151-159.

WANG Lei, JIANG Tao, SONG Dan, et al. Multi-objective optimal dispatch of a regional integrated energy system based on a flexible heat-to-electric ratio[J]. Power System Protection and Control, 2021, 49(8): 151-159.

[19] YU L, XIE W W, XIE D, et al. Deep reinforcement learning for smart home energy management[J]. IEEE Internet of Things Journal, 2020, 7(4): 2751-2762.

[20] PERERA A T D, WICKRAMASINGHE P U, NIK V M, et al. Introducing reinforcement learning to the energy system design process[J]. Applied Energy, 2020, 262.

[21] YANG T, ZHAO L Y, LI W, et al. Reinforcement learning in sustainable energy and electric systems: a survey[J]. Annual Reviews in Control, 2020, 49: 145-163.

[22] 杨挺, 赵黎媛, 刘亚闯, 等. 基于深度强化学习的综合能源系统动态经济调度[J]. 电力系统自动化, 2021, 45(5): 39-47.

YANG Ting, ZHAO Liyuan, LIU Yachuang, et al. Dynamic economic dispatch for integrated energy system based on deep reinforcement learning[J]. Automation of Electric Power Systems, 2021, 45(5): 39-47.

[23] YANG T, ZHAO L Y, LI W, et al. Dynamic energy dispatch strategy for integrated energy system based on improved deep reinforcement learning[J]. Energy, 2021, 235.

Dynamic dispatch of an integrated energy system based on deep reinforcement learning in an uncertain environment

LIN Weishan1, WANG Xiaojun1, SUN Qingkai1, LIU Zhao1, HE Jinghan1, PU Tianjiao2

(1. School of Electrical Engineering, Beijing Jiaotong University, Beijing 100044, China;2. China Electric Power Research Institute Co., Ltd., Beijing 100192, China)

As the uncertainties of intermittent energy and load in the integrated energy system gradually increase, traditional dispatch methods are limited to fixed physical models and parameter settings that can hardly respond to the random fluctuations in the dynamic system with source-load. In this paper, a deep reinforcement learning-based dynamic dispatch method for the integrated energy system is proposed to address this problem. First, a data-driven deep reinforcement learning model is constructed for the integrated energy system. Through the continuous interaction between agent and integrated energy system, the dispatch strategies are learned adaptively to reduce dependence on the physical models. Secondly, the variations of source-load uncertainties are characterized by adding random disturbances. Pivotal aspects such as state spaces, action spaces, reward mechanisms and the training process of the deep reinforcement learning model are improved according to the characteristics of uncertainties. Then a proximal policy optimization algorithm is used to solve the problem, and the dynamic dispatch decisions of the integrated energy system are realized. Finally, simulation results verify the feasibility and effectiveness of the proposed method over different time scales and in uncertain environments.

integrated energy system; dynamic dispatch; uncertainties; deep reinforcement learning; proximal policy optimization

10.19783/j.cnki.pspc.211685

2021-12-10;

2022-01-24

蔺伟山(1997—),男,硕士研究生,研究方向为人工智能在综合能源系统中的应用;E-mail: 20121455@bjtu.edu.cn

王小君(1978—),男,通信作者,博士,教授,研究方向为电力系统分析与控制、综合能源系统优化运行;E-mail: xjwang1@bjtu.edu.cn

孙庆凯(1992—),男,博士研究生,研究方向为人工智能在综合能源系统中的应用。E-mail: sunqingkai_123@ 163.com

国家自然科学基金项目资助(51977005)

This work is supported by the National Natural Science Foundation of China (No. 51977005).

(编辑 周金梅)