基于BERT-FHAN模型融合语句特征的汉语复句关系自动识别①

2022-09-20杨进才曹煜欣蔡旭勋

杨进才, 曹煜欣, 胡 泉, 蔡旭勋

1(华中师范大学 计算机学院, 武汉 430079)

2(华中师范大学 人工智能教育学部, 武汉 430079)

中文信息处理进程分为字处理、词处理、句处理、篇章处理4个阶段[1], 目前, 字处理和词处理方面的研究均取得了巨大的进展, 对句以及篇章的研究正在继续向前推进.

复句是由两个或两个以上的分句组成的句子[2], 汉语文本中复句占多数. 复句连接单句和篇章, 在篇章视野大范围内进行复句关系识别有助于加深对篇章句间语义关系的理解[3,4]. 因而可以广泛应用到机器翻译[5]、篇章分析[6]、自动问答[7]和信息抽取[8]等领域中.

复句的语义表达复杂, 复句的分类问题作为复句理论研究与应用研究的重要内容, 一直是汉语言学界关注的热点, 同时也是自然语言处理的难点. 目前, 在语言界最有影响的是《现代汉语》教材的分类和邢福义[2]在《汉语复句研究》(2001)中提出的复句三分系统. 三分系统将复句划分为因果、转折、并列大类, 又将这3大类依次划分为因果、假设、推断、条件、目的, 并列、连贯、递进、选择, 转折、让步、假转12个二级类. 本文采用三分系统的12个二级类作为分类标准.

关系词(关系标记)用来连接复句的各个分句, 拥有关系词标志的复句被界定为有标复句[9]. 在有标复句中, 由于关系词的积极指向作用, 使得识别有标复句关系类别的准确率要高于无标复句[10,11]. 但在有标复句关系识别中存在如下困难: (1)搭配使用的关系词部分缺省, 余下的关系词可对应多种类别; (2)存在一部分跨类别的关系词.

例1. 你不说, 我们<也>查得出你姓甚名谁!(吴强《红日》)

例2. 条件不同, 面临的任务<也>不同. (《邓小平文选》)

在例1与例2中, 关系词均为“也”, 但对应的关系分别为让步与因果.

1 相关工作

从中文信息处理角度对复句类别自动识别的方法包括: 利用规则、结合规则和机器学习、利用深度学习的方法3类. 李艳翠等[12]以有标的清华汉语树库作为研究对象, 抽取显式和隐式的自动句法树的规则特征, 判定复句关系类别; 杨进才等[13]把已知的复句句法、关系词搭配等知识结合在一起, 以非充盈态二句式有标复句为研究对象, 鉴定复句所属关系类别; 杨进才等[14]探索复句字面及内部语法等特征, 并总结特征形成规则, 判断复句所属的关系类别. 随着深度学习方法研究的不断发展, 因其可以自动获取特征, 所以被应用在复句类别识别的研究中. 孙凯丽等[15]将Bi-LSTM模型学习到的句内注意力多路特征与CNN建模得到的复句局部特征结合, 使用Inatt-MCNN模型对复句进行因果、并列、转折3大关系类别识别. 孙凯丽等[16]使用CNN和Bi-LSTM相结合的BCCNN网络和词聚类算法来捕获单词间的相似特征, 从而辅助计算机识别复句的关系类别.

深度学习不需要人工操作, 能够自己独立研究复句语料中的特征. 然而, 在深度学习过程中融入已有的、显然的、人们主动选择的外部知识, 对模型而言依然具有吸引力[17]. Qin等[18]以词性为句子特征, 联合词向量一起传输到CNN中, 来判断无标复句所属关系类别; 杨进才等[19]在CNN模型中融合关系词特征, 对非充盈态复句进行3类识别; 杨进才等[20]在Transformer网络中拼接关系词、词性的特征, 完成因果、假设、推断、条件、目的的因果类复句识别任务.

复句作为中文中出现频率最高的句子形态, 语言学界对复句的研究积累了丰富的知识. 前述的关系类别识别的利用规则、机器学习、深度学习的方法用到了这些语句特征, 本文探讨在深度学习模型中充分融入多种语句特征, 进行复句关系类别的识别.

2 复句文本特征表示

2.1 词向量表示

复句主要组成部分为词, 计算机将词处理成稠密的词向量表示[21], 词向量的表示效果影响着复句关系识别的准确率. 目前主流的词向量模型分为两类: 一类是以Word2Vec[22]为代表的词向量模型, 它分为连续词袋模型(CBOW)和Skip-gram模型, 另一类是最新的BERT词向量模型[23].

Word2Vec词向量模型利用输入的单词及其上下文信息, 在映射层中将信息整合, 由输出层输出对单词分析的结果. 但Word2Vec得到的词向量与对应的单词之间属于静态文本表示, 这种表示方式在解决一词多义问题上表现局限, 因而在某些任务中不能很好地动态优化. BERT模型在中文处理方面有很大的优势,它利用双向Transformer语言模型[24]进行预训练, 在不同单词间添加注意力机制将单词联合起来, 为解决中长期依赖问题提供了思路. 掩码语言模型和下一句预测是BERT的两种任务. 这两项任务使BERT不仅具备对目标句上下文进行预测的能力, 同时能够捕获句子间的深层语义关联. 因而, BERT文本表示比Word2Vec表达的语义更丰富, 内容更全面. 将例2输入BERT预训练模型, 获得的输入表示如图1所示. 句子开头和结束分别使用[CLS]和[SEP]标志表示, 复句映射的向量由词向量, 词在整个复句中的位置向量, 词在子句中的位置向量3部分组成.

图1 例2的BERT词向量组成

2.2 复句语句特征

2.2.1 候选关系词及类别特征

候选关系词(准关系词)是可以充当关系词的词,当候选关系词在一条复句中能够将各分句联系起来时,该候选关系词是关系词. 候选关系词的所属类别对识别复句的关系类别有着积极的指示作用. 因此, 候选关系词及其所属类别是至关重要的语句特征.

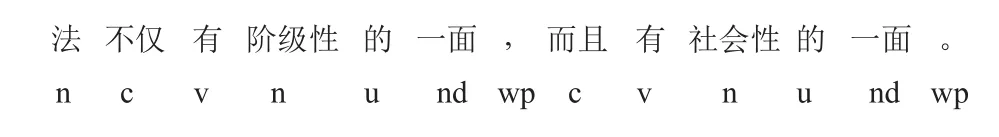

例3. 法不仅有阶级性的一面, 而且有社会性的一面. (《人民日报》1981年01月27日)

“不仅”“一面”“而且”“一面”, “一面”是复句存在的部分, 属于句中的方位名词, 它不是句子的关系词. 例3的两个分句由“不仅”“而且”连接, “不仅”“而且”属于递进关系类别. 例3是表示递进的复句.

2.2.2 词性特征

复句的各个单词均有与之相对应的词性, 词性反映了单词所具有的语法功能, 也约束了该词在复句中所充当的角色. 对例句3词性标注, 结果如图2所示.

图2 例3的词性标注图

例句3中“一面/一面”的词性都为nd (方向名词),它们属于复句的组成部分, 代表了句中的方位, 因此不是复句的关系词.

2.2.3 句法依存关系特征

法国语言学家特斯尼耶尔将句子中的词的关联构成句子的句法依存关系. 句法依存关系能够辨析复句中主、谓、宾、定、状、补的组成结构, 从复句的构成单元出发, 分析各个单元之间的相互关联, 加深对复句句法关系的理解. 5条公理[25]规定了句法依存关系,复句中有且仅有一个独立核心成分, 其他单词都与支配词有句法依存关系. 复句核心词的句法依存特征为HED (核心关系), 再依次抽取复句中其他单词与支配词之间的句法依存关系, 构成本文的句法依存关系特征. 将复句根据句法依存关系转换为相应的句法依存图, 例3分析结果如图3所示.

图3 例3的句法依存分析图

候选关系词依次为“不仅”“一面”“而且”“一面”, 与它们的支配词之间的句法依存关系分别为“ADV (状中关系)”“VOB (动宾关系)”“ADV”“VOB”. 关系词与其支配词之间出现频率相对较高的句法依存关系是状中关系, 而VOB关系常见于动名词之间的句法依存连接.从句法依存角度分析, 例3中的关系词为“不仅”“而且”, 它是一条表示递进关系的复句.

2.2.4 语义依存关系特征

语义依存和句法依存形似, 它们都是一种框架, 用以直观描述语言内部结构. 而不同的是, 语义依存采用单词的语义结构特征来阐述复句中单词彼此之间的关系, 它着重分析实词在句中的语义关联以及逻辑关联.语义依存不会随着语句结构变化而变化, 它能够超越句子表层的句法结构, 更进一步得到句子的语义信息.通过分析句子的语义依存关系, 能够明晰词汇在复句中所承担的语义角色. 语义依存关系中, 复句有且仅有一个核心词汇, 其他词汇与支配词间均有语义依存关系. 核心词的语义依存关系特征为Root (根节点), 依次抽取复句中其他单词与其支配词之间的语义依存关系,构成本文的语义依存关系特征. 将语义依存关系转换成相应的语义依存图, 例3分析结果如图4所示.

图4 例3的语义依存分析图

由图4知, 候选关系词依次为“不仅”“一面”“而且”“一面”, 与它们的支配词之间的语义依存关系分别为“mRELA (关系标记)”“LINK (系事关系)”“mRELA”“LINK”. 关系标记是关系词与其支配词之间多见的语义依存关系, 而系事关系表示的是与事件相关联的客体, 表示“一面”在例3中是方位名词, 不是句子的关系词. 因此, 例3句由“不仅”“而且”连接, 表示递进关系.

2.3 融合语句特征的文本表示

将单词的文本表示分别与候选关系词 (candidate relational words, CRW)、词性 (part of speech, POS)、句法依存关系 (grammar dependency relation, GDR)、语义依存关系 (semantic dependency relation, SDR)排列组合得到的语句特征拼接作为复句的文本特征表示.具体表示如下, 对于一个长为L的, 含有n个单词的句子, 第i个单词文本表示为Wi(i=1,…, n), 其候选关系词特征为CRWi, 词性为POSi, 句法依存关系为GDRi,语义依存关系记为SDRi.

候选关系词特征表示如式(1)所示, flag为候选关系词是否为关系词的标志, relation是候选关系词所属类别的关系矩阵; 融合上述多个特征的第i个单词的词向量VecWi表示如式(2)所示:

在例3中, “不仅”的词向量为[0.3145324], 候选关系词标志为1, 候选关系词属于递进关系, relation是递进关系的特征矩阵, 词性为“c”, 句法依存关系是“ADV”,语义依存关系为“mRELA”. “不仅”融合多个特征的文本特征表示为[0.3145324, 1, 递进, 5, 4, 7].

3 基于语句特征的BERT-FHAN模型

为了研究语句特征对复句关系识别的影响, 本文利用BERT预训练模型动态表示复句文本, 并在HAN神经网络中融入外部语言学知识, 得到FHAN模型. 进而构建BERT-FHAN模型, 该模型结构如图5所示.

图5 BERT-FHAN模型结构图

3.1 词嵌入层

词嵌入层用机器能够识别的数字向量表示文本,使用第2.3节提出的融合复句语句特征的文本表示方法, 获得每个单词的特征文本表示VecW1, VecW2, …,VecWn. 将它们依次输入单词注意力机制层, 帮助机器捕获语义知识.

3.2 单词注意力机制

使用双向GRU来获取单词的进一步表示, GRU通过重置门、更新门模拟语言模型, 综合单词的上下文信息获取到每个单词的隐藏状态.复句中第i个子句的第j个单词单词的前向隐藏状态后向隐藏状态其计算公式为:

通过单词的前后向隐藏状态得到单词的编码表示信息hij:

在复句关系识别过程中, 不是所有单词对任务都有影响, 因而引入注意力机制来提取对复句语义表示起作用的单词的隐藏表示uij:

计算与单词隐藏表示ujt的相似性, 来判断单词的重要性, 通过Softmax得到单词的权重αij:

seni为uij和αij加权和, 它蕴含了分句i的信息:

3.3 句子注意力机制

GRU获取复句中第i个子句的前、后隐藏状态

通过子句的前后向隐藏状态得到子句的编码表示信息hi:

通过注意力机制来获取对复句语义表示起作用的子句隐藏表示信息ui, 将子句信息汇总得到复句的表示信息:

通过计算与子句隐藏表示ui的相似性, 来判断子句的重要性, 通过Softmax得到子句权重 αi, 最后获得复句的信息表示com_sen:

3.4 输出层

复句信息表示com_sen蕴含了复句L的所有信息,通过Softmax激活函数得到复句类别的分类结果result:

4 实验与分析

4.1 数据集

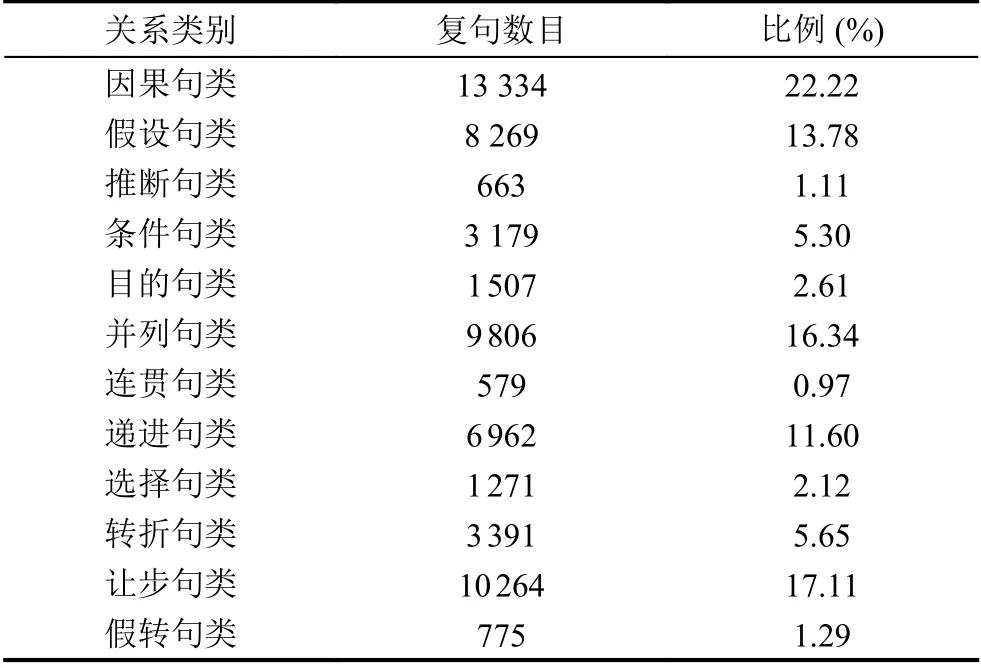

汉语复句语料库(the corpus of Chinese compound sentence, CCCS)[26]是目前针对有标复句研究的规模最大的语料库, 它共收录了65万余条有标复句, 数据主要源自《人民日报》与《长江日报》. 我们在CCCS语料库中添加随机因子并排序后, 从中选择了60 000条复句, 构成一个新的用于标注关系类别的语料库, 简记为CCCSRA (the corpus of Chinese compound sentence with relation annotation). 在CCCSRA语料库中, 各个类别的数据分布如表1所示. 将CCCSRA按照14:3:3的比例划分训练、测试、验证集.

表1 CCCSRA语料库数据分布表

4.2 实验参数

本文使用的是BERT预训练的768维词向量, 训练过程中为了使模型不产生过拟合的情况, 采用了dropout策略[27], 在神经网络中取舍. 同时, 实验借助L2正则项来提高模型的实际应用能力. 模型单词级、句子级注意力层的GRU的值设置为300. 详细的参数如表2所示.

表2 模型参数设置

4.3 对比实验

为了验证BERT-FHAN模型的性能, 我们在CCCSRA数据集上设置了几个基线模型: ① TextCNN模型[28],通过卷积层网络来捕获句子的文本特征, 依靠固定的filter窗口抽取特征进行分类; ② 带自注意力机制的Bi-LSTM模型[29], 通过双向LSTM提取每个词语上下文特征, 结合attention对每个词语加权求和, 使用Softmax激活函数进行输出; ③ Transformer模型, 使用encoder模型, 通过位置编码获取单词相对位置信息, 使用ReLU激活函数进行输出; ④ Inatt-MCNN[30], 对复句语义编码, 添加注意力机制, 之后通过CNN获得局部特征信息, 通过Softmax得到输出结果; ⑤ HAN模型[31], 通过多层注意力机制获得丰富的复句文本知识表示, 使用Softmax激活函数输出类别; ⑥ 结合BERT模型获取复句的动态词向量表示, 与HAN模型结合, 得到BERTHAN模型.

4.4 实验结果分析

本文使用准确率(Accuracy), 召回率(Recall), 精确率(Precision), F1值作为评估标准. 从图6可以看出,基线模型的准确率在80%以上, 这证明了实验中使用的深度学习模型均能够有效识别复句的关系类别. 其中, BERT-HAN模型的性能优于其他模型, 4项指标的值最高.

图6 基线模型的实验结果

为了进一步研究句子特征和不同的文本表示对汉语复句关系识别的影响, 我们分别在HAN和BERTHAN模型中融入CRW、POS、GDR、SDR排列组合的15种组合特征, 得到FHAN和BERT-FHAN模型.FHAN和BERT-FHAN模型的实验准确率如图7所示. 在BERT-FHAN模型上的实验结果如表3所示.

表3 BERT-FHAN融合不同语句特征的实验结果 (%)

从图7可知, 无论是Word2Vec还是BERT词向量表示方法, 融合不同语句特征, 模型训练后的准确率都在90%以上. BERT文本表示方法的准确率在Word2-Vec基础上有所提升. 这是因为BERT模型得到的词向量是动态的, 可以随复句的上下文而变化, 提升了机器识别复句语义关系的能力.

图7 FHAN和BERT-FHAN的实验准确率

从表3的实验结果可知, 融合了语句特征的实验结果与无语句特征的结果相比均有所提升. 当添加单个语句特征时, 实验准确度最高的是POS (词性), 其次是SDR (语义依存关系), 然后是GDR (句法依存关系),最后是CRW (候选关系词). 在所有特征组合中, “CRW+POS”组合特征的效果最好, 其准确度可达96.97%. 其次是融合“CRW+POS+SDR”组合特征, 它的准确率为96.88%. 组合多个句子特征的模型通常比单句特征模型结果更好, 这是因为融合单个特征时, 复句的复杂语义会在现有单个特征基础上产生一些歧义特征. 而多个语句特征的组合可以有效地消除这些歧义, 从而更好地发现复句中的语义关联, 准确地识别复句之间的关系.

“CRW+POS+GDR+SDR”组合特征融合了所有语句特征, 但它的准确率与最佳组合特征相比降低了0.6%.这是因为不同语句特征相互干扰, 阻碍特征独立表达,影响模型自动获取复句的内部特征; 除此之外, BERT动态文本表示与外部特征以及模型都能捕获句子的语义关联, 三者内部共同作用, 结果却适得其反. 在BERTFHAN模型的实验中, 以上所有特征组合的F1值的变化幅度很小, 表明此方法稳定性较强, 抛开少数的误差情况, BERT-FHAN模型能够正确判别复句关系.

在复句关系识别中, 一些关系词对应关系多种类别会给复句关系识别带来一定的困难. 经统计, CCCSRA语料库中有10 722条复句的关系词对应多种关系类别, 占比为17%. 由实验结果知, 融合不同语句特征的BERT-FHAN模型准确率均在95%以上, 证实了本文模型对含有一对多关系词的复句进行类别识别的有效性. 为进一步验证模型在复句类别识别中的两个困难问题上的适用性, 在融合“CRW+POS”特征的模型上,统计出测试集中含有跨类别关系词的复句总数及模型识别的正确率, 结果如表4所示. 模型在这些含有跨复句类别的关系词的复句上, 识别的正确率均超过87.5%, 统计结果表明文方法可适用在含有一对多关系词的复句关系识别任务上. 同时将测试集部分结果输出, 如表5所示. 语料中用缩写标注复句的关系类别,模型将测试集结果输出, 数值按照三分系统二级类的顺序依次输出, 0表示因果句, 1表示假设句, 2表示推断句, 依次类推. 由表4输出结果可知, 本文使用的模型能够正确输出测试集中含有这些关系词的有标复句的关系类别, 证明了本文方法的有效性.

表4 测试集中跨类别关系词统计情况

表5 测试集部分一对多关系词结果

5 总结

本文提出BERT-FHAN模型, 进行复句关系类别识别. 实验结果表明, BERT-FHAN模型在复句关系识别任务上相对于多个深度学习模型, 表现较好. 融入15种不同语句特征组合时, 实验结果较基线模型均有所提升, 其中, 融合候选关系词、词性语句特征得到的准确率最高. 充分证明了方法的有效性与适用性. 同时,发掘出对关系类别有显著影响的语句特征, 弥补了深度学习模型对特征利用的不可解释的不足.

在今后的工作中, 我们将进一步挖掘复句语句特征,研究在深度学习模型中更有效利用语言学研究的成果.目前, 无标复句关系识别的正确率还很低, 我们将探索借助有标复句关系识别来进行无标复句关系识别的方法.