基于注意力与特征融合的工程机械目标检测方法

2022-08-23吴靖赵尔敦林卓成秦文清

吴靖,赵尔敦,林卓成,秦文清

基于注意力与特征融合的工程机械目标检测方法

吴靖,赵尔敦,林卓成,秦文清

(华中师范大学,武汉 430079)

针对施工环境中工程机械目标大小不一、相互遮挡、工作形态各异等问题,提出一种基于注意力与特征融合的目标检测方法(AT–FFRCNN)。在主干网络中采用ResNet50和特征路径聚合网络PFPN,融合不同尺度的特征信息,在区域建议网络(RPN)和全连接层引入注意力机制,提高目标识别的能力,在损失函数中使用广义交并比(GIoU),提高目标框的准确性。实验表明,文中提出方法检测准确率比其他方法有较大提高,检测平均准确率(mAP)达到90%以上。能够较好地完成工程机械目标的检测任务。

目标检测;Faster R–CNN;注意力机制;特征融合

在施工现场中,工程机械目标常常是酿成安全事故的隐患,存在倒塌、侧翻等不稳定的因素,因此对工程机械进行目标检测是实现生产安全的重要一环。智能化的视频监控和影像分析可以实时了解施工现场的施工进度、秩序以及安全性。

近年来,基于深度学习目标检测方法的研究发展十分迅速,主要分为一阶段和两阶段的检测方法。一阶段的检测方法主要代表有YOLO[1]系列方法、CenterNet[2]、RetinaNet[3]、SSD[4]等,其特点是速度较快,候选框的生成和分类同时进行,将目标图片直接送入网络即可生成预测框;两阶段的检测方法有R–CNN[5]、Fast R–CNN[6]、Faster R–CNN[7]等,不同于一阶段的检测方法,两阶段方法将候选框的生成和分类分开进行,整体网络由提取区域建议网络RPN和公共特征层二者相结合而构成,检测精度相对较高。

施工场景的目标检测有以下难点:塔吊、挖机、吊车等工程机械目标形态、颜色各异;真实施工场景监控摄像头的位置距离目标较远,拍摄到的目标尺寸相差较大;目标与建筑物、目标与目标之间会出现相互遮挡的情况;受天气的影响,会存在光照不足或者背光的情况,导致目标不明显。

为了解决上述检测难点,文中基于Faster R–CNN提出一种基于注意力与特征融合的工程机械目标检测方法(AT–FFRCNN),其特点如下:在主干特征提取网络采用ResNet50,在特征提取网络之后加上特征路径聚合网络(PFPN),让网络能更好地学习不同尺度的特征;在区域建议网络(RPN)中引入注意力机制模块CABM(AT–RPN),实现对与目标有关的特征通道和空间位置赋予更多的关注,并在全连接层引入注意力机制进行增强(AT–FC),对目标建议框周围的建议框的特征向量赋予不同的权值并且进行融合,来更新目标建议框的特征向量;采用K–means聚类算法对样本集进行聚类,采用更适用于此问题的先验锚框(Anchor Box)宽高比(该问题场景计算出宽高比为1∶1.4、1∶1.7、1.5∶1);回归损失函数采用为广义交并比损失(GIoU),解决SmoothL1没有考虑预测框与真实框的重叠问题。

1 基于注意力与特征融合的工程机械目标检测方法

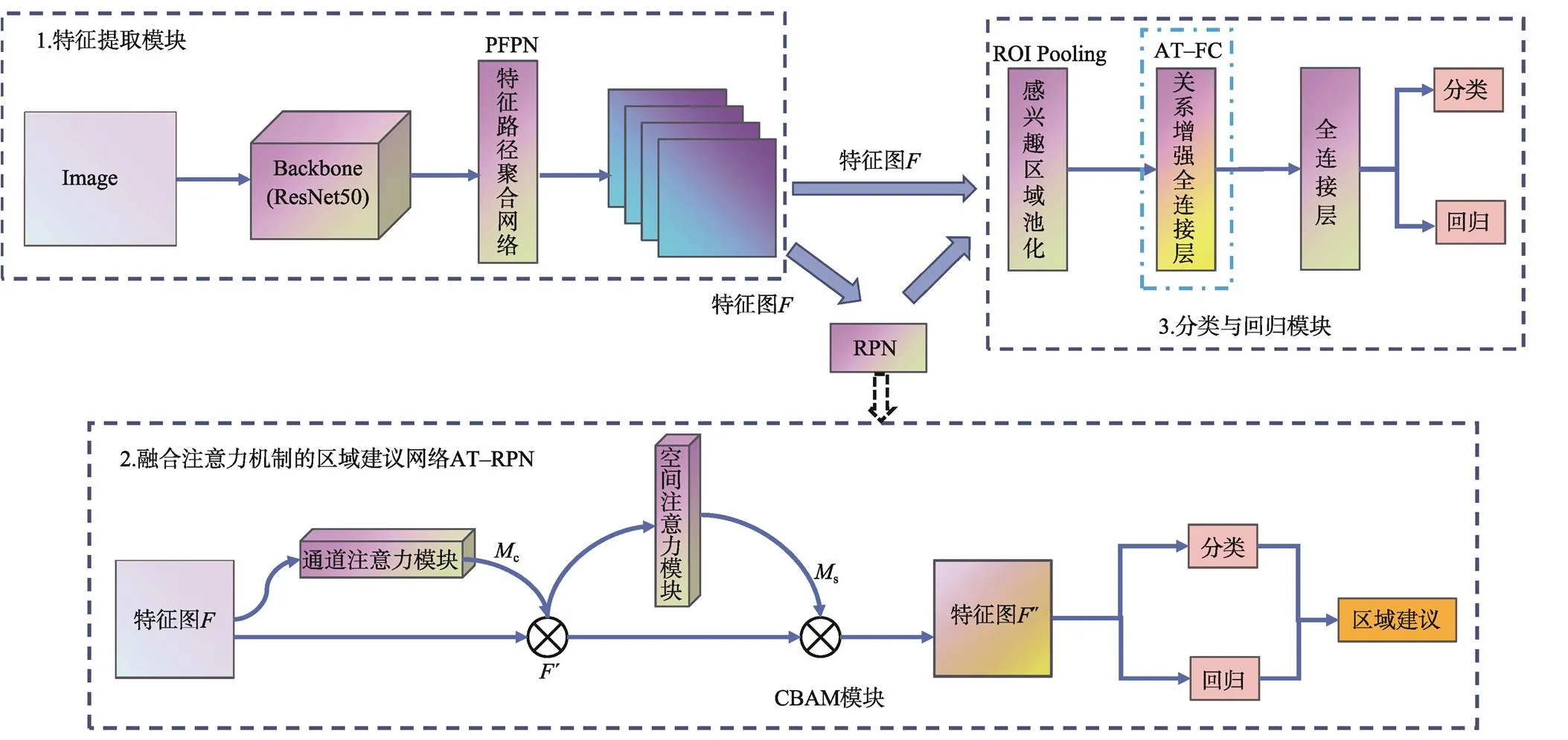

文中提出的AT–FFRCNN算法框架见图1,算法步骤如下。

1)首先将图片送入特征提取模块,经过主干网络ResNet–50和特征路径聚合网络PFPN后得到特征图。

2)接着将得到的特征图经过3×3的卷积之后得到特征图,随后将特征图送入融合注意力机制的区域建议网络AT–RPN,得到区域建议框。

3)将区域建议框映射到特征图上,得到一系列的特征矩阵,再对特征矩阵进行感兴趣区域池化,固定其尺寸大小。后将池化后的特征矩阵与目标建议框送入基于关系增强的全连接层,融合周围目标建议框,获取位置信息更精准的目标建议框,最后再送入分类与回归模块进行目标检测。

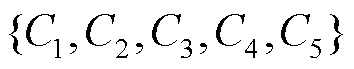

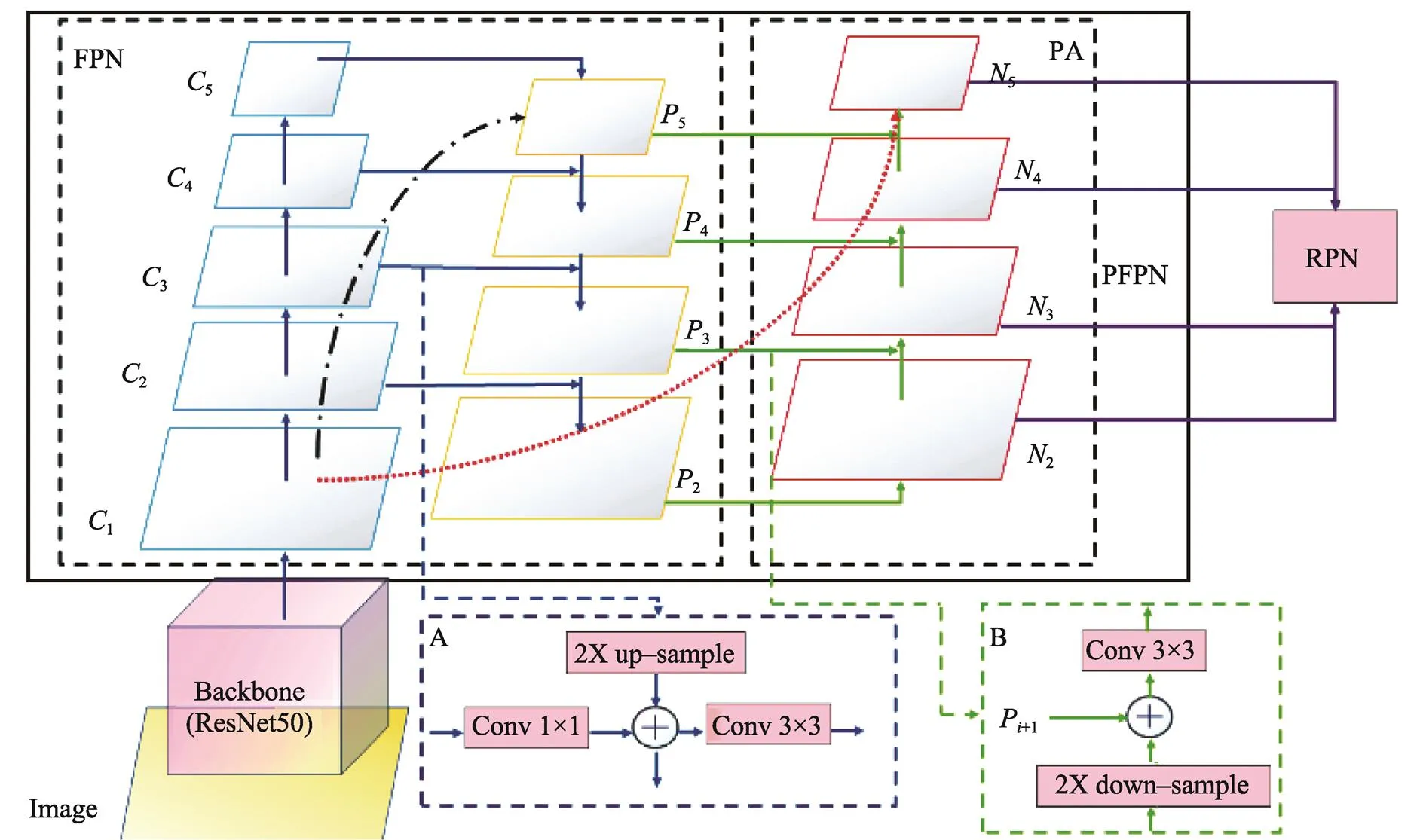

1.1 特征路径聚合网络PFPN

文中将Faster R‒CNN的特征提取网络由VGG16[8]替换成ResNet50[9],虽然能够提取到更为精细的特征,提高了检测大目标的检测效果。由于加深了网络的层数,也丢失了较多的浅层语义特征[10],最终导致无法精准地检测出小目标。为了解决这个问题,文中基于特征金字塔网络FPN和实例分割网络(PANet)的思想[11],构造一种特征路径聚合网络(PFPN),其结构见图2。特征路径聚合网络PFPN主要由特征金字塔(FPN)和自下而上的路径聚合(Path aggregation,PA)组成。PFPN的具体工作流程如下。

图1 AT–FFRCNN算法框架示意图

由于PFPN添加了自下而上的路径聚合过程,相较于原始的FPN,能够更好地保留浅层特征信息,增加特征的表达能力,更有利于小目标的检测。这是因为FPN虽然增加了自上而下的特征融合操作,能够保留一定的浅层特征信息,但是由于主干网络较深,浅层特征信息经过了太长的路径到达深层,丢失的浅层信息仍然较多,如图2中长点划线所示。在增加了自下而上的路径聚合后,更好地保留了浅层特征信息,如图2中圆点线所示。

1.2 K-means锚框宽高比设置

1.3 融合注意力机制的AT-RPN网络

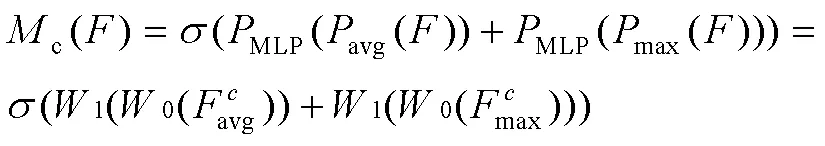

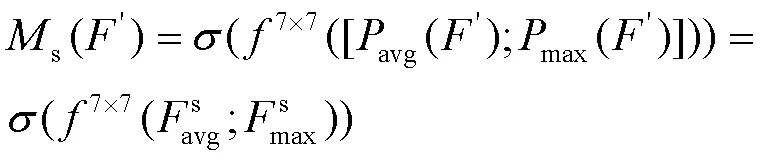

AT–RPN网络在RPN网络的基础上引入了注意力模块CBAM[12],提高RPN网络的目标分类与回归能力,获取更精细的目标候选框。CBAM包含通道注意力[13-14]和空间注意力,这两个部分相互连接、相互补充,能够突出图像中的目标特征抑制非目标部分(背景)的特征,而且还能突出目标的空间位置信息。

图2 PFPN网络结构

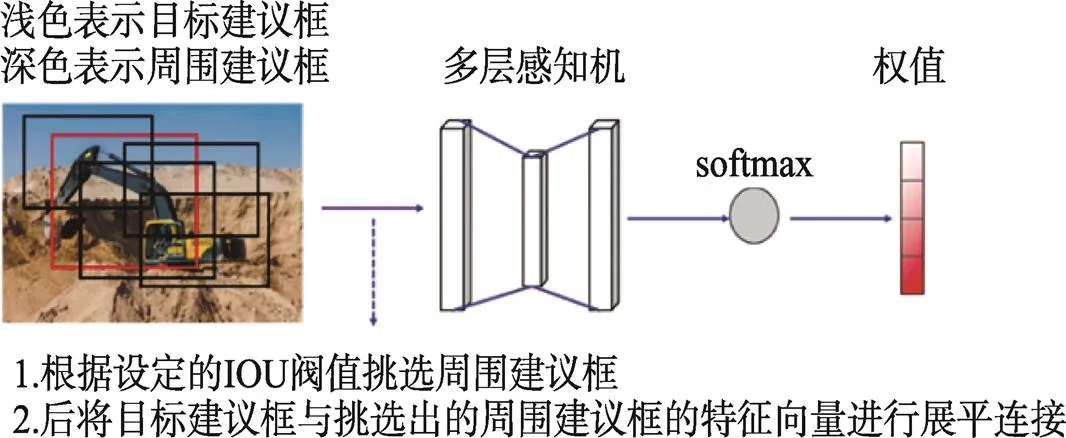

1.4 基于关系增强的全连接层AT–FC

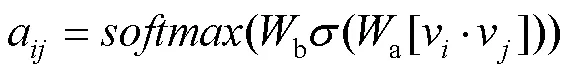

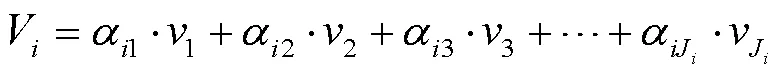

在AT–RPN网络之后,存在目标建议框与其交并比IoU较大的周围建议框,这些周围建议框与目标建议框之间存在一定的关系,其含有的位置信息能够帮助该目标建议框修正位置。为了使目标建议框的位置信息更精准,文中提出在RoI池化之后的全连接层引入注意力机制[15],构造了一种基于关系增强的全连接层AT–FC。AT–FC的原理见图3,运用注意力机制计算得出周围建议框与目标建议框位置信息的关系大小(权值),然后将这些周围建议框与其对应的权值相乘,以加权求和的方式融合并更新目标建议框。通过AT–FC更新之后,目标建议框的位置信息将更加精确。

图3 建议框融合算法

基于注意力机制的周围建议框融合算法步骤如下。

5)将更新后目标建议框特征向量送入后续全连接层,进行目标分类和位置回归定位。

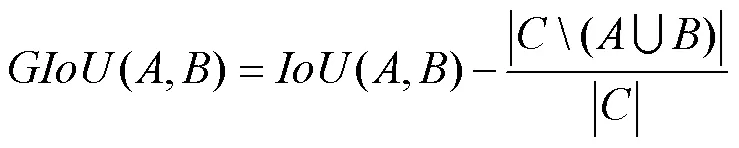

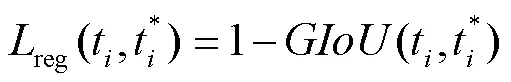

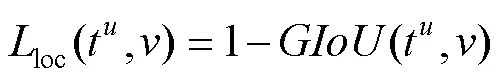

1.5 广义交并比GIoU

1.6 损失函数

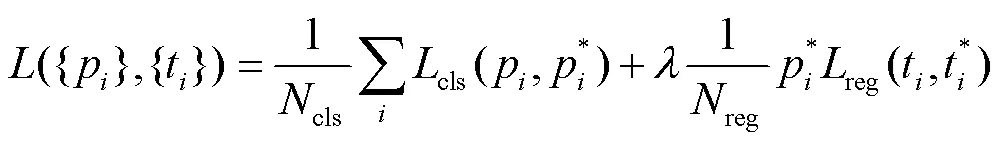

损失函数由2部分组成,分别是区域建议网络RPN的损失和分类与回归模块的损失。

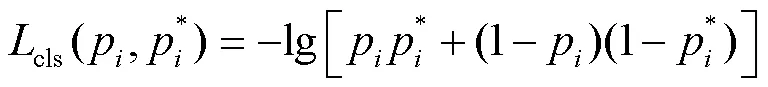

1.6.1 区域建议网络RPN损失

RPN网络包含锚框的分类与回归,其损失函数为:

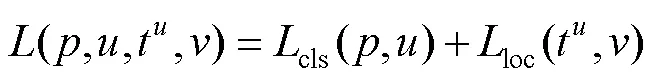

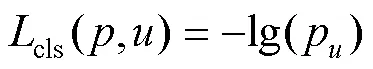

1.6.2 分类与回归模块损失

文中使用的损失函数为:

2 实验结果与分析

2.1 数据集与参数配置

文中收集了施工现场中3类机械目标的样本数据集,本数据集共包含有塔吊(crane)、挖机(excavator)和吊车(hoist)3类机械设备的图片共1 415张,其中991张为训练集,283张为验证集,141张为测试集。

文中实验采用带动量的随机梯度下降法(Stochasitc Gradient Descent,SGD)对网络进行训练,初始学习率为0.005,学习率更新策略采用的是Step,动量系数为0.9,学习率调整倍数为0.33,建议框融合算法阈值为0.7。

2.2 实验结果分析

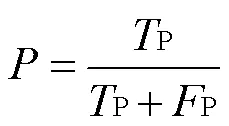

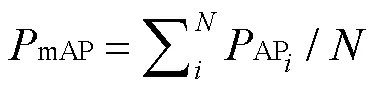

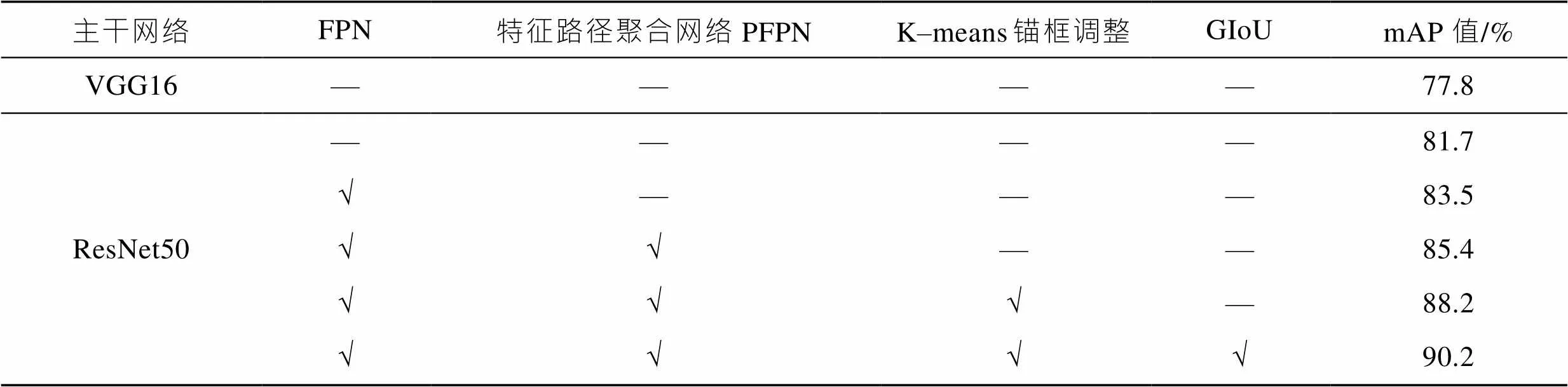

2.2.1 结果对比

与Faster R–CNN不同,AT–FFRCNN算法提出了多种模块,在文中的数据集下进行消融实验,探求各模块对实验效果的影响,实验对比结果见表1。表1中,mAP表示目标检测的评价精确率。由表1可知,Faster R–CNN网络的mAP值为77.8%,而将主干网络调整为ResNet50之后,mAP值提升了3.9%;在此基础之上加入特征金字塔网络FPN后,mAP值又提升了1.8%;引入文中构造的特征路径聚合网络FPFN后,mAP值则提升了1.9%。后继续通过K–means算法对样本聚类,修改RPN网络的锚框宽高比后,mAP值又提升了2.8%,最后在引入GIoU回归损失后,mAP值达到了90.2%。

表1 不同改进下的mAP对比

Tab.1 mAP comparison under different improvements

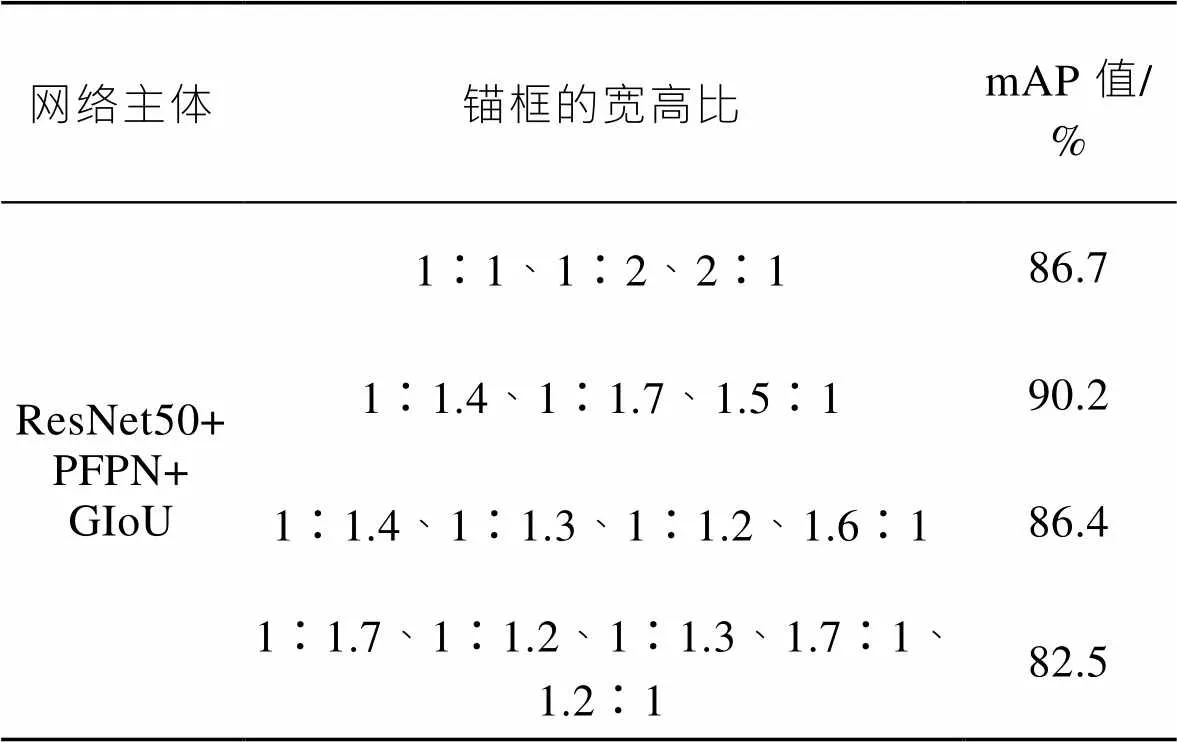

2.2.2 不同锚框宽高比的实验结果对比

利用文中K–mean聚类算法对锚框宽高比进行调整的多组实验结果见表2。从表2中可以得出,锚框的宽高比例并不是越多越好,也即K–means对样本聚的簇不是越多越好,最适合文中问题场景的锚框宽高比为1∶1.4、1∶1.7、1.5∶1,随着宽高比例数量的增加,模型的检测精度mAP值会变低。对比表格的第1行和第2行可知,相较于Faster R–CNN的默认锚框宽高比,使用K–means聚类算法对锚框宽高比进行调整后,网络模型的检测精度mAP值比初始Faster R–CNN提高了3.5%。

表2 不同锚框宽高比下的检测mAP

Tab.2 Detection mAP with different anchor box aspect ratios

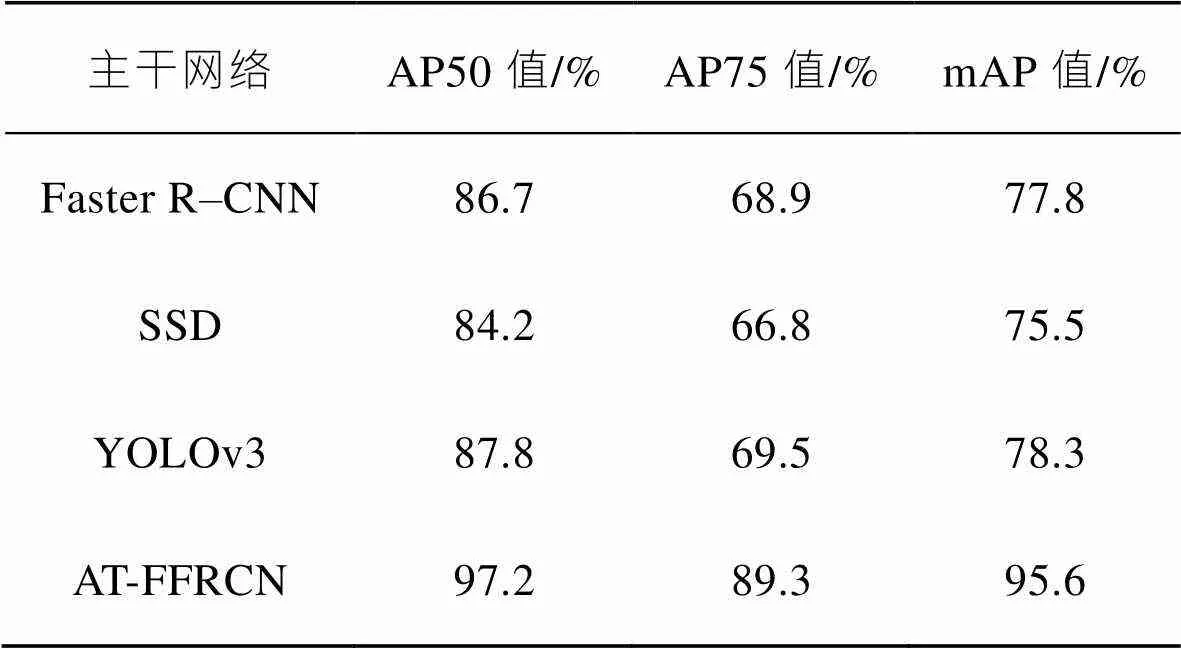

2.2.3 不同算法模型实验结果对比

为了验证文中提出AT–FFRCNN算法的效果,文中也与当前其他目标检测算法进行了对比,不同网络模型实验结果评价指标见表3。

从表3中可以看出,Faster R–CNN在使用文中数据集进行训练并在验证集上进行验证得到的AP50和AP75值分别为86.7%和68.9%,mAP值为77.8%。文中AT–FFRCN算法的AP50和AP75值相较于Faster R–CNN分别提高了10.5%、20.4%,并且mAP值达到了95.4%,在原来的基础上提升了17.8%。同其他目标检测算法比较,文中AT–FFRCN算法的各项指标均提高了不少,相较于SSD,AP50提高了13%,AP75提高了22.5%,mAP提高了20.1%,相较于YOLOV3,AP50、AP75、mAP则分别提高了9.4%、19.8%、17.3%,这也充分证明该算法在Faster R–CNN基础上的改进是有效的,能够解决文中引言中提出的问题。

表3 不同网络模型实验结果评价指标对比

Tab.3 Comparison of evaluation indicators of experimental results of different network models

注:评价指标AP50和AP75分别表示预测框与真实框交并比IoU值大于0.5和大于0.75的检测精度。

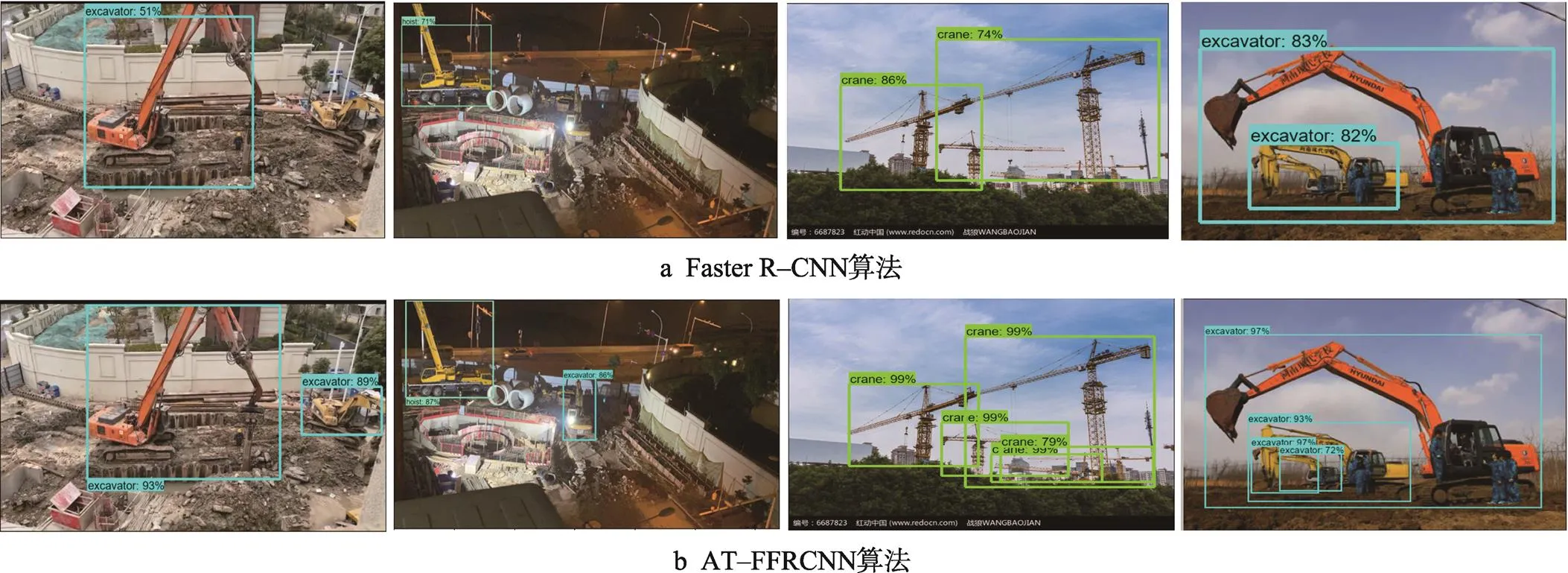

2.2.4 检测效果示例

图4是文中算法与Faster R‒CNN检测效果图,其中图4a为Faster R–CNN算法的检测效果,图4b为AT–FFRCNN算法对应的检测效果。可以看出,AT–FFRCNN检测出的工程机械目标准确率更高,位置信息也更准确,并且能够识别出尺寸较小和不明显的目标,针对Faster R–CNN在复杂场景目标遮挡、交叉的特殊情况下的漏检、错检问题有显著改善。

图4 2种算法的检测效果

3 结语

为实现对施工现场工程机械目标的准确检测,文中提出了基于一种基于多尺度特征融合的施工目标检测方法AT–FFRCNN。该方法采用了ResNet50作为主干特征提取结构,结合构造的特征路径聚合网络PFPN,提高了对不同尺寸目标的检测精度;使用GIoU和K–means锚框宽高比聚类算法,弥补了目标定位不准确的问题;在区域建议网络和全连接层引入注意力机制进行增强(AT–FC),提高了复杂环境中目标检测的能力。文中对设计的算法进行了相关对比实验,实验结果表明,文中提出的算法能实现对施工隐患目标更精准的检测,满足了实际应用的需求。

[1] REDMON J, DIVVALA S, GIRSHICK R, et al. You only Look Once: Unified, Real-Time Object Detection[J]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2016, 10: 779-788.

[2] DUAN KAIWEN, BAI SONG, XIE LINGXI, et al. CenterNet: Keypoint Triplets for Object Detection[C]// Proceedings of 2019 IEEE/CVF International Conference on Computer Vision, 2019: 6568-6577.

[3] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal Loss for Dense Object Detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(2): 318-327.

[4] LIU WEI, ANGUELOV D, ERHAN D, et al. SSD: Single Shot MultiBox Detector[C]// European conference on computer vision, Springer, Cham, 2016: 21-37.

[5] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[J]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[6] GIRSHICK R. Fast R-Cnn[C]// Proceedings of the IEEE international conference on computer vision. 2015: 1440-1448.

[7] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[8] SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Image Recognition[C]// International Conference on Learning Representations, 2015: 4011-4019.

[9] HE KAIMING, ZHANG XIANGYU, REN SHAOQING, et al. Deep Residual Learning for Image Recognition[C]// Conference on Computer Vision and Pattern Recognition. IEEE, 2015: 1212-1231.

[10] ZAGORUYKO S, LERER A, LIN T Y, et al. A MultiPath Network for Object Detection[J]. Computer Vision and Pattern Recognition, 2016,23(4):1604.

[11] LIU SHU, QI LU, QIN HAIFANG, et al. Path Aggregation Network for Instance Segmentation[C]// Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 8759-8768.

[12] WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional Block Attention Module[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 3-19.

[13] HU Jie, SHEN Li, SUN Gang, et al. Squeeze-and-Excitation Networks[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 7132-7141.

[14] WANG Q, WU B, ZHU P, et al. ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks[J]. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2020, Issue: 11531-11539.

[15] YANG JIANWEI, LU JIASEN, LEE S, et al. Graph R-CNN for Scene Graph Generation[C]// Proceedings of 15th European Conference on Computer Vision. Munich, Germany, 2018:670-685.

[16] REZATOFIGHI H, TSOI N, GWAK J, et al. Generalized Intersection over Union: A Metric and a Loss for Bounding Box Regression[C]// Proceedings of the 2019 IEEE Conference on Computer Vision and Pattern Recognition, 2019: 658-666.

Object Detection Method of Construction Machinery Based on Attention and Feature Fusion

WU Jing, ZHAO Er-dun,LIN Zhuo-cheng,QIN Wen-qing

(Central China Normal University, Wuhan 430079, China)

The work aims to propose an object detection method based on attention and feature fusion (AT-FFRCNN) aiming at the problems of different size, mutual occlusion and different working forms of construction machinery objects in the construction environment.ResNet50 and feature path aggregation network PFPN were used in the backbone network to fuse feature information of different scales, and an attention mechanism was introduced into the region proposal network (RPN) and fully connected layer to improve the ability of target recognition, and generalized intersection over union (GIoU) was used in the loss function to improve the accuracy of the object box.Experiments indicated that the detection accuracy of the proposed method was greatly improved compared with other methods, and the average detection accuracy (mAP) reached more than 90%. The proposed method can complete the detection task of the construction machinery better.

object detection; Faster R-CNN; attention mechanism; feature fusion

TP391

A

1001-3563(2022)15-0061-07

10.19554/j.cnki.1001-3563.2022.15.007

2022–06–09

吴靖(1997—),男,华中师范大学硕士生,主攻深度学习、机器视觉。

赵尔敦(1972—),男,博士,华中师范大学副教授,主要研究方向为机器视觉。

责任编辑:曾钰婵