一种面向无人车平台的无人机自主起降控制系统

2022-07-20时潮刘乔孙飞贾宇航代力白璇

时潮 刘乔 孙飞 贾宇航 代力 白璇

1.上海机电工程研究所;2.北方自动控制技术研究所

针对无人机在无人车上的自主降落问题,本文分解为两个阶段:基于机、车GPS 信息的导航飞行阶段和基于降落平台标志的精确视觉引导阶段。针对视觉引导无人机起降问题,本文设计了视觉伺服控制和模糊PID 控制两种方法,最后采用搭建的地空协同系统进行了机、车GPS 导航飞行实验和基于视觉引导的无人机自主起降实验,均达到了理想的效果。实验证实了本文提出的自主起降方案可行性和有效性。

无人车是智能交通系统的核心,研究无人驾驶技术的研究对于减少交通安全事故、缓解交通拥堵有着重要意义。现阶段,无人车研究仍然面临着环境感知范围小、非结构化道路适应能力差等技术难题。在机动灵活的无人机上搭载传感器,协同智能系统对于无人驾驶技术的研究有着重要意义。除此之外,地空协同系统在灾区救援、战场作战、环境侦查等领域也有着广阔的应用前景。而面向无人车平台的无人机自主起降控制将是地空协同中首个有待突破的技术难题。

无人机视觉着陆系统可以大致分为两类:第一类是将无人机降落在预定义的目标上,这种方法需要对无人机与降落平台的相对位置和姿态进行精确估计;第二类是将无人机降落在任意合适的区域上,其使用视觉算法检测足够平稳的着陆地点。文献[1-4]主要描述了旋翼式无人机在地面无人小车平台上的降落方法,而文献[5-8]主要对固定翼式无人机在舰船上的着陆方案进行研究。其中,文献[1]介绍了一套由小型旋翼式无人机和地面移动小车组成的混合系统,无人机能够从移动的小车上自主起飞,以恒定的速度跟踪它并且在运动的小车平台上降落。文献[4]展示了一套由小型无人机和地面无人车组成的混合系统,可共同协作执行室内搜救等任务,并且还设计了安装于无人车上的降落平台,从而起到承载、固定无人机的作用。除此之外,还有将无人机降落在地面指定地点的视觉着陆系统。文献[10]提出了一套地面红外立体视觉系统用于辅助降落,该系统的视觉传感器为两个红外摄像机,安装在两自由度的云台上,便于摄像机捕捉动态无人机目标,估计两者的相对位置。而文献[11]设计的降落系统采用机载的摄像机和处理器,通过识别地面上特定的标志物获得无人机与降落平台的相对位置,进而引导无人机降落。

与上述文献不同,本文以无人驾驶汽车作为地面平台,构建地空协同系统。对于无人机在无人车平台上的自主起降问题,本文提出一套完整的技术方案,并进行了地空协同系统的设计、搭建、试验调试等工作,实现无人机在静止的无人车平台上自主起飞、降落的功能。

1 总体方案

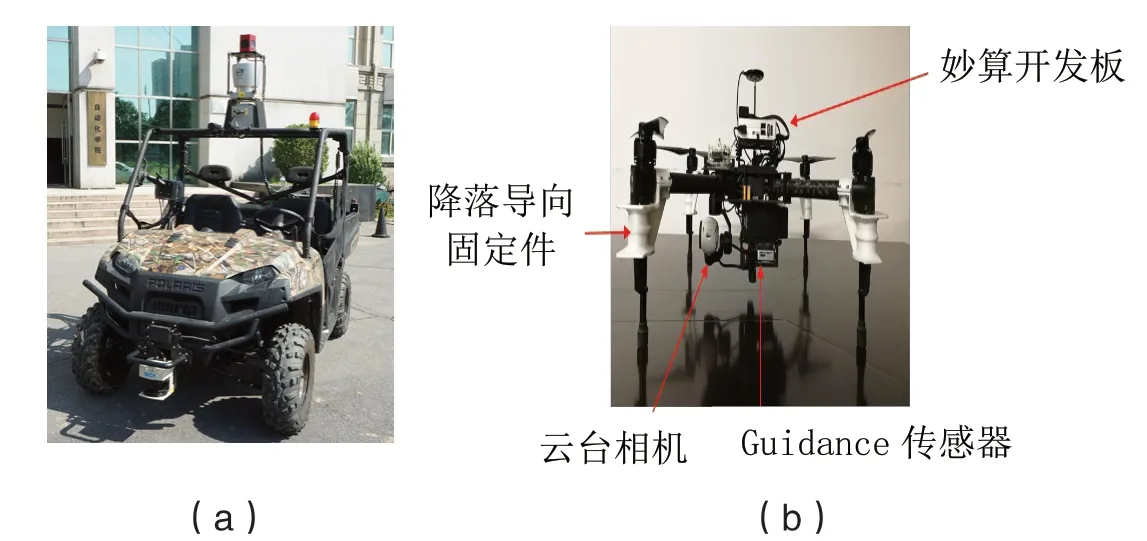

本文采用的无人车如图1(a)所示,从空间布局来看,无人车分为驾驶舱和后车厢两部分。驾驶舱顶部安装了激光雷达和全景摄像机等传感器,后车厢放置了电源、计算机组等功能模块,并且无人车上还安装了GPS 接收机实现定位功能。与固定翼无人机相比,旋翼式无人机具有机动灵活,可垂直起飞降落,定点悬停的优点,因此本文采用大疆公司研发生产的DJI Matrice 100(简称“M100”)四旋翼无人机,如图1(b)所示。

图1 无人车平台和无人机Fig.1 Unmanned ground vehicle and UAV

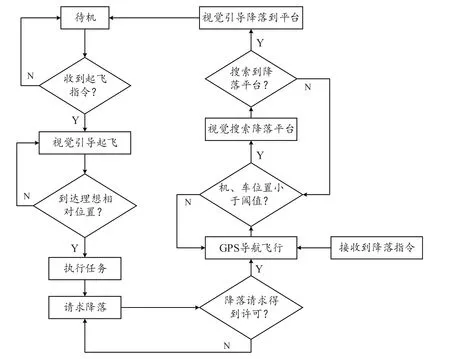

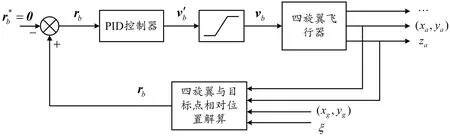

与固定翼无人机相比,旋翼式无人机具有机动灵活,可垂直起飞降落,定点悬停的优点,因此本文采用四旋翼式无人机。无人车和无人机都配备了GPS 接收机,虽然能够以此来计算两者的相对位置,但是得到的精度有限。无人车上装配了无人机降落平台,该平台安装了正交分布的视觉引导标志,并且无人车与无人机之间能够进行通信,无人车、无人机的任务指令、工作状态、GPS 位置等信息会通过通信模块进行交互。且本文采用视觉传感器来辅助降落,在降落平台上设置特征固定的引导标志,通过图像处理技术来实现视觉反馈。无人机自主起降控制系统的整体流程如图2 所示。

图2 无人机自主起降控制流程Fig.2 Autonomous takeoff and landing control flow chart

当无人机接收到无人车发布的起飞指令时,无人机起转电机并通过视觉反馈得到无人机与无人车的相对位置,当飞离无人车并距离其一定距离时,认为无人机完成了起飞任务。当无人机请求降落得到允许或者收到无人车发布的降落指令时,无人机通过当前机、车的GPS坐标计算得到与无人车的相对位置,以其为依据进行导航飞行,当到达无人车附近时,通过摄像机搜索降落标志从而获得更精确的相对位置,以此为反馈进行视觉引导直至降落到平台上。

2 控制策略设计

根据图2 所示的控制流程,控制策略包括GPS 导航控制和视觉引导控制两部分,其中,视觉引导控制部分设计了视觉伺服控制和模糊PID 控制两种控制方法。

2.1 GPS 导航控制

无人车和无人机平台上均搭载了GPS 接收机,输出数据为WGS-84 大地坐标系下的经纬度信息,两者之间的GPS 数据通过UDP 通信进行传输。

其GPS 信息经过通用横轴墨卡托投影后转换到北东平面坐标系,分别用(x

,y

)和(x

,y)表示无人车和无人机的坐标。通过无人机上的气压高度计可以得到无人机相对于无人车上降落平台的高度值,用z

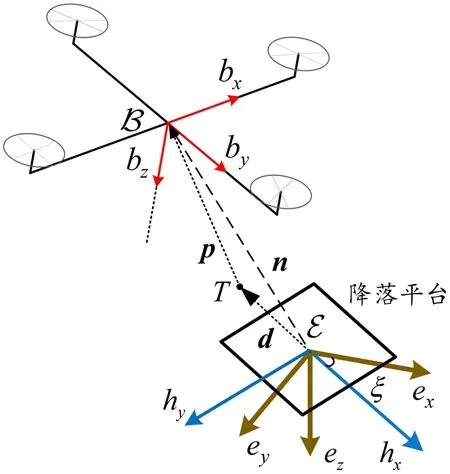

表示。图3 表示无人机与无人车的相对位置关系,其中h

轴代表无人车车头朝向,ξ

表示无人车的航向角,即h

轴与e

轴(北向)的夹角。

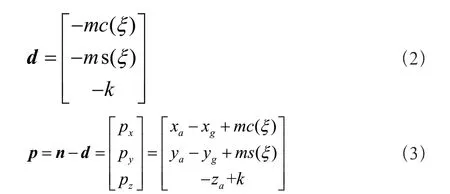

图3 无人机与无人车相对位置关系图Fig.3 The relative position relationship of UAV and UGV

如图3 所示,以无人车上GPS 天线为原点建立北东地直角坐标系E,由气压高度计得到的无人机相对于降落平台的高度为z

,无人机和无人车的相对位置在E 坐标系下的表示如式(1)所示:

T

点。T

在E 坐标系下的坐标为d

=[d d d

],且T

到无人机的空间向量为p

。假设导航目标点T

在无人车正后方m

米处,高度为k

米处,则有如式(2)-式(3)所示:

T

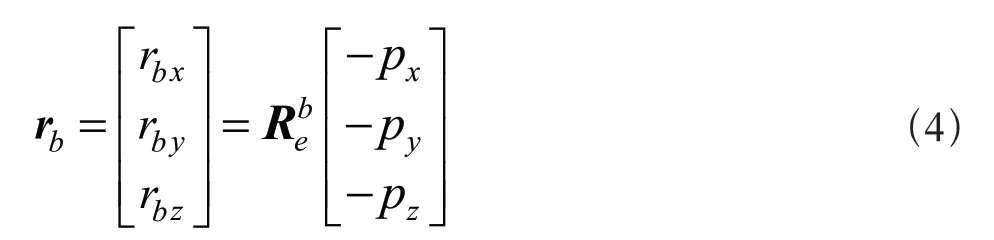

终点,构建无人机与目标点的相对位置向量r

,且有r

=-p

,其在机体坐标系下的表示记为r

=-p

,其表达式如式(4)所示:

T

,即r

=0,因此r

可被视为控制系统的误差输入。GPS 导航控制采用PID 控制器,机体坐标系下的线速度v

为控制器输出,并且出于飞行安全和避免超调量过大的考虑,对控制量进行输出限幅,则其控制框图如图4 所示。

图4 GPS 导航控制框图Fig.4 The control block diagram of GPS navigation

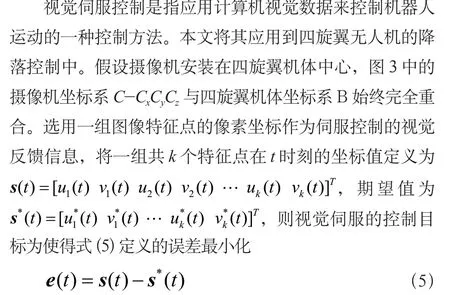

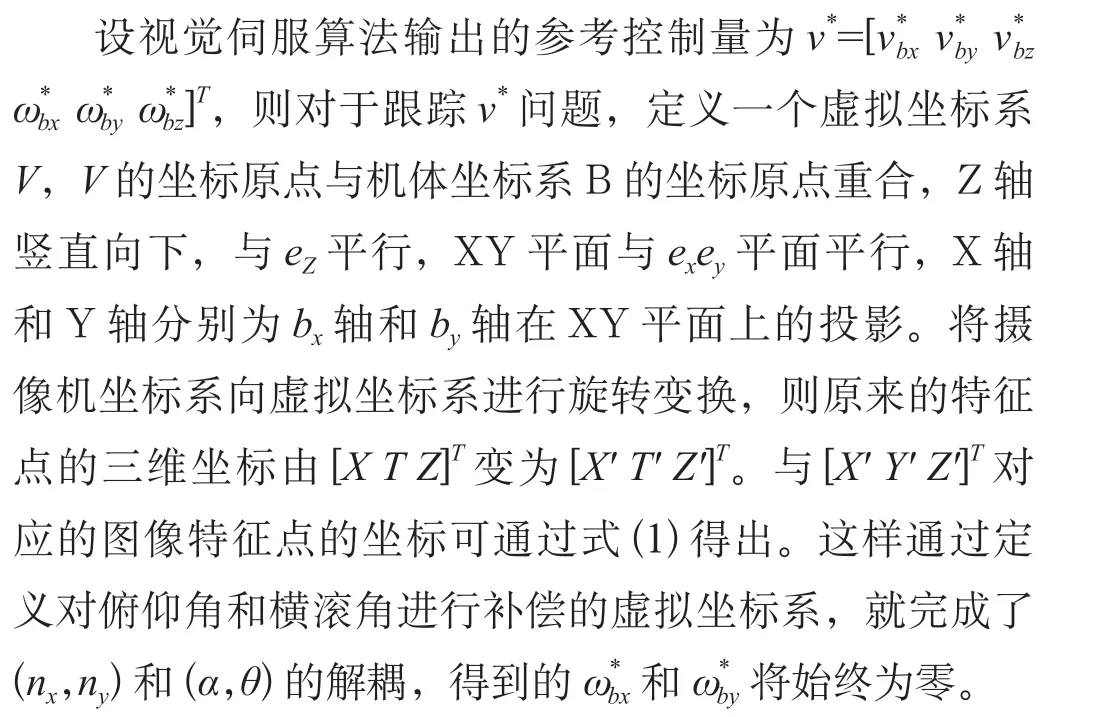

2.2 视觉伺服控制

s

(t

)是变化的,但是对于一个特定的引导阶段,s

(t

)是固定不变的。下文针对一个特定的引导阶段进行视觉伺服控制方法的讨论,这样可得如式(6)所示:

x

,y

,z

),在B 坐标系下的坐标表示为(X

,Y

,Z

),投影到图像平面的像素坐标为(u

,v

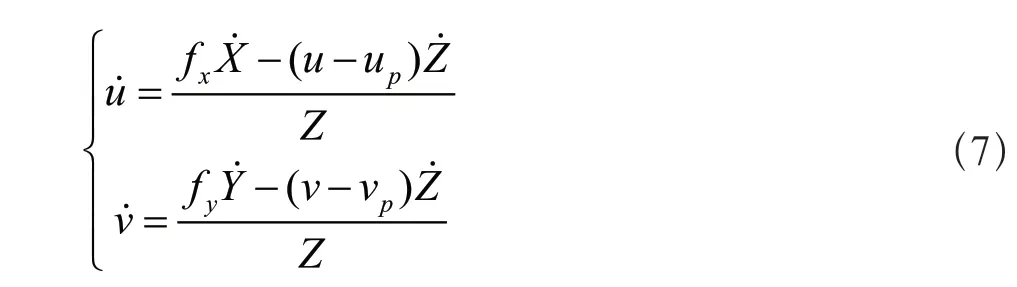

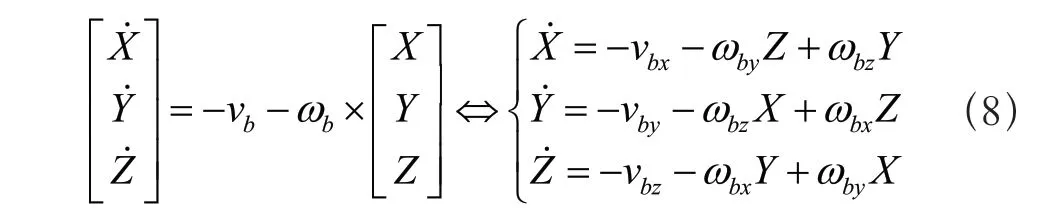

),可得如式(7)所示:

X

,Y

,Z

)的坐标对时间t

的一阶微分为如式(8)所示:

可得如式(9)所示:

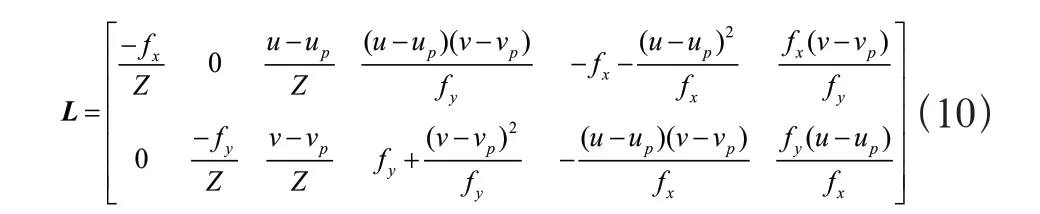

L

是(u

,v

)相关的图像雅克比矩阵,且有如式(10)所示:

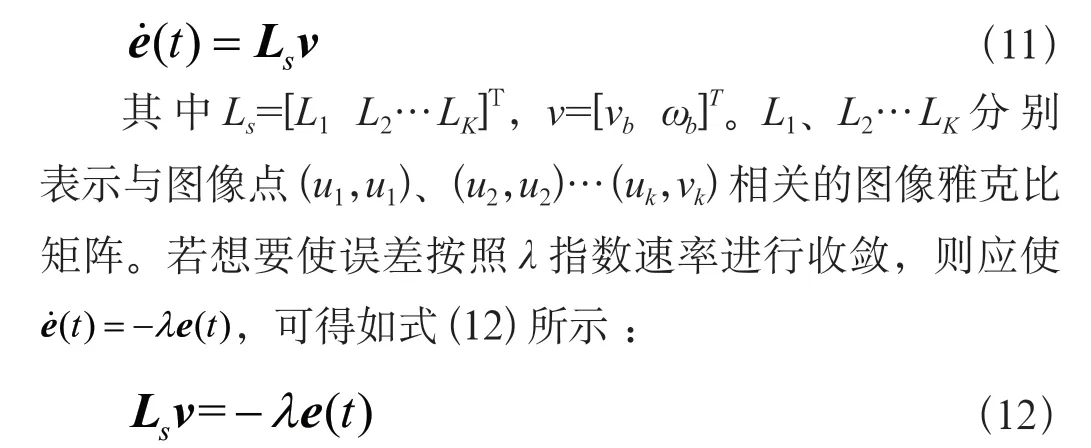

进一步可得如式(11)所示:

这样就将问题转换成求解带有6 个未知参数(三轴线速度和三轴角速度)的方程组,其最小二乘估计解为如式(13)所示:

LL

满秩;(2)计算欠驱动的四旋翼无人机系统伺服控制三轴的线速度和三轴的角速度;(3)估计L

矩阵中的Z

值。要确保LL

满秩,则需满足L

满秩,而L

为2k

×6的矩阵,因此有k

≥3。而当k

=3 时,即选取三个特征点来构造向量,存在L

为非奇异矩阵的可能。为保证LL

满秩,共选取4 个共面的特征点,并且任意3 个特征点不共线。

t

,对于E 坐标系下的一点(x

,y

,z

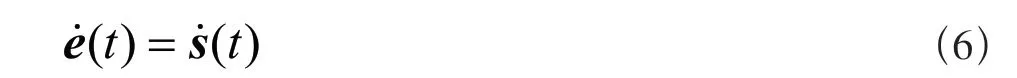

),可通过式(3)估计相应的Z 值。2.3 模糊PID 控制

针对视觉引导降落阶段,本文设计了模糊PID 控制器。B 坐标系原点到降落平台中心的向量为t

,且有t

=-n

,将其在B 坐标系的坐标记为t

=[t t t

],无人机机头朝向与车头朝向的夹角记为φ

,则在无人机降落过程中,主要需对t

、t

、t

以及φ

四个量进行控制,使其都趋近于零。将偏航角控制与线性位置控制分离,即在GPS 引导结束且搜索到降落标志后,首先对无人机偏航角进行调整,当φ

接近于零后再进行线性位置控制,这样就可以减小无人机在降落过程中的控制难度。偏航角控制采用PI 控制器,线性位置控制采用模糊PID 控制器,如图5 所示以t

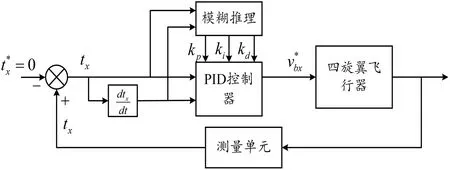

的控制为例,表示了模糊PID 控制系统结构。

图5 模糊PID 控制框图Fig.5 The control block diagram of fuzzy PID

根据降落技术方案的设定,无人机在车的后方进行降落,则t

为负时表明在降落过程中无人机发生了超调,并且很有可能会撞上驾驶舱,导致飞行事故,因此t

的负值可取范围很小,这也是t

的量化域不对称的原因。在建立PID 参数与输入项的模糊规则时,需综合考虑系统特性以及相关调试经验:在误差较大时,应选用适中的k

,使无人机快速响应,同时选用较小的k

,取k

为零,避免此时误差积分项过大造成超调;当误差大小中等时,选用较小的k

,使无人机减速避免超调撞车,同时取用适中的k

,较小的k

;当误差较小时,选用较大的k

,适中的k

,以消除稳态误差,达到较好的稳态效果,同时为避免较大超调,选用合适的k

,避免无人机在零平衡点附近震荡。出于安全的考虑,当误差为负小时选用较大的k

,负大时选用极大的k

,使无人机快速向后方飞行,避免发生飞行事故。以五个模糊子集表示k

的语言变量量化域,{ZO PS PM PB PL}分别表示“零 正小 正中 正大 极大”。根据上述分析,可得参数的模糊规则表,如表1 所示。

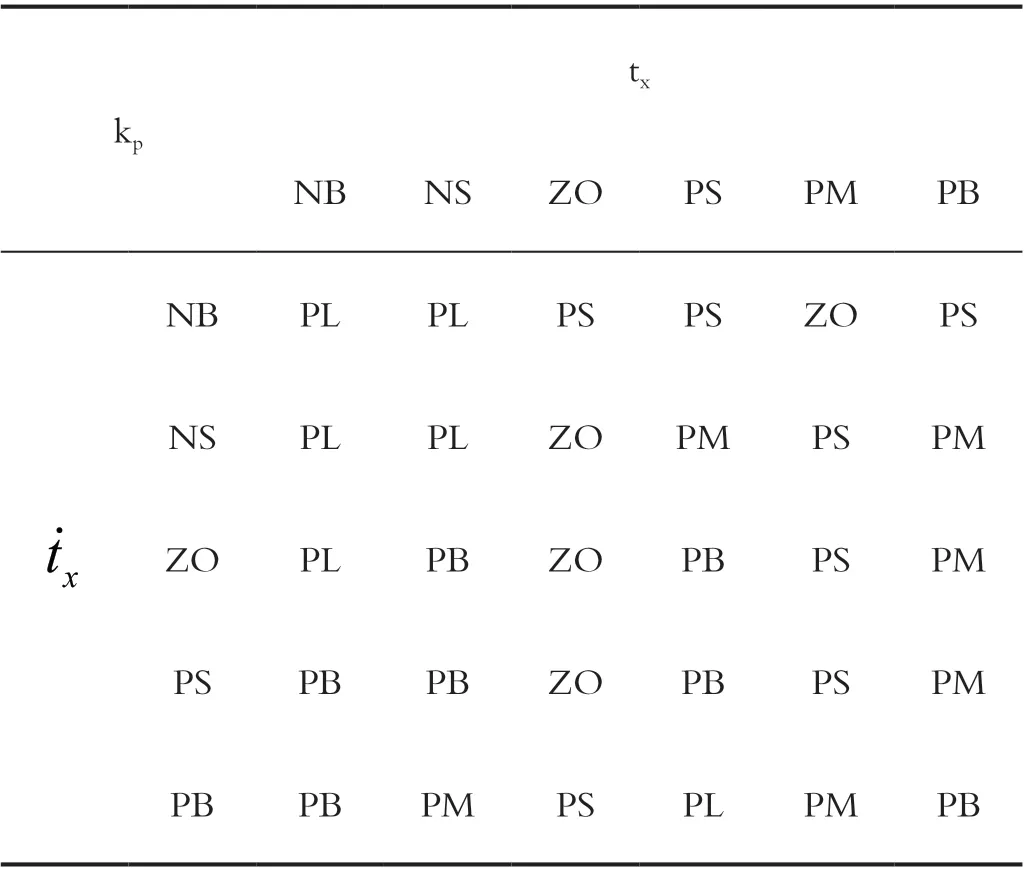

表1 模糊规则表Tab.1 The fuzzy rule of table

3 试验验证及结果分析

采用开发的地空协同系统进行了无人机GPS 导航实验和视觉引导无人机自主起飞、降落实验。视觉伺服控制方法在实际系统应用中,抗干扰性能较差,很容易受到外部因素的影响,如地空扰流、外界气流等。相比于视觉伺服控制方法,模糊PID 控制器抗干扰能力较强,并且其采用降落标志的三维空间位置误差作为反馈输入,更加直观,便于系统的调试,因此视觉引导实验部分采用模糊PID 控制方法。

3.1 GPS 导航试验

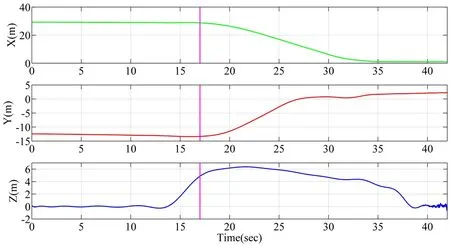

将GPS 导航从起飞、降落一体化的流程中抽离出来,在空旷的环境中,重新设计了GPS 导航实验,对GPS 导航飞行的精度和性能进行了验证。初始情况下,无人车静止不动,无人机放置于地面,两者间的直线距离约为40m。无人机在接收到GPS 导航指令后,根据接收到的无人车的GPS 位置和航向角进行解算,得到无人车在无人机机体坐标系下的坐标为(37,-16.0),根据无人车航向角及相关距离补偿(GPS 接收机与降落平台中心间的距离),计算得到导航目标点(无人车后方5m,高度4m的位置)在机体坐标系下的坐标为(32,-12.5,-4)。之后无人机自主完成平地起飞动作,并不断更新位置误差,根据2.1 节设计的GPS 导航控制律进行自主导航飞行。在飞行到目标点附近并对误差进行调整使其小于一定阈值后,完成在空旷地面上的自主降落动作。

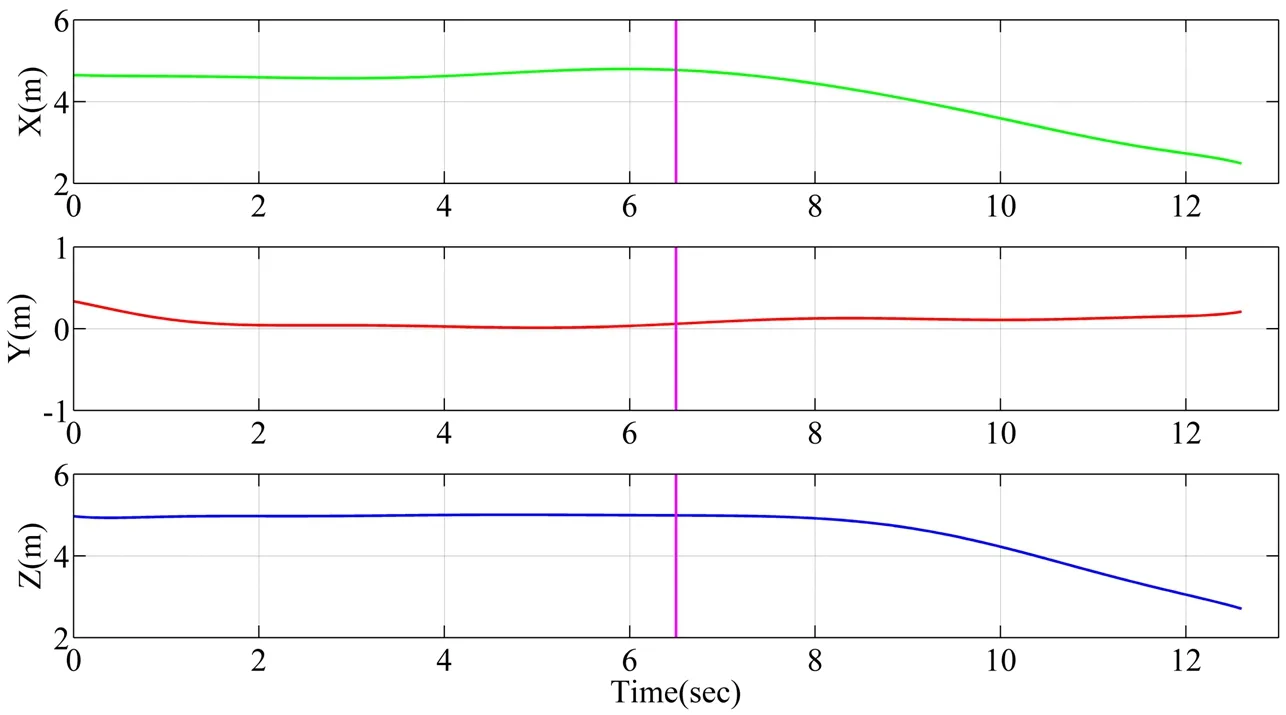

如图6 所示对GPS 导航目标点在机体坐标系下的坐标变化进行了展示。X 轴和Y 轴方向上控制效果良好,基本没有超调,存在2m 以内的稳态误差;Z 轴方向存在较大超调,但这种幅度的超调量和稳态误差对于后续降落环节影响不大。在数据处理上,本文将Z 轴方向的数据取反,这样表示更加直观,易于理解。整体来看GPS导航飞行控制轨迹平滑,控制效果良好,达到了预想的控制精度要求。

图6 GPS 导航目标点在机体坐标系下的坐标Fig.6 The coordinate of the GPS navigation target point in body coordinate system

3.2 视觉引导降落试验

视觉引导降落是视觉引导起飞的逆过程。视觉引导降落过程依次分为Tag1 引导和Tag16 引导两个阶段。

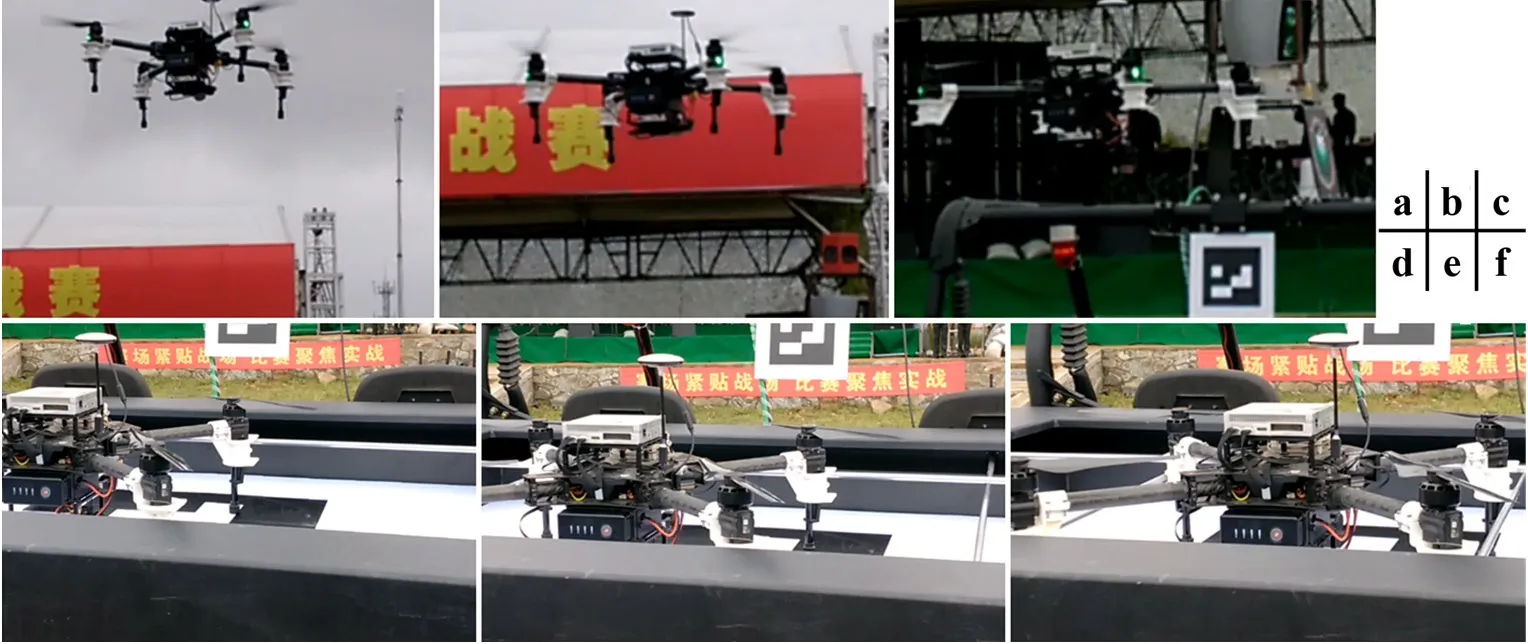

如图7 所示展示了视觉引导无人机降落过程的实际效果图。图7(a)中,无人机在接收到降落指令后,通过Tag1标志获得机、车相对位置,逐渐接近无人车;图7(b)中,Tag1 和Tag16 同时出现在云台相机视野中,此时切换为Tag16 引导;图7(c)中,无人机在Tag16 引导下对水平和竖直方向上的误差进行调整;图7(d)中,无人机降落到处于展开状态的平台上,虽然降落位置与平台中心位置有一定偏差,但在安全范围内;图7(e)中,降落平台处于调整状态,并在锁紧杆移动过程中调整无人机的位置;图7(f)中,无人机被调整到降落平台中心偏后位置,降落平台处于锁紧状态,起到保护固定无人机的作用。

图7 无人机自主降落过程Fig.7 Autonomous landing process of the UAV

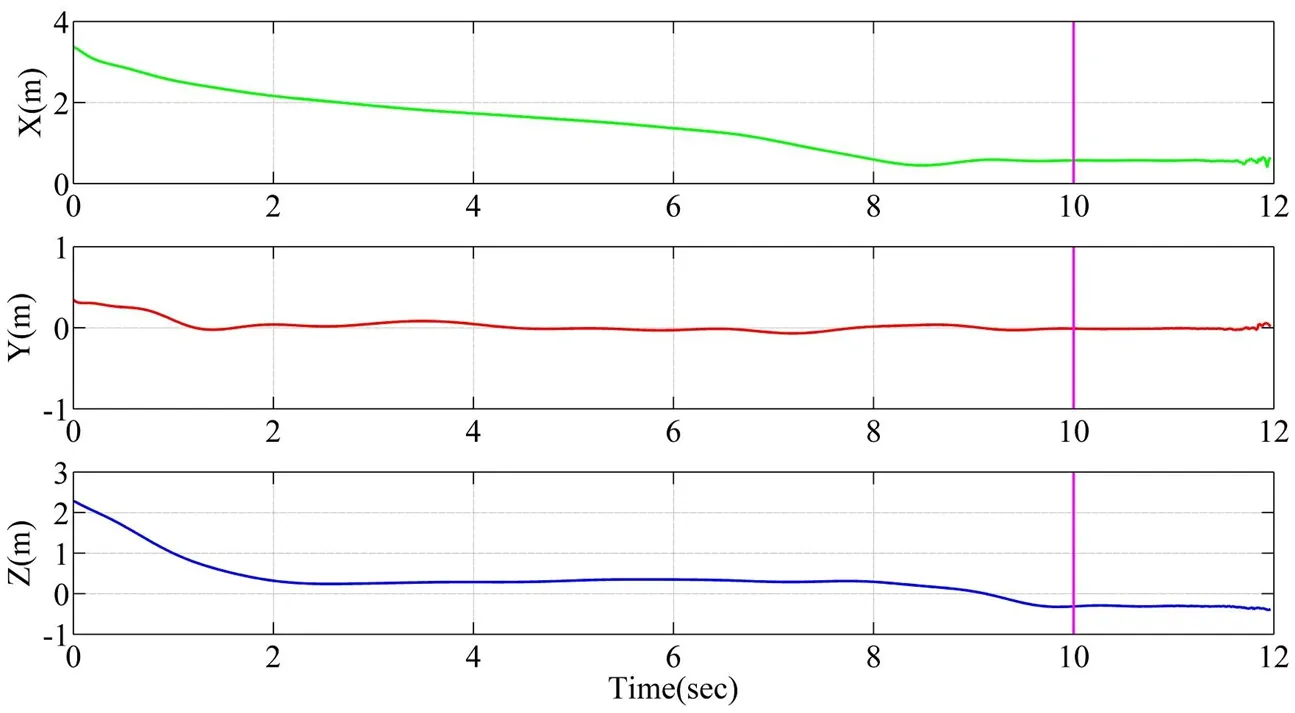

如图8 所示展示了Tag1 引导无人机降落过程中,Tag1标志在机体坐标系下的坐标变化。无人机在1 ~6s 内处于悬停状态,即依照起飞任务结束时的目标位置不断调整;在第6 秒收到降落指令后,无人机在Tag1 的引导下逐渐向降落平台靠近,当Tag1 在机体坐标系下的坐标为(2.5,0.2,2.75)时,切换为Tag16 引导。在整个Tag1引导过程中,三个方向的坐标变化平稳,没有超调和震荡,体现了良好的控制效果。

图8 降落过程Tag1 的坐标变化Fig.8 The coordinate of Tag 1 in landing process

如图9 所示表示了在Tag16 引导无人机降落阶段,Tag16 标志在机体坐标系下的坐标变化。在零时刻,即引导阶段刚发生切换时,Tag16 在机体坐标系下的坐标为(3.22,0.23,2.27),Tag1 在机体坐标系下的坐标(2.5,0.2,2.75),满足2 个Tag 标志的相对位置关系。在整个Tag16引导降落阶段,三个方向的坐标变化都比较平稳,并且Z 轴坐标表现出阶段性下降的特点。在第10s 时,无人机完成降落,之后Tag16 的坐标不再发生变化。

图9 降落过程Tag16 的坐标变化Fig.9 The coordinate of Tag 16 in landing process

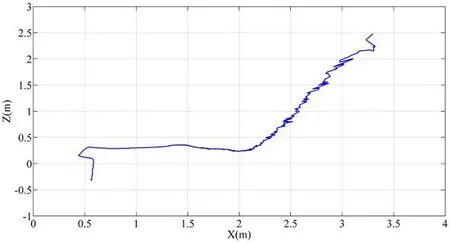

如图10 所示展示了无人机在XZ 平面内的运动轨迹。通过平面轨迹可以发现,与Tag16 引导起飞的过程类似,其引导降落过程也分为两个阶段。首先,控制无人机在水平方向上逐渐接近降落平台,并快速降低高度,使其距离平台高度为0.7m(则Tag16 的Z 轴方向坐标为0.35m)。接着在这个高度范围内,对无人机的水平误差进行调整,直至达到安全降落范围进而垂直降落。

图10 Tag16 引导降落过程中无人机运动轨迹Fig.10 The movement trajectory of UAV in landing process by Tag16 guidance

4 结语

本文针对无人机在无人车上的自主降落问题进行研究,提出了一套完整的主要基于GPS 和视觉传感器的解决方案,是实现无人系统地空协同的前提和重要保障,具有重要的实际应用价值与理论意义。针对视觉引导无人机起降问题,提出了视觉伺服控制和模糊PID 控制两种导航方法,进行了无人机自主起飞降落试验,取得了良好的控制效果,完成了四旋翼无人机在静止的无人车上自主起飞、降落的功能。结合现阶段研究成果,还有以下工作可以深入开展,无人机在移动地面无人平台上起飞降落的研究、无人机在地空协同中的作业任务研究等。

引用

[1] 王程,倪旖,李亮,等.针对小型商业无人机的预警技术发展现状与思考[J].空天防御,2021,4(1):83-90.

[2] BI Y C,DUAN H B.Implementation of Autonomous Visual Tracking and Landing for a Low-cost Quadrotor[J].Optik-International Journal for Light and Electron Optics,2013,124(18):3296-3300.

[3] LIPPIELLO V,MEBARKI R,RUGGIERO F.Visual Coordinated Landing of a UAV on a Mobile Robot Manipulator[C]//2013 IEEE International Symposium on Safety,Security,and Rescue Robotics(SSRR). IEEE,2013:1-7.

[4] SASKA M,KRAJNIK T,PFEUCIL L.Cooperative μUAV-UGV Autonomous Indoor Surveillance[C]//Systems,Signals and Devices (SSD),2012 9th International Multi-Conference on.IEEE,2012:1-6.

[5] XU G L,ZHANG Y,JI S Y,et al.Research on Computer Visionbased for UAV Autonomous Landing on a Ship[J].Pattern Recognition Letters,2009,30(6):600-605.

[6] YAKIMENKO O A,KAMINERI I,LENTZ W J,et al. Unmanned AircraftNavigation for Shipboard Landing Using Infrared Vision[J].Aerospace&Electronic Systems IEEE Transactions on, 2002,38(4):1181-1200.

[7] COUTARD L,CHAUMETTE F.Visual Detection and 3D Model-based Tracking for Landing on an Aircraft Carrier[C]//Robotics and Automation(ICRA),2011 IEEE International Conference on.IEEE,2011:1746-1751.

[8] COUTARD L,CHAUMETTE F,PFLIMLINJ M.Automatic Landing on Aircraft Carrier by Visual Servoing[C]//2011 IEEE/RSJ International Conference on Intelligent Robots and Systems.IEEE, 2011:2843-2848.

[9] HERISSE B,HAMEL T,MAHONY R,et al.Landing a VTOL Unmanned Aerial Vehicle on a Moving Platform Using Optical Flow[J].IEEE Transactions on Robotics,2012,28(1):77-89.

[10] KONG W W,ZHANG D B,WANG X,et al.Autonomous Landing of an UAV with a Ground-based Actuated Infrared Stereo Vision System[C]//2013 IEEE/RSJ International Conference on Intelligent Robots and Systems.IEEE,2013:2963-2970.

[11] YANG S W,SCHERER S A,ZELL A.An Onboard Monocular Vision System for Autonomous Takeoff,Hovering and Landing of a Micro Aerial Vehicle[J].Journal of Intelligent and Robotic Systems, 2013,69(1-4):499-515.

[12] YU Y S,DING X L.Safe Landing Analysis of a Quadrotor Qircraft with two Legs[J].Journal of Intelligent and Robotic Systems, 2014,76(3-4):527-537.

[13] Pedro J Garcia-Pardo,Gaurav S Sukhatme,James F Montgomery.Towards vision-based Safe Landing for an Autonomous Helicopter[J]. Robotics and Autonomous Systems,2002,38(1):19-29.

[14] CESETTI A,FRONTONI E,MANCINI A,et al.A Vision-Based Guidance System for UAV Navigation and Safe Landing using Natural Landmarks[J].Journal of Intelligent&Robotic Systems, 2010,57(1-4):233-257.

[15] THURROWGOOD S,MOORE R J D,SOCCOL D,et al.A Biologically Inspired, Vision-based Guidance System for Automatic Landing of a Fixed-wing Aircraft[J].Journal of Field Robotics,2014, 31(4):699-727.

[16] TEMPLETON T,SHIM D H,GEYER C,et al.Autonomous Vision-based Landing and Terrain Mapping using an MPC-controlled Unmanned Rotorcraft[C]//Proceedings of 2007 IEEE International Conference on Robotics and Automation.IEEE,2007:1349-1356.

[17] 吴鹏飞,石然,易志坤,等.基于改进型神经网络PID算法的太阳翼α驱动控制技术[J].空天防御,2018,1(4):8-17.