虚拟引擎制作在传统演播室的研究和实践

2022-06-13刘美

刘 美

(浙江广播电视集团,浙江 杭州 310000)

0 引 言

浙江广播电视集团广播电视制作中心的400 m2演播厅完成了一场使用国际上较为先进的Zero Density Reality 虚拟引擎实时渲染技术和增强现实(Augmented Reality,AR)技术的电视节目制作。相比于传统的切换台抠像,虚拟引擎制作能够呈现更宏大的视角,给视频制作人员更大的自由度,对于演播室的应用也更具有灵活性。为此,本文就虚拟引擎制作的特点和原理展开论述。

1 虚拟引擎制作的优点

虚拟演播室技术能够完成节目场景的变换,并且不会受到次数的限制,从而实现节目播出时环境变换的无缝衔接。与以往制作节目的演播室相比,虚拟演播室技术无需使用特定的道具或者节目场景,演播室可以随着节目内容的变化改变环境。一方面,这可以为节目设计者在前期的设计环节创造更多的可能性;另一方面,还可以有效减少成本的投入。

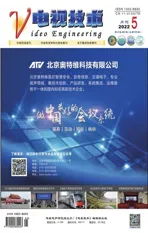

相比于传统的切换台抠像方式,虚拟引擎制作具有以下优点。第一,打破空间环境的限制,只需要不太大的空间就能创造出几倍于场地面积的视觉效果,如图1 所示。第二,缩短舞美置景的周期,场景素材由专门的制作人员在计算机内完成,现场只需要绿幕空间。第三,虚拟引擎自带的高质感画面渲染能力为创作者提供了更绚丽、更现代的舞台艺术选择。第四,配合AR 技术,可大大增强节目的交互感、体验性。

图1 本次虚拟制作的效果对比

2 虚拟引擎制作的基本原理

跟踪技术及方式是虚拟制作不可或缺的重要组成部分,也是实现整个虚拟场景的基础。该技术在现实空间内为虚拟场景提供准确的物理位置,为虚拟物体提供准确的畸变模式以及变换方式,从而实现虚拟场景与现实环境的无缝结合。摄像机将拍摄物体的跟踪数据实时传送给渲染引擎,通过计算得出拍摄物体与虚拟物体之间的距离和相对位置关系,使得拍摄实景与渲染生成的虚拟场景结合,最后合成为符合同一空间透视关系的画面[1]。

摄像机跟踪系统中,需要获取的摄像机运动参数包括变焦、聚焦、光圈、摇移、俯仰以及空间位置参数(X,Y,Z)。根据实现原理,可将跟踪方式分为基于硬件和基于计算机视觉的方式。前者常用的是机械跟踪(传感器跟踪),后者常用的是网格识别方式。还可以将两者结合,实现更精准的跟踪[2]。

本次制作使用的是Zero Density 公司的Reality Engine 产品。这是一款基于虚拟引擎打造的虚拟工作室和增强现实解决方案。Zero Density 的技术创新核心是其领先的基于节点的实时合成工具,以及其专有的键控技术——Reality Keyer,其所有计算都在GPU 上执行。与一般引擎不同的是,Reality是一种物理的引擎,其动画效果通过编程而不是制作人员通过手动关键帧实现[3]。Zero Density 的所有代码都能在虚拟引擎中运行,并且能够利用着色器编译器、C++语言以及虚拟引擎的跨平台功能。

在键控方面,Reality Keyer 使用一块空白板,将其与系统的追踪功能相结合。其生成的网格体可以用来表示摄影棚中的任意环形绿幕。三维图像是由程序生成的,支持更为干净的键控操作以及动态垃圾遮罩,即便是在扫描平移和倾斜时,也能生成干净而真实的键控最终图像。该系统通过在空白板上进行投影映射,协助键控操作,因此比普通的色度键控器更为先进,如图2 所示。

图2 Zero Density 抠像效果展示

传统上,图形化软件包只提供填充信号和键信号,并假设图像切换器中存在基本合成画面。Zero Density 提供了一种更为强大的系统,能够识别伽马信号,并且理解线性工作流和查找表。它能将通常为离线方案保留的控制功能添加到实时环境中。

Zero Density 可以从大多数主要解决方案中提取跟踪数据。此外,它还可以提取程序提供的镜头数据。如果没有镜头数据可用,软件会从最后一次校准的变焦和聚焦数据入手,估算出镜头曲率和其他属性如视野等。

绿幕中拍摄的前景画面直接进入虚拟引擎,与提前制作好的虚拟素材一起直接进入最终剪辑阶段,无需传统的离线渲染,也无需后期制作的视觉效果。软件不仅可以输出最终合成画面,还可以输出各种关键图层,以便在后期阶段完整地调整并重新剪辑,最终合成画面。这次实践也使用了AR技术。在电视内容创作的语境下,AR 指的是在摄像机画面上叠加一层虚拟空间,其中的虚拟物体多以元素的形态出现[4]。当AR 与虚拟演播技术结合,便形成了混合现实(Mixed Reality,MR),实景不再固定于做后景,而虚景也不再固定于做前景。

3 本次虚拟引擎制作的视频系统设计

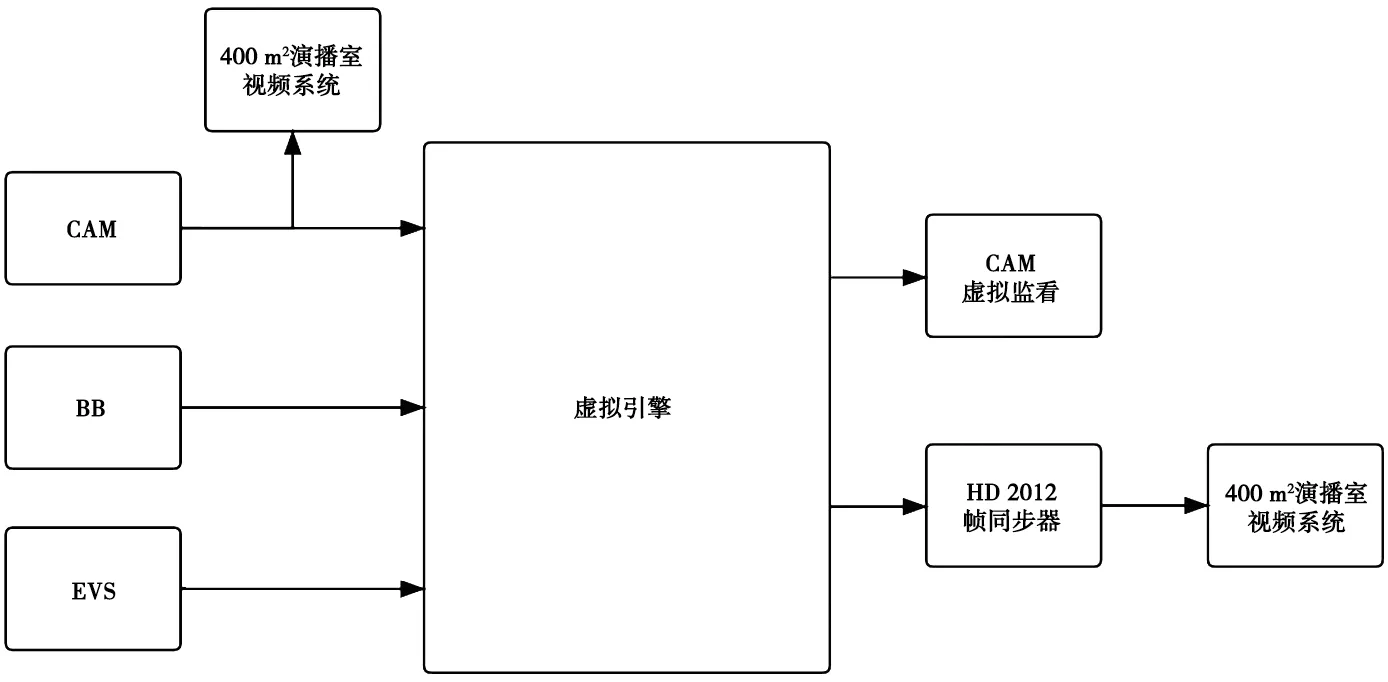

本次制作共有5 个摄制机位,CAM 1、CAM 3、CAM 5 为固定机位,CAM 2 为ROSS 机器人,CAM 4为摇臂。其中,CAM 1、CAM 2、CAM 3、CAM 4连接虚拟引擎,即由摄像机机头输出本机拍摄的绿幕画面信号送至虚拟引擎。经过虚拟引擎渲染后的信号(EXT 1、EXT 2、EXT 3、EXT 4)经过HD2012帧同步器进入系统,分别送往切换台和矩阵。切换台负责完成PGM 和PVW 信号的选切,矩阵负责完成录制等各个节点的信号调度。4 台虚拟引擎每一台都接入系统统一的BB 同步信号,虚拟引擎信号流程如图3 所示。

图3 虚拟引擎信号流程

每一台摄像机共有三路监看信号,一路是本机绿幕画面信号,一路是PGM 信号,一路是经过虚拟引擎渲染的本机合成后信号。其中,经过虚拟引擎渲染的合成信号单独使用一台监视器。这样的设置有利于摄像人员进行渲染前后画面的比对,更加方便构图和艺术化创作。

由于这种制作方式还比较新颖,现场除了PGM返看外,还特地为主持人和嘉宾在每一个机位前方都设置了一个单机位返看电视机,这台电视机接入的信号是经过虚拟引擎渲染的本机位信号,如图4 所示。

图4 现场单机位返看

录制方面,主要录制手段为7 台蓝光机。其中1台采集PGM 主路信号,1 台采集PGM 备路信号,4台采集经过虚拟引擎渲染后的单机位合成信号,1 台采集没有经过虚拟引擎渲染的绿幕信号。备份录制手段为两台EVS,分别采集主路、备路的PGM 信号。

现场主持人和嘉宾录制完成后,还有一些AR画面需要制作。此时先用蓝光机上载素材到EVS,再在EVS 里进行片段的编辑、播表的制作,最后将EVS 输出信号接入虚拟引擎,完成画面合成。

本次实践中,还对系统的TALLY 指示做了一定更改。在常规制作中,导播在切换台PGM 和PVW 母线选切CAM 信号时,相应的摄像机机头指示灯会显示红色或绿色。切换台的交叉点信息(包括PGM、PVW)经过一个GPI/O 控制设备传送给摄像机控制单元(CCU)。在本次制作中,导播实际选切信号为经过虚拟引擎渲染的信号,即EXT 1、EXT 2、EXT 3、EXT 4,但为了给主持人和现场嘉宾指示,需要相应的机头CAM 1、CAM 2、CAM 3、CAM 4 亮灯。所以在GPI 设置中,应该将EXT 1、EXT 2、EXT 3、EXT 4 的信号与CCU 1、CCU 2、CCU 3、CCU 4 做一一绑定。

经过虚拟引擎制作后,产生了比较明显的声画不同步现象。由于摄像机信号经过虚拟引擎处理,产生了比较大的延时,所以出现了视频滞后音频的问题。要解决这一问题,只需将声音做一定的延时处理。调音台将现场主持人及嘉宾声音做456 ms的延时处理后,经测定,声画不同步现象消除。

另外一个值得注意的问题是,为了保证虚拟引擎的抠像效果,对绿幕空间也有一定要求。抠像相体要能提供足够大小的纯色背景,最大限度地不产生色光反射,从而使摄像机采集的前景信号能够轻松地从纯色背景中剥离出来[5]。

4 结 语

虚拟引擎制作已成为一种趋势,它有着得天独厚的优点,对于传统演播室的再利用也有很大价值。虚拟引擎制作给观众带来了视觉奇观,也让电视从业者对审美有了重新的思考与升级。相信在未来会有更多的节目应用这一技术,而伴随而来的必将是更加优质的广播电视作品。