基于全局引导的行人序列重识别

2022-05-30张治军林敏强蒋浩

张治军 林敏强 蒋浩

摘 要:行人序列重识别是对同一个人进行跨摄像头识别,要实现跨摄像头行人精确识别必须充分利用行人序列的时空线索。为了解决这个问题,本文提出了一种基于全局引导的行人序列重识别,首先利用ResNet-50提取行人序列特征;然后用全局引导网络将行人序列特征分解为全局特征和局部特征,并提取行人序列全局特征和局部特征的时间相关性;最后对行人序列特征PCA降维后用JS散度计算相似度。实验结果表明本文算法在跨摄像头行人序列重识别中识不仅识别率高,而且效率高。

关键词:行人序列重识别;ResNet-50;全局引导;PCA

1 介绍

行人序列重新识别是跨摄像头识别同一个人,是智能监控和平安承受研究的热门课题。与单张行人图片相比,行人序列提供更全面的全局信息、运动线索和时间关系,如果充分利用行人序列的时空关系,行人序列重识别的识别率会高于单张图片的行人重识别。行人序列重识别以前的方法是利用卷积神经网络提取行人序列的空间特征和时间特征,然后对特征向量进行相似度计算,这种方法没有充分利用行人序列的全局信息,因此识别率不高。因此本文提出了一种基于全局引导的行人序列重识别,首先利用ResNet-50提取行人序列特征;然后用全局引导网络来增加行人序列帧特征之间的相关性;最后对行人序列特征PCA降维后用JS散度计算相似度。

2 本文算法

2.1 本文架构

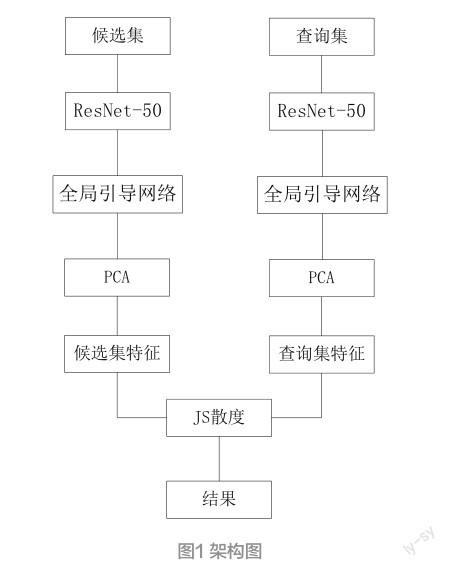

1)ResNet-50提取特征,用ResNet-50网络提取行人序列候選集和查询集特征。

2)全局引导网络,用全局引导网络来增加行人序列帧特征之间的相关性。

3)PCA,用PCA对特征降维,减少计算量,提供识别速度。

4)JS散度,对行人序列特征进行相似性度量。本文架构如下图1所示。

2.2 ResNet-50特征提取

ResNet-50网络由49个卷积层和1个全连接层组成。ResNet-50网络除了对输入进行卷积、正则化、激活函数、最大池化计算外,还增加了残差块。它对行人序列进行时间和空间建模来表示行人序列的全局特征和局部特征,以及行人序列全局特征和局部特征之间的关系。也就是说通过ResNet-50网络可以提取行人序列不同级别的特征。

2.3 全局引导网络

全局引导网络是用全局特征向量引导,用增加行人序列帧特征之间的相关性。首先通过ResNet-50提取行人序列的全局特征和局部特征,然后用时间平均池化和全局平均池化对行人特征的全局特征和局部特征进一步处理,生成全局特征向量来引导ResNet-50提取的行人序列特征,形成行人序列帧特征之间强相关特征和低相关特征。全局引导网络框图如下:

2.4 PCA降维

PCA又叫主成分分析,是Principal components analysis 的简写,是机器学习中使用最广泛的降维算法之一。图像处理计算是矩阵相乘计算,维度高时计算量非常大,运算速度非常慢,为了提升运算速度,保持识别效率,我们通常使用PCA降维。PCA降维的本质就是把高维空间投影到低维空间,也就是说在低维空间找一个新的正交坐标系,把高维空间向量投影到低维坐标系中,坐标系选择是原始数据方差最大的方向作为第一坐标轴,以此类推。因此PCA降维能保持高维空间最大的信息。本文在保证行人序列特征在99%的基础上,行人序列的特征维度从2048维降低到280维,在确保识别率的情况下极大的提升了识别速率。

2.5 JS散度

KL散度叫相对熵、信息散度或者信息增益。散度是两个概率分布差别的非对称性的度量。 JS散度解决了KL散度非对称的问题,因此本文采用JS散度进行相似性度量。

3 实验结果

本文实验是在MARS和iLIDS-VID数据集上进行的。MARS数据库是目前已公开的最大视频行人重识别数据集,包含1 261个行人,采集于6个不同的摄像头,每个人被2~3个摄像头捕捉到,每个行人平均含有13.2个视频序列。iLIDS-VID数据库包含从两个无交叠摄像头采集的300个行人的600个视频段,每个行人视频段含有23到192帧图像不止,平均含有73帧。

评测指标:采用行人重识别领域广泛使用的累计匹配特性曲线(cumulative matching characteristic,CMC)CMC@Rank-1、5、10,分别表示在一次查询结果中,排序列表的前1、5、10个排序样本中含有正确样本的概率;同时还采用检索任务中另一个常用的评测指标精度平均值(mean average precision, mAP),表示检索结果的精度平均值。

上表可以看出,本文算法在MARS和iLIDS-VID数据上识别率明显高于其它算法,说明本文基于全局引导的行人序列重识别算法充分利用了行人序列的信息。

4 结语

本文提出的基于全局引导的行人序列重识别算法,充分利用了行人序列的全局信息和局部信息,用全局引导网络来增加行人序列帧特征之间的相关性。实验结果表明,本文算法识别率高,识别速度快。

参考文献:

[1] CHEN G Y, RAO Y M, LU J W et al. Temporal coherence or temporal motion: Which is more critical for video-based person re-identification[C].ECCV,2020,(6):660-676.

[2] DAI J, ZHANG P P, WANG D, et al. Video person re- identification by temporal residual learning[J].TIP,2019,(3) 28:1366-1377.

[3] FU Y, WANG X Y, WEI Y C, et al. Sta: Spatial-temporal attention for large-scale video based person re-identification [R].AAAI,2019,(2):6.

[4] HOU R B, CHANG H, MA B P et al. Temporal complementary learning for video person re-identification[J].2020,(6).

[5] HOU R B, MA B P, CHANG H, et al. Vrstc: Occlusion-free video person re-identification[C].CVPR,2019,(6):7183-7192.

[6] LI J N, WANG J D, TIAN Q et al. Global-local temporal representations for video per son re-identification[C].ICCV, 2019,(6):3958-3967.

[7] LI S, BAK S, CARR P, et al. Diversity regularized spatiotemporal attention for video based person re-identification[C].CVPR, 2018.

[8] YANG J R, ZHENG W S, YANG Q Z et al. Spatial-temporal graph convolutional network for video-based person reidentification. [C].CVPR, 2020,(6):3289-3299.