跨尺度耦合的连续比例因子图像超分辨率

2022-05-23吴瀚霖李宛谕张立保

吴瀚霖,李宛谕,张立保

北京师范大学人工智能学院,北京 100875

0 引 言

单幅图像超分辨率(single image super-resolution,SISR)是计算机视觉领域的一项基本任务,旨在通过添加高频细节成分,从一幅低分辨率的图像中重建出逼真的高分辨率图像。由于其本身是一个具有挑战性的不适定问题,长期以来受到了研究者的广泛关注。在医学成像(Huang等,2017;Mahapatra等,2019)和遥感成像(Dong等,2021;Wu等,2022)等领域具有重要的应用前景。在这些场景的实际应用中,由于在不同放大倍数(比例因子)下,图像将呈现不同级别的细节信息,因此学者迫切希望能够使用超分辨率(super-resolution, SR)技术连续地放大低分辨率图像。

尽管大量基于深度学习的图像超分辨率算法已经取得了很好的性能,但是这些模型仅能处理单一整数比例因子,难以满足人们在实际应用中对于任意比例因子放大的需求。目前,主流的超分辨率算法将不同比例因子的超分辨率视为相互独立的任务,即:为每个比例因子单独设计网络结构,并独立地训练网络参数。这类方法在测试阶段,一个模型仅能处理单一比例因子,所以需要耗费大量的模型训练和存储代价。因此,研究如何使用单一模型实现连续比例因子的超分辨率具有重要的现实意义。

现有的超分辨率算法中,预上采样模型,如Dong等人(2016a)提出的SRCNN(super-resolution convolution neural network),首先将低分辨率图像使用插值算法放大到目标尺寸,然后再输入网络进行优化,可以实现连续比例因子的超分辨率。然而,由于大量卷积运算都是在高维空间中完成的,其计算效率极低,难以在实际场景中应用。后上采样模型通常使用位于网络末端的反卷积层(Zeiler等,2010)或亚像素层(Shi等,2016)实现上采样。不同比例因子的亚像素层具有不同的结构和参数量,因此亚像素层仅能处理单一比例因子。而反卷积层则需要根据比例因子调整卷积核的尺寸,且仅能处理整数的比例因子。因此,在后上采样模型中,受到亚像素层和反卷积层的固有限制,网络仅能使用单一整数比例因子进行训练,无法实现连续比例因子的超分辨率。

目前,仅有极少数的工作尝试使用单一模型处理多个比例因子。Lim等人(2017)提出的MDSR(multi-scale deep super-resolution)使用多个上采样分支处理多个比例因子,但是仅针对少数几个训练过的整数比例因子。Hu等人(2019)提出的Meta-SR是连续比例因子超分辨率的先驱性工作。但由于其需要一个额外的全连接网络为每个比例因子预测特征映射的权重,计算复杂度较高。此外,Meta-SR忽略了连续比例因子超分辨率重建任务对于特征提取部分的需求。

为了解决上述问题,本文提出一个基于全卷积的跨尺度耦合上采样模块(cross-scale coupled upsampling module, CSC-Up),高效地实现连续比例因子上采样。该模块的基本思想是:通过耦合一组包含多个分辨率的特征图,实现连续比例因子的上采样。首先,CSC-Up模块将低分辨率特征映射到多个尺度的高分辨率空间中。然后,基于跨尺度耦合策略,融合不同尺度空间的特征图,得到最终超分辨率的结果。该模块可以简单地嵌入到已有的超分辨率重建网络中,只需将原有的上采样层替换为CSC-Up模块,即可得到一个能够实现连续比例因子超分辨率的网络。

Fan等人(2020)、Han等人(2018)、Haris等人(2018)和Li等人(2018)等研究表明,提取低分辨率图像的多尺度特征有助于提升超分辨率的结果。受这个现象的启发,本文提出一个新的跨尺度卷积层,可以在多个尺度上并行提取特征,通过动态地激活和聚合不同尺度的特征来挖掘跨尺度上下文信息,以提升连续尺度超分辨率任务的表现。此外,受Li等人(2019)和Zamir等人(2017)工作的启发,本文在跨尺度特征学习部分采用反馈机制,允许高层级的特征金字塔修复低层级的特征。这样的迭代结构可以在不增加参数量的情况下,有效提升模型的表达能力。

本文的主要贡献包括:

1)提出一个跨尺度耦合上采样模块,可以端到端地实现连续比例因子的上采样。此外,该模块轻量且高效,可以方便地嵌入到已有的超分辨率模型中。

2)提出一个跨尺度卷积层,可以并行地在多个尺度的特征图上提取特征,实现跨尺度信息流动,提升连续比例因子超分辨率的表现。

3)提出一个新颖的跨尺度耦合网络,实现连续比例因子超分辨率,该网络采用反馈机制提升表达能力,参数量仅为Meta-SR的27%,并获得了与之相当甚至更好的性能。

1 相关工作

1.1 单一比例因子超分辨率

基于深度学习的SISR方法根据网络架构可以大致分为两类:预上采样模型和后上采样模型。

SRCNN(Dong等,2016a)和Kim等人(2016)提出的VDSR(very deep super-resolution)是两个典型的预上采样模型,即:首先将低分辨率图像上采样到目标分辨率,然后使用深度卷积神经网络恢复高频细节。由于这类方法大部分的卷积操作都是在高维空间中进行的,计算效率较低,难以应用在实际场景中。

为了提升计算效率,Dong等人(2016b)提出了后上采样模型,即在低维空间中完成低分辨率图像的特征学习,然后在网络的末端使用一个可学习的上采样层完成超分辨率。由于其在训练和测试阶段的计算效率很高,目前已经成为主流的超分辨率网络架构。Shi等人(2016)提出了一个基于学习的上采样层,名为亚像素卷积,将通道维度的元素重新排列,实现特征图空间分辨率的提升。反卷积层(Zeiler和Fergus,2014)也是一个端到端的上采样层,其首先通过插入零值的方式提升特征图的空间分辨率,然后使用卷积操作得到最终的结果。Zhang等人(2018a)提出了一个残差稠密网络(residual dense network, RDN),结合了残差模块(He等,2016)和密集连接模块(Tong等,2017)各自的优势,大幅提升了超分辨率的表现。Li等人(2019)将反馈机制引入到超分辨率任务中,提出了一个轻量的超分辨率反馈网络(super-resolution feedback network, SRFBN)。Soh等人(2020)提出了一个基于元迁移学习的训练策略,可以同时挖掘来自大规模数据集的外部信息和来自图像自身的内部信息。周波等人(2021)提出了区域级通道注意力机制,自适应地调整超分辨率网络对不同区域上通道的关注程度,提升了结果的视觉质量。

尽管这些网络在超分辨率任务上已经取得了很好的结果,但是它们只关注了少数几个整数的比例因子。

1.2 多比例因子超分辨率

Lim等人(2017)率先尝试使用单一网络实现多个比例因子的超分辨率,提出了MDSR模型。但是该模型不能实现任意连续比例因子的超分辨率。一方面,MDSR的每个上采样分支是独立工作的,仅能处理整数比例因子。另一方面,MDSR的网络结构依赖于预定义好的比例因子,不具有泛化到其他比例因子的能力。比如,使用×2,×4和×8这3个比例因子训练的网络不能实现×3的超分辨率任务。

Hu等人(2019)提出了一个基于元上采样模块的任意比例因子超分辨率网络(meta-learning super-resolution, Meta-SR)。Meta-SR首先建立从低分辨率空间到高分辨率空间的坐标映射,然后使用一个全连接网络动态预测从低分辨率空间到高分辨率空间的特征映射函数。尽管相比于MDSR,Meta-SR已大幅提高了单一网络实现多个比例因子超分辨率的能力,但是存在计算复杂度高、视觉结果存在网格状伪影的问题。

相比于Meta-SR,本文提出了一个新颖的跨尺度耦合上采样模块,用更加简单、高效的方式实现了端到端的连续比例因子上采样,提高了超分辨率网络的输出效率。

1.3 多尺度特征学习

多尺度特征学习有助于提升诸多计算机视觉任务的性能,如目标识别(Cai等,2016;Szegedy等,2015)和图像分割(Ronneberger等,2015)。在图像超分辨率领域,Han等人(2018)提出了一种双状态循环网络,结合低分辨率和高分辨率特征进行超分辨率重建。Haris等人(2018)利用多个堆叠的上、下采样层,不仅专注于生成高分辨率特征,还将它们投影回低分辨率空间。Fan等人(2020)提出使用多尺度卷积提取尺度不变的特征,提升图像复原任务的表现。孙超文和陈晓(2021)提出了多尺度特征融合反投影网络,可以在多个上下文尺度上提取图像特征,捕获更多的细节信息。

2 本文方法

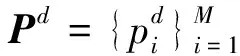

本文提出的跨尺度耦合网络的基本流程如图1所示,该网络包含3个部分:浅层特征提取部分、跨尺度特征学习部分和跨尺度耦合上采样模块。

图1 跨尺度耦合网络的流程图

令ILR和IHR分别表示输入的低分辨率图像和对应的高分辨率图像,SISR任务旨在生成一幅与IHR分辨率相同的图像ISR。首先,提取ILR的浅层特征F0,即

F0=fH(ILR)=Conv3,m(ILR)

(1)

式中,fH表示浅层特征提取部分的操作,Convk,m表示通道数为m的k×k卷积层。跨尺度特征学习部分包含N次迭代,输出一个包含N个层级特征的列表,该部分的操作可以总结为

[F1,F2,…,FN]=fB(F0)

(2)

式中,fB表示跨尺度特征学习部分的操作。

在网络的末端,多层级特征被送入到CSC-Up模块中,生成超分辨率结果,即

ISR=fT(F0,F1,F2,…,FN)

(3)

式中,fT表示CSC-Up模块的操作。

2.1 跨尺度卷积

具体地,首先使用两个卷积层来提取每个尺度的特征信息,即

(4)

然后,使用重采样操作fR调整特征图的尺寸。最后,使用一个1×1的卷积层自适应地聚合多个尺度的特征,得到下一个特征金字塔中第i个尺度的特征图,即

(5)

式中,[·]表示特征沿通道维度拼接操作。

这里,不同尺度的特征提取以及聚合操作是参数共享的。这不仅可以使信息在不同的尺度空间中流动,还大幅减少了参数量。本文中,重采样操作fR为双线性插值函数,因为其计算效率高且灵活。

2.2 跨尺度特征学习

受到Li等人(2019)方法的启发,本文采用反馈连接增强网络的特征表达能力,同时不会带来额外的参数量。

图2 跨尺度特征学习的示意图

(6)

然后,将增强后的特征金字塔送入到若干个连续的跨尺度卷积层中,得到具有多尺度、大感受野的特征信息Ht。Ht的计算为

(7)

2.3 跨尺度耦合上采样

为了实现任意非整数比例因子的超分辨率,一个简单的想法是使用插值算法,如:双线性插值、双三次插值。然而,在输入网络前就将输入图像放大到目标尺寸会极大增加计算复杂度。此外,Hu等人(2019)证明了在网络末端使用插值算法调整特征图的分辨率也会产生不理想的结果。这主要是因为插值算法不能从本质上实现不同分辨率特征空间的有效映射。为了避免单一尺度特征信息不完整的问题,本文使用多个上采样分支将特征映射到多个尺度空间,每个上采样分支可以采用亚像素层或者反卷积层作为基本的可学习上采样层。然后,将不同尺度空间的特征图使用插值算法调整到目标尺寸,尽管插值算法改变了特征图的大小,但是没有改变特征图的尺度信息。最后,通过耦合多个尺度的特征图得到最终结果。

(8)

式中,UPt表示第t个分支的上采样操作。为使特征图的尺寸与输出相符,使用重采样操作fR调整特征图的宽和高,即

(9)

为了减少多个上采样分支中的参数量,本文将上采样操作分解为多个小比例因子的上采样操作,以实现参数共享。于是,第t个分支分解为

UPt=Deconvk,m∘UPt-1

(10)

式中,Deconvk,m表示卷积核尺寸为k×k,输出通道数为m的反卷积操作,“∘”表示函数复合。

为了使该上采样模块可以嵌入到已有的超分辨率模型中,如RDN(Zhang等,2018a)和Lim 等人(2017)提出的EDSR(enhanced deep super-resolution),本文还提出了一个通用版本的CSC-Up,如图3(b)所示。作为上文介绍的CSC-Up模块的特殊情形,所有输入特征图可以相同,即可视为只接受一个特征作为输入。

图3 跨尺度耦合上采样示意图

2.4 模型实现细节

使用He等人(2015)提出的参数化线性整流函数(parametric rectified linear unit, PReLU)作为激活函数。在CSC-Up模块中,3个上采样分支的比例因子分别为×2,×4和×8。反卷积操作的卷积核尺寸为6×6,步长为2。跨尺度卷积层中,尺度数量M为3。在跨尺度特征学习部分,每次迭代包含16个跨尺度卷积层。除了网络输出层的通道数为3,每个卷积操作的通道数m均为64。网络使用L1损失函数优化。

3 实验结果

使用含有800幅图像的DIV2K(diverse 2K resolution)数据集训练网络。在训练阶段,使用双三次插值算法获得低分辨率图像,从中随机裁取32×32像素的图像块作为网络输入。采用随机水平翻转、垂直翻转和旋转90°操作进行数据增强。模型训练的批次大小为16,共进行4×105次迭代。初始学习率为1×10-3,分别在第1.5×105,2.5×105和3.5×105次迭代时,学习率减半。本文模型使用PyTorch框架实现,使用一块Nvidia Telsa V100 GPU完成训练。

在测试阶段,使用3个标准的测试数据集:Set14(Zeyde等,2010),BSD100(Martin等,2001)和Urban100(Huang等,2015)。将超分辨率结果转换到YCbCr空间中,使用Y通道计算客观评价指标:峰值信噪比(peak signal-to-noise ratio, PSNR)和结构相似度(structural similarity, SSIM)。

3.1 连续比例因子超分辨率结果对比

采用双三次插值的结果作为对比基准。Meta-EDSR和Meta-RDN(Hu等,2019)是连续比例因子超分辨率的先驱性工作,本文使用作者公布的源代码和预训练模型进行测试。

由于缺乏连续比例因子超分辨率模型进行对比,本文定义了一个新的对比基准,即:将已有的整数比例因子超分辨率结果使用插值算法调整到目标尺寸。假设目标比例因子为r,输入的低分辨率图像首先被RDN模型放大到3倍,然后使用Bicubic插值算法执行比例因子为r/3的重采样。本文将该方法命名为Bi-RDN。

此外,为了验证提出的CSC-Up模块的有效性,将RDN模型的上采样层替换为CSC-Up模块,得到一个可以实现连续比例因子放大的超分辨率模型,命名为CS-RDN(continuous-scale RDN)。客观评价指标如表1所示。本文还使用了自集成策略进一步提升CSCN的表现,记作CSCN+。

表1 在BSD100数据集上,连续比例因子超分辨率结果的PSNR和SSIM对比

从表1可以看出,本文提出的CSCN可以获得与Meta-RDN相近的指标,CSCN+在所有比例因子上都获得了最优的结果。此外,CS-RDN在几乎所有比例因子上都取得了比Meta-SR更高的PSNR,说明本文提出的CSC-Up模块可以应用到已有的超分辨率模型中,并获得优秀的非整数比例因子超分辨率结果。

3.2 整数比例因子超分辨率结果对比

在整数比例因子上与6个先进的超分辨率方法进行对比,分别是SRCNN(SR feedback network)(Dong等,2016a),RDN(Zhang等,2018a),SRFBN(SR feedback network)(Li等,2019),Meta-RDN(Hu等,2019),Tian等人(2021)提出的CFSRCNN(coarse-to-fine SRCNN)和Liu等人(2021)提出的ISRN(iterative SR network)。表2展示了在×3和×4两个整数比例因子上客观指标的对比结果。对比RDN与CS-RDN的结果可以看出,提出的连续比例因子上采样模块可以获得与传统的固定比例因子上采样层相近或更好的结果。得益于CSC-Up模块,提出的CSCN和CS-RDN只需要训练一次就可以在多个比例因子上进行预测,而SRCNN、RDN和SRFBN则需要在每个比例因子上训练一次,导致花费更长的训练时间并占用数倍的模型存储空间。此外,提出的CSCN使用更简单、高效的网络结构,实现了与Meta-RDN相近的结果。CSCN+在所有的数据集和比例因子上都获得了最好的结果。

表2 在Set14和Urban100数据集上,整数比例因子超分辨率结果的PSNR(/dB)和SSIM对比

3.3 网络参数比较

本文还与11种先进的方法进行了参数量及性能的比较,包括EDSR(Lim等,2017),Lai等人(2017)提出的LapSRN(Laplacian pyramid network),Tong等人(2017)提出的SRDenseNet(super-resolution dense connected network),RDN(Zhang 等, 2018a),Zhang 等人(2018b)提出的RCAN(residual channel attention network),Haris等人(2018)提出的DBPN(deep back-projection network),SRFBN(Li 等,2019),Dai等人(2019)提出的SAN(second-order attention network),Meta-RDN(Hu等,2019),CFSR-CNN(Tian等,2021),ISRN(Liu等,2021)。从图4可以看出,本文模型在所有参数量小于10 M的对比方法中,获得了最好的PSNR指标。同时,CSCN和CSCN+的参数量仅为Meta-RDN的27%,且获得了相近甚至更好的结果。得益于本文采用的反馈结构,提出的模型可以较好地平衡网络参数和模型性能间的矛盾。

图4 PSNR与参数量的对比(加粗字体为本文提出的模型)

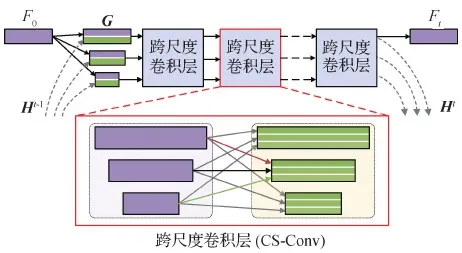

3.4 运行时间对比

运行时间的比较在一台配备了Intel i7-9700K CPU、16 GB内存和一张11 GB显存Nvidia 2080Ti GPU的工作站上完成。所有对比算法均使用PyTorch框架实现。本文在Set14数据集上使用×4比例因子与5个算法(SRCNN、EDSR、RDN、SRFBN和Meta-RDN)对比了运行时间,如表3所示。此外,也将本文基准方法Bi-RDN加入对比。对比CS-RDN与RDN的运行时间可以发现,本文CSC-Up模块非常高效,没有增加RDN模型的运行时间。更为重要的是,本文CSCN模型的运行时间不到Meta-RDN模型的一半,表明该模型是轻量、高效的。

表3 在BSD100数据集上的平均运行时间对比

3.5 消融实验

通过消融实验,验证模型中关键模块的有效性,包括反馈连接和跨尺度卷积层。首先,去掉特征学习部分的所有反馈连接,得到一个仅包含前向传播的网络,该网络的参数量与标准的CSCN相同。其次,将跨尺度卷积模块中尺度的数量设置为1,即退化成为普通的卷积层,得到第2个对比模型。从表4可以看出,跨尺度卷积层的确可以提升连续比例因子超分辨率任务的表现。此外,反馈机制可以有效地利用高层次信息增强低层次特征,从而提升模型性能。

表4 不同模型设置下的PSNR/dB对比

3.6 视觉结果比较

图5—图7展示了本文方法与其他对比算法视觉结果的比较。由于本文提出的CSCN能够充分利用多尺度特征图,超分辨率结果的视觉质量优于其他对比方法,表现为细节更加丰富,边缘更加清晰。图8展示了本文方法在单幅LR图像上使用多个小数比例因子超分辨率的视觉结果比较。

图5 比例因子为×2.9的视觉结果比较

图6 比例因子为×3.2的视觉结果比较

图7 比例因子为×4的视觉结果比较

图8 单幅LR图像使用多个小数比例因子超分辨率的视觉结果比较

4 结 论

面向连续比例因子超分辨率任务,提出了一种新的跨尺度耦合上采样模块,该模块可以轻松嵌入已有的超分辨率网络中以实现连续比例因子超分辨率。还设计了一个跨尺度卷积层来学习尺度稳健的特征,并采用反馈连接设计了一个轻量的跨尺度耦合网络。在Set14,BSD100和Urban100多个数据集上的实验结果表明,提出的CSCN只需训练一次,就可以获得较好的连续比例因子超分辨率结果。与已有的单一比例因子超分辨率网络相比,提出的跨尺度耦合网络可以获得有竞争力的结果,同时显著节省训练时间和模型存储空间。然而,本文也存在一定的不足,真实场景的低分辨率图像可能还受到噪声或者模糊的影响,因此需进一步考虑更加复杂的降质模型。提出自适应多种降质模型的连续比例因子超分辨率网络是后续工作的重点。

参考文献(References)

Cai Z W, Fan Q F, Feris R S and Vasconcelos N.2016.A unified multi-scale deep convolutional neural network for fast object detection//Proceedings of the 14th European Conference on Computer Vision.Amsterdam, the Netherlands: Springer: 354-370[DOI: 10.1007/978-3-319-46493-0_22]

Dai T, Cai J R, Zhang Y B, Xia S T and Zhang L.2019.Second-order attention network for single image super-resolution//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 11057-11066[DOI: 10.1109/CVPR.2019.01132]

Dong C, Loy C C, He K M and Tang X O.2016a.Image super-resolution using deep convolutional networks.IEEE Transactions on Pattern Analysis and Machine Intelligence, 38(2): 295-307[DOI: 10.1109/TPAMI.2015.2439281]

Dong C, Loy C C and Tang X O.2016b.Accelerating the super-resolution convolutional neural network//Proceedings of the 14th European Conference on Computer Vision.Amsterdam, the Netherlands: Springer: 391-407[DOI: 10.1007/978-3-319-46475-6_25]

Dong X Y, Wang L G, Sun X, Jia X P, Gao L R and Zhang B.2021.Remote sensing image super-resolution using second-order multi-scale networks.IEEE Transactions on Geoscience and Remote Sensing, 59(4): 3473-3485[DOI: 10.1109/TGRS.2020.3019660]

Fan Y C, Yu J H, Liu D and Huang T S.2020.Scale-wise convolution for image restoration//Proceedings of the 34th AAAI Conference on Artificial Intelligence.New York, USA: AAAI: 10770-10777[DOI: 10.1609/aaai.v34i07.6706]

Han W, Chang S Y, Liu D, Yu M, Witbrock M and Huang T S.2018.Image super-resolution via dual-state recurrent networks//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 1654-1663[DOI: 10.1109/CVPR.2018.00178]

Haris M, Shakhnarovich G and Ukita N.2018.Deep back-projection networks for super-resolution//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 1664-1673[DOI: 10.1109/CVPR.2018.00179]

He K M, Zhang X Y, Ren S Q and Sun J.2015.Delving deep into rectifiers: surpassing human-level performance on imagenet classification//Proceedings of 2015 IEEE International Conference on Computer Vision.Santiago, Chile: IEEE: 1026-1034[DOI: 10.1109/ICCV.2015.123]

He K M, Zhang X Y, Ren S Q and Sun J.2016.Deep residual learning for image recognition//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, USA: IEEE: 770-778[DOI: 10.1109/CVPR.2016.90]

Hu X C, Mu H Y, Zhang X Y, Wang, Z L, Tan T N and Sun J.2019.Meta-SR: a magnification-arbitrary network for super-resolution//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 1575-1584[DOI: 10.1109/CVPR.2019.00167]

Huang J B, Singh A and Ahuja N.2015.Single image super-resolution from transformed self-exemplars//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston, USA: IEEE: 5197-5206[DOI: 10.1109/CVPR.2015.7299156]

Huang Y W, Shao L and Frangi A F.2017.Simultaneous super-resolution and cross-modality synthesis of 3D medical images using weakly-supervised joint convolutional sparse coding//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu, USA: IEEE: 5787-5796[DOI: 10.1109/CVPR.2017.613]

Kim J, Lee J K and Lee K M.2016.Accurate image super-resolution using very deep convolutional networks//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, USA: IEEE: 1646-1654[DOI: 10.1109/CVPR.2016.182]

Lai W S, Huang J B, Ahuja N and Yang M H.2017.Deep Laplacian pyramid networks for fast and accurate super-resolution//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu, USA: IEEE: 5835-5843[DOI: 10.1109/CVPR.2017.618]

Li J C, Fang F M, Mei K F and Zhang G X.2018.Multi-scale residual network for image super-resolution//Proceedings of the 15th European Conference on Computer Vision.Munich, Germany: Springer: 527-542[DOI: 10.1007/978-3-030-01237-3_32]

Li Z, Yang J L, Liu Z, Yang X M, Jeon G and Wu W.2019.Feedback network for image super-resolution//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 3862-3871[DOI: 10.1109/CVPR.2019.00399]

Lim B, Son S, Kim H, Nah S and Lee K M.2017.Enhanced deep residual networks for single image super-resolution//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops.Honolulu, USA: IEEE: 1132-1140[DOI: 10.1109/CVPRW.2017.151]

Liu Y Q, Wang S Q, Zhang J, Wang S S, Ma S W and Gao W.2021.Iterative network for image super-resolution.IEEE Transactions on Multimedia[J/OL].[2021-08-25].https://ieeexplore.ieee.org/document/9427200[DOI: 10.1109/TMM.2021.3078615]

Mahapatra D, Bozorgtabar B and Garnavi R.2019.Image super-resolution using progressive generative adversarial networks for medical image analysis.Computerized Medical Imaging and Graphics, 71: 30-39[DOI: 10.1016/j.compmedimag.2018.10.005]

Martin D, Fowlkes C, Tal D and Malik J.2001.A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics//Proceedings of the 8th IEEE International Conference on Computer Vision.Vancouver, Canada: IEEE: 416-423[DOI: 10.1109/ICCV.2001.937655]

Ronneberger O, Fischer P and Brox T.2015.U-net: convolutional networks for biomedical image segmentation//Proceedings of the 18th International Conference on Medical Image Computing and Computer-Assisted Intervention.Munich, Germany: Springer: 234-241[DOI: 10.1007/978-3-319-24574-4_28]

Soh J W, Cho S and Cho N I.2020.Meta-transfer learning for zero-shot super-resolution//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle, USA: IEEE: 3513-3522[DOI: 10.1109/CVPR42600.2020.00357]

Sun C W and Chen X.2021.Multiscale feature fusion back-projection network for image super-resolution.Acta Automatica Sinica, 47(7): 1689-1700(孙超文, 陈晓.2021.基于多尺度特征融合反投影网络的图像超分辨率重建.自动化学报, 47(7): 1689-1700)[DOI: 10.16383/j.aas.c200714]

Szegedy C, Liu W, Jia Y Q, Sermanet P, Reed S, Anguelov D, Erhan D, Vanhoucke V and Rabinovich A.2015.Going deeper with convolutions//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston, USA: IEEE: 1-9[DOI: 10.1109/CVPR.2015.7298594]

Tian C W, Xu Y, Zuo W M, Zhang B, Fei L K and Lin C W.2021.Coarse-to-fine CNN for image super-resolution.IEEE Transactions on Multimedia, 23: 1489-1502[DOI: 10.1109/TMM.2020.2999182]

Tong T, Li G, Liu X J and Gao Q Q.2017.Image super-resolution using dense skip connections//Proceedings of 2017 IEEE International Conference on Computer Vision.Venice, Italy: IEEE: 4809-4817[DOI: 10.1109/ICCV.2017.514]

Wu H L, Zhang L B and Ma J.2022.Remote sensing image super-resolution via saliency-guided feedback GANs.IEEE Transactions on Geoscience and Remote Sensing, 60: #5600316[DOI: 10.1109/TGRS.2020.3042515]

Zamir A R, Wu T L, Sun L, Shen W B, Shi B E, Malik J and Savarese S.2017.Feedback networks//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu, USA: IEEE: 1808-1817[DOI: 10.1109/CVPR.2017.196]

Zeiler M D and Fergus R.2014.Visualizing and understanding convolutional networks//Proceedings of the 13th European Conference on Computer Vision.Zurich, Switzerland: Springer: 818-833[DOI: 10.1007/978-3-319-10590-1_53]

Zeiler M D, Krishnan D, Taylor G W and Fergus R.2010.Deconvolutional networks//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.San Francisco, USA: IEEE: 2528-2535[DOI: 10.1109/CVPR.2010.5539957]

Zeyde R, Elad M and Protter M.2010.On single image scale-up using sparse-representations//Proceedings of the 7th International Conference on Curves and Surfaces.Avignon, France: Springer: 711-730[DOI: 10.1007/978-3-642-27413-8_47]

Zhang Y L, Li K P, Li K, Wang L C, Zhong B N and Fu Y.2018b.Image super-resolution using very deep residual channel attention networks//Proceedings of the 15th European Conference on Computer Vision.Munich, Germany: Springer: 294-310[DOI: 10.1007/978-3-030-01234-2_18]

Zhang Y L, Tian Y P, Kong Y, Zhong B N and Fu Y.2018a.Residual dense network for image super-resolution//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 2472-2481[DOI: 10.1109/CVPR.2018.00262]

Zhou B, Li C H and Chen W.2021.Region-level channel attention for single image super-resolution combining high frequency loss.Journal of Image and Graphics, 26(12): 2836-2847(周波, 李成华, 陈伟.2021.区域级通道注意力融合高频损失的图像超分辨率重建.中国图象图形学报, 26(12): 2836-2847)[DOI: 10.11834/jig.200582]