图像质量评价研究综述

——从失真的角度

2022-05-23鄢杰斌方玉明刘学林

鄢杰斌,方玉明,刘学林

江西财经大学信息管理学院,南昌 330032

0 引 言

图像质量评价(image quality assessment,IQA)(Lin和Jay,2011;Zhai和Min,2020)是图像处理和计算机视觉相关领域的一个基础问题,从早期的仅包含少量图像数据且失真类型单一的图像质量数据库到当前失真种类丰富且图像数据多的图像质量数据库,从早期的特征工程与传统机器学习算法的结合到现在的端到端深度学习模型,从早期的较为单一的评价指标到如今的多样化应用相关评价指标,都见证了IQA研究领域的快速发展历程。IQA是指对图像质量的退化程度进行量化(吴金建,2014;顾锞,2015;鄢杰斌,2018),主要包括主观质量评价和客观质量评价。主观质量评价指的是由主观判断获取图像的视觉质量;客观质量评价指的是通过设计IQA算法预测图像的视觉质量,可分成3类:全参考质量评价(full reference IQA, FR-IQA)、半参考质量评价(reduced reference IQA, RR-IQA)和无参考质量评价(no reference IQA, NR-IQA)(Mittal等,2012)。其他IQA具体介绍可参考方玉明等人(2021)的工作。

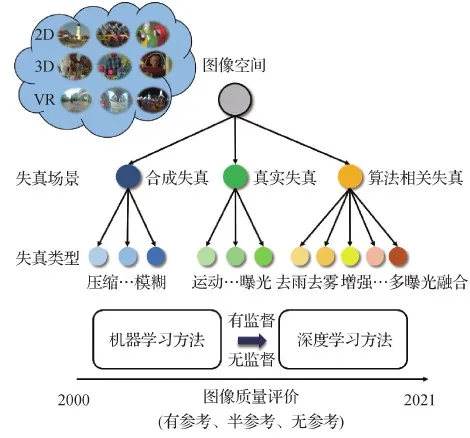

本文着重从图像失真的角度介绍IQA研究领域的发展现状,包括针对合成失真、真实失真和算法相关失真的IQA研究,每部分内容包括图像质量数据库和IQA模型。其中,图像质量数据库部分将详细介绍图像数据内容和数据库构建过程;IQA模型部分将重点介绍模型的设计思想。内容框架如图1所示。

图1 本文内容框架

1 针对合成失真的IQA研究

早期的IQA研究主要在合成失真(又称为模拟失真或人工失真)图像上进行,常见的合成失真包括高斯噪声、高斯模糊、运动模糊和JPEG压缩失真等,通过人工添加噪声的方式扰动图像使得图像视觉质量退化,研究对象主要是自然图像(natural image,NI)。随着多媒体技术和应用的蓬勃发展,越来越多种类的图像成为研究对象,如屏幕图像(screen content image,SCI)、3维立体图像(stereoscopic image,SI)、全景图像(omnidirectional image,OI)和光场图像(light field image, LFI)。

首先介绍合成失真图像质量数据库,包括图像数据的构成及对应的主观分数。需要说明的是主观分数包括:平均主观得分(mean opinion score,MOS)和平均主观得分差(differential mean opinion score,DMOS)。MOS的值越大表示图像质量越好,DMOS的值越小表示图像质量越好,它们的定义分别为

(1)

dm,n=mosref-mosdis

(2)

(3)

式中,P表示主观分数类别数,Sp表示第p类主观分数值,Np表示评分为Sp的受试者人数;mosref和mosdis分别表示参考图像和失真图像的MOS值,d′m,n的均值即为DMOS的值。

1.1 合成失真图像质量数据库

本小节介绍合成失真图像数据库,图像内容包括:NI、SI、SCI、OI和LFI。

1.1.1 2维图像

现有2维合成失真图像质量数据库主要包括IVC(images and video-communications)数据库(Le Callet和Autrusseau,2005)、LIVE(Laboratory for Image and Video Engineering)数据库(Sheikh等,2006a)、TID2008(Tampere Image Database 2008)数据库(Ponomarenko等,2009)、CSIQ(categorical subjective image quality)数据库(Larson和Chandler,2009)、TID2013(Tampere Image Database 2013)数据库(Ponomarenko等,2015)、Waterloo Exploration数据库(Ma等,2017b)、KADID-10k数据库(Lin等,2019)和图像数据库(Wu等,2020a)。在此,详细介绍后3个2维合成失真图像质量数据库,其他2维合成失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1)Waterloo Exploration数据库(Ma等,2017b)。由加拿大滑铁卢大学在2017年建立。该数据库包含4 744幅参考图像和94 880幅失真图像,图像失真类型包括4类:JPEG压缩、JPEG2000压缩、高斯模糊和高斯白噪声,每种失真类型包括5个失真等级。该数据库不包含主观分数。不同于包含主观分数的图像质量数据库,即可以直接用于训练传统算法或深度学习模型,该数据库可结合排序学习用于训练IQA模型。

2)KADID-10k数据库(Lin等,2019)。由德国康斯坦茨大学在2019年建立。KADID-10k数据库包括81幅参考图像和10 125幅失真图像,图像失真类型包括25类:高斯模糊、运动模糊、JPEG压缩、白噪声和量化失真等,每种失真类型包括5个失真等级。该数据库的主观分数通过众包的方式获得,以MOS的方式提供,每幅图像的打分次数为30。KADID-700k数据库(Lin等,2019)由德国康斯坦茨大学在2019年建立。KADID-700k数据库包括140 000幅参考图像和700 000幅失真图像,每幅参考图像对应25类失真类型中的某一种,每种失真类型包括5个失真等级,该数据库不包含主观分数。

3)Wu20数据库(Wu等,2020a)。由西安电子科技大学在2020年建立,包含10 000幅参考图像和1 050 000幅失真图像,图像失真类型包括21类:加性高斯噪声、量化噪声、高斯模糊、块效应和对比度失真等,每种失真类型包括5个失真等级。不同于Waterloo Exploration数据库和KADID-10k数据库,该数据库包含图像的伪标签,即将客观算法计算得到的客观分数作为标签。同时提出了一个图像质量评价模型(cascaded convolutional neural network with hierarchical degradation concatenation,CaHDC)。

1.1.2 3维图像

现有3维合成失真图像质量数据库主要包括LIVE 3D Image Quality Database Phase I(Moorthy等,2013)和Phase II(Chen等,2013a,b)、Waterloo IVC(image and vision computing)3D Phase I和Phase II图像质量数据库(Wang等,2015)、IRCCyN_IVC数据库(Benoit,2008)、NBU 3D图像质量数据库(Zhou等,2011)、Waterloo-IVC 3D Depth图像质量数据库(Wang等,2017b)以及NBU-MDSID Phase I(Shao等,2017)和Phase II数据库(Shao等,2018)。在此,详细介绍后4个3维合成失真图像质量数据库,其他3维合成失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1)IRCCyN_IVC数据库(Benoit,2008)。由法国南特大学在2009年建立。该数据库包含6幅参考图像和90幅失真图像,图像失真类型包括3类:模糊(高斯模糊和上采样下采样操作)、JPEG压缩和JPEG2000压缩。数据库采用单刺激法进行主观实验,主观分数以DMOS的形式提供,取值范围为[0, 100]。

2)NBU 3D图像质量数据库(Zhou等,2011)。由宁波大学在2011年建立。该数据库包含12幅参考图像和312幅失真图像,图像的失真类型包括JPEG压缩、JPEG2000压缩、高斯模糊、白噪声和H.264压缩,前4种失真对应5个失真等级,后一种失真对应6个失真等级。数据库采用双刺激法进行主观实验,主观分数以DMOS形式提供,取值范围为[0, 100]。

3)Waterloo-IVC 3D Depth图像质量数据库(Wang等,2017b)。由加拿大滑铁卢大学在2017年建立。该数据库包含72幅参考图像和1 728幅失真图像,图像的失真类型包括3类:高斯噪声、高斯模糊和JPEG压缩,每种失真类型对应4个失真等级。数据库采用多刺激法进行主观实验,主观分数以MOS形式提供,取值范围为[0, 1]。

4)NBU-MDSID Phase I(Shao等,2017)和Phase II数据库(Shao等,2018)。由宁波大学2017年建立。NBU-MDSID Phase I数据库包含10幅参考图像和360幅多重失真图像,图像失真类型包括3类:白噪声、高斯模糊和JPEG压缩。数据库采用双刺激法进行主观实验,主观分数以DMOS的形式提供,取值范围为[0, 100]。NBU-MDSID Phase II数据库包含30幅参考图像和300幅多重失真图像,图像失真类型包括3类:白噪声、高斯模糊和JPEG压缩。数据库采用双刺激法进行主观实验,主观分数以DMOS的形式提供,取值范围为[0, 100]。

1.1.3 屏幕图像

现有屏幕合成失真图像质量数据库主要包括SIQAD(screen image quality assessment database)数据库(Yang等,2015)、SCID(screen content image database)数据库(Ni等,2017)、QACS(quality assessment of compressed SCIs)数据库(Wang等,2016;Shi等,2015)和IML-SCIQD(immersive media laboratory screen content image quality database)数据库(Wang等,2017c)。在此,本文主要详细介绍后两个屏幕合成失真图像质量数据库,其他屏幕合成失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1)QACS数据库(Wang等,2016;Shi等,2015)。由新加坡南洋理工大学在2016年建立。该数据库包含492幅失真SCIs,来源于24幅参考SCIs。失真类型包括HEVC(high efficiency video coding)和HEVC-SCC(screen content coding)两种,每种失真类型对应11个失真等级(QP值)。数据库采用单刺激法进行主观实验,主观分数以MOS的形式提供,范围为[0, 10]。

2)IML-SCIQD数据库(Wang等,2017c)。由深圳大学在2017年建立。该数据库包含1 250幅失真SCIs,来源于25幅参考SCIs。失真类型包括10类:JPEG压缩、JPEG2000压缩、高斯模糊、运动模糊、白噪声、椒盐噪声、乘性噪声、对比度变化、快衰落和屏幕内容压缩。每种失真对应5个失真等级。数据库采用单刺激法进行主观实验,主观分数以MOS的形式提供,范围为[0, 10]。

1.1.4 全景图像

现有全景合成失真图像质量数据库主要包括OIQA(omnidirectional IQA)数据库(Duan等,2018)、CVIQD(compressed 360-degree image database)数据库(Sun等,2018)、全景图像数据库(Huang等,2018)、全景图像数据库(Sui等,2021)和SOLID(stereoscopic omnidirectional image quality assessment database)数据库(Xu等,2018)。在此,详细介绍后两个全景合成失真图像质量数据库,其他全景合成失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1)Sui21数据库(Sui等,2021)。由江西财经大学2020年构建,用于研究观看起始点、观看时间和失真等因素对OI质量的影响。相对其他数据库,该数据库规模较小,包含36幅参考图像和36幅失真图像,每幅参考图对应一幅失真图,失真类型包括H.265压缩和拼接(stitching)失真。数据库采用单刺激法进行主观实验,主观分数以MOS的形式提供,范围为[1, 5]。

2)SOLID数据库(Xu等,2018)。由中国科学技术大学2018年构建。不同于上述4个OI质量数据库,均包含单一视图全景图像,该数据库中的全景图像为立体全景图像,即一幅立体全景图像包含一幅左视图全景图像和一幅右视图全景图像,共包含6幅高质量全景图像和156幅失真图像,分辨率为8 192×8 192像素,影响图像质量因数包括深度信息变化和压缩失真。数据库采用单刺激法进行主观实验,主观分数以MOS的形式提供,范围为[1, 5]。

1.1.5 光场图像

现有光场合成失真图像质量数据库主要包括MPI-LFA(max planck institut informatik light field archive)数据库(Adhikarla等,2017)、光场图像数据库(Paudyal等,2017)、VALID(visual quality assessment for light field images dataset)数据库(Viola和Ebrahimi,2018)和Win5-LID(windowed 5 degree of freedom light field image database)数据库(Shi等,2019b)。有关光场合成失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1.1.6 小结

从图像失真的角度来看,部分合成失真图像质量数据库仅针对某种失真(如压缩失真)进行针对性的研究工作。而大部分的合成失真图像质量数据库包含多种类型的失真,如TID2013数据库、KADID-700k数据库、Wu20数据库(Wu等,2020a)均包含20种以上的失真类型。并且,近年来构建的数据库规模越来越大。合成失真图像质量数据库的构建相对简易,可通过计算机直接模拟失真过程。因此,在参考图像数据足够多的情况下,可生成大量的合成失真图像(Ma等,2017b;Lin等,2019;Wu等,2020a)。虽然合成失真与大部分应用场景中的真实失真及算法相关失真存在天然的分布差异,模拟图像降质过程依然是一个可选择的研究方向,其优势在于数据收集的简便性(可不收集主观分数,而是使用伪标签代替),大量的失真图像数据可用于训练基于深度学习的IQA模型。

1.2 针对合成失真的IQA模型

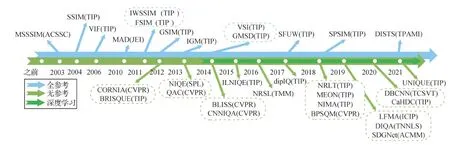

考虑到早期的IQA研究主要在合成失真图像上进行,且近年来依然有较多的IQA研究涉及合成失真,为了更好地区分针对其他类型失真的IQA研究,本文将在合成失真图像质量数据库上验证的IQA模型统称为针对合成失真的IQA模型。本小节介绍的IQA模型包括FR-IQA、RR-IQA和NR-IQA模型,重点介绍模型的设计思想和建模方式。针对合成失真的IQA模型发展历程如图2所示。

图2 合成失真图像质量评价方法发展历程(1)图2中的方法括号内为会议和期刊名称,具体为ACMM(ACM Multimedia); ECCV(European Conference on Computer Vision); CVPR(IEEE/CVF Conference on Computer Vision and Pattern Recognition); TII(IEEE Transactions on Industrial Informatics); TIE(IEEE Transactions on Industrial Electronics); TCYB(IEEE Transactions on Cybernetics); TCSVT(IEEE Transactions on Circuits and Systems for Video Technology); TNNLS(IEEE Transactions on Neural Networks and Learning Systems); TMM(IEEE Transactions on Multimedia); TIP(IEEE Transactions on Image Processing); TOG(ACM Transactions on Graphics); TPAMI(IEEE Transactions on Pattern Analysis and Machine Intelligence。

1.2.1 2维图像

应用较为广泛的一个FR-IQA模型是峰值信噪比(peak signal-to-noise ratio,PSNR),它的计算方式为

(4)

式中,Ir和Id分别表示参考图像和失真图像,L表示图像的最大动态范围,一般为255,N表示图像中像素点的个数。PSNR的工作原理是通过计算参考图像和失真图像对应位置像素的差,进而得到失真图像的质量分数。它的计算效率较高,且在度量某些特定的失真(如压缩失真)时性能较好,因而一直是IQA相关领域广泛应用的方法之一。PSNR的主要缺点是没有考虑人眼视觉特性,总体而言,它在IQA任务中表现较为一般。而结构相似性(structural similarity,SSIM)(Wang等,2004)考虑人类视觉系统对结构信息的敏感特性,可以获得与主观较为一致的预测结果。SSIM的计算方式为

(5)

因在预测图像质量分数时不需要参考图像,NR-IQA模型是近些年IQA研究的热点问题。NR-IQA模型的特征建模方式大致包括4类:1)自然场景统计(natural scene statistics,NSS)(Wang和Bovik,2011b);2)直方图统计;3)字典学习;4)端到端深度学习。前3种特征建模方式往往需要结合机器学习模型如支持向量回归(support vector regression,SVR)训练得到NR-IQA模型,而第4种特征建模方式是通过端到端的学习,得到图像特征表达与质量分数回归模型。NSS是NR-IQA建模中使用较为广泛的一种方式,它的核心思想是“质量完好”图像的视觉特征呈现一定的分布,而失真的引入会扰动特征的分布。基于此规律,研究人员对NR-IQA进行了深入的研究。Mittal等人(2012)较早地提出使用空域下NSS特征的NR-IQA模型,称之为BRISQUE(blind/referenceless image spatial quality),该作者研究发现,视觉质量完好的图像亮度特征呈现广义高斯分布(generalized Gaussian distribution,GGD)。同时,相邻像素对的亮度值乘积呈现非对称广义高斯分布(asymmetric generalized Gaussian distribution,AGGD),该作者使用GGD和AGGD模型的参数作为感知图像质量的特征。Gu等人(2015)提出基于自由能机制和NSS的NR-IQA模型,其中NSS部分为图像亮度特征拟合的GGD模型的参数。Mittal等人(2013)将BRISQUE的思想扩展至多元高斯(multivariate Gaussian,MVG)模型,提出基于无监督学习的NR-IQA模型,称之为NIQE(natural image quality evaluator)。其中,失真图像质量的计算方式为失真图像拟合得到的MVG模型与“质量完好”图像拟合得到的MVG模型的距离。Zhang等人(2015)在NIQE的基础上引入更多的特征描述,包括结构特征、方向和频率特征以及颜色特征,提出无参考图像质量评价模型ILNIQE(integrated local NIQE)。NSS的另一种特征提取方式是使用拟合得到的分布的概率值作为感知图像质量的特征,如Fang等人(2015)、贾惠珍等人(2014)的工作。

上述基于NSS的NR-IQA模型在特征提取过程中都需要拟合特征分数,这类特征建模方式虽然被广泛应用在IQA领域,其不足之处在于它的前提条件是图像视觉特征呈现一定的分布,而有些图像(如SCIs)的视觉特征不存在此规律,因而该类特征建模方式的应用存在局限性。研究人员尝试将NSS推广至一般形式,即不用特定的分布函数去拟合视觉特征分布,而是通过更加简便的方式即直方图表示视觉特征分数,如下

f=[f1,f2,…,fv]

(6)

(7)

(8)

第3种NR-IQA特征提取方式是字典学习。字典学习是指从图像中抽象出有代表性的原子,组成一个字典,再通过字典来表征图像。字典学习可表示为

(9)

(10)

式中,I表示图像,D表示学习到的字典,x表示稀疏系数矩阵,xk表示第k个系数,dk表示图像块或者特征向量,K表示字典中元素的数量,ε为常数,表示误差项。在提取视觉特征时,该类方法首先学习到字典,再使用稀疏系数作为表征图像质量变化的特征(高飞和高新波,2014;Jiang等,2017)。式(9)(10)中描述的是稀疏编码(sparse coding),获得字典需要反复的迭代过程。另一种直接的方式是构建码本。Ye等人(2012)提出使用K-Means聚类方法构建码本,并利用软分配编码和最大池化获取图像视觉感知特征,该方法称之为CORNIA(codebook representation for no-reference image assessment)。进一步地,Xue等人(2013)提出无参考图像质量评价模型(quality-aware clustering,QAC),通过构建码本之前首先使用FR-IQA算法(Zhang等,2011)计算图像块的分数,再根据客观分数对图像块分类。然后在每类图像块(属于同一个分数范围)中通过K-Means聚类获得聚类中心,作为码本。不同于CORNIA,该方法(Xue等,2013)直接使用码本计算图像质量分数。类似于CORNIA中的码本构建方法,Xu等人(2016)提出一种融合高阶统计特征的NR-IQA方法,通过计算测试图像中的图像块与码本中图像块间的高阶统计特征差异以用于后续的模型训练。Ye等人(2014)对于现有IQA算法进行拓展和融合,提出盲图像质量评价方法(blind learning of image quality using synthetic scores,BLISS)。

不同于上述3种特征建模方式,基于深度学习的模型不需要手工设计特征,可以通过端到端学习得到图像特征提取模型与映射模型。该类模型的核心在于卷积神经网络(convolutional neural network,CNN),可表示为

q=fc(conv(Ip))

(11)

式中,Ip表示输入图像块,q表示预测分数,fc表示全连接层(fully-connected layers,FCLs),conv表示卷积层(convolutional layers,CLs)。Kang等人(2014)较早地将CNN引入NR-IQA模型的设计中,提出模型CNNIQA(convolutional neural network for image quality assessment)。该模型仅包含1层CL、1层池化层和2层FCLs。Kim等人(2019b)提出了一个称为DIQA(deep image quality assessment)的NR-IQA模型,该模型通过两阶段训练。其中,第1阶段训练可学习客观误差图的CNN;第2阶段使用人类主观分数微调CNN模型。Yang等人(2019b)提出了一个基于双分支CNN结构的NR-IQA模型,两个分支分别处理输入图及对应的梯度图,最后将两个分支处理后的特征向量融合,经过FCLs,输入为图像质量分数。Zhang等人(2020a)提出了一个双线性NR-IQA模型(deep bilinear convolutional neural network, DBCNN),适用于合成失真和真实失真图像质量预测。模型特征提取模块包含两个分支,分别为一个浅层的CLs和VGG16(Visual Geometry Group)模型(Simonyan和Zisserman,2015),使用双线性汇合(bilinear pooling)融合两分支的输出特征图,再通过FCLs进行质量预测。

上述模型(Kang等,2014;Kim等,2019b;Yang等,2019a;Li等,2019a)仅包含特征提取模块和分数预测模块,也有研究者尝试在NR-IQA模型中加入多个模块,如相似性图预测模块。Pan等人(2018)提出首先使用U-Net(Ronneberger等,2015)训练质量图预测模型,再训练分数预测模型,模型称为BPSQM(blind predicting similar quality map)。Lin和Wang(2018)提出基于生成对抗网络(generative adversarial network, GAN)的NR-IQA模型,该作者使用GAN训练参考图预测模型,并将产生的参考图与失真图作为质量预测模型的输入。类似地,Li等人(2020c)提出使用差异图预测模型,再使用预测的差异图构建NR-IQA模型。

研究者也深入尝试了将多任务学习(multi-task learning)引入到NR-IQA模型的设计中。Kang等人(2015)和Ma等人(2018b)尝试使用图像失真类型预测任务,辅助IQA任务。其中Ma等人(2018b)提出的模型为MEON(multi-task end-to-end optimized deep neural network)。Yan等人(2019a)提出基于自然性预测的NR-IQA模型(natural scenes statics aided deep neural network,NSSADNN)。Yang等人(2019a)提出了一个显著性预测任务辅助的NR-IQA模型称为SGDNet(saliency-guided deep neural network),显著性预测和图像质量预测任务在前期共享特征提取器。

1.2.2 3维图像

不同于NI,一幅SI包含一幅左视图和一幅右视图。因观看SI时存在双目视觉特性(双目竞争和双目抑制),直接将2维图像质量评价方法应用于SIs无法获得较好的结果。考虑到双目竞争机制,Chen等人(2013b)提出先通过立体算法将SI的左右视图合成一幅2维图像,再使用2维图像质量评价算法计算得到3维图像的质量分数。Wang等人(2015)提出一种FR-SIQA(full-reference stereoscopic image quality assessment)方法,包括两个步骤:首先使用基于信息内容和归一化的结构相似性算法计算单视图的视觉质量评价;然后使用一个双目竞争机制启发的多尺度融合策略,将单视图质量分数转化成SI质量分数。

针对SIs的NR-IQA模型研究也较为热门。Chen等人(2013a)提出一种基于NSS特征的SIQA方法,NSS特征包括2维亮度统计特征和3维视差统计特征。考虑到双目视觉特性,即双目竞争(binocular rivalry,BR)和双目融合(binocular integration,BI),Fang等人(2019c)提出融合单目视觉特征和双目视觉特征的NR-SIQA(no-reference stereoscopic image quality assessment)模型。其中,单目视觉特征为左右视图的亮度统计特征;双目视觉特征为SI的结构特征和深度特征。针对3维图像,Lyu等人(2016)受双目视觉理论的启发,提出一个基于双目自相似度(binocular self-similarity,BS)和BI的NR-SIQA方法。Sim等人(2021)提出使用深度语义特征和传统视觉特征感知SI质量变化,使用SVR训练质量回归模型。

研究者也将CNN引入3维图像质量评价模型中。Oh等人(2017)建立了一个基于局部到全局特征聚合的深度NR-SIQA模型,该模型的训练包括两个阶段:第1阶段为局部质量分数预测,使用FR-SIQA模型获取SI的标签数据,再利用计算的标签指导基于块的CNN模型进行预训练。第2阶段为全局质量预测,在基于块的CNN模型上添加局部特征融合层,然后将局部特征聚合为全局特征,并通过FCLs转化为预测分数。受人类视觉系统(human visual system, HVS)多层结构及层次间交互现象的启发,Zhou等人(2019b)提出了一个NR-SIQA网络模型,该模型包含2个结构相同的子网络,均包含5个卷积层和2个全连接层。这2个子网络分别提取左右视图的特征,并在第2层和第5层分别进行交互操作,以获取低级双目特征和高级双目特征。最后,连接左右视图单目特征和高低级双目特征向量,并使用两个FCLs进一步融合特征,输出SI的质量分数。Kim等人(2019a)提出了一个双目融合深度网络(binocular fusion deep network,BFN),用于预测立体图像视觉舒适度。BFN主要包含空间特征编码、双目特征编码和视觉舒适度预测3部分。空间特征编码部分由多个不同尺度的卷积层组成,用于提取左右视图的不同感受野的空间特征;双目特征编码部分通过逐层融合左右视图不同尺度的空间特征来学习3维图像潜在的双目特征;视觉舒适度预测部分将学习到的潜在双目特征进行非线性映射,从而得到最后的视觉舒适度分数。同时,还定义了一个视差正则化网络,用于辅助BFN的训练。

Fang等人(2019a)考虑到大脑内在推导机制(Wu等,2013b)和HVS中的双目竞争机制(Chen等,2013a),提出一种基于双通道融合CNN的3维图像质量评价模型,该模型的双通道为权值共享网络,设计思想来源于VGG16(Simonyan和Zisserman,2015)。左右视图分别经过单一通道,获得相应的特征图,然后连接左右视图的特征图,并使用2个卷积层进一步融合左右视图信息,最后通过2个全连接层将融合后的特征图转化成质量分数。Yan等人(2020b)进一步提出了一种基于多尺度特征融合网络的3维图像质量评价模型,不同于仅融合高层抽象信息的模型(Fang等,2019b),该模型分别融合3维图像的低层、中层和高层抽象信息,再通过2个卷积层进一步融合多层信息,最后通过全连接网络将多层融合信息映射为主观分数。Xu等人(2021)受到预测编码理论和双目竞争机制启发,提出一个两阶段3维图像质量评价算法。其中,第1阶段是重构输入的失真左/右视图,第2阶段是将第1阶段预测编码过程中的似然图、先验图和左右视图作为质量评价网络的输入,输出为质量分数。

1.2.3 屏幕图像

SCI是指电子设备(如电脑显示屏)上显示的图像等,主要包含自然图像部分和文本部分。新加坡南洋理工大学较早地开始屏幕图像质量评价(screen content image quality assessment,SCIQA)研究(Yang等,2015),根据HVS对图像部分和文本部分不同的敏感性,提出使用锐利度计算图像部分的降质情况,使用锐利度和亮度计算文本部分的降质情况,然后使用基于屏幕图像变化(image activity measure,IAM)自适应权重策略融合图像部分和文本部分的降质情况得到屏幕图像的质量分数。进一步地,Fang等人(2017c)提出一种基于不确定性权重的FR-SCIQA(full-reference screen content image quality assessment)方法,简称为SFUW(structural features and uncertainty weighting)。该方法使用梯度域下的结构相似性度量文本部分的降质情况,使用亮度特征和结构特征度量图像部分的降质情况,最后使用梯度域下的信息熵自适应融合文本部分和图像部分的质量分数得到SCI的最终质量分数。Wang等人(2018a)考虑到HVS对图像区域和文本区域感受野的差异性,提出基于感受野自适应性和信息内容加权策略的SCIQA模型。除了上述考虑文本区域和图像区域差异性的SCIQA模型,也有较多模型在计算SCIs时不区分文本区域和图像区域。如:Gu等人(2016c)提出一种基于显著性的SCIQA方法,Ni等人(2016,2018)分别提出基于梯度方向、基于Gabor特征和基于边缘相似性的SCIQA方法,Fu等人(2018)提出使用多尺度高斯差分度量SCI的降质问题,Gu等人(2018a)提出局部和全局的结构信息计算SCI质量变化。Wang等人(2018b)从视觉感知的角度提出一种RR-SCIQA模型。

除了上述的FR-和RR-SCIQA方法,研究者们也陆续提出了较多的NR-SCIQA方法。Gu等人(2017)提出使用4类特征用于感知SCIs的质量变化,包括图像的复杂度、屏幕内容统计、全局亮度和细节锐利度。Fang等人(2018b)基于HVS对亮度和纹理的敏感特性,提出使用直方图提取亮度统计特征以及高阶导数纹理特征感知屏幕图像质量的变化。Zheng等人(2019)提出一种基于区域分割的NR-SCIQA(no-reference screen content image quality assessment)方法,使用局部标准差区分锐利边缘块和其他块。对于锐利边缘块,使用灰度共现矩阵的熵和对比度捕捉细小结构变化,并使用局部相位一致性度量锐利度信息丢失,将这部分特征做平均池化得到SCI的局部特征。对于整张SCI,使用亮度信息度量全局变化。最后,联合局部特征和全局变化用于表征SCI得到质量。受中心环绕机制(center-surround mechanism)启发,Fang等人(2020a)提出色彩和纹理变化统计特征感知SCI质量变化。Chen等人(2018b)提出一个自然化模块(naturalization module)用于解决NIs和SCIs之间视觉感知特性差异问题,并成功用于构建基于CNN的NR-SCIQA模型。Chen等人(2021a)首次提出针对SCIQA的无监督域迁移问题的解决方案,其中,NIs作为源域(source domain),SCIs作为目标域(target domain),联合最大化平均差异、排序学习和均方误差训练模型。

1.2.4 全景图像

OI作为VR技术中重要的信息载体之一,与传统2D图像存在较大差异,其存储与传输更加困难,容易引入不同的失真从而影响OI的质量。在沉浸式的视觉环境下,人们对于OI的视觉观看体验受到众多因素的影响,如起始点、观看时间以及观看路径等,并且目前针对OIQA的相关工作较少(Xu等,2020a;Sui等,2021)。

最近,深度学习技术也应用于OIQA中。Chen等人(2020)提出一种基于预测编码理论(predictive coding theory, PCT)的FR-OIQA(full-reference omnidirectional image quality assessment)算法。该算法包含一个基于PCT的双目竞争模块(PCT-binocular rivalry module,PC-BRM)和一个多视图模块(multi-view module,MvFM),其中,PC-BRM用于计算通过投影得到的视口的视觉质量分数,MvFM用于融合视口的分数得到OI最终的质量分数。Li等人(2020b)提出一种有效的OI-Stitching方法,并提出一种结合注意力的OIQA方法。Zhou等人(2021a)提出一种结合高、低频率信息和局部自然性的NR-OIQA方法。该方法首先使用离散哈尔小波变换将OI的等距柱状投影(equirectangular projection,ERP)格式转换,然后分别计算低频和高频子带的信息熵得到OI的频率信息。同时,提取全景图像的多个视口,并计算每个视口的NSS特征。最终,组合频率信息和局部NSS特征用于表征OI质量变化。Jiang等人(2021)开展了另一种格式的OIQA研究,即立方体图(cube map)。Zhou等人(2021b)提出一种多任务学习的OIQA模型,该模型包括一个质量预测分支和一个失真分类分支。Sun等人(2020)提出一种基于多通道卷积神经网络的FR-OIQA方法,通过将OI分别投影到6个视点图以保持与VR设备中场景内容观看一致。该方法模型由多通道卷积神经网络和图像质量回归两部分内容组成,其中多通道卷积神经网络部分用于有效提取图像中的相应特征,而质量回归部分则用于融合所提特征并进行特征到质量分数的映射学习。Kim等人(2020)提出基于对抗神经网络的OIQA方法。该方法将OI分割成若干图像块并估计其局部质量和相应权重,通过融合局部权重与局部质量得到最终的OI质量。Xu等人(2020b)提出基于视点导向的图神经网络的NR-OIQA方法,通过选择具有较高可见概率的选定视图作为图节点,建立OI各视点间的相互依赖关系,并经过图卷积网络对所提图进行推理。另外,在不进行视口采样的情况下,可利用整体OI直接获得全局质量。

1.2.5 光场图像

光场记录了空间中光线的集合,包含光线在空间中的位置和角度信息。由于光场包含丰富的场景信息,尽管近年来出现了许多光场处理技术,但这些操作在一定程度上都会导致视觉质量损失,为了对LFI的视觉质量进行有效评估,一些方法陆续提出(Fang等,2018a;Min等,2020)。

Shi等人(2019a)、Shi等人(2019b)于2019年提出了针对LFI的NR-IQA方法,作者通过使用双目视觉特征度量空间质量和角度一致性。并基于该方法,进一步提出基于张量理论的NR-LFIQA方法(Zhou等,2020b),通过考虑LFI的全局与局部特性,设计度量LFI主成分空间特征和张量角变化的指数。Meng等人(2020)提出从空间和角度信息度量光场图像的视觉质量。Tian等人(2020)提出使用阵列子图像(sub-aperture images,SAIs)的多尺度log-Gabor特征和极线图(epi-polar images,EPIs)的单尺度的log-Gabor特征感知光场图像质量变化。

1.2.6 小结

早期的IQA模型都是针对NIs,PSNR和SSIM等模型因计算简易和性能优异广泛应用于多媒体相关领域的任务中,如图像去噪、增强等。有参考IQA模型(主要指FR-IQA模型)的改进策略主要包括两点:提出更加有效的特征用于捕捉图像视觉质量失真;设计有效的权重策略(如信息内容加权)获得更加合理的局部到全局的质量聚合。基于手工特征的NR-IQA模型的改进主要着重于设计更加有效的特征表达。而基于深度学习的NR-IQA模型的改进包括训练技巧、训练数据部分、模型部分和损失函数等。随着多媒体技术的发展,图像内容也变得多样。为了进一步提升IQA模型性能,根据图像内容特点设计的IQA模型陆续提出,图像内容特点包括SIs的双目视觉机制、SCIs中图像部分和文本部分的降质对HVS的影响存在差异(如Fang等人(2017c)提出的基于不确定性加权的屏幕图像质量评价模型)、OIs的局部可视特性观看轨迹受观看条件、光场图像的空间信息和角度信息等影响。

2 针对真实失真的IQA研究

不同于合成失真,在日常的图像拍摄和处理系统中通常由于人工拍摄的不稳定性和系统处理算法缺陷,会对拍摄得到的图像引入不同类型和不同程度的噪声,导致图像的整体质量下降。基于合成失真的客观质量评价方法往往无法有效应用于真实失真的质量评价之中。因此,如何客观有效地评估含有真实失真的图像质量有利于各种质量驱动应用的优化和改进。为了解决上述存在的问题,真实失真图像质量数据库以及客观评价算法陆续提出。

2.1 真实失真图像质量数据库

现有真实失真图像质量数据库主要包括LIVEC(live in the wild image quality challenge)数据库(Ghadiyaram和Bovik,2016)、KonIQ-10K(Konstanz authentic image quality database)数据库(Hosu等,2020)、SPAQ(smartphone photography attribute and quality)数据库(Fang等,2020c)、FLIVE(large-scale social picture quality database)数据库(Ying等,2020)、BID(blurred image database)数据库(Ciancio等,2011)和CID(camera image database)数据库(Virtanen等,2015)。在此,详细介绍后两个真实失真图像质量数据库,其他真实失真图像质量数据库具体内容详见Fang等人(2021b)论文。

1)BID数据库(Ciancio等,2011)。由巴西里约热内卢联邦大学在2011年建立,共包含代表真实模糊失真的585幅图像。图像根据模糊种类划分成5类,分别是清晰图像、失焦模糊图像、简单运动模糊图像、复杂运动模糊图像和其他图像。主观实验采用单因素法(single stimulus,SS)进行图像连续质量范围评分。最终的图像主观质量分数取值范围为[0, 5]。

2.2 针对真实失真的IQA模型

根据真实图像质量评价特点,可以将现有评价算法分为网络模型结构设计和数据训练策略调整、训练策略调整(混合数据库和多任务学习)改进两种方式。同时,根据是否应用深度学习框架,也可以分为传统方法和深度方法。因为真实失真图像不存在参考图像,所以针对真实失真的IQA模型均属于NR-IQA 模型(Ghadiyaram和Bovik,2017)。真实失真图像质量评价方法发展过程如图3所示。

图3 真实失真图像质量评价方法发展历程

Liu和Liu(2018a)通过从亮度、对比度、颜色和纹理等感知域提取特征并分别用于训练质量分数预测模型,利用模型选择算法对整体模型进行优化并得到最终集成的NR-IQA模型(wide-perceptual-domain scorer ensemble,WPDSE)。Liu等人(2020)提出一个基于结构、自然性和感知质量变化特征提取的无监督NR-IQA模型(natural image quality evaluator based on structure, naturalness and perception,SNP-NIQE)。为了更好地评估不同质量评价算法的差异,Wu等人(2018)通过考虑高质量图像的排序准确性和主观判断的不确定性,提出了一个感知加权排序相关指标(perceptually weighted rank correlation indicator,PWRC)以比较不同的图像质量评价算法。Guan等人(2017)提出一个视觉重要性和失真指导的深度质量评价模型(visual importance and distortion guided deep image quality assessment,VIDGIQA)。Bosse等人(2018b)提出了一种基于加权平均和分块联合优化的NR-IQA模型(weighted average deep image quality measure,WaDIQaM),该模型实现了将图像局部块质量池化为全局图像质量。Kim等人(2017)对基于CNN的数据驱动的图像质量预测模型进行深入分析和汇总,并将这些模型在现有数据库上进行了结果对比。为了解决真实图像失真多样性和内容变化多样性,Su等人(2020)提出一种自适应网络结构以进行真实失真图像质量评估(self-adaptive hyper network,SAHN),该方法将质量评价过程划分为3个阶段,分别是内容理解、感知规则学习和质量预测。Su和Korhonen(2020)通过提出基于加权空间池化(weighted spatial pooling,WSP)的NR-IQA方法,使用WSP替代全局平均池化(global average pooling)以实现网络任意输入尺寸大小。Lin等人(2020)提出一个基于特征学习的NR-IQA模型(deep image quality assessment by feature learning,DeepFL-IQA),该模型通过多任务学习从11个FR-IQA指标中学习质量预测模型。Sun等人(2021a)提出一个基于失真图表示(distortion graph representation,DGR)的NR-IQA方法(distortion graph representation based IQA,GraphIQA),通过比较不同的DGR区分不同失真类型,进而学习DGR不同失真程度之间的关系以预测图像质量。最近自然语言处理领域常用模型Transformer也被引入到图像质量评价领域中。You和Korhonen(2021)提出基于浅层Transformer编码器的NR-IQA方法,称为TRIQ(Transformer-based image quality)。

现有IQA领域通常使用单一质量分数作为图像质量衡量指标,但往往无法全面代表图像的真实多样性质量。Siahaan等人(2018)发现通过添加图像语义信息,如场景内容、目标种类等,可以帮助提升现有的NR-IQA模型(semantic-aware image quality,SA-IQ)。Zeng等人(2018)提出一个基于概率质量表达的NR-IQA方法(probabilistic quality representation,PQR)。通过将概率约束加入到网络模型的训练中以调整模型学习过程。Varga等人(2018)提出预测图像质量分布而不是直接预测图像单一主观分数,并设计出一个基于卷积神经网络的NR-IQA算法(deep ResNet,deepRN)。Jiang等人(2019)提出使用一种信息更丰富的矢量化标签,经验分数分布(empirical score distribution,ESD),以建立ESD辅助的真实失真图像质量预测的深度神经网络模型。

Dendi等人(2019)提出使用质量评价指标生成的图像质量图作为标签进行自编码模型预训练,用于训练模型的失真图像通过添加合成失真生成,利用合成失真图像预训练模型对真实失真图像进行质量图预测,并根据获得的质量图进行特征提取从而实现图像质量回归(distortion net,DistNet)。人类视觉系统的视觉注意使得人类对注意区域的失真比非注意焦点区域更加敏感,因而,视觉注意机制可以被集成到图像质量评价当中。类似地,Li等人(2021)提出一个基于多尺度和多分层融合的多任务学习卷积神经网络图像质量评价模型(multi-task deep convolution neural network with multi-scale and multi-hierarchy fusion,MMMNet),通过联合优化质量预测子任务和显著性预测子任务,提高以显著性导向的图像质量评价性能。

为了解决图像质量特征有效表达和训练样本不充足的问题,Sun等人(2021b)提出基于阶梯结构和混合数据库迭代训练策略的NR-IQA模型,其中,网络阶梯结构用于分层提取低水平特征和高层语义特征,混合数据库迭代训练策略(iterative mixed database training strategy,IMDT)则用于同时训练多个数据库内容。现有基于深度学习的IQA模型构建过程中通常依赖于通过其他领域训练得到的预训练权重,而这些权重只针对于某些特定任务,可能与质量评价任务不符。Zhu等人(2020)首次将元学习引入到IQA领域以解决泛化问题,设计出基于深度元学习的NR-IQA模型(meta IQA,MetaIQA)。为了探索图像高水平的语义信息,Li等人(2019a)提出了一个针对真实模糊图像的基于语义特征聚合的NR-IQA方法(semantic feature aggregation,SFA),该算法模型输入的特征是通过已有预训练深度模型进行提取。Li等人(2020a)从损失函数出发设计出norm-in-norm的损失函数以实现IQA模型学习快速收敛和更好性能。

从传统合成失真到真实失真评价,现有IQA方法还无法做到合理跨越或有效集成。Zhang等人(2020b)紧接着提出一个基于排序学习的多数据混合训练的NR-IQA方法,该方法解决了不同数据库由于失真和主观分数差异较大造成难以共同训练的问题。并在此基础上,Zhang等人(2021a)设计出一个通用的合成失真和真实失真混合数据库训练的盲图像质量评价和不确定性度量指标(unified no-reference image quality and uncertainty evaluator,UNIQUE)。由于现有IQA模型通常不能自适应新出现的失真,且无法进行连续有效数据迁移,Zhang等人(2021b)提出了一个在已训练数据学习的基础上从现有IQA数据集的流中不断进行学习(continual learning for IQA,CLIQA),解决模型的学习遗忘的缺陷,从而提升模型的泛化能力。Liu等人(2021b)提出了一个终生盲图像质量评价方法(lifelong blind image quality assessment,LIQA),采用分并蒸馏策略训练一个单支网络以进行不可知任务的预测。同时,使用基于失真类型和质量分数的生成器来生成伪特征,在学习新任务时充当记忆重放器。

为了扩充现有真实失真图像数据,Ou等人(2019)模拟真实失真过程产生失真图像,并提出一个基于可控列表排序的NR-IQA模型(controllable list-wise ranking,CLRIQA)。同样地,Wang等人(2021a)生成包含模拟真实失真的失真图像数据用于模型训练,并设计无监督域自适应模块(unsupervised domain adaptation module,UDA)以解决从合成失真到真实失真的域迁移问题。Wang等人(2021b)提出了一个半监督集成学习的方法,以构建泛化能力强的NR-IQA模型。现有IQA模型通常以低分辨率图像作为输入进行训练,为了研究高分辨率图像的质量评价,Korhonen等人(2021)提出基于循环神经网络的高分辨率的NR-IQA模型(recurrent neural network IQA,RNN-IQA)。

2.3 小结

本节从真实失真数据库和相应的评价算法两个方面详细介绍了针对真实失真图像质量评价方法的发展历程。其中,主观图像数据库在数量和内容上都在不断增加,但相对合成失真图像质量数据库,数量及规模依然较小,主要障碍在于收集大量的主观分数是非常困难的。相应的NR-IQA模型设计已从特征工程逐渐转向深度学习,而针对真实失真的基于深度学习的NR-IQA模型也从单一的端到端学习、多任务学习发展到专注于解决模型鲁棒性。

3 针对算法相关失真的IQA研究

近年来,由于图像在日常生活中得到广泛的应用,一些针对特定算法处理过程中产生的失真图像质量评价相关研究逐步提出。本文对基于深度图的图像绘制(depth image based rendering,DIBR)、超分重建(super-resolution,SR)、多曝光融合(multi-exposure fusion,MEF)、色调映射(tone-mapping,TM)和图像增强与修复(image enhancement/restoration,IE/IR)5类算法进行总结与概括,其中,图像增强与修复具体包括图像去雨(image deraining,IDR)、图像去雾(image dehazing,IDH)、图像去模糊(image deblurring,IDB)和图像去噪(image denosing,IDN)等。根据5种不同特定算法的自身特点,概述各应用背景下的相关图像质量评价发展过程。

3.1 算法相关失真图像质量数据库

3.1.1 基于深度图绘制图像质量数据库

DIBR技术指的是借助深度信息,将原始视角图像投影至3维空间,再投影至目标视角的2D平面(周玉,2019)。该技术主要包括变形和绘制两个过程。为了填补非掩蔽区域,往往容易引入填补失真,该类失真主要呈现非局部分布特性。主流的DIBR数据库包括以下3个。

1)IETR DIBR(Institut d′Electronique et Téléc-ommunications de Rennes depth image based rendering)数据库(Bosc等,2011)。由法国国立应用科学学院2011年构建,包含由7个DIBR算法的生成150幅DIBR图像,来源于10个多视角序列。数据库采用绝对分类评分法进行主观实验,主观分数以DMOS的形式提供。

2)MCL-3D(media communications lab-3d)数据库(Song等,2015)。由西安电子科技大学在2015年建立,共包含9幅原始图像及对应的深度图,693对合成立体图像。图像分辨率包括1 024×768像素和1 920×1 080像素,失真类型包括高斯模糊、白噪声、下采样模糊、JPEG压缩、JPEG2000压缩和传输错误,噪声加在彩色图或深度图上。数据库采用双刺激法进行主观实验,数据库以MOS的形式提供主观分数。

3)IRCCyN/IVC DIBR数据库(Tian等,2019)。由法国IETR构建,共包含12幅参考图像和由7种DIBR算法生成的84幅DIBR图像。数据库采用连续评分法进行主观实验,受试者可以比较不同的失真图像。该数据库主观分数以MOS的形式提供,源于21个受试者打分。

3.1.2 超分辨率图像质量数据库

相较于低分辨率图像,高分辨率图像有着更加丰富的细节和图像质量。但由于高成本、难获取等因素,目前还无法广泛应用于实际生活之中。因此,单张图像超分辨率(single-image super-resolution, SISR)技术应运而生,其目标是从低分辨率图像生成高分辨率图像。早期简单的图像上采样技术已经无法满足当前人们的需求,更加有效的SR算法逐步提出。在SR过程中,因为过程复杂和诸多技术问题,导致生成的SR图像可能存在一定程度的失真,对图像的质量有较大的影响。因而,如何有效度量SR过程中的图像失真,评估SR图像的真实质量以及优化现有SR算法则尤为重要。

在SR任务中,通常有以下几个基础图像数据集,包括Set5(Bevilacqua等,2012), Set14(Zeyde等,2010), BSD100(Berkeley segmentation dataset)(Huang等,2015)和BSD200(Martin等,2001),广泛应用于SR方向。数据集Set5和Set14分别包含5幅和14幅不同分辨率的图像。数据集BSD100和BSD200中的原始图像来源于Berkeley图像分割数据库。在这些数据集的基础之上,一些针对于SR图像质量评价的数据库逐步提出。现有超分辨率图像质量数据库主要包括超分图像数据库(Ma等,2017a)、SRID(super-resolution reconstructed image database)数据库(Wang等,2017a)、超分图像数据库(Lukeš等,2013)、超分图像数据库(Yang等,2014)、超分图像数据库(Yeganeh等,2015)、NID(non-inter image interpolation database)数据库(Chen等,2018a)、QADS(quality assessment database for super-resolved images)数据库(Zhou等,2019a)、SISRSet(single image super-resolution set)数据库(Shi等,2019a)、SISAR(super-resolution image quality database with semi-automatic ratings)数据库(Zhao等,2020b)、SUPE(super-resolution erlangen database)数据库(Köhler等,2020)和SRIJ(super resolution image quality assessment javeriana database)数据库(Beron等,2020)。在此,详细介绍后9个超分图像质量数据库,其他超分图像质量数据库具体内容详见Fang等人(2021b)论文。

1)Lukeš13数据库(Lukeš等,2013)。由捷克共和国捷克技术大学在2013年建立,共包含7幅原始图像和由6种不同超分辨方法以及双线性插值生成的49幅失真图像。图像包含的失真是在SR过程中产生的伪影,如振铃、额外噪声和边缘像素化等。主观实验采用单一因素方法,共有36名受试者参与实验,且受试者均没有视觉障碍。通过采用5个等级(优秀、良好、公平、较差、较差)的质量表来获得图像的最终视觉主观分数。

3)Yeganeh15数据库(Yeganeh等,2015)。由加拿大滑铁卢大学在2015年建立,共包含13幅高分辨率的原始图像(用于生成低分辨率图像)和312幅高分辨率插值图像。该高分辨率插值图像由8种不同的插值算法在不同的缩放因子设置下处理低分辨率图像产生。在主观实验中,共有30位主观受试者参与实验,最终每幅图像的主观分数通过平均所有受试者的主观评分得到。

4)NID数据库(Chen等,2018a)。由福州大学在2018年建立,共包含25幅原始高分辨率图像和480幅插值高分辨率图像。该数据库是一个非整数插值图像数据库,其中,作为中间结果的低分辨率图像是通过使用3种非整数插值因子对原始高分辨率图像进行采样得到。在主观实验中,受试者对于每幅插值高分辨率图像进行主观评分,评分范围为[0, 10]。

5)QADS数据库(Zhou等,2019a)。由深圳大学在2019年建立,共包含20幅原始高分辨率图像和由21种SR算法(包括4种插值算法、11种字典算法和6种深度学习算法)在3种采样因子(2, 3和4)的设置下生成的980幅SR图像。通过进行包含100位受试者的主观实验,从而获得每幅SR图像的主观分数,且该主观分数的取值范围为[0, 1]。

6)SISRSet数据库(Shi等,2019a)。由西安电子科技大学在2019年建立,共包含15幅原始图像和由8种SR算法生成的360幅SR图像。其中作为中间结果的低分辨率图像通过对原始高清图像进行下采样和双线性插值处理得到。在主观实验中,成对比较策略被用于计算和度量SR图像的主观分数。

7)SISAR数据库(Zhao等,2020b)。由福州大学在2020年建立,共包含由6种SR算法在3种不同的缩放因子的设置下处理生成的8 400幅SR图像。在主观测试中,采用半自动评分方法对数据库中的图像进行质量评分,并在实验过程中采用双因素连续质量等级(double stimulus continuous quality scale,DSCQS)方法。最终获得的SR图像主观分数取值范围为[0, 1]。

8)SUPE数据库(Köhler等,2020)。由德国埃尔朗根—纽伦堡大学在2020年建立,共包含由20种不同SR算法处理生成的3 024幅SR图像。这些SR图像包含不同的失真,如传感器噪声、采样失真、运动失真和编码失真等。在主观实验中,双重因素策略被使用并根据受试者的视觉感知对图像质量进行评价。

9)SRIJ数据库(Beron等,2020)。由哥伦比亚主教大学2020年建立,包含32幅原始图像和由7种不同SR算法处理生成的608幅SR图像。该数据库部分图像来源于SUPER-20数据库。在主观实验中,共有43位受试者参与测试,并且采用单因素方法进行实验。最终得到的图像的主观分数取值范围为[0, 100]。

3.1.3 多曝光融合图像质量数据库

将MEF算法用于融合具有不同曝光水平的低动态范围图像以得到良好的感知图像。对于MEF算法而言,在不同场景下的图像融合困难程度有所不同(Tursun等,2015),如静态场景与动态场景。因此,如何对融合后的图像质量进行有效评估和研究则显得尤为重要。近年来,一些针对MEF图像质量评估的主观数据库和客观评价算法逐步提出。

2)MEMF(multiexposure multifocus image fusion database)数据库(Hassen等,2015)。由加拿大滑铁卢大学在2015年建立,是一个同时包含多曝光和多聚焦的图像数据库,数据库中的融合图片由14对原始图像生成,通过采用6种不同规则的融合算法从输入图像对中提取和组合图像结构生成融合图像。通过对20名受试者进行主观测试,将主观排名得分转成为最终的主观分数。

3)MEF-D(multi-exposure image fusion with dynamic scenes)数据库(Fang等,2017b)。由江西财经大学在2017年建立,共包含20个动态自然场景的多曝光图像序列以及由9种MEF算法生成的180幅融合图像。每一组多曝光图像序列包含至少3幅不同曝光水平的图像,如低曝光、过曝光以及中间水平。数据库采用2AFC(two-alternative forced choice)方法进行主观分数收集,共有60位受试者参与主观实验,融合图像的最终主观分数形式为MOS。

3.1.4 色调映射图像质量数据库

高动态范围(high dynamic range,HDR)成像通常用于获取较大动态范围的图像内容,相比较于低动态范围(low dynamic range,LDR)的图像,HDR图像包含的颜色和亮度等内容水平更加丰富(Reinhard等,2010)。然而,由于目前HDR显示设备不足,为了使HDR图像能在传统显示器上更好地显示,大量用于将HDR图像转换成LDR图像的色调映射算子(tone-mapped operators,TMOs)相继提出,但由于TMOs的鲁棒性问题,生成的色调映射图像(tone-mapped images,TMIs)往往引入了失真。为了有效度量TMI的质量,相关的图像主观数据库和客观质量评价算法逐步提出。现有色调映射图像质量数据库主要包括TMID(tone mapped image database)数据库(Yeganeh和Wang,2013)和ESPL_LIVE HDR(embedded signal processing laboratory-laboratory for image and video engineering,high dynamic range)数据库(Kundu等,2017)。有关色调映射图像质量数据库具体内容详见Fang等人(2021b)论文。

3.1.5 增强修复图像质量数据库

本小节介绍的增强修复图像(enhanced/restored image,EI/RI)质量数据库内容包括去雨图像(derained image,DRI)、去雾图像(dehazed image,DHI)、去模糊图像(deblurred image,DBI)、去噪图像(denoised image,DNI)、生成图像(generated image,GI)和其他增强修复图像等。

1)DRI质量数据库。人们获取的雨天户外图像通常由于能见度差等问题,对图像视觉内容的理解存在一定的困难。尽管近年来为了提高图像的可见性,研究人员对IDR技术进行了大量研究。但由于现有方法对引导图像和参数选择的敏感性,通过这些方法得到的DRI往往过平滑或欠平滑,引入了各种异向性和可变性的失真,从而破坏原始图像的结构(Yang等,2021a)。目前,对于DRI数据集构建和DRI客观质量评估的相关研究相对较少。

(1)Rain100L和Rain100H数据库(Yang等,2017),由北京大学在2017年建立,共包含3 800幅合成的雨图,其中,Rain100L包括1 900幅含一种雨条纹的雨图,Rain100H则包括1 900幅含5种雨条纹的雨图。该合成雨图像数据集通常用于deraining算法模型的训练与测试,未能用于DRI的质量评价研究中。

(2)MPID(multi-purpose image deraining)数据库(Li等,2019c),由天津大学在2019年建立,共包含2 600个合成雨条纹图像对、1 010个合成雨滴图像对、700个合成雨雾图像对、50幅真实雨条纹图像、58幅真实雨滴图像和30幅真实雨雾图像。该数据库也仅用于IDR模型训练与测试。

(3)IVIPC-DQA(intelligent visual information processing and communication-deraining quality assessment)数据库(Wu等,2020b),由电子科技大学在2020年建立,共包含206幅真实雨图和由6种不同IDR算法生成的770幅DRIs。为了定量评价6种IDR算法的性能差异,共有22名受试者参与主观实验,通过对每幅DRI进行感知质量评分,最终的主观分数取值范围为[0, 100]。

2)DHI质量数据库。霾和雾由于它们对光线的散射和吸收,导致日常环境下雾天的可见度降低。虽然它们是不同的大气现象,具有不同的特征和成分,但都对相关视觉算法或系统的性能产生影响。因此,研究人员对IDH相关技术内容进行研究并提出IDH算法。但由于目前缺乏适当的指标和基准数据集,如何有效评估这些IDH算法仍然是一个开放性问题。为了解决这些问题,针对IDH算法评价的数据库和相应DHI质量评价算法逐步提出。

(1)FRIDA(foggy road image database)数据库(Tarel等,2010)和FRIDA2数据库(Tarel等,2012),由法国巴黎东部大学分别在2010和2012年建立,FRIDA和FRIDA2数据库分别包括18个城市道路场景下的90幅合成雾图和66个不同场景下的330幅合成雾图。两个数据库中的雾图均包含均匀和非均匀密度的雾。

(3)RESIDE(realistic single image dehazing)数据库(Li等,2019b),由美国康奈尔大学在2018年建立,包含14 490幅室内环境下的模拟雾图、72 135幅室外环境下的模拟雾图和9 129幅户外环境下的真实雾图,且共有4 322幅户外真实雾图通过主观实验进行标注。

(4)O-HAZE(outdoor scenes haze database)数据库(Ancuti等,2018a)和I-HAZE(indoor scenes haze database)数据库(Ancuti等,2018b),由罗马尼亚蒂米什瓦拉理工大学在2018年建立,其中,O-HAZE数据库包含45对户外雾图和对应参考图像。I-HAZE数据库则包含35幅室内雾图,图像构建方法类似于O-HAZE数据库的构建过程。

(5)DHQ(dehazing quality)数据库(Min等,2019a),由上海交通大学在2019年建立,共包含250幅不同雾密度的真实雾图和由7种不同IDH算法生成的1 750幅DHIs。通过主观实验得到每幅DHI的主观分数,且主观分数取值范围为[0, 100]。

(6)SHRQ(synthetic removing quality database)数据库(Min等,2019b),由上海交通大学在2019年建立,包含常规图像和航拍图像两个数据集,分别包括由45幅和30幅合成雾图和8种IDH算法生成的360幅和240幅DHIs。通过主观实验得到的主观分数取值范围为[0, 100]。

(7)BeDDE(benchmark database for dehazing evaluation)和exBeDDE(the extension of the bedde)数据库(Zhao等,2020a),由同济大学在2020年建立,其中,BeDDE数据库是第1个真实IDH数据集,包含从全国23个省会城市拍摄的208个图像对以用于评估不同IDH方法的性能,每个图像对包括雾图、清晰图、雾水平标签以及图像感兴趣区域的人工标注掩码。exBeDDE数据库则共包含167幅雾图和由10种IDH算法生成的1 670幅DHIs,这些DHI均有相应的主观分数。

(8)MRFID(multiple real-world foggy image database)数据库(Liu等,2021c),由武汉理工大学在2021年建立,共包含200个户外场景下的雾图和清晰图像。对所有场景进行周期为一年的拍摄,每个场景下均含有1幅清晰图像和4幅具有不同密度的雾图,包括轻微雾、中度雾、高度雾以及强度雾。通过16种IDH算法处理得到12 800幅DHIs,每幅DHI的视觉质量分数通过主观实验得到。

(9)RHVD(real haze video database)数据库(Chu等,2021),由深圳大学在2021年建立,共包含403个真实户外场景下的雾天视频。40位受试者参与主观实验以获得最终雾天视频主观分数。

3)DBI质量数据库。由于用户的无经验操作,通常会在拍摄过程中引入不同类型和程度的模糊噪声,如失焦模糊、运动模糊等。模糊通常可能造成图像内容纹理信息的丢失或者损失图像高频信息,而运动模糊不仅会在图像中引入大量的伪影,而且还会破坏检测识别等高级任务的结果。为了提高和控制图像质量,对图像中的模糊进行识别和量化具有重要意义。

(1)Liu3数据库(Liu等,2013),由美国普林斯顿大学在2013年建立,包含不同场景下的40幅高质量图像和由5种IDB算法生成的1 239幅去运动模糊图像。在主观实验中,用户通过众包平台对测试图像进行主观评分,以获得最终DBI的质量分数。

(2)DDID(defocus deblurred image database)数据库(Li等,2016a),由中国地质大学在2016年建立,共包含由8种不同IDB算法生成的240幅DBIs。该数据库中DBI的主观分数取值范围为[0, 5]。

(3)Lai16数据库(Lai等,2016),由美国加利福尼亚大学在2016年建立,包含真实模糊图像和合成模糊图像数据集。其中,真实模糊图像数据集包括通过不同摄像机拍摄的100幅真实模糊图像和由13种IDB算法生成的1 291幅DBIs,合成模糊图像数据集则分别包括100幅均匀模糊图像和由13种算法生成的1 291幅DBIs,100幅非均匀模糊图像和1 291幅DBI。

(4)GOPRO-17数据库(Nah等,2017),由韩国首尔大学在2017年建立,共包含分辨率为1 280×720像素的3 214个模糊图像对。该数据集中的图像对由GOPRO像机拍摄获取的真实模糊图像和相应清晰的图像组成。

4)去噪图像质量数据库。在系统成像的过程中,成像过程通常会引入一定程度的噪声,比如噪声或伪影等。IDN技术则是从给定的噪声信号中恢复最大视觉质量的理想无噪声信号。但由于现有IDN技术存在缺陷,导致DNI仍可能存在图像失真。为了有效评估DNI的质量和优化现有IDN算法的性能,一些针对DNI数据库和DNI质量评价方法相继提出。该数据库(Zeng和Wang,2013),由加拿大滑铁卢大学在2013年建立,共包含10幅高质量原始图像、不同失真水平的高斯噪声图像和由8种不同IDN算法生成的240幅DNIs。共有20位受试者参与主观实验以评价DNI的质量。

5)GI质量数据库。近年来,深度神经网络已被广泛应用于包括图像生成在内的各种领域。GAN虽然能够生成高度逼真的图像内容且可以作为编码器实现图像内容的编码压缩,但其作为图像压缩任务的一部分,仅通过网络模型往往难以自动评估生成图像的质量以控制编码过程。并且,现有的图像质量算法对GAN生成的内容基本无效,尤其是对于图像纹理区域和高压缩区域。为了解决上述问题,一些针对GAN生成的图像数据集和质量评价算法相应提出。

(1)LSUN(large-scale scene understanding)数据库(Yu等,2015),由美国普林斯顿大学在2015年建立,共包含由10个场景类别和20个对象类别组成的约100万幅标签图像。图像的数据标签来源于众包平台,通常用于深度视觉识别研究任务中。

(2)Cityscapes数据库(Cordts等,2016),由德国达姆施塔特戴姆勒股份有限公司在2016年建立,包含50个不同城市的街道上拍摄的多样化立体视频序列。其中,5 000幅图像具有高质量的像素级标注,因而,该数据库多用于像素水平或实例水平的语义标注任务中。

(3)FFHQ(flickr-face-high-quality)数据库(Karra等,2019),由英伟达公司在2019年建立,共包含70 000幅高分辨率人脸图像。数据库中的人脸图像在年龄、图像背景等方面都具有较大的多样性,对眼镜、帽子等配件也有更好的内容覆盖。

(4)Ko20数据库(Ko等,2020),由韩国汉阳大学在2020年建立,共包含4个GI子集,分别包括1个全分辨率的图像集合和3个图像块数据子集。该数据库由18幅含有不同程度JPEG压缩失真的参考图像和使用不同CNN和GAN生成的216幅失真GI组成,主观实验采取成对比较策略,共20位受试者从3个方面对图像进行评分以获得最终的感知质量分数。

6)其他增强修复图像质量数据库。图像增强与修复技术目的均为提升图像的质量,但前者用于显著提升图像质量,而后者则是从失真图像中恢复出潜在的清晰图像内容,处理的图像质量相对较差。虽然各种图像增强修复算法相继提出,但针对增强修复的IQA研究较少。为了区别于上述增强修复相关内容,本小节将其他增强修复内容概括于此。

(1)Chen14数据库(Chen等,2014),由北京大学在2014年建立,共包含30幅原始图像和由不同IE算法生成的EIs,增强方向包括图像去雾、水下图像增强和弱光场景增强。共有5种IE算法对每幅原始图像进行处理以得到相应的EIs。通过主观实验,得到不同增强算法生成的EIs的相对排名。

(2)CCID2014(contrast-changed image database)数据库(Gu等,2014),由上海交通大学在2016年建立,共包含15幅无损彩色图像和655幅EIs。主观实验采用单因素方案,共有22名受试者参与,最终EI的主观分数取值范围为[0, 5]。

(3)DBID(deblocked image database)数据库(Li等,2016b),由中国地质大学在2016年建立,共包含3种不同JPEG压缩水平的20幅原始自然图像和由6种去块效应算法生成的去块效应图像。主观实验采用双因素策略。

(4)CSRID(compressive sensing recovered image database)数据库(Hu等,2016),由中国地质大学在2016年建立,包含10幅原始高清图像和由10种压缩感知恢复算法生成的300幅恢复图像。通过进行主观实验,采用单因素策略获取图像质量分数,并用MOS表示图像质量。

(5)CEED2016(contrast enhancement evaluation database)数据库(Qureshi等,2017),由巴基斯坦巴哈瓦尔普尔伊斯兰大学在2017年建立,包含30幅原始彩色图像和由6种不同对比度IE算法生成的180幅EI。共有23位受试者参与主观实验以获得EI的主观质量分数。

(6)PIPAL(perceptual image processing algorithms)数据库(Gu等,2020a),由香港中文大学在2020年建立,包含250幅原始参考图像和含有40种失真类型和116种失真水平的29 000幅失真图像。主观实验通过Elo评分系统获得图像主观分数。

3.1.6 小结

不同于其他两类数据库,算法相关失真图像质量数据库因涉及到的算法不同而有所不同,可随着算法迭代而更新。总体而言,大部分算法相关图像质量数据库规模较小。随着算法的迭代更新,算法相关图像质量数据库中图像的质量也将逐渐接近。

3.2 针对算法相关失真的IQA模型

针对算法相关失真的IQA方法发展过程如图4和图5所示。考虑到内容平衡,本文将DIBR图像、SR图像、MEF图像和TM图像质量评价方法集成到一起,而单独介绍ER图像质量评价。

图4 算法相关失真图像质量评价方法发展历程(第1部分)

图5 算法相关失真图像质量评价方法发展历程(第2部分)

3.2.1 针对DIBR图像的IQA模型

除了上述的FR-DIBRIQA和RR-DIBRIQA方法,也有很多研究者致力于NR-DIBR IQA研究。Jakhetiya等人(2019)提出将DIBR图像中几何失真区域的像素点看做离群点,并以此为基础设计了一种简单有效的NR-DIBRIQA模型。Zhou等人(2019c)认为DIBR过程的两阶段都会造成边缘信息丢失和纹理信息的不自然,并提出使用高斯差分(difference of Gaussian)表达来捕捉DIBR图像的降质情况。不同于Zhou等人(2019c)方法,该方法的特征提取操作均在全局层面,Yan等人(2020a)提出融合局部结构特征变化和全局自然性建模的NR-DIBRIQA模型,并取得了非常不错的性能。Wang等人(2020a)提出离散傅里叶变换域下的NR-DIBRIQA模型。

3.2.2 针对SR图像的IQA模型

由于NSS信息在IQA领域的有效性,同样地,研究人员也提出将NSS信息引入SR IQA当中。Dong等人(2015)提出使用图像保真度和自然性来度量SR失真图像的质量。Yeganeh等人(2015)提出基于NSS信息的SR IQA模型(weighted interpolated natural image distortion,WIND),该模型使用3种统计特征,包括频率能量衰减统计、局部主导方向统计和空间连续性统计。

类似地,Ma等人(2017a)通过从SR图像的空间域和频率域中提取3种低水平的统计特征以回归图像感知分数。Chen等人(2018a)提出了一种针对非整数插值图像的RR和NR方式混合的质量指标。

受人类视觉感知系统的起源选择性机制(origination selectivity mechanism,OSM)和内部生成机制(internal generative mechanism,IGM)(Wu等人,2013a)的启发,Shi等人(2019a)提出一种用于测量SR图像视觉内容预测模型(visual content prediction model,VCPM)。Zhou等人(2021a)从结构保真度和自然统计两个维度进行SR图像的质量估计。Fang等人(2019a)提出一个RR-SR IQA算法(reduced-reference quality metric for image super-resolution,RRIQA-SR),该算法通过计算图像低频区域的能量改变和高频区域的纹理变化以捕获图像中的全局和局部失真。Tang等人(2019)提出基于信息增益和纹理相似性的RR-SR IQA方法。Zhang等人(2019b)通过学习一个两层回归模型来建立多个自然统计特征与视觉感知评分之间的映射关系。其中,AdaBoost决策树回归和山脊回归用于训练逐步求精的质量预测模型。Beron等人(2020)提出基于感知特征提取优化的NR-SR IQA模型。

最近,深度学习也逐步应用到SR IQA当中。Fang等人(2018c)提出一个基于卷积神经网络的SR IQA模型,该模型通过深度网络提取高级特征,通过图像分块,将局部信息有效结合到图像视觉质量预测当中。同样地,Bare等人(2018a)也将神经网络引入到SR IQA中,并在此基础上,进一步提出将FR-SR IQA指标作为损失函数,以指导SR图像重建网络模型的优化(Yan等,2019b)。Zhou等人(2020a)提出一个基于双流卷积神经网络的NR-SR IQA模型(deep neural network-based SR image quality assessor, DeepSRQ),该模型将失真的SR图像和相应的纹理结构图像分别作为网络的分支输入进行模型的训练和预测。Zhao等人(2020b)也提出了一个基于端到端的双分支卷积神经网络的SR IQA模型(deep image SR quality, DISQ),但与Zhou等人(2020a)不同的是,该模型使用低分辨率图像作为网络的一个分支输入。

3.2.3 针对MEF图像的IQA模型

由于人类视觉感知对MEF图像的对比度信息较为敏感,Xing等人(2017)通过对对比度结构相似性和对比度饱和相似性进行测量以估计MEF图像的感知质量(multi-scale contrast-based model,MCM)。Rahman等人(2017)提出通过在多个尺度和方向上计算融合图像和单个过/欠曝光图像之间的单个质量图,并利用相应质量图计算得到图像的质量分数(multi-exposure fusion image information,MEF-II)。Martinez等人(2019)提出了一个多尺度保真度模型(multi-scale structural similarity measure,MS-Qw),利用多尺度和结构相似性计算融合图像质量。针对不同场景下的MEF图像,Fang等人(2020b)提出了基于SSIM的客观MEF IQA指标(dynamic multi-exposure fusion structural similarity index,MEF-SSIMd)。另外,为了同时有效评估动态场景和静态场景下的MEF图像质量,Fang等人(2019d)提出了一种基于金字塔对比度保持和信息熵自适应池化策略的MEF IQA模型(static and dynamic multi-exposure fusion Laplacian pyramid,MEF-LAPsd)。在此基础上,Fang等人(2021b)进一步提出基于超像素和信息理论的MEF IQA(static and dynamic multi-exposure fusion superpixel Laplacian pyramid,MEF-Sup-LAPsd),该方法不仅在公开的静态和动态MEF图像数据库上具有较好性能,并且为MEF算法参数优化等应用提供基础。

3.2.4 针对TM图像的IQA模型

由于HDR图像和LDR图像的动态范围不同,因此,传统的IQA方法不能够直接应用于TM IQA中。Yeganeh和Wang(2013)提出了一个基于亮度信息的FR-TM IQA方法(tone-mapped image quality index,TMQI),通过结合多尺度结构保真度度量和自然统计度量对图像进行整体质量分数估计,但由于TMQI仅从图像的亮度出发,忽略了颜色信息的影响。Nafchi等人(2015)将颜色信息加入到TMI质量评价中,并提出基于局部相位相似性的FR-TM IQA指标(feature similarity index for tone-mapped images, FSITM)。为了结合更多的信息,Hadizadeh和Bajic(2018)提出了基于特征集合(bag of featuers, BOF)的FR-TM IQA算法。Krasula等人(2020)提出了一种特征选择策略以捕获感知相关的信息并进行相互补充融合(features fusion for tone-mapped images,FFTMI),从而计算图像的质量。另外,Kundu和Evans(2016)在TMQI的基础上,引入视觉注意力概念,提出借助于图像显著性加权计算TMI的方法。Nasrinpour和Bruce(2015)也提出了类似的方法(saliency weighted tone-mapped quality index,STMQI)。

由于原始图像难获得等因素,图像的大量相关信息,如颜色、亮度、纹理等,被逐一进行筛选和提取。一些RR-TM和NR-TM IQA方法也逐步提出。Yue等人(2019a)通过从颜色、曝光和自然性等方面提取特征,提出了一个RR-TM IQA模型,但该方法未能考虑到TM过程中可能产生的局部光晕和轮廓错误等情况。Gu等人(2016a)提出了一个基于信息量、自然统计和结构保真度的NR-TM IQA方法(blind tone-mapped quality index,BTMQI),类似于前述方法,该模型同样忽略了颜色信息。Kundu等人(2017)通过考虑空间域的自然场景统计特征和梯度信息,提出了一个基于梯度信息的NR-TM IQA方法(HDR image gradient based evaluator,HIGRADE)。Yue等人(2019b)从结构、颜色和自然性等角度对图像进行特征提取并进一步评估图像质量。Jiang等人(2019)提出了一个局部和全局特征分析的NR-TM IQA方法(blind quality evaluator to blindly predict the quality of tone-mapped images,BLIQUE-TMI),通过提取视觉信息、局部结构信息和自然统计信息相关特征,并使用极限学习机(extreme learning machine,ELM)学习预测图像质量。Fang等人(2021a)通过分析梯度和色彩统计信息,提出一个新的NR-TM IQA方法(gradient and chromatic statistics,VQGC)。随着深度学习技术的发展,基于深度学习技术的TM IQA方法也进一步提出。Ravuri等人(2019)提出基于卷积神经网络的NR-TM IQA模型(deep-based tone-mapped IQA,Deep-TMI),该模型利用卷积神经网络生成质量图,并使用AGGD进行特征参数提取,最终获得的特征进入到SVR中进行质量回归预测。

3.2.5 针对ER图像的IQA模型

针对DRI失真特性,Wu等人(2020b)先建立了一个去雨图像质量评价的主观数据库,然后提出一个基于双向控制融合的NR-DR IQA指标(bi-directional gated fusion network,B-GFN)。在该指标的基础上,Wu等人(2019b)进一步提出了一个集成全局感知和局部差异的双向特征嵌入网络模型(bi-directional feature embedding network,B-FEN),以预测不同DRI的视觉感知质量。

针对DHI失真特性,Hautiere等人(2008)提出了一种计算对比恢复前后图像可见边缘梯度比值的方法。Gibson和Nguyen(2013)提出一种基于感知对比度增强度量方法,用来解决图像自动增强中被雾降级的问题。Choi等人(2015)提出了一种基于自然场景统计和雾感知统计特征的NR感知雾密度预测模型(fog aware density evaluator,FADE)。并在此基础上,进一步提出一种基于FADE的NR感知图像去雾方法。Jiang等人(2017)提出了一种雾密度估计和图像去雾的方法,通过综合研究各种与雾相关的特征,如暗通道、饱和度和色度等,提出了一种基于色调、饱和度和颜色空间的感知特征,并使用基于替代的方法学习光学深度的细化多项式回归模型。Min等人(2019a)提出一个NR-DHIQA指标(image dehazing quality index,DHQI),该指标通过提取去雾特征、结构保持特征和增强特征3组特征以实现DH IQA。另外,Min等人(2019b)提出结合图像结构恢复特征、色彩还原特征和低对比度区域过增强等相关特征以实现DHI的FR质量评价的方法。为了度量DHI的可见修复程度和真实修复程度,Zhao等人(2020a)分别构建了两个计算标准,包括可见性指标(visibility index,VI)和真实性指标(realness index,RI)。

针对DBI失真特性,Marziliano等人(2003)分别提出一个RR或NR的图像模糊度量指标和一个针对振铃噪声度量的指标。这些指标通过对图像边缘和邻近区域进行分析以计算图像质量。Narvekar和Karam(2011)提出一种基于人眼对不同对比度模糊感知的NR图像模糊度量方法,该方法使用概率模型测量图像中边缘模糊的概率,并通过模糊检测概率累积(cumulative probability of blur detection,CPBD)将信息继承在一起。Ciancio等人(2011)构建了一个包含6 000幅合成模糊图像数据集,并提出了一种图像模糊评价的范式,通过将该范式与多种指标和低层次图像特征相结合以探索更加有效的模糊评价方法。Liu等人(2013)提出了一个感知验证的NR-DB IQA指标。Sang等人(2014)提出一个基于奇异值曲线(singular value curve,SVC)的NR-DB IQA算法。由于图像模糊造成的图像形状改变可以被离散矩所捕获,Li等人(2016e)提出一个基于Tchebichef矩的NR-DB IQA算法(blind image blur evaluation,BIBLE),该图像模糊计算分数使用视觉显著模型作为指引,并视做方差归一化的矩能量。通过从空间域和频率域提取去模糊图像的全局和局部失真,Li等人(2017)提出基于NSS信息的NR-DB IQA指标。Liu等人(2020)提出基于方位感知的局部模式操作算子的NR-DB IQA模型。该方位感知的局部模式算子充分考虑了方向选择机制的各向异性和梯度方位效应对视觉感知的影响。通过将深度学习引入到DB IQA领域,Li等人(2020d)提出了基于深度学习的多尺度NR-DB IQA模型(deep learning based multi-scale non-reference quality assessment network,DEBLUR-IQA),该模型可以进一步用于优化图像deblurring算法中。

针对DNI失真特性,Kong等人(2013)提出从图像噪声削减和结构保存两方面构建NR-DN IQA算法。Zeng和Wang(2013)提出了一种基于SSIM的结构保真度指数和NSS的统计失真度量相结合的DNI客观质量评价方法。Zhang等人(2019a)提出了一种IQA方法(corrupted reference image quality assessment,CRIQA),该方法使用损坏的图像作为理想的参考图像以评估图像的视觉质量。通过CRIQA可以对基于FRIQA的denoising算法进行参数优化以获得良好的denoising结果,并为IQA和图像denoising问题的联合推理奠定了基础。

针对GI失真特性,Ko等人(2020)提出针对GI的FR-IQA方法(structural and statistical quality predictor,SSQP),该方法基于结构相似特征和统计相似度测量,利用多级并行提升系统进行图像质量预测器的构建。Gu等人(2020b)提出了GI质量评价(generated image quality assessment,GIQA)的研究方向,并从学习为主和数据为主的两个角度分别构建两个GIQA算法。其中,以学习为主的评价算法(GIQA with multiple binary classifiers as regressor,MBC-GIQA)使用多种二值分类器的预测结果作为回归标签,而以数据为主的评价算法(GIQA with gaussian mixture model,GMM-IQA)则采用两种概率密度测量方法以实现GIQA。

针对EI/RI失真特性,Gu等人(2016b)提出了一种针对对比度变化的RR-IQA指标(reduced-reference image quality metric for contrast change,RIQMC),该算法通过图像相位一致性和直方图统计信息计算EI感知质量,并进一步应用于对比度自动增强算法中。由于现有对比度增强相关的图像数据缺乏,Gu等人(2018b)生成超过100 000幅EI作为大数据训练样本,EI对应标签使用FR-IQA指标计算获得,同时提出一个两阶段框架的NR-EN IQA模型(blind image quality measure of enhanced images,BIQME)。该模型通过对图像对比度,锐度和亮度等进行分析并提取相应特征,最终构建图像视觉质量度量的回归模型。

Liang和Weller(2016)提出基于比较的IQA框架(comparison-based IQA,CIQA),以用于图像修复算法的参数选择,该框架包含3个主要模块,即内容检测、贡献计算和失真敏感补偿。Hu等人(2019)提出了一种基于成对比较的排序学习框架,用于对图像恢复算法的性能进行基准测试,并在此基础上,进一步提出基于空间和频率域特征的通用图像恢复质量评价指标。为了更深入地研究图像修复质量评价相关内容,Hu等人(2020)对现有图像修复主观数据库、客观质量评价指标和图像修复质量指标应用进行了较为全面的总结和概括。

3.2.6 小结

不同于针对其他内容如SCIs和OIs等IQA模型的设计,即它们的设计主要是根据图像内容的特点,而算法相关失真IQA模型的设计主要根据失真的特点,如DIBR过程引入的黑洞区域和扭曲、GAN生成图像时引入的伪结构信息。针对算法相关失真的IQA相关研究逐渐得到了学术界和工业界的广泛关注,它的另一特点是将随着算法的迭代更新而调整,因为迭代更新后的算法所引入的失真与迭代更新前的算法所引入的失真特点可能存在差异。

4 IQA模型的应用

随着互联网的快速发展和计算机视觉技术的广泛应用,IQA模型的受重视程度也越来越凸显。除上一节所描述的用于评价不同算法生成图像的质量(Liu等,2021a),进而评价算法性能,IQA的另外3个重要应用是:图像筛选、算法参数选择和模型优化。

1)图像筛选。当前互联网每日产生的图像数据都是海量的,对低质量图像的筛选去除是一个十分必要的操作。一般而言,可以根据具体需求,设置不同的筛选规则或者筛选设置。

2)算法参数选择。当图像处理算法依赖于多个或多组关键参数时,自动选择最优参数是较好的选择。Fang等人(2017a)通过感知相似性方法(Fang等,2014)迭代优化,选择最优的重定向算子序列。Fang等人(2020b)尝试使用IQA模型选择多曝光图像融合算法最优参数。

3)模型优化。SSIM和MSSSIM(multi-scale structural similarity)广泛用于图像的生成任务,如图像增强和修复(Yang等,2021b)。另外,也有研究者针对某问题提供IQA引导的模型优化方案。Ma等人(2015b)提出一种TMO,通过交替迭代优化结构保真度和统计自然性,将HDR图像转化为LDR图像。类似地,Ma等人(2018a)使用一种MEF IQA模型优化多曝光图像融合算法。这两个模型优化算法均使用梯度下降法,一次完整的迭代过程针对同一幅图像,比较耗时。针对算法耗时问题,Ma等人(2020b)提出一种基于CNN的快速MEF算法,核心部分是一个语义聚合网络(Chen等,2017),通过MEF IQA模型作为目标函数优化网络。Ding等人(2021)详细比较了不同的IQA模型在图像增强的应用。

5 IQA模型的评价指标

根据评价指标的功能不同,分别介绍IQA模型预测结果与主观判断的相关性指标、IQA模型的区分性指标和IQA模型比较指标。

5.1 相关性指标

研究者使用的最常用的3个评价指标为:皮尔逊线性相关系数(Pearson linear correlation coefficient,PLCC)、斯皮尔曼等级相关系数(Spearman rank-order correlation coefficient,SRCC)和均方根误差(root mean square error,RMSE)(ITU,2000)。通过计算图像的模型预测分数与主观分数的各指标值以判别模型的优劣,其具体计算方式详见Fang等人(2021b)的论文。其中,PLCC用于评估IQA模型预测的准确性,SRCC用于衡量IQA模型预测结果的单调性,RMSE用于评估IQA模型预测的一致性。在计算PLCC前,需对客观分数和主观分数进行非线性回归操作。

5.2 区分性指标

2017年,Ma等人(2017b)提出了3种新的评价指标,分别为原始图/失真图可辨别性测试(D-test)、基于序列排序一致性测试(L-test)和配对偏好一致性测试(P-test)。其中,D-test将原始图和失真图视为两类,量化IQA模型区分参考图像和失真图像的能力。L-test的目的是评估IQA模型在对具有相同内容、相同失真类型但不同失真程度的图像进行评级时的鲁棒性。而P-test则比较了IQA模型在质量可分的图像对(quality-discriminable image pairs,DIPs)上的偏好预测。3种指标的计算方式详见Fang等人(2021b)论文。

5.3 模型比较指标

Wang和Simoncelli(2008)提出最大差异化竞争(maximum differentiation competition,MAD)模型比较方法,它需要的条件是对比模型均可导。MAD的工作过程为:假定参考图像为Ir和失真图像为Id,两个比较模型分别为f1和f2。优化过程中,固定其中一个模型(f1或f2),最大化/最小化另一个模型(f2或f1)。该过程将生成得到的两张结果图Id1和Id2,其中一个模型(f1或f2)认为两幅结果图质量一致,而另一个模型(f2或f1)认为质量差别较大。通过变换参考图像和失真类型,可得到多对结果图,与主观判断更为一致的模型认为性能更好。

Ma等人(2020a)将MAD思想扩展到一般的IQA模型比较,提出基于gMAD的模型比较方法,并成功应用在IQA、图像美感评价等模型比较上。gMAD引入“攻击者”和“防守者”概念,模型的攻击能力/防守能力越强,模型性能更好。gMAD的工作过程为:假定两个比较模型分别为f1和f2,将f1和f2分别设置为防守者和攻击者,在防守者f1预测结果接近的样本中,选择攻击者f2认为差异最大的样本对。调换f1和f2的角色,重复上述操作。与主观判断更为一致的模型认为性能更好。该思想也成功用于图像分类模型比较(Wang等,2020b)和语义分割模型比较(Yan等,2021)。

6 结 语

6.1 总结

近年来,IQA研究发展较为迅速,大规模图像质量数据库和大量先进的IQA算法相继提出。同时,IQA研究也逐渐引起其他相关领域研究者的关注,如SR、MEF、IDR和IDB等。研究者们构建算法相关图像质量数据库及相应的IQA算法。

1)从图像失真角度来看,大部分IQA研究涵盖的合成失真主要包含常见的几类,如JPEG压缩、高斯噪声、高斯模糊和运动模糊等。合成失真图像质量数据库从小规模、包含主观分数发展为大规模、无主观分数,可作为IQA模型的性能测试基准和IQA模型的训练数据等(Zhang等,2020a;Ma等,2017b,2019)。从公开数据库的数量来看,真实失真IQA研究相对较少,主要的两点原因是真实失真图像数据收集困难(合成失真图像数据可大量自动生成)和大规模主观实验耗时耗力(合成失真图像可生成伪标签)。算法相关失真逐渐受到研究者的关注,主要原因在于算法相关失真与合成失真分布差异较大,有明显的算法相关特性,如DIBR中引入的扭曲和GAN生成图像中的伪结构信息。直接使用现有的IQA算法无法获得与主观感知较为一致的结果。算法相关失真研究对于算法性能提升是十分必要的,也将随着算法的迭代更新而发展(Gu等,2020b)。算法相关失真的IQA研究存在的一个问题为:当新的算法提出时,已有的图像质量数据库可能无法较好地用来做基准,即已有的图像质量数据库中包含的图像质量问题可能在新的算法中并不会出现。

2)从图像内容角度来看,IQA的研究对象已经从单一的NIs变成形式多样的多媒体内容,如SCIs和OIs等。相应地,因图像内容的特殊性,图像质量数据库的构建过程也存在一些差异,如SIs和OIs等。针对NIs的IQA研究当前主要集中在真实失真和算法相关失真,针对其他多媒体内容数据的研究失真类型主要还是合成失真,针对新型媒体内容数据如OIs的研究是当前的热点。然而,依然存在规模相对较小的问题。

3)从IQA模型角度来看,IQA模型的设计都涵盖了传统特征工程和端到端深度学习。受限于手工特征的表达能力,基于深度学习的IQA模型已经成为研究者的研究重点。早期基于深度学习的IQA模型着重在模型的设计上,且仅在小规模图像质量数据库上测试。随着越来越多的大规模图像质量数据库的提出,对IQA模型性能要求从单个数据库上比较,变成多个数据库上比较和跨数据库比较,即对IQA模型可扩展能力的探索越来越多(Wang等,2021a,b)。

6.2 未来发展方向

1)就图像失真而言,虽然合成失真与真实失真和算法相关失真差别较大,即合成失真与真实应用中可能出现的失真情况存在天然的分布差异,得益于合成失真图像生成的简便,如何利用好大规模合成失真图像数据(Ma等,2018b,2019;Wu等,2020a;Wang等,2020a;Wang等,2020b)进一步地推进真实失真和算法相关失真问题研究,依然值得深入探索。当前,针对真实失真的研究及如何应用的工作相对较少,该类研究依然具有较大的挑战性。真实失真图像数据的来源主要是拍摄成像,而其他真实场景如工业、医学等的真实失真图像质量评价研究也值得关注。另外,算法相关失真逐渐引起研究者的注意,因为针对NIs设计的IQA模型无法准确地预测相关算法生成的图像,如SRIs。虽然在SR领域中PSNR和SSIM一直是两个常用的评价指标,这并不意味着这两个IQA模型在预测SR图像质量时是最准确的。因此,应用最新的算法相关失真的IQA模型去继续提升算法性能是值得考虑的。虽然针对算法相关失真的研究越来越多,但依然存在较大的研究空间,这将是一个需要持续推进的研究方向。

2)就IQA模型而言,针对合成失真和真实失真的IQA模型性能已趋于饱和。但是,依然有两个方向值得深入研究。第1个是鲁棒的IQA模型设计。虽然已经有研究者做出了比较有意思的工作,如Wang等人(2021a)和Zhang等人(2021b),鲁棒的IQA模型依然值得继续研究。第2个是针对算法相关失真的IQA模型设计。从总体而言,各类算法相关失真度量的研究层出不穷,但针对某种特定的算法相关失真研究依然处于上升阶段,值得进一步研究。同时,因为算法相关失真图像质量数据库涉及到的算法有限,针对现有算法相关失真图像质量数据库设计的IQA算法是否可以有效地评价其他相关算法生成的图像质量值得深入研究。

参考文献(References)

Adhikarla V K, Vinkler M, Sumin D, Mantiuk R K, Myszkowski K, Seidel H P and Didyk P.2017.Towards a quality metric for dense light fields//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu,USA: IEEE: 3720-3729[DOI: 10.1109/CVPR.2017.396]

Ancuti C O, Ancuti C, Timofte R and De Vleeschouwer C.2018b.I-HAZE: a dehazing benchmark with real hazy and haze-free indoor images[EB/OL].[2020-04-13].https://arxiv.org/pdf/1804.05091.pdf

Ancuti C O, Ancuti C, Timofte R and Vleeschouwer C D.2018a.O-HAZE: a dehazing benchmark with real hazy and haze-free outdoor images//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops.Salt Lake City, USA: IEEE: 867-8678[DOI: 10.1109/CVPRW.2018.00119]

Bare B, Li K, Yan B, Feng B L and Yao C F.2018a.A deep learning based no-reference image quality assessment model for single-image super-resolution//Proceedings of 2018 IEEE International Conference on Acoustics, Speech and Signal Processing.Calgary, Canada: IEEE: 1223-1227[DOI: 10.1109/ICASSP.2018.8461931]

Battisti F, Bosc E, Carli M, Le Callet P and Perugia S.2015.Objective image quality assessment of 3D synthesized views.Signal Processing: Image Communication, 30: 78-88[DOI: 10.1016/j.image.2014.10.005]

Benoit A, Le Callet P, Campisi P and Cousseau R.2008.Quality assessment of stereoscopic images.EURASIP Journal of Image and Video Processing, 2008: #659024[DOI: 10.1155/2008/659024]

Beron J, Benitez-Restrepo H D and Bovik A C.2020.Blind image quality assessment for super resolution via optimal feature selection.IEEE Access, 8: 143201-143218[DOI: 10.1109/ACCESS.2020.3014497]

Bevilacqua M, Roumy A, Guillemot C and Morel M L A.2012.Low-complexity single-image super-resolution based on nonnegative neighbor embedding//Proceedings of British Machine Vision Conference.Surrey, UK: BMVA Press: 135[DOI: 10.5244/C.26.135]

Bosc E, Pepion R, Le Callet P, Koppel M, Ndjiki-Nya P, Pressigout M and Morin L.2011.Towards a new quality metric for 3-D synthesized view assessment.IEEE Journal of Selected Topics in Signal Processing, 5(7): 1332-1343[DOI: 10.1109/JSTSP.2011.2166245]

Bosse S, Maniry D, Müller K R, Wiegand T and Samek W.2018b.Deep neural networks for no-reference and full-reference image quality assessment.IEEE Transactions on Image Processing, 27(1): 206-219[DOI: 10.1109/TIP.2017.2760518]

Chen B L, Li H L, Fan H F and Wang S Q.2021a.No-reference screen content image quality assessment with unsupervised domain adaptation.IEEE Transactions on Image Processing, 30: 5463-5476[DOI: 10.1109/TIP.2021.3084750]

Chen J L, Xu Y W, Ma K D, Huang H W and Zhao T S.2018a.A hybrid quality metric for non-integer image interpolation//Proceedings of 2018 Tenth International Conference on Quality of Multimedia Experience.Cagliari,Italy: IEEE: 1-3[DOI: 10.1109/QoMEX.2018.8463405]

Chen J N, Shen L Q, Zheng L R and Jiang X H.2018b.Naturalization module in neural networks for screen content image quality assessment.IEEE Signal Processing Letters, 25(11): 1685-1689[DOI: 10.1109/LSP.2018.2871250]

Chen M J, Cormack L K and Bovik A C.2013a.No-reference quality assessment of natural stereopairs.IEEE Transactions on Image Processing, 22(9): 3379-3391[DOI: 10.1109/TIP.2013.2267393]

Chen M J, Su C C, Kwon D K, Cormack L K and Bovik A C.2013b.Full-reference quality assessment of stereopairs accounting for rivalry.Signal Processing: Image Communication, 28(9): 1143-1155[DOI: 10.1016/j.image.2013.05.006]

Chen Q F, Xu J and Koltun V.2017.Fast image processing with fully-convolutional networks//Proceedings of 2017 IEEE International Conference on Computer Vision.Venice, Italy: IEEE: 2516-2525[DOI: 10.1109/ICCV.2017.273]

Chen Z B, Xu J H, Lin C Y and Zhou W.2020.Stereoscopic omnidirectional image quality assessment based on predictive coding theory.IEEE Journal of Selected Topics in Signal Processing, 14(1): 103-117[DOI: 10.1109/JSTSP.2020.2968182]

Chen Z Y, Jiang T T and Tian Y H.2014.Quality assessment for comparing image enhancement algorithms//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus, USA: IEEE: 3003-3010[DOI: 10.1109/CVPR.2014.384]

Choi L K, You J and Bovik A C.2015.Referenceless prediction of perceptual fog density and perceptual image defogging.IEEE Transactions on Image Processing, 24(11): 3888-3901[DOI: 10.1109/TIP.2015.2456502]

Chu Y, Luo G X and Chen F.2021.A real haze video database for haze level evaluation//Proceedings of the 13th International Conference on Quality of Multimedia Experience.Montreal, Canada: IEEE: 69-72[DOI: 10.1109/QoMEX51781.2021.9465461]

Ciancio A, Da Costa A L N T T, Da Silva E A B, Said A, Samadani R and Obrador P.2011.No-reference blur assessment of digital pictures based on multifeature classifiers.IEEE Transactions on Image Processing, 20(1): 64-75[DOI: 10.1109/TIP.2010.2053549]

Conze P H, Robert P and Morin L.2012.Objective view synthesis quality assessment//Proceedings of SPIE 8288, Stereoscopic Displays and Applications XXIII.Burlingame, USA: SPIE: 82881M[DOI: 10.1117/12.908762]

Cordts M, Omran M, Ramos S, Rehfeld T, Enzweiler M, Benenson R, Franke U, Roth S and Schiele B.2016.The Cityscapes dataset for semantic urban scene understanding//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, USA: IEEE: 3213-3223[DOI: 10.1109/CVPR.2016.350]

Dendi S V R, Dev C, Kothari N and Channappayya S S.2019.Generating image distortion maps using convolutional autoencoders with application to no reference image quality assessment.IEEE Signal Processing Letters, 26(1): 89-93[DOI: 10.1109/LSP.2018.2879518]

Ding K Y, Ma K D, Wang S Q and Simoncelli E P.2020.Image quality assessment: unifying structure and texture similarity.IEEE Transactions on Pattern Analysis and Machine Intelligence, 44(5): 2567-2581[DOI: 10.1109/TPAMI.2020.3045810]

Ding K Y, Ma K D, Wang S Q and Simoncelli E P.2021.Comparison of full-reference image quality models for optimization of image processing systems.International Journal of Computer Vision, 129(4): 1258-1281[DOI: 10.1007/s11263-020-01419-7]

Dong X, Zhu Y, Li W X, Xie L X, Wong A and Yuille A.2015.Fidelity-naturalness evaluation of single image super resolution[EB/OL].[2020-11-21].https://arxiv.org/pdf/1511.06834.pdf

Duan H Y, Zhai G T, Min X K, Zhu Y C, Fang Y and Yang X K.2018.Perceptual quality assessment of omnidirectional images//Proceedings of 2018 IEEE International Symposium on Circuits and Systems.Florence, Italy: IEEE: 1-5[DOI: 10.1109/ISCAS.2018.8351786]

Fang Y M, Du R G, Zuo Y F, Wen W Y and Li L D.2020a.Perceptual quality assessment for screen content images by spatial continuity.IEEE Transactions on Circuits and Systems for Video Technology, 30(11): 4050-4063[DOI: 10.1109/TCSVT.2019.2951747]

Fang Y M, Fang Z J, Yuan F N, Yang Y, Yang S Y and Xiong N N.2017a.Optimized multioperator image retargeting based on perceptual similarity measure.IEEE Transactions on Systems, Man, and Cybernetics: Systems, 47(11): 2956-2966[DOI: 10.1109/TSMC.2016.2557225]

Fang Y M, Liu J Y, Zhang Y B, Lin W S and Guo Z M.2019a.Reduced-reference quality assessment of image super-resolution by energy change and texture variation.Journal of Visual Communication and Image Representation, 60: 140-148[DOI: 10.1016/j.jvcir.2018.12.035]

Fang Y M, Ma K D, Wang Z, Lin W S, Fang Z J and Zhai G T.2015.No-reference quality assessment of contrast-distorted images based on natural scene statistics.IEEE Signal Processing Letters, 22(7): 838-842[DOI: 10.1109/LSP.2014.2372333]

Fang Y M, Sui X J, Yan J B, Liu X L and Huang L P.2021.Progress in no-reference image quality assessment.Journal of Image and Graphics, 26(2): 265-286(方玉明, 眭相杰, 鄢杰斌, 刘学林, 黄丽萍.2021.无参考图像质量评价研究进展.中国图象图形学报, 26(2): 265-286)[DOI: 10.11834/jig.200274]

Fang Y M, Wei K K, Hou J H, Wen W Y and Imamoglu N.2018a.Light filed image quality assessment by local and global features of epipolar plane image//Proceedings of the 4th IEEE International Conference on Multimedia Big Data.Xi′an, China: IEEE: 1-6[DOI: 10.1109/BigMM.2018.8499086]

Fang Y M, Yan J B, Du R G, Zuo Y F, Wen W Y, Zeng Y and Li L D.2021a.Blind quality assessment for tone-mapped images by analysis of gradient and chromatic statistics.IEEE Transactions on Multimedia, 23: 955-966[DOI: 10.1109/TMM.2020.2991528]

Fang Y M, Yan J B, Li L D, Wu J J and Lin W S.2018b.No reference quality assessment for screen content images with both local and global feature representation.IEEE Transactions on Image Processing, 27(4): 1600-1610[DOI: 10.1109/TIP.2017.2781307]

Fang Y M, Yan J B, Liu X L and Wang J H.2019b.Stereoscopic image quality assessment by deep convolutional neural network.Journal of Visual Communication and Image Representation, 58: 400-406[DOI: 10.1016/j.jvcir.2018.12.006]

Fang Y M, Yan J B, Liu J Y, Wang S Q, Li Q H and Guo Z M.2017c.Objective quality assessment of screen content images by uncertainty weighting.IEEE Transactions on Image Processing, 26(4): 2016-2027[DOI: 10.1109/TIP.2017.2669840]

Fang Y M, Yan J B, Wang J H, Liu X L, Zhai G T and Le Callet P.2019c.Learning a no-reference quality predictor of stereoscopic images by visual binocular properties.IEEE Access, 7: 132649-132661[DOI: 10.1109/ACCESS.2019.2941112]

Fang Y M, Zeng Y, Jiang W H, Zhu H W and Yan J B.2021b.Superpixel-based quality assessment of multi-exposure image fusion for both static and dynamic scenes.IEEE Transactions on Image Processing, 30: 2526-2537[DOI: 10.1109/TIP.2021.3053465]

Fang Y M, Zeng K, Wang Z, Lin W S, Fang Z J and Lin C W.2014.Objective quality assessment for image retargeting based on structural similarity.IEEE Journal on Emerging and Selected Topics in Circuits and Systems, 4(1): 95-105[DOI: 10.1109/JETCAS.2014.2298919]

Fang Y M, Zeng Y, Zhu H W and Zhai G T.2019 d.Image quality assessment of multi-exposure image fusion for both static and dynamic scenes//Proceedings of 2019 IEEE International Conference on Multimedia and Expo.Shanghai, China: IEEE: 442-447[DOI: 10.1109/ICME.2019.00083]

Fang Y M, Zhang C, Yang W H, Liu J Y and Guo Z M.2018c.Blind visual quality assessment for image super-resolution by convolutional neural network.Multimedia Tools and Applications, 77(22): 29829-29846[DOI: 10.1007/s11042-018-5805-z]

Fang Y M, Zhu H W, Ma K D and Wang Z.2017b.Perceptual quality assessment of HDR deghosting algorithms//Proceedings of 2017 IEEE International Conference on Image Processing.Beijing, China: IEEE: 3165-3169[DOI: 10.1109/ICIP.2017.8296866]

Fang Y M, Zhu H W, Ma K D, Wang Z and Li S T.2020b.Perceptual evaluation for multi-exposure image fusion of dynamic scenes.IEEE Transactions on Image Processing, 29: 1127-1138[DOI: 10.1109/TIP.2019.2940678]

Fang Y M, Zhu H W, Zeng Y, Ma K D and Wang Z.2020c.Perceptual quality assessment of smartphone photography//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle, USA: IEEE: 3674-3683[DOI: 10.1109/CVPR42600.2020.00373]

Fu Y, Zeng H Q, Ma L, Ni Z K, Zhu J Q and Ma K K.2018.Screen content image quality assessment using multi-scale difference of Gaussian.IEEE Transactions on Circuits and Systems for Video Technology, 28(9): 2428-2432[DOI: 10.1109/TCSVT.2018.2854176]

Gao F and Gao X B.2014.Active feature learning and its application in blind image quality assessment.Chinese Journal of Computers, 37(10): 2227-2234(高飞, 高新波.2014.主动特征学习及其在盲图像质量评价中的应用.计算机学报, 37(10): 2227-2234)[DOI: 10.3724/SP.J.1016.2014.02227]

Ghadiyaram D and Bovik A C.2016.Massive online crowdsourced study of subjective and objective picture quality.IEEE Transactions on Image Processing, 25(1): 372-387[DOI: 10.1109/TIP.2015.2500021]

Ghadiyaram D and Bovik A C.2017.Perceptual quality prediction on authentically distorted images using a bag of features approach.Journal of Vision, 17(1): 32[DOI: 10.1167/17.1.32]

Gibson K B and Nguyen T Q.2013.A no-reference perceptual based contrast enhancement metric for ocean scenes in fog.IEEE Transactions on Image Processing, 22(10): 3982-3993[DOI: 10.1109/TIP.2013.2265884]

Gu J J, Cai H M, Chen H Y, Ye X X, Jimmy S R and Dong C.2020a.PIPAL: a large-scale image quality assessment dataset for perceptual image restoration//Proceedings of the 16th European Conference on Computer Vision.Glasgow, UK: Springer: 633-651[DOI: 10.1007/978-3-030-58621-8]

Gu K.2015.Research on Perceptual and Statistical Image Quality Assessment and its Application.Shanghai: Shanghai Jiao Tong University(顾锞.2015.基于感知和统计模型的图像质量评价技术及应用研究.上海: 上海交通大学)

Gu K, Qiao J F, Min X K, Yue G H, Lin W S and Thalmann D.2018a.Evaluating quality of screen content images via structural variation analysis.IEEE Transactions on Visualization and Computer Graphics, 24(10): 2689-2701[DOI: 10.1109/TVCG.2017.2771284]

Gu K, Tao D C, Qiao J F and Lin W S.2018b.Learning a no-reference quality assessment model of enhanced images with big data.IEEE Transactions on Neural Networks and Learning Systems, 29(4): 1301-1313[DOI: 10.1109/TNNLS.2017.2649101]

Gu K, Wang S Q, Yang H, Lin W S, Zhai G T, Yang X K and Zhang W J.2016c.Saliency-guided quality assessment of screen content images.IEEE Transactions on Multimedia, 18(6): 1098-1110[DOI: 10.1109/TMM.2016.2547343]

Gu K, Wang S Q, Zhai G T, Ma S W, Yang X K, Lin W S, Zhang W J and Gao W.2016a.Blind quality assessment of tone-mapped images via analysis of information, naturalness, and structure.IEEE Transactions on Multimedia, 18(3): 432-443[DOI: 10.1109/TMM.2016.2518868]

Gu K, Zhai G T, Lin W S and Liu M.2016b.The analysis of image contrast: from quality assessment to automatic enhancement.IEEE Transactions on Cybernetics, 46(1): 284-297[DOI: 10.1109/TCYB.2015.2401732]

Gu K, Zhai G T, Yang X K and Zhang W J.2014.Hybrid no-reference quality metric for singly and multiply distorted images.IEEE Transactions on Broadcasting, 60(3): 555-567[DOI: 10.1109/TBC.2014.2344471]

Gu K, Zhai G T, Yang X K and Zhang W J.2015.Using free energy principle for blind image quality assessment.IEEE Transactions on Multimedia, 17(1): 50-63[DOI: 10.1109/TMM.2014.2373812]

Gu K, Zhou J, Qiao J F, Zhai G T, Lin W S and Bovik A C.2017.No-reference quality assessment of screen content pictures.IEEE Transactions on Image Processing, 26(8): 4005-4018[DOI: 10.1109/TIP.2017.2711279]

Gu S Y, Bao J M, Chen D and Wen F.2020b.GIQA: generated image quality assessment//Proceedings of the 16th European Conference on Computer Vision.Glasgow, UK: Springer: 369-385[DOI: 10.1007/978-3-030-58621-8_22]

Guan J W, Yi S, Zeng X Y, Cham W K and Wang X G.2017.Visual importance and distortion guided deep image quality assessment framework.IEEE Transactions on Multimedia, 19(11): 2505-2520[DOI: 10.1109/TMM.2017.2703148]

Hadizadeh H and Bajic I V.2018.Full-reference objective quality assessment of tone-mapped images.IEEE Transactions on Multimedia, 20(2): 392-404[DOI: 10.1109/TMM.2017.2740023]

Hassen R, Wang Z and Salama M M A.2015.Objective quality assessment for multiexposure multifocus image fusion.IEEE Transactions on Image Processing, 24(9): 2712-2724[DOI: 10.1109/TIP.2015.2428051]

Hautiere N, Tarel J, Aubert D and Dumont E.2008.Blind contrast enhancement assessment by gradient ratioing at visible edges.Image Analysis and Stereology, 27(2): 87-95[DOI: 10.5566/ias.v27.p87-95]

Hosu V, Lin H H, Sziranyi T and Saupe D.2020.KonIQ-10k: an ecologically valid database for deep learning of blind image quality assessment.IEEE Transactions on Image Processing, 29: 4041-4056[DOI: 10.1109/TIP.2020.2967829]

Hu B, Li L D, Liu H, Lin W and Q J.2019.Pairwise-comparison-based rank learning for benchmarking image restoration algorithms.IEEE Transactions on Multimedia, 21(8): 2042-2056[DOI: 10.1109/TMM.2019.2894958]

Hu B, Li L D, Qian J S and Fang Y M.2016.Perceptual evaluation of compressive sensing image recovery//Proceedings of 2016 Eighth International Conference on Quality of Multimedia Experience.Lisbon, Portugal: IEEE: 1-6[DOI: 10.1109/QoMEX.2016.7498963]

Hu B, Li L D, Wu J J and Qian J S.2020.Subjective and objective quality assessment for image restoration: a critical survey.Signal Processing: Image Communication, 85: #115839[DOI: 10.1016/j.image.2020.115839]

Huang J B, Singh A and Ahuja N.2015.Single image super-resolution from transformed self-exemplars//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston, USA: IEEE: 5197-5206[DOI: 10.1109/CVPR.2015.7299156]

Huang M K, Shen Q, Ma Z, Bovik A C, Gupta P, Zhou R B and Cao X.2018.Modeling the perceptual quality of immersive images rendered on head mounted displays: resolution and compression.IEEE Transactions on Image Processing, 27(12): 6039-6050[DOI: 10.1109/TIP.2018.2865089]

ITU.2000.Final report from the video quality experts group on the validation of objective models of video quality assessment[EB/OL].[2020-07-08].http://videoclarity.com/PDF/COM-80E_final_report.pdf

Jakhetiya V, Gu K, Singhal T, Guntuku S C, Xia Z F and Lin W S.2019.A highly efficient blind image quality assessment metric of 3-D synthesized images using outlier detection.IEEE Transactions on Industrial Informatics, 15(7): 4120-4128[DOI: 10.1109/TII.2018.2888861]

Jia H Z, Sun Q S and Wang T H.2014.Blind image quality assessment based on perceptual features and natural scene statistics.Journal of Image and Graphics, 19(6): 859-867(贾惠珍, 孙权森, 王同罕.2014.结合感知特征和自然场景统计的无参考图像质量评价.中国图象图形学报, 19(6): 859-867)[DOI: 10.11834/jig.20140606]

Jiang H, Jiang G Y, Yu M, Zhang Y, Yang Y, Peng Z J, Chen F and Zhang Q B.2021.Cubemap-based perception-driven blind quality assessment for 360-degree images.IEEE Transactions on Image Processing, 30: 2364-2377[DOI: 10.1109/TIP.2021.3052073]

Jiang Q P, Peng Z Y, Yang S and Shao F.2019.Authentically distorted image quality assessment by learning from empirical score distributions.IEEE Signal Processing Letters, 26(12): 1867-1871[DOI: 10.1109/LSP.2019.2951533]

Jiang Q P, Shao F and Jiang G Y.2017.MSFE: blind image quality assessment based on multi-stage feature encoding//Proceedings of 2017 IEEE International Conference on Image Processing.Beijing, China: IEEE: 3160-3164[DOI: 10.1109/ICIP.2017.8296865]

Kang L, Ye P, Li Y and Doermann D.2014.Convolutional neural networks for no-reference image quality assessment//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus, USA: IEEE: 1733-1740[DOI: 10.1109/CVPR.2014.224]

Kang L, Ye P, Li Y and Doermann D.2015.Simultaneous estimation of image quality and distortion via multi-task convolutional neural networks//Proceedings of 2015 IEEE International Conference on Image Processing.Quebec City, Canada: IEEE: 2791-2795[DOI: 10.1109/ICIP.2015.7351311]

Karras T, Laine S and Aila T.2019.A style-based generator architecture for generative adversarial networks//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 4396-4405[DOI: 10.1109/CVPR.2019.00453]

Kim H G, Jeong H, Lim H T and Ro Y M.2019a.Binocular fusion net: deep learning visual comfort assessment for stereoscopic 3D.IEEE Transactions on Circuits and Systems for Video Technology, 29(4): 956-967[DOI: 10.1109/TCSVT.2018.2817250]

Kim H G, Lim H T and Ro Y M.2020.Deep virtual reality image quality assessment with human perception guider for omnidirectional image.IEEE Transactions on Circuits and Systems for Video Technology, 30(4): 917-928[DOI: 10.1109/TCSVT.2019.2898732]

Kim J, Nguyen A D and Lee S.2019b.Deep CNN-based blind image quality predictor.IEEE Transactions on Neural Networks and Learning Systems, 30(1): 11-24[DOI: 10.1109/TNNLS.2018.2829819]

Kim J, Zeng H, Ghadiyaram D, Lee S, Zhang L and Bovik A C.2017.Deep convolutional neural models for picture-quality prediction: challenges and solutions to data-driven image quality assessment.IEEE Signal Processing Magazine, 34(6): 130-141[DOI: 10.1109/MSP.2017.2736018]

Ko H, Lee D Y, Cho S and Bovik A C.2020.Quality prediction on deep generative images.IEEE Transactions on Image Processing, 29: 5964-5979[DOI: 10.1109/TIP.2020.2987180]

Köhler T, Bätz M, Naderi F, Kaup A, Maier A and Riess C.2020.Toward bridging the simulated-to-real gap: benchmarking super-resolution on real data.IEEE Transactions on Pattern Analysis and machine intelligence, 42(11): 2944-2959[DOI: 10.1109/TPAMI.2019.2917037]

Kong X, Li K, Yang Q, Liu W and Yang M.2013.A new image quality metric for image auto-denoising//Proceedings of 2013 IEEE International Conference on Computer Vision.Sydney, Australia: IEEE: 1550-5499[DOI: 10.1109/ICCV.2013.359]

Korhonen J, Su Y C and You J Y.2021.Consumer image quality prediction using recurrent neural networks for spatial pooling[EB/OL].[2021-01-02].https://arxiv.org/pdf/2106.00918.pdf

Krasula L, Fliegel K and Callet P L.2020.FFTMI: Features fusion for natural tone-mapped images quality evaluation.IEEE Transactions on Multimedia, 22(8): 2038-2047[DOI: 10.1109/TMM.2019.2952256]

Kundu D and Evans B L.2016.Visual attention guided quality assessment of tone-mapped images using scene statistics//Proceedings of 2016 IEEE International Conference on Image Processing.Phoenix, USA: IEEE: 2381-8549[DOI: 10.1109/ICIP.2016.7532326]

Kundu D, Ghadiyaram D, Bovik A C and Evans B L.2017.Large-scale crowdsourced study for tone-mapped HDR pictures.IEEE Transactions on Image Processing, 26(10): 4725-4740[DOI: 10.1109/TIP.2017.2713945]

Lai W S, Huang J B, Hu Z, Ahuja N and Yang M H.2016.A comparative study for single image blind deblurring//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, USA: IEEE: 1701-1709[DOI: 10.1109/CVPR.2016.188]

Larson E C and Chandler D M.2009.Categorical subjective image quality CSIQ database[DB/OL].[2020-07-08].http://vision.okstate.edu/csiq/

Larson E C and Chandler D M.2010.Most apparent distortion: full-reference image quality assessment and the role of strategy.Journal of Electronic Imaging, 19(1): #011006[DOI: 10.1117/1.3267105]

Le Callet P and Autrusseau F.2005.Subjective quality assessment IRCCyN/IVC database[DB/OL].[2020-07-08].http://www2.irccyn.ec-nantes.fr/ivcdb/

Li A, Li J, Lin Q, Ma C and Yan B.2020 d.Deep image quality assessment driven single image deblurring//Proceedings of 2020 IEEE International Conference on Multimedia and Expo.London, UK: IEEE: 1945-7871[DOI: 10.1109/ICME46284.2020.9102899]

Li B Y, Ren W Q, Fu D P, Tao D C, Feng D, Zeng W J and Wang Z Y.2019b.Benchmarking single-image dehazing and beyond.IEEE Transactions on Image Processing, 28(1): 492-505[DOI: 10.1109/TIP.2018.2867951]

Li D Q, Jiang T T and Jiang M.2020a.Norm-in-norm loss with faster convergence and better performance for image quality assessment//Proceedings of the 28th ACM International Conference on Multimedia.Seattle, USA: ACM: 789-797[DOI: 10.1145/3394171.3413804]

Li D Q, Jiang T T, Lin W S and Jiang M.2019a.Which has better visual quality: the clear blue sky or a blurry animal? IEEE Transactions on Multimedia, 21(5): 1221-1234[DOI: 10.1109/TMM.2018.2875354]

Li F, Zhang Y F and Cosman P C.2021.MMMNet: an end-to-end multi-task deep convolution neural network with multi-scale and multi-hierarchy fusion for blind image quality assessment.IEEE Transactions on Circuits and Systems for Video Technology, 31(12): 4798-4811[DOI: 10.1109/TCSVT.2021.3055197]

Li J, Zhao Y F, Ye W H, Yu K W and Ge S M.2020b.Attentive deep stitching and quality assessment for 360oOmnidirectional images.IEEE Journal of Selected Topics in Signal Processing, 14(1): 209-221[DOI: 10.1109/JSTSP.2019.2953950]

Li L, Yan Y, Lu Z, Wu J, Gu K and Wang S.2017.No-reference quality assessment of deblurred images based on natural scene statistics.IEEE Access,(5): 2163-2171[DOI: 10.1109/ACCESS.2017.2661858]

Li L D, Lin W S, Wang X S, Yang G B, Bahrami K and Kot A C.2016e.No-reference image blur assessment based on discrete orthogonal moments.IEEE Transactions on Cybernetics, 46(1): 39-50[DOI: 10.1109/TCYB.2015.2392129]

Li L D, Yan Y, Fang Y M, Wang S Q, Tang L and Qian J S.2016a.Perceptual quality evaluation for image defocus deblurring.Signal Processing: Image Communication, 48: 81-91[DOI: 10.1016/j.image.2016.09.005]

Li L D, Zhou Y, Gu K, Yang Y Z and Fang Y M.2020c.Blind realistic blur assessment based on discrepancy learning.IEEE Transactions on Circuits and Systems for Video Technology, 30(11): 3859-3869[DOI: 10.1109/TCSVT.2019.2947450]

Li L D, Zhou Y, Lin W S, Wu J J, Zhang X F and Chen B J.2016b.No-reference quality assessment of deblocked images.Neurocomputing, 177: 572-584[DOI: 10.1016/j.neucom.2015.11.063]

Li Q H, Lin W S and Fang Y M.2016c.No-reference quality assessment for multiply-distorted images in gradient domain.IEEE Signal Processing Letters, 23(4): 541-545[DOI: 10.1109/LSP.2016.2537321]

Li Q H, Lin W S, Xu J T and Fang Y M.2016d.Blind image quality assessment using statistical structural and luminance features.IEEE Transactions on Multimedia, 18(12): 2457-2469[DOI: 10.1109/TMM.2016.2601028]

Li S Y, Araujo I B, Ren W Q, Wang Z Y, Tokuda E K, Junior R H, Cesar-Junior R, Zhang J W, Guo X J and Cao X C.2019c.Single image deraining: a comprehensive benchmark analysis//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 3833-3842[DOI: 10.1109/CVPR.2019.00396]

Liang H and Weller D S.2016.Comparison-based image quality assessment for selecting image restoration parameters.IEEE Transactions on Image Processing, 25(11): 5118-5130[DOI: 10.1109/TIP.2016.2601783]

Lin H H, Hosu V and Saupe D.2019.KADID-10k: a large-scale artificially distorted IQA database//Proceedings of 2019 Eleventh International Conference on Quality of Multimedia Experience.Berlin, Germany: IEEE: 1-3[DOI: 10.1109/QoMEX.2019.8743252]

Lin H H, Hosu V and Saupe D.2020.DeepFL-IQA: weak supervision for deep IQA feature learning[EB/OL].[2020-01-20].https://arxiv.org/pdf/2001.08113.pdf

Lin K Y and Wang G X.2018.Hallucinated-IQA: no-reference image quality assessment via adversarial learning//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 732-741[DOI: 10.1109/CVPR.2018.00083]

Lin W S and Jay Kuo C C.2011.Perceptual visual quality metrics: a survey.Journal of Visual Communication and Image Representation, 22(4): 297-312[DOI: 10.1016/j.jvcir.2011.01.005]

Liu A M, Lin W S and Narwaria M.2012.Image quality assessment based on gradient similarity.IEEE Transactions on Image Processing, 21(4): 1500-1512[DOI: 10.1109/TIP.2011.2175935]

Liu J Y, Xu D J, Yang W H, Fan M H and Huang H F.2021a.Benchmarking low-light image enhancement and beyond.International Journal of Computer Vision, 129(4): 1153-1184[DOI: 10.1007/s11263-020-01418-8]

Liu J Z, Zhou W, Xu J H, Li X, An S K and Chen Z B.2021b.LIQA: lifelong blind image quality assessment[EB/OL].[2021-04-29].https://arxiv.org/pdf/2104.14115.pdf

Liu T J and Liu K H.2018a.No-reference image quality assessment by wide-perceptual-domain scorer ensemble method.IEEE Transactions on Image Processing, 27(3): 1138-1151[DOI: 10.1109/TIP.2017.2771422]

Liu W, Zhou F, Lu T, Duan J and Qiu G P.2021c.Image defogging quality assessment: real-world database and method.IEEE Transactions on Image Processing, 30: 176-190[DOI: 10.1109/TIP.2020.3033402]

Liu Y M, Wang J, Cho S, Finkelstein A and Rusinkiewicz S.2013.A no-reference metric for evaluating the quality of motion deblurring.ACM Transactions on Graphics, 32(6): #175[DOI: 10.1145/2508363.2508391]

Liu Y T, Gu K, Zhang Y B, Li X, Zhai G T, Zhao D B and Gao W.2020.Unsupervised blind image quality evaluation via statistical measurements of structure, naturalness, and perception.IEEE Transactions on Circuits and Systems for Video Technology, 30(4): 929-943[DOI: 10.1109/TCSVT.2019.2900472]

Liu Y T, Zhai G T, Gu K, Liu X M, Zhao D B and Gao W.2018b.Reduced-reference image quality assessment in free-energy principle and sparse representation.IEEE Transactions on Multimedia, 20(2): 379-391[DOI: 10.1109/TMM.2017.2729020]

Lukeš T, Fliegel K and Klíma M.2013.Performance evaluation of image quality metrics with respect to their use for super-resolution enhancement//Proceedings of the 5th International Workshop on Quality of Multimedia Experience.Klagenfurt, Austria: IEEE: 42-43[DOI: 10.1109/QoMEX.2013.6603205]

Lv Y Q, Yu M, Jiang G Y, Shao F, Peng Z J and Chen F.2016.No-reference stereoscopic image quality assessment using binocular self-similarity and deep neural network.Signal Processing: Image Communication, 47: 346-357[DOI: 10.1016/j.image.2016.07.003]

Ma C, Yang C Y, Yang X K and Yang M H.2017a.Learning a no-reference quality metric for single-image super-resolution.Computer Vision and Image Understanding, 158: 1-16[DOI: 10.1016/j.cviu.2016.12.009]

Ma K D, Duanmu Z F, Wang Z, Wu Q B, Liu W T, Yong H W, Li H L and Zhang L.2020a.Group maximum differentiation competition: model comparison with few samples.IEEE Transactions on Pattern Analysis and Machine Intelligence, 42(4): 851-864[DOI: 10.1109/TPAMI.2018.2889948]

Ma K D, Duanmu Z F, Wu Q B, Wang Z, Yong H W, Li H L and Zhang L.2017b.Waterloo exploration database: new challenges for image quality assessment models.IEEE Transactions on Image Processing, 26(2): 1004-1016[DOI: 10.1109/TIP.2016.2631888]

Ma K D, Liu W T, Liu T L, Wang Z and Tao D C.2017c.dipIQ: blind image quality assessment by learning-to-rank discriminable image pairs.IEEE Transactions on Image Processing, 26(8): 3951-3964[DOI: 10.1109/TIP.2017.2708503]

Ma K D, Duanmu Z F, Yeganeh H and Wang Z.2018a.Multi-exposure image fusion by optimizing a structural similarity index.IEEE Transactions on Computational Imaging, 4(1): 60-72[DOI: 10.1109/TIP.2017.2786138]

Ma K D, Duanmu Z F, Zhu H W, Fang Y M and Wang Z.2020b.Deep guided learning for fast multi-exposure image fusion.IEEE Transactions on Image Processing, 29: 2808-2819[DOI: 10.1109/TIP.2019.2952716]

Ma K D, Liu W T and Wang Z.2015a.Perceptual evaluation of single image dehazing algorithms//Proceedings of 2015 IEEE International Conference on Image Processing.Quebec City, Canada: IEEE: 3600-3604[DOI: 10.1109/ICIP.2015.7351475]

Ma K D, Liu W T, Zhang K, Duanmu Z F, Wang Z and Zuo W M.2018b.End-to-end blind image quality assessment using deep neural networks.IEEE Transactions on Image Processing, 27(3): 1202-1213[DOI: 10.1109/TIP.2017.2774045]

Ma K D, Liu X L, Fang Y M and Simoncelli E P.2019.Blind image quality assessment by learning from multiple annotators//Proceedings of 2019 IEEE International Conference on Image Processing.Taipei, China: IEEE: 2344-2348[DOI: 10.1109/ICIP.2019.8803390]

Ma K D, Yeganeh H, Zeng K and Wang Z.2015b.High dynamic range image compression by optimizing tone mapped image quality index.IEEE Transactions on Image Processing, 24(10): 3086-3097[DOI: 10.1109/TIP.2015.2436340]

Ma K D, Zeng K and Wang Z.2015c.Perceptual quality assessment for multi-exposure image fusion.IEEE Transactions on Image Processing, 24(11): 3345-3356[DOI: 10.1109/TIP.2015.2442920]

Martin D, Fowlkes C, Tal D and Malik J.2001.A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics//Proceedings of the 8th IEEE International Conference on Computer Vision.Vancouver, Canada: IEEE: 416-423[DOI: 10.1109/ICCV.2001.937655]

Martinez J, Pistonesi S, Maciel M C and Flesia A G.2019.Multi-scale fidelity measure for image fusion quality assessment.Information Fusion, 50: 197-211[DOI: 10.1016/j.inffus.2019.01.003]

Marziliano P, Dufaux F, Winkler S and Ebrahimi T.2003.Perceptual blur and ring metrics: application to JPEG2000.Single Processing: Image Communication, 19(2): 163-172[DOI: 10.1016/j.image.2003.08.003]

Meng C L, An P, Huang X P, Yang C and Liu D Y.2020.Full reference light field image quality evaluation based on angular-spatial characteristic.IEEE Signal Processing Letters, 27: 525-529[DOI: 10.1109/LSP.2020.2982060]

Min X K, Zhai G T, Gu K, Yang X K and Guan X P.2019a.Objective quality evaluation of dehazed images.IEEE Transactions on Intelligent Transportation Systems, 20(8): 2879-2892[DOI: 10.1109/TITS.2018.2868771]

Min X K, Zhai G T, Gu K, Zhu Y C, Zhou J T, Guo G D, Yang X K, Guan X P and Zhang W J.2019b.Quality evaluation of image dehazing methods using synthetic hazy images.IEEE Transactions on Multimedia, 21(9): 2319-2333[DOI: 10.1109/TMM.2019.2902097]

Min X K, Zhou J T, Zhai G T, Le Callet P, Yang X K and Guan X P.2020.A metric for light field reconstruction, compression, and display quality evaluation.IEEE Transactions on Image Processing, 29: 3790-3804[DOI: 10.1109/TIP.2020.2966081]

Mittal A, Moorthy A K and Bovik A C.2012.No-reference image quality assessment in the spatial domain.IEEE Transactions on Image Processing, 21(12): 4695-4708[DOI: 10.1109/TIP.2012.2214050]

Mittal A, Soundararajan R and Bovik A C.2013.Making a “completely blind” image quality analyzer.IEEE Signal Processing Letters, 20(3): 209-212[DOI: 10.1109/LSP.2012.2227726]

Moorthy A K, Su C C, Mittal A and Bovik A C.2013.Subjective evaluation of stereoscopic image quality.Signal Processing: Image Communication, 28(8): 870-883[DOI: 10.1016/j.image.2012.08.004]

Nafchi H Z, Shahkolaei A, Moghaddam R F and Cheriet M.2015.FSITM: a feature similarity index for tone-mapped images.IEEE Signal Processing Letters, 22(8): 1026-1029[DOI: 10.1109/LSP.2014.2381458]

Nah S, Kim T H and Lee K M.2017.Deep multi-scale convolutional neural network for dynamic scene deblurring//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu, USA: IEEE: 257-265[DOI: 10.1109/CVPR.2017.35]

Narvekar N D and Karam L J.2011.A no-reference image blur metric based on the cumulative probability of blur detection(CPBD).IEEE Transactions on Image Processing.20(9): 2678-2683[DOI: 10.1109/TIP.2011.2131660]

Nasrinpour H R and Bruce N D B.2015.Saliency weighted quality assessment of tone-mapped images//Proceedings of 2016 IEEE International Conference on Image Processing.Quebec City, Canada: IEEE: 4799-8339[DOI: 10.1109/ICIP.2015.7351748]

Ni Z K, Ma L, Zeng H Q, Cai C H and Ma K K.2016.Gradient direction for screen content image quality assessment.IEEE Signal Processing Letters, 23(10): 1394-1398[DOI: 10.1109/LSP.2016.2599294]

Ni Z K, Ma L, Zeng H Q, Chen J, Cai C H and Ma K K.2017.ESIM: edge similarity for screen content image quality assessment.IEEE Transactions on Image Processing, 26(10): 4818-4831[DOI: 10.1109/TIP.2017.2718185]

Ni Z K, Zeng H Q, Ma L, Hou J H, Chen J and Ma K K.2018.A Gabor feature-based quality assessment model for the screen content images.IEEE Transactions on Image Processing, 27(9): 4516-4528[DOI: 10.1109/TIP.2018.2839890]

Oh H, Ahn S, Kim J and Lee S.2017.Blind deep S3D image quality evaluation via local to global feature aggregation.IEEE Transactions on Image Processing, 26(10): 4923-4936[DOI: 10.1109/TIP.2017.2725584]

Ou F Z, Wang Y G, Li Jin, Zhu G P and Kwong S.2019.Controllable list-wise ranking for universal no-reference image quality assessment[EB/OL].[2020-11-24].https://arxiv.org/pdf/1911.10566.pdf