基于深度学习的空天地缓存中继网络性能评估方法

2022-05-22郭凇岐孙艺夫施育鑫朱勇刚

郭凇岐,安 康*,孙艺夫,施育鑫,朱勇刚,梁 涛

(1.南京信息工程大学 电子与信息工程学院,江苏 南京 210000;2.国防科技大学第六十三研究所,江苏 南京 210007;3.国防科技大学 电子科学学院,湖南 长沙 410073)

0 引言

随着无线通信向移动化、异构化、全球化和多网系融合的方向发展,以及星载处理性能的大幅提升和空间组网关键技术的突破,基于不同轨道的卫星、空中平台(HAP)、无人机(UAV)和地面辅助中继的空天地融合网络(Satellite-Aerial-Terrestrial Integrated Network,SATIN),能够为全球广域空间范围内的各种应用提供协同、高效和安全的信息保障,在各个领域都引起了极大关注[1]。一体化组网方式下的融合架构能够充分挖掘时域、频域、空域等多维空闲频谱资源,具有全局信息处理、灵活部署、广泛覆盖范围等优势[2]。

当前应用中继协同通信技术被广泛研究,文献[3]研究了混合卫星地面通信网络最优中继选择策略下系统中断概率和误码率性能,文献[4]分析了基于地面中继到用户链路部分策略下系统中断概率性能。此外,文献[5]进一步在文献[4]工作的基础上,提出了联合中继选择和功率分配的协作传输方案。针对多用户星地协同传输网络,文献[6]提出了一种针对实时业务的多用户协同传输方案。针对多中继参与的多用户星地协同传输场景,文献[7]提出了一种基于中继和用户联合选择的协同传输方案。针对存在非法窃听用户的场景,文献[8]分析了最优中继选择方案对星地协同网络安全性能的影响。文献[9]针对LEO卫星协作传输场景,对LEO单层协同中继选择算法展开了研究,提出基于遍历容量中继选择算法。目前,大部分文献研究针对地面中继,而应用高空平台作为协同中继研究甚少,本文将选择高空平台作为中继协同传输卫星信号。

SATIN具有广域的覆盖范围,但不可避免受到带宽不足和潜在的传输延迟影响,无法满足日益增长的通信需求。近来,无线缓存已经被证明是一种有效的方法,其可以提高卫星通信(Satellite Communications,SATCOM)的服务质量(Quality-of-Service,QoS),比如延迟和吞吐量[10-11]。通过将缓存概念结合到协作传输中,集中式和分布式节点能够存储频繁需要的业务内容并方便快速地服务于用户请求,而不是先接受用户请求然后重传用户需要的业务内容,因此可以大大缓解包括带宽不足和传输延迟等在内的内在问题[12]。近年来,深度学习已被广泛应用于无线通信领域,包括无线传输、性能评估、频谱管理、资源配置、网络接入、网络及系统优化,解决了传统无线通信技术面对信息爆炸和万物互联等新发展趋势所遇到的瓶颈问题[13]。受传统最小均方误差(Minimum Mean Square Error,MMSE)信道估计器的启发,文献[13]提出了一种基于深度学习(Deep Learning,DL)的MMSE 信道估计方案。具体来说,作者首先根据MMSE估计器的结构设计深度神经网络(Deep Neural Network,DNN)结构,在信道协方差矩阵为拓普利兹矩阵(Toeplitz Matrix)的假设下,利用卷积神经网络(Convolutional Neural Network,CNN)来降低DNN的计算复杂度。文献[14]考虑一个单用户多天线的频谱感知系统,根据信号协方差矩阵与图片的相似性,采用CNN从接收信号的协方差矩阵提取检验统计量,然后基于该检验统计量进行判决。

本文采用SATIN系统模型,应用高空平台作为中继协同传输卫星信号,卫星网络作为发射端,地面目标用户作为接收端,实现了空天地融合网络协同通信。为了实现高效率协同传输将无线缓存纳入到SATIN中,考虑了两种典型的中继缓存方案,即最多访问业务缓存(Most Popular Content Caching,MPCC)方案和均匀缓存(Uniform Caching,UC)方案,将中继和缓存相结合,打破了传统模式下的一发一收策略,给中继系统在选择收发信息上提供了更多的自由,使协作中继的传输更加灵活多变,在提升协作网络吞吐量、无线覆盖范围和边缘用户服务质量的同时,降低了回程链路开销和额外时延。最后采用了一种改进后的CNN对不同缓存方案下的OP值进行预测,将空天地融合网络性能评估智能化,一定程度上解决了传统网络性能评估方法效率低的问题。

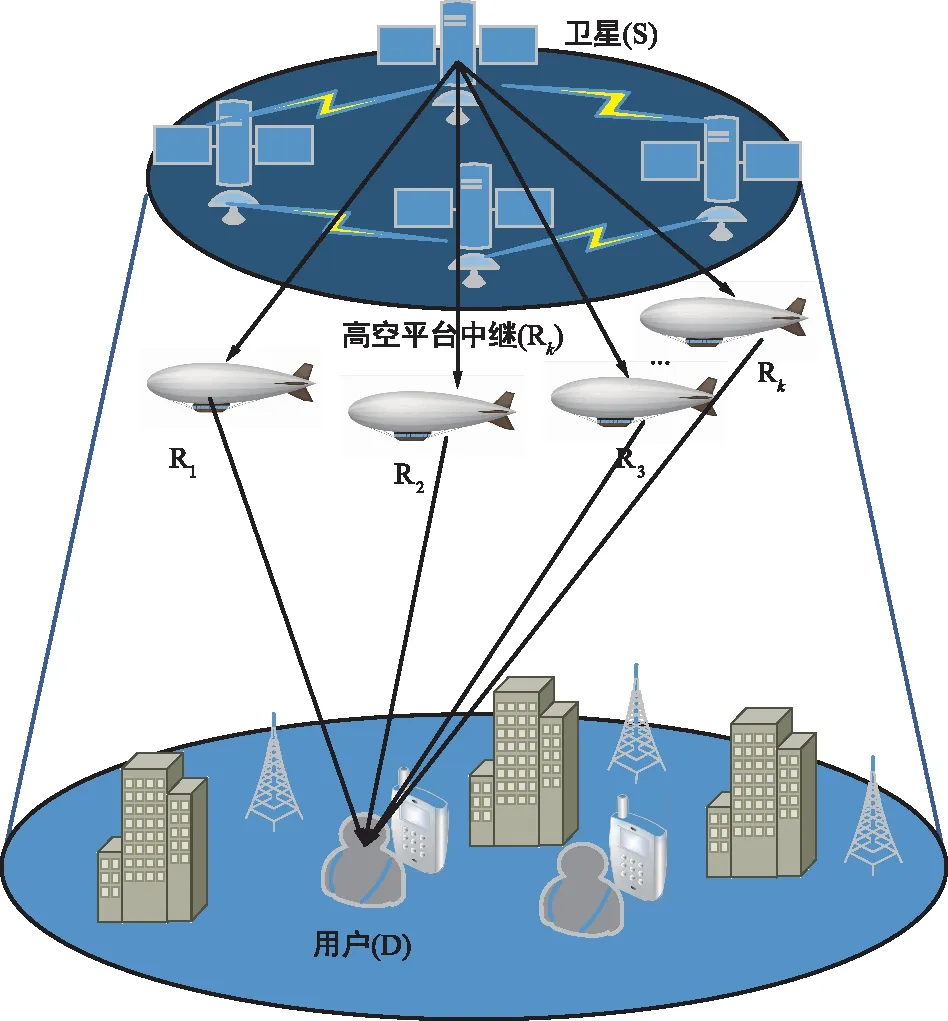

1 系统模型

本文采用放大转发型(Amplify-and-Forward,AF)SATIN系统模型,它由一个卫星节点(S)、地面目标用户节点(D)和K个高空平台中继节点(Rk,k∈[1,2,….,K])组成,如图1所示,其中设定每个高空平台中继节点都具有单根天线。

图1 系统模型Fig.1 System model

S-Rk和Rk-D两条链路的信道系数用hk和gk表示,S和R处的发射功率用Ps和Pr表示,并且每个中继节点处都加有加性高斯白噪声(Additive White Gaussian Noise,AWGN)。

通常而言,S和D之间的直达径(Line of Sight,LOS)是不存在的。所以,最终D处的信噪比(Signal-to-Noise Ratio,SNR)可以表示为[15-16]:

(1)

其中,

式中,Ωk表示LOS平均功率,2bk表示多径平均功率,mk表示衰落严重程度[18]。

R-D链路服从Nakagami-m分布信道衰落特性,其PDF可以表示为:

本文选用具有缓存功能的Rk,能够辅助存储和传输用户请求访问的业务。为了平衡复杂性和效率之间的关系,在每个时隙期间从中继集群中选择一个中继节点。为了获得最大信噪比,无缓存方案的最优中继选择策略为:

(2)

2 缓存放置方案

(3)

式中,ζ表示Zipf分布系数,当ζ取值越大,表明Zipf分布越密集,即该业务请求次数越大、访问量越多,反之则亦然,此次选择两种典型的中继缓存方案,具体细节如下。

最多访问业务缓存方案(MPCC)假设有K个中继协作传输的场景,且每个中继的缓存大小都为C。在MPC方案下,所有中继节点同时缓存C个最受欢迎的业务。对于任意第n个业务,目标用户选择缓存中继中链路通信质量最好的一条进行通信。

3 中断概率

中断概率函数定义为终端接收信噪比γ低于阈值信噪比γth的概率[16]:

Pout=Pr{γ≤γth}=Fγ(γth),

(4)

式中,Fγ(x)为累积分布函数(Cumulative Distribution Function,CDF)。

3.1 无缓存方案

首先,从对比分析的角度给出了传统无缓存方案最优中继选择的OP:

(5)

式中,Rth表示阈值传输速率,进一步

(6)

式中,γth=2Rth-1。Fγk(x)可以表示为:

(7)

由第一节中得到的fγ1,k(x)推得Fγ1,k(x)表达式为:

(8)

其中,

将式(8)和fγ2,k(y)带入式(7),先经过变量代换z=y-x,后结合下述积分公式[18]:

可以得到最终Fγk(x)的表达式:

(9)

将式(9)带入式(6),可得到无缓存方案下基于最优中继选择策略的OP闭合表达式。

无中继缓存能力的AF SATIN作为性能比较的基准。由于允许具有相同业务的中继协同传输所需业务,因此传统的中继选择方案将不适用。随后将讨论不同缓存放置策略的中继选择方案。

3.2 最多访问业务缓存方案(MPCC)

MPC方案下星地网络协同传输的OP为:

(10)

(11)

(12)

式中,γth=2Rth-1。

3.3 均匀缓存方案(UC)

UC方案下星地网络协同传输的OP为:

(13)

式中,Φ1表示UC方案下被呼叫业务n不在缓存中继里存储的概率。此方案与MPC方案不同之处在于此方案下,无论信道条件如何都可以确定R-D信道的中断概率。Φ2表示缓存中继节点与目标用户通信过程中发生中断的概率。

(14)

进一步可表示为:

(15)

式中,γth=2Rth-1。

4 卷积神经网络预测

本节构建了一个CNN来对OP值进行预测。

4.1 数据集

数据集表示为Ti,Ti={Xi,Yi}。共有12个输入参数构成输入集Xi,输出Yi对应于OP。

无缓存方案下的输入为Rth,γmin,γmax,m1,b1,Ω1,m2,Ω2,K。

MPC和UC方案下的输入为Rth,γmin,γmax,m1,b1,Ω1,m2,Ω2,K,ζ,C,N。

其中,γmin和γmax为信噪比界值,m1,b1,Ω1为Rician信道参数,m2,Ω2为Nakagami-m信道参数,K为用户数,C为缓存容量,N为业务数。

4.2 CNN结构

与图像信号相比,通信信号中的特征数量是有限的。然而,池化层可能会移除对CNN预测输出有重要影响的特征。为了避免丢失重要的特征信息,本文设计了一个不带有池化层结构的改进后CNN神经网络,如图2所示,其包含输入层、三层卷积层、全连接层和输出层。

图2 CNN网络结构Fig.2 CNN neural network structure

在设计此改进版的CNN时,设计步骤如下。

(1) 数据预处理

Ti是二维数据,CNN只能处理三维数据。因此,二维数据(14×1)在数据预处理过程中转化为三维数据(14×1×1)。

(2) 卷积层

CNN神经网络中有3个卷积层。每层卷积层中,有32个、大小为6×1的卷积核。每个卷积层之间选用非线性激活函数ReLU连接。数据经过预处理后,途经输入层进入卷积层1,输入经ReLU激活函数处理后再进入卷积层2,以此类推。ReLU函数表示为:

ReLU(x)=max(0,x)。

(16)

(3) 全连接层

全连接层将错综复杂的三维数据转换为一维数据。全连接层一共有两层,每层全连接层有128个神经元,通过Tanh激活函数输出。Tanh函数表示为:

(17)

4.3 CNN模型训练

首先,选择CNN模型训练方法,现有的CNN模型训练方法包括:批量梯度下降(Stochastic Gradient Descent,SGD)算法和小批量梯度下降(Mini-Batch Gradient Descent,MBGD)算法。但是采用BGD算法会导致单次迭代时间过长,而采用SGD算法会导致下降速度慢,陷入局部最优值,降低学习效率。因此,本文选择了学习速度最快的MBGD算法。它的优点如下:① CNN模型训练可以获得矢量运算带来的加速度;② CNN模型训练可以在不处理整个数据集的情况进行。

选择优化器对CNN模型进行训练,在当前已测试的优化器中,动量随机梯度下降(SGD with Momentum,SGDM)优化器、均方根传递(Root Mean Square Prop,RMSProp)优化器和自适应矩阵估计(Adaptive Moment Estimation,Adam)优化器已被广泛应用。对于Adam优化器来说,它大大减小了梯度下降的抖动,使神经网络参数快速逼近最优值。比较预测结果后,本文选择Adam优化器作为CNN模型训练的优化器。

4.4 性能指标

CNN预测选用的性能指标为均方误差(Mean Squared Error,MSE)[20],表示为:

(18)

4.5 OP预测算法

图3给出了OP预测算法。预测算法主要分为以下步骤:

图3 OP预测算法流程图Fig.3 Flow chart of OP prediction algorithm

首先,由上节推导出的3种缓存方案下的OP闭合表达式分别产生6 400组数据集,经数据预处理后打乱,将上述处理过的数据集分为训练集和测试集, 6 350组用于CNN模型训练,50组用于OP值预测。

其次,设计了一个改进的CNN来预测OP,改进后的CNN采用了三层卷积层,其卷积核大小为6×1。

再者,将训练集输入到改进后的CNN中,以获得最佳OP预测CNN模型。在这个过程中,需要判断所得的CNN模型是否能满足预测准确率要求,并调整CNN网络参数。

最后,将测试集输入到最佳CNN预测模型中,得到最佳OP预测结果。

5 仿真实验结果

利用Matlab2020a作为仿真软件,第一部分仿真模拟评估了不同中继缓存方案对SATIN OP性能的影响。仿真参数设置为Ps=2Pr,N=1 000,卫星链路的Shadowed-Rician信道参数设置b1=0.063,m1=1,Ω1=8.97×10-4[15,17]。地面链路的Nakagami-m信道参数设置为m2=1,Ω2=1。

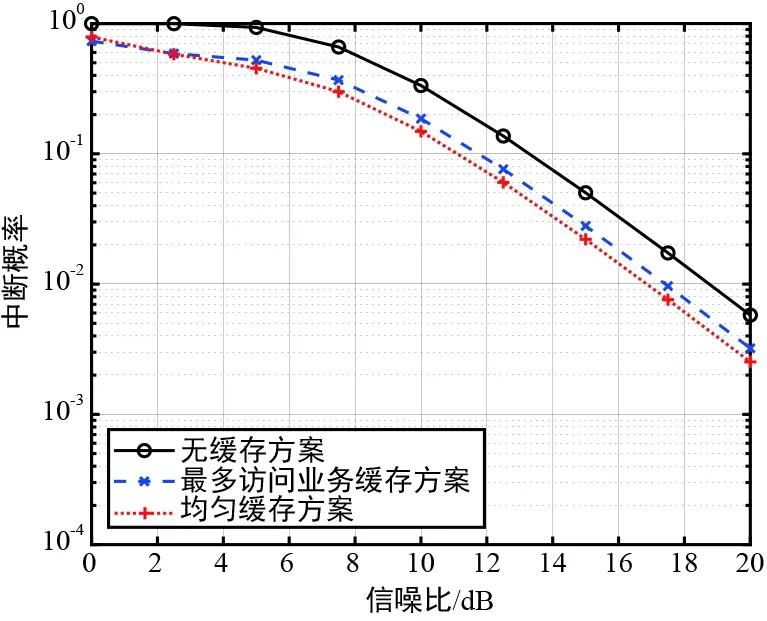

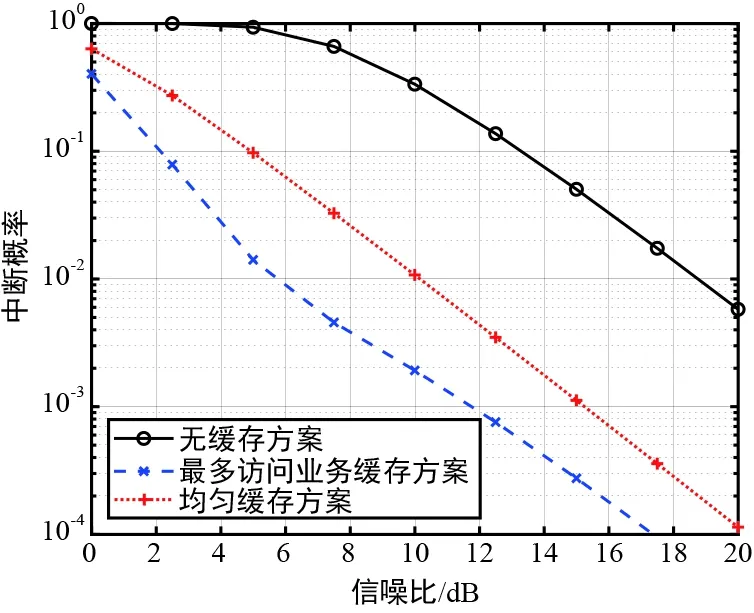

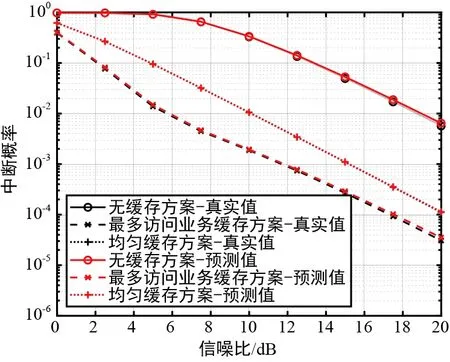

图4给出了缓存容量C相同的情况下,不同中继缓存方案下OP性能比较。

(a)ζ=0.7Zipf参数场景

(b)ζ=2Zipf参数场景图4 不同缓存放置方案的OP性能Fig.4 OP performance under different caching schemes

同前文,传统无缓存方案作为与其他方案比较的基准。由图4可以看出,对于低Zipf参数场景(ζ=0.7)和高Zipf参数场景(ζ=2),MPC和UC方案OP性能明显优于传统无缓存方案OP性能。对于低Zipf参数场景,UC方案OP性能优于MPC方案OP性能,因为低Zipf参数值意味着更一致的业务访问请求。相反,对于高Zipf参数场景(即访问业务的受欢迎程度更集中),UC方案会失去信号协同增益,所以MPC方案实现了更低的OP值。

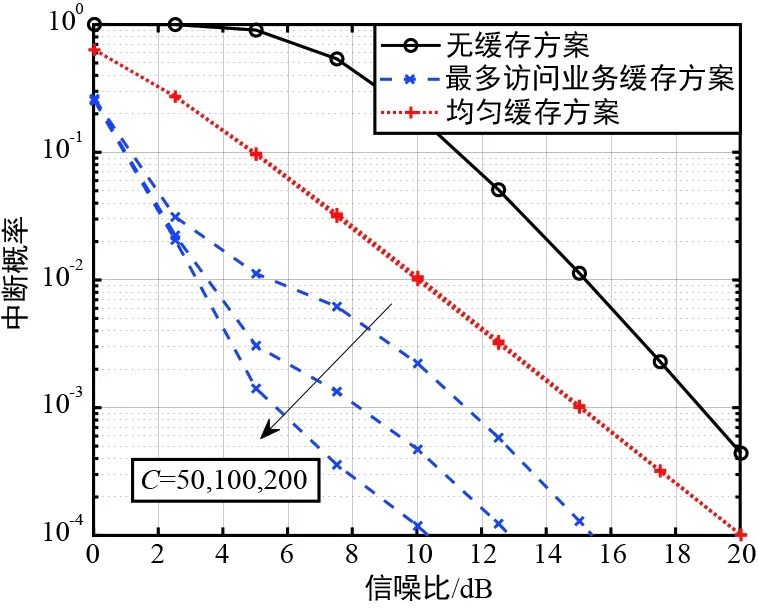

图5给出了在不同缓存容量C的情况下,MPC方案与UC方案之间的OP性能比较。观察可知,对于低Zipf参数值,MPC和UC方案的OP性能都随着C的增加而提高。但是,在高Zipf参数场景下,UC方案的OP性能没有随着C的增大而提高,是因为C对受欢迎的业务访问请求影响较小。

(a)ζ=0.7Zipf参数场景

(b)ζ=2Zipf参数场景图5 不同缓存容量C的OP性能Fig.5 OP performance under different caching capacities

第二部分,利用设计好的CNN对OP值进行预测。输入参数设定Rth=0,γmin=0,γmax=20,m1=1,b1=0.063,Ω1=8.97×10-4,m2∈[1,20],Ω2=1,K∈[2,5],ζ∈[0.5,2],C∈[50,200],N∈[800,1200]。本次CNN预测分为两种情况:第一种情况是针对SNR为固定值情况下,利用CNN分别对3种不同缓存方案下的OP值进行预测;第二种情况利用CNN对3种不同缓存方案下的OP值进行预测,并寻求与关键参数SNR的关系。

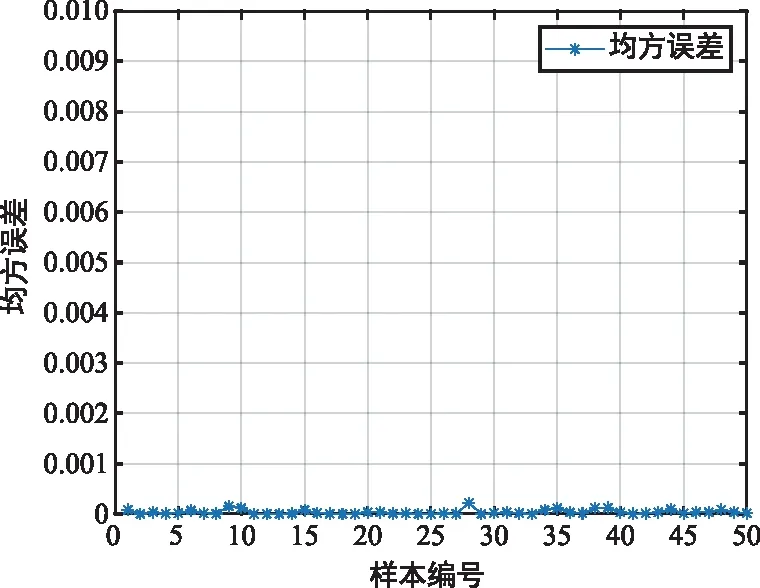

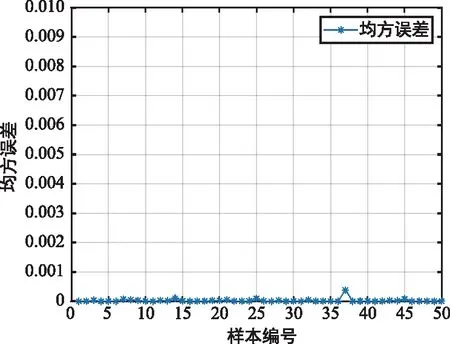

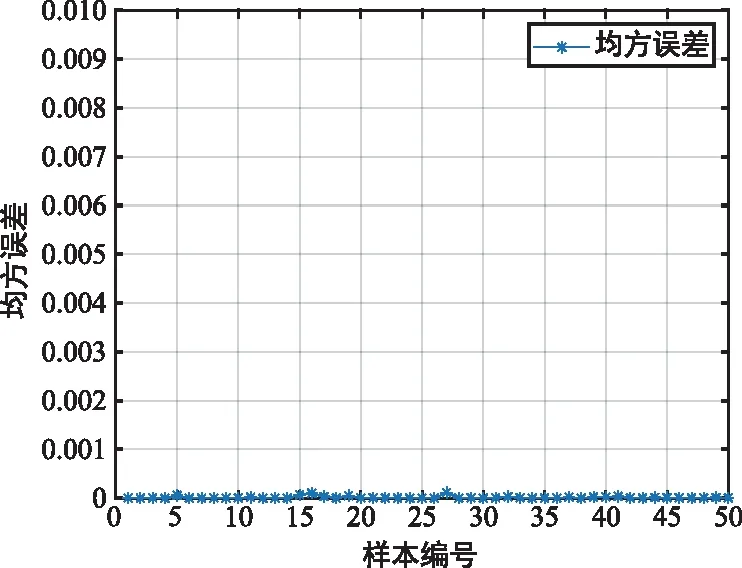

第一种情况的预测参照图6和图7。其设置的MiniBatchSize为100,初始学习率为0.005。从图6和图7不难看出,CNN针对3种不同缓存方案下的OP预测效果甚优,误差MSE在10-3浮动,能准确预测OP值。

(a) 无缓存方案

(b) 最多访问业务缓存方案

(c) 均匀缓存方案图6 不同缓存方案下OP预测性能Fig.6 OP prediction performance under different caching schemes

(a) 无缓存方案

(b) 最多访问业务缓存方案

(c) 均匀缓存方案图7 不同缓存方案下误差性能Fig.7 Error performance in different caching schemes

第二种情况的预测参照图8。从图8可以看出,CNN针对不同方案下OP值预测效果较优。无缓存方案的OP预测效果最佳,MPC和UC方案的OP预测效果次之。3种方案下OP性能都随着SNR的增大而提高。

图8 不同方案下基于深度学习的OP预测性能对比Fig.8 Comparison of OP prediction performance based on deep learning under different schemes

另外,本文还比较了闭合表达式求OP值和CNN预测OP值的运行时间。结果证明,CNN预测OP值耗时相比较于闭合表达式求OP值有大幅度缩减,只需要约0.05 s,闭合表达式求OP值耗时约1 s。因此,可以得出结论,CNN预测方法可以大大加快OP性能的预测与分析。

6 结束语

本文将不同的无线中继缓存方案纳入到SATIN中以提高网络的性能。通过采用两种典型的中继缓存方案,即MPC和UC,推导出了3种缓存方案下SATIN的OP闭合表达式,仿真并对比了在不同参数条件下3种缓存方案的OP性能表现,仿真结果验证了理论公式推导及分析的正确性,并证实了所提方案相较于无缓存功能的传统中继选择方案性能提升显著。同时,基于深度学习的方法,采用一种改进后的CNN对不同缓存方案下的OP进行预测,所用网络去除了在信息特征提取过程中容易造成特征丢失的池化层,结果表明所提方法对3种方案下的OP值预测效果较优。