基于遥感影像和卷积神经网络的农田及道路信息提取

2022-05-16刘名洋周宇光

陈 理 杨 广 刘名洋 周宇光

(中国农业大学 工学院,北京 100083)

农业设备的智能化研究是当前农业智能化研究的热点。掌握农田及其道路分布信息是实现农业智能化的关键,明确农田分布及其道路信息不仅可以为农作物及其秸秆产量等提供精准的预测,而且可以提高农业机械化程度和农产品的运输效率。图像是获取上述信息的主要方式。因此,探索稳定可靠的农用地(耕地)信息提取技术,实现对原始图像进行高效的加工,使其成为可以直接利用的信息,对于农业资源的整合与利用起着至关重要的作用。

当前,农用地(耕地)的分类识别存在一些问题,如耗人力、效率低、难量化等。现有的农用地识别算法主要包括人工标注和计算机视觉。人工标注主要采用人工牵引的方式,受时间、人力等因素的限制,不适用于大面积的分类识别。随着计算机与遥感技术的进步,计算机视觉算法在土地识别方面取得丰硕的成果。Dronova等对覆盖复杂、田间获取困难的湿地进行多分类植被分析;Mylonas等提出一种面向对象的遥感影像分类方案;邓曾等利用SVM等方法区分城市土地利用类型。但早期的人工特征提取算法精度较差、难以适配大尺寸图像。随着大数据技术的蓬勃发展和硬件计算能力的飞速提升,基于深度学习的图像分割成为新的研究方向。杨蜀秦等利用改进后的DeepLab v3+分类农田作物;吕道双等利用改进后的U-Net提取遥感图像中的建筑物;Rawat等利用CNN-LSTM分割水稻移栽田影像。但大多数研究基都基于公开数据集进行,这些数据集主要包含城市、道路和山区等,缺乏农田等乡村场景;在预测图像的后续处理及应用方面,多数论文也鲜有提及。本研究拟采用卷积神经网络(Convolutional neural network,CNN)的方法,以提取农田和道路信息为目标,为相关研究者提供利用遥感影像和深度学习技术获取田间道路和农田信息的通用流程。

1 图像获取与模型搭建

1.1 图像采集

本研究样本数据源为6幅拍摄于2020年5月24日的河北省献县某乡的卫星遥感影像,图片大小为11 651像素×7 768像素,空间分辨率0.23 m,覆盖区域面积4.787 7 km,其中5幅用于制作训练集和验证集,1幅用于制作测试集。为使模型可以进行学习,需要对图片进行标注加工,研究使用的标注工具为labelme,基于此制作“道路-背景”和“农田-背景”2个数据集。在原始图像中由于道路和农田所占的像素比例相差较大,而不同的模型在分割大小不同的目标时效果也有所差别,因此,单独提取道路和农田有助于后期进行模型选择和模型融合等操作。

1.2 图像处理及数据集划分

由于原始影像的尺寸过于庞大,不能将其直接送入网络进行训练,故需要根据训练集、验证集和测试集的不同特点对原始图像进行切割。

制作训练集和验证集时,综合考虑数据量、GPU显存和模型特性等,图像提取方式确定为从图像原点开始,每向右(或向下)滑动224像素或384像素即取出1副小图。切割后的图片总数分别为8 840张(224像素×224像素)与3 000张(384像素×384像素)。选取9∶1、8∶2和7∶3的比例划分训练集与验证集。

制作测试集时,考虑到后续的相关应用,需要将预测后的小图拼接成一幅完整的大图。由于原图的宽和高均非小图边长的整数倍,因此会留下一部分宽或(和)高小于切割尺寸的长方形图像,此时使用0 像素对它们进行边缘填充,使其边长变为224 像素或384 像素。

1.3 数据增强

在深度学习中,训练数据的不足容易导致过拟合,因此需要进行数据增强,以提高模型的稳定性和鲁棒性。本研究利用伽马校正、图像旋转、图像滤波、噪声增加、图像翻转、图像放缩的方式对2个数据集中的训练集进行数据增强。图1以分割后为224像素×224像素的原始图像及其标签图像为例,展示旋转、翻转、缩放3种数据增强的效果。

(b)和(c)中,红色像素为农田和道路的真值,黑色像素为非真值。图3、4、5同。 In (b) and (c), the red pixel is the true value of field and road. The black pixel is the non-truthy.Figs. 3, 4 and 5 are the same.图1 原始图像及其标签的旋转、翻转、缩放3种数据增强示例Fig.1 Three types of data enhancement examples: rotation, overturn, and resize of the original image and its label

1.4 模型搭建

本研究制作的2个数据集具有如下特点:1)仅涉及相对简单的2分类问题;2)数据量相对较少;3)目标道路和农田的图像特征相对简单;4)需要测试上百个超参数不同、网络结构不同的模型。因此选取结构简单、参数量小的神经网络模型。

基于此本研究共搭建5种模型,分别是:1)基于MobileNet v1的U-Net;2)基于MobileNet v1的SegNet;3)基于MobileNet v1的PSPNet;4)基于MobileNet v1的 DeepLab v3+;5)基于MobileNet v2的DeepLab v3+。本节以基于MobileNet v1的U-Net模型和MobileNet v1的SegNet模型为例介绍5种模型的搭建思路。

MobileNet v1最主要的特点是深度可分离卷积,深度可分离卷积可实现常规卷积的效果,但它的参数量却大大减少。

U-Net是一个典型的具有“编码器-解码器”结构的语义分割模型,具有全卷积、上采样和跳跃连接的特点,可以融合图像的多尺度特征,在小数据集上有着良好的表现。

SegNet的编码部分沿用VGG16的前13层结构;其解码部分采用Same padding以丰富特征图中的内容,使网络能够在解码时学习到池化过程中丢失的部分信息。

图2(b)为基于MobileNet v1的U-Net的结构图:Dep sep conv block为深度可分离卷积模块(图2(a)),F

至F

分别代表不同编码阶段输出的特征图,Zero padding为补零,Conv为卷积,BN为批标准化,ReLU为激活函数,Upsampling为上采样模块,Reshape用于调整输出张量的尺寸,Softmax为损失函数。图中的左半部分为模型的编码器,其基本沿用MobileNet v1的结构;右半部分为解码器,其结构参考U-Net的解码部分,但层数更少,这主要是因为相较于经典U-Net中的编码器VGG16,MobileNet v1提取到的图像特征更为浅层。解码部分共进行3次上采样,先后用到编码阶段输出的F

、F

和F

共3组特征图。此外,经过多次对比试验发现,将F

或(和)F

拼接到解码部分会使模型的性能下降。图2(c)示出基于MobileNet v1的SegNet模型的结构图,编码部分采用MobileNet v1的大部分结构;解码部分则参考经典SegNet解码部分的结构,但更为简洁:3次重复的“补零-卷积-批标准化-激活-上采样”操作。该模型并没有使用经典SegNet中的池化索引策略,因为其利用MobileNet v1编码时未进行池化操作。此外,经多次对比试验发现,相较于F

、F

、F

和F

,使用F

作为解码部分的输入可使模型表现更好。基于MobileNet v1的PSPNet、基于MobileNet v1的DeepLab v3+和基于MobileNet v2的DeepLab v3+的构建思路同上述2种模型基本一致:选用去除全连接层的MobileNet v1、v2作为网络的编码器,选用PSPNet、DeepLab v3+作为网络的解码器,并经过一定修改。

图2模型结构图Fig.2 Model structure drawing

1.5 迁移学习

迁移学习部分使用基于ILSVRC数据集和Cityscapes数据集进行训练所获得的2套预训练权重,对于使用ILSVRC数据集进行训练的权重,迁移的目标是基于MobileNet v1的U-Net、SegNet、PSPNet和DeepLab v3+共4个模型的编码部分;另1套使用Cityscapes数据集进行训练所获得的权重应用于基于MobileNet v2的DeepLab v3+模型本身的编码和解码部分。

2 试验方法

2.1 试验环境

硬件环境为Intel Core i7- 10700F CPU、16 gb内存、NVIDIA GeForce RTX 2060 Super GPU。软件环境为Windows 10专业版、CUDA 10.0、cuDNN 7.4.1.5、Python 3.6、Tensorflow-gpu 1.13.2、Keras 2.1.5。

2.2 评价指标

对于像素级别的图像分类,最常用的评价指标是交并比(Intersection over union,IoU)和平均交并比(Mean intersection over union, mIoU)。前者的含义是某一类标签中的像素(Ground truth)的集合和模型预测出的结果(Prediction)的集合之间的交集同它们之间的并集的比值,后者则是多个IoU值的平均值。IoU的表达式为:

(1)

mIoU的表达式为:

(2)

式中:TP表示真值为某类别x

,预测值也为x

的像素点的数量(预测正确);FN表示真值为x

,但预测值不是x

的像素点的数量(预测错误);FP表示真值不是x

,但预测值为x

的像素点的数量(预测错误);TN表示真值不是x

,预测值也不是x

的像素点的数量(预测正确);n

为总类别数,iIoU表示第i

个类别的IoU值。本研究选用mIoU为不同模型在2个数据集上表现的评价指标,选用IoU为软投票时的权重。

2.3 超参数设置

超参数(Hyperparameters)对模型的表现有着极大的影响。本研究中,超参数的设置目标是:构建参数不同的模型和确保每个模型能够以较快的速度收敛。具体设置为:

1)Batch size分别设置为:4、8、16、32;

2)优化器:Adam;

除传统的历史文化外,地方民俗文化对三峡游客也十分具有吸引力。很多游客在游记中描述了土家族民俗文化和巴东纤夫文化体验,表示参与性的土家婚嫁仪式十分受欢迎,如一位北京游客在游记中所写:

3)学习率:初始值为10,当验证集的损失函数值经过3个Epoch后不下降时,学习率就下降为先前的1/2;

4)最大迭代次数:40;

5)损失函数:“道路-背景”数据集采用Focal loss+Softmax损失函数、“农田-背景”数据集采用Cross entropy loss +Softmax损失函数;

6)早停:当验证集的损失函数值经过6个Epoch后不下降,网络停止训练。

3 试验过程与结果分析

依据2种测试集图像切割方法,设计对应的图像拼接策略:1)对于切割步长为224 像素或384 像素的小图,进行预测后直接按照切割时的顺序将其拼接(拼接策略1);2)对于切割步长为112像素或192像素的小图,同样需要进行预测和依序拼接,但拼接时需考虑相邻图像间的重叠区域:对于2张相邻的小图,模型对二者重叠区域的预测结果可能不同,主要原因是部分模型对图像边缘特征的提取能力较差,从而误将图像边缘的道路或田地识别为背景。因此,在对上述重叠区域的预测结果进行判定时,遵循“对于某1像素点,只要其在1张小图中被预测为道路或田地,那么该点在最终生成的大图中即被认定为道路或田地”的原则(拼接策略2)。此外,对于进行补零操作的小图,在大图融合完毕后,应切除补零,以使预测拼接图的尺寸与原始图像的尺寸保持一致。

为比较不同算法的有效性及其与传统算法的差别,对5种算法与支持向量机 (Support vector machine,SVM)共6种算法进行比较。此外,为测试算法的稳定性,每种使用不同参数组合的模型都进行3次训练,同时记录其mIoU的最佳值、平均值和标准差。

3.1 “道路-背景”数据集的试验结果

表1示出按照最佳mIoU从高到低顺序列出的7种性能最佳、超参数不同、结合不同拼接策略的CNN以及SVM道路预测模型。可见,在5种CNN模型中,基于MobileNet v1的SegNet和基于MobileNet v1的U-Net从图像中提取道路信息的能力较强,且稳定性较高。在输入图像的尺寸方面,224 像素×224 像素是更优的选择;训练集与验证集的样本数比则以9∶1和8∶2为宜;第2种图像拼接策略可以更好地优化预测结果;此外,相较于CNN模型, SVM在“道路-背景”数据集中表现较差,最佳mIoU值仅为0.695 5,且稳定性较弱。

表1 7个mIoU值最高的CNN道路预测模型和SVM道路预测模型

Table 1 7 CNN road prediction models with the highest mIoU and SVM road prediction model

模型名称Model图像尺寸(长×宽)/像素×像素Image size(length×width) Batchsize迭代次数IterationsnT∶nV①图像拼接策略ImageMosaicstrategy最佳mIoU值OptimalmIoUvalue平均mIoU值AveragemIoUvaluemIoU值的标准差StandarddeviationmIoU valueM1-SegNet224×224 8169∶120.839 60.834 00.004 7M1-U-Net224×22432199∶120.829 00.825 90.005 2M1-U-Net224×22416158∶220.825 80.822 60.004 1M1-U-Net224×22416158∶210.823 00.82070.003 8M1-SegNet224×22416148∶220.819 30.815 00.004 7M1-SegNet224×2248106∶420.816 90.811 30.008 1M1-U-Net224×22432199∶120.812 30.806 40.005 8SVM224×224——10∶0 20.695 50.673 30.022 0

注:M1表示MobileNet v1。①和分别为训练集和验证集样本数量。下表同。

Note: M1 stands for MobileNet v1. and are the number of samples of training set and verification set, respectively. The same as in the following

Table.

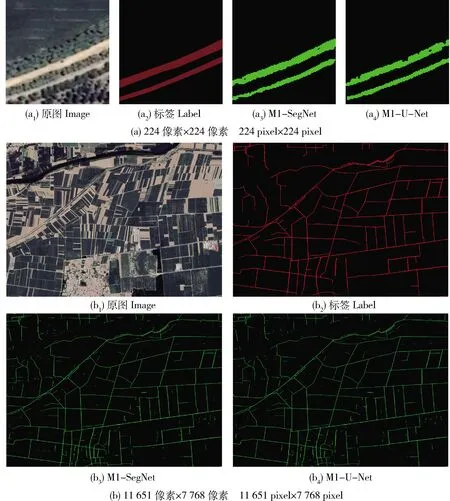

M1-SegNet:基于MobileNet v1的SegNet的预测图;M1-U-Net:基于MobileNet v1的U-Net的预测图。图4、5同。 M1-SegNet: Prediction graph of SegNet based on MobileNet v1; M1-U-Net: Prediction graph of U-NET based on MobileNet v1.Fig.4 and 5 are the same. 绿色像素表示模型预测为真值的像素,黑色像素表示模型预测为非真值的像素。图4、5同。 The green pixels in the prediction graph represent the pixels predicted by the model to be truthy, and the black pixels represent the pixels predicted by the model to be non-truthy.Fig.4 and 5 are the same.图3 基于MobileNet v1的SegNet、U-Net的道路预测图Fig.3 Road prediction results of SegNet/U-Net based on MobileNet v1

3.2 “农田-背景”数据集的试验结果

表2示出“农田-背景”数据集的试验结果,可见:基于MobileNet v1的SegNet和基于MobileNet v1的U-Net在图像中提取农田信息的能力较强,且稳定性较好;基于MobileNet v1的DeepLab v3+和基于MobileNet v1的PSPNet也具有不错的提取效果,但稳定性欠佳;而基于MobileNet v2的DeepLab v3+的分割效果较差。在输入图像的尺寸方面,224 像素×224 像素是更优的选择;在Batch size的选择上,使用32能够更好地帮助网络训练;而训练集与验证集的样本数比则以9∶1和8∶2为宜;第二种图像拼接策略可以更好地优化预测结果。此外,SVM在“农田-背景”数据集上表现尚可,最佳的mIoU值可以达到0.849 2,但稳定性较弱,且同CNN

表2 7个mIoU值最高的CNN农田预测模型和SVM农田预测模型

Table 2 7 CNN field prediction models with the highest mIoU and SVM field prediction model

模型名称Model图像尺寸(长×宽)/像素×像素Image size(length×width)Batchsize迭代次数IterationsnT∶nV图像拼接策略Imagemosaicstrategy最佳mIoU值OptimalmIoUvalue平均mIoU值AveragemIoUvaluemIoU值的标准差StandarddeviationmIoUvalueM1-SegNet224×22432197∶320.947 30.943 30.006 0M1-U-Net224×22432129∶120.946 80.944 10.005 1M1-U-Net224×22432138∶220.926 10.921 20.007 2M1-SegNet224×22416119∶120.897 00.893 60.006 3M1-DeepLab v3+224×22432169∶120.887 50.880 10.010 2M1-U-Net224×22432129∶110.885 40.881 90.006 1M1-PSPNet384×384 8188∶220.869 30.860 00.012 4SVM224×224——10∶0 20.849 20.838 80.025 3

模型有着较为明显的差距。

图4(a)为2种模型在测试集(224像素×224像素)上的预测结果。可以看到,2种模型可以正确地预测出大部分的农田,但即使是表现较好的模型,有时也无法完整地提取到图像的边缘特征;此外,农田的内部还存在着少许孔洞,这进一步说明拼接策略的必要性。图4(b)为基于MobileNet v1的SegNet和基于MobileNet v1的U-Net在测试集上的预测图(融合拼接策略2、大小为11 651像素×7 768像素),可以看到其中绝大部分预测的农田像素和标签中的农田像素是重合的,并且图中几乎没有因模型提取不到边缘特征而产生的缝隙;同时,相对于预测小图,预测大图中农田内部的孔洞也大幅减少,这说明搭建的模型和图像拼接策略是有效的。

图4 基于MobileNet v1的SegNet、U-Net的农田预测结果Fig.4 Field prediction results of SegNet/U-Net based on MobileNet v1

为验证迁移学习在模型训练中起到的作用,本研究选取在农田预测结果中表现较好的基于MobileNet v1的U-Net和MobileNet v1的SegNet,采用训练集样本数:验证集样本数为9∶1和8∶1,Batch size分别设置为8、16、32进行训练,结果表明:基于MobileNet v1的U-Net模型在使用迁移学习的情况下表现更好,迭代可以次数减少50%~100%、准确率提升5%~16%、mIoU提升0.02~0.1;基于MobileNet V1的SegNet模型在加入迁移学习之后准确率和mIoU没有较大提升,但其迭代次数也可减少20%~80%。

3.3 模型融合

模型融合属于集成学习的范畴,是1种把分类器强强联合,以使最终的模型具有更好分割效果的算法。本研究主要使用投票法进行模型融合,CNN模型(表1、2各7个)被选为待融合模型,衡量指标为mIoU,表3为融合的结果,可以看出,硬投票和软投票都可以优化模型的性能,而软投票的效果略优于硬投票。从mIoU提升的幅度来看,相较于“农田-背景”数据集,模型融合更有助于提高“道路-背景”数据集的分割精度,这是因为参与优化的单个“道路-背景”模型本身的精确度相对较低,提升空间较大。

表3 农田和道路预测图的模型融合结果

Table 3 Model Ensemble results of field and road forecast maps

数据集Data set未融合前最佳Best before fusion硬投票Hard vote软投票Soft vote差值(硬投票后)Margin (after hard vote)差值(软投票后)Margin (after a soft vote)道路 Road0.839 60.850 10.853 30.010 50.013 7农田 Field0.947 30.954 40.956 80.007 10.009 5

3.4 预测时间成本及储存成本

本研究对模型的训练和预测时长以及参数占用硬盘储存空间的大小进行记录。在5种模型中,基于MobileNet v1的U-Net和基于MobileNet v1的SegNet的训练时间相对最短,在15~33 min。此外,就权重文件的存储而言,5种模型的权重文件均在电脑硬盘上占据20~30 Mb的空间。由此可见,本研究最终选用的模型的训练和预测时间成本以及储存成本可被接受。

3.5 结果分析及图像后处理

3

.5

.1

结果分析对农田和道路信息的提取试验表明:1)在使用2分类方法从农村地区的遥感影像中提取道路和农田信息时基于MobileNet v1的U-Net模型和基于MobileNet v1的SegNet模型拥有更佳的准确率和稳定性, 这可能是由于数据量有限,而PSPNet和DeepLab v3+模型解码部分的网络层数较多,且乡间道路和冬小麦田所具有的图像特征较为简单,从而产生过拟合现象导致的。此外,随着网络层数和参数量的增加,模型训练的稳定性会相应降低。综上,在搭建深度学习模型时,模型的结构并非越复杂越好,应该依据具体的应用场景加以确定;2)迁移学习在模型的训练过程中发挥良好的作用;3)在对大尺寸图片进行处理时,合理的切割和拼接方法有助于提升图像的分割效果;4)模型融合(硬投票法和软投票法)可以进一步提升道路和农田的分割精度;5)传统的机器学习方法支持向量机在数据分布很不均匀的“道路-背景”数据集上表现不佳,而在数据分布相对平均的“农田-背景”数据集上表现较好,但总体而言,CNN模型的分割精度和稳定性更高。

3

.5

.2

图像后处理模型预测出的图像由于存在缝隙、孤立点和细小连接等问题,不能直接应用于后续的相关研究,需对其进行处理。因此,确定了如下图像处理方法:对农田预测图而言,采用“形态学处理+去除孤立区域”的方法;对道路预测图来说,采用“形态学处理+去除孤立区域+细化中心线”的方法,使之能够满足后续相关研究的基本条件。

数学形态学处理基于集合理论、格理论、拓扑学和随机函数,是一种识别和分析几何结构的技术。它利用一些具有原始形态特征的核来测量和获取图像中的形状。腐蚀、膨胀、开操作和闭操作是形态学处理中常用的4种处理方式。

对基于MobileNet v1的SegNet模型预测出的道路图像,根据其特征,对其进行闭操作处理(图5(a))。同时,由于原始影像中存在部分宽度较大的田埂和宽度较小的小路,模型在预测时会将这些田埂和小路预测为道路,这部分预测错误的像素点相对孤立,而预测正确的道路像素点则互相连接,形成若干个面积较大的连通域。因此,本研究去除预测图中面积小于15 000个像素点的8连通域(图5(a))。此外,尽管经过处理后的道路预测图中仍有个别不合要求且连接着主干路网的田埂和小路,但它们仅与道路的1端相连,几乎不会对后续的路径规划产生影响。经过上述操作的道路预测图需要经过细化处理(提取道路的中心线)才可被直接用于路径规划,参照Lam等的算法对道路预测图进行提取中心线(图5(a))。

对基于MobileNet v1的U-Net模型预测出的农田图像,需要去除相邻田地间的细小连接,因此应选用开操作对其进行处理(图5(b))。同时,因为在献县境内地势较为平缓,农田大都成片相连,较少出现单独在小片区域种植粮食作物的情况。所以对农田预测图,本研究设定去除面积小于5 000个像素点(对应实际的土地面积为264.5 m)的八连通区域(图5(b))。

图5 农田和道路预测图的后处理Fig.5 Post-processing of field and road forecast maps

4 结束语

本研究以我国河北省献县某乡为研究区域,制作“道路-背景”和“农田-背景”遥感影像数据集,搭建了5种基于卷积神经网络的语义分割模型,基于此进行图像分割试验,并融入迁移学习、图像拼接和模型融合策略。研究结果表明:基于MobileNet v1的U-Net和基于MobileNet v1的SegNet 2种模型的准确率和稳定性最佳;此外,在提取道路和农田时,融合后模型的平均交并比(mIoU)值分别可达0.853 3和0.956 8;同时图像后处理的运用,也使预测结果能够满足后续相关研究的基本要求。

在进一步的研究中可以改变超参数部分相关参数的设置,同时,将不同版本的MobileNet作为特征提取部分,将SegNet等作为像素分类部分,以形成具有不同结构的网络模型,并测试其能否具有更佳的图像提取效果。