车辆全景环视设备图像质量评价方法研究

2022-05-08刘梦雅

董 轩,周 炜*,刘梦雅

(1.交通运输部公路研究所,北京 100088;2.交通运输部车辆运行安全技术重点实验室,北京 100088)

随着经济的发展,人们生活水平的提高,汽车的产量和销量逐年递增,与此同时,行车安全对人们生命财产安全的影响越来越大[1]。由于驾驶员视觉盲区的存在,极易造成判断和操作失误,从而导致吞人卷车、汽车追尾等交通事故频发,驾驶员视野盲区成为获取汽车周围环境信息的最大障碍。尤其是大型客车与货车,车身周围存在许多视野盲区,经常发生车辆起步或泊车时碾压视野盲区内行人及非机动车的事故,特别是公交车、城市物流车辆等在人员密集场所运营车辆的此类事故风险尤其严重,大型营运车辆车身周围盲区面积可达70 m2[1]。为了解决这些问题,车载环视系统萌芽并发展起来,在无人驾驶和汽车电子安全驾驶领域具有广阔的应用前景。车载环视系统的概念由K.Kato等[2]人于2006年首先提出,并申请了美国专利。车载环视系统是一种基于机器视觉的车辆辅助驾驶系统,是利用安装在车辆四周的广角摄像头,通过图像变换重构车辆以及周围场景的鸟瞰视角图像,驾驶员可以安全泊车、避开障碍物和消除视觉盲区,达到安全行车的目的。

车载环视拼接相关技术研究已经逐渐成为国内外研究重点[3-6]。相对于图像拼接方法的研究,目前国内外文献中对拼接图像质量评价的研究较少。图像质量评价是比较各种图像拼接方案性能优劣以及优化系统参数的重要手段,因此建立有效的图像质量评价机制对评估全景拼接性能具有重要的意义。特别是全景环视系统的图像质量依赖于图像的拼接算法,必然会存在重影、损失等情况。本文提出了用软件检测360度全景环视设备的图像质量,从而判定待检360度全景环视设备成像系统质量好坏,为360度全景环视设备成像质量判断提供科学的方法。

1 场景布置

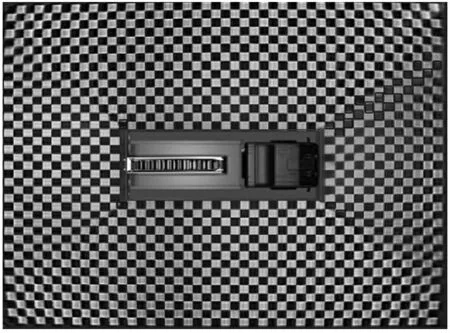

在安装有360度全景环视设备的车辆的周围布置黑白棋盘格,启动车辆和360度全景环视设备,360度全景环视设备拍摄清晰的全景图像并将融合后的全景拼接图像发送至360度全景环视设备成像质量评估软件。通过矩阵式光源系统对环境照度进行精确控制,实现在地面2~3 000 lux的照顾调节,试验设置为1 000 lux进行采集,地面照度均匀性Min/Ave>0.9@Average≈1 000 lux。

黑白棋盘格符合ISO 16505的要求,布置方式:在车辆垂直地面投影外边缘远离车辆方向5~20 cm处,即车辆的前后左右,布置单个方格尺寸大小30 cm*30 cm的棋盘格,前后左右布置的棋盘格形成方框型,且其排布前后、左右分别对称。场景布置如图1所示。

图1 场景布置图

2 软件计算步骤

车辆360度全景环视设备开启并拍摄清晰全景图像,并将融合后的全景拼接图像发至电脑端软件;软件方基于深度学习,生成训练数据集合和测试数据集,构建YOLOV3网络;根据YOLOV3网络计算全景拼接图像的拼接损失占比、拼接重影占比、拼接错位长度以及拼接缝隙宽度,生成测试报告,并存储数据。

2.1 生成训练数据集和获取测试数据集

获取360度全景拼接图像,生成图像数据集,通过获取的不同环境、车型和厂商的拼接合成图像;对每张图像进行标注,分别框出图像中拼接重影,拼接损失,拼接错位、拼接缝隙的位置并标注每个位置的类别;将图像数据集按9∶1划分为训练集和验证集,获取测试数据集。

2.2 构建并训练YOLOV3网络模型

将生成训练数据集和获取测试数据集作为图像为输入,生成一个YOLOV3网络模型,该网络模型主要由输入层、主干特征提取层、特征融合输出层组成。

输入层输入416×416×3大小的图像。

主干特征提取层由残差卷积模块和在残差卷积模块间实现下采样的卷积模块组成,用来提取图像特征。首先,对输入层输入的图像进行32通道的卷积,再通过BN归一化和LeakyReLU激活后得到特征层;卷积计算公式如下:

其中,xi为第i个像素值,n为图像块的像素点总数,wi为权重矩阵第i个下标的值。

BN归一化函数如下:

其中,xout为归一化结果,γ为缩放因子,u为均值,σ2为方差,β为偏置。

LeakyReLU激活函数如下:

其中,xi为BN归一化后的输出,ai为非零系数。

然后,对输入的特征层进行卷积核大小为3,步长为2的下采样,归一化和激活函数后,进行残差网络的堆叠,残差网络由两组卷积标准化和激活函数组成,在前向传播阶段,将输入的特征层分为2部分,一部分为主干卷积边,对输入的特征层进行2组卷积标准化和激活操作,再与另一部分残差边相加得到残差堆叠的结果。将结果又进行卷积核大小为3,步长为2的下采样,归一化和激活函数后,进行2次残差网络的堆叠,得到第2次下采样和残差堆叠的结果,从第1次开始分别对上一步结果进行下采样后进行1次、2次、8次、8次、4次残差堆叠,得到5次下采样和残差堆叠的结果,对后3层的特征层进行保存,进行下一层的处理。

特征融合层将上一层保存的3个尺度的特征层构建特征金字塔,进行分类和回归预测。以416×416图像作为输入的特征融合层的3个尺度分别为13×13、26×26和52×52。在每个尺度内,通过卷积核的方式进行局部特征交互,完成金字塔特征融合;首先,对13×13特征层的图像进行1×1的卷积调整通道数,3×3的卷积进行进一步的特征提取,再进行1×1的卷积调整通道数,3×3的卷积进行特征提取,以此来减少网络的参数量进行特征的提取,接着又通过一个1×1的卷积对通道数进行调整,对5次卷积后的结果又进行3×3和1×1的卷积进行分类和回归预测;然后,对前5次卷积后的结果进行1×1的卷积调整通道数后进行上采样操作,与上一层26×26的特征层进行堆叠,堆叠结果进行与13×13特征层相同的5次卷积提取特征以及3×3和1×1的卷积进行分类和回归预测;最后,52×52特征层也进行相同操作,最终获得3个尺度的回归预测结果。

输出层对特征融合层输出的3个尺度特征图进行分类和位置回归,通过获取的3个预测结果进行先验框的调整,获得最终的预测框。其中损失函数如下:

其中,Llocation(l,g)为目标边框定位偏移量损失,Lconfidence(o,c)为目标边框置信度损失,Lclass(O,C)为目标边框分类损失,λ1、λ2、λ3表示平衡系数。

Lconfidence(o,c)采用二值交叉熵损失,公式如下:

式中,oi∈{0,1},表示第i个预测框是否存在待检测目标,其中0表示不存在,1表示存在。ci表示第i个预测框存在已知目标的Sigmoid概率。

Lclass(O,C)采用二值交叉熵损失,公式如下:

式中,oij∈{0,1}表示第i个目标预测框是否存在第j类待检测目标,0表示不存在,1表示存在,Cij表示第i个目标预测框存在第j类目标的Sigmoid概率。

Llocation(l,g)采用真实值与预测偏差值差的平方和表示,公式如下:

其中,gi为预测框相对预设框坐标偏移量,li为预测矩形框坐标偏移量,(bx,by,bw,bh)为预测框参数,(cx,cy,pw,ph)为预设框参数,(gx,gy,gw,gh)表示映射在预测特征图上真实目标框参数。

最后,利用数据集训练YOLOV3网络。

2.3 对YOLOV3网络模型进行评分

通过软件指出损失图像、拼接重影、拼接错位、以及拼接缝隙的位置并进行计算损失占比、重影占比、错位长度以及缝隙宽度。

损失占比计算公式如下:

其中,l为单个棋盘格的损失占比,sl为单个棋盘格损失的面积,sc为棋盘格本身的面积。

重影占比计算公式如下:

其中,g为单个棋盘格的损失占比,sg为单个棋盘格重影面积,sc为棋盘格本身的面积。

错位长度计算公式如下:

其中,dd为2个棋盘格的错位距离(单位:cm),dx为2个棋盘格横向错位距离,dy为2个棋盘格纵向错位距离。

缝隙宽度根据图像像素距离与实际距离进行缝隙宽度的计算。

某360度全景环视设备拼接图像结果分析如图2所示,该图像共检测出46处损失,11处重影和11个错位的地方,无拼接缝隙。

图2 某360度全景环视设备拼接图像分析

3 结束语

通过360度全景环视拼接图像质量评价软件对360度全景环视设备的拼接图像质量进行评价。软件基于深度学习,生成训练数据集合和测试数据集,构建YOLOV3网络;根据YOLOV3网络计算全景拼接图像的拼接损失占比、拼接重影占比、拼接错位长度以及拼接缝隙宽度的结果表明,360度全景环视设备图像评价软件能准确地判断拼接图像的效果,代替繁琐的、大量的人为统计评分,并且可以克服单因素评价指标所带来的局限性,有利于全自动自适应图像拼接系统的实现,具有非常重要的应用价值。

同时,该方法可以扩展环视拼接的立体测试内容,通过垂直于地面的棋盘格实现垂直方向的重影、损失等参数的量化分析,考察行人、车辆从盲区通过时候的图像置信度与驾车风险,后续工作正在持续开展中。