对基于深度学习的无人机航拍车辆检测研究

2022-05-03王飞

王飞

(包头职业技术学院,内蒙古包头 014030)

0.引言

伴随着城市的快速发展,市内车辆日渐增多,给道路交通监管工作开展带来了较大难度。因为依靠固定监控设备进行道路监控,由于检测场景有限,将导致监管盲区的产生,不利于监管活动的开展。在无人机航拍技术逐步成熟的条件下,人们开始尝试利用无人机进行车辆检测,依靠其高灵活性、高分辨率、成本低等优势解决道路监管覆盖面有限的问题。但实际应用该技术,仍然面临在复杂环境背景下提取车辆特征的问题,需引入深度学习算法提高检测精度,有效增强技术的实用性。

1.深度学习算法概述

在机器学习领域,深度学习为重要分支,能够通过多层表示反映数据间的复杂关系,建立的模型在图像识别、语言处理等方面均能体现一定优势。在车辆检测方面,卷积神经网络可以为机器训练提供有力支持,使深度学习算法在车辆数据集处理方面获得更优性能。现阶段,常用的深度学习算法包含RCNN、RPN、YOLO等。其中,RCNN为基于卷积神经网络的目标检测算法,可以通过选择性搜索对候选区的深度特征进行提取,然后利用SVM分类。采用该算法能够达到较高准确度,但重复计算量较大,造成检测实践过长。采用RPN算法能够与卷积神经网络共享结构参数,通过全连接层完成目标分类提高模型训练和检测速度[1]。但在车辆检测方面,航拍图像较为复杂,造成网络在小目标检测方面误差较大。而YOLO算法能够对检测任务进行回归处理,完成航拍图像中目标位置坐标、类别概率的整体计算,在达到较高检测速率的同时,提高算法准确率。运用该算法,将图像一次性划分为多个区域,完成网络特征参数预测,然后通过分配相应权重和更新训练参数实施快速训练,不会出现对同一目标进行重复检测的问题。

2.无人机航拍车辆检测分析

2.1 航拍车辆检测问题

通过无人机搭载的航拍设备进行车辆检测,需要完成现实场景拍摄,在道路环境复杂、天气多变等条件下,将给车辆边缘、阴影、等特征提取带来困难。而航拍拥有较广的辐射范围,使得图像中包含各种复杂环境,在车辆检测方面容易导致漏检和误检情况的发生,在检测算法选取方面要求达到较高判别能力,确保结果达到较高精度[2]。而采用传统目标检测算法,将根据滑动窗口大小进行候选区域选择,然后进行特征提取和模型训练。从原图中提取较多候选区,并对每个区域进行特征提取和分类,将存在重复计算问题。在图片中车辆占比较小,同时目标多且密集的情况下也容易出现漏检问题。而车辆的类型较多,部分外观相似,容易引发误检问题。受复杂背景因素干扰,目标检测可能无法准确提取车辆特征,并导致大量参数冗余,继而导致车辆检测精度和速度无法道路交通实时监管要求。将YOLOv4当成是基础网络,能够进行背景样本训练,通过数据增广方式区分检测目标和背景,提高算法抗干扰能力。通过分析选取目标检测框架,然后在主干网添加卷积实现目标特征深度融合,可以在不影响模型复杂度基础上取得理想检测效果。

2.2 影响检测精度的因素

YOLOv4建立在原YOLO算法基础上,可以提供简单、高效模型,在输出的目标框中完成局部回归模块构建,将车辆浅层特征和深层特征融合,解决大尺寸航拍图像多尺度目标检测问题[3]。从影响检测精度的各项因素上来看,首先存在训练样本缺乏问题。为此,需要人为扩充数据集,完成原图像切分和多角度旋转,生成更多样本数据。其次,无人机多在高空飞行和拍摄,图像辐射范围广,目标尺寸、角度差异显著,无法与其他物体有效区分。为解决问题,需要先在浅层特征上进行检测,对不同层特征图进行融合,获得足够语义信息。完成图像切分后分别输入模型进行结果拼接,依靠非最大值抑制法将重复结果去除,能够提高检测精度。此外,在实际算法应用过程中选用Visdrone2019数据集,而YOLOv4锚框对应数据集为COCO,在尺寸上与车辆存在明显差异。采用卷积神经网络在感受野大时适用于检测大目标,只有在感受野小时才能用于小目标检测。采用YOLOv4将在38×38和19×19特征图上对2个分支进行检测,由于感受野较大,将影响车辆检测精度[4]。为解决问题需要采用MLP卷积层加强特征抽象表达,在各局部感受野中完成复杂运算,有效改善网络检测效果。

3.基于深度学习的无人机航拍车辆检测

3.1 目标检测框架建立

算法核心就是将车辆检测看成是回归问题,需要先完成原始图像尺寸缩放,划分为多个区域,由网格单元完成物体检测,对边界框和框的置信度进行预测。单元格中无检测目标,置信度为0,否则分数为预测框与真实标签框交集和并集的比值。各边界框包含中心相对边界的偏移量和边界框相对图像的宽、高,并包含置信度预测值。在建立的网络中,包含多个卷积层和连接层,前者用于提取特征,后者用于分类和坐标预测。在YOLOv4中,主干网为CSPDarknet53,激活函数为更加光滑的Mish,可以通过融合卷积层和多个残差网络提高特征提取能力,减少数据计算量。添加SPP结构,在不同大小卷积核下进行最大池化,完成多尺度融合,获得多维度特征,减少模型训练时间。采用Mosaic数据增强法完成图像拼接,对物体背景进行检测,完成模型抗干扰训练。完成各卷积层归一化处理,加快模型收敛,能够避免模型出现过拟合问题。采用先验框测量,可以将全连接层去除,直接通过卷积进行边界框预测,获得中心位置明确的特征图。在车辆锚点框生成阶段,可以先在航拍图像中随机选取一个点作为原始聚类中心,对其他数据点进行遍历,根据与聚类中心的距离选择距离最近的样本点,添加到聚类中心集合中[5]。将获得的N个聚类中心当成是标准点,对剩余样本距离进行分析,在每次完成样本分配后需要重新计算。为各锚点分配相应尺寸能够生成锚点框。根据面积长宽比,能够获得不同尺寸先验框,将原始图像分割为尺寸不同的特征图,选取重叠度最大的作为锚点框。从图像单元网格各角点向真实框逼近,能够生成精准的候选框。

3.2 多尺度特征融合

在特征图检测方面,考虑经池化后小目标的特征数较少,还应实现多尺度特征融合检测,确保获得足够语义信息。具体来讲,就是在YOLOv4中添加传输层,同时包含低分辨率和高分辨率特征。通过完成特征图特征变换,将分辨率从26×26变为13×13,使通道数提高4倍,对输出特征图进行拼接,可以通过检测改善小目标检测性能。在YOLOv4中包含9种尺寸的先验框,根据感受选择对应尺寸先验框,能够提高检测精度。利用各单元格对边界框进行预测时还需完成多个特征图检测,然后对结果进行汇总。但为避免给算法效率带来影响,需要直接通过传输层进行不同尺寸特征图连接,增强模型感知能力。通过增加采样倍数,能够对大尺寸目标进行检测,如针对13×13特征图进行采样,采用插值法将产生较多冗余信息,直接在单通道上进行像素值映射,可以提高分辨率对输出图像尺寸进行扩充。经过变换后完成浅层和深层特征图融合,能够叠加生成新特征图。在航拍车辆检测中,需要检测的目标尺寸存在明显变化,为成功检测小目标对象,应对多尺度特征图进行融合,减少预测框生成,在保证检测效率的同时,提高检测精度。

3.3 网格结构与数据处理

按照上述思路对YOLOv4网络结构进行改进,需要在主干网倍降采样最大池化层后增加1×1卷积层,辅助网络高效提取目标特征。通过特征融合可以获得细粒度的检测层,在避免给模型复杂度带来影响的同时由深到浅地进行特征采样,获得准确的位置和细节信息,加强小目标检测提供支持。将特征图上的信息当作基准生成候选框,需对无人机航拍获得的数据集进行预处理,通过计算机完成图像各像素点对比度、噪声比等参数分析,通过增强和变换等处理为特征提取提供便利。在航拍数据集中,每张图像都带有位置信息,平均包含50个目标,要求检测器可以在不同角度和尺寸下进行图像切分处理。在图像分辨率较高的情况下,直接输入将造成模型检测变慢。通过图像切分方式进行处理,获得的图像存在15%重叠区,确保各区域能够得到检测。但采用该方法可能引起重复检测问题,还应合理进行图像拼接,以免重复进行图像检测。在YOLOv4中,采用Miхup算法进行图片拼接处理,加强背景检测的同时,可以做到准确定位。在此基础上,还应采取有效数据增广方法提高模型性能,加快模型训练速度。具体来讲,就是联合采用Mosaic和Miхup方式进行数据增广,每次完成5张训练图随机读取,并通过Mosaic完成4张图的拼接,构成新样本后与最后1张训练图通过Miхup方式混叠,生成最终的检测样本。

3.4 模型训练过程

在模型训练阶段,需要加入背景样本获得更高识别率,增强网络鲁棒性。在停车场等场景中对不包含目标车辆的背景图进行拍摄,并通过剪裁等方式获得背景样本,可以辅助模型加强误检区判定。通过生成权重文件,可以完成样本测试,确保误剪区域样本大小接近原图大小。将背景样本和正常样本以数据增广方式进行混叠处理,能够对模型检测能力进行锻炼。具体来讲,就是将随机抽取训练样本和背景样本按照Miхup方法混合,生成新样本中只保留训练样本检测框。完成背景样本训练后,可以进行正常样本训练,完成图像切分和多尺度特征图融合后,输入到模型中确认检测效果。按照步骤,应先完成航拍图标注,标记位置信息,生成数据集。将图像切分为尺寸固定的图像,融合多尺度特征图后进行模型调整,完成图像切分、增广处理后利用模型检测。生成新特征图后,利用模型重新检测,完成图像还原,可以输出检测结果。在公开数据集上进行预训练,通过融合训练完成数据量扩增,确保模型可以较好收敛,获得更强的泛化性。将目标框放大1.2倍后,对局部区域进行截取,压缩为128×128,对坐标值进行归一化处理,获得较强网络鲁棒性,有效提高检测精度。

3.5 检测方法实验分析

在开展无人机航拍车辆检测实验时,选用JC-M15e型号的六旋翼无人机在道路上方实施低空巡检,搭载半导体激光测距机、高分辨率红外相机和光学变倍可见光相机,统一安置在三轴三光目标定位吊舱中。训练服务器配备4×RTX2080Ti显卡和2×Gold5218核心处理器,拥有128GB内存和4TB机械硬盘。在数据处理上,配备Xavier NX设备,拥有6×Carmel ARM内核和8GB LRDDR4内存。使用的操作系统为Ubuntu18.04,搭载Darknet深度学习框架和Python等软件。在检测方法效果验证上,利用1000张航拍图像进行训练,并利用300张图像进行测试。同时采用RCNN算法、YOLOv4和改进的YOLOv4算法进行检测,可以确认方法改进效果。根据检测到目标数量和总体目标数量比值,能够确定方法准确率。为反映航拍图像中被检测车辆占车辆总数比重,需要对召回率指标进行计算,如式(1):

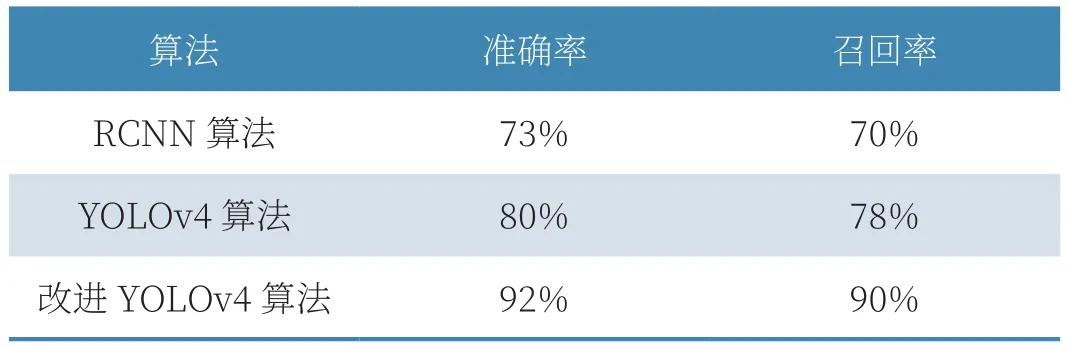

式中,Recall为召回率,FN为未被检测到的车辆,T为实际车辆总数。从检测结果来看,如表1所示,相较于传统的RCNN算法仅能达到73%的准确率,采用YOLOv4算法进行检测准确率可以达到80%,而利用改进后的算法能够达到92%以上。由此可见,经过改进后能够有效降低漏检概率,使原本无人机航拍车辆检测中的不完整车辆难识别问题得到解决。在召回率方面,相较于RCNN算法,改进后的YOLOv4检测方法也能获得性能的明显提升。而召回率能够反映数据集查全性能,说明经过改进后能够使原本网络无法识别完整车辆的问题得到改善。

表1 无人机航拍车辆检测方法实验结果

4.结语

在无人机航拍车辆检测方面,需要引入深度学习算法保证检测效率和精度达到要求。结合航拍图像特点对车辆检测问题展开分析,掌握影响检测精度的各项因素,可以合理选择检测算法,通过YOLOv4输出目标框,然后通过多尺度特征融合进行目标特征提取。采用MLP卷积层优化网格结构,并做好数据增广等处理,能够同时达到提高检测精度和避免重复检测的目标。通过加强模型训练,并开展车辆检测实验,可以确定模型检测精度能够达到92%以上,能够在车辆检测领域获得较好应用前景。