基于图深度学习的金融文本多标签分类算法

2022-04-18金雨澄王清钦苗仲辰林越峰项雅丽

金雨澄,王清钦,高 剑,苗仲辰,林越峰,项雅丽,熊 贇

(1.复旦大学 计算机科学技术学院,上海 210438;2.上海市数据科学重点实验室,上海 200438;3.上海金融期货信息技术有限公司,上海 200120)

0 概述

在移动互联网时代,金融新闻资讯成为人们高效获取市场情报的主要途径。然而随着新闻数量的爆发式增长,如何准确地对金融文本进行分类用以精准推荐或辅助决策,成为亟待解决的问题。由于单条新闻文本常常同多个标签相关联,因此多标签文本分类问题受到广泛关注[1-3]。

二元关联是解决多标签问题最常用的思路[1-3]。二元关联把多标签分类转化为多个二分类问题[4],每次针对一个标签类别开展,即每次判断样本是否属于某个类别。不同的标签与文本中不同的特征有关。文献[1]提出的CAML算法使用标签注意力机制为每个二分类问题进行特征提取。然而,CAML使用固定窗口大小的卷积网络融入上下文信息,导致模型只能提取固定长度的局部短语信息。文献[2-3]提出的MSATT-KG和BiGRULWAN 算法分别使用密集连接卷积层和双向门控循环网络代替一维卷积层,从而关注到文本中不同粒度的上下文信息。文献[5]提出的ZACNN 算法在CAML 的基础上进一步融入标签语义特征等先验知识,以提升模型在小样本场景下的性能表现。然而,这些工作都忽略了标签之间的复杂依赖关系,二元关联中多个二分类问题并不是相互独立的。

图深度学习[5-7]通过深度网络刻画了图节点之间的关联,其在蛋白质分子属性推断[8]、交通流量预测[9]、金融欺诈检测[10]、新闻文本分类[11]等领域得到了成功应用。在多标签文本分类中,也有一些工作通过图深度学习刻画了标签层级结构。文献[12-13]分别提出使用Tree-LSTM(Tree-structured Long Short Term Memory)网络和图卷积神经网络(Graph Convolution Network,GCN)对标签的层级结构和标签语义描述进行编码表示。上述方法都依赖于预先定义的标签层级结构和丰富的标签语义信息。然而,在金融领域,这样的标签结构信息获取依赖于专业领域人员,对标签划分层级结构的代价很大,并且由于尾部标签出现频次较低,尾部标签对应的二分类问题中正负样本数量严重失衡,但上述工作难以直接处理这种数据的不均衡性问题。

本文通过建模金融文本多标签分类中标签之间的相关性,提出基于图深度学习的金融文本多标签分类算法,在不依赖于标签层级结构等先验知识的前提下,学习语义信息以建模标签之间的复杂依赖关系。该算法根据原始数据集中的标签分布构建标签关联图,对新闻文本使用双向门控循环网络进行上下文语义嵌入,并将通过标签注意力机制得到的文本特征表示作为图上对应标签节点的属性信息,进一步使用图神经网络融合标签之间的关联与文本信息得到新闻的特征表征,利用多个线性层预测新闻文本在标签空间中的概率分布。同时,为解决二元关联中尾部标签正负样本严重不均衡的问题,选用非对称损失函数[14]作为优化目标。

1 问题定义

给定一段新闻文本,经过分词、去除停用词等处理,将原始输入文本转换为字符序列d=[w1,w2,…,wm],其中:wi表示输入序列中的第i个单词;m表示输入文本长度。标签空间被定义为集合{l1,l2,…,lL},其中:L代表标签空间中的标签数量。每个新闻文本可能属于一个或多个标签,表示为标签集合C。本文多标签文本分类任务的目标是学习一个映射函数f(·),将字符序列映射为一个标签集合C,即f(d)=C,0 ≤|C| ≤L。具体地,输入新闻样本d,对于每个标签li,模型输出该样本属于标签li的概率,最终根据输入样本关于L个标签的概率构造输出标签集合C。

2 基于图深度学习的多标签分类算法

本节将详细介绍本文提出的基于图深度学习的多标签文本分类模型FMLG,其中所使用的重要符号定义如表1 所示。

表1 重要符号定义Table 1 Definition of important symbols

2.1 模型框架

图1 展示了FMLG 模型的基本框架。输入新闻文本d。首先,将原始字符序列转换为嵌入表示,并进一步表示为融合上下文信息的语义嵌入向量,由于不同标签会侧重不同的文本特征,因此多标签注意力网络使用多个注意力头提取标签相关的文本特征;然后,为了捕捉标签之间的依赖关系并学习更丰富的语义信息,在构建标签关联图的基础上,模型使用门控图神经网络实现标签间的语义特征交互;最后,多个线性层被用于预测标签的概率分布。

图1 FMLG 模型框架Fig.1 Framework of FMLG model

2.2 上下文语义嵌入

JOHNSON 等[15]指出,预训 练的词嵌入 表示可以使模型训练过程更加稳定,因此,使用word2vec[16]进行嵌入表示学习。单词序列经过嵌入表示后得到向量序列为了在嵌入表示中融入上下文信息,进一步使用双向门控循环网络对向量序列H进行编码,得到一系列文本的上下文语义嵌入表示

2.3 多标签注意力网络

由于文本中常常包含大量冗余信息且每个标签侧重不同角度的文本特征,因此FMLG 使用标签注意力{q1,q2,…,qL}进行特征提取,对每个注意力向量有qi∈注意力权重计算方式如下:

其中:αij代表文本中第j个字符与标签li的相关程度;fai代表同标签li相关的文本向量表示。最终可以得到文本的向量表示

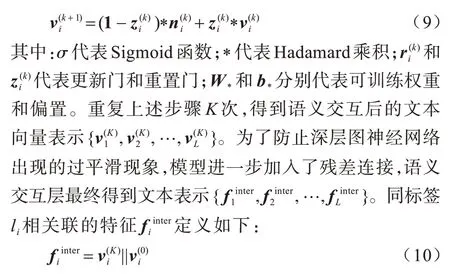

2.4 图语义交互层

尽管FMLG 模型利用了标签注意力来提取与各个标签相关的文本特征,但这样的做法只是在标签与文本之间建立联系,仍然无法捕捉标签之间的关系。本文先利用统计关系对标签进行构图,再通过门控图神经网络[17]对其进行特征交互。这不仅可以在模型中显式地融入标签之间的关联,而且其中的门控机制也可以自适应地捕捉到更丰富的相关文本特征。

本文模型首先根据训练集构建标签关联图G,图G为有向带权图,其中节点集V由数据集中的所有标签组成,边权Aij被定义为标签li和lj之间的条件概率,条件概率通过训练数据集估算得到,即:

其中:I为指示函数。给定图G,模型使用门控图神经网络进行特征交互。图上节点的初始向量表示设置为注意力层提取得到的特征,即首先通过图上的信息流动从邻节点聚合信息:

然而从邻节点聚合到的信息可能存在噪声,因此模型使用门控机制自适应选择有效信息,信息聚合与传递的具体过程如下:

其中:||代表拼接操作。

最终,对于每个类别,模型训练一个二分类器:

2.5 损失函数

由于大部分标签只在少数样本中出现,因此采用二元关联解决多标签分类会导致二分类问题中正负样本比例的严重失衡。本文采用非对称损失函数(Asymmetric Loss)[14]处理非均衡分布问题。非对称损失通过权重衰减因子和置信度阈值平衡正负样本在损失中的占比。预测概率同真实概率pi之间的非对称损失函数Lasy计算如下:

其中:L+和L-分别代表样本作为正类和负类时带来的损失。权重衰减因子γ用于为易分负样本的损失赋予更小的权重,置信度阈值m用于忽略预测置信度较高负样本带来(<m)的损失。上述2 个参数可以减少负样本在损失中的占比,使模型更注重正样本产生的优化信息。

3 实验与结果分析

本节通过实验验证FMLG 模型的有效性,并分析讨论实验中的场景数据以及相关的参数设置。

3.1 数据集

实验使用的金融新闻数据集中共包含84 707 条中文金融新闻文本,文本的平均长度为598 个中文字符。每条文本由新闻标题和内容两部分组成。数据集中的每条文本都被打上多个金融类话题标签,共包含115 个标签。数据集中每条文本平均被打上1.5 个标签,35%的文本标签数量大于1,13%的标签在数据集中出现次数少于100 次。

3.2 对比算法

下面介绍本文采用的对比算法:

1)CAML[1]。由于文本中存在大量冗余信息且不同标签对应着不同的文本特征,因此该方法提出在卷积神经网络的基础上,进一步使用注意力机制为每个标签进行特征提取。

2)BiGRU-LWAN[3]。由于卷积神经网络只能提取局部信息,而双向GRU 可以捕捉长距离依赖,因此该方法将CAML 的卷积神经网络替换为双向GRU。BiGRU-LWAN 在多个多标签文本分类数据集上都取得了极佳的效果,是一个极具竞争力的对比算法。

3)ZACNN[5]。RIOS 等提出在CAML 中融入标签的语义信息以进一步提升模型在尾部低频标签上的性能表现。

3.3 实验设置

实验预处理阶段使用jieba(https://github.com/fxsjy/jieba)对文本进行分词,并取文档频率大于4 次的字符组成词表。预训练嵌入表示维度设置为100。随机划分70%、15%、15%的数据分别作为训练集,测试集和验证集,并将在训练集中出现次数少于100 次的标签视为尾部少样本标签。

对于本文提出的FMLG 算法,经双向GRU 编码后的特征维度dc,门控图神经网络隐藏层维度都设置为300。非对称损失函数中的γ和m分别被设置为2 和0.05。对于CAML 算法,CNN 的卷积核大小设置为3,特征维度dc设置为100。BiGRU-LWAN 的特征维度设置为300。ZACNN 的卷积核大小设置为3。

为了使得模型有着更好的泛化能力,实验中对于上述所有模型的词嵌入层向量表示和注意力系数使用概率为0.2 的Dropout[18]。训练阶段优化器选用Adam[19],学习率设置为10-4,ZACNN 训练轮数设为30 轮,其余模型设置为10 轮。本文实验中选择广泛使用的评价指标精度、召回率和F1 值来评估模型的性能对比,并基于验证集选择最优的模型进行测试。

3.4 实验结果

在FMLG 模型上分别进行2 组实验。FMLG/BCE 和FMLG/ASL 分别表示使用交叉熵和非对称损失函数训练的FMLG 模型。表2、表3 展示了模型在所有标签和尾部标签上的性能表现,其中,加粗数据表示最优结果。

表2 模型在所有标签上的性能表现Table 2 Model performance on all labels %

表3 模型在尾部标签上的性能表现Table 3 Model performance on tail labels %

从表2、表3 所列出的实验数据可以看出:

1)ZACNN 模型效果最差。ZACNN 中标签的嵌入表示通过标签名称中字符的嵌入表示取平均得到,但是由于标签名称同对应文本特征存在较大的语义鸿沟,因此导致模型表达能力欠缺。

2)BIGRU-LWAN 效果优于CAML,表明卷积网络只能提取固定长度的局部信息的特点具有局限性,双向GRU 可以更好地建模上下文之间的长距离依赖。

3)相比BIGRU-LWAN,FMLG/BCE 取得了更好的结果,且在尾部标签上的提升更为明显,这表明显式地建模标签之间的关联能够提升模型性能。

4)对比FMLG/BCE 和FMLG/ASL 可以发现,使用非对称损失函数能够大幅提升模型在正负样本失衡条件下的召回率与F1 值。

为了更加直观,在表4 中进一步列出部分测试样例预测结果,其中文本中的下划线部分代表新闻中的重要信息。从中可以发现,相比性能最优的对比算法BIGRU-LWAN 算法,FMLG 可以预测出更为完整的标签集合。以样例1 为例,由于标签“A 股策略”和“研判优选”在训练集中存在共现关系,它们在标签关联图中存在连边,FMLG 可以通过图语义交互层学习两者之间的依赖关系,从而实现更为准确完整的预测输出。

表4 部分测试样例预测结果Table 4 Prediction results of some test samples

3.5 消融实验

为表明语义交互层带来的提升不完全是由于更深层的网络结构导致,实验中还将图神经网络中的邻接矩阵替换为单位阵。从表5 实验结果可以发现,使用单位阵代替标签关联图会导致性能下降。这表明在模型中通过构建标签关联图的方式显式建模标签之间的关联具有重要意义。

表5 不同邻接矩阵对实验结果的影响Table 5 Influence of adjacency matrix to experimental result %

此外,还通过实验探究不同图神经网络结构对实验结果的影响,实验结果见表6。可以发现,门控图神经网络取得了更好的效果,进一步验证了从邻节点聚合到的信息往往存在噪声,门控机制可以从中自适应选择有效信息。

表6 不同图神经网络对实验结果的影响Table 6 Influence of different graph neural networks to experimental result %

4 结束语

本文提出基于图深度学习的多标签文本分类算法FMLG,通过标签统计信息构建关联图,并利用门控图神经网络挖掘标签之间的关系。在与各个算法的对比实验中,FMLG 在所有标签和尾部标签的宏观F1 值上最高取得了2.0%和4.5%的提升,这表明显式建模标签之间的关系可以大幅提升模型的泛化能力。为了进一步解决二元关联中正负样本不均衡的问题,FMLG 使用非对称损失函数作为优化目标。相比现有算法,FMLG 在所有标签和尾部标签宏观F1值上最高取得了3.1%和6.9%的提升。由于现实场景中标签数量较多,数据集中的样本常常只被打上部分标签,使用存在标签缺失的样本训练模型会对性能造成较大的负面影响。后续将在本文工作的基础上使用PU learning[21-22](Positive-Unlabelled learning)进一步模型在标签缺失场景下的鲁棒性。