“双碳”背景下新型数据中心数据存储绿色节能技术

2022-03-30张明王旭东翟爽

张明 王旭东 翟爽

(华为技术有限公司,深圳 518129)

0 引言

纵观全球,新一轮的科技革命和产业变革正在全方位地改变着社会生产生活,一个以数据服务能力为基础的,万物感知、万物互联、万物智能的数字经济世界正在加速到来。实施数据战略、积累数据资源、保障数据安全、做大做强数据产业,已经成为全球主要国家共同的战略选择。2020年4月,中共中央、国务院发布《关于构建更加完善的要素市场化配置体制机制的意见》[1],首次明确“数据成为继土地、劳动力、资本和技术之外的第五大生产要素”。随着各行业数字化转型升级进度加快,全社会数据总量呈爆发式增长,4K/8K、AI、HPDA、5G、IoT、大数据,催生海量多样数据。同时,2025年是“十四五”规划收官之年,全球数据量将突破175 ZB,中国数据圈将增至48.6 ZB,占全球27%,成为全球最大数据圈。随着移动互联网、物联网、云计算产业的深入发展,大数据国家战略加速落地,我国数据中心数量和机架规模高速增长,超大型、大型数据中心也逐渐成为建设的主流模式,金融等行业的数据中心建设进入快速扩张期。

由于数据中心基础设施具有高耗能以及7×24×365不间断服务的特性,是各地的“用电大户”,数据存储能耗过高问题已成为数据中心面临的巨大挑战。

1 新型数据中心的数据存储能耗主要面临三大挑战

1.1 数据爆发式增长,数据中心的大规模建设,资源利用率低,碳排放显著增加

数字经济本身是建立在电力的基础上的。云、区块链、数据中心等基础设施都是耗电大户。根据《中国数据中心可再生能源应用发展报告(2020)》,2019年我国数据中心行业耗电总量约为600亿~700亿千瓦时,占全国全社会用电量的0.8%~1%。预计到2030年,我国数据中心机架总规模将在2019年基础上增加1~2倍,能源消耗量也将翻一番,达到社会总用电量的1.5%~2%。高能耗除了带来高成本,还带来了高碳排,2018年全球数据中心的碳排放量已与航空业相当,我国数据中心总碳排放量则接近1亿吨二氧化碳,相当于2 100万辆汽车的排放量[2]。

1.2 数据存储的HDD介质能耗高,全闪半导体介质部署率低

按照国家对数据中心PUE高标准建设要求,从数据中心IT设施的能耗占比维度看,数据存储设施的占比大约在35%,成为双碳目标达成的主要矛盾之一。数据存储有83%的能耗来自于存储介质,目前主流的存储介质主要包括HDD机械磁盘介质和基于SSD的半导体闪存介质。在全负荷情况下,SSD固态硬盘功耗基本小于3 W,而HDD磁盘功耗基本大于6 W。在静态无负荷情况下,SSD的功耗约0.05~1.3 W,但是机械磁盘功耗基本大于4 W。可见,HDD机械硬盘的能耗大于SSD盘。在相同容量下,固态盘相比机械硬盘的能耗降低70%,空间占用节省50%。

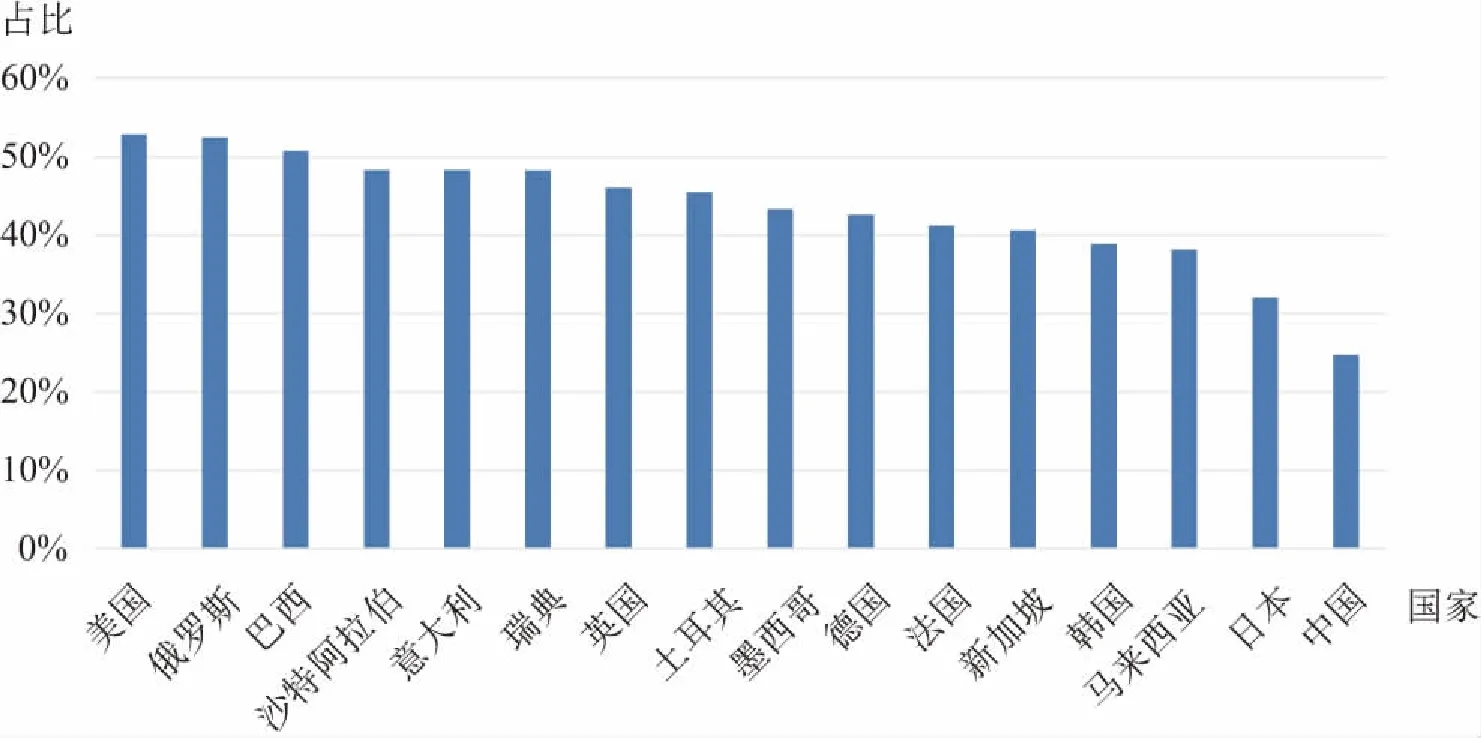

通过对代表先进生产力的全闪存存储和代表传统生产力的机械存储投资比例进行比较,可以看出,2020年中国全闪存容量占比为25%,而美国该项占比为53%(见图1)。我国的数据中心全闪半导体介质容量占比落后于美国。

图1 闪存半导体介质容量占比统计[3]

1.3 数据存取流通效率低,能耗增加

数据和计算是数字经济的两个核心要素。在数据和计算之间通过复杂的存储层次来均衡带宽、延迟、容量、成本等因素,尽可能让计算芯片对数据能做到“随用随取”,这在物理上是不可能实现的。将数据从生产侧或存储侧搬运到计算节点上也需要时间和能耗。为了把数据搬运到完成布尔逻辑的计算单元,已经消耗了90%以上的能耗。数据中心国家枢纽节点建设过程需要评估海量数据处理和数据存储难题,尤其是双碳背景下,亟需灵活数据基础设施架构来支撑我国下一代大规模新型数据中心的发展。

2 双碳背景下,新型数据中心存储绿色节能技术

当前,控制能耗水平、建设绿色数据中心成为我国数字经济发展的重要内容。2020年,国家发展和改革委员会、中央网信办、工业和信息化部、国家能源局4部门联合印发《关于加快构建全国一体化大数据中心协同创新体系的指导意见》[4];2021年,《全国一体化大数据中心协同创新体系算力枢纽实施方案》提出,“进一步降低数据中心用电成本,加快推广应用先进节能技术,推动绿色数据中心建设,加快数据中心节能和绿色化改造”[5];2021年,国务院印发《关于加快建立健全绿色低碳循环发展经济体系的指导意见》,提出“做好大中型数据中心、网络机房绿色建设和改造”[6],以确保实现碳达峰、碳中和。2021年,工业和信息化部发布了《新型数据中心发展三年行动计划(2021—2023年)》,在“绿色低碳发展行动”重点任务中明确提出“加快先进绿色技术产品应用”[7]。

2.1 优化数据中心布局,建设存算均衡、架构先进、算法高效的数据中心,提高数据利用效率

2.1.1 存算均衡:优化数据中心存算比,向存算并进方向发展,提高资源利用率,降低能耗

数据中心计算和存储的能力需要相互匹配,才能有效降低能耗,提高效率。业内通常是采用每秒浮点运算次数(Floating-point Operations Per Second,Flops)或者调整后的峰值性能(Adjusted Peak Performance,APP)定义算力,算力的使用率可以通过CPU的使用率进行衡量,而定义存储能力是采用存储容量,容量的大小决定了保存数据量的多少,数据量决定了算力的使用率。经过调研发现,当前全球数据中心的CPU利用率并不高,比如谷歌数据中心的CPU利用率最高约为75%,而中国某大型电商的CPU利用率约为45%。可见,即使在虚拟化技术非常流行的今天,数据中心的算力利用率还有较大的提升空间。

数据越多,算力利用率越高,存算并进、存算均衡可大幅降低不必要成本。通过提高数据中心资源利用率,减少新建数据中心数量可以达到节能降耗目标。

2.1.2 架构节能:通过存算分离架构,利用数据高密存储及纠删码技术,提高数据存储效率

受限于散热和空间限制,普通的通用型服务器配备硬盘的数量有限,通常为1U10盘、2U24盘、4U36盘。而专门设计的高密存储型节点,能做到1U32盘、2U36盘、5U80盘、4U80盘、5U120盘,密度达到传统存储服务器的2~2.6倍,结合存算分离架构,相对使用通用型服务器,减少了节点CPU、内存及配套交换机,同等容量下节约能耗 10%~30%。

在大数据分析场景,采用存算分离架构后,还可以利用数据纠删码(Erasure Code, EC)技术替代三副本数据,把磁盘利用率从33%提升到91%,减少磁盘空间占用,节约能耗。

2.1.3 算法节能:利用数据重删和压缩技术,提高数据利用效率;多协议访问技术,提高数据访问效率

借助闪存介质带来的100倍性能提升,利用数据重删压缩技术,目前业界已经能够在数据库、桌面云、虚拟机等业务场景实现2~3.6的数据缩减率(重删压缩前数据总量/重删压缩后数据总量),相当于同样的存储空间能够储存2~3.6倍的数据,耗能节约50%以上。

数据重删技术是通过利用定长重删、变长重删、相似重删算法来检查数据块,把相同数据删除的技术。数据压缩、压紧技术是通过数据压缩、压紧算法把定长的数据块优化数据存储布局,节约存储空间。多协议互通技术的核心能力是通过保存一种类型的数据让多种协议访问来实现,当前数据中心存在同一份数据需要在多套存储系统中存储多份、浪费存储空间的痛点,通过多协议互通技术可以降低数据中心数据量,提高访问效率。从新型数据中心建设角度看,节省了数据中心IT设施的投资数量,可以达到节能降碳的效果。

综合评估如上数据节能技术,为了应对数据的爆炸式增长,支撑企业更好地进行价值变现,新型数据中心大规模普及全闪存及数据高密存储技术可节约数据存储耗能,使用同等电力情况下存储更多数据,可更好地应对数字经济时代高速增长的数据存储需求。

2.2 硅进磁退,大力建设全闪数据中心,提高数据中心全闪存容量占比,降低能耗

针对如何解决数据存储节能问题,进一步推动新型数据中心整体低碳化发展,业界提出了一种“全闪存数据中心”解决方案。“全闪存数据中心”的核心观点是介质全闪存化,即逐步提升数据中心存储介质闪存化比例,最终实现全闪存化。加速数据中心向“磁退硅进”战略方向演进。

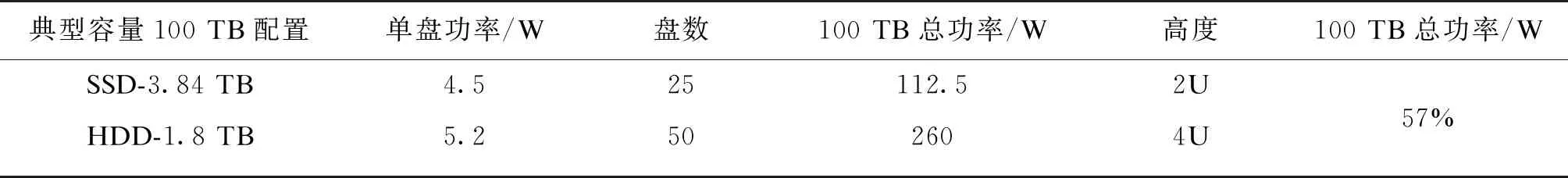

全闪半导体介质有高密度、高可靠、低延迟、低能耗等特点。从数据全生命周期角度来说,硬件能力的提升给数据流通带来巨大的变化,存储介质由传统磁介质转向闪存介质,机械硬盘转向固态盘。随着固态盘的快速发展,数据访问固态盘比机械硬盘速度提升100倍,吞吐量提升100倍,单盘的IOPS提升1000倍以上;随着存储通信协议的发展,存储介质变化的效率和网络带宽提升的作用得以充分发挥,这些变化促使了计算机系统处理能力的大幅提升,优化了数据中心算力与存力的基础能力结构,加速了数据资源的快速流通。同等容量下典型配置存储系统和典型机架配置的能耗最大可节省57%(见表1)。

表1 同等容量下不同存储介质能耗对比

如果数据中心的闪存比例按照50%建设,那么到2025年将累计节约750亿千瓦时耗能,相当于4个葛洲坝的(年发电量157亿千瓦时)发电量,新建数据中心的能耗将下降21%。通过大规模部署全闪存可为企业带来诸多价值,一是推动数字经济快速高效发展。全闪存半导体介质性能比HDD高,有利于企业核心业务和增值业务的快速发展。二是促进数字经济绿色持续发展,可以大大降低数据中心能耗,助力企业实现绿色节能和可持续发展。

2.3 利用高密液冷超融合数据基础设施,降低数据中心能耗

全球数据中心正在从“以计算为中心”逐步转向“以数据为中心”。以数据为中心的绿色节能类数据基础设施,核心是要解决海量数据绿色存储和快速处理问题;要解决跨数据中心海量数据调度、生态开放多云对接等问题。另外,国家枢纽节点大于3 000的大型数据中心建设时,IT管理运维难度指数级增加,以整机柜形态交付是未来数据中心建设的关键需求。高密液冷超融合集群、计算液冷整柜集群,配合绿色节能大规模模块化能基设备,共同支撑中大型数据中心绿色节能建设。

高密液冷超融合数据基础设施主要解决中大型数据中心绿色节能问题,具备整柜液冷交付、大规模线性扩展、高密计算存储、高通量数据处理、跨域数据调度、多云对接等特性。未来2~3年,高密液冷超融合集群将面向绿色节能打造全面液冷架构,开创存储介质高密液冷设计,面向中大型数据中心打造PUE1.1超融合解决方案,将算力、SSD、HDD全面池化,实现高通量数据处理能力,在同等可得容量与性能下,节省5倍功耗、10倍空间。

传统液冷整柜主要是风液混合部署,以服务器冷板液冷为主,部分场景下采用浸没式液冷技术。华为下一代高密液冷超融合设计基于全栈高密液冷,全面支持计算液冷、存储液冷,使能数据中心能耗降低3倍,全面提升数据中心绿色节能水平。数据存储密度维度,单U可容纳24块3.5寸硬盘,是通用高密存储服务器的2.67倍,同等容量下机柜空间占用下降62.5%,高密数据处理和存储带来数据中心空间、功耗、制冷、运维等环节综合成本的大幅降低。

高密液冷超融合集群以计算、存储、虚拟化为底座,融合网络、安全等技术,提供大数据、HPDA等数据密集型场景下跨域海量数据调度、高通量数据处理能力,支撑新型数据中心东数(东部产生数据、实时分析、AI推理)西算/存(西部离线分析、AI训练数据)。同时,以生态开放为首要目标,提供南北向标准的API接口,实现数据基础设施与异构多云连接与融合,通过一池对接多云,避免多云导致的数据存储管理孤岛问题,实现跨数据中心统一融合资源池。另外,高密液冷超融合集群、计算液冷整柜集群、配合绿色节能大规模模块化能基设备,提升数据中心交付效率,缩短上线周期,有效降低TCO。数据存储作为数据的核心承载底座,需高性能、高扩展、高性价比、高效能、高可靠的灵活数据基础设施架构来支撑未来数据中心的发展。

3 “全闪存数据中心”节能案例

目前,“全闪存数据中心”已在多个行业开启广泛实践。在金融行业,越来越多的企业在IT系统中选择全闪存存储来替换机械硬盘存储设备:浦发银行率先开启“全闪存数据中心”改革实践,在全行各个数据中心开展闪存化改造,基于AI算法主学习银行业务的数据路径,提高数据预读命中率;智能重删压缩大大降低存储及电力资源消耗;三层智能管理系统实现数据全生命周期管理,降低运维成本。整体实现50%的机柜空间缩减、72%的电费缩减,66%的OPEX缩减。在医疗行业,北京同仁医院率先开启“全闪存数据中心”实践,南区HIS、LIS、PACS等核心业务系统全部替换为全闪存设备,实现了系统性能飞跃和7×24 h不中断运行,大幅降低医院IT系统整体能耗。

4 结束语

在面对世界百年未有之大变局和不断做强做优做大我国数字经济的背景下,国家明确要求打造集约高效、经济适用、智能绿色、安全可靠的现代化数字基础设施体系。作为新基建的重要组成部分,新型数据中心迫切需要推动绿色节能发展。未来2~3年,数据中心存储将在介质升级、存算均衡架构、数据重删压缩算法、高密液冷超融合集群等领域加强技术、产品和服务协同,全面发力,为打造数字经济发展新优势,为建设数字中国奠定坚实的基础。