结合注意力和纹理特征增强的行人再识别

2022-03-13李杰

李 杰

中国民航大学 信息网络中心,天津300300

行人再识别旨在识别跨越不同监控摄像机下的同一行人目标,可广泛应用于视频监控、智能安防等领域中,如可疑人员的追踪、特定人群的轨迹分析等。但由于不同摄像机下不同时间的图像分辨率差异、光照影响、姿态和视角多样等问题,行人再识别仍然是一个具有较高研究价值和挑战性的问题。

为了克服上述问题,行人再识别分别从两个不同的方向发展:提取鲁棒性的行人特征和学习合适的距离度量。近年来随着深度学习的蓬勃发展,基于卷积神经网络(convolutional neural networks,CNN)的行人再识别方法逐步取代传统的手工特征识别方法成为主流。在科研工作者的不断努力探索下,行人再识别再次从通过CNN 提取行人特征应用到单一行人再识别任务开始,逐步发展为结合属性等的多任务行人再识别阶段。其中后者的代表工作:2019年Lin 等人在Market-1501这一主流行人再识别数据集上添加了行人的属性标签,并设计实现了结合属性特征的多任务识别模型(attribute person recognition,APR),可有效提高行人再识别的精度。Schumann等人分别设计了MultiView Attribute 和Attribute-Complementary Re-id Network 用于属性识别和行人再识别。随后,Liu 等人通过在Resnet50的基础上级联Densenet101网络能够更细致地获取行人特征,进而提高行人再识别的精度。但这些工作或者没有考虑行人属性包含信息的差异性,或者采用多网络模型结合,导致训练相对复杂,应用相对较难。

针对这些问题,本文提出了基于空间注意力和纹理特征增强的多任务行人再识别算法。主要包括以下四方面:

(1)设计属性识别网络的空间注意力模块,使网络更注重与行人属性相关的潜在图像区域,同时抑制与行人无关的背景区域的影响,实现属性特征挖掘从而提高行人属性识别准确性。

(2)设计行人再识别网络的纹理特征增强模块,通过结合不同空间级别的全局和局部行人表观特征,融合轮廓性和显著性特征来提高行人再识别准确性。

(3)提出多任务加权损失函数,使属性识别网络和行人再识别网络有效联合,并将属性特征作为辅助信息融入行人特征,避免由属性异质性造成行人再识别精度损失。

(4)本文算法在Market-1501和DukeMTMC-reID两大公开行人再识别数据集的平均精度分别可以达到81.1%和70.1%。

1 基本原理

1.1 整体框架

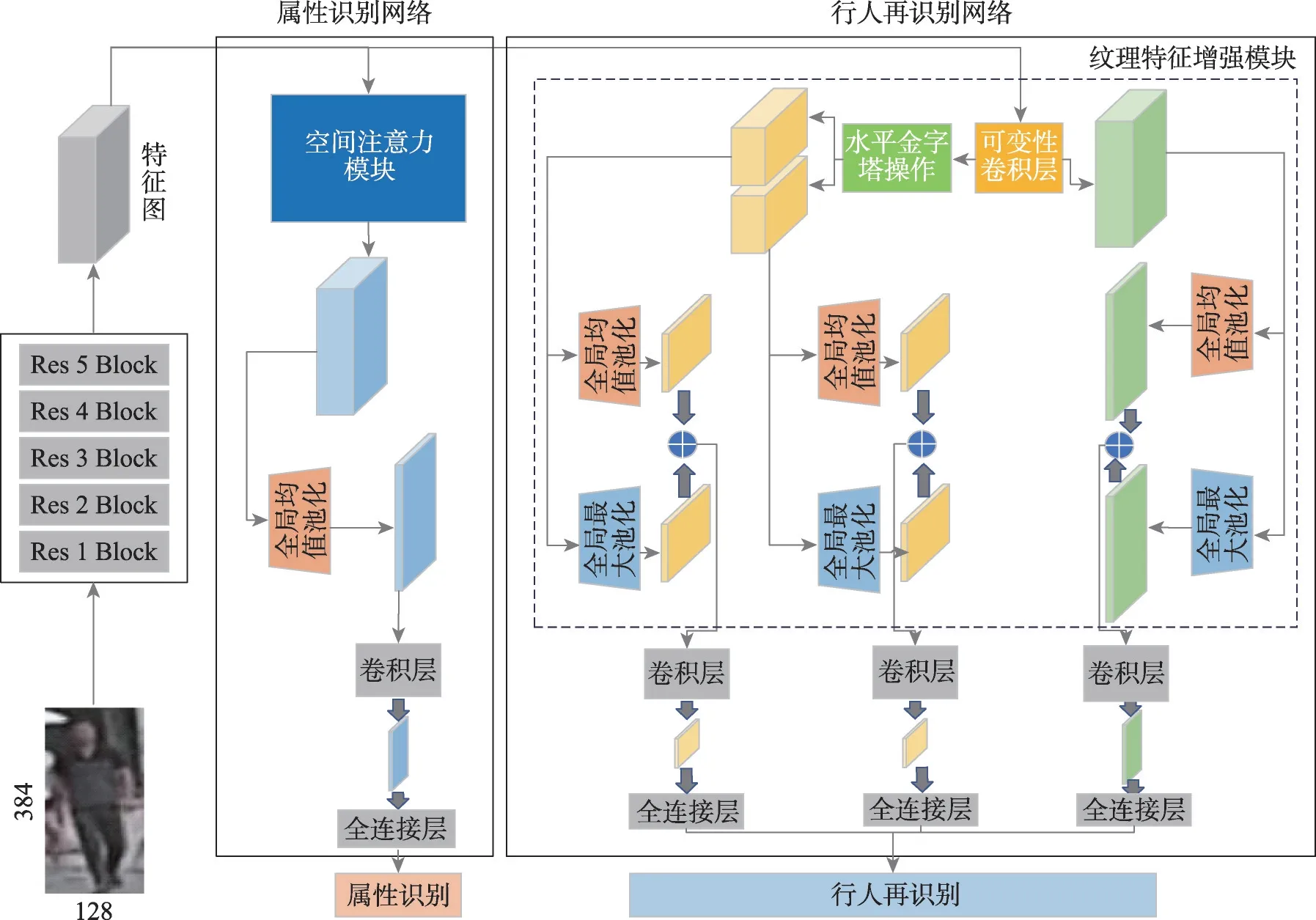

本文方法的整体框架如图1 所示,主要分为三部分:第一部分为采用ResNet50 作为骨干网络提取特征;第二、三部分分别为基于空间注意力的属性识别网络和纹理特征增强的行人再识别网络。引入属性识别网络的原因在于,包括性别、年龄等属性特征与行人特征在一定程度上是紧密相连且互为补充的,可有效提高行人再识别的准确率。在属性识别网络中添加空间注意力模块是为了抑制无关背景区域,使网络本身更注重于与特定属性相关的,对识别更有利的潜在图像区域。行人再识别网络中的纹理特征增强模块通过融合映射身体结构分布的全局和局部特征,弥补因遮挡或姿态变换等特征不全情况下识别率低的短板。图1 中“+”表示像素值点积的特征融合方式。

图1 整体框架Fig.1 Overall structure

1.2 基于空间注意力的属性识别网络

属性识别网络的引入是为了从行人图像中学习更有判别性的属性特征描述。特定的行人属性可以从图像中的一个甚至多个区域获得。为了更好地学习这些属性特征,需要卷积神经网络更注重于这些相对应的区域。这些与属性特征相关的区域不一定与标注的目标区域相对应。与此同时,行人各个属性之间也是存在语义相关的,某个属性的存在与否有助于推理其他属性的存在与否。与此同时,在文献[11]中,通过实验证明了采用注意力模块使得网络能聚焦于更与行人相关的属性特征区域,注意力分配概率分布更加偏向于关联性强的属性,以及在一定程度上减弱了网络对行人无关的背景区域的关注。例如,女性和长发同时出现的概率高,而手提一个包和背一个双肩包同时出现的概率则低得多。这些特点有助于属性识别并提高行人识别的精度。

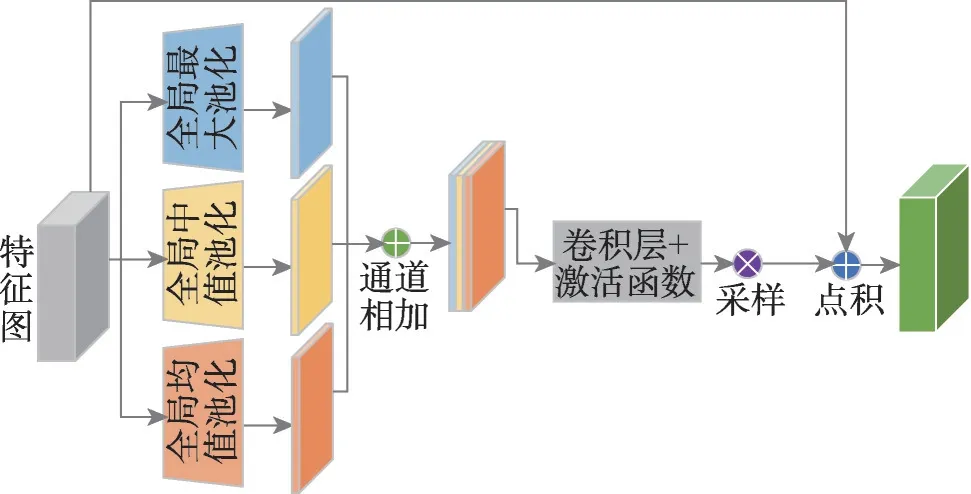

为了使网络更加关注与属性相关的图像区域以及挖掘属性特性的相关性,本文提出了基于空间注意力的属性识别网络。其中空间注意力模块的结构图如图2 所示。空间注意力模块包括全局最大池化、全局中值池化和全局均值池化三个池化层,一个通道相加的特征融合操作,一个普通卷积层和激活函数,一个统一特征的采样操作和像素值点积的特征融合操作。空间注意力模块可用式(1)表示:

图2 空间注意力模块结构图Fig.2 Structure diagram of spatial attention module

其中,代表输入特征图;、、分别代表全局均值、中值和最大池化;、分别代表像素值点积和通道相加的特征融合方式;代表普通卷积,代表sigmod 激活函数,代表双线性差值的上采样操作。该空间注意力模块,采用包括全局、均值和中值的多层次池化来获得空间上对行人更有效的显著属性特征,利用通道相加的特征融合操作来将多层次池化获得的有效特征在通道层面实现融合,设计的卷积层和激活函数构成的激励将融合新特征的权重进行再次优化分配,最终再通过采样和引入原始特征的点积融合操作来进一步关注更具有判别性的、与行人相关的属性特征。这样的属性挖掘方式不仅能提高重要属性所对应区域的权重,还能同时降低背景等对应图像特征的权重,进而提高了属性识别网络的性能。

1.3 纹理特征增强的行人再识别网络

行人再识别的最终环节在于特征的相似度比较。而特征的有效获取是相似度比较的基础。引入的纹理特征增强模块能够更好地提取全局和局部行人特征,进而实现快速准确的行人特征匹配。其中纹理特征增强模块的结构图见图1 中的虚线框部分。其中全局特征是指行人的整体特征,包括颜色纹理等,是相关性较强的特征,在图像遮挡的情况下表达能力较差。而与之相对的局部特征,包括边缘、角点等,特征稳定,特征相关性稍弱,遮挡时仍能通过部分特征来感知整体特点。本节通过纹理特征增强模块中的多种操作使得行人再识别网络获得更全面的全局特征和更精准的局部特征,进而在一定程度上克服因遮挡等造成的行人再识别网络性能下降的问题。

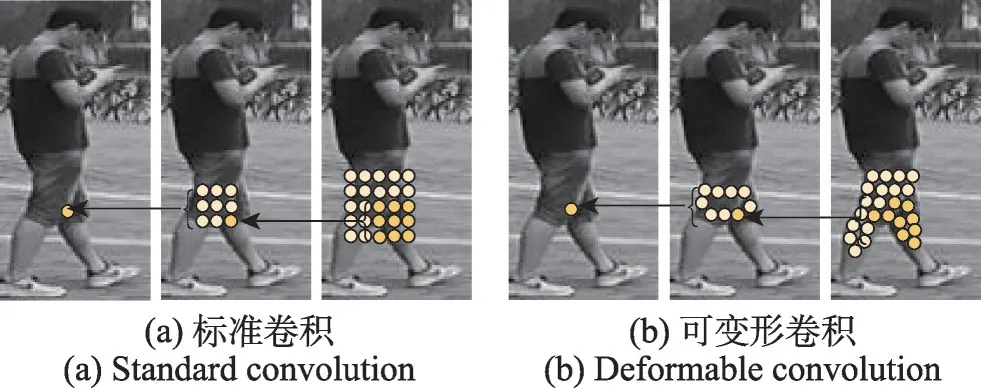

纹理特征增强模块主要包括可变形卷积操作、水平金字塔分割、全局均值、最大池化以及像素值点积的特征融合四部分。第一步引入可变形卷积操作不仅在一定程度上突破了固定采样、固定感受野的限制,将特征聚集在行人等非刚体的姿态变化上,还能融入更合理的上下文信息以及边缘信息。其中标准卷积和可变形卷积的感受野示例如图3 所示。第二步采用水平金字塔分割操作,目的在于将特征分为与人体上下半身空间相对应的水平局部特征。对于采用水平金字塔分割而不采用包括垂直分割等的其他分割方式,原因在于水平分割后的两部分特征更能和人体的上下半身特征相对应。同时在文献[19]中的实验分析中,在保证实验公平,只有分割方式一种变量的前提下,对采用不分割、垂直分割、水平金字塔分割三种方式进行对比,三种的平均精度分别为51.9%、59.6%和63.9%。第三步对由HPP(horizontal pyramid pooling)所得的局部特征和可表达颜色纹理以及形状的行人全局特征进行全局均值池化和全局最大池化。这一步操作一方面可以对多种特征进行维度统一,便于后续对接固定数目的全连接层;另一方面可以进一步获得具有轮廓性和显著性特点的特征。最后一步将这多种特征进行像素值点积的特征融合操作,最终得到纹理特征增强模块输出的多路有效行人特征。纹理特征增强模块不仅使网络的关注点更聚焦在行人特征上,同时使模块输出特征兼具行人局部和全局特征的特点,在一定程度上解决了因遮挡、姿态变化等引起的识别率降低的问题。

图3 两种卷积的感受野示例Fig.3 Examples of two convolutional receptive fields

1.4 多任务加权损失函数

行人特征与属性特征可互为补充,有效地利用行人属性信息在一定程度上可以减弱视角、光照强度变化等的影响,进而提高行人再识别任务的精度。但如果将属性特征与行人特征直接进行特征融合,虽然有包括像素值相加、像素值点积和通道相加等特征融合方式,但还是会由于属性的异质性及两者特征的差异性影响到融合特征的有效性,进而干扰行人再识别的精度。针对这一问题,本文提出了多任务加权损失函数。

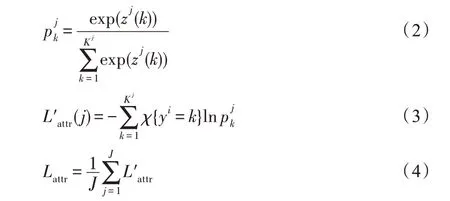

多任务加权损失函数主要分为两大部分:一部分为属性识别损失;另一部分为行人再识别损失,其中行人再识别损失可根据特征的划分再分为行人的全局特征损失、上半身和下半身特征损失三部分。对于属性识别部分,选择与一般基于属性的行人识别方法不同,这里对每一个属性都采用了Softmax 损失。假定数据集中共有类行人,每个行人有属性种,其中每个属性包含的类别数为K,∈{1,2,…,}。如属性为行人性别,则类别数的值为2。那么行人属性属于其中第个类别的预测概率值可用式(2)来表示,其中∈{1,2,…,K}。属性经过Softmax 后回归所得的交叉熵损失即为式(3)。最终的属性识别损失函数见式(4)。

其中,z() 为全连接层输出的属性的第个值。{·}是示性函数,{}=1,{}=0 。 y为该样本的第个属性的真实属性类别。

对于行人再识别部分,按照划分的行人特征分为全局特征、上半身和下半身特征。在训练过程中对每一部分特征都会计算一个分类损失值,其中全局特征行人再识别的交叉熵损失函数如式(5)所示:

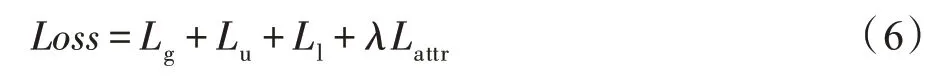

其中,∈{1,2,…,},p为该样本属于第类行人的概率预测值,计算方法与式(2)一致,为该样本的真实行人类别。由上述公式最终可得多任务加权损失函数如式(6)所示:

其中,、分别代表行人的上半身和下半身特征损失,计算方法与式(5)一致。

上述1.2~1.4 节分别从为获得更有判别力属性特征的基于空间注意力的属性识别网络部分,可有效提取行人全局及局部特征的行人再识别网络部分以及能充分发挥行人特征与属性特征的多任务损失函数三方面进行了分析。通过三部分的优化设计,联合使用,在充分增强行人特征的基础上,不断挖掘属性特征之间的相关性,再利用多任务损失函数将两个网络同时训练,使行人特征融合与之契合的属性特征,增强算法整体的鲁棒性。

2 实验结果及分析

2.1 实验设置

为了验证方法的有效性,分别采用Market-1501和DukeMTMC-reID 数据集进行训练。为了使模型具有更好的鲁棒性和泛化性能,在训练的过程中采用了随机水平翻转、裁剪等数据增强操作。训练过程中图像大小统一为384×128,损失函数使用交叉熵损失,批处理数量设置为64,训练批次设置为60,学习率初始值设置为0.01,优化过程采用随机梯度下降算法,其中动量设置为0.9。

2.2 控制变量实验及分析

为了验证本文算法的有效性,本文在Market-1501 和DukeMTMC-reID 两大主流的行人再识别数据集上进行多组实验分析。其中本文表中的评价指标Rank-1 和mAP(mean average precision)的具体含义分别如下:Rank-表示对行人图像特征按照相似度大小进行排序后,在排序结果中前张图像与查询图像具有相同行人ID 的准确率。Rank-1 则表示为计算在排序后的测试集中前1 张图像中能找到与查询图片相同标签的图像的准确率。mAP 是将多分类任务中的平均精度(average precision,AP)求和再取平均,其中AP 的计算为查准率(precision)和查全率(recall)构成的P-R 曲线图曲线下方的面积。

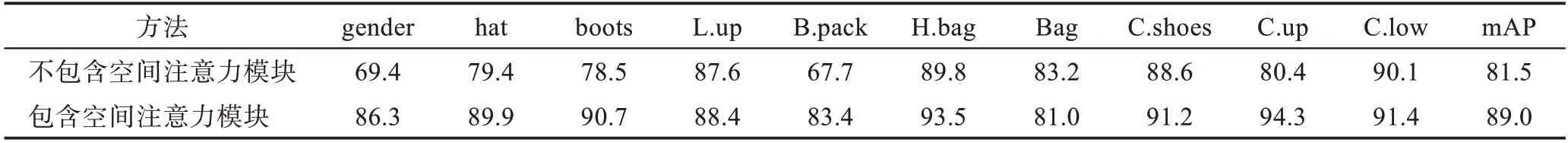

首先为了验证空间注意力模块对于属性识别网络的有效性,通过对比移除空间注意力模块前后,模型在DukeMTMC-attribute 数据集上的效果,来得出其对于属性识别网络的贡献。具体评测结果见表1所示。

表1 中,L.up、B.pack、H.bag、C.shoes、C.up、C.low分别代表袖子长度、背包、手提包、鞋子颜色、上半身衣服颜色、下半身衣服颜色。从表1 中可以看出,在包含空间注意力模块之后,行人属性的mAP 提高了7个百分点左右。而针对单个属性而言,除了Bag 属性有稍微的降低之外,其他的9 种属性均有不同程度的提升。

表1 空间注意力模块对属性识别的有效性验证Table 1 Validity verification of spatial attention module for attribute recognition %

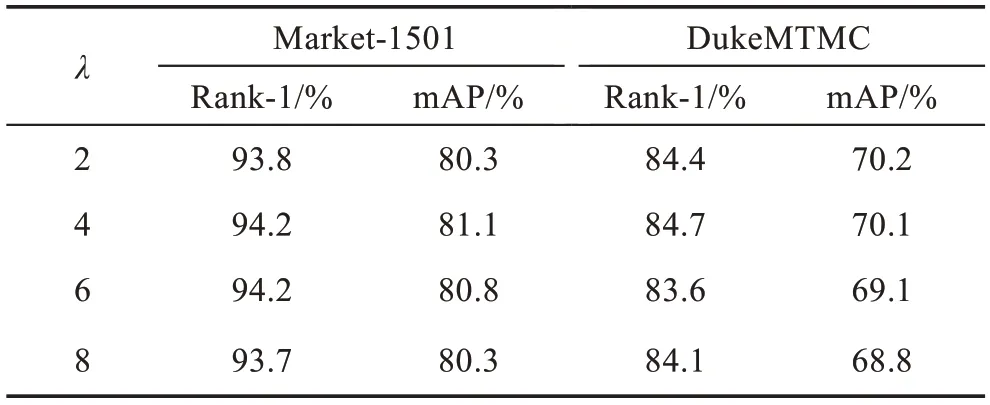

其次为了验证多任务加权损失函数中权重系数对于算法性能的影响,本文对不同的值进行了多组实验,具体实验结果见表2 所示。

从表2 可以看出,对于Market-1501 数据集,当=4 时取得的效果最好,而在DukeMTMC 数据集上=2 时的效果最好,但是=4 的结果与=2 的结果相差只有0.1 个百分点。综合考虑,本文最终选择=4。

表2 不同λ 值在数据集上的结果Table 2 Results of different λ on datasets

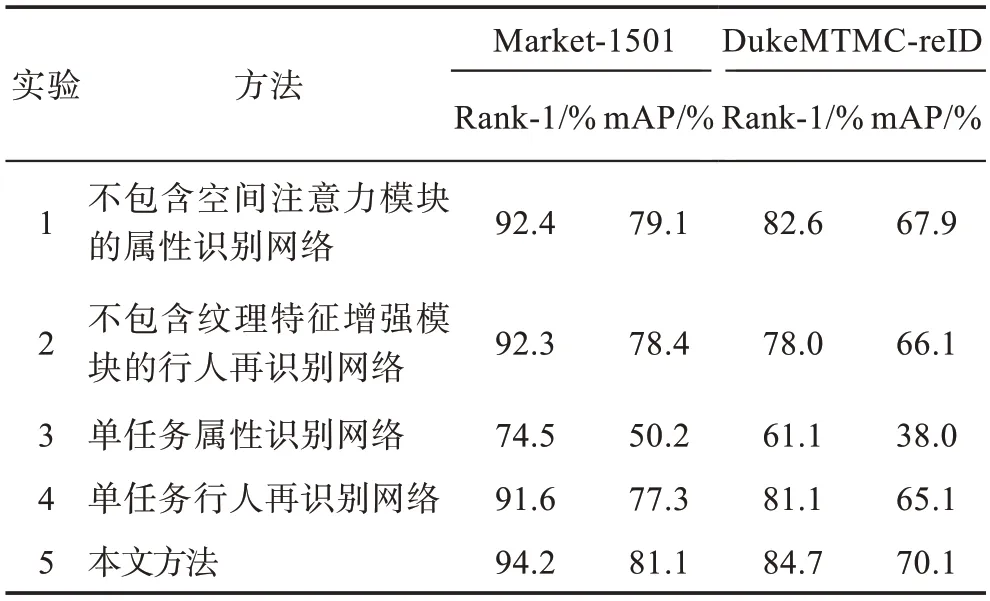

为了进一步验证文中提出的各个模块的有效性,本文设计了4 组控制变量实验来分析不同情况对行人再识别平均准确率的影响。4 组实验分别为不包含空间注意力模块的属性识别网络、不包含纹理特征增强模块的行人再识别网络、单任务属性识别网络和单任务行人再识别网络。其中第三组和第四组单任务识别网络中都分别包含了空间注意力和纹理特征增强模块。为了保证实验的公平性,4 组实验的训练过程都采用了随机水平翻转、裁剪等相同的数据增强操作。其中具体的评测结果见表3 所示。

在实验1 中,本文将属性识别中的空间注意力模块去掉,将输入特征图直接进行属性识别。从表3 中可以看到,缺少空间注意力模块的mAP 值相对完整网络在两个数据集上相差2 个百分点左右。在实验2中,本文将纹理特征增强模块去掉,主要去掉其中可变性卷积操作、全局最大池化、全局均值池化以及像素值点积的特征融合方法,但仍然进行水平金字塔分割等操作,只对得到特征图进行普通池化,使得特征图可输入相对应的全连接层。从表3 中可以看到,缺少纹理特征模块的mAP值相对完整网络在Market-1501 和DukeMTMC-reID 数据集分别相差约3 个百分点和4 个百分点。

为了进一步验证本文算法的有效性,本文继续设计了实验3 和实验4。在实验3 中,只利用单任务属性识别网络进行行人再识别任务。通过表3 中结果可以看出,只使用单任务属性识别网络在行人再识别任务中表现相对较差。在实验4 中,只使用单任务行人再识别网络进行行人再识别任务,通过表3 中结果看出,只利用了行人特征而不结合与之互为补充的属性信息,在最终的识别精度上相较完整网络在两个数据集上相差4~5 个百分点。通过4 组对比实验的结果及分析,可以得出缺少行人再识别网络对算法精度影响最大,缺少属性识别网络中的空间注意模块影响最小。同时可以看出本文所设计的3个子模块缺少其中任意一个都会影响算法的性能,只有联合使用,构成完整算法时,效果最佳。综上所述,本文提出的基于空间注意力的属性识别网络、纹理特征增强的行人再识别网络及多任务加权损失函数对行人再识别任务的识别精度是有明显提升的。

表3 Market-1501 和DukeMTMC-reID评测集结果对比Table 3 Results comparison of Market-1501 and DukeMTMC-reID evaluation sets

2.3 与现有方法比较

为了进一步验证本文算法的性能,本节在Market-1501 和DukeMTMC-reID 两大主流的行人再识别数据集上采用官方的评测程序,将本文的基于空间注意力和纹理特征增强的多任务行人再识别算法与多种目前流行的方法进行对比。在比较过程中为了保证实验公平性,选取的比较方法在训练过程中同样采用了随机水平翻转、裁剪等数据增强操作。同时为了充分体现本文算法的鲁棒性,本节将对比实验分为两组,分别为单任务行人再识别算法和多任务行人再识别算法。具体实验结果如表4 所示。

从表4中可以看出,在Market-1501和DukeMTMCreID 两个数据集上的对比评测结果里,本文算法优于其他单任务行人再识别算法。而在与其他多任务行人再识别算法的比较中,本文算法虽然在DukeMTMC-reID 数据集上稍弱于最好的CA3Net,但是在Market-1501 数据集上却比JCM 和CA3Net 表现得更为优异。其中JCM 的基础网络采用的是Resnet50 加Desnet101,而本文设计的行人再识别网络模型仅采用Resnet50,在模型大小上要比JCM 模型小很多。而CA3Net在网络中添加LSTM(long short-term memory)等模块,在速度上并不占优。CA3Net 需要在两块TitanXP 显卡进行70 个循环次数(epochs)才能达到表中所示精度,而本文方法只需要在一块1080 显卡上迭代60 个epochs 便可以达到目前的精度。这也从另一方面证明了本文所提出的基于空间注意力和纹理特征增强的多任务行人再识别算法的鲁棒性。

表4 与现有方法在Market-1501 和DukeMTMC-reID 数据集上的结果对比Table 4 Comparison with existing methods on Market-1501 and DukeMTMC-reID datasets

3 结束语

本文提出的基于空间注意力和纹理特征增强的多任务行人再识别算法,通过基于空间注意力模块的属性识别网络使网络实现了属性特征的挖掘,抑制了无关背景区域。通过融入行人再识别网络的纹理特征增强模块将特征聚集在行人等非刚体的姿态变化上,同时使特征兼具行人局部和全局特征的特点。最后通过多任务加权损失函数将属性特征和行人特征有效融合,提高了行人再识别的识别精度,同时使得模型具有了更好的泛化性能。