复杂对抗场景下的对空目标混合智能抗干扰研究

2022-03-04张良李少毅杨曦田晓倩

张良 李少毅 杨曦 田晓倩

摘 要:目标识别与抗干扰技术已经成为决定精确制导武器性能优劣的关键技术。 本文针对复杂对抗场景下红外空空导弹作战特点,分析了其目标识别与抗干扰发展需求,提出了融合传统算法与深度学习的混合智能抗干扰算法。 该算法充分利用传统算法在确定场景下的高可靠性优势与深度学习算法在复杂场景下的高维特征提取能力,最大化挖掘了导弹探测的场景信息,对于提高系统抗干扰能力具有重要意义。 在此基础上,构造了算法测试训练的空战数据集,覆盖了典型的空战作战场景。 实验结果表明,相同特征融合条件下,典型场景混合智能抗干扰算法的全程抗干扰概率达到了71.56%,比传统算法提高了15.77%,验证了算法的有效性。

关键词:红外空空导弹;智能抗干扰;空战数据集;特征提取;目标识别;深度学习

中图分类号:TJ760.2; V271.4 文献标识码: A 文章编号:1673-5048(2022)01-0022-07[SQ0]

0 引 言

现代战争中,没有人工干扰的净空作战条件已经不复存在,新型干扰不断出现、战场环境瞬息万变,使传统基于人工定义特征和逻辑的算法难以应对。 近年来在导弹型号研制和部队训练中频繁暴露出的问题表明,空空导弹的抗干扰能力已经成为能否达成其作战意图的首要性能。 图1所示为国外军机抛射红外诱饵弹示意图。

导引头抗自然背景和人工诱饵干扰能力的提升主要依赖于目标检测识别算法的性能[1]。 目前,导弹抗干扰方法主要通过强化空中目标和诱饵红外特性认识,充分挖掘热成像视觉特征,基于特征相似性匹配实现自动目标识别。 传统基于逻辑规则的算法由于阈值设置缺乏灵活性、规则表达存在局限性,难以应对瞬息万变的战场环境[2-3]。 人工智能技术的推理、学习等能力恰恰能丰富和完善抗干扰过程中的目标与场景定义、特征提取等功能,不仅能提高对目标的检测识别能力,而且能通过对环境及攻防对抗态势的融合分析生成最佳博弈策略,对于提高导弹在复杂环境下的作战能力具有重要意义。

自2006年以来,深度学习方面的文献层出不穷[4-6]。 深度学习技术带来的进步主要体现在能够从数据中学习提取出目标特征,这些特征无论从数量上,还是维度或复杂度上,都远超设计人员手工设计的特征。 但深度学习存在不可解释的特点,这对于复杂对抗、真实数据缺乏的空战场景应用带来了较大的不确定性[7-8]。

针对该问题,本文充分利用传统算法在确定场景下的高可靠性优势与深度学习算法在复杂场景下的高维特征提取能力,提出一种复杂对抗场景下的对空目标混合智能抗干扰算法,最大化挖掘导引头图像蕴含信息,极大提高红外空空导弹在复杂场景下的感知对抗能力。

1 混合智能抗干扰算法

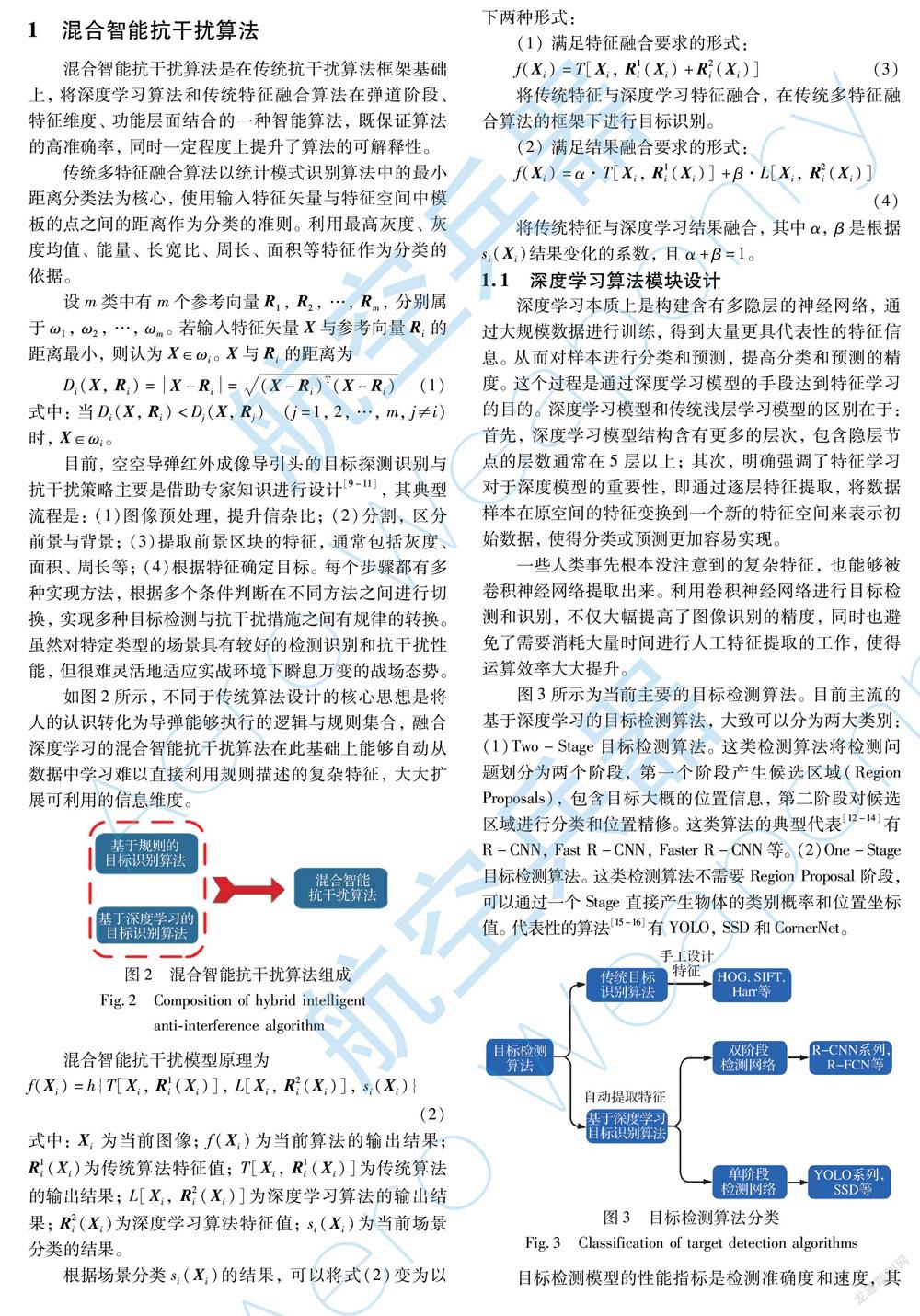

混合智能抗干扰算法是在传统抗干扰算法框架基础上,将深度学习算法和传统特征融合算法在弹道阶段、特征维度、功能层面结合的一种智能算法,既保证算法的高准确率,同时一定程度上提升了算法的可解释性。

传统多特征融合算法以统计模式识别算法中的最小距离分类法为核心,使用输入特征矢量与特征空间中模板的点之间的距离作为分类的准则。 利用最高灰度、灰度均值、能量、长宽比、周长、面积等特征作为分类的依据。

设m类中有m个参考向量R1,R2,…,Rm,分别属于ω1,ω2,…,ωm。 若输入特征矢量X与参考向量Ri的距离最小,则认为X∈ωi。 X与Ri的距离为

Di(X, Ri)=X-Ri=(X-Ri)T(X-Ri)(1)

式中:当Di(X, Ri)<Dj(X, Rj) (j=1, 2, …, m, j≠i)时,X∈ωi。

目前,空空导弹红外成像导引头的目标探测识别与抗干扰策略主要是借助专家知识进行设计[9-11],其典型流程是:(1)图像预处理,提升信杂比;(2)分割,区分前景与背景;(3)提取前景区块的特征,通常包括灰度、面积、周长等;(4)根据特征确定目标。 每个步骤都有多种实现方法,根据多个条件判断在不同方法之间进行切换,实现多种目标检测与抗干扰措施之间有规律的转换。 虽然对特定类型的场景具有较好的检测识别和抗干扰性能,但很难灵活地适应实战环境下瞬息万变的战场态势。

如图2所示,不同于传统算法设计的核心思想是将人的认识转化为导弹能够执行的逻辑与规则集合,融合深度学习的混合智能抗干扰算法在此基础上能够自动从数据中学习难以直接利用规则描述的复杂特征,大大扩展可利用的信息维度。

混合智能抗干扰模型原理为

f(Xi)=h{T[Xi, R1i(Xi)], L[Xi, R2i(Xi)],

si(Xi)}(2)

式中:Xi為当前图像;f(Xi)为当前算法的输出结果;R1i(Xi)为传统算法特征值;T[Xi, R1i(Xi)]为传统算法的输出结果;L[Xi, R2i(Xi)]为深度学习算法的输出结果;R2i(Xi)为深度学习算法特征值; si(Xi)为当前场景分类的结果。

根据场景分类si(Xi)的结果,可以将式(2)变为以下两种形式:

(1) 满足特征融合要求的形式:

f(Xi)=T[Xi, R1i(Xi)+R2i(Xi)](3)

将传统特征与深度学习特征融合,在传统多特征融合算法的框架下进行目标识别。

(2) 满足结果融合要求的形式:

f(Xi)=α·T[Xi, R1i(Xi)]+β·L[Xi, R2i(Xi)](4)

将传统特征与深度学习结果融合,其中α, β是根据si(Xi)结果变化的系数,且α+β=1。

1.1 深度学习算法模块设计

深度学习本质上是构建含有多隐层的神经网络,通过大规模数据进行训练,得到大量更具代表性的特征信息。 从而对样本进行分类和预测,提高分类和预测的精度。 这个过程是通过深度学习模型的手段达到特征学习的目的。 深度学习模型和传统浅层学习模型的区别在于:首先,深度学习模型结构含有更多的层次,包含隐层节点的层数通常在5层以上;其次,明确强调了特征学习对于深度模型的重要性,即通过逐层特征提取,将数据样本在原空间的特征变换到一个新的特征空间来表示初始数据,使得分类或预测更加容易实现。

一些人类事先根本没注意到的复杂特征,也能够被卷积神经网络提取出来。 利用卷积神经网络进行目标检测和识别,不仅大幅提高了图像识别的精度,同时也避免了需要消耗大量时间进行人工特征提取的工作,使得运算效率大大提升。

图3所示为当前主要的目标检测算法。 目前主流的基于深度学习的目标检测算法,大致可以分为两大类别:(1)Two-Stage目标检测算法。 这类检测算法将检测问题划分为两个阶段,第一个阶段产生候选区域(Region Proposals),包含目标大概的位置信息,第二阶段对候选区域进行分类和位置精修。 这类算法的典型代表[12-14]有R-CNN,Fast R-CNN, Faster R-CNN等。 (2)One-

Stage目标检测算法。 这类检测算法不需要Region Proposal阶段,可以通过一个Stage直接产生物体的类别概率和位置坐标值。 代表性的算法[15-16]有YOLO,SSD和CornerNet。

目标检测模型的性能指标是检测准确度和速度,其中准确度主要考虑物体的定位及分类精度。 一般情况下,Two-Stage算法在精度上有优势,而One-Stage算法在速度上有优势。 不过,随着研究的发展,两类算法都做了改进,均能在准确度以及速度上取得较好的结果。

由于弹载应用对算法实时性要求很高。 Two-Stage检测算法中,经典的检测方法生成候选区域都非常耗时,如R-CNN使用SS(Selective Search)方法生成检测框,在Nvidia Titan X上只有0.02 fps的检测速度。 即便宣称极大地提升了检测框生成速度的Faster R-CNN在同等条件下也只有7 fps的检测速度。 而One-Stage类中的代表算法SSD300,在同等硬件条件下,能够达到46 fps,且拥有和Faster R-CNN相当的检测精度。 因此,考虑对空目标探测识别的高实时性要求,本文采用单阶段检测算法开展算法设计。

本文的应用场合需要考虑弱小目标检测,选取一个弱小目标检测能力强的目标分类器是十分必要的,因此,选取了YOLOV3目标检测算法的尾部分类器[17]。 YOLOV3由华盛顿大学的Joseph Redmon和Ali Farhadi于2018年提出,旨在提升目标检测的检测效率,试图使目标检测达到实时检测的程度。 特别在经过改进后,YOLOV3能在提升目标检测效率的同时保持检测精度,是双赢的算法。

YOLOV3使用的是Darknet-53的网络结构(含有53个卷积层),其借鉴了残差网络的做法,在一些层之间设置了快捷链路(shortcut connections),从而加深了网络的深度,使网络提取特征的能力更进一步加强,如图4所示。

MobileNet是Google提出的一种轻量级网络,体积小,计算量少,适用于移动设备,MobileNetV2[18]在一代基础上提升了训练速度并有效解决了梯度弥散的问题。 虽然MobileNetV2的精度(74.9%)略低于Darknet-53,但由于弹上资源有限,Darknet-53等其他大型网络部署起来会有困难,权衡之下,选用MobileNetV2作为YOLOV3的特征提取器。 MobileNetV2网络结构如表1所示。

1.2 混合智能抗干扰算法设计

从特征级和决策级两个层面开展传统目标识别算法与深度学习算法的融合设计。 决策级:一方面,利用深度学习算法输出结果辅助传统算法进行执行路径选择;另一方面,根据场景对深度学习算法和传统算法的识别结果进行融合,在提高目标识别正确概率的同时保证跟踪点的稳定性。 特征级:通过深度学习算法得到场景所有对象的态势分布,将该分布态势信息矢量化表示形成特征信息后与传统算法成像特征进行融合。

1.2.1 场景分类

传统算法在可定义确定场景下能够取得较好的识别效果,且具有高可靠性的优势。 由于场景类别的判断本身具有一定的难度,而深度学习算法可以通过对场景中各对象类型的输出,综合得出场景类别[19-21],因此,将深度学习算法的场景分类结果输出给传统算法,传统算法根据场景类别选择规定好的执行路径,提高算法对于复杂场景的适应能力。

根据训练好的模型,识别该时刻场景所处的分类情况,进而选择更适合的参数或算法对图像进行处理,提升处理精度及效率。 如图5所示,通过场景分类算法得出目前所处的阶段及目标态势,选择目标态势最适用的算法处理目标信息。 如远距应選择小目标检测识别算法;目标若处于复杂机动条件下,应选择对应的复杂机动条件下的识别和跟踪方法,以确保处理不同场景所依赖的算法及参数处于最优状态。

1.2.2 特征融合

目标识别主要基于红外干扰与真实空中目标在红外成像上的差异性,充分提取并利用相关成像特征,构建目标模型并进行识别判定,抗干扰过程中存在目标特征连续性被破坏、干扰与目标特征相似带来的目标难以识别问题,而深度学习具有极强的特征表示能力,因此,可将卷积神经网络提取的深度特征与传统人工特征融合进行目标识别。

人工特征的提取主要依赖先验知识,通过对图像分割后的候选区域进行处理,最大程度找出能反映不同样本间差异的特征变量,通常以能反映能量强度、外形轮廓等的物理量为主。 本文所选的特征有长宽比、周长、面积、能量、灰度均值、熵、傅里叶描述子。

深度学习网络输出的特征图反映了像面的对象分布态势,将该分布态势信息矢量化表示形成特征信息后,可以与传统算法提取的像面成像特征融合,得到更加完整和全面的特征表示。 如发生目标被新的诱饵遮挡情况,利用深度学习输出的分布矢量特征,与传统算法的成像特征融合,完成当前时刻目标与干扰相对位置矢量的观测与估计。

图6所示为目标与干扰的深度特征图。 通过这些抽象程度不高的特征图可以看出,目标与干扰的特征提取较为准确,其主要轮廓特征可以清晰分辨,特征差别较为明显,特征描述较为准确。 不难推断,高维深度特征也具有此类特性。 所以,对于目标与干扰深度卷积特征,可以用目标分类识别的一项约束,与传统特征进行融合。

图像经过多次卷积后得到的深度卷积特征维度一般高于传统特征的维度,通常需将高维卷积特征降维至与传统特征相同的维度进行融合:

Xn=f(Cd, i, j)(5)

式中:Cd, i, j为高维卷积特征;Xn为降维后特征,与传统特征维度一致;f(x)为降维算法,如主成分分析法(PCA)、线性判别分析法(LDA)等。

1.2.3 识别结果融合

导弹作战需要在识别出目标的同时,测量目标的跟踪点用于制导系统闭合。 深度学习算法可极大提高系统对于目标的识别分类能力,但对于跟踪点的提取并不稳定。 故将深度学习算法的分类识别结果与传统算法的识别结果相结合,在传统算法可定义的场景下以传统算法的识别结果为主,输出跟踪点供制导系统闭合。

在传统算法难以识别出目标的场景下,以深度学习算法的分类识别结果辅助传统算法进行目标识别,并通过传统算法输出目标跟踪点,在提高系统目标识别与抗干扰能力的同时,保证跟踪点的稳定性:

xi, j=ti,j, di, j=0α·di, j+β·ti, j, di, j≠0且α+β=1 (6)

式中:xi, j为输出的目标跟踪点;di, j为深度学习算法结果;ti, j为传统算法识别结果;α和β为权重系数。

同时,利用深度学习算法结果在目标与干扰粘连状态下所表现出的对部分特征依然能精准锁定的特性,结合传统算法结果可判定目标与干扰的相对运动关系,利用得到的方向特征增强空间约束,提升跟踪稳定性。

混合智能抗干扰算法具体流程如图7所示。 首先对输入的图像进行预处理,对处理后的图像进行场景分类识别,根据得到的不同阶段选用不同的融合算法,最后得到跟踪目标的位置,更新跟踪框。

1.3 数据集构造与标注

本文采用仿真数据集中的复杂对抗场景是由导弹发射初始态势、 载机机动策略、 诱饵对抗策略共同耦合生成的。 通过建立载机、点源诱饵的运动、几何、红外辐射

模型,导弹的运动、动力学、制导控制模型及导弹红外导引头模型,结合OSG+GPU实现红外场景实时动态渲染,构成了导弹导引头弹道数据仿真软件,逼近实际空战对抗环境的不同弹道数据。

构建样本空间,首先进行战场态势想定,弹道中目标高度为6 km, 目标飞行马赫数为0.8;导弹发射距离为7 km;干扰弹投射距离在2~7 km以500 m为间隔平均划分为11种投射距离。 样本集弹道态势如表2所示。

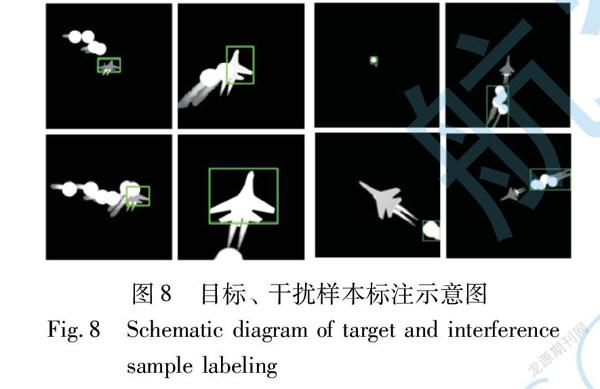

根据表2,共仿真1 132条弹道,将弹道全过程输出格式为256×256的单通道16位灰度图序列。 提取导引头图像序列,分别进行目标和干扰区域标注,以此作为正、负样本构造数据集,如图8所示。

2 仿真分析

2.1 实验条件

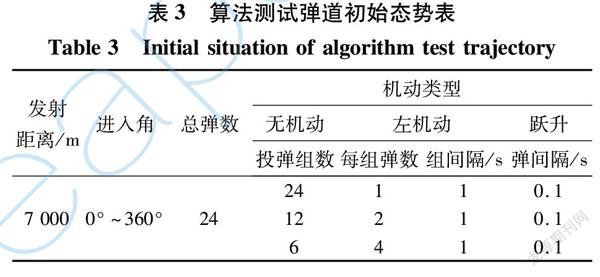

仿真测试数据集包括初始发射条件、目标机动、干扰投射策略3个维度的对抗条件参数,本实验所用图像数据集的对抗条件参数的量化共包含16个。

(1) 对抗态势有7个参数:目标高度、载机高度、目标速度、载机速度、水平进入角、发射距离、综合离轴角(可分解为水平离轴角、垂直离轴角);

(2) 目标机动有5种类型:无机动、左机动、右机动、跃升、俯冲;

(3) 红外干扰投放策略有4个参数:总弹数、组数、弹间隔、组间隔。

本文设置的测试集弹道态势如表3所示。 基于表3数据,使用红外仿真平台产生逼近实际空战对抗环境的仿真图像,共生成弹道2 416条。

2.2 实验结果

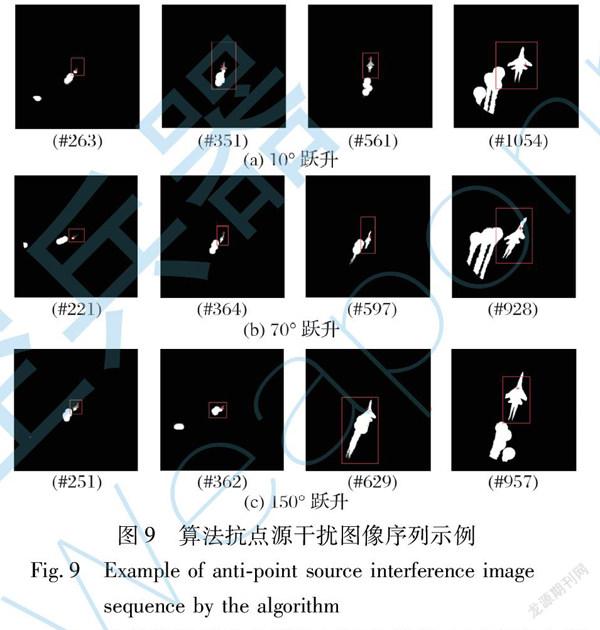

用混合智能抗干扰算法对多种态势下的飞机进行追踪,部分结果如图9所示。 将飞机用红色矩形框标出,追踪点用红色十字表示。

表4为传统特征融合算法与混合智能抗干扰融合算法部分详细测试结果。 测试方式为相同初始条件下同一条弹道运行仿真10次的命中率对比,脱靶量为20 m。 表5为传统特征融合算法与混合智能抗干扰融合算法概率指标测试结果。 实验结果表明,在以上测试条件下,混合智能抗干扰算法具备良好的抗干扰能力,导弹的全程抗干扰概率达到71.56%,相比传统算法提高15.77%,验证了算法的有效性与正确性。

3 结 论

本文提出了一种复杂对抗场景下的对空目标混合智能抗干扰算法, 通过复杂对抗场景构成要素分析构造了算法的训练和测试的空战场景数据集,并基于该数据集完成了算法的训练和测试验证。 实验结果表明,典型数据集下混合智能抗干扰算法的全程抗干扰概率达到了71.56%,相比传统算法提高了15.77%,验证了算法的正确性和有效性,对于提高红外空空导弹复杂对抗场景下的作战能力具有重要意义。

参考文献:

[1] 樊会涛, 张蓬蓬. 空空导弹面临的挑战[J]. 航空兵器, 2017(2): 3-7.

Fan Huitao, Zhang Pengpeng. The Challenges for Air-to-Air Missile[J]. Aero Weaponry, 2017(2): 3-7.(in Chinese)

[2] 樊会涛, 闫俊. 自主化: 机载导弹重要的发展方向[J]. 航空兵器, 2019, 26(1): 1-10.

Fan Huitao, Yan Jun. The Important Development Direction of Airborne Missile: Autonomization[J]. Aero Weaponry, 2019, 26(1): 1-10.(in Chinese)

[3] 范晉祥,刘嘉. 精确制导自动目标识别智能化的挑战与思考[J]. 航空兵器,2019,26(1): 30-38.

Fan Jinxiang,Liu Jia. Challenges and Thinking for the Precision Guidance ATR Intelligentization[J]. Aero Weaponry,2019,26(1): 30-38.(in Chinese)

[4] Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[J].Communications of the ACM, 2017, 60(6): 84-90.

[5] Goodfellow I J, Pouget-Abadie J, Mirza M, et al. Generative Adversarial Nets[C]∥Advances in Neural Information Processing Systems, 2014: 2672-2680.

[6] Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[EB/OL].(2014-09-18)[2021-09-12].https:∥arxiv.org/pdf/1409.1556.pdf 2014.

[7] 周飛燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251.

Zhou Feiyan, Jin Linpeng, Dong Jun. Review of Convolutional Neural Network[J].Chinese Journal of Computers, 2017, 40(6): 1229-1251.(in Chinese)

[8] 卢晓, 梁晓庚, 贾晓洪. 红外成像空空导弹智能化抗干扰研究[J]. 红外与激光工程, 2021, 50(4): 29-37.

Lu Xiao, Liang Xiaogeng, Jia Xiaohong. Study on Intelligent Counter-Countermeasures of Infrared Imaging Air-to-Air Missiles[J].Infrared and Laser Engineering, 2021, 50(4): 29-37.(in Chinese)

[9] Marsiglia G, Fortunato L, Ondini A, et al. Template Matching Techniques for Automatic IR Target Recognition in Real and Simulated Scenarios: Tests and Evaluations[C]∥Automatic Target Re-cognition XIII, 2003, 5094: 159-169.

[10] Berg A C, Berg T L, Malik J. Shape Matching and Object Recognition Using Low Distortion Correspondences[C]∥IEEE Compu-ter Society Conference on Computer Vision and Pattern Recognition, 2005: 26-33.

[11] Ullman S. Object Recognition and Segmentation by a Fragment-Based Hierarchy[J].Trends in Cognitive Sciences, 2007, 11(2): 58-64.

[12] Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]∥IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[13] Girshick R. Fast R-CNN[C]∥IEEE International Conference on Computer Vision, 2015: 1440-1448.

[14] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[15] Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection[C]∥ IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779-788.

[16] Liu W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[M]. Cham: Springer International Publishing, 2016: 21-37.

[17] Redmon J, Farhadi A.YOLOv3:An Incremental Improvement[EB/OL].(2018-04-08)[2021-09-12].https:∥arxiv.org/pdf/1804.02767.pdf.

[18] Sandler M, Howard A, Zhu M L, et al. Inverted Residuals and Linear Bottlenecks: Mobile Networks for Classification, Detection and Segmentation[EB/OL]. (2019-03-21)[2021-09-12].https:∥arxiv.org/pdf/1801.04381.pdf.

[19] 郭东恩, 夏英, 罗小波, 等. 基于有监督对比学习的遥感图像场景分类[J]. 光子学报, 2021, 50(7): 87-98.

Guo Dong’en, Xia Ying, Luo Xiaobo, et al. Remote Sensing Image Scene Classification Based on Supervised Contrastive Learning[J]. Acta Photonica Sinica, 2021, 50(7): 87-98.(in Chinese)

[20] Mosella-Montoro A, Ruiz-Hidalgo J. 2D-3D Geometric Fusion Network Using Multi-Neighbourhood Graph Convolution for RGB-D Indoor Scene Classification[J]. Information Fusion, 2021, 76: 46-54.

[21] Xu K J, Huang H, Deng P F, et al. Deep Feature Aggregation Framework Driven by Graph Convolutional Network for Scene Classification in Remote Sensing[J]. IEEE Transactions on Neural Networks and Learning Systems, 1369(99): 1-15.

Research on Hybrid Intelligent Anti-Interference against

Air

Targets in Complex Confrontation Scene

Zhang Liang1, 2,Li Shaoyi3*,Yang Xi3,Tian Xiaoqian3

(1. China Airborne Missile Academy,Luoyang 471009,China;

2. Aviation Key Laboratory of Science and Technology on Airborne Guided Weapons,Luoyang 471009,China;

3. School of Astronautics, Northwestern Polytechnical University, Xi’an 710072, China)

Abstract: Target recognition and anti-interference technology have become key technologies that determine the performance of precision guided weapons. Aiming at the combat characteristics of infrared air-to-air missiles in complex confrontation scene, this paper analyzes its target recognition and anti-interference development needs, and proposes a hybrid intelligent anti-interference algorithm that combines traditional algorithms and deep learning. This algorithm makes full use of the high reliability advantages of traditional algorithms in certain scene and the high-dimensional feature extraction capabilities of deep learning algorithms in complex scene, maximizing the mining of missile detection scene information, which is of great significance for improving the system’s anti-interference capability. On this basis, an air combat data set for algorithm testing and training is constructed, covering typical air combat scene. The experimental results show that under the same feature fusion conditions, the full anti-interference probability of the hybrid intelligent anti-jamming algorithm in typical scene reaches 71.56%, which is 15.77% higher than the traditional algorithm, which verifies the effectiveness of the algorithm.

Key words: infrared air-to-air missile; intelligent anti-interference; air combat data set; feature extraction; target recognition; deep learning

收稿日期: 2021-09-14

基金項目: 国家自然科学基金项目(61703337);航空科学基金项目(ASFC20191053002)

作者简介:张良(1987-),男,河南洛阳人,高级工程师。

通讯作者:李少毅(1986-),男,陕西西安人,副研究员。