面向端到端的情感对话生成研究综述

2022-02-23王春喻马志强杜宝祥贾文超王洪彬宝财吉拉呼

王春喻,马志强,2+,杜宝祥,贾文超,王洪彬,宝财吉拉呼

1.内蒙古工业大学 数据科学与应用学院,呼和浩特010080

2.内蒙古工业大学 内蒙古自治区基于大数据的软件服务工程技术研究中心,呼和浩特010080

人机对话系统的研究最早追溯到1950 年图灵提出的“图灵测试”,采用人机交互的方式验证机器智能。此后,人机对话研究引起了学术界与工业界的高度关注。对话系统的研究主要面向任务型对话和非任务型对话。早期任务型人机对话是基于模板与规则构建的,随着深度学习的发展,越来越多的研究者将深度学习技术应用于对话系统的研究中。当前任务型对话系统的构建主要使用基于流水线的方法和基于端到端的方法。基于流水线的方法构建灵活,而基于端到端的方法能够学习数据的特征,且避免了人为因素的影响。任务型对话的主要应用场景为虚拟个人助理、网站客服,并且有着明确的目标,目的是通过较少的对话轮数帮助用户完成预定任务。非任务型对话系统则面向开放领域,主要通过基于检索的方法和生成式的方法构建,主要应用场景为闲聊机器人、智能客服以及个性化推荐等,回复内容具有主题一致性、语言多样性以及个性化的特点。在开放域对话系统的研究中,基于检索的方法回复语句流畅且易于评价,而基于生成式的方法能够更多地考虑上下文的影响,且回复内容多样,能够更好地模拟人类的正常交流。近年来,随着大规模语料库的出现,计算机计算能力的提升,开放域下的对话生成研究成为了学术界研究的热点。面向开放域对话的各种语音助手、闲聊机器人以及智能音响逐渐走入大众的生活中,成为人们工作和生活娱乐的一部分。

然而人类在交换信息的过程中,不仅包含语法和句法信息,还包含着情感信息与情感状态。人工智能的长期目标是使机器能够理解情绪和情感,现有的研究表明,在对话系统中加入情感信息会提高用户的满意度,并且情感信息有助于机器和人之间的交流更加自然。因此,如何处理用户的情感信息,并且设计能够与用户进行正常情感交互的对话系统非常重要。情感对话生成最初的研究是基于模板与规则的方法构建的,其中情感语句使用基于模式的方式生成,但是这种方法构造难度大且不易拓展,难以进行广泛的应用。受到神经模型在机器翻译等领域成功应用的启发,基于端到端的神经网络模型被广泛应用于生成式对话研究中,旨在提高语句的语言质量,包括句法、多样性以及主题关联性等。为了使生成式对话模型具备感知和表达情感的能力,许多研究者将各种端到端的神经模型作为情感对话生成模型的基础,并通过情感分析、情感嵌入等技术对模型进行改进,实现了在对话生成中情感的表达。

由于基于端到端的情感对话生成研究时间较短,现有的综述未能针对最新的研究进行及时而全面的总结。李赟等人简要概述了情感对话生成的目标,从情感向量以及深度学习技术两方面梳理了情感对话生成研究中的解决方案。Pamungkas对企业化建立情感聊天机器人的方法进行了回顾,但是没有针对现有情感对话生成研究涉及的问题进行描述。Ma 等人重点关注移情对话系统的研究,将情感意识作为移情对话系统的一部分,情感对话生成的研究未能详细介绍。庄寅等人面向情感对话系统中的对话情绪感知和情感对话生成两个任务开展综述,但是并未对当前情感对话生成研究涉及的模型及其改进方面开展叙述。本文将基于端到端的情感对话生成作为研究对象,归纳并详细描述了基于端到端的情感对话生成研究涉及的关键问题以及当前研究的主要任务,同时重点阐述了端到端的基本模型及每种模型的研究应用,最后聚焦于情感对话生成未来的发展方向,并且给出了详细的未来研究思路。

1 情感对话生成任务描述

表1 情感对话生成示例Table 1 Example of emotional dialogue generation

1.1 问题定义

根据对情感对话生成任务以及情感对话生成现状的研究,当前情感对话生成的问题主要集中于对话生成中情感的回复问题,而该问题则包括三方面:对话中的情感一致性问题、回复生成情感恰当性问题以及情感通用性回复问题。

当前情感对话生成研究面临的问题贯穿于情感对话生成的研究进展中。从生成指定情感类别的情感语句,到生成符合人类交流恰当的情感语句,再到生成多样性以及情感丰富的情感语句,这项研究将会沿着拟人化表达的方向不断发展。

1.2 任务框架

根据对现有研究的整理,情感对话生成任务框架如图1 所示,情感对话生成主要完成以下任务:情感嵌入编码任务、回复情感控制任务以及情感回复解码任务。以此解决情感对话生成中的问题:对话中的情感一致性问题、回复生成情感恰当性问题以及情感通用性回复等问题。而实现的方式则包括:(1)情感对话数据集的收集。以数据驱动为主的情感对话生成模型对大规模、高质量的情感对话数据集有很高的要求。(2)情感对话生成模型的构建。面向不同的任务,研究者采取不同的基础模型,针对存在的问题进行模型的构建。(3)情感对话生成模型的评价。选取合适的评价指标对构建的模型生成质量进行评价,可以检验模型是否成功。

图1 基于端到端的情感对话生成任务框架Fig.1 Task framework based on end-to-end emotional dialogue generation

2 数据集

早期的对话系统基于手工制定规则的方式构建,因此不需要数据集训练。而当前情感对话生成模型以数据驱动的方式训练得到,因此大规模且高质量的情感对话数据集的收集与整理是构建情感对话生成系统的关键。

当前许多研究者收集并整理了大量的情感对话数据集,对这些开源的数据集进行预处理之后,可以在情感对话生成模型的训练中使用。根据整理发现,当前情感对话数据集只有两种语言,英语和汉语。表2 为具有代表性的情感对话数据集。

表2 情感对话数据集Table 2 Emotional dialogue dataset

根据对现有的情感对话数据集的分析,可以发现:(1)中文数据集来源于论坛评论,数据集质量不高,对于情感对话模型的训练来说,每种情感类别的分布不均,会造成情感语句生成时的情感不可控。因此使用中文情感对话语料构建的模型在情感一致性、情感恰当性等方面存在的问题较多。(2)英文数据集来源广泛,既有对论坛评论的收集,也有来自于电影台词的整理,更适合用作模型的训练,使用英文数据集训练的模型更多地为了提高情感生成内容方面的效果。

3 情感对话生成模型

受到统计机器翻译的启发,Ritter 等人提出一个短文本的回复生成概率模型,激发了研究者对于生成式概率模型的研究。Shang等人、Mou等人、Wu 等人、Li 等人在大规模数据上训练的神经模型为对话生成的研究提供了基础,之后各种神经模型被广泛地应用于对话生成研究中。根据对现有基于端到端的情感对话生成模型的研究,本文将对主流的序列到序列模型(sequence to sequence,Seq2Seq)、层级编解码器模型(hierarchical recurrent encoderdecoder,HRED)、变分自编码器(variational autoencoder,VAE)和基于Transformer的对话生成模型以及与每种模型相关的情感对话生成模型的应用进行介绍。

3.1 基于Seq2Seq 的情感对话生成模型

序列到序列模型(Seq2Seq)是由Sutskever等人提出的一种神经网络模型,最初的工作是在机器翻译上进行的。之后Bengio 等人提出注意力机制,进一步提高了机器翻译的效果。Cho 等人成功地将Seq2Seq 模型应用于对话生成中,成为了开放域对话生成研究的主流模型。Seq2Seq 模型包括三部分:编码器、解码器和中间向量。经典的Seq2Seq模型如图2所示。

图2 Seq2Seq 模型结构Fig.2 Structure of Seq2Seq model

编码器与解码器通常以循环神经网络(recurrent neural network,RNN)、门控循环单元(gated recurrent unit,GRU)以及长短期记忆网络(long shortterm memory,LSTM)为基础。给定一个包含个词的消息序列=,,…,x,…,x,目标是生成一个包含个词的回复=,,…,y,…,y。模型不断调整参数,得到最理想的输出序列。编码器能够将当前输入编码成中间向量,其计算方式如式(2)所示。

其中,h是编码器编码形成的中间隐藏状态,对每一时刻的隐藏状态联合起来进行变换可以形成中间向量,为了方便计算,将最后一个时刻的隐藏状态看作中间语义向量。 x代表当前输入。解码器解码过程刚好与编码过程相反,在解码阶段,生成的输出是利用编码器生成的中间语义向量和上一时刻解码器解码的输出共同生成当前输出,计算概率分布,预测下一时刻输出的词:

Seq2Seq 功能强大,易于扩展,在单轮对话生成方面取得了很好的效果,但是对于多轮对话中较多的对话记录,模型回复生成的效果不佳。

鉴于Seq2Seq 模型在对话生成方面的良好表现,许多研究者选择该模型作为情感对话生成模型的基础。

研究者基于Seq2Seq 模型针对情感嵌入编码任务开展了大量的研究:Zhou 等人首次提出了基于Seq2Seq 模型的情感聊天机(emotional chatting machine,ECM),ECM 使用情感类别嵌入模拟情感表达,实现情感向量的编码,对解码器进行改进,实现情感语句的生成。Shantala 等人在一个Seq2Seq 模型上调节回复情绪,以类似于单词嵌入的方式训练情绪嵌入。在回复生成阶段,系统不仅可以生成内容恰当的语句,而且还可以生成期望的情感语调和话语。Huang 等人在学习的过程中将期望的情感与输入连接起来,实现了情感的表达。Yuan 等人应用Seq2Seq 框架,以给定的消息和分配的情绪标签生成情感回复。为了产生一致情绪的回复,使用情感嵌入指导情感化过程。Sun 等人应用一个Seq2Seq 框架,并且通过使用一系列转换来改变模型的输入解决对话生成的情感因素。Zhou 等人在Seq2Seq 的基础上应用了一种注意力机制,捕捉上文的情绪并将其整合到回复生成中。Huang 等人对Seq2Seq 框架进行改进,能够在传达给定情感的同时自动生成回复。Wei 等人在Seq2Seq 框架的基础上增加了一个情感偏置回复生成器,解决生成回复中忽视情感信息的问题,同时对消息中的语义和情绪进行编码,产生更智能的回复,并恰当地表达情绪。Song 等人对Seq2Seq 框架以基于词典的注意力机制进行扩展,确保特定的情感词插入文本中,以显式或隐式地表达期望的情感。Guo 等人提出了一种基于Seq2Seq 框架的动态情感对话生成模型,结合了基于词典的注意力机制,提高了对话生成质量。Chen 等人对Seq2Seq 框架扩展,增加了情感感知生成器,从而提高了情感回复的恰当性。Zhou 等人在Seq2Seq 框架的基础上,结合了基于词典的注意力机制,该机制鼓励用情感词典中的同义词来替换单词。Ma 等人提出了一个情感和上下文敏感的对话生成Seq2Seq 模型。在模型中对话语的编码增加了词级和话语级的情感信息,增强了情感的模型表征能力,生成满足语境的情感语句。

为了对回复中的情感进行控制生成,大量的研究者基于Seq2Seq 框架开展了回复情感控制任务研究:Colombo 等人基于Seq2Seq 框架使用连续的情感表征,能够按照可控的方式生成有情感的回复。Ma 等人基于Seq2Seq 框架提出了一个由情感通道和词级注意力组成的控制单元框架,获得了更好的情感回复。Asghar 等人将情感控制理论(affect control theory,ACT)引入到Seq2Seq 框架中,产生了情绪一致的回复,并考虑了交互者的身份。Sun等人提出了一种基于Seq2Seq 框架的对话内容生成模型,使用强化学习的方法,生成了更有意义的情感回复。Li 等人将Seq2Seq 框架与生成式对抗网络(generative adversarial networks,GAN)相结合,生成了更高质量的情感回复。

情感回复内容的好坏也是研究者的关注点,因此情感回复生成解码任务成为了情感对话生成研究的热点:Asghar 等人基于Seq2Seq 框架使用情感维度方法对情感建模,能够将情感的多样性融入到解码器的生成回复中,解决了在对话生成中的情感内容回复问题。Zhong 等人基于Seq2Seq 框架使用情感维度方法标注嵌入词,解码生成的回复不仅符合语法和语义,还具有丰富的情感。Liu 等人提出了一个基于Seq2Seq 框架的情感自然语言回复模型,将对话的情感状态编码为分布式嵌入到回复生成过程中。Peng 等人提出了一个基于Seq2Seq 框架的话题增强情感对话生成模型,使用动态情感注意力机制自适应地输入与文本相关的情感信息,产生了丰富的情感回复。Sun 等人将GAN 网络的机制应用到Seq2Seq 模型中,推动系统生成最接近人类对话的语句。Sun 等人提出一种基于Seq2Seq 框架的多阶段双向异步解码器,该解码器充分利用语法约束,保证回复的流畅性和语法性。

为了更清晰地描述基于Seq2Seq 框架的情感对话生成模型的研究现状,本文根据模型涉及的三个子任务、解决的问题、使用的数据集、涉及的评价指标以及模型的性能对这一类情感对话生成模型的研究现状进行了梳理,如表3~表5 所示。在评价指标方面,A.E 代表自动评价,M.E 代表人工评价。A.E 主要包括困惑度(perplexity,PPL)、BLEU、ROUGE、Embedding、Distinct、EC(emotional consistency)以及Accuracy。M.E 使用人工的方式对内容(content)、情感(emotion)、语义连贯性(syntactic coherence)、自然(natural)、情感恰当性(emotional appropriateness)、语法正确性(grammatical correctness)、上下文连贯性(contextual coherence)、逻辑性(logic)等方面对模型的性能进行打分。

表3 情感嵌入编码任务研究Table 3 Research on emotional embedding encoding task

表4 回复生成情感控制任务研究Table 4 Research on emotional control task of responsive generation

表5 情感回复生成解码任务研究Table 5 Research on decoding task of emotional response generation

3.2 基于HRED 的情感对话生成模型

为了解决Seq2Seq 模型对于上下文依赖差的问题,Serban 等人提出了层级编解码器模型(HRED),并且取得了很好的效果。如图3 所示,该模型由话语级编码器、话语间编码器以及响应生成器三个网络组成。首先话语级编码器将每个话语中的词序列向量表示转换为话语的向量表示,以此捕捉每个话语的语义信息。然后,话语间编码器将多个话语的序列表示转换为对话上下文的向量表示,并提高对话上下文间的相关性。最后响应生成器获取话语间编码器的隐藏状态,预测下一个话语中的概率分布,生成过程中的预测取决于话语间编码器的隐藏状态。

图3 HRED 模型结构Fig.3 Structure of HRED model

由于HRED 模型可以更好地关注于上下文信息,提高对话上下文的关联性,也被研究者应用在情感对话生成的研究中。例如:Xie 等人对HRED 框架进行改进,构建了一个多轮情感对话系统。通过额外的情感向量对话语建模,并且增加了一个学习数据集中情感交流的情感编码器,使得多轮对话系统能够识别和产生情感上恰当的回复。Lubis 等人扩展了HRED 模型,并增加了一个情感编码器,以捕捉对话的情感背景,上文中的情感将对回复的生成产生影响。本文将基于HRED 框架的情感对话生成研究以及涉及的问题、任务、数据集、评价指标以及模型的性能进行梳理,如表6 所示。

表6 基于HRED 模型的情感对话生成研究Table 6 Research on generation of emotional dialogue based on HRED model

根据对现有的基于HRED 框架的情感对话生成研究现状的整理,可以发现:基于该模型的研究,一方面关注于上文中的情感背景对于回复生成的影响,另一方面关注对话互动者之间的情感变化,因此HRED 框架相对于Seq2Seq 框架的优势在这两个问题上比较明显。除此之外,正因为HRED 模型提高了对上文的关注,用来构建多轮情感对话系统也是一个很好的基础模型。

3.3 基于VAE 的情感对话生成模型

由于变分自编码器(VAE)可以将给定输入的每个潜在特征表示为概率分布(|),这样的表示方法特别适合表示对话中上下文的内部状态,也可以表示对话上文中的情感状态。因此许多研究者将VAE 应用到情感对话生成研究中,并且取得了很好的效果。如图4 所示,VAE 由编码器与解码器两部分组成,VAE 利用神经网络建立了两个概率分布模型:一个用于原始输入数据的变分推断,生成隐变量的变分概率分布,称为推断网络;另一个根据生成的隐变量变分概率分布,还原生成原始数据的近似概率分布,称为生成网络。因此,VAE是一种生成模型。它引入统计思想在自编码器中加入正则约束项,使得潜在特征满足概率分布,并从中自动生成数据。条件变分自编码器(conditional variational auto-encoder,CVAE)是在变分自编码器之上再加一些额外信息为条件的一类模型,模型如图5 所示。

图4 VAE 模型结构Fig.4 Structure of VAE model

图5 CVAE 模型结构Fig.5 Structure of CVAE model

由于CVAE 可以捕捉对话上文中的潜在变量,而情感对话生成中的情感状态正好符合这个特性,许多研究者应用CVAE 实现情感回复生成,并且取得了不错的效果。Gu 等人将CVAE 中的潜在变量分成情感和内容两部分。然后进一步迫使潜在情绪策略预测目标情绪概率分布。通过使用隐式和显式情感策略,新设计的解码器结合了丰富的控制信息来解码生成回复。Xu 等人提出了生成情绪回复的多任务双注意力框架。利用双重注意力机制结合CVAE,解码基于CVAE 的输出和给定的情感标签生成情感回复,在保证回复多样性的同时控制了回复的情感倾向。Kong 等人提出了结合CVAE 与Seq2Seq 模型的情感回复模型,将情感上下文回复和采样的随机潜在变量连接作为输入并生成回复。显式控制情感回复的方式,提高了生成内容的质量。Yao 等人基于CVAE 模型,引入了情绪门控机制和情绪引导机制,帮助模型基于相同的输入生成多个情绪和语法正确的回复,生成的情感在多样性方面取得了很好的效果。Peng 等人在CVAE 的基础上,使用判别器来约束中间潜在变量,使得该变量能够更好地编码原始文本的情感特征信息,最终生成包含情感的对话文本。Huo 等人在解码结构中配置了一个基于CVAE 的情感感知模块来控制情感句子的生成,并配置一个用于增强主题相关性的主题感知模块,该模型不仅能准确地生成期望的情绪回复,而且在话题关联性方面表现良好。Deng 等人提出了一种基于CVAE 的情感回复生成模型,其中CVAE 中的潜在变量被用于促进对话的多样性,使用双重情感框架控制回复的情感,提高了情感回复的连贯性。基于CVAE 的情感对话生成研究如表7 所示。

表7 基于CVAE 模型的情感对话生成研究Table 7 Research on generation of emotional dialogue based on CVAE model

通过对现有的应用CVAE 模型进行情感对话生成研究的整理,可以发现CVAE 模型在情感对话生成中有很高的应用价值。一方面,它可以很好地解决情感对话上文中难以捕捉的情感状态问题,并且可以进行情感引导以及情感控制方面的研究;另一方面,CVAE 将潜在变量表示为概率分布而不是普通的编码向量,因此将概率分布与情感向量结合进行解码,不仅可以生成指定的情感,也可以提高生成的多样性。

3.4 基于Transformer的情感对话生成模型

虽然Seq2Seq 模型与HRED 模型在对话生成方面取得了不错的效果,但是基于RNN 的Seq2Seq 模型与HRED 模型对于长句以及多轮对话的生成效果却不尽人意。为了解决这个问题,2017 年,Vaswani等人提出一种基于注意力机制的Transformer 模型,该模型引入多头注意力机制,不仅关注当前词,而且更多地关注整个句子中的词,从而获取到上下文的语义,有效解决了长句子文本以及多轮对话效果不佳的问题。

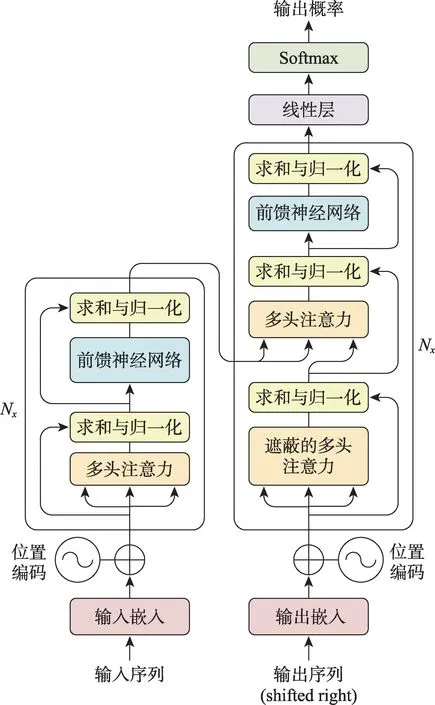

如图6 所示,Transformer 模型也由编码器和解码器两部分组成,对模型进一步细化后可以发现模型是由6 层编码器和6 层解码器组成的。每层编码器包含多个子层,其结构都是相同的,且每一层都是由多头注意力(multi-head attention)和前馈神经网络层(feed forward neural network,FFN)构成。多头自注意力层由自注意力机制构成,其主要目的是使当前节点不仅关注当前的词,而且要对整个句子中的词进行关注,从而获取到句子中的上下文语义。前馈网络层的目的是为增加多头注意力层中输出的向量的非线性变换。

图6 Transformer模型结构Fig.6 Structure of Transformer model

对于Transformer 模型的每层解码器来说,结构也是相同的,与编码器不同之处在于,解码器在编码器结构的基础上增加了一层交叉多头注意力机制层,其主要目的是使编码器的输出向量与当前解码器中输入的向量进行内容对齐,这与Seq2Seq 模型原理类似。除此之外,解码器不再使用编码器中的多头注意力层,而使用遮蔽多头注意力(masked multihead attention)层,其目的为帮助当前节点获取到当前需要关注的重要内容,遮蔽的内容是真实标签序列中当前节点之后的标签。

Olabiyi 等人提出基于Transformer 的对话生成模型,更好地捕捉对话中的长期依赖,模拟了上下文的联合分布,该模型相比其他多轮对话模型,性能有显著提高,对于长句子生成也有很好的效果。鉴于Transformer 模型在多轮对话以及长句子生成方面的优越性,今后以Transformer 模型为基础的对话生成模型将成为一大热点。

由于Transformer 能够关注全局信息,许多研究者将其引入情感对话生成研究。Sun 等人提出了一种基于贝叶斯深层神经网络的情感对话生成模型,利用Transformer 中自注意力充分捕捉整句话前向与后向的信息,使模型在解码过程中得到充分约束,生成高质量的文本。并且引入常识知识,生成了情感丰富、主题明确、句子多样的回复。Li 等人提出一个新的变分模型来产生恰当的回复,可以引发用户的特定情绪。该模型将回复后的下一轮话语整合到后验网络中以丰富语境,并在预先训练的Transformer 模型的帮助下,将单个潜在变量分解成多个连续变量来指导回复生成。基于Transformer 的情感对话生成研究如表8 所示。

表8 基于Transformer模型的情感对话生成研究Table 8 Research on emotional dialogue generation based on Transformer model

通过对Transformer 应用于情感对话生成研究的整理,可以发现Transformer 改进了注意力机制,解决了RNN 存在的长时间依赖问题,可以关注于整句话的影响,对于对话中的上下文语境有着更好的关注。另外,相对于Seq2Seq 模型,Transformer 模型生成语言文本质量较高,更适合作为情感对话生成研究的基础模型。

4 评价方式

基于端到端的情感对话生成回复的质量需要合适的评价指标进行评价,主流的评价方式包括自动评价与人工评价。

4.1 自动评价

在自动评价中,研究者采用机器翻译的方法对模型生成回复与目标回复进行比较用于评价模型的质量,例如BLEU,但是由于这种方法与人类判断的相关性较低,文献[63]认为该方法不适合评价对话生成任务。本文面向情感对话生成中存在的回复生成质量、回复多样性、语义相关性以及情感一致性问题,对相关的自动评价指标进行了梳理。

为了评价模型生成回复质量的好坏,研究者将ROUGE和困惑度(perplexity,PPL)作为衡量情感对话生成模型回复质量的评价标准。

ROUGE 指标是一种通过统计n-gram、词序列和词对重叠等单位来衡量生成摘要质量的指标,包括ROUGE-N、ROUGE-L 以及ROUGE-W。其中ROUGE-L 计算候选句与目标句之间的最长相同子序列(longest common subsequence,LCS),因此被用于对话生成任务中。ROUGE-L 计算公式如下所示:

其中,和分别代表候选句和目标句序列,()和()分别代表候选句和目标句长度,代表超参数常量。

是基于模型自身,衡量语言模型好坏的指标。句子概率越大,语言模型越好,困惑度越小。计算方法主要是根据每个词来估计一句话出现的概率,并用句子长度作标准化,公式为:

式中,代表候选句,()是句子长度,(w)是第个词的概率。第一个词就是(|),而是START,表示句子的起始,是个占位符。

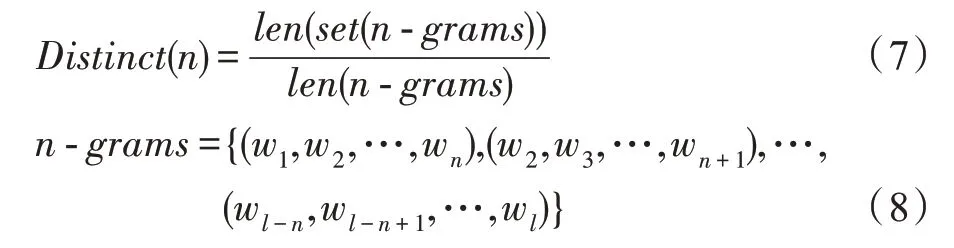

然而研究者在评价回复生成质量的同时,也需要针对回复的多样性展开评价。为了评价回复的多样性,Distinct指标已被研究者所接受。其中文献[63]使用生成回复中不同的Distinct-1 与Distinct-2 的数量计算候选回复中的多样性成为了评价生成模型回复多样性的重要依据。Distinct的计算公式如下:

其中,()表示回复中不重复的数量,表示回复中词语的总数量。()越大表示生成的多样性越高。

为了捕捉生成的回复语句和目标语句之间的语义层面相关性,文献[63]提出基于向量嵌入指标:贪婪匹配法(greedy matching)、向量均值法(embedding average)与向量极值法(vector extrema)。它们将回复映射到向量空间并计算余弦相似度,这几种方法被广泛应用于对话生成语义相似度计算中。

向量均值的计算方式:通过对句子中所有的词向量求均值计算句向量的方法,计算句向量的公式如式(11)所示。

向量极值的计算方法:选择句子中每个词向量的最大维度和最小维度作为句向量的维度表示,极值计算公式如式(12)所示。

其中,代表一个向量的维度,e是的词向量的第维。min 函数指如果最小负值的绝对值大于最大的正值时,取负值。

情感对话生成的关键在于生成带有情感色彩的回复语句。当前主要针对回复生成一致性的情感的评价方式展开研究,衡量回复生成中情感的准确表达。根据文献[44]的工作,研究者设计了基于情绪的度量标准,情绪a。情绪a 是通过构建基于神经网络的情感分类器衡量预测的标签和原始标签之间的情感一致性。情感一致性(EC)计算公式如下:

其中,代表情感类别的数量;y代表如果预测标签与原始标签相同则为1,反之为0;代表语句的数量;代表情感类别索引;e代表目标句指定的情感类别索引。

4.2 人工评价

人工评价涉及人类的判断来评价情感对话生成模型的性能。按照文献[36]的工作,首先随机取样测试数据集中的100 个输入句子。对于每个输入句子,随机化每个模型生成回复的顺序。对于每个回复,需要5 个人工注释者评估两方面:内容和情绪。他们通过3 级评分(0,1,2)和2 级评分(0,1,2)分别从内容层面以及情绪层面评估每个回复。从内容层面评估一个回复是否连贯和对上下文有意义。从情感层面评估决定了一个回复是否揭示了期望的情感属性,例如情感一致性、情感多样性等,具体分值的含义如表9 所示。当然评分标准并不唯一,文献[57]则使用分级评估量表对生成的回复进行评分,其中0=非常糟糕,1=差,2=边缘,3=不差,4=好,5=惊讶。使用人工评价对本文的模型以及基线模型进行对比,比较模型性能的好坏。

表9 情感对话生成人工评价标准Table 9 Standard of emotional dialogue generation manual evaluation

通过对当前情感对话生成模型评价指标的整理,可以发现:一方面,对话生成中的自动评价指标主要延续机器翻译的评价方式,针对候选句与目标句的匹配衡量对话生成回复质量的好坏显然是不合适的。因此,针对情感对话生成自身的特点,设计衡量回复生成多样性、回复内容逻辑性、情感恰当性等问题的自动评价指标是必要的。另一方面,当前的人工评价方式主要通过人为的方式进行衡量,这样的方式经济成本高,且不易普及。因此,如何对人工评价方式进行改进,将成为情感对话生成面临的一大难题。

5 未来展望

通过对现有研究的梳理,本文对基于端到端的情感对话生成研究方向进行了展望。

(1)构建高质量的情感对话数据集。现有的对话数据集分别是从社交媒体或者影视资料中获得,因此存在大量的错误以及噪音,适合情感对话生成模型训练的高质量情感对话数据集相对匮乏。未来,可以参考对偶学习的方式,使情感对话模型实现自我对话,收集对话内容作为情感对话数据集。

(2)控制情感对话模型的回复逻辑。对话生成模型回复语言的逻辑性一直以来都是困扰研究者的一个重要问题,情感对话模型增加了情感信息使得这一问题尤为突出。数据驱动的情感对话生成模型的回复质量会受到数据集质量的影响。因此,一方面,引入文本推理技术对对话逻辑推理展开研究,可以作为未来研究者的研究方向;另一方面,使用知识图谱的技术提高对话上下文中的指代,加强主题、情感与知识三者之间的联系,生成符合主题逻辑、指代准确且情感丰富的语句,可以更好地模拟人类的交流方式,生成更有意义的语句。

(3)考虑个性化的情感回复生成。当前已经有许多研究者针对角色以及个性化的对话生成开展了研究,但是这些研究更倾向于学习角色的对话风格,在真实的对话场景中,不同的角色表达情感的方式是不同的。因此未来研究者应该面向角色与情感结合的对话生成建模,引入不同角色的情感表达方式以及表达风格,例如温文尔雅的角色在表达情感时是含蓄的,而性格直爽的角色表达情感是直接的。这样的研究可以使对话生成研究更符合人类的表达习惯。

(4)在情感对话中加入情绪引导机制。当前的情感对话生成研究中的情感回复生成大多数针对指定情感进行回复生成,这与真实的人类对话场景存在差异。为了使情感聊天机器人走入人类的日常生活,构建能够随着用户情感变化而生成恰当情感回复的情感抚慰机器人是必不可少的,因此在情感对话生成中构建符合心理学逻辑的情感引导机制是未来可行的一项研究。

6 总结

随着深度学习技术的发展,情感对话生成模型已经被越来越多的研究者关注,构建符合人类正常表达的情感对话系统是研究者努力的方向。因此,情感对话生成模型不仅仅要实现情感的表达,而且对于生成语言质量以及对话逻辑有着更高的要求。本文面向基于端到端的情感对话生成研究开展综述,首先对现有的研究进行整理并总结了情感对话生成研究的任务组成,并对解决的问题进行了定义和总结;其次对现有研究所需的情感对话数据集进行了总结;然后针对基于端到端的情感对话生成研究涉及的基础模型,分别从原理以及研究现状进行了梳理;最后对当前研究中模型的评价方式进行了总结。