网络环境下全景图和点云数据快速融合可视化方法

2022-02-11陈逸东张昀昊黄华平吴思豪

朱 军 ,陈逸东 ,张昀昊 ,黄华平 ,吴思豪 ,赵 犁

(1.西南交通大学地球科学与环境工程学院,四川 成都 611756;2.中铁二院工程集团有限责任公司,四川 成都610031;3.四川豪格远景市政建设有限公司,四川 成都 610036)

伴随空天地一体化观测技术的发展,地理数据获取能力不断提高,获取到的地理数据的属性描述、特征分布和结构关系也普遍呈现多元化的特点[1-2].对同一场景多源数据进行融合可视化,能够帮助用户理解、诠释和探究地理数据的隐藏价值,提升用户分析与利用数据的能力[3-4].激光探测与测距LiDAR(light detection and ranging)技术属于一种主动遥感技术,具备数据采集效率高、目标点定位精确等优点,采集到的激光点云数据具有精确的空间坐标信息,因此具备较好的可量测性[5-6].但是单独对三维点云数据进行可视化难以体现三维场景丰富的纹理细节,可视化效果不佳,而全景图数据由一系列多视角图像构成,其完整的记录了场景全视角下完整且真实的影像信息,全景图的可视化能够为用户提供身临其境的视觉体验[7-9].因此,可将三维点云数据与全景图数据融合可视化显示[10],在为用户提供真实感强烈的可视化效果的同时,用户也能利用点云数据精确的空间位置信息进行场景交互分析.

目前的激光点云与光学影像匹配融合过程可拆分为以下3个步骤:观测值提取及预处理、配准模型建立、配准参数优化[5].观测值提取可分为基于区域、基于特征与基于多视几何等多种方法.在基于区域的方法中,基于灰度区域的配准方法是一种直观、简便的方法,此方法主要着重对比所选区域内的影像信息像素点的关联性,特点是不需要进行特征提取与特征描述,但配准速度较慢.基于特征的方法主要思路是提取光学影像与激光点云中具有区分性的特征点、线和面,再根据所提取到的特征对进行配准[11-13].Leberl等[14]提出基于多视几何的方法,对数据源进行转换,把两种特征的数据切换为同等维度的三维点集进行配准,但此方法通常需要较好的初值.光学影像与点云数据具有各自独立的空间坐标系,坐标系的差异及坐标统一带来的误差因素是导致二者融合困难的主要原因,故配准模型的选择非常重要.常见配准模型可分为共线方程、直接线性变换、角锥体等多种模型[15].其中,共线方程模型属于传感器严格模型,需要原始传感器参数等多种参数,模型较为复杂.直接线性变换简化了共线方程模型,建立像点与物点坐标之间的线性方程,但对于控制点近似分布于同一平面的情况并不适用[16-17].角锥体法对初值的要求较高,有良好的初值才能完成迭代运算[18].参数优化可获得模型参数的最佳估计,方法分为局部优化与全局优化,局部优化容易受到初值的影响,全局优化计算效率较低[5].综上所述,目前方法分别存在步骤复杂、计算效率低、约束条件多等问题,并且对全景数据质量具有较高的要求.但实际应用中,用户通常不希望受限于冗余、复杂的步骤与要求,需求的是低成本、高效率、快速便捷的轻量化匹配融合过程与方法.

在网络环境下的数据组织与调度方式影响着数据的可视化效率,目前,对于大规模点云数据的组织方式主要有四叉树、八叉树、R树等.其中,四叉树的组织方式简单,但组织整体速度缓慢,且数据较为冗余,在数据量增加时,会使四叉树构树深度增加;八叉树索引的组织方式查询精度高,但平衡性与动态性较差,并且在显示的交互性上用户体验较差;R树的组织方式虽然较为多变灵活,但在用户交互性与数据索引速度上有待提升[19],而大规模点云具有数据量庞大、数据结构复杂、点云空间分布不规律等特点,故目前的数据匹配方法与数据组织方式在面对网络环境下的快速融合可视化应用并不适用.

本文提出了一种面向网络环境的全景图与点云数据快速融合可视化方法.降低对全景数据源的要求,简化数据匹配步骤,通过研究建立二维图像与三维点云数据坐标系的映射关系,探究点云数据优化组织与索引方法、动态调度等关键技术,并研究设计融合场景交互分析机制.旨在结合全景图与三维点云数据优势,提高全景图与点云数据的融合可视化效率,为用户提高网络环境下真实感强烈、交互性好的融合可视化场景.

1 快速融合可视化方法

1.1 方法总体设计思路

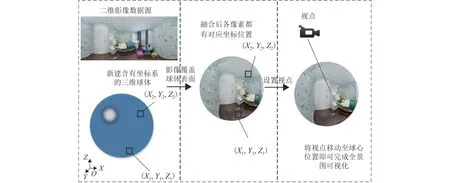

本文的数据层主要包括大规模三维点云数据与二维影像数据.首先进行数据的处理,将二维影像数据进行拼接,创建三维球体,通过添加球体表面纹理的方式,将二维全景图作为纹理进行渲染可视化,使二维影像像素点映射于具有三维坐标系统的球体表面的独特坐标点,将空间视点置于球体中心,以达到全景图的可视化展示效果,并将三维点云数据进行空间可视化,此时即将不同维度的数据匹配问题转换至同等维度的三维数据匹配问题;接下来对两种三维空间可视化数据进行视点的匹配,寻找、匹配数据特征点,并建立空间语义约束,统一相机参数,建立映射关系,实现多源数据的快速映射匹配;再对点云数据的组织与调度方式进行优化,进行多源数据网络可视化,并研究建立跨模态的数据交互机制,完成网络环境下的全景图与点云数据快速融合可视化.

1.2 空间语义约束的多源数据映射匹配

目前,用作于三维数据融合可视化的全景数据的数据采集设备如Ladybug全景摄像机具有高分辨率、多功能拍摄等优点[20],但用户在应对轻量级融合可视化应用时,专业数据采集设备操作较为复杂,无法满足用户对便捷高效的需求,本文所采用的快速匹配融合方法可使用户不需要使用具有坐标系的全景采集设备,例如可将普通智能手机作为全景数据采集设备,降低数据采集设备要求、提高数据采集效率.对采集到的二维影像进行拼接处理,将二维影像映射具有坐标系统的三维全景球,即可完成全景数据的三维球面映射,如图1所示.图中:(X1,Y1,Z1)和(X2,Y2,Z2)为三维全景球上任意两点.

图1 全景图构建三维映射Fig.1 Construction of 3D mapping from panorama

具体步骤如下:

1)将手机采集到的同一视点下的一组多角度图像通过匹配影像边缘信息,多角度拼接,形成无坐标系的二维全景影像数据.

2)创建含有坐标系统的三维球体,使球体上每个位置可用X、Y和Z坐标值进行表示.

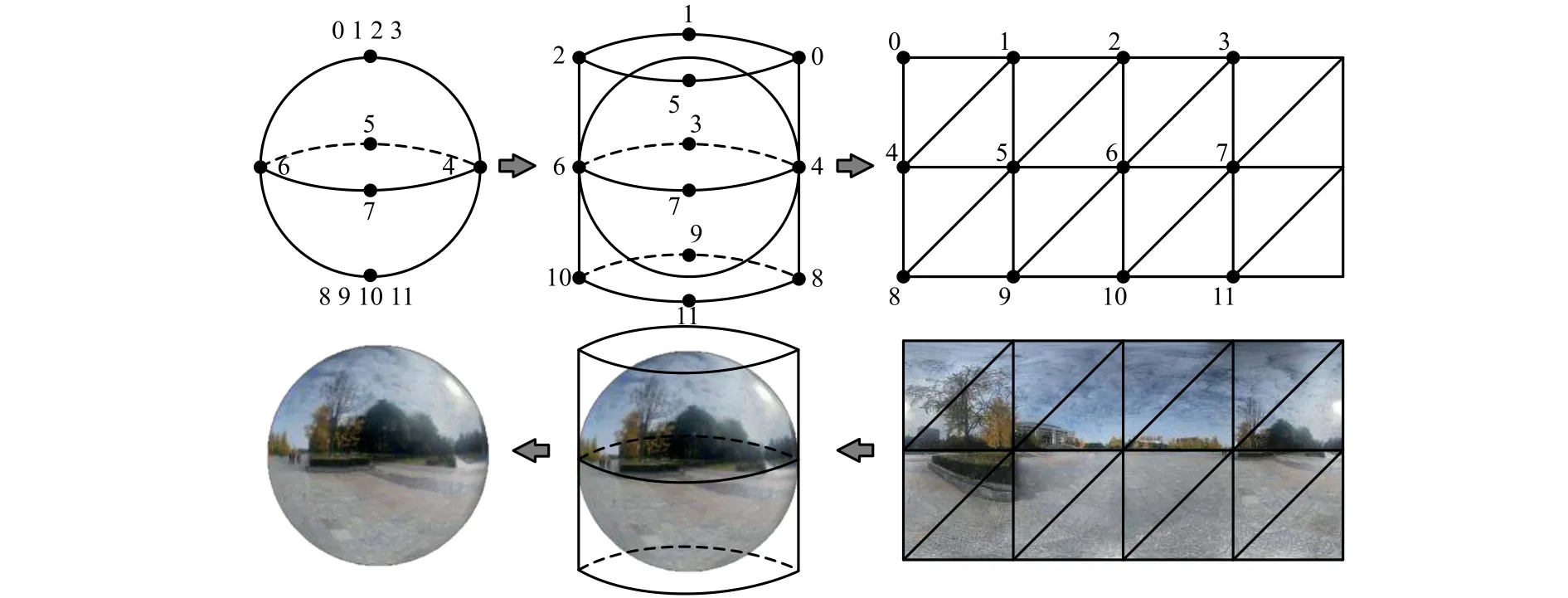

3)通过添加三维球体表面纹理的方式,将长宽比为2∶1的二维影像数据作为纹理进行球体表面渲染可视化,其原理如图2所示,使二维影像数据中的像素点都对应于三维球体表面某一独特位置,并且获取到该位置的X、Y和Z值的坐标信息.图2中:数字1~11表示三维球体到二维平面的对应点.

图2 二维影像映射原理Fig.2 Two-dimensional image mapping principle

4)重新设置视点位置,将视点移动到三维球体的球心,通过球心位置观察球体表面覆盖上的二维全景影像,从而产生空间中360°全方位的全景图视觉体验效果,即完成二维影像数据到三维全景球的快速映射.

完成全景图的三维映射后即可进行三维全景球与点云数据快速匹配融合.目前,主流的匹配融合方法是通过构建数学模型进行参数配准,但在面对轻量化需求时,数据的局限性、步骤的冗余都会降低匹配融合效率.本文的快速匹配融合方法,需要配准基础视点与特征点,并建立空间语义约束,由于相机拍摄的二维全景图在进行三维可视化匹配展示时会导致图像变形,需要通过调整相机参数进行校正,即可完成全景与点云数据的快速匹配融合,步骤如下:

1)在三维点云数据中,定位到全景图拍摄地点A0作为点云数据视点B0,将全景球心移动至该视点,完成基础视点的匹配,但视觉内容信息位置不匹配,此时全景球与点云数据三维坐标系开始重叠,并未建立点集与点集之间的坐标映射关系,只有全景球球心坐标(XA0,YA0,ZA0)与三维点云视点处坐标(XB0,YB0,ZB0)位置匹配,可以作为单个点在不同坐标系下的映射.

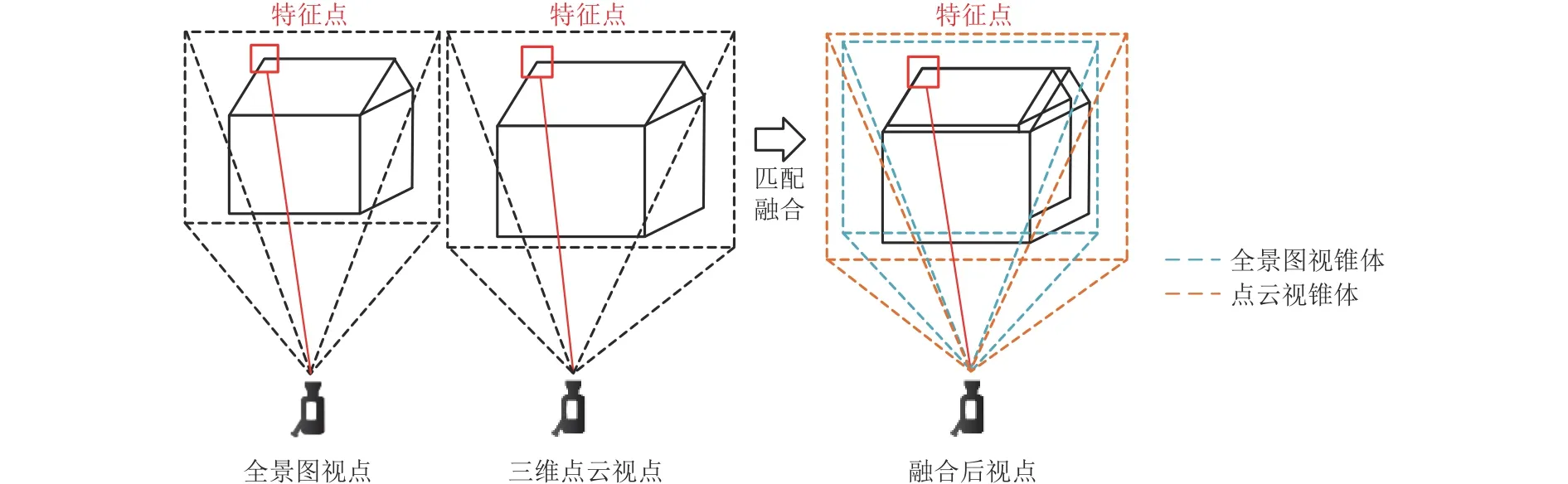

2)寻找两种数据视觉内容中的特征点位组,如图3所示.通常特征点位一般选取视觉特征明显、与周围点位有较强辨识度的点位,如建筑物框架角点、道路拐点、特定物品顶点等点位.在三维空间内两种不同数据源中寻得对应视觉特征点位组(如A1与B1)后,在全景三维球体可视化空间中,以全景球球心A0为旋转中心,通过旋转球体坐标系与全景球球面影像信息,将全景球球面上的特征点A1移动至已可视化的三维点云数据对应空间视觉特征点B1位置即可完成视觉特征点的视觉融合匹配,并记录旋转角θ的值,此时全景球影像各个像素点位具有新的坐标值,并且特征点组A1与B1的坐标值(XA1,YA1,ZA1)与(XB1,YB1,ZB1)也可以作为单个点在不同坐标系下的映射.

图3 寻找特征点Fig.3 Finding of feature points

3)设置空间语义约束,调整视点位置相机参数,以提高全景图与三维点云的视觉匹配度.因全景图数据与三维点云数据采集设备不同,并且新建的全景球与点云自身视点可视化参数、视锥几何体参数不同,从而导致二维全景图像在进行三维可视化匹配展示时会发生图像的视觉变形,即便全景与点云的三维视点(A0与B0)、1 组特征点(A1与B1)完全匹配过后,依旧会使两种数据融合展示后无法完全重合,如图4所示.

图4 匹配后融合不精确Fig.4 Fusion inaccuracy after matching

此时需通过修正相机的视场角(fov)、垂直与水平比值(aspect)、视场体最近距离(near)、视场体最远距离(far)等参数,具体方法为:固定全景球球心A0与三维点云视点B0,以特征点组A1与B1为基准,寻找第2组特征点组A2与B2,更改视点相机的参数,使第2组特征点组完成匹配,要使图4中建筑物进行配准,需将三维点云视点的建筑物缩小,视场角如式(1).

式中:αd为视场角;d为传感器对角线长;f为焦距.

由式(1)可知:为使第2组特征点组A2与B2配准,可增大相机视场角以达到建筑物上两组特征点组都完全配准,两组特征点完全匹配过后,可将同一视点下特征点匹配后的单个影像画面完全匹配融合.

绑定相机、建立映射.根据记录的全景球旋转角θ值,使三维点云视点相机与全景球视点相机的视线方向一致,以达到任意视线方向下,全景信息与点云信息完全匹配,此时快速匹配融合已完成.若用户需要获取、转换任意点位在两组坐标系下的具体位置信息,可通过建立全景球坐标系与三维点云坐标系之间的映射关系实现,具体步骤如下:

1)通过之前获取到的单个点组(视点A0与B0,特征点Ai与Bi,i=1,2,···,N)在不同坐标系下的坐标构建两个点向量A与B(点数越多,精确度越高),N个特征点构建的点向量坐标为(PA,PB),其中PA= (PA0,PA1,···,PAN),PB= (PB0,PB1,···,PBN).

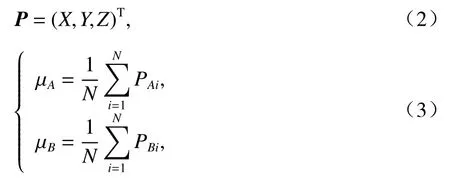

2)计算点向量中心点坐标.设P为点向量中的坐标点,

式中:μA、μB为计算后的中心点.

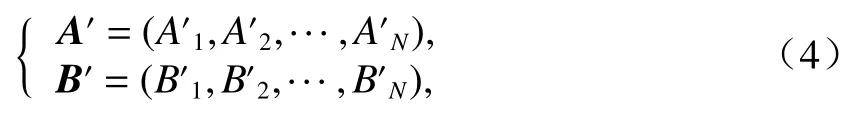

3)点向量坐标重新中心化.重新中心化后得到新的点向量A′ 和B′,如式(4).

式中:A′i=PAi-μA,B′i=PBi-μB.

4)计算两个点集的协方差矩阵H,如式(5).

5)利用 SVD (singular value decomposition)分解计算获得矩阵U、S和V,并计算两个点集的旋转矩阵R,如式(6).

6)最后计算转移矩阵t,如式(7).

7)两个点集的映射关系构建完成,如式(8).

1.3 网络环境下数据组织调度方式

在全景与点云数据匹配融合过后,需要在网络环境下进行两种数据的可视化,全景数据的可视化较为方便,借助 WebGL (Web graphics library)技术对由二维图像映射而成的三维全景球进行渲染,WebGL是一种面向浏览器端三维可视化的三维绘图标准,提供了直接基于GPU硬件加速的三维渲染和浏览器端免插件式的三维图形可视化[21].

而三维点云数据由于其数据量庞大且结构复杂,需要对数据进行优化组织和动态调度.本文充分考虑网络环境下数据传输效率不够且浏览器渲染能力有限等问题,结合三维激光点云数据的分布特点,采用非规则性八叉树对点云数据进行分块组织.传统的八叉树索引使用3个正交平面将三维空间划分为相同大小的8个小立方体,每个立方体具有相同的时间和空间的复杂度,但在复杂的大规模三维点云场景中,点的分布通常不均匀,在物体内与物体框架上分布较为密集,在物体外分布较为稀疏,传统八叉树无法估计空间分布的不规则性,空间利用率较低,导致索引效率不高.不同于传统的八叉树索引,非规则性八叉树不将三维空间等比分为八个区域,而是按照三维场景中点云分布特征将场景进行区域划分,区域边界由点云分布决定,如图5所示.在每一次分割时,需要判断并选择一个合适的分割维度,而不是每次都按照X、Y与Z三维度做3次等比分割.这样将尽量避免叶子节点为空,尽可能地缩小分块区域的体积,有效地避免场景中空白区域数据组织检索时消耗资源,从而提升数据检索效率,能够很好地适应在大规模复杂场景下,点云数据分布不均匀的特点,对点云数据进行高效索引.

图5 基于非规则性八叉树点云数据组织Fig.5 Point cloud data organization based on irregular octree

在对点云数据进行分块组织索引之后,对三维点云数据的可视化时就可以根据点云数据的组织索引进行不同相机视角下的多细节层次的动态调度和渲染,在相机视野范围较大、距离较远时,只调度并渲染低细节层次的点云数据,忽略非重要点位与细节点位的数据,提升可视化效率;在相机视野范围较小、距离较近时,调度渲染高细节层次的点云数据,提升数据显示精度,提供更精细的可视化场景,并在渲染场景时采用视域剔除的方法,高效地进行不同细节层次(level of detail,LOD)下的过渡与衔接,提升调度、渲染与可视化场景的效率,具体视域剔除步骤如下:

1)加载三维点云数据,判断当前相机视锥体内是否包含有第1层点云数据,若有数据被包含,则进行第1层点云数据的渲染.

2)加载第2层点云数据,判断当前相机视锥体内是否包含第2层点云数据,若包含,则进行第2层点云数据的渲染,视域外未被包含的点云数据被剔除,不进行渲染.

3)加载下一层点云数据,相机视锥体发生改变,判断视锥体内是否包含下一层点云数据,若有数据被包含,则进行下一层点云数据的渲染,视域外未被包含的数据不进行渲染,并继续渲染过程,直至视锥体内所有层级的数据加载渲染完成.

1.4 跨模态数据交互机制

在点云与全景数据可视化过程完成的基础上,需要实现在融合三维场景下的交互分析.三维点云数据具有较好的可测量性,每个点都有具体的地理坐标,可准确表达空间位置信息;全景图数据纹理丰富,细节表达真实,可视化真实感强烈,故可将点云作为基础,提供点位坐标值的计算功能,再将结果绘制显示于全景图上,如此将点云数据的可量测性与全景图的真实性进行结合,不仅为用户提供真实感强烈的三维融合场景,并可提供如选择查询、空间量测、区域分析等交互分析功能.本文建立了一套跨模态数据交互机制,具体过程步骤如下:

1)开始交互分析.用户以真实感强烈、可视化效果更好的全景图数据为直接交互数据源,选择交互对象.

2)根据用户选择的交互对象,以屏幕坐标为中间介质,计算并存储屏幕坐标系下交互对象的位置坐标信息.

3)根据屏幕坐标值计算出点云数据地理坐标系下交互对象的坐标值,获取坐标值后可进行数据交互分析所需要的计算,如属性查询、距离量测等.

4)再以屏幕坐标为中间介质,重新计算并存储屏幕坐标系下交互对象的位置坐标信息.

5)根据屏幕坐标值计算出交互对象在全景球坐标系下的坐标值,并将交互分析结果进行绘制展示,完成跨模态的数据交互分析过程.

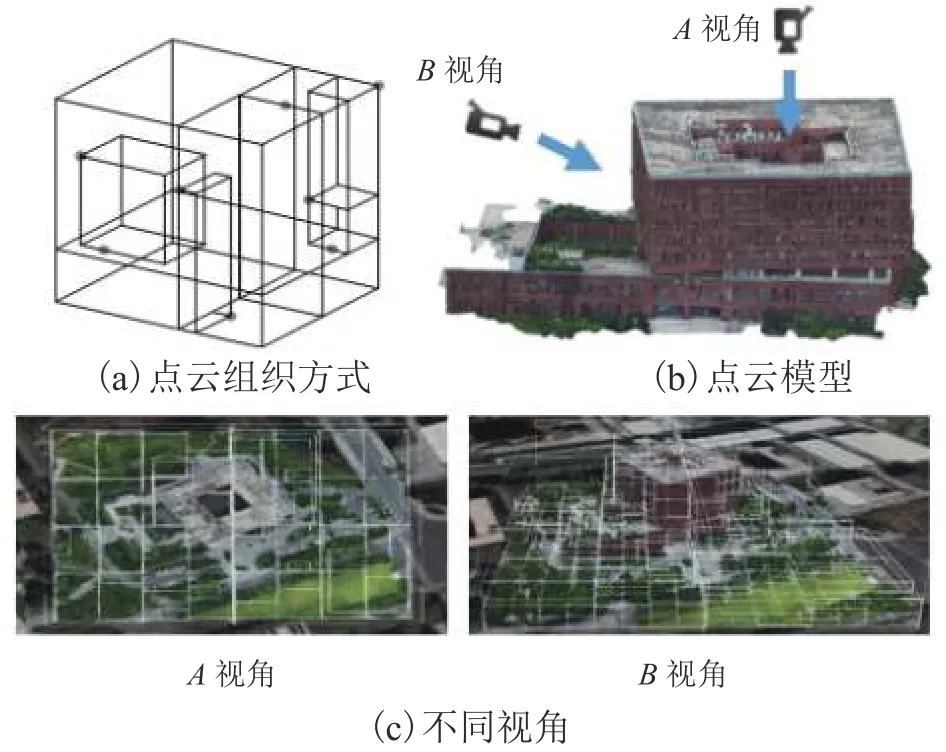

2 实验分析

为验证本文方法的可行性与有效性,在网络环境下利用WebGL技术进行原型系统的研发,并进行多源数据的匹配展示与可视化交互,选择西南交通大学犀浦校区综合楼与图书馆作为实验案例区域,包括三维激光点云数据与Iphone XR等效35 mm相机拍摄并进行拼接的二维全景图数据,其中点云数据的数据量大小为 221 MB,包含 49484157 个点;二维全景图的数据量大小为1.35 MB,分辨率为3 200 × 1 600.

实验系统构建与展示设备为笔记本电脑,其硬件设备为 Intel Core i79750HQ 4.5 GHz 12 线程CPU、32 GB 内存、8 GB 显存的 NVIDA GeForce RTX 2080MAX-Q 显卡,软件环境为 Windows 10 操作系统、Google Chrome 浏览器.

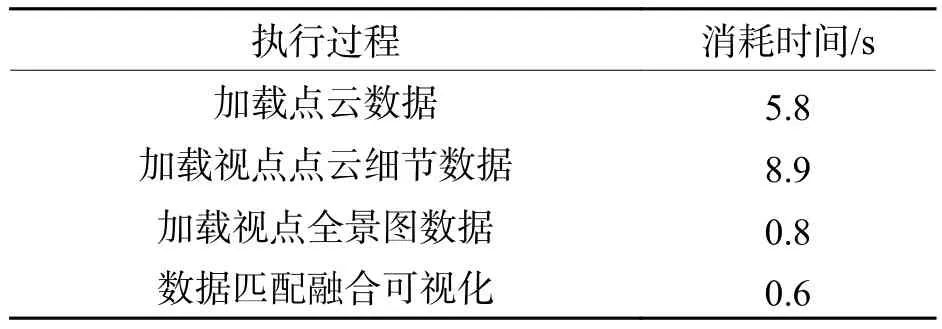

首先只进行全景数据的加载与可视化,性能高效,画面帧率稳定,在需要进行交互时,再对多源数据进行加载与融合,多源数据加载与融合效率通过Chrome浏览器数据加载与相应时间来进行检测,数据加载与融合匹配可视化的过程耗时如表1所示.

表1 不同过程执行消耗时间Tab.1 Time consumed by different processes

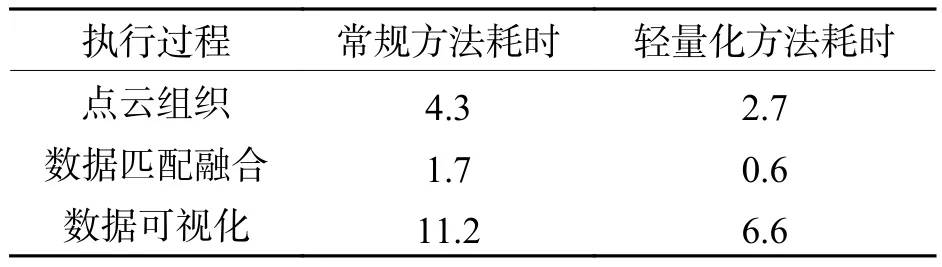

表2是对相同数据源采用常规方法与本文轻量化方法下点云组织、数据匹配融合和数据可视化3个过程的耗时对比.

表2 传统方法与轻量化方法结果对比Tab.2 Comparison of results between traditional method and lightweight method s

如表2所示,采用未经轻量化处理的方式进行数据组织、匹配、融合可视化总体耗时17.2 s,而采用轻量化处理后,总体耗时为9.9 s,由此可证明经过轻量化处理后,整体效率得到大幅度提升.其中采用传统规则八叉树点云索引方式耗时4.3 s,采用非规则性八叉树方式耗时2.7 s;数据可视化过程中,在LOD 1视角(低层级视角)下,可视化数据量为16 MB,耗时 1.3 s,LOD 2 视角(中层级视角)下,可视化数据量为 42 MB,耗时 2.2 s,LOD 3 视角(高层级视角)下,数据量为 72 MB,耗时 3.1 s,轻量化方法总共耗时6.6 s.

4个不同位置数据融合匹配可视化结果如图6所示.

图6 不同位置融合可视化结果Fig.6 Fusion visualization results at different positions

图7展示了融合匹配精度.融合精度的判定,采用融合后点云与对应全景匹配特征点的误差判定,若使用常规匹配算法进行数据匹配,全景与点云数据的匹配精度误差控制可以控制到3个像素以内[22].图7中红框中为选取的图书馆建筑物特征角点,其融合匹配误差控制在4个像素以内,从视觉上可看出:点云数据与全景图融合匹配效果良好,建筑物细节达到了高度重合,匹配效率高,满足网络环境下的轻量化融合数据可视化与交互.

图7 融合匹配精度Fig.7 Fusion accuracy

融合可视化后,本次实验选择点云查询与标绘量测为例展示场景交互过程:在鼠标滑过全景图层时,自动选择点云图层作为查询数据源进行点云属性查询,在属性查询完成后,将查询结果自动显示于全景数据图层,如图8所示.

图8 融合场景属性信息查询Fig.8 Attribute information query for fusion scene

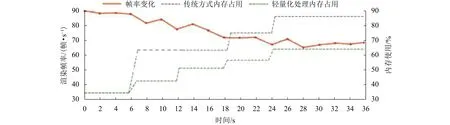

鼠标在全景数据图层选取待测量线段,选择完成后自动根据点云位置信息进行距离量测计算,计算完成后,将结果显示于全景数据图层,如图9所示.不同过程中场景渲染效率如图10所示.

图9 量测标绘交互过程Fig.9 Measurement plotting interactive process

图10 场景渲染帧率、内存使用变化趋势Fig.10 Variation of scene rendering frame rate and memory usage

从实验结果可以看出:采用该方法进行点云数据与全景数据的匹配融合可视化,场景渲染过程中主要耗时较长的过程是数据的加载工作,场景中数据的匹配以及数据的融合可视化过程耗时很少,浏览器响应速度较快,说明该方法数据匹配与融合可视化效率较高;从图10可知:若只进行全景数据的可视化与交互,系统性能稳定,画面渲染帧率能稳定在55帧/s以上,在进行融合数据加载与交互过程之间,场景的渲染帧率能稳定在40帧/s以上,在进行交互过程中,由于点云数据的测量计算过程占据了设备性能资源,导致帧率有所下降,但仍然能稳定在35帧/s以上;采用轻量化处理后,系统内存占用率降低20%左右,效果显著,性能表现良好,具有较好的用户体验.证明该方法有效地结合了全景与点云数据的可视化优势,进行快速高效的数据融合可视化,并支持用户进行稳定的交互操作.

3 结 论

面向当今人们在应对网络环境下数据融合可视化的实际需求,针对当前全景图与三维点云数据匹配、数据可视化与交互方法存在高成本、步骤复杂、效率较低等问题,本文进行了网络环境下的全景图与点云数据快速融合可视化方法的研究.详细阐述了全景图与点云数据的快速映射匹配过程,探究数据网络可视化组织调度方式与跨模态数据交互机制.最后构建原型系统,并以西南交通大学为实验场景,按照前文的理论与方法进行了数据融合可视化案例实验.实验结果表明,在短时间内完成全景图与点云数据映射匹配,匹配精度良好,支持网络环境下融合场景的高效可视化及数据的查询、量测标绘等交互分析,并且整个过程渲染帧数能够稳定在40帧/s以上,能够提供效果较好的用户体验,满足网络环境下的全景与点云数据快速融合可视化的需求.