KubeTelecom:一种面向5G网络切片的多云多容器集群管理与运维引擎

2022-01-17武宇亭王旭亮全硕

武宇亭,王旭亮,全硕

KubeTelecom:一种面向5G网络切片的多云多容器集群管理与运维引擎

武宇亭,王旭亮,全硕

(中国电信股份有限公司研究院,北京 102209)

面向运营商多种网络云化应用的多云多容器集群管理与运维引擎,提出并详细介绍了KubeTelecom的设计架构以及实现方案。从5G切片场景的承载需求入手,分析了KubeTelecom为上层应用平台提供多容器集群管理与编排能力以及数据驱动的综合运维能力。展望了未来电信云平台通过集成KubeTelecom模块,可以为多种云原生应用提供统一的资源管理和运维能力,为运营商的多种DICT业务生态发展提供坚实的技术支持。

多云多容器集群;云边协同;5G网络切片

1 引言

5G作为新一代移动通信技术,大量引入了云原生的理念及技术,使能新型网络业务具备弹性、灵活性、敏捷性和快速迭代等传统云计算业务的特点。虽然当前5G建设中,主流电信设备提供商已经基于容器、微服务等先进技术实现了核心网元的部署。但是,以容器为代表的云原生技术在5G中的应用还存在诸多问题。第一,当前电信设备商基于容器安全性的考虑,当前大多采用虚拟机容器方式进行网元承载与部署,设备商的5G设备当前仍以虚拟机的形式对外呈现并交付给运营商,未对运营商提供完全开放容器相关的开发、管理接口,要将云原生技术应用到网络业务的设计与开发、承载与编排、部署与运维等全生命周期中,还有很长的路要走。第二,云原生网元部署对基础设施提出了更高的技术要求,国内运营商对于与云原生基础设施相关技术的研究还处于起步与验证阶段,缺乏有效管理、使用、运维、运营多DC(datacenter)、多容器集群的相关能力。因此,本文以5G网络切片应用的需求为出发点,提出了一种在边缘云和核心云之间通过多容器集群管理与运维引擎,解决5G网络切片业务的云资源横跨多个云资源池时,带来网络切片功能所需的云原生资源管理、编排与运维等问题。

1.1 5G网络切片的云化部署与运维需求

5G网络功能采用虚拟化的部署方案,根据欧洲电信标准协会(ETSI)的网络功能虚拟化(network function virtualization,NFV)工作组发布的NFV白皮书[1]以及面向5G的NFV技术白皮书[2]中的介绍,5G网元相比于传统网元设备,在设备形态上主要是采用容器虚拟化技术部署在通用IT服务器之上。同时5G切片服务主要依赖于ETSI NFV提出的NFV MANO(management and orchestration)编排系统实现5G网络服务的调度与编排。NFV MANO系统中关于5G网络切片迫切需要跨云资源池云原生资源的编排管理主要依赖于虚拟基础设施管理器(virtualization infrastructure manager,VIM)实现。VIM在传统的物理机和虚拟机编排框架之上通过文献[3]中的定义的CISM(container infrastructure service management)模块负责容器服务的部署、监控运维以及生命周期管理,业界多数人认为当前开源的Kubernetes容器管理系统实现了CISM中定义的大部分工作。通过在VIM中集成和扩展对CISM定义的工作的支持,运营商的电信云可以实现对5G切片业务所须容器服务的承载。

经过深度调研与分析,发现上述方案只存在理论上的可行性,距离生产系统还有较大的差距。一个面向5G网络切片业务的电信云承载平台通常需要考虑多租户管理、多业务之间的隔离性、租户运维策略独立性、业务部署的可用性、高并发、云资源的容灾与备份、容器集群的跨云资源池的分布式部署等核心要素。直接在电信云的MANO管理系统中集成Kubernetes容器集群的方式显然是无法满足上述需求的。

1.2 面向电信业务的云管平台

运营商通过云管平台可以实现电信级VNF的云化部署。该平台不仅重点实现了ETSI NFV MANO中VIM模块定义的核心功能,还根据电信云特点实现了多级的监控与告警系统以及级联部署等重要功能。根据电信云的需求与特点,以省为单位的VIM共包含两个层级,分别为省级节点与边缘节点。在省级节点部署管理边缘节点内多个OpenStack的业务网关,该网关实现了对省内多个边缘节点云资源的管理与调度。在边缘节点按需部署一个或多个OpenStack集群,每个集群向上层业务系统提供物理机、虚拟机以及容器集群服务。但是当前云管系统只能提供管理与运维多个独立的Kubernetes集群的能力,5G切片依赖端到端资源联动,在采用Kubernetes承载时,需要多Kubernetes集群实现统一管理与协同。因此,云管系统目前无法满足5G切片的云化承载需求。解决该问题,可以从如下两个方面考虑:一方面由5G切片业务系统本身实现对多个Kubernetes集群的管理与运维另一方面在云管平台内扩展实现对多个Kubernetes集群的管理与运维能力,然后向5G切片业务系统提供整体的多容器集群管理与运维服务。

1.3 多云多容器集群管理与运维引擎

从云计算资源集约化管理与运营以及对多种业务统一承载的角度,本文提出KubeTelecom,即一种在当前统一云管平台上扩展实现多云多容器集群管理与运维方案,以满足5G切片业务的云化部署与运维需求的方案及原型系统。

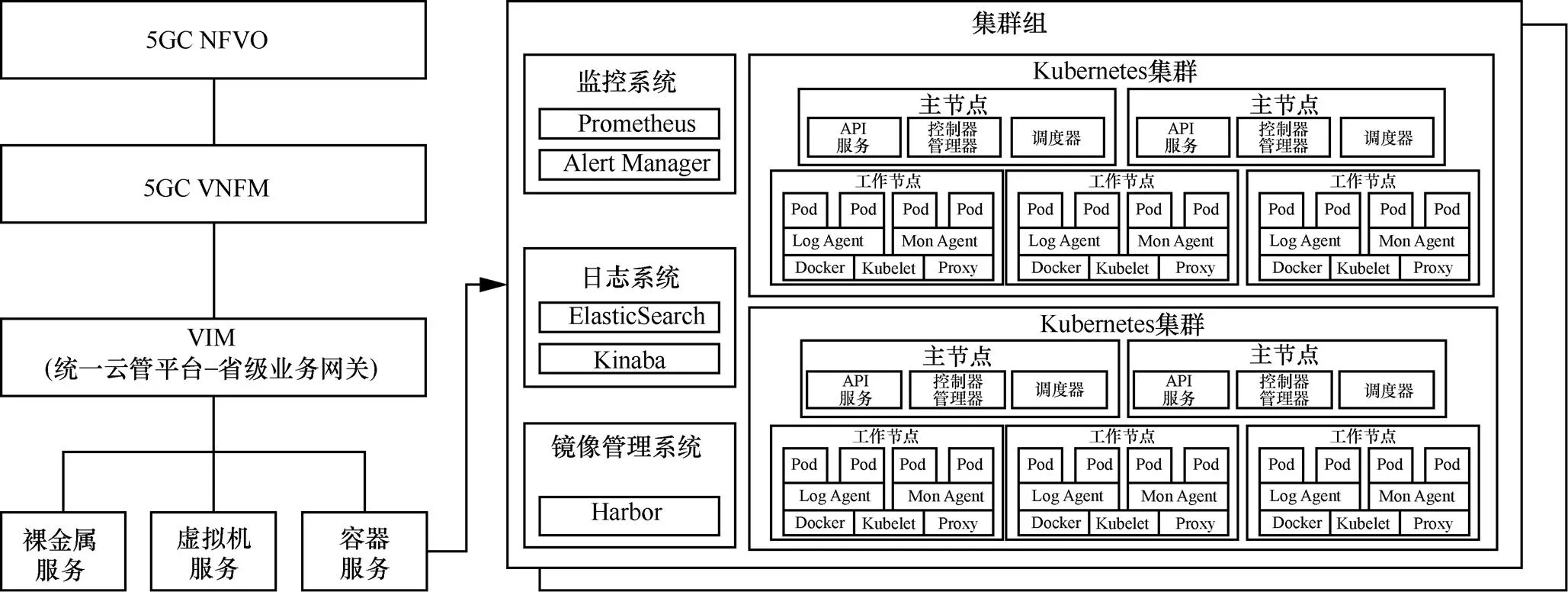

基于云管平台的多容器集群管理与运维引擎总体视图如图1所示,多容器集群管理与运维引擎与现有云管系统集成部署在省级节点。通过与云管平台省级网关交互,调用边缘节点中的物理机与虚拟机资源,为5G切片业务系统按须创建多个统一管理和运维的Kubernetes容器集群,满足5G切片业务跨集群的高可用、高并发、备份与容灾以及云边协同部署与运维要求。具体来讲,为每个5G网络切片租户提供集群组(cluster group)级别的云资源切片。在该逻辑资源切片中可以根据每个租户的需求,实现多个Kubernetes集群的动态生命周期管理功能;此外为了满足每个5G网络切片租户独立的监控与运维策略管理,KubeTelecom还设计并实现了租户级别的监控、日志以及私有镜像仓库功能,为租户提供最大程度的业务部署与运营的灵活性和独立性。

2 相关研究

5G网络切片技术可以使运营商在硬件基础设施中为每个客户按需切分出多个逻辑隔离的网络切片服务。围绕着5G网络切片业务,大量的研究人员作了很多领域的相关工作。

图1 基于云管平台的多容器集群管理与运维引擎总体视图

现有文献主要对网络切片部署问题进行分析,如文献[4]主要针对互联网或EPC(evolved packet core)等网络场景及架构,结合不同的优化目标对切片中的VNF部署策略优化,如采用节点分割算法及业务流量感知算法对vEPC(virtualized evolved packed core)网络池组虚拟网络功能部署,提高网络接收率、降低网络资源开销。文献[5]主要针对核心网网元形成的服务功能链进行网络拓扑优化以及网元功能部署。文献[6]指出为了提高物理资源利用率,运营商通常将不同网络切片实例(network slice instance,NSI)的虚拟网络功能部署在相同的服务器上,并采用资源复用技术实现资源的超额分配。上述文献对网络切片部署的研究主要集中在VNF部署策略优化或提高资源利用率、降低能源消耗方面,未对5G切片业务应用部署及运维管理进行改进。

在现有5G网络部署方案中,边缘计算是网络切片技术的重要支撑。文献[7]指出网络切片和边缘计算融合部署方案的优势,方案中网络切片可通过将网络实体划分成多个逻辑独立网络、为不同业务场景提供所需服务;而边缘计算可利用网络中用户和边缘网络设备的计算和存储功能,承载部分核心节点中的控制、管理、业务功能,能够提升传统移动宽带业务能力和应对新兴的机器类通信业务。通常基于边缘计算的网络切片部署方案,会在靠近移动用户的位置上提供信息技术服务和云计算能力,将内容分发推送到靠近用户侧,而应用、服务和内容都部署在高度分布的环境中,能使得运营商根据第三方需求及网络情况以低成本为用户提供个性化网络服务。

5G网络切片在多数情况下除了无线网络和回传网络之外,更需要考虑在边缘UPF和5G核心网元部分逻辑切片的动态管理问题。文献[8]中提到多云平台统一运营的关键技术包括多云平台的统一纳管、多云平台的统一监控、多云平台的统一分析3个方面。但是成熟的5G网络切片服务更加关注多云平台(核心云与边缘云)向每个租户提供云边协同的多容器集群生命周期管理和运维平台服务,具体表现在面对多云多容器集群时,需要对其进行统一纳管、监控、分析等,实现对各类资源的统一管理运营,获得多云多容器环境的控制权。

基于上述研究分析,本论文重点关注5G网络切片在核心网以及在边缘节点部署的用户面网元(UPF)的云化承载与运维技术方案,具体包括面向5G网络切片的多云多容器集群管理与运维引擎,该引擎主要面向5G网络切片场景,实现多云多容器集群的统一纳管、运营分析,满足5G切片业务的云化部署与运维需求。

3 系统设计与实现

通过在运营商云管平台的基础之上增加针对多租户的多容器集群的生命周期管理引擎设计与实现方案使运营商云管平台可以为5G网络切片业务提供所需要的多容器集群的管理与运维能力。以5G网络切片应用为例,最终实现在云管平台为上层各类应用提供综合的云资源统一承载与管理运维能力,主要从多容器集群的管理引擎和运维引擎两个角度分析。

3.1 多容器集群管理引擎

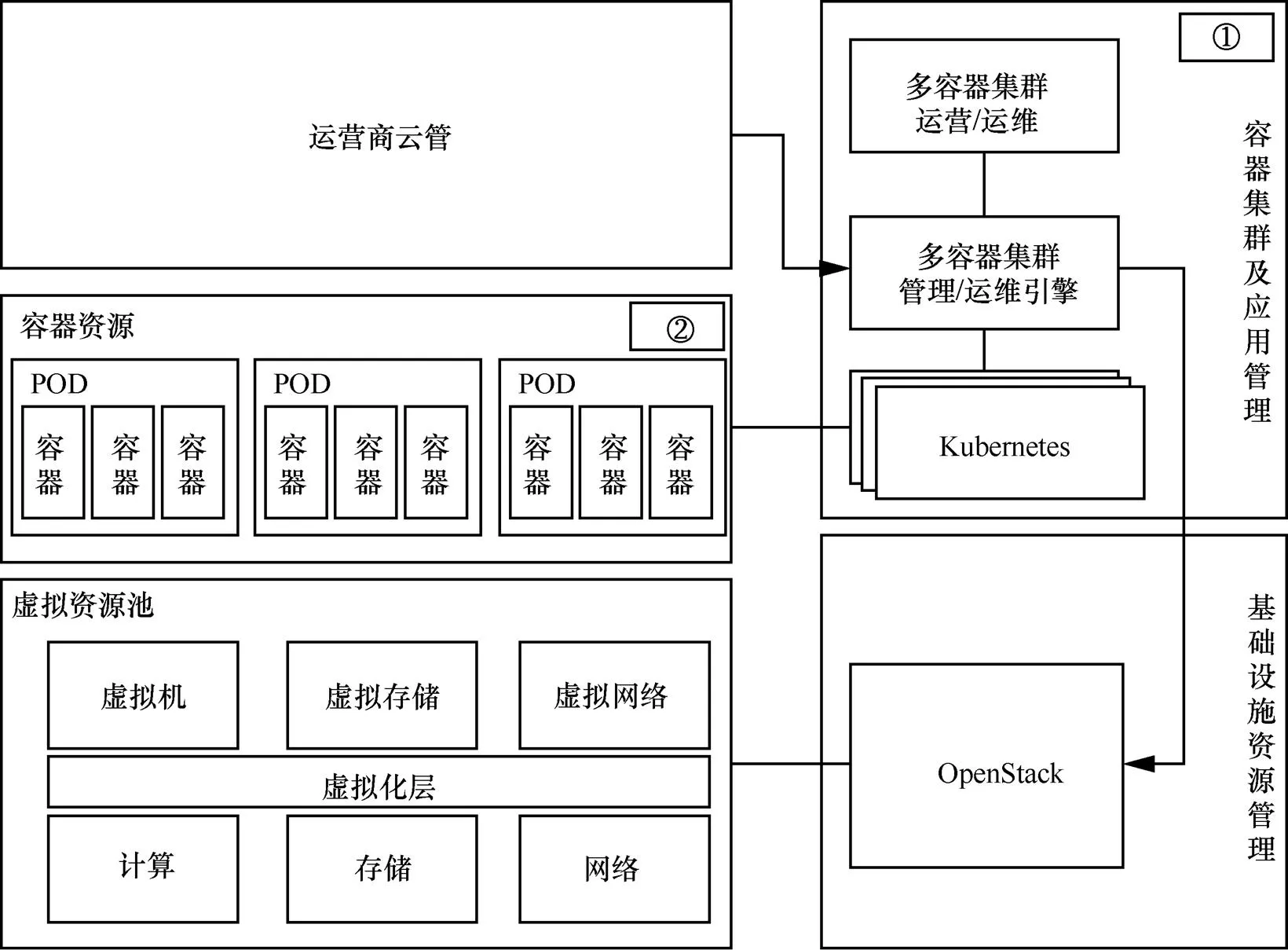

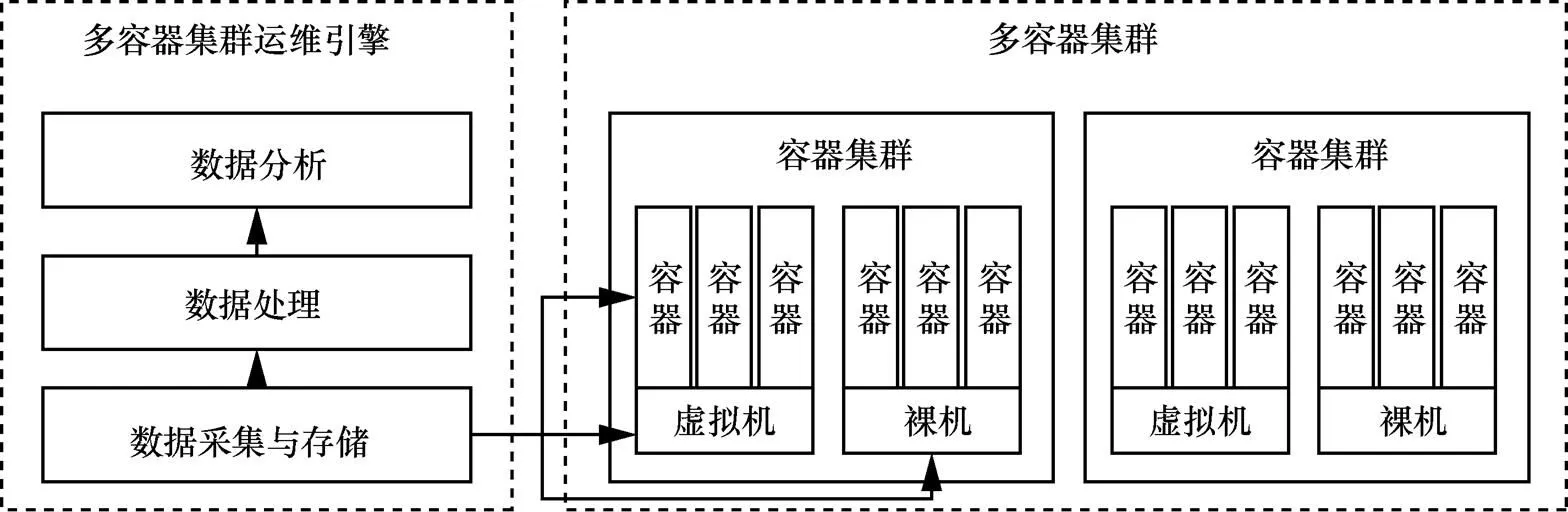

支持多容器集群的电信云整体方案架构如图2所示。在原有的电信云管及OpenStack资源池基础之上引入容器集群及应用管理模块①,该模块的核心是多容器集群管理引擎。通过该模块,在当前基于NFV的运营商云管架构中,增加对于容器资源②的支持,基于容器技术可以实现网元设备软硬件功能的解耦,从而实现对接入网和核心网中网络资源细粒度划分[9],进而满足对5G网络中端到端切片灵活构建的需求[10]。多容器集群管理引擎提供完整的API管理能力,运营商云管可以通过调用这些API实现容器集群的生命周期以及容器化网络切片应用的编排调度能力。

多容器集群管理引擎创建的容器集群以及承载的容器化网络切片运行在传统的虚拟化资源池上,为了达到上述目的,多容器集群管理引擎应该具备和基础设施资源对接的能力,从而创建出承载5G端到端网络切片容器集群的计算、存储、网络等虚拟资源。

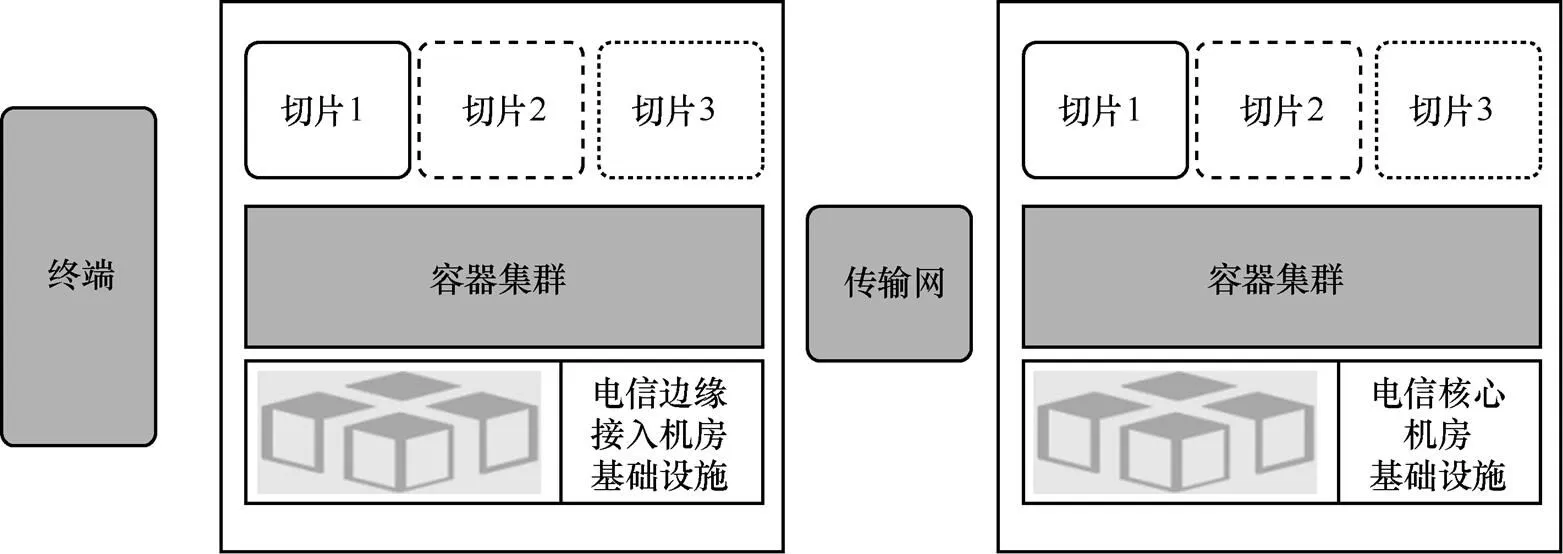

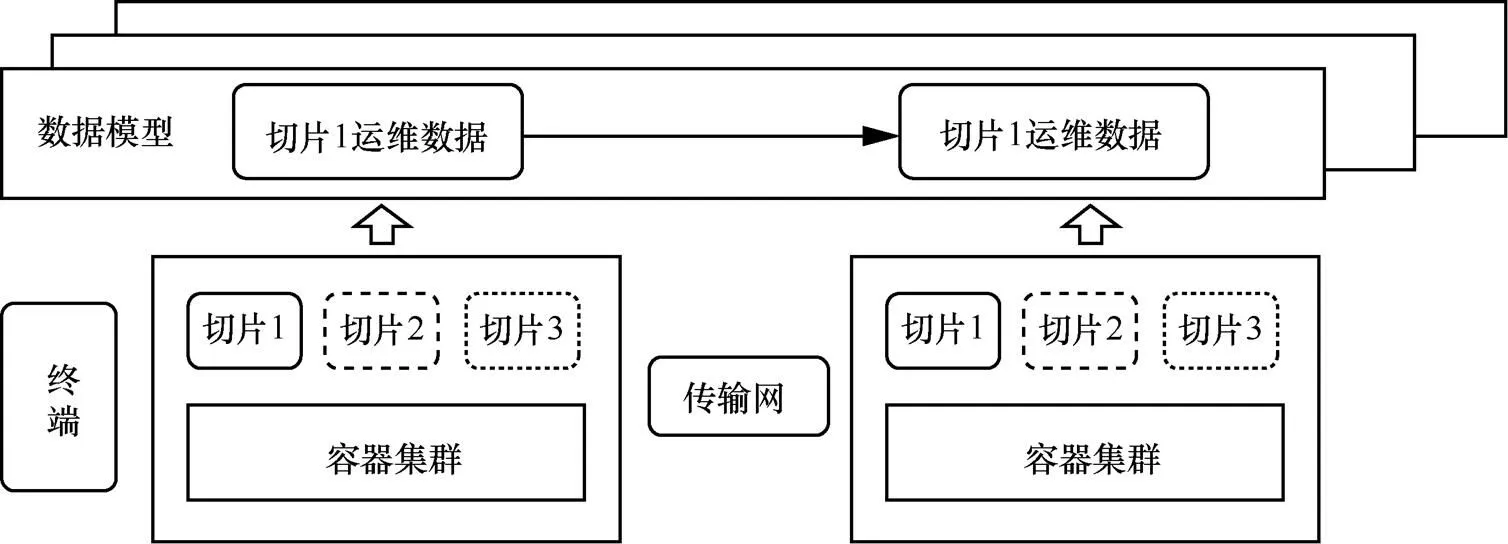

多容器集群管理平台的核心是多容器集群管理与运维引擎,基于多容器集群的5G网络切片端到端承载示意图如图3所示,端到端的5G网络切片主要依赖电信接入网和核心网,也就是说需要边缘接入机房和核心机房承载。通过多容器集群管理引擎,可以在当前承载5G的边缘接入机房、核心机房的基础设施之上实现Kubernetes容器集群生命周期的管理能力,从而为5G端到端的不同网络切片(如图3中切片1、切片2、切片3所示)的容器化承载提供基础环境。通过运维引擎,提供了集群本身及容器化应用的可视化能力,为集群及应用的可靠运行提供了有力保障。

3.1.1 多容器集群引擎整体架构

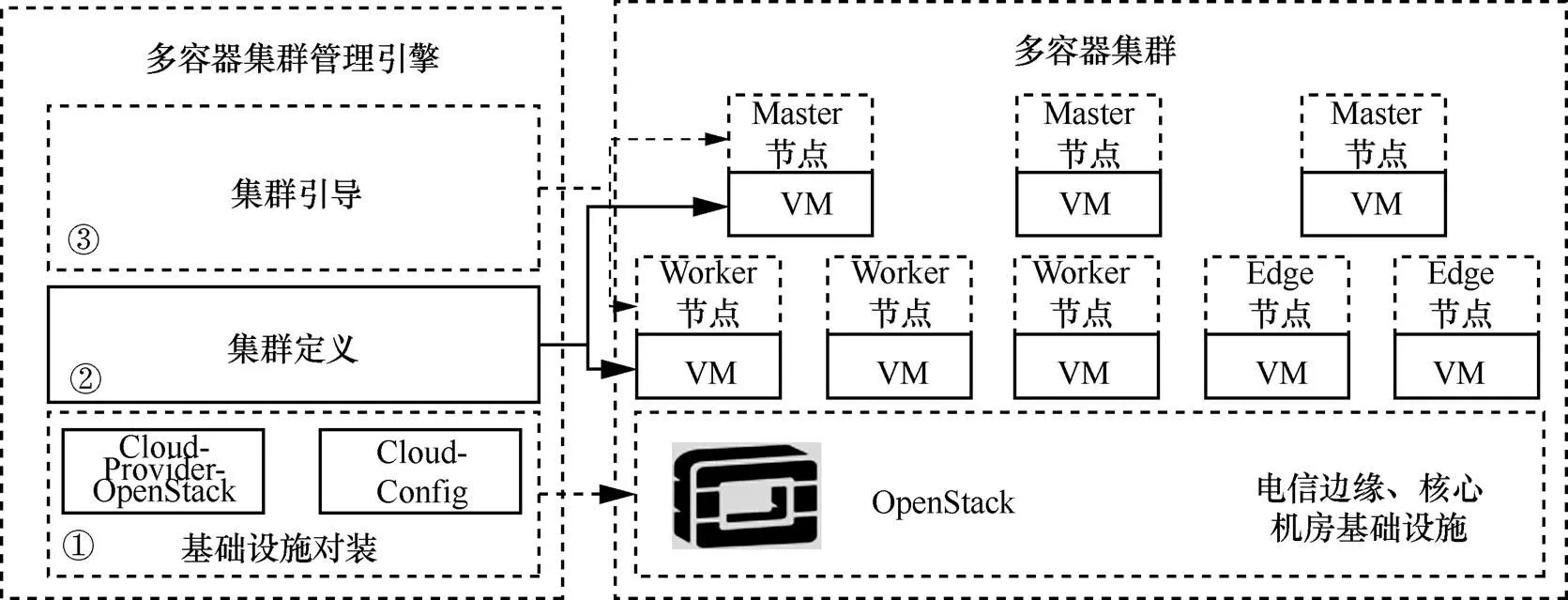

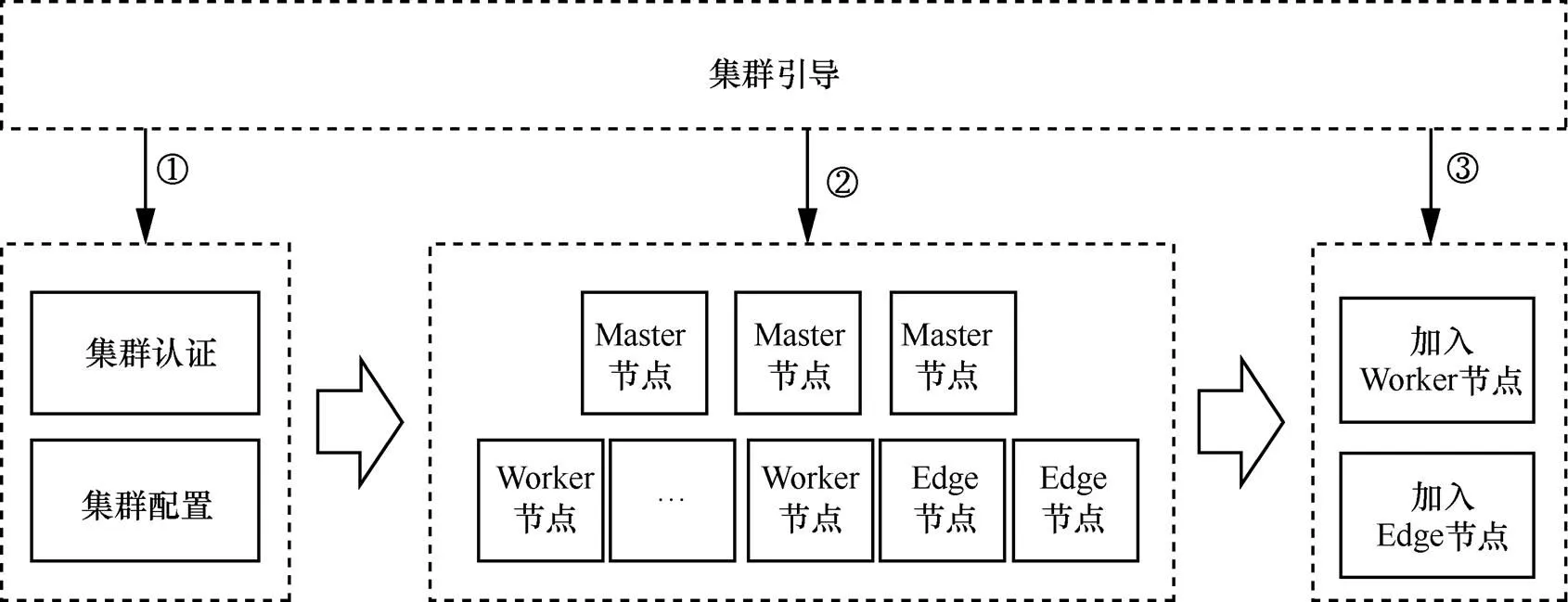

多容器集群管理引擎主要功能架构如图4所示,其整体分为3个部分。首先,基础设施对接模块①主要提供与电信接入边缘机房的基础设施、电信核心机房基础设施的交互能力,从而为创建容器集群准备好所需的计算、存储、网络等基础设施资源;其次,集群定义模块②主要实现集群所用虚拟机镜像、规格、Master节点数量、Worker节点数量等的定义;最后,集群引导模块③主要用于Kubernetes集群的创建等生命周期管理能力。各模块均提供对应的API,通过这些API可以实现集群的创建、配置和管理。

图2 支持多容器集群的电信云整体方案架构

图3 基于多容器集群的5G网络切片端到端承载示意图

3.1.2 基础设施对接

端到端5G网络切片是一种跨域的技术方案,需要在电信统一的边缘接入机房、传输网、电信核心机房的基础设施上容器化多个网络功能,进而实现端到端的网络形态。因此,多容器集群管理引擎的基础设施对接模块,如图4中的①所示,需要和接入网边缘机房以及核心网核心机房的基础设施对接,为容器化网络功能的承载提供所需要的资源。不同的基础设施管理软件提供了不同的API,为了保证和基础设施对接的开放性和兼容性,基础设施对接模块通过驱动方式和不同的基础设施进行对接。在运营商网络中,基础设施主要是通过开源云计算套件OpenStack实现,因此需要通过Cloud-Provider-OpenStack驱动实现和OpenStack资源池的对接。需要注意的是,电信不同机房部署的OpenStack版本不一致导致API存在不一致的情形,需要针对每个版本的API分别提供对应的Cloud-Provider-OpenStack驱动插件。

图4 多容器集群管理引擎主要功能架构

通过Cloud-Provider-OpenStack保证了和不同基础设施管理面API交互的能力,但不同的基础设施通常具有不同租户、认证、访问端点、网络等信息,因此还需要用户根据所选的驱动插件指明其所需的Cloud-Config配置信息。Cloud-Provider-OpenStack和Cloud-Config共同保证的多容器集群引擎可以按需调用基础设施API创建所需要的资源。

3.1.3 集群定义

基础设施对接模块保证了承载Kubernetes集群所需要的基础设施资源的对接调用能力,此外还需要集群定义模块,如图4中的②所示,该模块的主要职责是明确要创建的Kubernetes容器集群的具体信息。首先,Kubernetes集群由一组基础设施提供的虚拟机或者裸机组成,按角色可以分为Master节点、Worker节点以及只有受限资源的Edge节点,其中Edge节点为可选节点,主要通过业界开源的KubeEdge方案实现该节点上容器化应用的编排能力。因此集群定义模块首先需要定义创建的这些角色虚拟机或者裸机的镜像以及规格信息。通常不同的Kubernetes版本对应不同的镜像,Kubernetes的Master节点、Worker节点、Edge节点可以分别指定不同的规格。其次,需要指明Kubernetes的Master节点的部署模式。例如,是单Master节点部署还是通过多个Master节点提供高可用的Kubernetes集群管理面。最后,还需要明确定义集群的规模,主要是定义Worker节点的数量与规模。用户通过调用集群定义模块的API完成以上集群信息的声明,集群定模块根据用户的声明并且调用基础设施对接模块,即可创建出承载容器集群所需要的所有云资源。

3.1.4 集群引导

在完成基础设施对接以及Kubernetes容器集群定义后,需要集群引导模块,其功能如图5所示,该模块主要是提供多个容器集群的生命周期管理能力。集群引导模块是创建Kubernetes集群的核心工作引擎,其主要职责包括以下3点。

· 为每个集群生成集群认证信息及配置文件,确保创建集群访问的安全性。

· 初始化集群的控制平面,也就是根据用户的集群定义完成集群组件部署。

· 将部署好的Master节点和Worker节点组合成为完整的Kubernetes集群。

图5 集群引导模块功能

对于资源受限的边缘节点的管理以及其上应用的分发,主要采用开源的KubeEdge方案。因此,对于包含Edge节点的Kubernetes集群,需要完成Kubernetes集群部署,再引导KubeEdge插件安装Edge节点组件并加入上述集群中,从而形成具有云边协同能力的Kubernetes集群。

3.2 多容器集群运维引擎

5G网络切片提供特定的网络能力,满足不同的业务场景需求,使得网络的规模和复杂程度远超以往[11];5G网络切片的云化承载,相较于传统专有硬件设备的网络运维,在异常检测、故障根因分析、性能优化等问题上变得更加复杂,此外云资源、虚拟网元和网管3个层面的分层告警降噪与快速收敛以及多层之间的故障关联进一步加剧网络运维工作难度。本文主要针对5G网络切片业务所需云资源侧的多云多容器集群,通过对基础设施云以及多容器集群资源的监控告警等数据进行采集,并利用数据科学、人工智能等技术对这些数据进行处理及分析,辅助多容器管理集群对5G网络切片整个生命周期的管理,实现效率提升、质量保障和成本优化的目标。

3.2.1 多容器集群运维引擎整体架构

多容器集群运维引擎整体架构方案如图6所示,其整体分为3个部分。首先是数据采集与存储模块,主要实现从裸机、虚拟机、容器资源中采集存储指标、告警、日志、事件等数据,以及对外提供查询、检索能力。其次是数据处理模块,根据不同的运维场景对采集的基础数据进行清洗、归类、聚合,构建全面、标准、精细、统一的数据模型。最后是数据分析模块,使用机器学习、人工智能的方法,在异常检测、根因分析、趋势预测等场景中代替人工进行决策,提升运维效率。

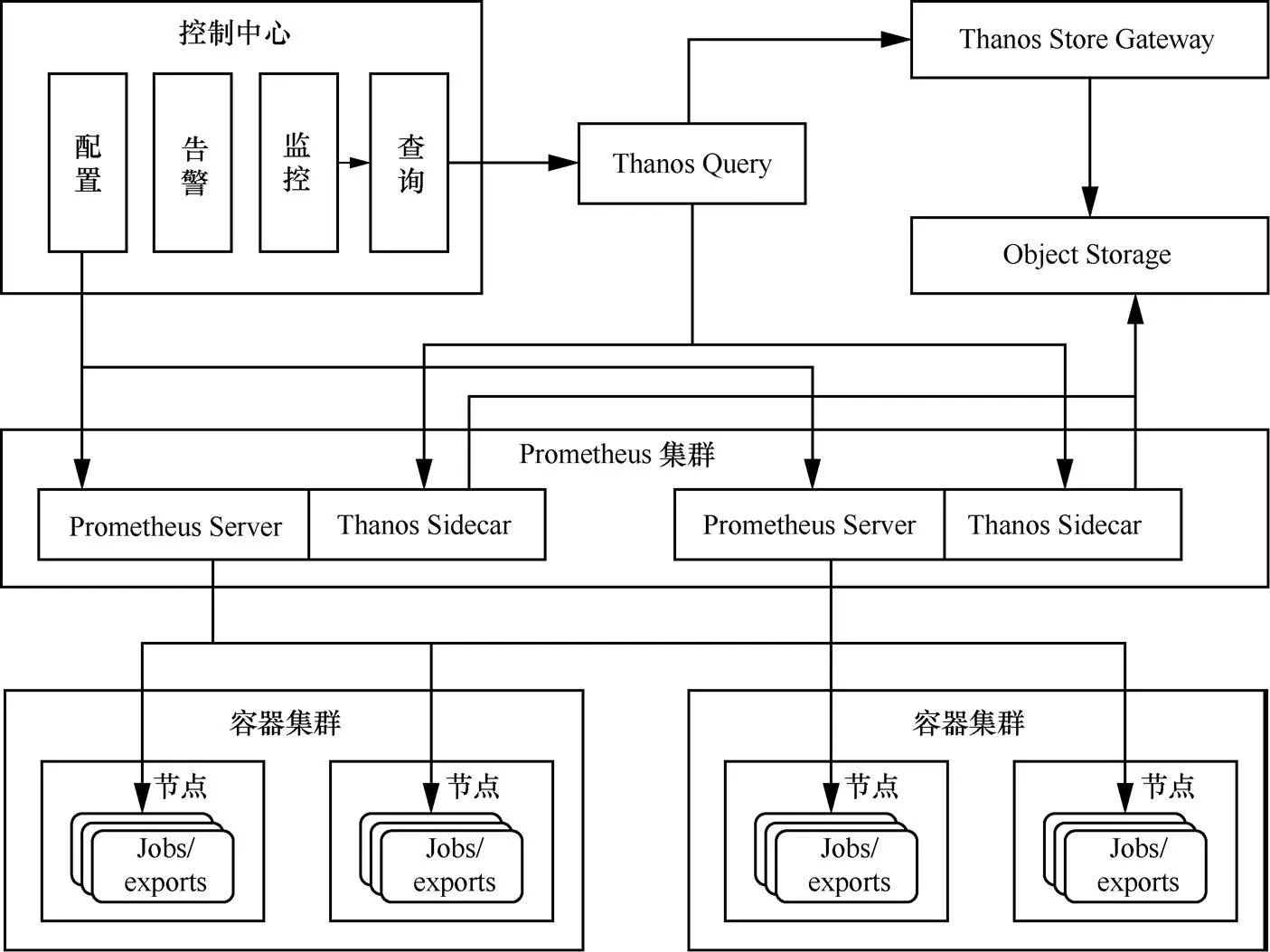

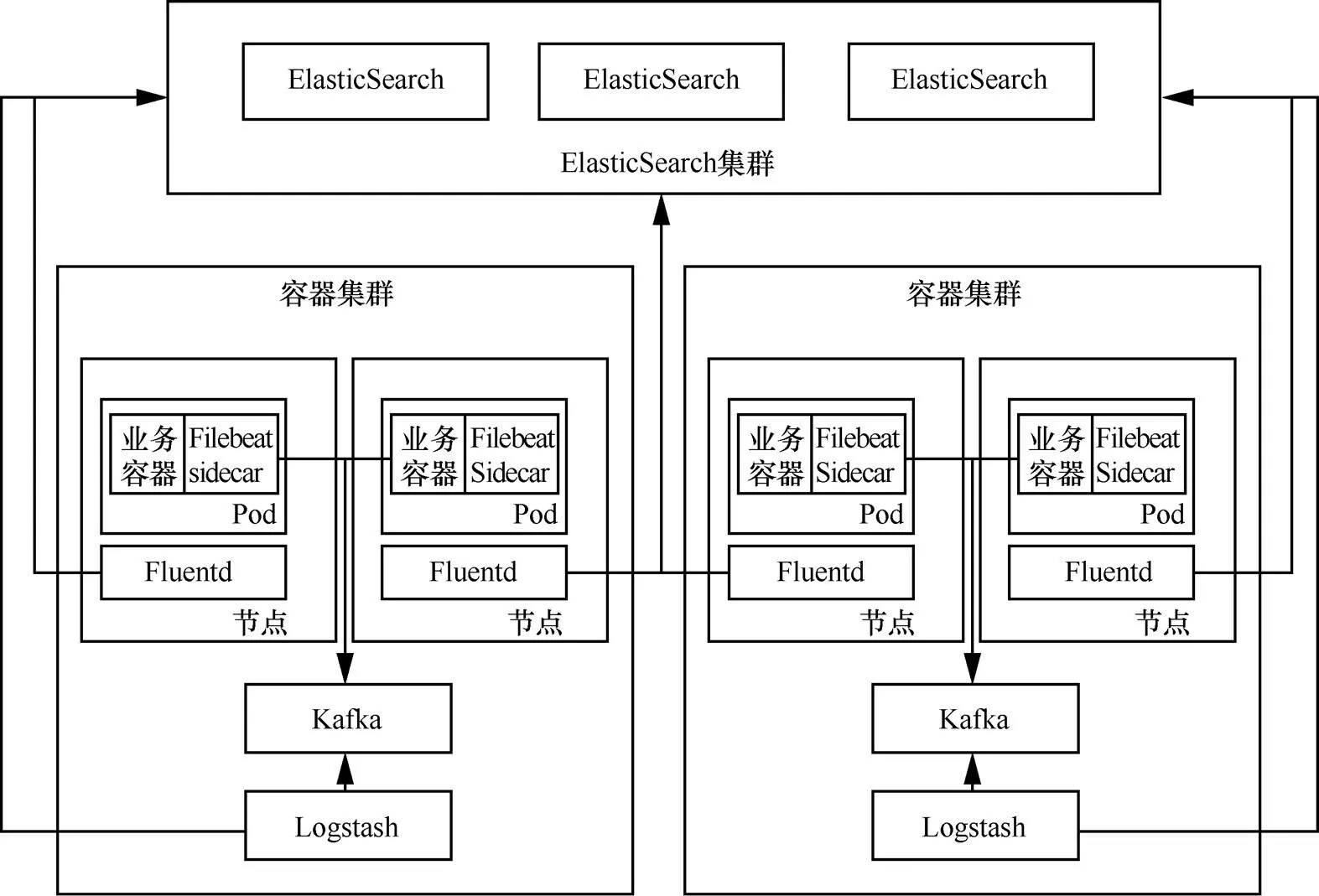

3.2.2 数据采集与存储

数据采集与存储模块需要满足大规模集群下裸机、虚拟机、容器运维数据的采集、存储与检索任务。采集数据的主要类型分为监控数据和日志数据两类。数据采集与存储架构基于开源社区的主流解决方案设计。监控数据的采集与存储架构如图7所示,通过搭建指标及报警监控解决方案Prometheus集群对多容器集群运维数据进行采集;使用具有长期存储的高可用Prometheus解决方案Thanos提供的Query和Object Storage组件进行统一的查询、存储;使用控制中心组件完成整个采集过程的控制及管理,包括配置Prometheus集群的采集对象、提供数据监控视图、基于监控指标的基础告警等。日志数据的采集与存储架构如图8所示,使用轻量级数据采集器Filebeat以边车方式采集日志文件,通过分布式消息系统Kafka组件汇总日志数据,数据处理管道Logstash组件将数据转发到分布式搜索及分析引擎ElasticSearch集群中;使用数据采集系统Fluentd组件采集标准日志输出流到ElasticSearch集群中;构建ElasticSearch集群统一实现日志的持久化存储及检索。

图6 多容器集群运维引擎整体架构方案

图7 监控数据的采集与存储架构

图8 日志数据的采集与存储架构

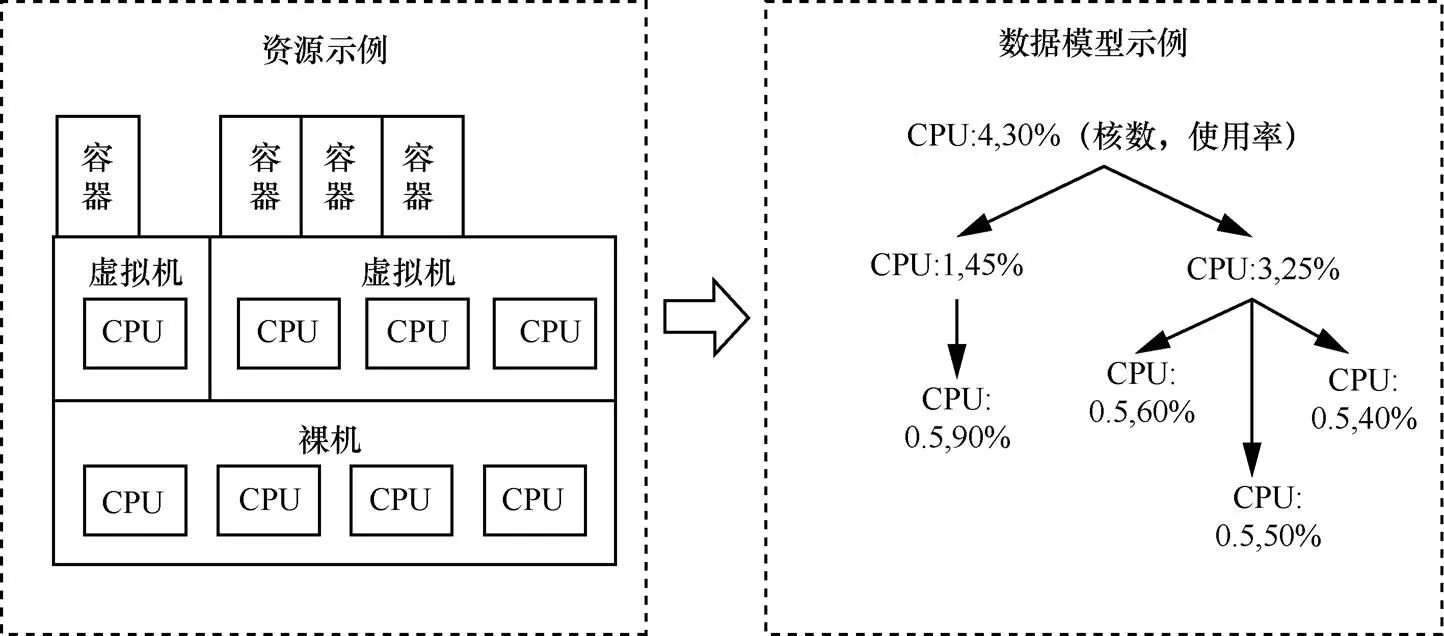

3.2.3 数据处理

数据处理模块是对多源数据进行统一的数据治理,为人工决策、智能运维提供坚实的数据基础。该模块主要包括数据清洗、数据归类存储、数据建模等部分[12]。数据清洗以数据去重、噪声数据识别、缺失值处理为主,构建高质量数据。数据归类存储实现多维度监控数据的统一化[13],以CPU的使用率为例,数据采集与存储模块可以收集到一台裸机及之上运行的虚拟机和容器3个维度的CPU使用率数据,它们之间是无关联的,如果不进行数据归类,无法反映数据间的相关性,数据归类存储示意图如图9所示,可以进行统一化描述,更好地解决故障诊断及性能优化。数据建模根据具体的运维场景对数据进行建模,以根因分析为例,端到端的5G网络切片业务会经过多个容器集群,数据建模示例如图10所示,将每个容器集群的运维数据聚合汇总起来,构建一条完整的调用连,可以更好地解决根因分析、性能瓶颈等问题。

图9 数据归类存储示意图

图10 数据建模示例

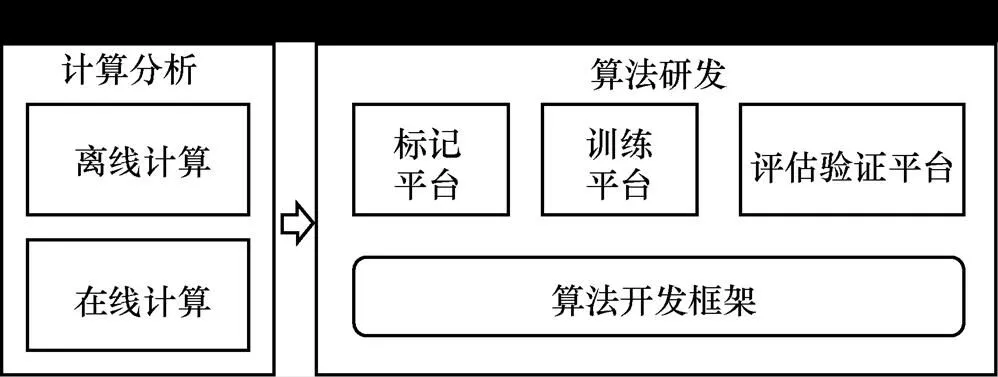

3.2.4 数据分析

数据分析模块主要应用于多云多容器集群的效率提升、质量保证、成本管理等场景[14],通过智能决策、异常检测、故障预测、资源优化等技术[15],提升多容器集群的运行质量、减少运营成本。数据分析模块分为计算分析组件和算法研发组件,数据分析模块架构示意图如图11所示。其中计算、分析组件包括离线计算和在线计算两部分,主要为数据分析模块提供计算能力,可以对历史数据进行离线分析处理,对实时数据进行在线分析处理。算法研发平台分为标记平台、训练平台、评估验证平台、算法开发框架等部分,主要为数据分析模块提供算法能力,可以满足不同场景下的算法需求。

图11 数据分析模块架构示意图

4 关键技术讨论

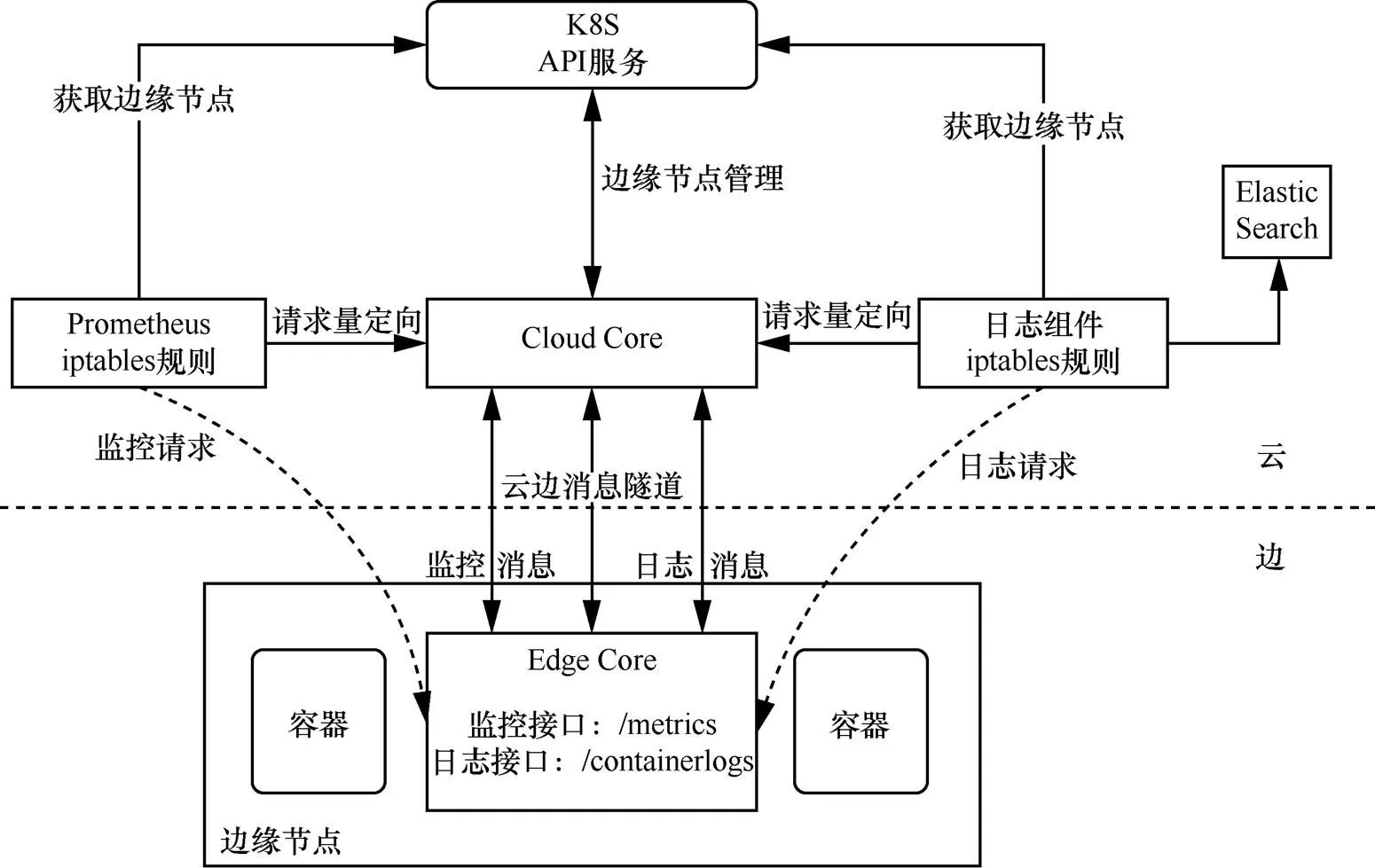

4.1 面向云边协同的监控和日志方案

面向云边协同监控和日志方案的重点是解决边缘节点的数据采集问题,边缘节点的网络和资源受限是边缘侧数据采集的主要挑战。在第3.2节的方案中,Promethues部署在远端,对Worker节点的监控数据采集是通过云端节点对外暴露Metrics接口,Prometheus直接请求云端节点的Metrcis接口实现的;云端节点的日志数据采集是通过直接部署日志采集组件Fluend,由Fluend上报给ElasticSearch集群实现的。但是,在边缘环境中,边节点通常以有限的计算资源运行在私有网段,不提供公网IP地址,云端组件无法直连。因此,Promethues对边节点无法按照云端方式直接采集监控数据。边节点也因为计算资源受限,不适宜直接部署Fluentd这样高资源消耗的组件采集日志数据。

本节将基于KubeEdge给出边缘节点监控和日志数据的采集方案,方案架构如图12所示。其中,API服务是Kubernetes原生组件;Cloud Core是KubeEdge的云端组件,负责边缘节点管理,如上报边缘节点信息;Edge Core是KubeEdge的边缘组件,运行在边缘节点,负责管理边缘容器,如容器的监控信息和日志信息获取,并分别通过监控接口和日志接口对外提供访问。Cloud Core和Edge Core基于Websocket建立消息隧道实现云边通信,并且已默认实现了监控消息隧道和日志消息隧道用于传递Edge Core获取的容器监控信息和日志信息。基于KubeEdge的现有模块,本文边缘节点数据采集方案和实现步骤如下。

图12 边缘节点监控与日志数据采集架构

4.2 面向跨域的多容器集群及应用的统一管理

如前文所述,5G网络切片是一种端到端的网络解决方案,其实现依赖电信接入、核心等多个机房的跨域网络环境。要实现端到端5G网络切片的灵活管理,除了通过多容器管理与运维引擎提供5G网络切片的多容器集群承载环境,同时还需要跨域的多集群统一管理以及应用的统一编排与部署能力。

第一,通过跨域的多集群统一管理可以实现对电信接入、核心等多个机房中容器集群的统一管理能力。容器集群及基于集群联邦CRD的应用管理模块,除了实现容器集群生命周期的管理能力以及对全局集群的统一监控能力,还提供了多集群的统一管理能力。

多集群统一管理,一方面提供了多集群统一的访问入口,基于此入口可以提供多集群一致的访问与管理视图,简化管理员多集群的管理复杂度;另一方面可以实现全局的账号与权限管理,从而提供面向CT场景的多租户能力。除此以外,多集群统一管理还提供项目管理机制,具有相应权限的管理员或者普通用户,可以在对应集群上创建项目,并在对应项目中创建容器化工作负载、微服务、面向CT的DevOps等应用。

第二,跨域应用的统一管理。网络切片端到端形态特点,要求实现跨域容器化应用的统一管理能力。基于容器多集群以及Federation V2联邦技术,可以实现全局的应用统一编排、部署、运维能力,从而满足网络切片的部署需求。

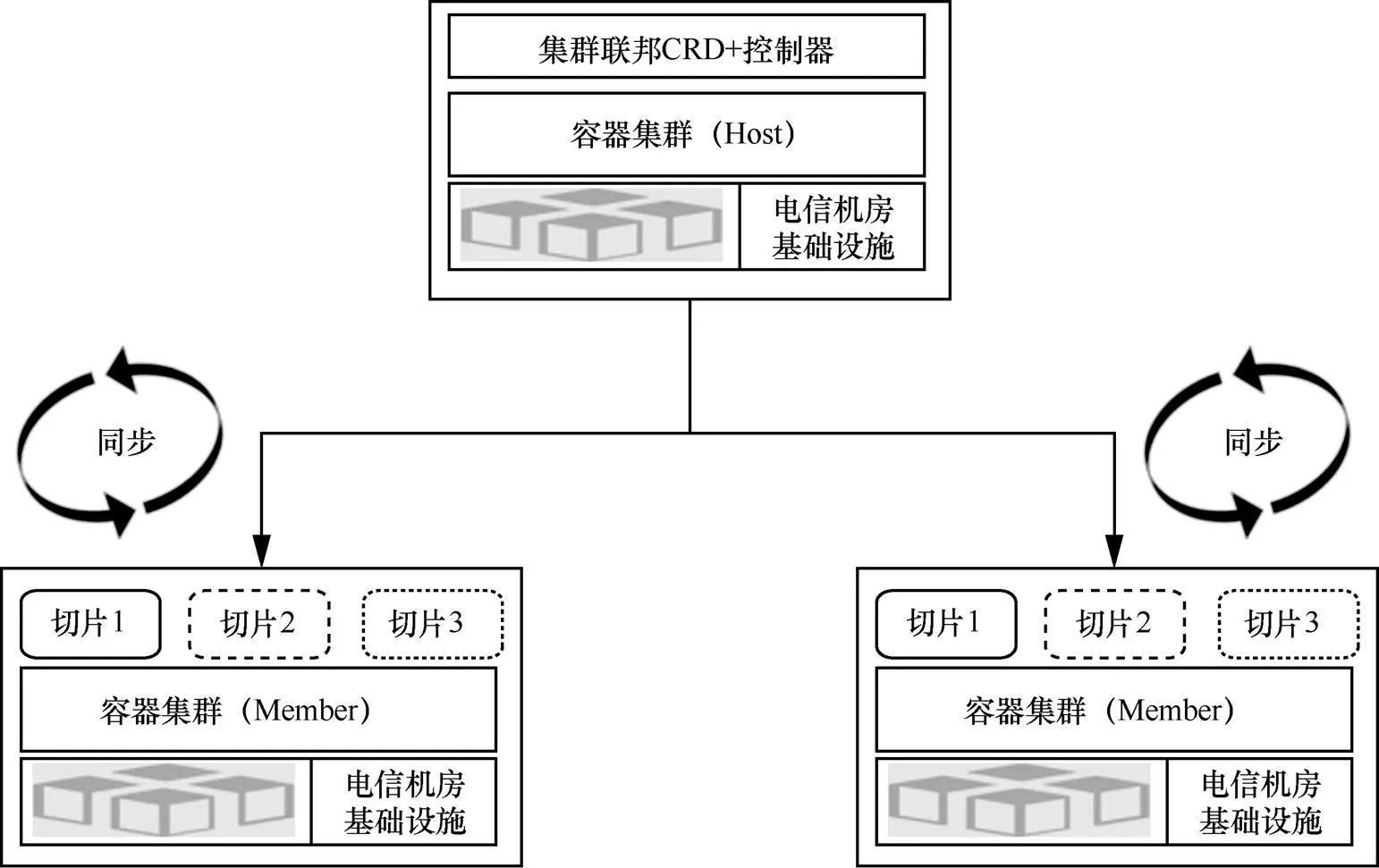

通过Federation V2组建的联邦集群组成示意图如图13所示,有一个集群是Host集群,其余集群是Member集群,在Host集群中,通过Kubernetes提供的CRD机制实现联邦资源的扩展,这些联邦资源由对应的控制器管理,实现跨集群的应用编排、资源同步等功能。用户基于扩展CRD提供的API即可实现联邦资源的创建。

图13 联邦集群组成示意图

5 结束语

本论文通过对5G网络切片场景云化承载需求的分析,对于以容器及多容器集群等云原生技术在电信行业的应用进行了积极的探索,通过自主设计与研发具备云边协同、多租户隔离、多容器集群高可用部署、敏捷管理与运维的KubeTelecom,满足了5G切片云化承载的核心需求,使得云管平台初步具备了对以5G网络切片为例的云原生应用系统的统一云化承载与运维的系统原型能力。未来将重点验证KubeTelecom引擎与统一云管平台的系统集成工作。同时以5G网络切片业务为抓手,在具体的现网试点工作中逐步提高KubeTelecom与统一云管平台的适配性和相关功能模块的延伸研发工作。根据现网试验结果,不断总结和完善KubeTelecom,使其逐步具备承载大规模商用的云原生业务系统的稳定性与可靠性。

[1] ETSI NFV ISG. Network functions virtualization-introduction white paper[R]. 2012.

[2] ETSI NFV ISG. Network functions virtualization white paper on NFV priorities for 5G[R]. 2017.

[3] ETSI NFV ISG. Report on the enhancement of the NFV architecture towards “Cloud-native” and “PaaS”[R]. 2019.

[4] 汤红波, 袁泉, 卢干强, 等. 一种支持节点分割的vEPC虚拟网络功能部署模型[J]. 电子与信息学报, 2017, 39(3): 546-553.

TANG H B, YUAN Q, LU G Q, et al. A model for virtualized network function deployment based on node-splitting in vEPC[J]. Journal of Electronics & Information Technology, 2017, 39(3): 546-553.

[5] 王琛, 汤红波, 游伟, 等. 一种基于动态规划的vEPC服务功能链部署方法[J]. 计算机应用研究, 2018, 35(7): 2106-2109.

WANG C, TANG H B, YOU W, et al. Method for service function chaining deployment based on dynamic programming in vEPC[J]. Application Research of Computers, 2018, 35(7): 2106-2109.

[6] 黄开枝, 潘启润, 袁泉, 等. 基于性能感知的网络切片部署方法[J]. 通信学报, 2019, 40(8): 114-122.

HUANG K Z, PAN Q R, YUAN Q, et al. Method of network slicing deployment based on performance-aware[J]. Journal on Communications, 2019, 40(8): 114-122.

[7] 刘健. 5G边缘计算和网络切片技术[J]. 电子技术与软件工程, 2019(12): 1.

LIU J. 5g edge computing and network slicing technology[J]. Electronic Technology & Software Engineering, 2019(12): 1.

[8] 黎宇. 多云平台的统一运营及关键技术研究[J]. 信息通信, 2019, 32(6): 232-233.

LI Y. Research on unified operation and key technologies of multi cloud platform[J]. Information & Communications, 2019, 32(6): 232-233.

[9] COTRONEO D, DE SIMONE L, NATELLA R. NFV-bench: a dependability benchmark for network function virtualization systems[J]. IEEE Transactions on Network and Service Management, 2017, 14(4): 934-948.

[10] 安琪, 刘艳萍, 孙茜, 等. 基于SDN与NFV的网络切片架构[J]. 电信科学, 2016, 32(11): 119-126.

AN Q, LIU Y P, SUN Q, et al. Network slicing architecture based on SDN and NFV[J]. Telecommunications Science, 2016, 32(11): 119-126.

[11] 张巍. 5G核心网切片运维管理关键技术研究[J]. 数字通信世界, 2020(3): 39, 68.

ZHANG W. Research on key technologies of 5G core network slice operation and maintenance management[J]. Digital Communication World, 2020(3): 39, 68.

[12] 李杰. IT运维监控系统的设计与实现[D]. 成都: 电子科技大学, 2020.

LI J. Design and realization of the network maintenance and monitoring system[D]. Chengdu: University of Electronic Science and Technology of China, 2020.

[13] 冷喜武, 李平, 霍雪松, 等. 智能电网监控运行大数据分析系统统一建模方法研究[J]. 电力大数据, 2019, 22(7): 48-54.

LENG X W, LI P, HUO X S, et al. Research on unified modeling method of big data analysis system for monitoring operation of smartpower grid[J]. Power Systems and Big Data, 2019, 22(7): 48-54.

[14] 肖哲. 人工智能在5G网络中的应用[J]. 中国电子科学研究院学报, 2020, 15(8): 746-749.

XIAO Z. Application of artificial intelligence in 5G Network[J]. Journal of China Academy of Electronics and Information Technology, 2020, 15(8): 746-749.

[15] 林舒刚. 5G网络智能运维研究[J]. 广东通信技术, 2020, 40(3): 32-35.

LIN S G. Research on intelligent operation and maintenance of 5G network[J]. Guangdong Communication Technology, 2020, 40(3): 32-35.

KubeTelecom: a multi-cloud multi-container cluster management and operation engine for 5G network slicing

WU Yuting, WANG Xuliang, QUAN Shuo

Research Institute of China Telecom Co., Ltd., Beijing 102209, China

KubeTelecom design architecture and implementation were proposed and introduced in detail, which was for multi-cloud multi-container cluster management and operation and maintenance engine operators’ multiple network cloud applications. Based on the bearer requirements of the 5G slicing scenario, KubeTelecom provided the upper-layer application platform with multi-container cluster management and orchestration capabilities and data-driven comprehensive operation and maintenance capabilities were analyzed in detail. The future telecom cloud platform integrates the KubeTelecom module to provide unified resource management and operation and maintenance capabilities for multiple cloud-native applications, and provide solid technical support for the development of operators’ multiple DICT business ecosystems.

multi-cloud multi-container cluster, cloud edge collaboration, 5G network slice

TP393

A

10.11959/j.issn.1000−0801.2021276

2021−10−20;

2021−12−10

武宇亭(1986−),男,中国电信股份有限公司研究院工程师,主要研究方向为云网融合、边缘计算、分布式存储。

王旭亮(1986−),男,中国电信股份有限公司研究院高级工程师,主要研究方向为云网融合、云数据中心网络和边缘计算等。

全硕(1991−),男,中国电信股份有限公司研究院工程师,主要研究方向为云网融合、云计算与大数据和云网运营等。