一种基于EfficientNet与BiGRU的多角度SAR图像目标识别方法

2022-01-08赵鹏菲黄丽佳

赵鹏菲 黄丽佳

①(中国科学院空天信息创新研究院 北京 100094)

②(中国科学院空间信息处理与应用系统技术重点实验室 北京 100190)

③(中国科学院大学 北京 100049)

1 引言

合成孔径雷达(Synthetic Aperture Radar,SAR)是一种主动式微波遥感设备,其通过天线主动地向目标发射微波,并接收目标反射的回波实现对目标的成像[1]。SAR不仅可以在光照不足和恶劣天气下工作,而且可以实现对隐蔽目标的穿透探测,具有全天时、全天候工作的特点[2]。经过30余年的发展,SAR技术越来越成熟,目前已经成为遥感信息获取的重要途径,在军用以及民用领域都有广泛的应用[3]。

与光学图像不同,由于电磁散射和相干成像机理,SAR图像是目标三维几何和辐射信息在二维图像中的映射,存在叠掩、阴影等特点,且含有大量相干斑噪声。这使SAR图像在视觉上较光学图像更难解释与理解,对目标的检测和识别有较大的影响[4]。因此,从SAR图像中识别目标的真实属性,即SAR自动目标识别技术(SAR Automatic Target Recognition,SAR ATR)成为一直以来的研究热点。

近年来,随着深度学习技术的发展,基于深度学习的SAR ATR技术得到了广泛的应用[5–8]。都设计了不同的卷积神经网络来对SAR图像进行目标识别任务,并取得了不错的效果,但这些方法都是基于SAR的单角度图像进行的目标识别。

由于SAR采用侧视成像原理,SAR对目标观测俯仰角和方位角的变化都十分敏感。对于同一观测目标,即便观测的方位角仅有较少变化,所得目标的SAR图像也会有较大的差别。而对于不同目标在某一个观测角度下又呈现较大的相似性,这些情况对基于单角度SAR图像的目标识别造成相当的困难。此外,同一观测目标的多角度SAR图像序列中蕴含着多个角度的散射回波,较单角度SAR图像更加全面精细地刻画了目标散射特性[9]。

多角度SAR目标识别技术基于SAR平台获取目标不同方位角的多幅图像组成的图像序列,利用不同视角的散射特性对目标进行类别属性判别,其拥有更高的准确度和鲁棒性[10,11]。

目前,多角度SAR目标识别技术也有了一定的发展。2017年,Zhang等人[12]提出多角度感知双向长短期记忆网络(Multi-Aspect-aware Bidirectional Long-Short Term Memory,MA-BLSTM)用于多角度SAR目标识别,其首先提取单张图像的Gabor特征和3片局部二值模式(Three Patches Local Binary Pattern,TPLBP)特征,并进一步利用长短期记忆网络(Long-Short Term Memory,LSTM)提取了图像特征序列的时序特征,最后通过Softmax层进行目标的分类,取得了不错的效果。2018年,Pei等人[13]提出多视角深度卷积神经网络(Multi-View Deep Convolutional Neural Network,MVDCNN)方法,利用并行的卷积神经网络(Convolutional Neural Network,CNN)来提取不同角度图像的深度特征,并逐步将这些特征进行融合,从而进行识别。邹浩等人[14]将3张不同角度的SAR图像合并作为1张3通道的图像送入CNN网络进行目标识别,取得了不错的效果。Zhao等人[15]提出了多流卷积神经网络(Multi-Stream Convolutional Neural Network,MS-CNN)方法,设计了傅里叶特征融合层,来对由卷积神经网络提取的深度特征进行了融合。2019年,Zhang等人[16]在文献[12]的基础上,将Gabor特征和TPLBP特征换为由ResNet提取的深度特征,并提出基于投票的后处理方法,取得了目前最高的准确率。

尽管上述方法都取得了不错的效果,但仍然存在一些尚未解决的问题,如在训练集和测试集图像成像条件不同时,识别准确率较低;基于深度学习的方法通常需要大量数据进行训练等。

为解决以上问题,本文提出基于EfficientNet[17]和BiGRU[18]的多角度SAR目标识别方法,主要贡献如下:

(1) 本文采用EfficientNet提取单张SAR图像的空间特征,并进一步利用BiGRU提取图像序列的时序特征。这使模型保持高性能的同时也降低了模型参数量;

(2) 本文采用孤岛损失(Island Loss)[19]改进分类模型的训练损失。在SAR图像目标识别任务中,Island Loss通过扩大各个目标类别间的类间距离及缩小类内距离来有效提升识别准确率。

实验证明,本方法不仅在大部分数据集上取得了当前最好的识别效果,还在小规模数据集上取得了不错的识别性能。

本文的第2节详细介绍了本文所提多角度SAR目标识别方法;第3节介绍实验所采用的图像数据以及多角度图像数据集的构造;第4节介绍实验细节与结果;第5节总结本方法的优越性并安排了后续的工作。

2 多角度SAR图像目标识别方法

2.1 多角度SAR图像序列识别网络结构

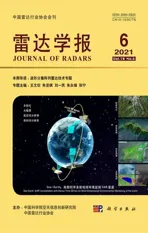

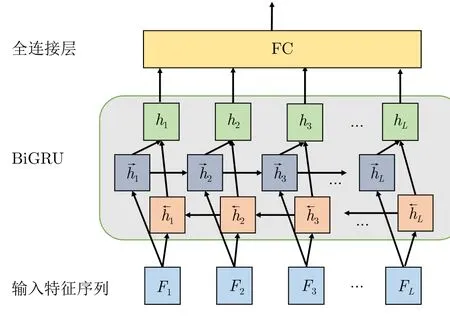

本文所提多角度SAR图像目标识别网络的结构如图1所示,其主要由提取单张图像特征的EfficientNet网络与进一步提取多角度SAR图像序列时序特征的BiGRU网络构成。

图1 多角度SAR目标识别网络结构图Fig.1 Multi-aspect SAR ATR framework

该网络的输入数据是一组同一目标的多角度SAR图像序列(B,L,C,H,W)。其中,B为模型训练时的Batch Size,L为图像序列的图像数量,C,H,W分别为图像通道数、图像高度与宽度。

该方法首先使用一组共享权重的EfficientNet网络提取图像序列中单张图像的空间特征(B×L,U),其中U为单张图像空间特征的维度。对图像序列所提取的图像特征序列进行维度变换,得到特征(B,L,U),再送入BiGRU网络继续提取多角度图像序列时序特征 (B,V),其中V为特征的维度。最后,将经过BiGRU网络提取的特征送入全连接层获取最终的输出,即该组多角度图像的目标类别概率 (B,k),其中k为待识别目标的类别数目。

2.2 EfficientNet

EfficientNet系列模型是目前性能最好的深度学习分类模型之一,该模型的基础网络架构是通过神经网络架构搜索(Neural Architecture Search,NAS)技术得到的[17]。本文选取了EfficientNet系列模型中的EfficientNet-B0网络,该网络在Efficient-Net系列模型中尺寸最小,速度最快,更适用于SAR领域这类小规模数据集。

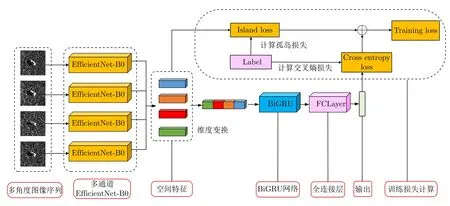

本文所使用的EfficientNet-B0网络结构组成如表1所示,其由16个移动倒置瓶颈卷积模块(Mobile inverted Bottleneck Convolution,MBConv)[17]、2个卷积层、1个全局平均池化层和1个全连接层构成。

表1 EfficientNet-B0网络结构Tab.1 EfficientNet-B0 network structure

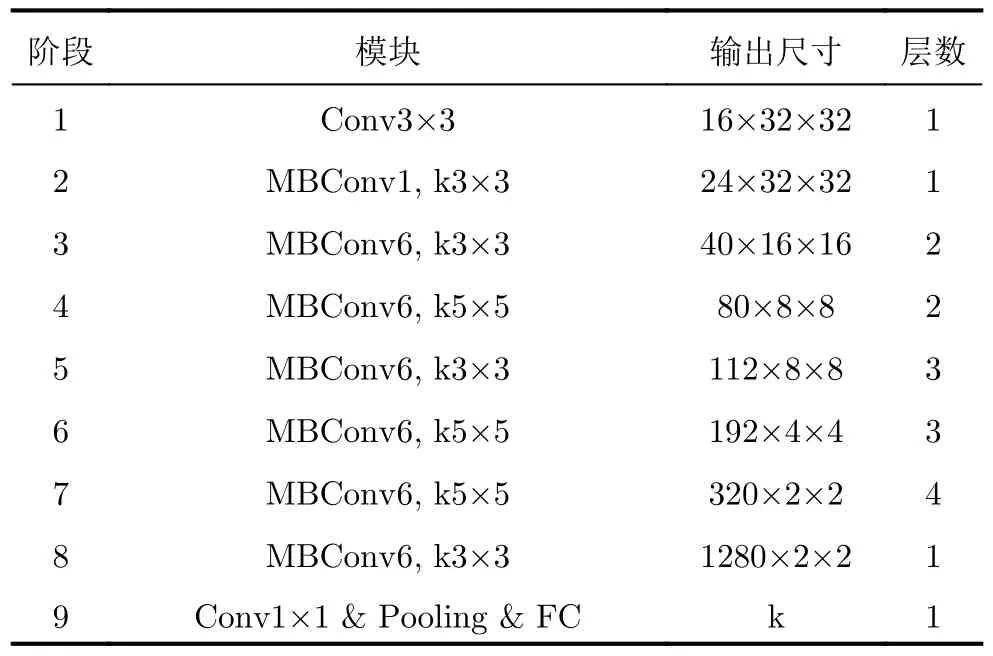

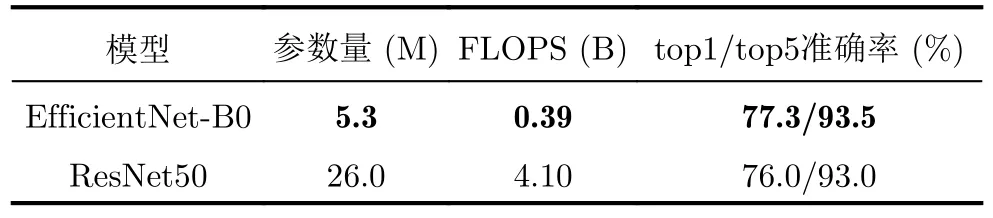

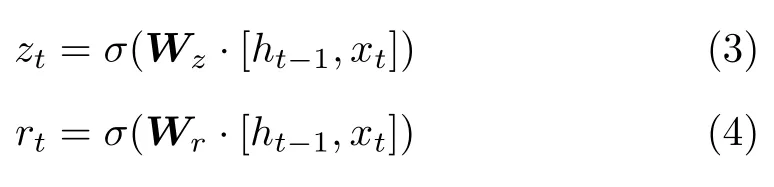

深度学习任务中常用的残差网络ResNet分类网络[20],其也应用于文献[16]进行多角度SAR目标图像的识别。表2对比了EfficientNet-B0和ResNet50网络的参数量、计算量与性能,top1/top5准确率是在ImageNet数据集中得出的[17,21]。top1/top5准确率如式(1)所示,n为 样本总数,gk表示第k个样本的真实标签,lj表示模型对当前样本所得概率向量中第j大的概率所对应的标签,函数d如式(2)所示

如表2所示,对比ResNet50网络,Efficient-Net-B0网络的速度快10倍、参数仅为其1/5且性能更好,这使其更适用于较难获取、数量较少的SAR遥感目标数据集。此外,由于EfficientNet-B0网络参数较少,模型部署更加容易。

表2 EfficientNet-B0与ResNet50网络对比Tab.2 Comparison of EfficientNet-B0 and ResNet50 networks

在本文所提多角度SAR图像识别框架中,EfficientNet-B0网络的输入是单张SAR的目标图像,输出是其空间特征。模型将多角度图像序列的特征进行维度变换后送入后续的BiGRU网络。

2.3 BiGRU

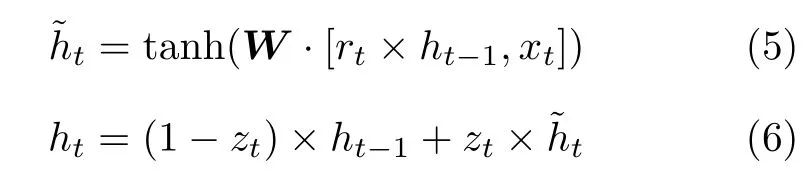

门控循环单元(Gate Recurrent Unit,GRU)[18]是一种特殊的循环神经网络(Recurrent Neural Network,RNN),其与长短期记忆网络(LSTM)[21]相似,是为了解决长期记忆和反向传播中的梯度等问题而提出的。

GRU适宜于处理时间序列数据,本文使用GRU来提取多角度SAR图像序列的空间变化特征。对比LSTM,GRU在性能相当的同时参数量更少、更易于训练。相比之下更适宜于小规模数据集,因此本文选取了GRU网络用于多角度图像序列的处理。

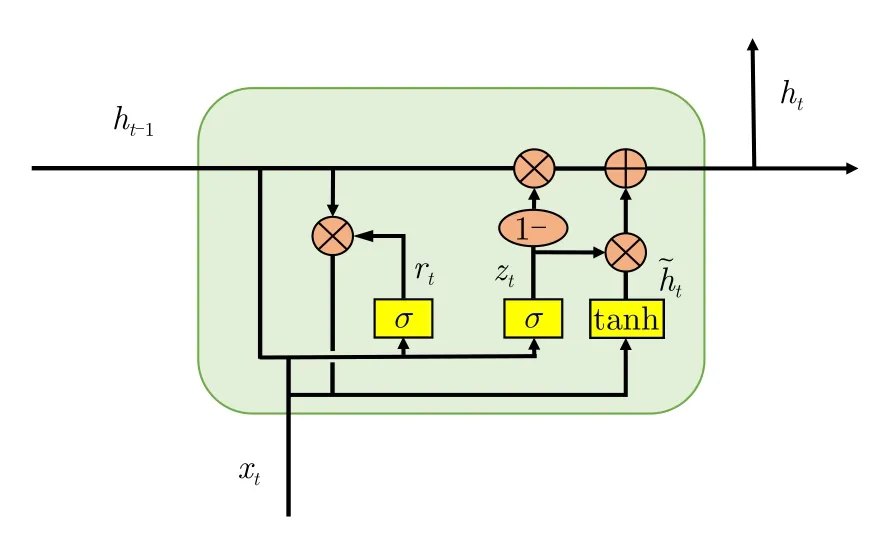

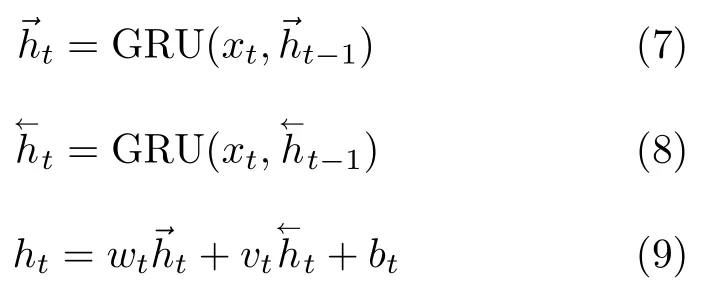

GRU由更新门和重置门两个门控单元组成,如图2所示,其利用门控单元控制输入、记忆等数据在当前时刻做出预测,其表达式为式(3)—式(6),其中zt为更新门,rt为重置门,Wz,Wr,W分别为更新门、重置门和候选隐层状态的权值矩阵,xt为输入信息,ht为t时刻的隐层状态,h˜t为t时刻的候选隐层状态,ht−1为t −1时刻的隐层状态,σ是Sigmoid函数。重置门将新的输入信息与前面的记忆相结合,输出一个0~1的值,其决定将ht−1向下一状态传递的多少。更新门定义了先前记忆保存至当前时刻的量,即先前记忆对当前状态的影响程度

图2 GRU结构示意图Fig.2 The structure of GRU

然而,普通的GRU网络仅能编码从前向后的序列信息,无法编码从后往前的序列信息。因此,本文采用了双向的GRU网络BiGRU来获取了图像特征序列双向信息。

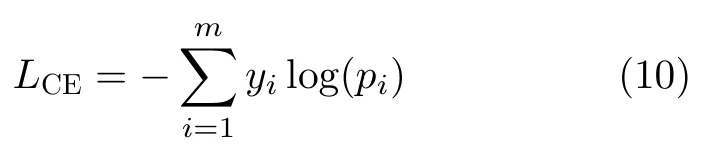

本文所采用的BiGRU结构如图3所示。

图3 BiGRU结构示意图Fig.3 The structure of BiGRU

BiGRU的计算公式如式(7)—式(9)所示,其中与分别表示前向GRU与后向GRU输出的隐层状态,wt与vt分别表示与所对应的权重,bt则为偏置参数。可以看出,在BiGRU中,当前隐层状态ht由前向GRU与后向GRU输出的隐层状态加权所得

在本文的实验中,BiGRU网络的隐层节点数为128,网络层数为4。

2.4 训练损失

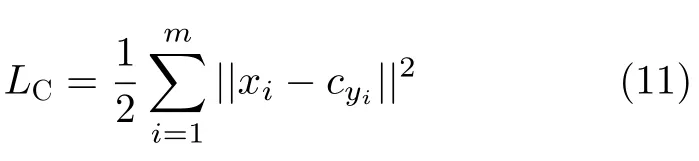

在基于深度学习的目标识别任务中,交叉熵损失是最常使用的。然而,由于SAR图像自身成像机理的复杂性和成像角度的敏感性,SAR图像通常存在同一目标之间类内距离大,不同目标之间类间距离小的问题。因此,简单地使用交叉熵不适用于SAR图像目标任务。如图1所示,本文使用孤岛损失(Island Loss)[19]和交叉熵损失共同作为训练损失来解决以上问题,其中交叉熵损失公式为

其中,yi是第i个样本的类别,pi是模型输出的第i个值。

Island Loss可以在训练中扩大类间距离、缩小类内距离,从而提高模型的分类性能。

Island Loss基于中心损失(Center Loss)[22]提出,Center Loss的公式为

其中,yi是第i个样本的类别,xi是第i个样本由EfficientNet-B0输出的特征向量,第i个样本所在类别的所有样本计算的中心点。根据式(11),Center Loss为每个样本特征距离其所在类中心的欧氏距离之和。因此,通过最小化Center Loss,可以将同一类别的不同样本的特征聚向类别中心,以此来缩小类内距离。

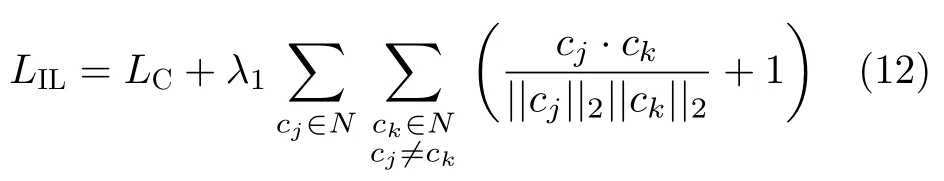

Center Loss仅仅可以缩小类内距离,而Island Loss在其基础上进一步优化了不同目标的类间距离。其公式为

其中,cj和ck分别是第j个类别和第k个类别的中心点,λ1为超参数。由式(12)可知,Island Loss的前半部分是Center Loss,后半部分是训练样本所属各个类别的特征中心之间的余弦相似度加1后的总和。当第j个类别和第k个类别的中心点cj和ck相差较远时,其余弦相似度接近于–1,此时的两个类别之间所产生的损失为0; 当cj和ck相近时,其余弦相似度接近于1,此时两个类别之间所产生的损失接近于最大值2。由此可见,可以通过最小化Island Loss,将同一类别的不同样本的特征聚向类别中心的同时,并将类别中心互相推离彼此,在高维空间中形成一座座“孤岛”,因此Island Loss可以扩大类间距离,缩小类内距离。

在联合交叉熵损失后,本文所使用的训练损失为

其中,λ为超参数。

3 数据集

本文使用了由桑迪亚国家实验室(Sandia national laboratory)提供的SAR图像数据集——移动与静止目标获取识别(Moving and Stationary Target Acquisition and Recognition,MSTAR)数据集,针对SAR图像目标识别的研究大多都基于该数据集而展开。在该数据集中,图像的分辨率为0.3 m×0.3 m,工作波段为X波段,所用的极化方式为HH极化方式。数据集中包含了10种不同类型的地面车辆目标在不同俯仰角、不同方位角下的图像数据。如图4所示,其包含了目标车辆在0°~360°间各个方位角的图像数据,因此该数据集适宜于建立多角度图像目标识别数据集。

图4 不同方位角、同一目标的SAR图像Fig.4 SAR images of the same target with different azimuth

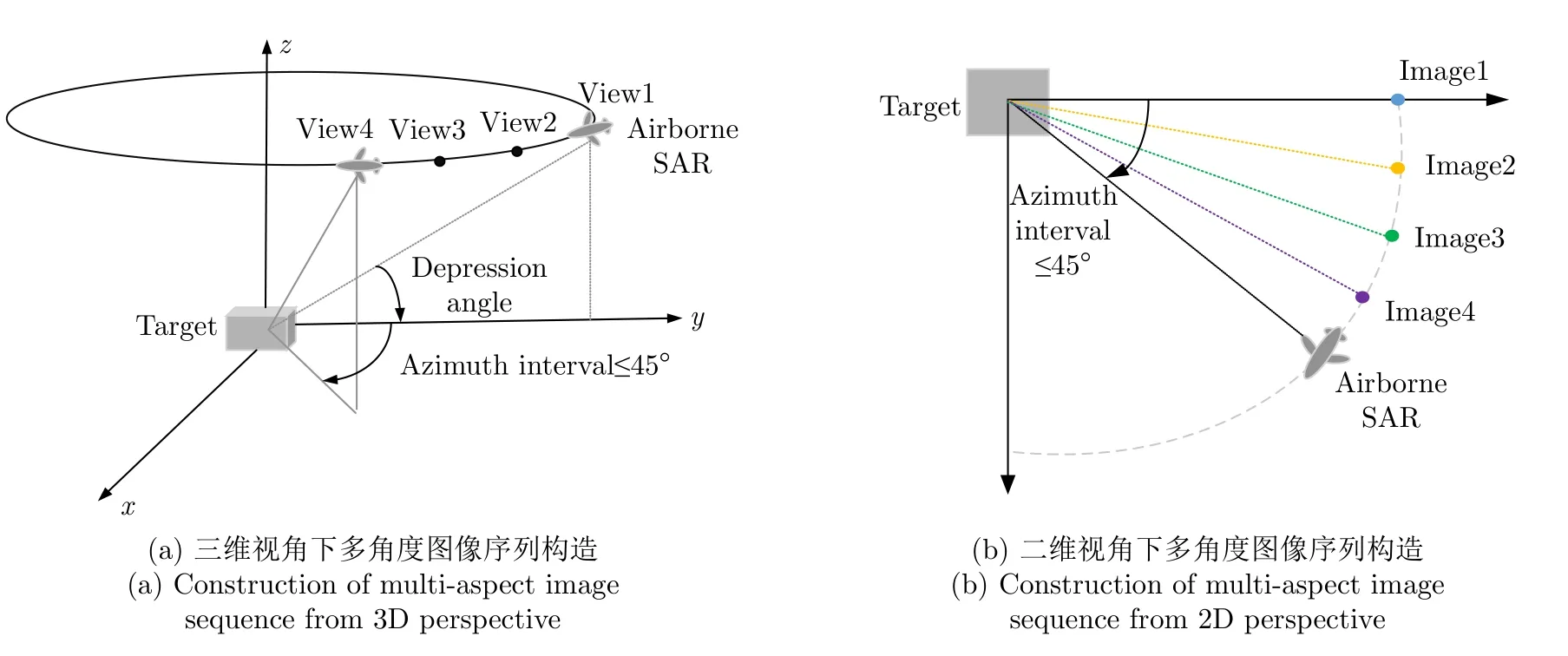

本文采用了文献[16]中多角度SAR图像数据集的构造方式。目前,宽角SAR一次可以对目标实现90°以下方位角的连续观察,为了使方法更实用,本文设置连续观测角θ为45°,多角度图像序列包含的图像个数L分别设置为2,3,4,数据集的构造方式如图5所示。

图5 多角度图像序列构造示意图Fig.5 Schematic diagram of multi-angle image sequence structure

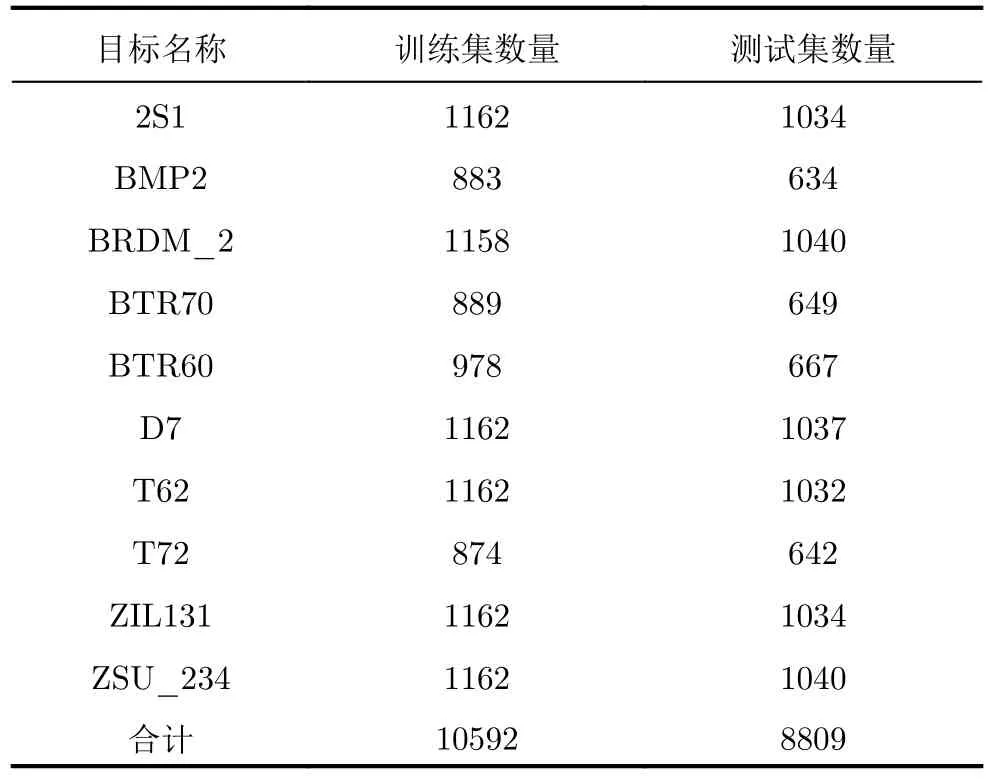

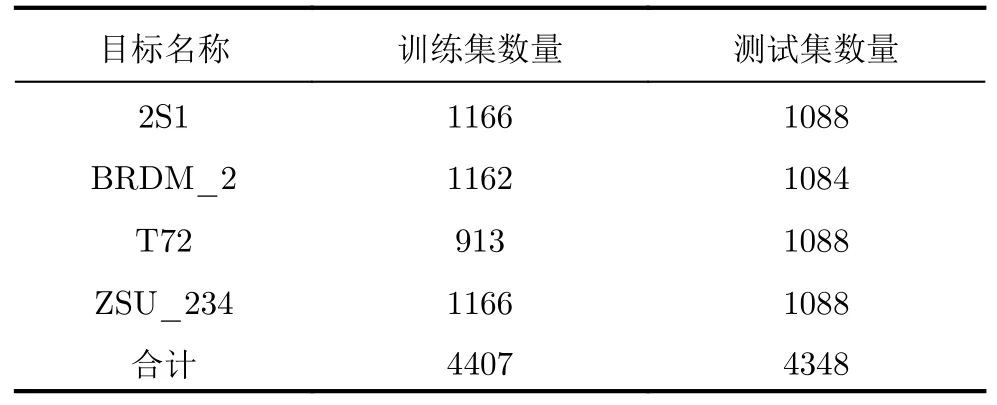

构建完成后的多角度SAR图像序列数据集分为标准工作条件(Standard Operating Condition,SOC)和扩展工作条件(Extended Operating Condition,EOC)两类。其中SOC指的是训练集和测试集数据的SAR传感器的成像条件相似,在实验中,训练集的成像俯仰角为17°,测试集的成像俯仰角为15°;EOC指的是训练集和测试集数据的SAR传感器的成像条件存在一定的差异。图像序列L4的SOC数据集目标种类及数量如表3所示,其中训练集合计10592组,测试集合计8809组;当图像序列L3时,训练集合计8016组,测试集合计6771组;当图像序列L2 时,训练集合计5 3 4 7组,测试集合计4669组。

表3 图像序列L为4时,SOC数据集大小Tab.3 SOC dataset size when L=4

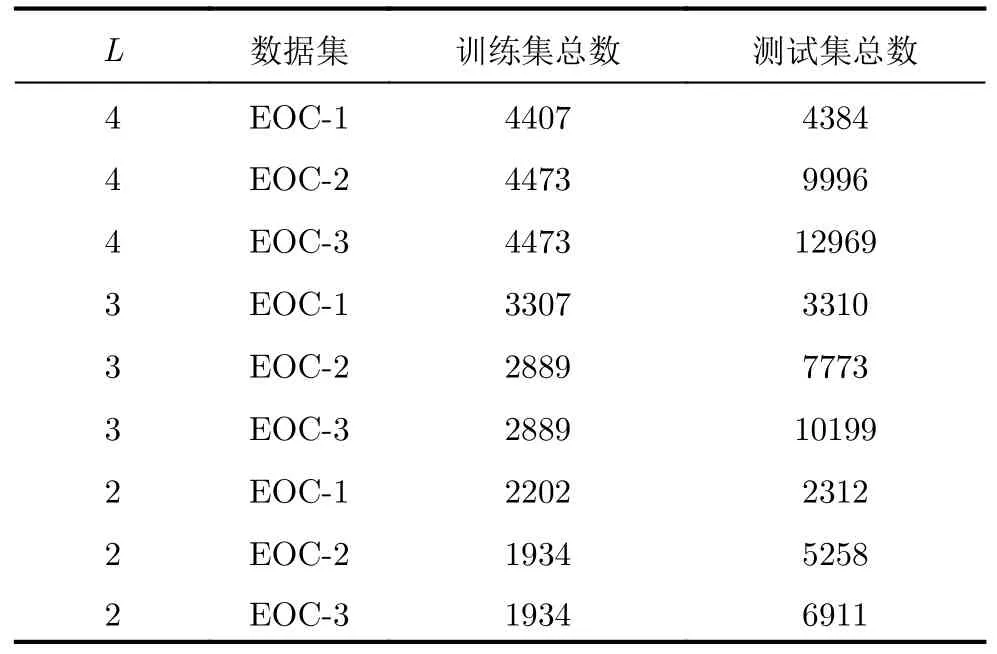

在MSTAR数据集中,EOC通常有3种,第1类为大俯仰角情况,本文称为EOC-1,EOC-1的训练集成像俯仰角为17°,测试集成像俯仰角为30°,其中图像序列L4时,EOC-1数据集目标种类及数量如表4所示。

表4 图像序列L为4时,EOC-1数据集大小Tab.4 EOC-1 dataset size when L=4

此外,另外两种EOC分别指车辆版本变化与车辆配置变化。版本变化是指车辆的功能改变,即原始车辆变化为救护车、运输车、侦察车等;配置变化是指车辆上一些部件的增加或移除,如T72移除车后的油罐等[15]。在本文称这两种变化分别为EOC-2和EOC-3。

实验中选取了SOC训练集中的BMP2,BRDM_2,BTR70与T72作为EOC-2,EOC-3的训练集,选择T72的5类版本变体S7,A32,A62,A63,A64作为EOC-2的测试集,选择BMP2的两类配置变体9566,C21及T72的5类配置变体812,A04,A05,A07,A10作为EOC-3的测试集[15]。

构建完成后的EOC-1,EOC-2与EOC-3训练集与测试集总数量如表5所示。

表5 EOC-1,EOC-2与EOC-3数据集大小Tab.5 EOC-1,EOC-2 and EOC-3 dataset size

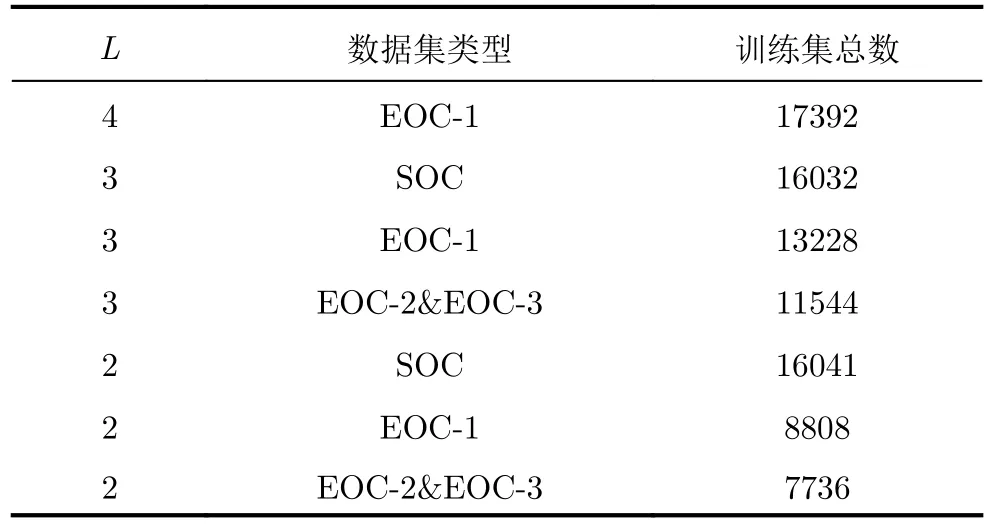

在图像预处理中,本文对所有的图像均中心裁剪成64×64。此外,本文还对部分训练集进行了数据增广,具体方法采用了由文献[8]提出的SAR图像增广方法。首先将原始图片中心裁剪为68×68,之后再随机裁剪多张64×64的图像,进行数据增广的训练集图像序列数量如表6所示。

表6 部分进行数据增广的数据集增广后大小Tab.6 The size of some data sets for data augmentation

4 实验

4.1 训练与测试

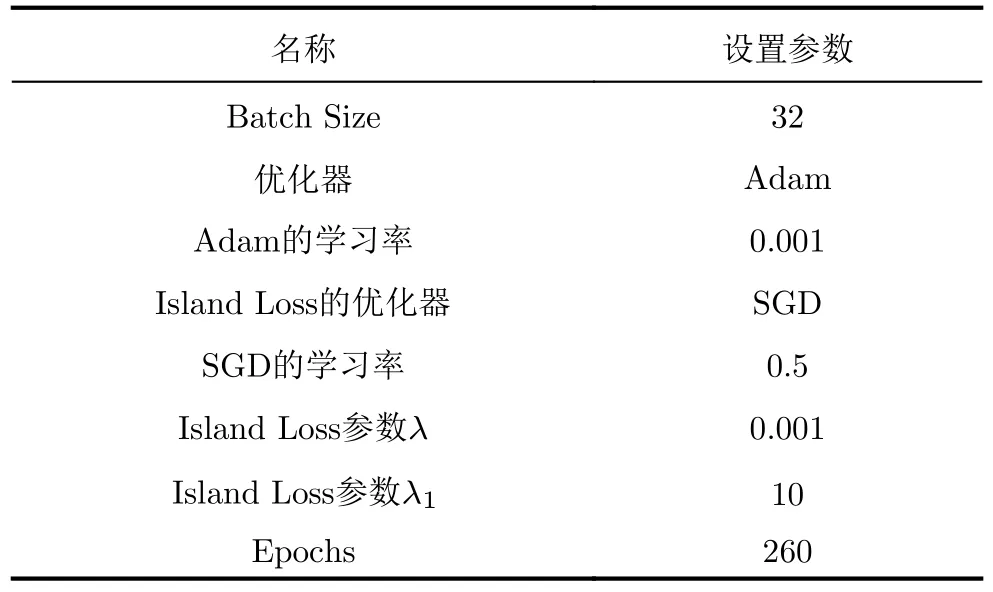

在SOC实验中,模型的各参数设置如表7所示。

表7 SOC实验中各参数设置Tab.7 Parameter in SOC experiment

在EOC-1实验中,数据增广前λ为0.01,数据增广后的λ为0.0001,训练的Epoch增加为300。对于Island Loss的超参数λ,其根据数据集的大小而变化,数据集图像序列越大,其数值应越少。在EOC-2与EOC-3实验中,其各项参数与SOC保持一致。

2.3 两组治疗前后血清白蛋白、非结合胆红素及总胆红素水平对比 治疗后,观察组黄疸新生儿血清白蛋白、肺结核胆红素、总胆红素水平均明显低于治疗前(P<0.05),而观察组明显低于对照组(P<0.05)。见表3。

在训练过程中,每80个Epoch,Adam优化器的学习率会缩减到1/10。此外,实验中使用了EfficientNet-B0在ImageNet数据集上的预训练模型,而BiGRU部分,则从头开始训练。

本文所有训练与测试实验均在Ubuntu18.04系统下进行。在硬件方面,实验采用了Intel i9-9900 CPU和NVIDIA RTX 2080Ti GPU。

4.2 SOC与EOC实验

在SOC实验中,其中图像序列个数为4,未进行数据集的增广,在正常数据集大小就达到了100%的识别准确率。

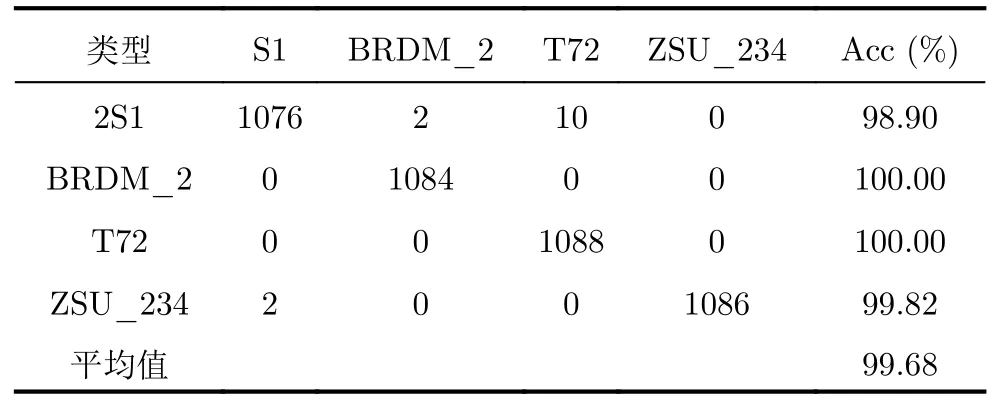

在EOC-1实验中,当图像序列个数为4时,且数据未增广时,识别准确率已达到99.08%,进行数据增广后,识别准确率提高为99.68%,其混淆矩阵如表8所示。

表8 图像序列数L为4时,EOC-1混淆矩阵Tab.8 The EOC-1 confusion matrix when L=4

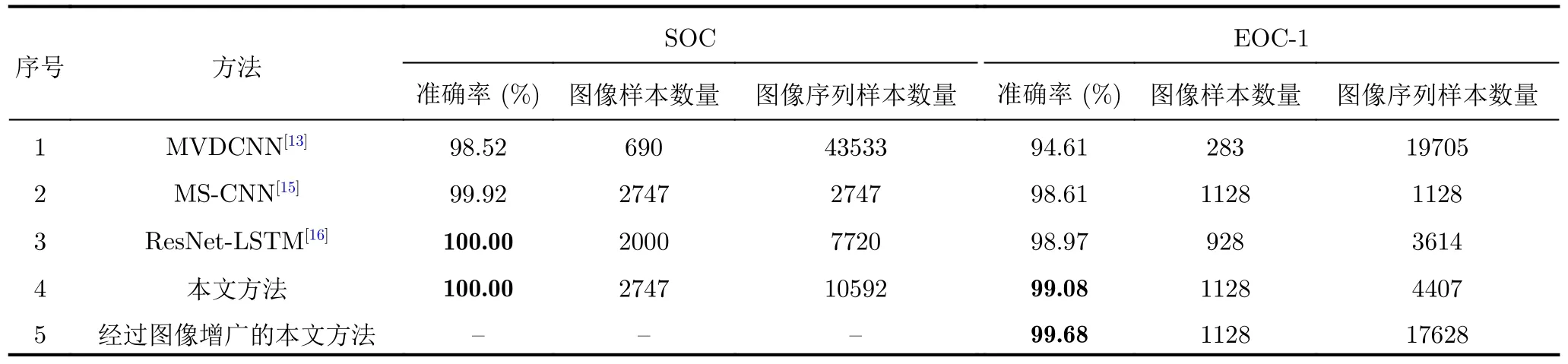

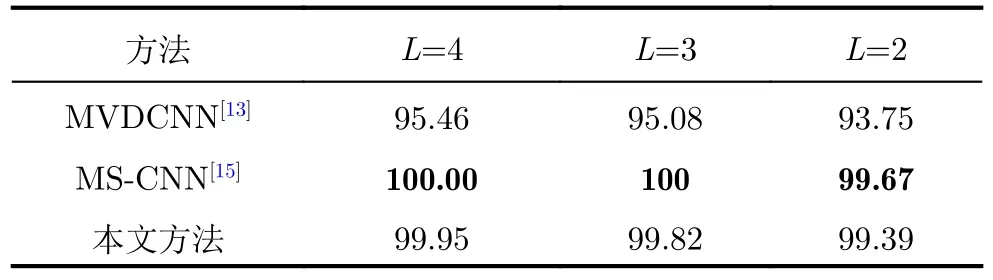

如表9所示,本文对比了当图像序列数为4时各主要方法的识别准确率。本文所提方法不仅在SOC数据集上取得了100%的识别准确率,在EOC-1数据集上取得的识别准确率也优于其他方法。

表9 图像序列数L为4时,各方法识别准确率在SOC与EOC-1数据集上对比Tab.9 Comparison of the recognition accuracy on SOC and EOC-1 dataset when L is 4

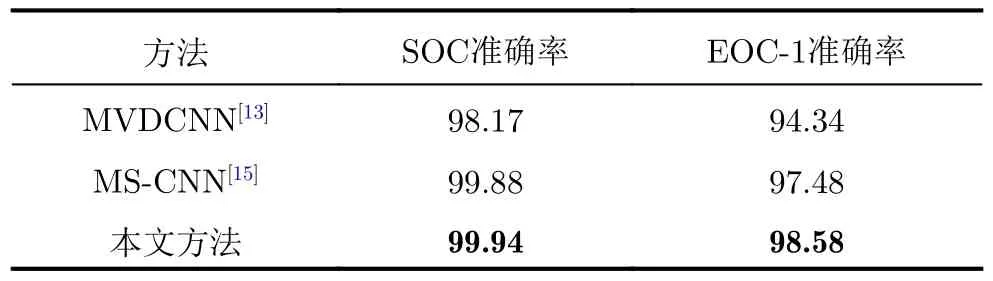

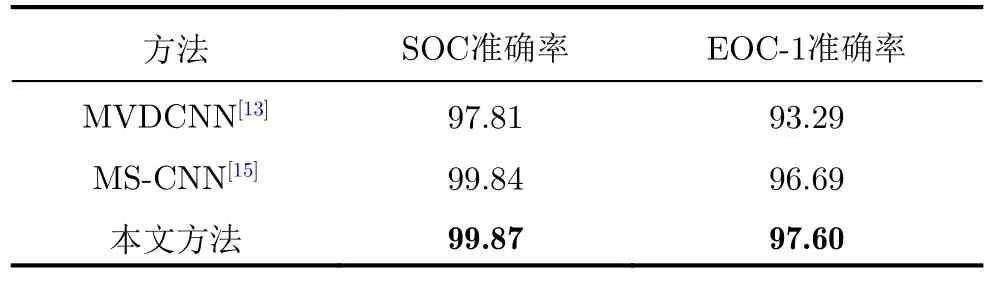

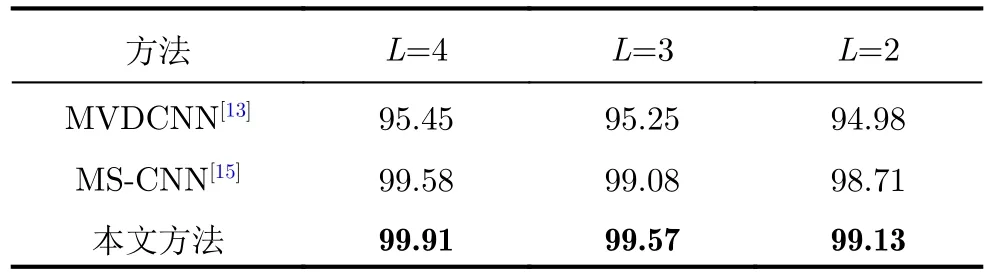

当图像序列数L为3,2时,SOC与EOC-1两种类型的测试集准确率如表10、表11,其中当图像序列数L为3时,SOC的准确率为99.94%,EOC-1的准确率为98.58%;图像序列数L为2时,SOC的准确率为99.87%,EOC-1的准确率为97.60%。与主要多角度识别方法进行对比如表10与表11所示。

表10 图像序列数L为3时,各方法准确率对比(%)Tab.10 Comparison of test accuracy when L=3 (%)

表11 图像序列数L为2时,各方法准确率对比(%)Tab.11 Comparison of test accuracy when L=2 (%)

表12 EOC-2数据集识别准确率对比(%)Tab.12 Comparison of accuracy on EOC-2 (%)

表13 EOC-3数据集识别准确率对比(%)Tab.13 Comparison of accuracy on EOC-3 (%)

对比其他方法,在SOC,EOC-1及EOC-3数据集上,本方法取得了相对更优的识别结果,在EOC-2数据集上,本文方法仅略低于MS-CNN[15]。

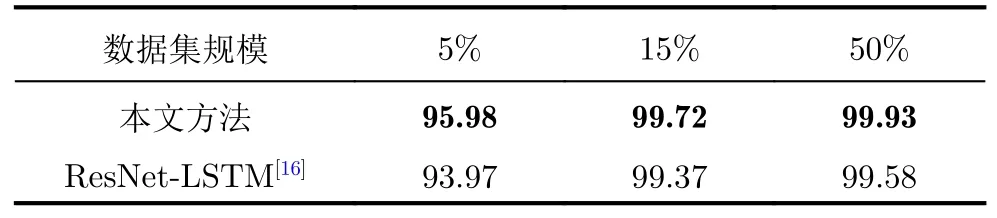

4.3 数据集缩减实验

由于SAR图像较难获取,SAR目标识别通常面临着数据样本较少的共性问题,因此,本文对图像序列L为4时的训练集进行了缩减,分别测试了本文所提方法和文献[13]所提方法在5%,15%,50%训练集规模上的识别准确率,测试结果如表14所示,可以看出,本文所提方法在数据集缩减的情况下同样保持了较高的准确率。

表14 在缩减数据集上的识别准确率(%)Tab.14 Recognition accuracy on the reduced dataset (%)

4.4 消融实验

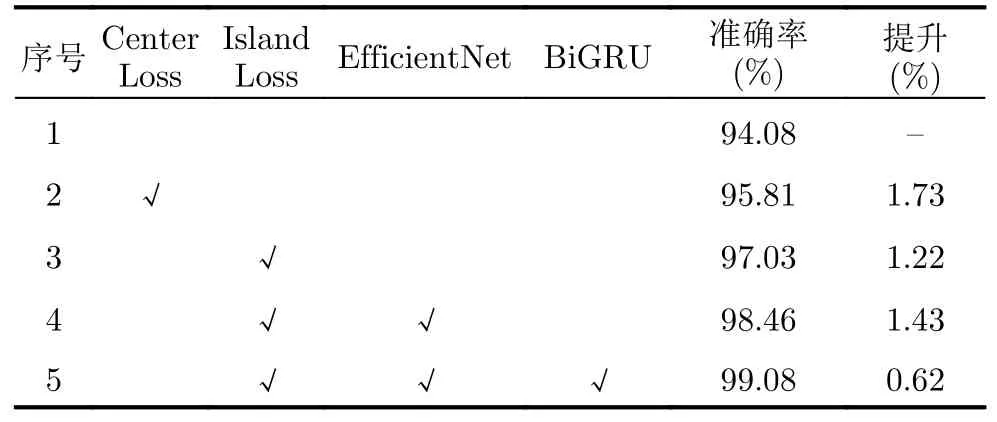

为验证不同模块对模型性能的影响,本文在图像序列数为4且未进行图像增广的EOC-1数据集上进行了消融实验。

消融实验以ResNet与GRU组成的基线模型为基础,依次进行添加Center Loss、改变Center Loss为Island Loss、改变骨干网络为EfficientNet-B0、改变GRU为BiGRU,操作对性能的影响如表15所示,其中序号1为基线模型的测试结果。

表15 消融实验结果Tab.15 Results of ablation experiments

由表15的实验结果,本文所采用的不同模块对模型的识别准确率均有较大的提升作用。在训练损失的改进上,Island Loss和Center Loss的加入对模型的识别准确率均有所提升,其中更改训练损失为Island Loss的效果更好,对比Center Loss提升了1.22%,对比基线模型提升了2.95%;更改骨干网络为EfficientNet-B0网络后,对比ResNet模型,识别准确率提升了1.43%;将GRU网络更改为BiGRU后,模型具有获取序列中双向信息的能力,进一步使识别准确率提升了0.62%。

消融实验展示了本文所采用的EfficientNet,BiGRU和Island Loss对识别性能的影响,三者的组合对比基线模型提升了5.00%的识别准确率,从而使本文所提方法取得了相当的目标识别性能。

5 结束语

本文提出一种基于EfficientNet,BiGRU与Island Loss的多角度SAR图像目标识别模型,其在SOC,EOC-1,EOC-3 3类数据集下的识别准确率均优于其他主流方法,在EOC-2数据集下的识别准确率也接近目前的最优准确率。

同时此模型也在训练样本减小的情况下维持了较高的识别准确率,有较好的鲁棒性,是多角度SAR目标识别任务中一种行之有效的方法。

然而,本文方法虽提高了EOC数据集的识别准确率,但仍没有达到SOC数据集的识别准确率水平,因此后续可以继续研究测试集和训练集存在一定差距情况下的模型改进和准确率提升问题。