基于深度学习的焊缝定位与缺陷识别

2021-10-21薛龙,曹楷顺,黄军芬,黄继强,邹勇,曹莹瑜

薛龙,曹楷顺,黄军芬,黄继强,邹勇,曹莹瑜

摘要:针对大型构件缺陷焊缝的自动定位及缺陷识别是实现焊缝打磨、补焊等自动化操作的必要条件。大型构件焊缝及焊缝缺陷图像具有形状多样、灰度分布随机等特点,加大了图像处理的难度。提出一种基于深度学习的焊缝定位及缺陷识别方法,通过深度学习目标检测方法确定焊缝位置并识别焊瘤及不合格缺陷,通过深度学习语义分割方法识别气孔及凹坑缺陷。选取FPN网络结构创建和训练焊缝定位及缺陷识别模型,并通过增加样本数量完成模型优化,焊缝定位识别准确率达到95%,焊瘤识别准确率达到98%,气孔与凹坑两类缺陷的识别准确率约为91.8%。

关键词:焊缝定位;缺陷识别;深度学习方法

中图分类号:TG441.7 文献标志码:A 文章编号:1001-2003(2021)09-0031-05

DOI:10.7512/j.issn.1001-2303.2021.09.06

0 前言

随着大型港机设备生产制造要求的进一步提升,监测其焊接质量成为保障生产安全的重要环节。港机大型设备在生产过程中焊接工作量大,不可避免地会产生如气孔、凹坑、焊瘤等焊接缺陷,由于焊缝数量多,依赖人工完成焊缝缺陷识别大大影响了工作效率。国内针对港机大型设备焊缝缺陷的自动化识别技术相较于国外发展较为落后,为了提高港机生产效率及生产质量,需要研发出焊缝缺陷自动化处理系统,其中焊接缺陷的自动化定位识别技术是重要关键点之一[1]。由于港机设备上不同位置的焊缝及焊缝缺陷的形状、亮度等不同,增大了定位识别难度。应对这种纹理、形状、亮度均有变化的对象识别,深度学习的方法具有很好的识别效果。因此,文中提出应用深度学习的方法实现焊缝定位与缺陷识别[2]。借助HALCON的深度学习功能,收集缺陷数据集进行网络模型训练以及优化,从而实现焊缝的定位以及缺陷识别。

1 焊缝定位与缺陷识别方案设计

深度学习在图像领域的三大主要功能为图像分类、目标检测及语义分割。图像分类是根据图像中主要特征信息确定图像中主要目标对象的类别。目标检测功能是针对每张图片包含多个待检测目标的情况,如工件图像中包含多种焊接缺陷(焊瘤、气孔等等),可用于确定图像中各种缺陷类别信息及其所在位置。语义分割功能是实现图像像素级别的定位与识别[3-5],适用于识别焊缝气孔、凹坑等边缘不规则的缺陷。基于深度学习的语义分割给予每个像素一个标签,分割的目标可以具有更精确的边缘,判断图像中的缺陷类型及缺陷边缘[6]。本研究中基于深度学习的目标检测功能开发焊缝定位算法,基于深度学习的语义分割功能开发气孔及凹坑焊缝缺陷识别定位算法。

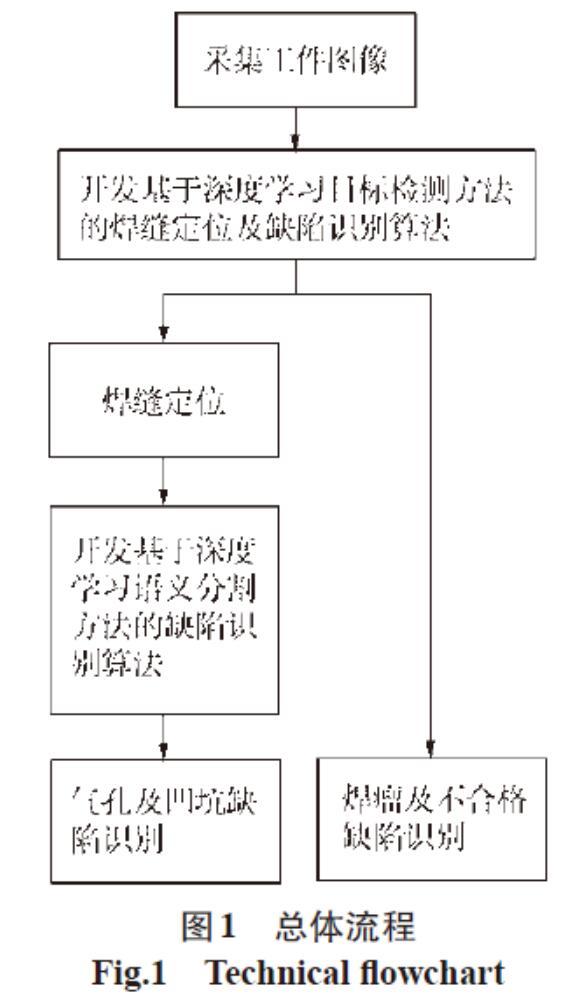

焊缝定位及缺陷识别总体流程如图1所示。采集工件图像后,通过深度学习目标检测方法完成焊缝定位任务,同时将焊瘤、存在严重不合格缺陷的焊缝进行定位识别;焊缝定位后,在焊缝区域通过深度学习语义分割方法识别凹坑及气孔缺陷。

文中深度学习方法应用的训练网络是基于FPN网络的结构。FPN网络是Tsung Yili等人在2017年提出的金字塔网络结构Feature Pyramid Network。通过该网络结构解决了不同尺寸图像的目标检测问题[7],它可以将卷积神经网络的高维特征与低维特征进行融合,使网络所包含的语义更加丰富。在塔形结构端部的目标会有更高的分辨率,有助于小目标的识别[8]。FPN网络结构如图2所示。

研究过程中发现,代表焊缝及焊缝缺陷的像素在图像中的占比非常小,而高分辨率的相机拍摄的工件图像包含的信息量非常大,焊缝及缺陷属于小目标,因此适合运用这种塔形结构的FPN网络进行焊缝定位及缺陷识别,既保证了图像输入输出尺寸前后一致,又保证了焊缝与焊缝缺陷最终的识别效果。

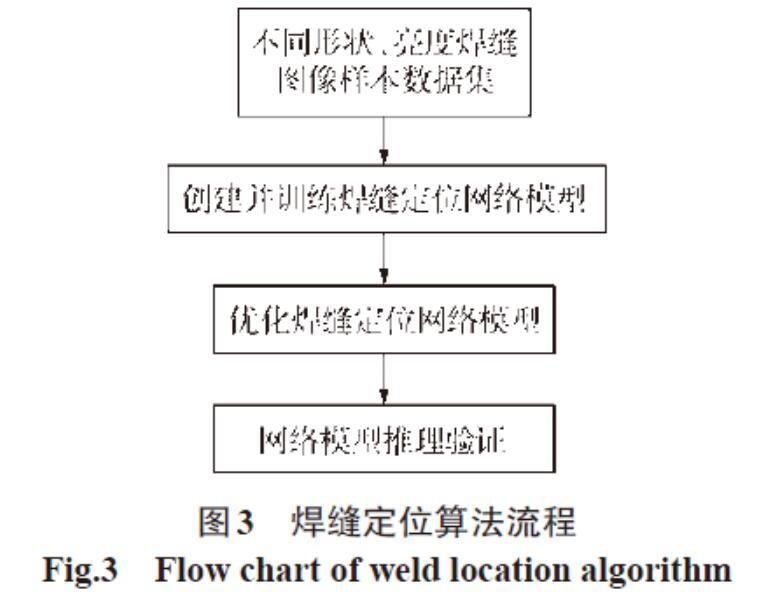

2 焊缝定位

焊缝定位算法通过深度学习中的目标检测功能来实现。目标检测工作流程主要包含:准备数据、网络模型训练、推理验证。准备数据包括采集焊缝图像、图像中焊缝标注;训练包括选取网络框架并创建网络模型,基于特定待识别目标训练模型,并评估训练模型的性能;推理验证即指在新图像集上应用训练好的模型。焊缝定位算法流程如图3所示。

2.1 焊缝定位网络模型训练

基于深度学习目标检测方法的焊缝定位算法要求有充足的焊缝图像样本,样本中包括不同形状、亮度的焊缝,然后对图像中的焊缝进行标注,基于FPN网络结构创建和训练焊缝定位模型,以及优化网络模型等。

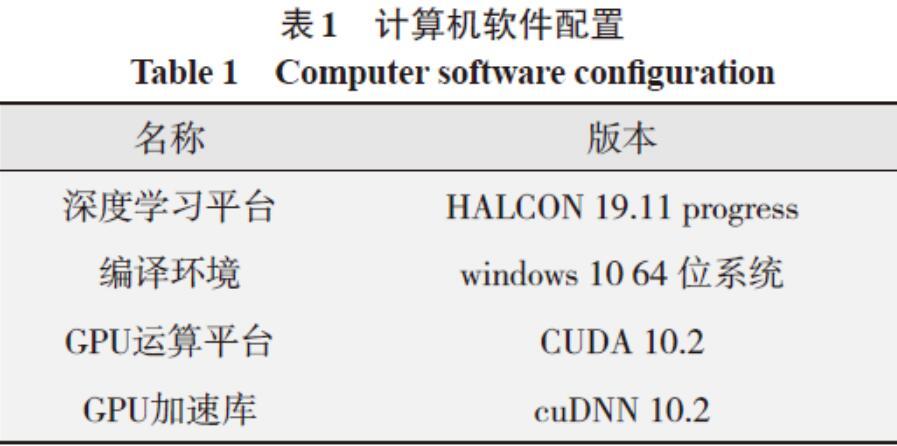

训练用于焊缝目标检测的深度学习网络使用的计算机硬件配置为:CPU型号Intel Corei7-6700HQ,GPU型号NVIDIA GeForce GTX 1060,运行内存为6 GB,固态硬盘存储容量为256 GB,内存为金士顿 DDR4,参数为8 GB@ 2 400 MHz。軟件参数如表1所示。

软硬件的合理配置可确保网络模型训练的顺利进行。焊缝图像样本数据集共444张图像,其中测试集为65张,约占总图像数量的12%,剩余379张图像用于焊缝定位网络模型训练,经统计,总体识别准确率为78.8%,如图4所示,焊缝识别效果不太理想,需要进一步优化网络模型。

2.2 网络模型优化

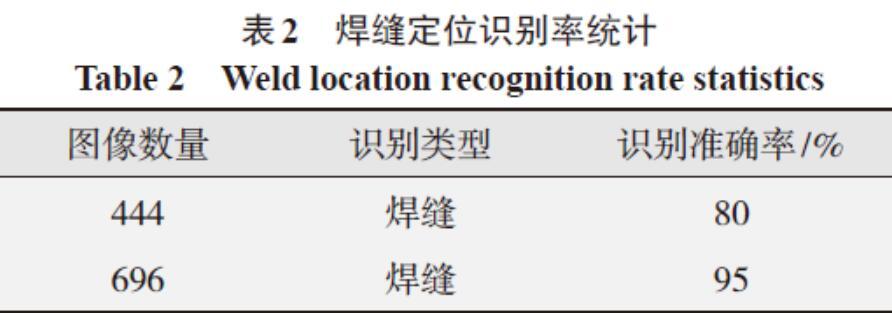

通过分析上面网络模型训练结果,对样本图像数据进行调整,重新对网络模型进行训练,在训练中将训练图像增加到696张,焊缝定位识别准确率增加到95%。初始网络模型训练后焊缝识别结果及网络模型优化后焊缝识别结果统计如表2所示。

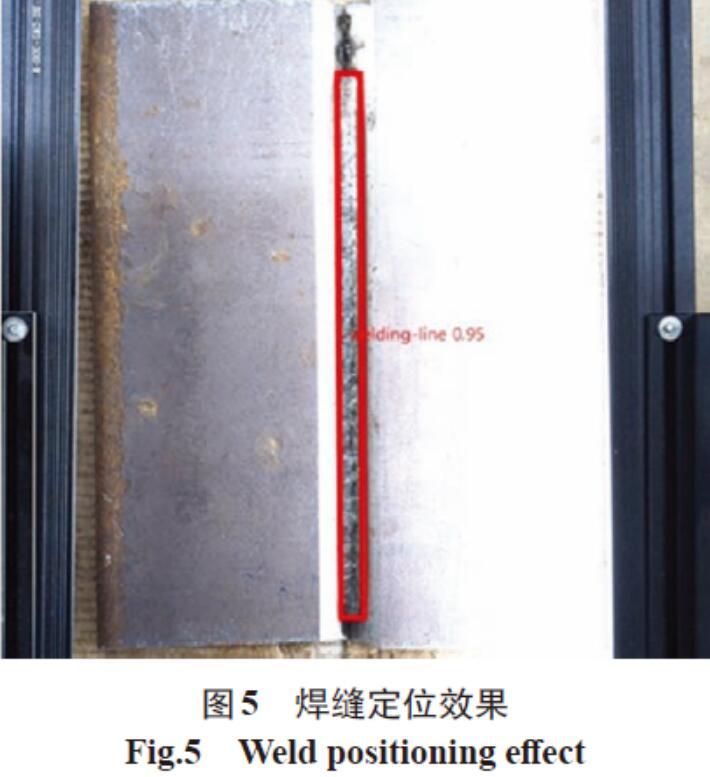

识别准确率的提升反应到焊缝图像中即为准确的焊缝定位,定位效果如图5所示。图中红色矩形框中的区域便是网络模型优化后定位识别的焊缝区域,该区域很好地覆盖了焊缝位置,虽然工件右侧受到强光干扰,半块工件反光严重,不过坡口中焊缝位置依然准确。综上所述,充足数量的训练样本可以提升网络模型的训练效果。

3 缺陷识别

工件中的焊缝缺陷根据特征不同分别应用深度学习目标检测和语义分割两种方法进行识别。焊缝图像中焊瘤缺陷轮廓的圆度较高并且通常与焊缝分离,因此使用深度学习目标检测的方法进行识别定位。焊缝上的气孔、凹坑缺陷因为与焊缝融合并且边缘轮廓不规则,采用深度学习语义分割方法进行识别定位。针对这两种缺陷识别方案进行了实验研究。

3.1 应用深度学习目标检测法实现缺陷识别

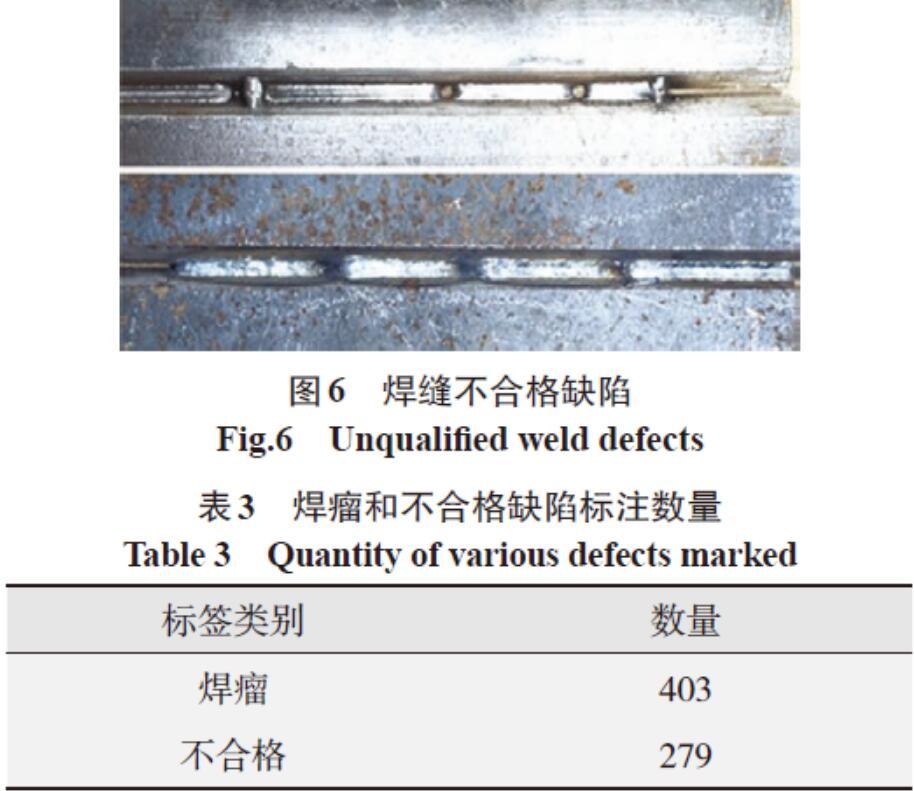

在采用深度学习目标检测方法进行焊缝定位识别的过程中,标注焊缝的同时可以将焊瘤缺陷与断续焊缝(定义为不合格缺陷,见图6)一起标注出来,具体标注数量如表3所示。通过网络模型训练,在实现焊缝定位识别的同时也实现了焊瘤及不合格缺陷的定位识别。

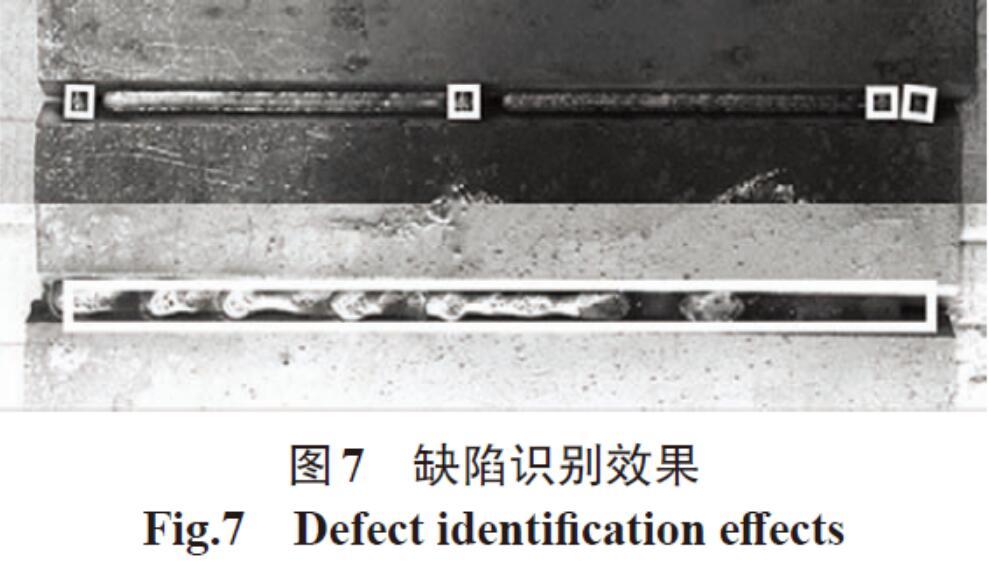

统计网络模型训练结果得出,焊瘤缺陷识别准确率为80%、不合格类型识别准确率为67%。通过不断优化训练数据集,焊瘤识别准确率由80%提高到98%,不合格缺陷识别准确率由67%提高到78%,焊瘤与不合格缺陷识别效果如图7所示。

图7中白色框选范围内是通过网络模型识别的缺陷位置。上面焊缝中共有4个焊瘤缺陷,都被准确地识别出来;下面焊缝属于不合格缺陷,框选区域表明对这类缺陷有良好的识别定位效果。

3.2 应用深度学习语义分割法实现缺陷识别

在完整识别焊缝的基础上对焊缝上存在的气孔、凹坑缺陷进行下一步的识别,此时就需要借助深度学习的语义分割方法。气孔、凹坑缺陷边缘较为清晰,但是边界形态各异,深度学习语义分割的方法可以细化每个像素的分类,较适用于边缘不规则缺陷的识别。凹坑缺陷及标注示意如图8所示,气孔缺陷与标注后效果示意如图9所示。

深度学习语义分割方法的工作流程同样包括准备数据、网络模型训练、推理验证三部分,其中准备数据包括采集焊缝图像、图像中气孔及凹坑的标注。语义分割方法要求图像标注精确度较高,达到像素级标注,可以从根本上解决边缘不贴合目标、背景信息过多等问题。实验中标注完成的训练图像共430张,推理验证数据集共73张图像。

深度学习语义分割方法通常采用交并比均值(MIoU)和像素精度均值(MPA)作为算法衡量标准。其中MIoU是将焊缝中每一类(背景、气孔、凹坑)的交并比求平均值。每一类的交并比是属于该类的实际像素集合与预测像素集合的交集和并集之比。焊缝图像分为背景、气孔、凹坑3类(k=0,1,2),MIoU的计算公式如式(1)所示

式中 pij表示本属于类i但被预测为类j的像素数量,pii为预测正确的像素数量,pji表示本属于类j但被预测为类i的像素数量。交并比均值是简单、高效的衡量缺陷识别准确程度的参数[9]。

准确率均值是指分别计算背景、气孔、凹坑3类中每个类别分类正确的像素数和该类所有像素数的比例然后求平均。MPA的计算公式如式(2)所示。

语义分割方法同样基于FPN网络结构创建和训练网络模型,训练后获得交并比均值MIoU为0.582 (MIoU>0.5),准确率均值MPA为0.683(MPA>0.5),表明网络模型满足要求。

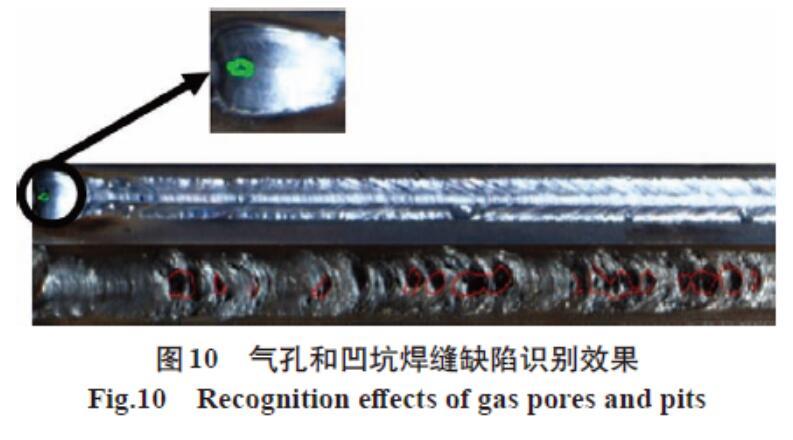

基于语义分割方法网络模型训练气孔与凹坑两类缺陷的识别准确率约为91.8%,体现出了语义分割方法在焊缝缺陷识别上的良好效果。焊缝气孔和凹坑识别效果如图10所示。

4 结论

(1)采用深度学习目标检测法识别并定位焊缝,基于FPN网络结构创建和训练焊缝定位模型,通过增加图像数据集优化定位模型,焊缝定位识别准确率达到95%。

(2)采用深度學习目标检测法实现了焊瘤和不合格缺陷识别,通过优化训练数据集,焊瘤识别准确率达到98%,不合格缺陷识别准确率达到78%。

(3)采用深度学习语义分割方法进行了焊缝气孔和凹坑两类缺陷的识别,识别准确率约为91.8%。

参考文献:

[1]Edwards G R. Inspection of welded joints[M]. ASM handbook welding, brazing and soldering,ASM International,1993(6):1081-1088.

[2]范立南,韩晓微,张广渊. 图像处理与模式识别[M]. 北京:科学出版社,2007:1-2.

[3]苏赋,吕沁,罗仁泽.基于深度学习的图像分类研究综述[J]. 电信科学,2019,35(11):58-74.

[4]顾佳晨,高雷,刘路璐.基于深度学习的目标检测算法在冷轧表面缺陷检测中的应用[J]. 冶金自动化,2019,43(6):19-22,27.

[5]侯文慧. 基于深度学习的焊缝图像缺陷识别方法研究[D]. 安徽:中国科学技术大学,2019.

[6]凌晨,张鑫彤,马雷.基于Mask R-CNN算法的遥感图像处理技术及其应用[J]. 计算机科学,2020,47(10):151-160.

[7]刘艳飞,丁乐乐,孟凡效,等.深度辨别性增强网络高分影像语义分割[J]. 遥感信息,2021,36(2):24-31.

[8]程龙.基于特征融合的目标检测算法研究[D].北京:北京邮电大学,2020.

[9]旷视科技数据业务团队. 计算机视觉图像与视频数据标注[M]. 北京:人民邮电出版社,2020.