基于门控权重单元的多变量时间序列预测

2021-09-14张冬梅李金平李江余想宋凯旋

张冬梅 李金平 李江 余想 宋凯旋

摘 要:多变量时间序列各变量间依赖性较强,数据变化趋势不明显,预测难度高. 传统研究采用带门控机制的循环神经网络及变体进行预测,但序列间存在相互依赖关系,突变数据段建模预测不精确. 基于信息熵,本文提出一种新的改进门控权重单元,利用信息熵技术量化数据序列的变化程度,动态调整权重矩阵刻画数据的变化趋势. 基于4个公开数据集分别进行实验,实验结果表明新模型比传统循环神经网络模型具有更好的预测性能.

关键词:多变量时间序列;门控机制;循环神经网络;门控权重单元;信息熵

中图分类号:TP391 文献标志码:A

Multivariate Time Series Prediction Based on Gating Weight Unit

ZHANG Dongmei LI Jinping LI Jiang YU Xiang SONG Kaixuan

(1. School of Computer Science,China University of Geosciences,Wuhan 430074,China)

2. Information Center,Department of Natural Resources of Hubei Province,Wuhan 430071,China)

Abtract:There is strong dependence among the variables of multivariate time series,which makes the data trend unobvious and the prediction difficult. Traditionally,recurrent neural network with gating mechanisms and its variants are used for prediction. But the interdependence between sequences makes the prediction result of mutation data not accurate. Based on information entropy,a new modified gating weight unit is presented. The change degree of data is quantified by using information entropy to dynamically adjust the weight matrix and describe the trend of data. The experiment is conducted with four public data sets. The experimental results show that the proposed model has better prediction performance than the traditional recurrent neural network.

Key word:multivariate time series;gated mechanism;recurrent neural network;gating weight unit;information entropy

多變量时间序列预测根据历史数据对未来进行预测,是近年来研究的热点问题. 多变量序列间存在的相互依赖关系难以学习、特别是突变数据的变化趋势挖掘困难,导致该类问题的预测精度不高[1]. 早期研究主要是通过建立加权滑动平均模型、差分整合移动平均自回归模型等模型进行预测,简单直观,但极易损失变量间的动态依赖信息. 近年基于浅层机器学习的非参数模型是多变量时间序列预测问题的主流方法,可有效克服序列非线性和变量依赖性强等问题,如支持向量回归(Support Vector Regression,SVR)、高斯过程回归(Gaussian Process Regression,GPR)等具有更好的性能,但浅层机器学习方法易过拟合,影响预测精度[2].

早期网络模型不能解决长期依赖问题,存在梯度消失和梯度爆炸现象[3-4]. 目前多利用深度学习中的循环神经网络(Recurrent Neural Network,RNN)模型解决多变量时序预测问题[5]. Graves在RNN单元中引入记忆单元和门控机制,提出长短期记忆网络(Long Short-Term Memory,LSTM)[6],解决RNN的长期依赖问题. 目前对于循环神经网络的改进多基于LSTM门控机制的扩展,如Zhou等提出的最小门控单元(Minimal Gated Unit,MGU)[7]、Gers 等提出的窥视孔连接[8]、Cho等提出的门控循环单元(Gate Recurrent Unit,GRU)[9]、刘颉曦等提出的混合门单元[10]. 各类LSTM变体虽然对LSTM的结构进行了改进优化,但没有根本解决门控组件难以学习突变数据变化趋势的问题,对变化剧烈的时序数据预测效果较差[11-12].

信息熵(Information Entropy)技术通过概率分布计算刻画数据分布变化,Haghizadeh等使用信息熵度量灾害突发信息,在洪涝灾害预防方面取得较好效果[13].Naghibi等使用信息熵模型预测地下水变化趋势[14].信息熵对数据变化敏感,可较好度量时序数据的变化程度. 针对非稳态数据预测问题,本文对网络单元的门控机制进行扩展,提出一种新的E-LSTM单元(Entropy-LSTM,E-LSTM). 与同类研究工作不同的是通过引入信息熵技术量化数据变化程度,设置两个动态调整权重矩阵代替传统遗忘门权重矩阵,刻画数据变化趋势. 新单元通过信息熵动态调整权重矩阵,克服了传统LSTM单元难以挖掘突变数据段变化趋势的问题,有效提升了模型的预测精度.

本文主要贡献有2个方面:

1)融合信息熵和循环神经网络技术进行时序序列预测;

2)引入信息熵动态调整权重矩阵扩展门控机制,对时序数据中的突变特征提出新的量化方法和技术,相较于传统LSTM预测精度更高.

1 模 型

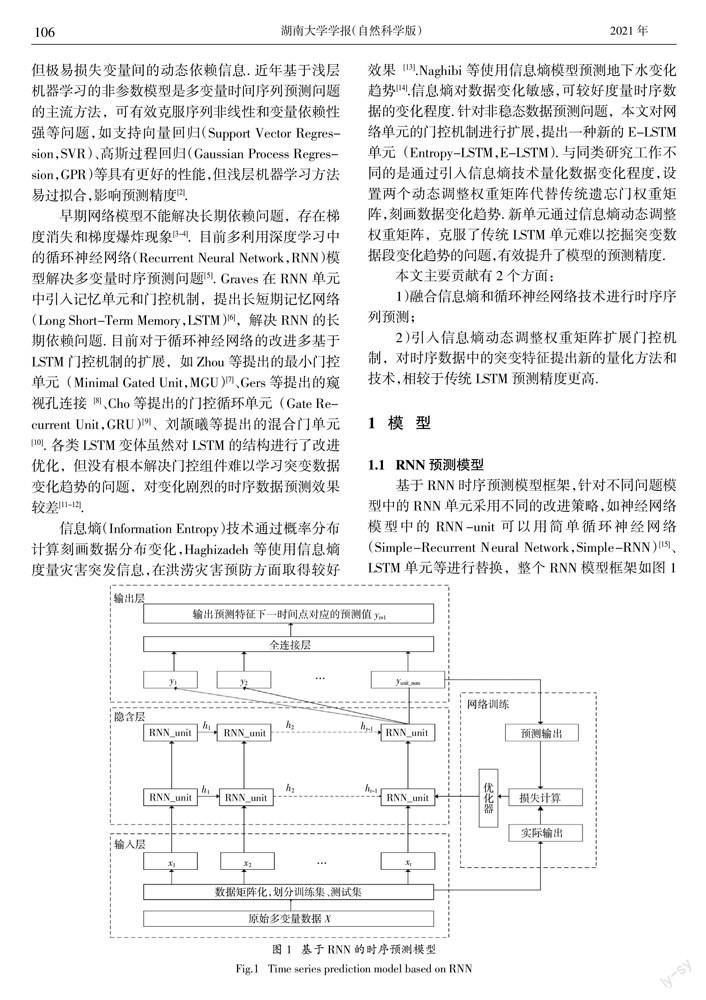

1.1 RNN预测模型

基于RNN时序预测模型框架,针对不同问题模型中的RNN单元采用不同的改进策略,如神经网络模型中的RNN-unit可以用简单循环神经网络(Simple-Recurrent Neural Network,Simple-RNN)[15]、LSTM单元等进行替换,整个RNN模型框架如图1所示. t时刻隐藏单元RNN-unit接收网络前一时刻的隐藏层输出ht-1和当前输入层输入的xt,按隐含层更新方法计算当前时刻的最后一层隐藏层输出yt+1.

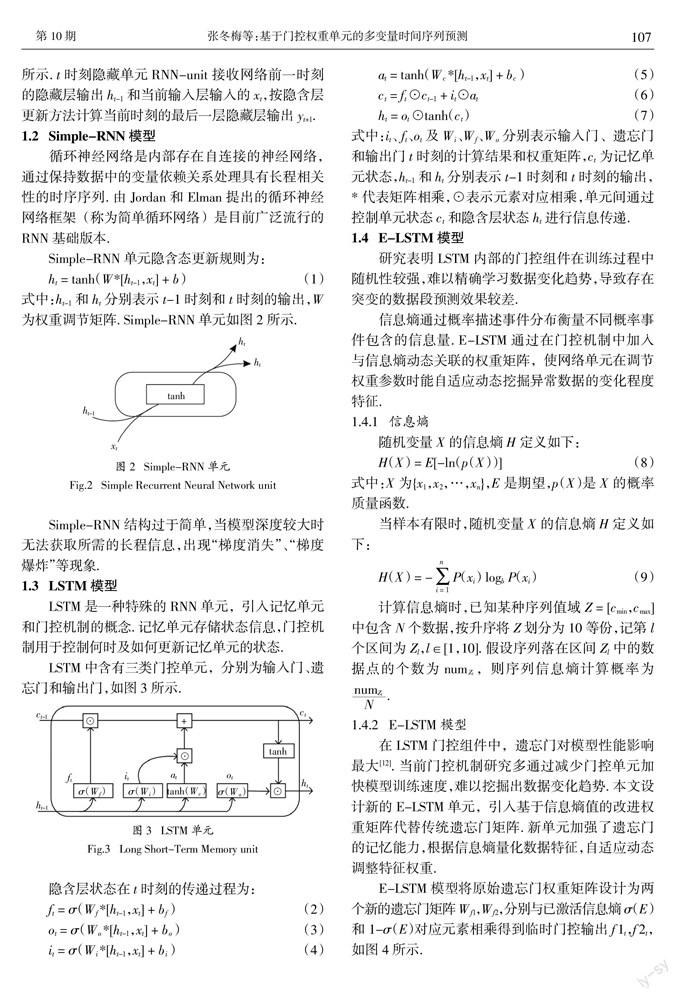

1.2 Simple-RNN模型

1.3 LSTM模型

1.4 E-LSTM模型

研究表明LSTM内部的门控组件在训练过程中随机性较强,难以精确学习数据变化趋势,导致存在突变的数据段预测效果较差.

信息熵通过概率描述事件分布衡量不同概率事件包含的信息量. E-LSTM通过在门控机制中加入与信息熵动态关联的权重矩阵,使网络单元在调节权重参数时能自适应动态挖掘异常数据的变化程度特征.

1.4.1 信息熵

1.4.2 E-LSTM模型

1.4.3 E-LSTM模型反向傳播

2 实验与分析

本节结合4个多变量时序数据集评估新提出的E-LSTM模型,并将其性能与其他模型(Simple-RNN、LSTM、GRU)进行比较,所有RNN模型均基于TensorFlow框架实现.

2.1 度量指标

2.2 数据说明

实验使用的4个多变量时序数据集为3个股市数据集和1个空气湿度指数预测数据集,划分前60%为训练集,后40%为测试集.

股票数据集:3个股票公开数据集收录于Kaggle Datasets机器学习库,分别记作“BAC”、“GS”、“C”. 每个数据集有2 517条记录,包含5个有效特征(收盘价、开盘价、最低价、最高价、成交量).

空气湿度指数预测数据集:收录于UCI机器学习库,主要记录在雅典沿海地区的海面湿度数据,数据集记作“USV”. 该数据集有1 672条记录,包含4个有效特征(设备号、湿度、温度、报告时间). 数据缺失时,选择用对应属性平均值补齐.

2.3 参数调优

选择LSTM网络作为基准结构. 循环神经网络训练均以小批量进行,批次大小为128,所有模型训练2 000代. 构建E-LSTM预测模型前,预先调整网络模型的隐含层层数和各层神经元数量. 其中隐含层层数的候选集为{1,2,3} ,神经元数目候选集为{16,32,64,96,128}.

基准结构在设置超参数时采用“控制变量法”. 固定其他参数,从候选集{16,32,64,96,128}中依次选择神经元数目. 随着隐含层神经元数量的增加,模型预测性能逐步提升,并在神经元数量为32或64时达到候选集参数的最高精度,当神经元数量超过64时会出现过拟合导致精度下降. 基准模型不同神经元节点数量的具体性能评价指标如表1所示. 后续实验中,将隐含层神经元的数量设置为64.

2.4 权重矩阵分析

为说明E-LSTM模型两个基于信息熵的权重矩阵的动态调整效果,对训练过程中Wf1和Wf2的变化进行实验. 由于权重矩阵维度较高、不易衡量特征向量的变化趋势,使用频率直方图描述训练过程中权重矩阵的变化,其中横坐标为权重矩阵Wf1和Wf2的取值,纵坐标为权重矩阵值出现次数. 以数据集“BAC”为例进行实验,结果如图6所示,图6(a)与图6(b),图6(c)与图6(d)分别为训练初期和结束训练时的Wf1和Wf2的频率分布直方图. 对比图6(a)、图6(c)发现Wf1早期部分权重值分布多集中于0,后期部分权重系数上升至1,这说明Wf1捕获到了数据的突变特征,改变了权重系数. 对比图6(b)、图6(d)发现Wf2在训练过程中发生大幅度变化,0附近的权重参数频率从4 000下降到3 000,0.5和-0.5附近的权重参数频率显著增加,说明Wf2权重变化与数据变化趋势相关.

实验结果表明,基于信息熵的权重矩阵Wf1和Wf2在训练过程中能够识别出数据的变化趋势,并做相应的权重调整.

2.5 时间分析

2.6 实验对比

根据调优设置参数进行训练,各模型在4个测试集上实验结果如表5所示. 其中加粗部分表示传统循环神经网络(GRU,LSTM,Simple-RNN)的最优效果,灰色背景表示添加E-LSTM后所有模型的最优效果. 实验得到以下结论:

传统循环神经网络方法中,Simple-RNN结构简单,针对不同数据集效果差异大,数据集越复杂效果越差. LSTM和GRU两者性能相当且稳定性均优于Simple-RNN.

与传统循环神经网络方法相比,本文提出的E-LSTM模型在4个数据集上的MAE、RMSE和MAPE指标精度更高.

实验4个数据集预测部分曲线如图8所示. 显然E-LSTM模型预测结果在所有数据集上与真实值最接近,预测精度最高. 以数据集C为例,传统方法(GRU,LSTM,Simple-RNN)在突变数据段处(图8(b))的预测值与真实值误差较大,由于基于信息熵的权重矩阵能够更好地量化数据的变化趋势,E-LSTM模型在数据变化段的预测值与真实值基本一致,预测效果更优.

3 结 论

本文提出一种基于信息熵改进门控权重单元的时间序列预测方法,并与Simple-RNN、LSTM、GRU等传统预测模型进行对比分析. 研究证实E-LSTM可根据输入数据的特征动态调整新权重矩阵的权重系数,更好地刻画数据的变化趋势,实验结果表明,本文提出的E-LSTM模型对局部突变数据更为敏感,预测精度更高.

在后续的研究中将进一步结合多重分形等技术改进模型的门控权重,细粒度刻画数据多尺度的变化趋势,提升模型的预测效率.

参考文献

[1] BOX G, JENKINS G M, REINSEL G C,et al. Time series analysis:forecasting and control,5th edition[J]. Journal of the Operational Research Society,2015,22(2):199—201.

[2] BENGIO Y,LECUN Y. Scaling learning algorithms toward AI[M]//Large-Scale Kernel Machines.:The MIT Press,2007,34(5):1-41.

[3] BENGIO Y,SIMARD P,FRASCONI P. Learning long-term dependencies with gradient descent is difficult[J]. IEEE Transactions on Neural Networks,1994,5(2):157—166.

[4] TSIRONI E,BARROS P,WEBER C,et al. An analysis of convolutional long-short term memory recurrent neural networks for gesture recognition[J]. Neurocomputing,2017,268:78—86.

[5] 许淼,刘宏飞,初凯. 基于AM-LSTM模型的共享单车时空需求预测[J]. 湖南大学学报(自然科学版),2020,47(12):77—85XU M,LIU H F,CHU K. Spatiotemporal demand prediction of bike-sharing based on AM-LSTM model [J]. Journal of Hunan University (Natural Sciences),2020,47(12):77—85. (In Chinese)

[6] GRAVES A. Long short-term memory[M]. Berlin:Springer,2012:1735—1780.

[7] ZHOU G B,WU J X,ZHANG C L,et al. Minimal gated unit for recurrent neural networks[J]. Int Journal of Automation and Computing,2016,13 (3):226—234.

[8] GERS F A,SCHMIDHUBER J. Recurrent nets that time and count[C]//Proceedings of the IEEE-INNS-ENNS International Joint Conference on Neural Networks. NeuralComputing:New Challenges and Perspectives for the New Millennium. Como,Italy:IEEE,2000:189—194.

[9] CHO K,VAN MERRIENBOER B,BAHDANAU D,et al. On the properties of neural machine translation:encoder-decoder approaches[C]//arXiv Preprint arXiv:1409.1259,2014.

[10] 劉颉羲,陈松灿. 基于混合门单元的非平稳时间序列预测[J]. 计算机研究与发展,2019,56(8):1642—1651.LIU J X,CHEN S C. Non-stationary multivariate time series prediction with MIX gated unit[J]. Journal of Computer Research and Development,2019,56(8):1642—1651. (In Chinese)

[11] JOZEFOWICZ R,ZAREMBA W,SUTSKEVER I. An empirical exploration of recurrent network architectures[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille,France:JMLR,2015:2342-2350.

[12] YANG Y. Hybrid method for short-term time series forecasting based on EEMD[J]. IEEE Access,2020,8:61915—61928.

[13] HAGHIZADEH A,SIAHKAMARI S,HAGHIABI A H,et al. Forecasting flood-prone areas using Shannons entropy model[J]. Journal of Earth System Science,2017,126(3):1—11.

[14] NAGHIBI S A,POURGHASEMI H R,POURTAGHI Z S,et al. Groundwater qanat potential mapping using frequency ratio and Shannons entropy models in the Moghan watershed,Iran[J]. Earth Science Informatics,2015,8(1):171—186.

[15] JEFFREY L. ELMAN. Distributed representations,simple recurrent networks,and grammatical structure[J]. Machine Learning,1991,7(2/3):195—225.