卷积神经网络模型研究分析*

2021-08-30郭俊亮张洪川

郭俊亮,张洪川

(铜仁职业技术学院,贵州 铜仁554300)

卷积神经网络是一种局部提取特征的方法,可以有效地响应局部模式,用这种方法提取整张图片的特征,它是平移不变模式。在网络逐层累加的过程中,对图像进行了缩放。卷积神经网络的核心是卷积层和池化层。

1 卷积神经网络的核心运算

1.1 卷积层的运算

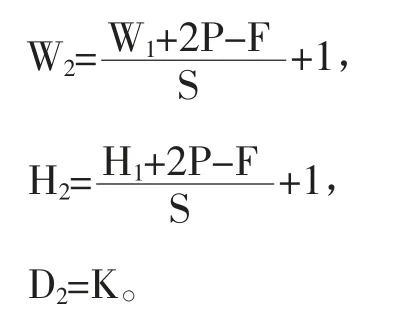

(1)输入:W1×H1×D1。

(2)超参数:卷积核的个数:K,卷积核的尺寸:F,步长:S,填充:P。

(3)输出:W2×H2×D2,

(4)参数:(F×F×D1+1)×K,其中,W是图像的宽度,H是图像的高度,D是图像的深度。

1.2 池化层运算

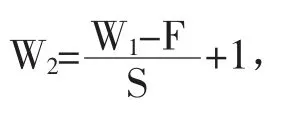

(1)输入:W1×H1×D1。

(2)超参数:卷积核的尺寸:F,步长:S。

(3)输出:W2×H2×D2,

参数:最大池化和平均池化是没有参数的,但是一些池化方法中是有参数的。

2 卷积神经网络经典模型

2.1 LeNet-5网络结构

LeNet-5是由输入层、卷积层、池化层、卷积层、池化层、全连接层、全连接层、输出层组成[1]。输入层图像的尺寸大小是32*32,卷积层C1使用了6个5*5*1卷积核,对输入图像进行valid卷积操作,输出28*28*6。池化层S2使用了6个2*2的矩阵,对28*28*6进行最大池化操作,输出14*14*6。卷积层C3使用了16个5*5*6的卷积核,对14*14*6进行valid卷积操作,输出10*10*16。池化层C4使用了16个2*2的矩阵,对10*10*16进行最大池化操作,输出5*5*16。全连接层有两个隐含层,第一个隐含层有120个神经元,第二个隐含层有84个神经元。输出层有10个神经元。

2.2 AlexNet网络结构

AlexNet是由卷积层、池化层、卷积层、池化层、卷积层、卷积层、卷积层、池化层、输出层组成[2]。输入层图像的尺寸是224*224*3,在实际应用中,需要变成227*227*3,卷积层C1使用了96个11*11*3卷积核,对输入图像进行步长为4的valid卷积操作,输出55*55*96。S1使用96个3*3卷积核,对55*55*96进行步长为2的valid最大值池化操作,输出27*27*96。C2使用了256个5*5*96卷积核,对27*27*96,进行same卷积操作,输出27*27*256。S2使用256个3*3卷积核,对27*27*256,进行步长为2的valid最大池化操作,输出13*13*256。C3使用256个13*13*256卷积核,对13*13*256进行same卷积操作,输出13*13*384。C4使用384个13*13*384卷积核,对13*13*384进行same卷积操作,输出13*13*384。C5使用256个13*13*384卷积核,对13*13*384进行same卷积操作,输出13*13*256。S3使用3*3*256卷积核,对13*13*256进行步长为2的valid最大池化操作,输出6*6*256。全连接层6有4096个神经元,全连接层7有4096个神经元,输出有1000个神经元。

2.3 VGG网络结构

VGG是由牛津大学计算机视觉组和DeepMind公司共同研发的经典的CNN模型,它采用小卷积核和增加网络的深度方法,对网络最后的分类识别效果有很大作用[3]。VGG共有6种不同的网络结构,它们都包含5组卷积操作,每组卷积包括2个2*2或3个2*2卷积操作,然后进行2*2的最大值池化,将卷积层和最大池化层反复叠加,最后连接3个全连接层,组成VGG网络结构,现在,在图像处理研究和应用最多的是VGG16和VGG19,VGG16是卷积层和池化层叠加的层数是16,VGG19是卷积层和池化层叠加的层数是19,两者只是网络的深度不同,VGG16是16层,VGG19是19层。

2.4 Inception

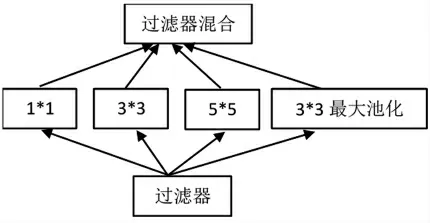

Inception网络结构是由Google团队提出,因此也称为GoogLeNet,该模型一共有四个版本,V1到V4[4]。采用并行执行多个具有不同尺度的卷积运算或池化操作,并将多个卷积核卷积的结果拼接到一起,增加特征图的深度,使用全局平均池化代替全连接层。在V2中,采用Batch Normaliziton。在V3中,采用非对称卷积降低运算量。如图1所示。

图1 经典Inception模块

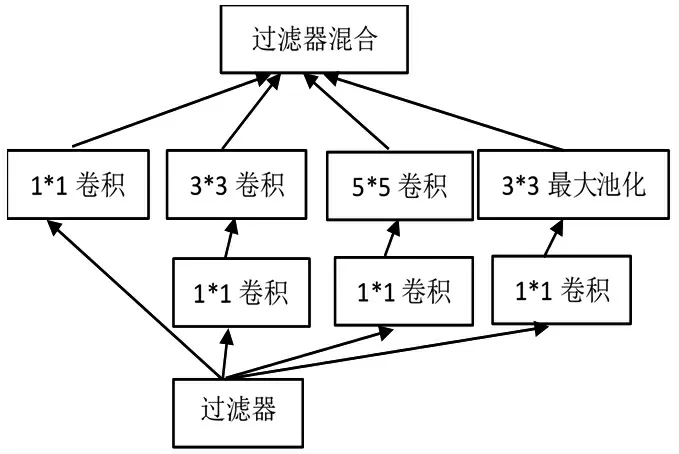

在同一层使用多个不同的卷积核,会导致过多的参数出现,在原来的Inception结构中加入1*1卷积核,进行降维操作。如图2所示。

图2 改进Inception模块

2.5 ResNet

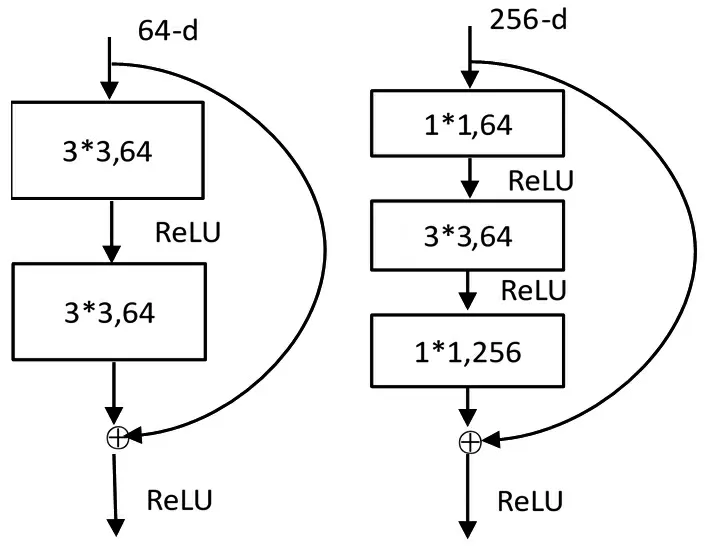

ResNet是由微软研究院何恺明等人提出来的,该算法获得了2015年大规模视觉识别挑战赛的冠军[5]。它提出了残差学习的思想。图3是残差学习模块,该模块包括几个卷积层,相当于对输入X进行F(X)变化,同时加入原始的输入X,整合成F(X)+X,作为整体的输入,并用激活函数激活,最终得到此残差学习模块的输出结果如图3所示。

图3 残差学习模块

图4是ResNet网络结构中常用的两种残差学习模块,第一个是2个3*3卷积神经网络串联在一起作为残差学习模块,第二个是1*1、3*3、1*1卷积神经网络串联在一起,组成一个残差学习模块。

图4 两种残差学习模块

ResNet网络结构都是以这两种学习模块叠加在一起来实现的。常见的ResNet网络结构有50层、101层和152层。

3 卷积神经网络改进

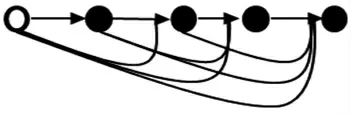

3.1 DenseNet

DenseNet的论文获得了2017年国际视觉与模式识别会议最佳论文[6]。该模型吸取了ResNet的精华,并做出创新,如图5所示,组建了Dense Block卷积神经网络模块。在该模块中的任何两层都有直接连接,模块中每层的输入是前面所有层输出的并集。不同的Dense Block是没有这种紧密连接的。该网络模型缓解了梯度消失的问题,加强了特征的传播,支持特征的重复利用,提高了网络性能。

图5 Dense Block的结构

3.2 MobileNet

MobileNet是一项比较新的研究成果,它的核心要点是深度可分离卷积和两个超参数[7]。其中,深度可分离卷积分成两个步骤,第一步是深度卷积,卷积核分别去卷积输入的每个通道;第二步是逐点卷积,用的是Inception中的1*1卷积。两个超参数是α和ρ,α用于控制输入和输出的通道数,ρ用于控制输入图像的分辨率。

4 网络模型性能对比

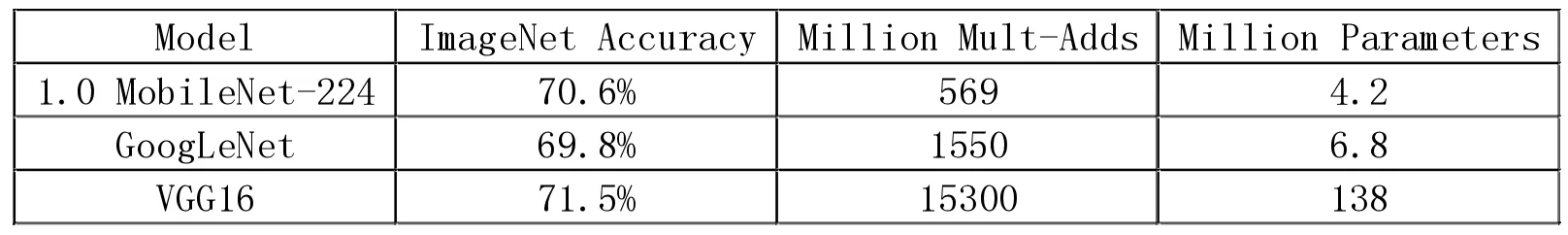

ImageNet数据集是一个计算机视觉数据集,该数据集包含14197122张图片和21841个Synset索引,在数据集中,包含多个种类的图像,并且,每张图像都被关联了标签(类别名)。将多种卷积神经网络的模型在ImageNet数据集进行了对比分析,运行精度和效率值如表1和表2所示。

表1 运行精度和效率值

表2 运行精度和效率值

表1可以看出三个模型在精度上不相上下,但是MobileNet比其他两个模型在计算量和参数上降低了很多。表2是把宽度因子设定为0.5,与另外两个模型相比,MobileNet的预测精度是最高的,计算量和参数也是最少的。MobileNet预测的精度最高,速度最快,表现最好。

5 结束语

本文分析了传统经典卷积神经网络的结构和思想,介绍了最新改进过的卷积神经网络模型,最后,对常用的网络模型进行了性能对比。为研究者选择模型提供了依据。