基于多源异构信息融合的智能汽车目标检测算法

2021-08-27隗寒冰

隗寒冰,白 林

(重庆交通大学 机电与车辆工程学院,重庆 400074)

0 引 言

融合多源异构信息的环境感知算法是智能汽车目标检测的关键和共性技术之一。近年来,采用单一传感器信息进行目标检测算法开发的研究较为普遍,对基于多线激光雷达、GPS、相机等多源信息融合的智能汽车环境感知算法研究还相对较少。文献[1-3]通过递归思想将目标检测构建为一个回归问题,利用单一神经网络预测目标的位置和分类。LIU Wei等[4]采用前馈卷积网络产生固定大小的边界框集合,并对这些边界框中存在的目标类别实例进行评分,然后进行非极大值抑制来选择最终检测结果。.ARCOS-GARCA等[5]分析了几种目标检测框架与特征提取器相结合的性能,并提出迁移学习方法改进交通标志检测算法,然后对检测算法的mPA、内存分配、运行时间等进行测试评价;但该算法未考虑到车辆运动状态、天气条件、传感器抖动、目标遮挡、光照强度变化等因素对环境感知算法产生的影响。但基于深度学习识别交通标志的应用场景仍能在雾霾天气进行[6]。

考虑到单一传感器受自身条件与环境因素限制,XUE Jianru等[7]利用多传感器数据融合进行障碍物检测,并以手工标记障碍物的准确率为标准,采用数据关联匹配对算法进行测试评价。CHEN Xiaozhi等[8]采用多视图融合的目标检测框架,将雷达点云映射到二维坐标图像以得到前视图和鸟瞰图,然后通过提取感兴趣区域特征信息进行目标检测。LIANG Peijung等[9]采用相邻数据帧跟踪的方法对多源传感器数据时间同步进行估计,空间配准变换矩阵来自点云SLAM(simultaneous localization and mapping),最后基于多源传感器信息融合进行目标检测,但该算法未考虑时间同步误差、空间配准误差、交通场景、车辆状态等对多源信息融合目标检测算法准确性、实时性等的影响。WANG Jun等[10]采用概率融合框架解决了行人检测性能限制问题,应用激光雷达提取对象结构特征并训练SVM分类器,减少候选窗口数量,提高对行人检测的准确率。DENG Zhidong等[11]通过关联相机与激光雷达数据,使关联后的数据信息包含颜色与几何特征信息,然后利用几何特征进行目标检测与识别。ZHOU Lipu等[12]基于激光雷达与相机的数据,将位置、颜色、激光反射率和几何特征等信息融合,以改进仅依靠图像数据对交通标志识别的准确性。

笔者基于GPS、16线激光雷达和双目深度相机等多源信息融合开发了智能汽车环境感知目标检测算法,实现了信息融合过程中的时间同步、联合标定及目标检测。数据时间同步采用同一时间节点插值匹配,以减小多源传感器基于相邻帧估计同步时间的误差;空间配准先对双目深度相机与激光雷达单传感器进行标定,以修正传感器因自身物理结构与安装位置产生的误差。然后改进文献[13]提出的联合标定算法,将修正后的单传感器时间同步数据信息作为联合标定算法的输入,对双目深度相机和激光雷达进行联合标定求解最优空间变换矩阵,利用标定结果得到的空间变换矩阵融合多源异构传感器信息进行目标检测算法开发,并在智能汽车实验平台对环境感知算法进行性能测试评价。

1 多源异构传感器时间同步

在多源异构信息融合过程中,时间同步主要解决各传感器之间因数据流时间周期或启动时刻不同造成的观测数据不匹配问题。笔者在GPS时间同步基础上,采用时间节点插值匹配方法,实现异构传感器数据时间同步。根据数据帧头求解激光雷达的启动时间,并设置激光雷达的工作频率为10 Hz,相机帧率设置为30帧,并在同一时间节点对各传感器数据帧设置相同ID编号,实现数据同步接收。

1.1 GPS与激光雷达时间同步

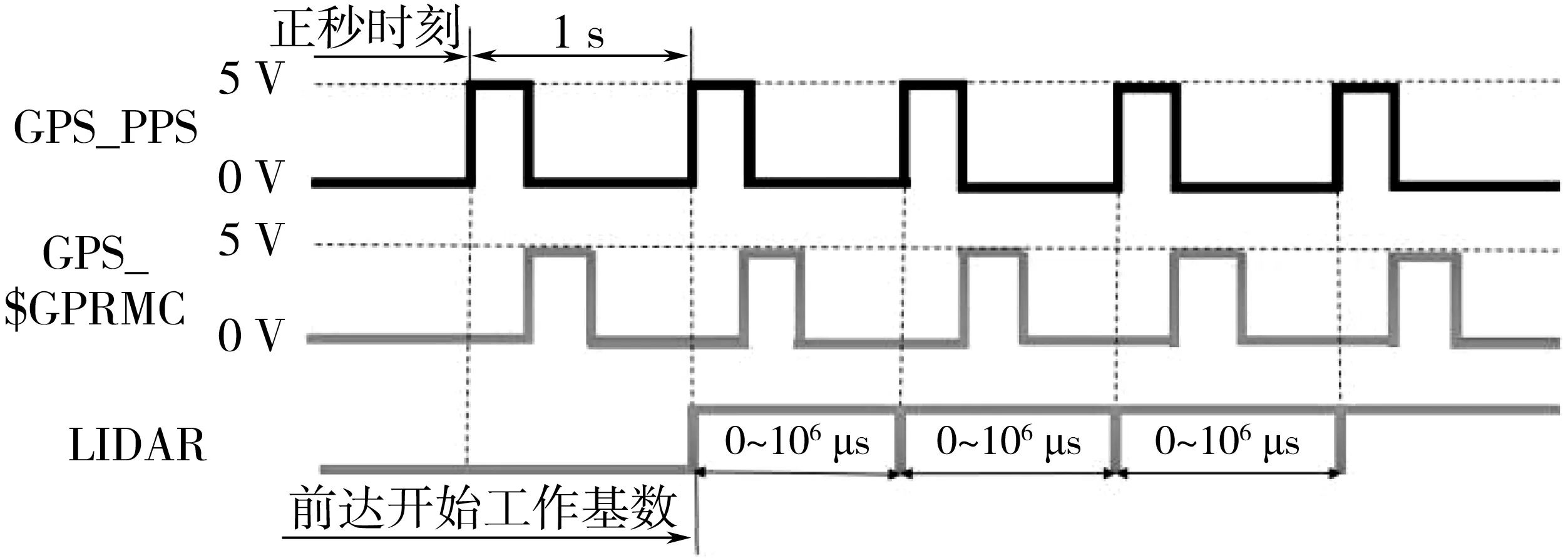

雷达接收由GPS提供的数据包$GPRMC中的时间信息后,赋值到设备信息输出协议(DIFOP)的时间信息内,在1 s内,设备信息输出协议重复发送3次,数据长度为10个字节,包括年、月、日、时、分、秒、毫秒,GPS的$GPRMC数据信息提供准确时间到秒,再以PPS正秒时刻为基准,当PPS 上升沿到来触发雷达内部的微处理器从零以微秒开始计数,将GPS的UTC时间与雷达输出的数据包时间戳计数值相加得到绝对精确时间,使GPS与激光雷达数据流时间同步,结果如图1。

图1 GPS与激光雷达时间同步序列Fig. 1 GPS and LIDAR time synchronization sequence

1.2 双目深度相机与激光雷达时间同步

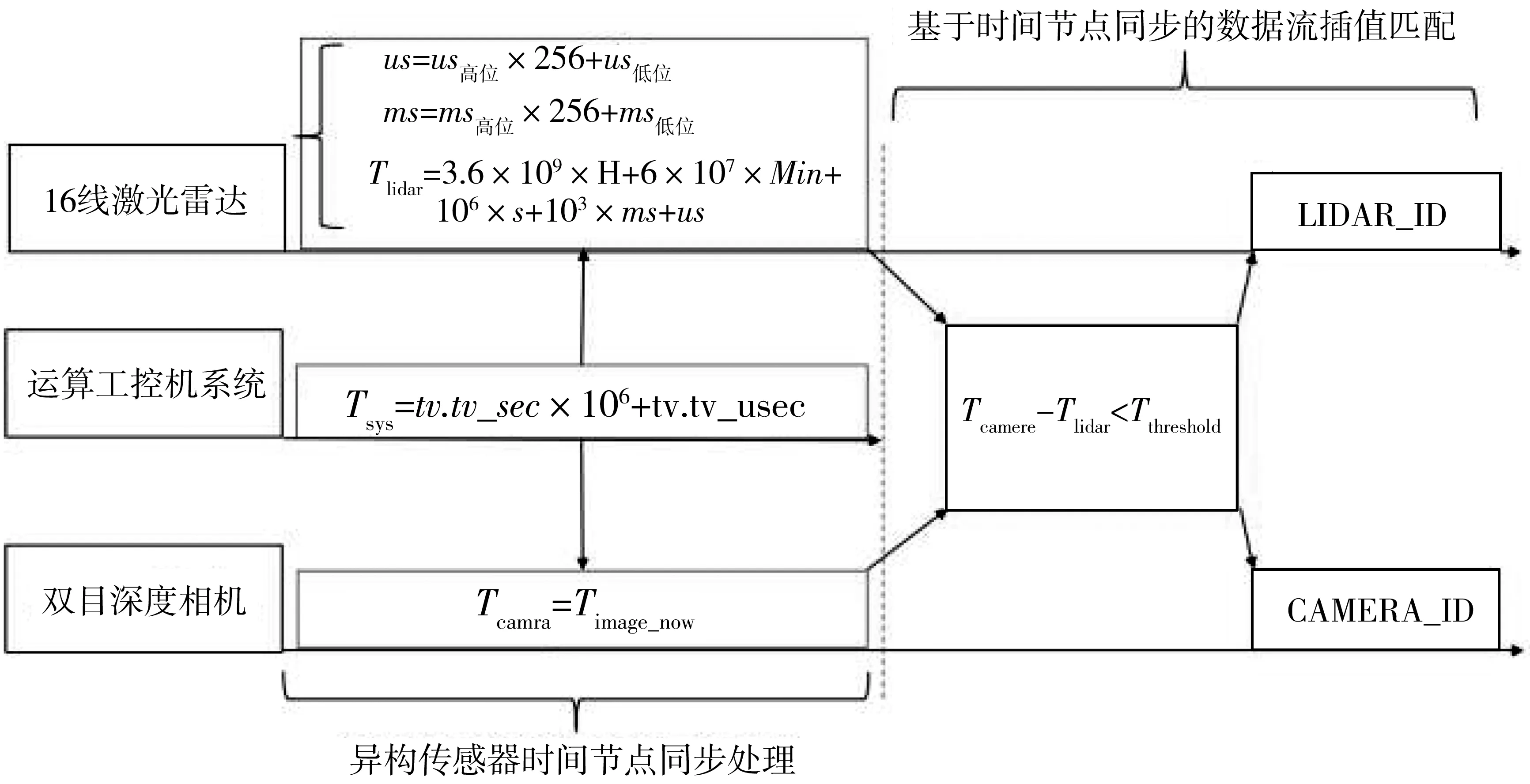

将多源异构传感器与工控机并联,设置工控机系统时间节点为基准时间标准,根据工控机系统时间节点求解激光雷达数据帧时间节点与相机数据帧时间节点,求解流程如图2。若雷达数据帧时间节点与相机数据帧时间节点之差在设定阈值0.001 s内,即得到多源异构传感器时间同步数据流。

图2 相机与激光雷达时间同步Fig. 2 Camera and LIDAR time synchronization

2 多源异构传感器联合标定

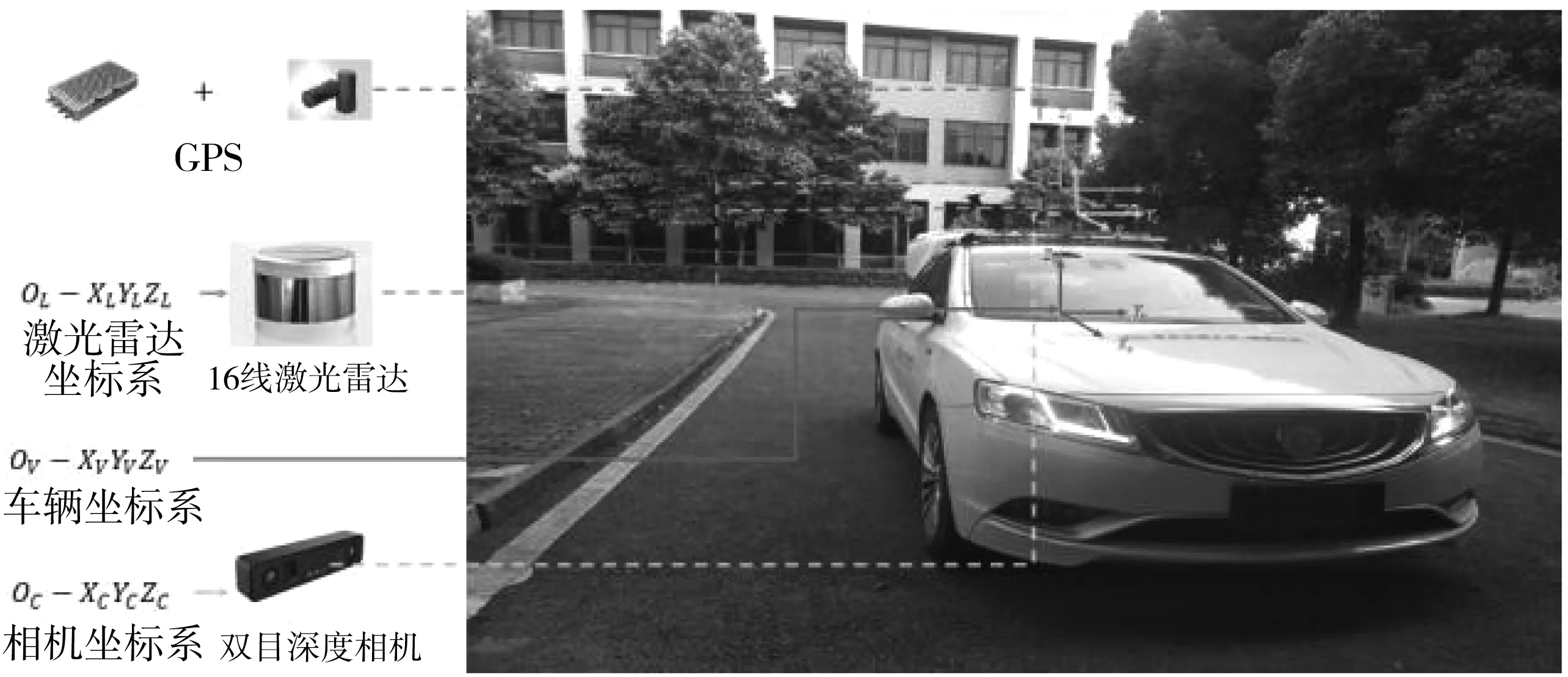

多源异构传感器联合标定是为了求解传感器坐标系与车辆坐标系之间的空间变换矩阵,然后根据变换矩阵将激光雷达数据与双目深度相机进行空间配准,从而将采集的图像和点云统一变换到车辆坐标系。假设激光雷达坐标系为OL-XLYLZL,车体坐标系为OV-XVYVZV,双目深度相机坐标系为OC-XCYCZC,如图3。

图3 智能汽车实验平台Fig. 3 Intelligent vehicle experimental platform

2.1 单一传感器标定

相机标定采用张氏标定法[14]标定深度相机的内外参数,完成三维坐标系到图像坐标系的映射。对激光雷达进行标定,根据雷达信息进行距离补偿及垂直角度、水平角度、旋转角度矫正。设激光雷达三维点云测量距离为r,激光雷达安装位置的俯仰角为ω,旋转角为α,并将雷达数据由极坐标变换为笛卡尔坐标(x,y,z)。

根据坐标系定义,激光雷达坐标系相对车体坐标系沿x,y轴方向的平移向量为0。激光雷达外参标定简化为求解俯仰角α、横摆角β、航向角γ和纵向位移这4个量。根据需求选取实验场平整的水平地面作为参照,激光雷达俯仰角和横摆角的存在使水平地面点云形成的平面在雷达坐标系OL-XLYLZL中相对XLYL方向具有一定倾斜值。假设水平地面返回的激光雷达点云信息构成的平面在雷达坐标系中的平面拟合方程如式(1):

ZL=AXL+BYL+C

(1)

式中:A、B、C分别为点云平面方程常数;XL、YL、ZL分别为三维空间的坐标轴。

假设雷达坐标系与车体坐标系之间的俯仰角和横摆角偏差为0,使水平地面点云形成的平面在雷达坐标系中处于水平,平行车体坐标系XVYV平面,即参数A,B为0,C为两个坐标系原点纵向距离。构造无约束非线性优化目标函数如式(2):

G(α,β)=argmin(|A|+|B|)

(2)

将雷达坐标系下地面点云通过坐标变换矩阵得到的校正值应与水平面充分平行,此时G取得最小值。式(2)难以求解析解,笔者根据优化目标和优化变量,将目标点云作为输入。依据遗传算法优化应用场景及效果明显[15],采用遗传算法迭代求解α,β最优值。

根据目标函数和变量初始化种群,利用二进制进行编码,并通过函数转化为十进制(x,y),如式(3):

(3)

式中:(ai1,ai2,…,aiL) ∈[ri,Ti]为某个个体的第i段,每段段长都为1;Ti和ri为第i段分量定义域的两个端点,每个ai*均为0或1。

由坐标变换矩阵求解原始点云的变换坐标,拟合变换的点云坐标平面,求解系数A,B的值,由函数G(α,β)计算适应度值F′。根据适应度值进行选择运算,对群体中个体进行优胜劣汰,按与个体适应度成正比概率决定当前群体中的个体是否遗传下一代。笔者采用轮盘赌法选择算子,个体i被选中遗传到下一代的概率如式(4):

(4)

式中:L为种群中个体数量;F′为个体i适应度值。

利用经过选择操作后种群中的两个随机对象作为交叉对象,并作为父个体进行染色体交换重组生成两个子个体。染色体重组产生的变异运算是通过按变异概率随机反转某位等位基因的二进制字符值来实现。然后寻找最优解,根据最优解计算俯仰角、横摆角及纵向距离,如图4。

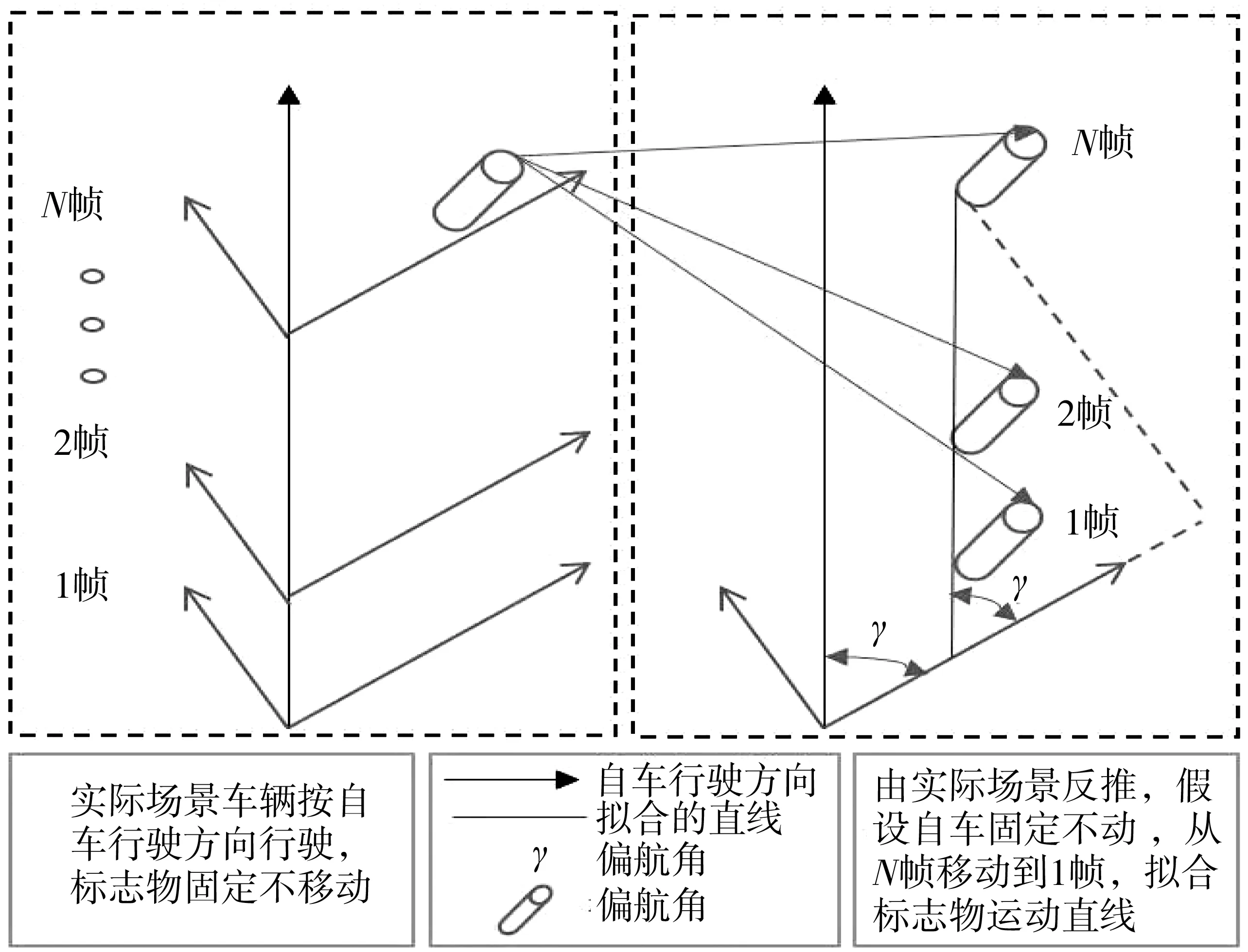

图4 目标物的投影点拟合直线Fig. 4 Fitting straight line of the projection point of the target

对两坐标系间的导航角求解,采用垂直水平地面的物体作为标志物,通过车辆直线行驶,采集包含标志物的多帧点云数据,使用直通滤波、区域聚类等方法提取标志物点云投影至水平面,并标记每一帧数据的投影点为(xi,yi),其中i∈(1, 2, 3,…,n),对投影点进行直线拟合,如式(5):

y=kx+b

(5)

式中:k为斜率,b为截距。

由此推算航向角如式(6):

γ=arctan(k)

(6)

完成单一传感器标定,修正传感器因自身物理结构与安装位置产生的误差。并将修正后的激光雷达与相机时间同步数据信息作为联合标定算法的输入。

2.2 多源异构传感器联合标定

多源异构传感器联合标定是为了求解车体坐标系、激光雷达坐标系与相机坐标系之间的空间变换矩阵。调整双目深度相机和激光雷达安装位置,使之同时观测到规则标定板平面,然后根据各传感器数据在同一空间下测量时目标位姿不变性建立优化目标,求闭式解或迭代优化。对标定矫正的三维激光雷达点云数据进行滤波处理,即分别对XYZ三个维度方向进行滤波消除背景噪声,以提取目标点云。对标定板平面激光雷达点云进行平面拟合,假设拟合平面法向量和激光雷达坐标系原点到拟合平面的距离分别为θL,sL。同时假设标定板平面在相机物理坐标系中法向量和相机物理坐标系原点至标定板平面的距离分别为θc,sc。其计算如式(7):

(7)

式中:θL为激光雷达点云拟合标定板平面法向量;sL为激光雷达坐标系原点到标定板的距离;θc为图像中标定板平面法向量;sc为图像坐标系原点到标定板平面距离。

对空间任意一点,激光雷达坐标系下观测该点到标定板平面距离应与双目深度相机物理坐标系下观测结果相同。当该点取为雷达坐标系原点时,定义目标函数如式(8):

(8)

令该函数结果等于T0,如式(9):

(9)

求解该函数的闭式解如式(10):

(10)

与之类似,对于空间中的任意向量,先在激光雷达坐标系中进行观测并变换到相机物理坐标系,应与相机物理坐标系中观测结果相同,即内积最大。当选取标定板平面法向量时,定义目标函数,该令函数结果等于R0,其计算如式(11):

(11)

在内积最大时,旋转矩阵满足正交矩阵条件,设此时的旋转矩阵R有RTR=I,根据矩阵迹性质将目标函数等价如式(12):

(12)

该函数闭式解如式(13):

Rl=VUT

(13)

求得旋转矩阵、平移向量的初始闭式解后,在激光雷达坐标系的标定板平面任意取点,通过变换矩阵映射至相机物理坐标系,使激光雷达点云在相机物理坐标系观测结果与相机理坐标系中直接观测的结果相同,由此构造优化函数如式(14):

(14)

采集离线数据进行标定,求解空间变换矩阵,将激光雷达点云映射至图像坐标系下,并变换到车辆坐标系,如式(15):

(15)

式中:PV、Pc为车体坐标下坐标和相机坐标下坐标;RVL、tVL为雷达坐标系到车辆坐标系的旋转矩阵与平移向量;RcL、tcL为雷达坐标系到相机坐标系的旋转矩阵与平移向量。

3 基于多源异构信息融合目标检测

在多源传感器时间同步和联合标定结果基础上,提出基于多源异构信息融合的目标检测算法,解决单一传感器环境感知时的局限性问题,算法框架如图5。其中:P(x,y,z)为激光雷达点云中每个点坐标信息;R为空间旋转矩阵;T为平移向量;(x,y,w,h)lidar与(x,y,w,h)camera为异构传感器提供的位置信息。

图5 基于多源信息融合的目标检测算法框架Fig. 5 Framework of target detection algorithm based on multi-source information fusion

算法框架求解步骤如下:

1)根据C/S通信模型下的数据报通信协议实现多源传感器之间通信及时间同步处理,完成传感器之间数据的同步采集,得到原始数据集。

2)利用相机与激光雷达同一时间节点采集的环境信息,分别实现激光雷达目标检测及图像目标检测,并分析基于单一传感器信息进行目标检测时存在的局限性。

3)利用基于递归神经网络方法对图像信息进行预处理,在预处理过程中通过损失函数准确的求解出目标的位置信息和类别信息;利用基于几何特征求解的方法对雷达信息预处理,并在预处理过程中利用联合标定求解的空间变换矩阵进行空间配准,将配准的3D点云信息转化为2D点云信息。

4)根据求解目标位置信息进行融合,融合后主要包含目标的位置信息和类别信息,能有效感知交通场景中的环境信息。

3.1 激光雷达目标检测

在传感器信息融合算法基础上,基于SVM点云分割与欧式聚类法对激光雷达点云中的目标进行检测。对激光雷达点云数据使用网格化方法进行下采样,使保持点云有效形状特征的同时减少点数量;在下采样基础上进行空间剪切滤波,获取空间下与相机相同视场点云数据,并对点云数据进行滤波提取索引点云子集。假设索引点云集合为V,随机选取点云V中的3个坐标点V1、V2、V3,求解两点之间距离,设为d1、d2,即有式(16):

(16)

式中:V1、V2、V3分别为激光雷达点云集合中3个随机点的坐标;d1为随机点V2与随机点V1之间坐标差值;d2为随机点V3与随机点V1之间坐标差值。

根据两点之间坐标之差,求解SVM平面方程,如式(17):

a×x+b×y+c×z=d

(17)

式中:a、b、c分别为点云平面方程常数;x、y、z分别为三维空间坐标轴。

则法向量n的表达式如式(18):

(18)

其中法向量n有式(19):

(19)

式中:a、b、c分别为平面方程常数,可构成平面方程法向量。

根据法向量和平面内任意点云坐标V,即可求得点到平面的距离,在点云集合V中,遍历求解点云到拟合平面的距离d′,如式(20):

(20)

若点云到拟合平面的在设定距离内,即生成索引点云子集,并对点云子集进行滤波处理,提取障碍物特征点云。采用欧式距离计算和对比不同数据点之间的距离,结合二叉树搜索方法使距离值在阈值范围内的数据点进行组合,对障碍物特征点云进行目标聚类,如式(21):

(21)

式中:D(x,y)为点与点之间的距离值;xi、yi分别为每个点坐标值。

在目标聚类后,根据每个点云子集求解点云子集在空间雷达坐标系下的最大点坐标信息与最小点坐标信息,由最大点与最小点坐标信息求解障碍物的包围框。激光雷达点云随距离增加变得稀疏,环境感知算法对障碍物检测性能降低[16],远处目标不能有效检测,如图6。

图6 激光雷达目标检测Fig. 6 LIDAR target detection

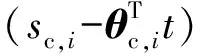

3.2 图像目标检测

结合基于递归神经网络目标检测算法在实时性与准确性等方面的性能,对相同视场空间下的图像处理采用文献[3]的目标检测算法,在图像目标检测方面权衡了实时性和准确性,尤其在小目标检测方面性能较好。算法处理流程主要包含特征提取、目标预测、包围框位置与目标类别的损失回归等步骤,如图7。

图7 Yolo目标检测算法结构Fig. 7 Yolo target detection algorithm structure

笔者针对智能汽车行驶的实际交通场景,对算法模型超参数进行微调,根据实际应用场景,学习需要检测的障碍物目标如车辆、行人等。将采集的交通场景数据与手工标签作为算法输入,对场景中的目标进行特征提取、目标预测与分类,最后对包围框与目标类别进行损失回归,回归函数分别对预测中心坐标、预测边界框、类别与置信度做损失。其中:心坐标损失函数为Lc,预测边界框的宽高损失函数为Lwh,预测类别损失函数为Lclass,预测置信度损失函数为Lci,其计算有式(22)~(25):

(22)

(23)

(24)

(25)

根据损失函数判断是否为求解的检测目标,如式(26):

Lobject=Lc+Lwh+Lclass+Lci

(26)

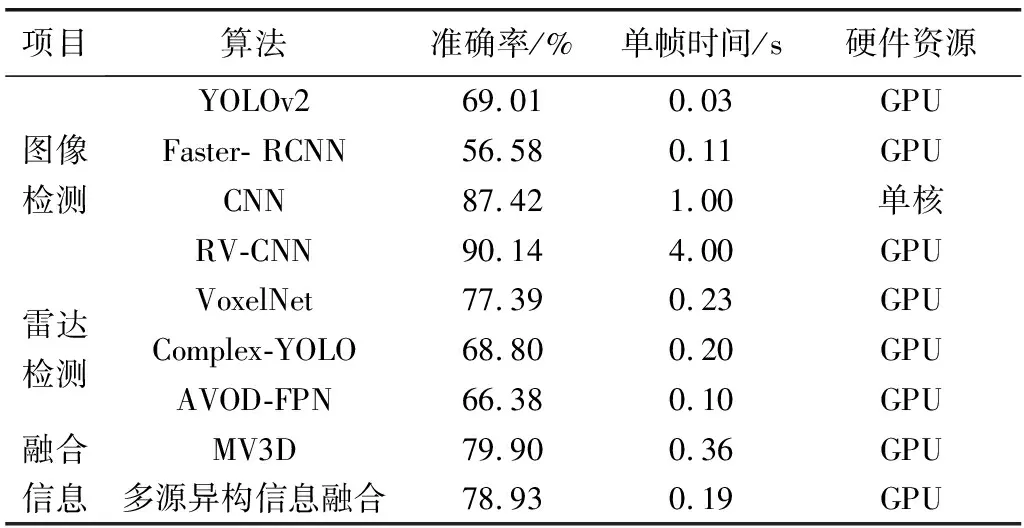

通过图像纹理及颜色等信息能更有效感知环境信息,但对环境适应性较差,在目标遮挡、光照变化等条件下,会出现难适应环境变化的工况。

3.3 基于多源异构传感器信息融合的目标检测

在实际交通场景中,车辆、行人及其他障碍物目标形态存在较大差异,视角遮挡等干扰因素很难获得某种固定模式,从而进行有效的目标检测。三维点云缺少目标对象的纹理信息及实际场景数据空间拓扑结构信息;深度相机能标定目标的纹理轮廓信息,但缺少速度分辨率和角度分辨率;基于单传感器信息的环境感知算法对环境适应性较差,并与实际场景的工程应用具有一定差距。文中算法在激光雷达信息目标检测与图像信息目标检测基础上,将激光雷达获取的目标信息与相机图像提供的目标颜色信息相结合,并基于时间同步、联合标定的空间配准实现多源信息进行实时融合,为智能汽车在实际交通场景行驶时提供有效的环境感知信息。

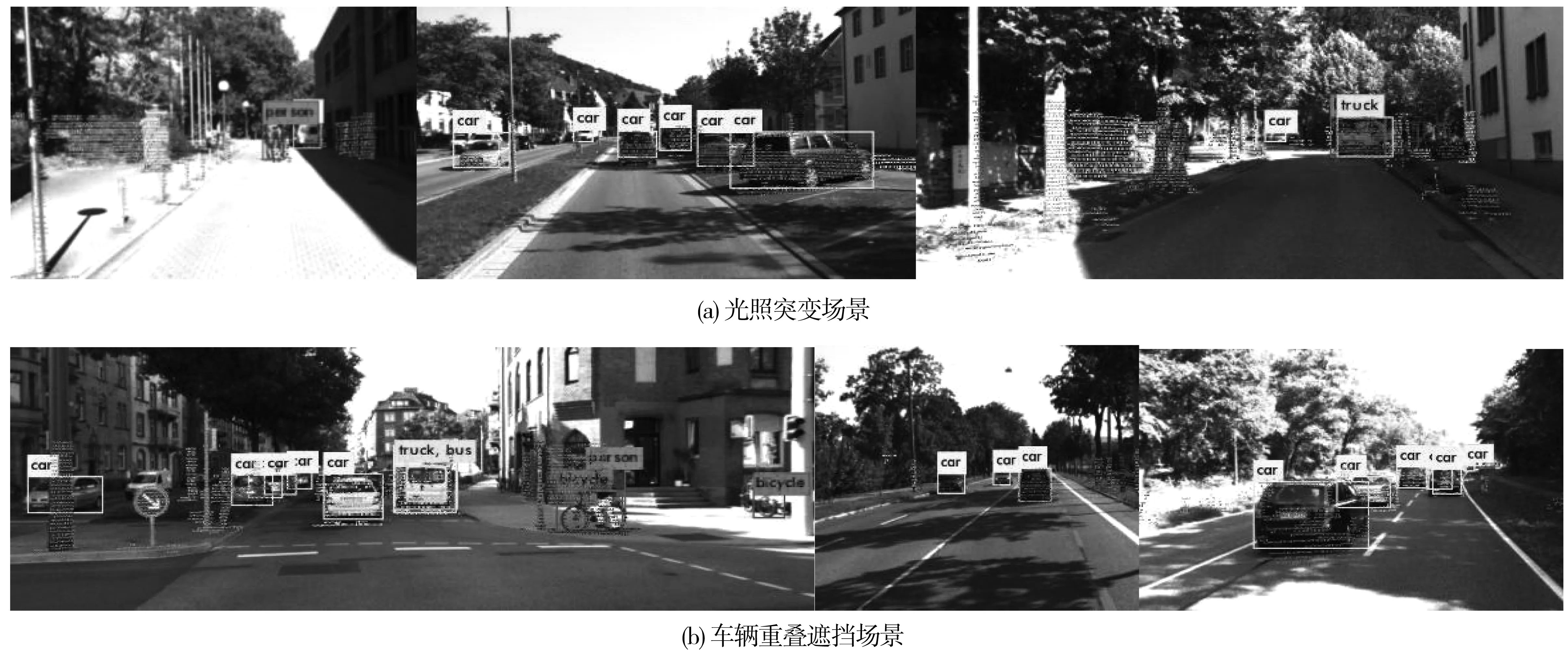

根据图5多源异构传感器信息融合算法框架,多源异构信息包围框位置信息如图8。

图8 多源异构信息包围框位置信息Fig. 8 Location information of multi-source heterogeneousinformation bounding box

将激光雷达信息进行预处理,提取障碍物点云的几何特征信息,将拥有障碍物几何特征的点云通过R、T组成的空间变换矩阵变换至相机坐标系,如式(27):

P(x,y,z)L_c=P(x,y,z)L×[RT]

(27)

式中:P(x,y,z)L为激光雷达点云信息;P(x,y,z)L_c为经过旋转矩阵R和平移矩阵T组成的空间变换矩阵变换的激光雷达点云信息。

(28)

根据式(28)变换后的点云几何特征信息求解障碍物3D包围框的极值坐标。图像信息求解包围框位置坐设为a、b、c、d,如式(29):

(29)

由点云信息和图像信息求解的位置信息融合函数Hx_center、Hy_center、Hwidth、Hheight如式(30):

(30)

4 实验结果

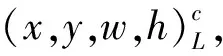

笔者以重庆交通大学行远智能汽车作为实验平台。该平台搭载差分GPS、小觅双目深度相机、16线激光雷达等,其参数如表1。

表1 车载多源传感器及工控机关键参数Table 1 Key parameters of automotive multi-source sensors and industrial computers

4.1 多源异构传感器标定实验结果

在时间同步与单传感器标定基础之上,进行联合标定求解获得空间变换矩阵[R,T],对多源传感器数据进行空间变换,映射到图像坐标系。根据采集20~30帧数据进行实验,通过空间变换,能有效地将雷达数据流映射到图像空间坐标系中,如图9。

图9 多源传感器联合标定实验Fig. 9 Multi-source sensor joint calibration experiment

4.2 多源信息融合的环境感知算法测试结果

图像信息处理采用文献[3]中的深度学习算法模型,通过特征提取、分类回归,求解图像信息包含的障碍物位置信息与类别信息。激光雷达点云信息通过平面分割、欧式聚类等方法求解点云信息中障碍物的几何特征,通过空间变换矩阵[R,T]将激光雷达点云信息中包含的障碍物几何特征点云从激光雷达坐标系变换至相机物理坐标系,并将变换后的3D点云信息映射为2D信息,融合至相机图像信息进行环境感知。

将文中构建的多源异构信息融合算法进行实车实验,通过对时间同步误差和空间配准误差的优化,融合图像信息与激光雷达信息,从而有效弥补单一传感器在环境感知中存在的局限性。校园光影遮挡环境下的算法测试结果如图10,算法统计结果如表2。基于多源信息融合的目标检测准确率在78.13%~85.56%,平均耗时0.16 s,具有较好的工程实际价值。

图10 实际检测结果Fig. 10 Actual test results

表2 多源异构信息融合算法检测结果统计Table 2 Statistics of detection results of multi-source heterogeneousinformation fusion algorithm

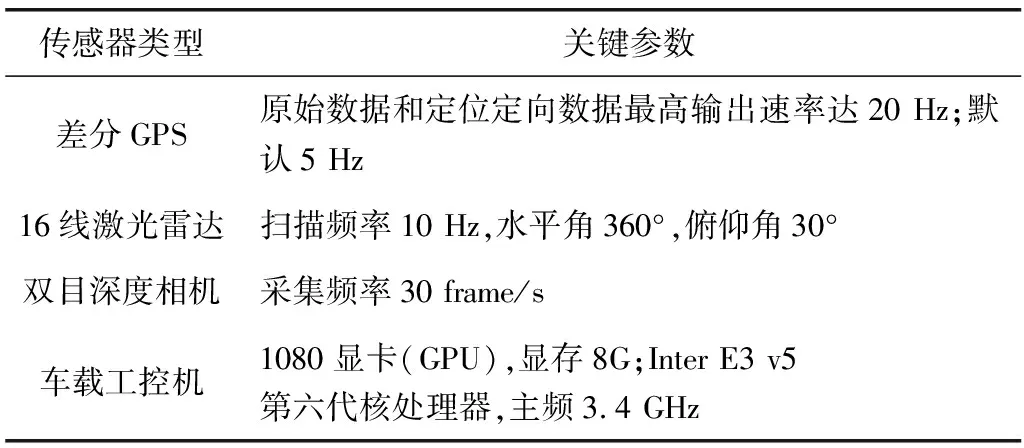

4.3 KITTI数据集对比结果

采用KITTI数据集对算法进行客观评价,如图11。在仅依靠图像信息的环境感知算法中,基于卷积神网络的图像检测算法准确率较高,如RV-CNN的准确率超过90%,但由于使用了非常深的网络,即使使用GPU单帧目标检测耗时仍然较高。YOLOv2通过优化网络结构,检测速度有较好提升,但准确率有所下降。在仅依靠雷达信息的环境感知算法中,行人姿态不断变化导致目标准确率均有所降低。虽然车辆等障碍物点云信息有固定目标检测求解模式,其准确率也仅在70%左右。如Complex-YOLO相对VoxelNet算法,单帧数据检测速度有所提升,但准确率又有所降低。而在信息融合检测算法中,MV3D算法利用了较深层次的网络,准确率接近80%。笔者开发的多源异构信息融合环境感知算法平均准确率78.93%,检测速度达到0.19 s/帧,准确率有所提升,且算法较好权衡了实时性和准确率。

图11 标准数据集对比结果(KITTI车辆、行人数据)Fig. 11 Comparison results of standard datasets (KITTI vehicle and pedestrian data)

5 结 论

1)针对多源异构传感器时间同步的数据帧信息多为随机匹配,产生的误差较大,笔者采用基于时间节点的插值匹配,能有效减少随机匹配产生误差,增加多源异构信息的匹配度。

2)将双目深度相机图像标定结果与矫正的激光雷达点云作为联合标定输入,求解最优的空间变换矩阵,将包含障碍物几何特征的点云信息变换至图像坐标系,融合图像中求解的障碍物信息,弥补单一传感器环境感知存在的局限性。

3)在KITTI数据集中及实车实验对笔者提出的目标检测算法进行验证,准确率为78.13%~85.56%,每帧数据检测平均耗时为0.16~0.19 s,在遮挡、光照变化等工况下均能准确检测环境目标,具有较好的工程应用前景。