基于多源异构数据融合的船舶目标检测与跟踪技术研究

2021-08-24马瑞鑫李子龙

马瑞鑫,李子龙,陈 静

(1.交通运输部天津水运工程科学研究所,天津 300456; 2.大连海事大学 航海动态仿真和控制实验室,大连116026)

随着内河航运的快速发展,水上运输船舶数量日益增多,水上交通压力越来越大,单纯依靠人工进行现场或视频巡检效率较低,针对船舶的智能监管,目前主要采用视频监控、AIS、射频识别、雷达等技术。但尚没有完善的监控系统对水上交通出现的船舶超载、超限、遮挡船名、不按规定开启AIS等违法违规行为进行智能监控及预警,智能化的监管手段仍显不足。

当前水运行业传统的视频监控已经较为普遍,但如何从视频中提取出关注的信息仍较为繁琐,由于船名标识不规范、字符不清晰,基于计算机视觉的智能分析应用较少;AIS应用较为广泛,但其必须依赖于船载终端的安装及正确使用;雷达在沿海港口应用较为广泛,但在内河中由于航道沿线山林阻隔及岸线阻挡应用较少。当前,单一的监测方法都有相应弊端,同时无法有效进行数据协同,尚没有统一高效的融合方法使其从多源无序的监测数据中发掘精准的有价值信息。如何精准有效地从现有视频中提取出船舶目标,实现船舶视频目标的自动检测与跟踪;并协同多传感器的多源数据融合分析,提高监测精细化水平,实现船舶监管的直观表达是当前亟需解决的问题。

当前基于计算机视觉的目标检测方法主要分为传统目标检测算法和深度学习目标检测算法[1]。浙江大学刘宝龙[2]博士通过图像分析、深度学习等计算机视觉技术对船名标识字符进行了检测与识别,并提出了船名标识字符基准数据集。武汉理工大学相关研究人员[3]在传统YOLOv3算法基础上,提出了用于船舶目标检测的增强YOLOv3算法,在雾天和低照度等不良天气条件下均能实现船舶目标的高精度稳定检测。但是基于深度学习的目标检测算法因为需要大量样本,受限于应用场景,在山区内河环境下获取较为困难,传统目标检测方法主要有帧间差分法、光流法和背景减除法等[4];在多传感器数据融合方面,目前的内河船舶轨迹融合主要是AIS和雷达数据的融合,主要通过卡尔曼滤波器去噪法、修正的K近邻域法等,核心在于判断来自多个系统的两条轨迹是否代表同一个目标[5]。叶蕾[6]研究了摄像机与激光测距仪在船舶过闸中的应用,并依据摄像机和激光测距仪研究了基于多传感器结合的过闸船舶运动状态检测系统。L. Achiri等[7]利用AIS和SAR两种数据源进行融合,实现船舶海事监管。孟琭[8]对当前主流的目标跟踪算法进行了测试,分析了Kalman、深度学习方法在不同场景下的跟踪效果。上述方法虽然取得了一定成果,但仍存在以下局限性,单一传感器难以应对复杂环境感知信息,激光传感器具备探测精度高,不受天气状况影响等优点,但无法获取颜色、纹理等信息,只能反应目标的外形轮廓等特征;视频弥补了激光在识别物体方面的劣势,可以捕获目标及环境的大量细节特征,但受天气影响较大,且识别精度不高;AIS数据是一种结构化较为规范的数据,但其获取方式依赖于船载终端的使用,不能进行主动式监管[9-10]。

针对以上问题,本文在现有研究基础上针对视频船舶目标检测,提出了一种基于Canny边缘检测的三帧差分法与基于混合高斯背景建模的背景减除法相结合的船舶目标检测算法,有效提高了传统图像目标检测准确率;针对多传感器目标融合,本文分析了激光点云数据和AIS数据的处理方法,并基于模糊数学的思路,提出了一种正态性隶属度函数计算模糊相关矩阵的方法,实现了在动态视频修正下的激光点云数据与AIS数据的船舶轨迹特征融合。

1 多源异构传感器数据处理

1.1 船舶图像目标检测

本方法首先通过直方图均衡化和中值滤波对视频图像序列进行预处理,对图像出现的亮度或对比度不均匀进行处理,提高船舶目标提取的精准度。然后对连续的三帧图像之间做两两相邻两帧的差分图像计算,采用Otsu方法求取差分图像的阈值,将差分图像结果做二值化处理,最后将得到的2个二值图像进行逻辑“与”运算,获取两个结果图像中共同的目标部分,从而获得船舶运动目标的轮廓信息[11]。

为了能够尽可能准确标识出图像中船舶目标的实际边缘,再通过Canny算子对第N帧图像进行边缘检测,得到目标图像的轮廓信息,在得到图像边缘后与三帧差分法得到的轮廓信息进行逻辑“与”运算,即可得到船舶目标前景图像。

继续对第N帧图像做背景减除运算,可得到当前帧的前景图像,并进行二值化处理得到二值化图像,将上述逻辑“与”计算得到的前景图像和该二值图像进行逻辑“或”运算,即可得到边缘信息和船舶目标较完整的图像信息。具体实现流程如图1所示。

图1 视频图像处理流程Fig.1 Video image processing

提取船舶前景图像需要获得图像的背景信息。为克服外部环境变化较大的复杂场景,本文采用混合高斯背景建模法获得背景图像,混合高斯背景模型使用多个单高斯概率密度函数,通过所有密度函数的加权平均值来近似地表示某一像素点值的密度分布函数,令I(x,y,t)表示像素点(x,y,t)在t时刻的像素值,见式(1)

(1)

(2)

式中:T的值根据实验结果设为0.7,是背景模型占有高斯分布的最小比例,根据背景情况,T越大则可以描述越复杂的动态背景模型。对于当前像素(x,y,t),若它的值I(x,y,t)服从背景模型中第k(k≤B)个高斯分布,那么该像素点为图像背景像素点,否则是目标前景。设ImageOutput函数为输出图像,则可由(3)式判定。

(3)

在图像自动识别该像素为目标前景后,需要更新高斯分布去替代权重最小的当前值,这一新的高斯分布的期望值用当前的像素点值来表示。如果该像素为背景图像中的像素点,则需要进行权重的更新,此处权重值是该图像背景像素的各个高速分布的权重值。基于目标像素匹配的高斯分布,需要同时更新高斯模型中的期望值和偏差值。

1.2 船舶激光点云数据处理

本文采用的激光雷达是一个水平视角360°全方位的16线激光雷达,采用混合固态激光雷达方式,通过激光发射组件棱镜快速旋转的同时,由发射器发射高频率激光束对外界环境进行持续性的扫描,经过测距算法提供三维空间点云数据及物体反射率,可以获取船舶、水面的距离,通过激光束的扇面扫描在航道切面方向形成多道激光幕帘。当船舶通过激光幕帘时,可采集船舶每个段面的激光反射数据,系统将获得船舶切向的多断面轮廓尺寸数据,每个段面均由无数个激光反射数据组成,随着船舶航行通过监测点,激光扫描仪即可采集完整的若干个段面的激光反射数据,从而获取船舶完整的轮廓数据。

本激光雷达有效探测距离150 m,测量精度+/-2 cm以内,垂直视角30°(-15°~15°),分辨率为2°,当转速为10 Hz时,出点数高达30万点/s,本文采用基于八叉树的点云精简方法,以实现在保持船舶点云数据几何特征的同时减少点云数据量,同时采用基于聚类分析的场景点云自动裁剪算法实现水平面和船舶的三维立体重构,并通过自适应滤波算法滤除水面及船体的波动,即可获得船舶的三维尺寸等参数,包括船舶的行驶方向、速度、干舷等特征。船舶实景和经精简后的点云图如图2所示。

图2 船舶实物和激光点云示意图Fig.2 Schematic diagram of the ship′s physical object and laser point cloud

为减少盲区干扰,本文需两台激光扫描仪共同扫描,即在航道两侧各安装一台固定角度的激光扫描仪,实现盲区互补。对于多位置扫描所得到的点云数据,通过迭代最近点(Iterative Closet Point, ICP)算法将其匹配到一个统一坐标系中[12]。

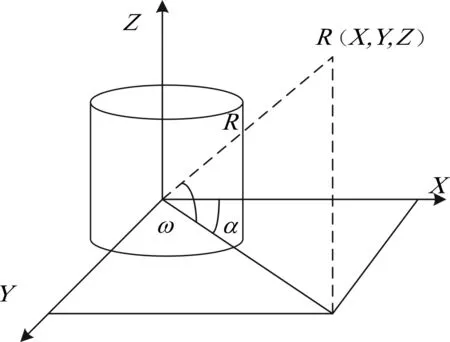

激光点云数据为立体角坐标系,点云中每一个扫描点的位置信息由矢量(R,α,ω)表示,3个分量的物理意义如图3所示。

图3 点云数据极坐标系Fig.3 Polar coordinate system of point cloud data

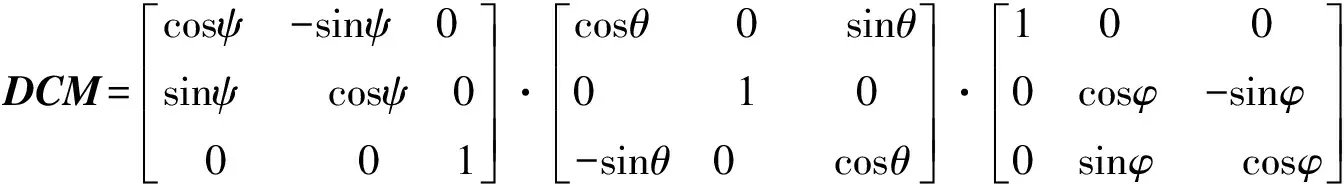

由扫描点的随体坐标系V=(X,Y,Z)和雷达的姿态信息(φ,θ,ψ)可以求出扫描点在以雷达位置为原点的大地坐标系下的坐标值VE

VE=(XE,YE,ZE)=DCM·V

(4)

(5)

1.3 船舶AIS数据

AIS系统是一种船舶自动识别系统,可以收发覆盖范围内的船舶动态、静态信息,用于船舶目标的识别与信息交换。主要包括以下种类数据:

(1)静态信息:IMO编号、呼号和船名、船长和型宽、船舶类型;

(2)动态信息:船位位置、UTC时间、对地航向、对地航速、船艏向、航行状态、转向率;

(3)航次相关信息:船舶吃水、危险货物类型、目的港和预计到达时间、航线计划等;

(4)安全相关消息:广播和通知消息。

2 目标融合算法

2.1 融合流程分析

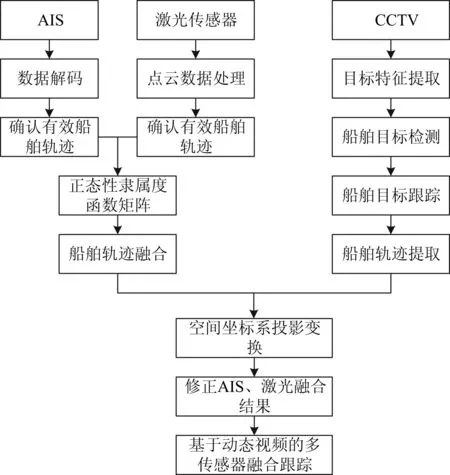

本方法所采用的单个传感器(激光、视频、AIS)均可独立采集并形成各自的目标运动模型,系统对多个独立的船舶运动模型进行对比匹配后,通过多传感器融合计算确定统一的船舶运动模型。本方法先将激光点云数据和AIS数据进行船舶航迹融合计算,在视频检测出船舶运动目标后,实现船舶的目标跟踪,对激光点云数据和AIS数据融合后的船舶轨迹进行修正,并将其综合叠加显示在动态视频上,使船舶目标具有丰富实时的环境特征,且整体具有更好的测距精度和更高的识别率,具体流程如图4所示。

图4 多传感器目标融合流程Fig.4 Process of multi-sensor target fusion

2.2 船舶轨迹融合方法

本文提出的多传感器融合关键在于AIS和激光点云的船舶轨迹融合,AIS数据和激光点云数据必须统一到同一个时间系统。首先提取出各自监测的船舶动态数据,然后进行位置坐标变换和时间校正,在统一的融合时间节点上进行轨迹相关计算,最后基于关联目标加权实现轨迹融合。

针对统一时间系统,激光传感器的扫描周期是固定的,可以进行线性插值,AIS发送动态信息时间间隔随着船舶航行状态不同而不同,对其进行时间校准可采用三次样条差值进行计算,求得t时刻的目标向量为X(t),具体计算方法如下

X(t)=A0+A1(t-t0)+A2(t-t0)2+A3(t-t0)3

(6)

式中:A0、A1、A2、A3为变换系数,可以通过将AIS时间变成GMT时间,取4个目标向量代入,即可解出。

船舶轨迹融合的关键是判断来自AIS和激光点云数据的两条航迹线是否代表同一船舶,本文采用模糊数学的隶属度函数[5]表示其航迹的相似性。

(7)

式中:ξ(ζp)为模糊因素集中第p个因素的隶属度函数;ηp、ζp、σp分别为模糊因素集中第p个因素的权重、欧式距离和展度。隶属度函数值越大,说明两条航迹线相关联程度越大。

对来自AIS数据的m条轨迹和来自点云数据的n条轨迹建立t时刻的模糊相关矩阵,即

(8)

式中:λmn(t)表示在t时刻AIS中的第m条轨迹与点云中的第n条轨迹的综合相似度。

检验航迹的相似度,具体步骤为:

(1)确定阈值ε的大小,通常取ε≥0.5;

(2)在矩阵λ(t)中找到最大元素λmn(t),如果λmn(t)≥ε,则判定AIS轨迹m和点云轨迹n相关,并从矩阵λ(t)中去掉λmn(t)所在的行和列元素,得到新的(m-1)*(n-1)维降阶模糊矩阵λ1(t);

(3)对λ1(t)重复上述过程,获得λ2(t)…λk(t),直到λk(t)中的所有元素均小于ε,则剩下元素对应的行列号代表的轨迹在t时刻不相关;

(4)如果某两条轨迹信息相关,并且在任意t时刻均相关,则可判定它们来自于同一目标船舶,此时即可关联这两条轨迹信息。

2.3 空间变换矩阵

多源异构传感器数据融合需要实现空间信息的匹配。点云数据位于以激光雷达为中心的激光雷达坐标系OlXlYlZl下,视觉图像信息位于以相机为中心的相机坐标系OcXcYcZc下。需要对其坐标系进行联合标定,激光雷达坐标系与相机坐标系的转换关系[13]可以表示为

(9)

式中:R、T分别为2个坐标系的相对旋转矩阵和平移矩阵。

3D点云B=(x,y,z)在校正过的相机中的投影位置A=(u,v)可以表示为

(10)

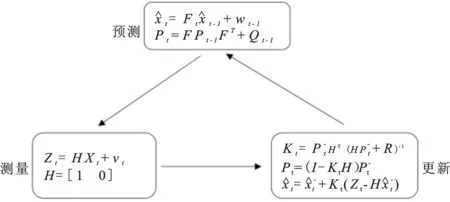

2.4 船舶目标动态跟踪

通过多源传感器识别出船舶目标后,需要实现对其运动跟踪,而确定目标的运动模型是目标跟踪的关键。船舶在通过监测水域中大多数保持匀速运动,运动状态不会在短时间发生改变,因此本文对船舶运动建立CV模型[14]。假设t时刻船舶的状态为Xt,表示为

(11)

式中:Vt为船舶t时刻的速度;Pt为船舶t时刻的位置,按照CV模型,得到船舶的位置及速度转换关系为

(12)

可将式(12)写成如下形式

(13)

在CV模型的基础上运用卡尔曼滤波跟踪船舶的运行轨迹,并得到船舶的实时运动状态。根据上式预测当前船舶的运动状态,对当前船舶运动状态的预测是有噪声的,因此需用协方差矩阵P来表示预测中的噪声,即

Pt=Fcov(Xt-1,Xt-1)FT+Qt-1=FPt-1FT+Qt-1

(14)

式中:Q为过程噪声的协方差。

具体流程如图5所示。

图5 卡尔曼滤波跟踪船位Fig.5 Kalman filter tracking

3 系统展示

面向内河船舶安全监管,在某内河航道对本文提出的方法进行了试验,并基于此研发了一套船舶态势主动式智能感知系统。该系统可对进出辖区的船舶实现船舶轮廓识别、船舶干舷测量、船舶位置航速监测、船舶流量统计,船舶违章自动取证等功能。实现对内河航道船舶的高精度、全天候、不间断地自动监测和统计分析。系统前端传感器综合采用了激光扫描仪、CCTV、AIS等设备,现场综合采集环境示意图和系统界面如图6所示。

图6 现场环境和系统展示Fig.6 Site environment and comprehensive information system display

4 结论

针对现有手段在船舶安全监管上的不足[15-16],本文提出了一种船舶视频目标自动检测方法,并分析了激光点云数据处理,利用正态性隶属度函数矩阵实现了在动态视频修正下的船舶轨迹特征融合。基于本文提出的方法研发了一套多传感器融合的船舶态势主动式智能感知系统,可实现不依赖于船铭、船号等可见标识下的主动式全天候高精度自主监测。系统是信息化与传统水运融合发展的重要实践,对于提升海事管理水平,创新船舶监管手段具有重要意义。