基于高光谱图像的近距离显著性目标检测

2021-08-09皋婕季泽华杨智钦熊凤超陆建峰

皋婕,季泽华,杨智钦,熊凤超,陆建峰

(南京理工大学计算机科学与工程学院,江苏 南京 210094)

0 引言

显著性目标检测旨在模拟人类的视觉系统,发现图像中的感兴趣的目标,是计算机视觉重要研究内容。显著性概念的提出是受到早期灵长类动物视觉系统和神经元结构的启发[1],引入显著性的概念可以将有限的计算资源分配给图像视频中更重要的部分。因此,显著性检测在视觉跟踪[2-3]、语义分割[4],图像视频压缩,图像检索等领域中有着重要的应用价值。

早期显著性检测方法,大多数基于手工特征如强度、颜色、方向的特征[5-7],或这些特征的组合生成显著图。随着近几年卷积神经网络(Convolutional Neural Networks, CNN)的应用越来越广泛,基于深度学习的显著目标检测方法得到大量研究。

此类模型通过学习大量的输入与输出之间的非线性映射关系,避免了显式的手工特征抽取,具有更强的表达能力。基于卷积神经网络的显著性检测模型表现远好于早期的基于手工特征的模型,其中以基于全卷积神经网络(Fully Convolutional Networks, FCN)的显著模型为代表[8-9]。

虽然基于彩色图像的显著性目标检测的研究已经取得了很大的进展,但是在某些场景中,这些已经十分成熟的模型会失效,如目标与周围的环境具有相近的颜色、纹理,并且没有明显的边缘,这种情况下彩色图像提供的信息不足以正确识别出感兴趣的对象。

高光谱成像技术为解决此类问题提供了新方案,高光谱图像记录了每个目标的连续光谱信息,这是传统彩色相机无法做到的。这些光谱信息提供了场景详细的材料信息,为材料成分分析和基于材料的目标检测提供了基础。基于高光谱图像,Liang等人[10]将基于高光谱成像的显著性物体检测概念扩展到材料级别。Liang的方法扩展了Itti的视觉注意模型[1],从高光谱图像中提取材料信息生成显著图以进行目标检测。 这里主要使用三种方法进行了扩展:一是使用颜色匹配函数将高光谱图像转换为三色图像,而后直接应用Itti模型;二是将光谱波段分组来替换Itti模型中的颜色对;三是使用光谱角距离(Spectral Angle Distance, SAD)和欧几里德距离(Euclidean Distance, ED)计算出光谱响应及其邻域之间的差异,得到显著图。这些方法使光谱数据中的额外信息得到利用。

1 正文

1.1 相关工作

1,1.1 基于显著性的视觉注意力快速场景分析模型

Itti等人提出了一个基于彩色图像的显著性模型,他们首先对输入的彩色图像使用二元高斯金字塔[11]创建了九个空间比例尺,保证模型特征的多尺度提取。在经过低通滤波后,分别提取颜色、方向、强度特征。R,G,B分别作为图像输入的红色,绿色和蓝色通道,强度函数I被定义为三个通道的平均值;颜色函数有四个,分别为从原始的红色,绿色和蓝色通道计算出的红色,绿色、蓝色以及黄色通道函数;局部方向信息由定向Gabor金字塔得到。随后对这三类函数进行中心-周围差分运算以及归一化,这里的中心-周围差分运算指根据“中心-周围”拮抗理论,算出每一个像素点(作为中心点)相对于周围的像素点的显著值,方法是将尺度较大的图像和尺度较小的图像进行跨尺度减操作,能得到局部中心和周边背景信息的对比信息。最后得到42张特征图,分别为6张强度图,12张颜色图和24张方向图。为了防止某几张图的显著特征在42张图的融合过程中被平均,Itti模型提出一种归一化运算符,在缺少自上而下监督的情况下增强波峰较少时的峰值,抑制波峰较多时的峰值。在经历此种归一化后使用线性组合将特征图融合,得到最终的显著图。

1,1.2 高光谱解混

由于传感器的空间分辨率低以及远距离图像采集,高光谱图像中总是存在难以分析的混合像元,即单一像元包含多种材质。高光谱图像解把混合的像元分解为一组称为端元(Endmember)的光谱特征以及它们相应的混合比例,即丰度(Abundance)。按照光谱混合方式,高光谱图像解混可以分为线性光谱混合模型(Linear Spectral Mixture Model, LMM )和非线性光谱混合模型(Nonlinear Spectral Mixture Model, NLMM)。LMM由于其简单性和适用性而在混合算法中被广泛采用。基于LMM的高光谱解混方法大致分为三类:

(1)单纯形几何理论。高光谱数据在几何角度上可以视为单纯形(Simplex)基于单纯形几何的解混方法利用高光谱图像的几何信息对数据进行分解,可以分为基于纯像元的方法和非纯像元的方法。基于纯像元的方法假设数据集中存在只包含一种材质的像元,而非纯元方法无此假设。

(2)基于统计理论。在数据高度复杂、材料高度混合的情况下,基于几何的方法可能不再适合。在这些情况下,提出基于统计的方法来替代几何理论,但统计方法通常具有更高的计算复杂度。代表性的方法有如独立成分分析(Independent Components Analysis, ICA)[12-13]、非负矩阵分解(Nonnegative Matrix Factorization, NMF)[14-15]等。

(3)稀疏回归理论。稀疏回归理论假设高光谱图像可以通过预先已知的若干纯光谱特征的线性组合来表示,那么解混就是在光谱库中找到最佳的光谱子集,用以更好地表示高光谱图像中的混合像元。由于高光谱图像中的端元数量与光谱库中的数量相比非常少,解混变成了利用线性稀疏回归技术和稀疏性正则化技术进行优化的过程。基于稀疏回归的方法要求我们在解混前有一个库,里面包含了待解混图像中存在的所有端元,因此光谱库的构建十分关键。

受益于深度学习强大学习能力,钱等人提出了一种基于线性光谱混合模型和迭代收缩阈值算法(Iterative Shrinkage Thresholding Algorithm, ISTA)提出了一种基于深度展开的深度盲解混算法(Unfolded Blind Neural Network, UBNN)[16]。UBNN把ISTA的迭代算法展开,形成深度编码结构,然后将端元矩阵以解码器结构连接,形成编码器-解码器结构,实现盲解混,并且取得了较好的解混精度和速度。

1.2 深度与手工特征融合的高光谱显著性检测模型

1.2.1 整体框架

我们提出深度与手工特征融合的高光谱显著性检测模型,将其简称为HD-Detector(Handcraft and Deep Detector)。首先将高光谱数据输入深度解混网络(详见1.2.2节),得到若干个端元的丰度图。然后根据解混结果中的丰度图来计算光谱空间分布,提取显著性,生成材料特征图。同时我们计算欧几里得距离以及光谱角距离来测量两个光谱矢量之间的相似性。基于这两种距离,我们可以计算出另外两个显著图。将上述三幅图进行线性组合,就得到了最终的显著图。最后,使用最佳阈值对图片进行二值化,得到结果。我们把它命名为深度与手工特征融合基于深度解混的高光谱显著性检测模型

图1 整体框架图

1.2.2 深度高光谱图像解混

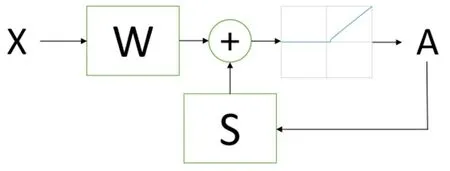

首先我们的方法基于LMM(线性混合模型),LMM模型认为采集的光谱是端元光谱线性组合产生,以此为前提假设。假定有p个波段的高光谱图像,LMM模型将一个像元表示为R个端元以及其对应的丰度。即:

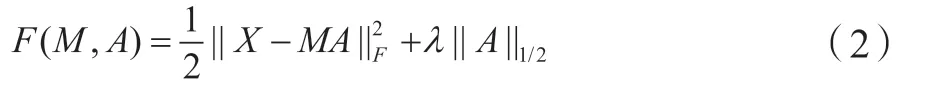

通常每个像元是由端元矩阵中的几个端元组成,即丰度矩阵是稀疏的。范数是得到稀疏解的重要方式,但L1正则化对于大小不同的值的处理力度是一样的,这对于稀疏问题是“不公平”的,稀疏问题要抑制接近0的值,保持较大的值,所以我们采用L1/2约束半阈值算法来产生更强的稀疏性。此外,也已有从几何角度证明了L1/2与最小值之间关系密切,即稀疏表示使单纯形的值最小化。理论分析和实验结果表明,L1/2[17]是比L1更有前途的替代方法。因此,L1/2约束半阈值算法将问题建模为:

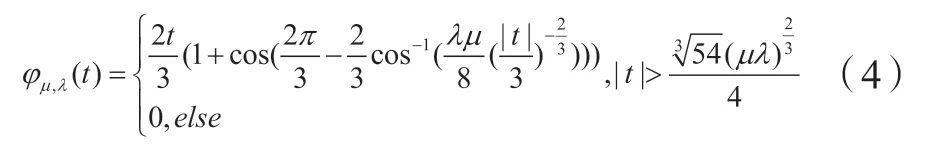

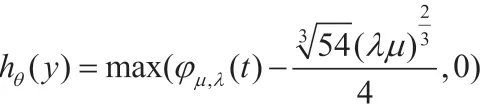

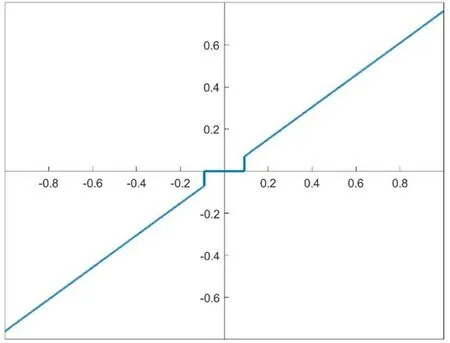

当端元已知时,求解丰度的过程可以看做是稀疏回归问题,近端梯度算法(Proximal Gradient Decent)是求解这类问题的方法。它把问题分解为可微分部分和不可微分两部分,并且对可微分部分进行梯度下降,把得到的结果用于不可微分部分对应的近端算子投影,得到相应的解。采用近端梯度下降算法求解矩阵A,我们可以得到,

上述公式可以进一步转化为

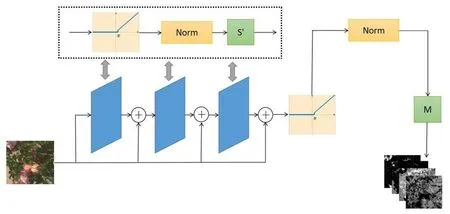

图2 递归神经网络结构图

图3 递归神经网络结构图

用公式4代替公式里的θ,我们的网络结构如图4所示,共三层,每层网络的参数共享,在经过这些层时,同时学习和优化公式5里W',S',θ'并经过归一化以保证ASC约束,即所有端元的丰度值和为1。经过最后一层时,端元矩阵M作为参数也被学习。此方法提供了更稀疏并且更好的解混结果。

图4 深度网络结构图

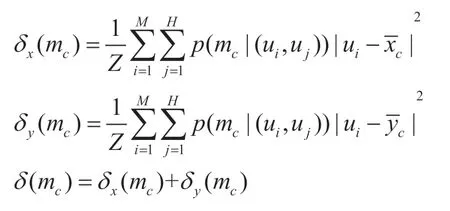

1.2.3 全局材质分布特征

根据解混得到的丰度特征,我们使用材料的光谱空间分布来计算显著性,对于彩色图像的显著性提取告诉我们:显著对象的颜色分量倾向于集中在空间域中,但是背景对象的颜色分量通常分布在整个图像上。因此,颜色分量的整体分布方差可用于指示对象的显著程度。同样的,对于高光谱图像,具有材料显著性的对象的光谱分布倾向于集中在空间域中,因为光谱空间分布本质上反映了场景中的材质成分,材料出现在图像上的频率越低且其空间分布越集中,它就更可能属于一个显著性物体。我们根据Liang的显著性提取模型[18],可以得到,端成员mc的空间分布方差可表示为沿x和y维度的方差的组合:

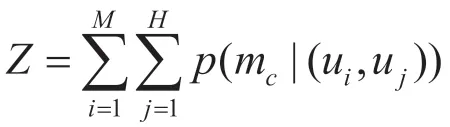

其中Z为归一化因子:

随后可以根据当前像元u与图像中心uc的距离进行显著性加权,来消除临近边界的一些小目标光谱的影响。

1.2.4 局部空间结构信息

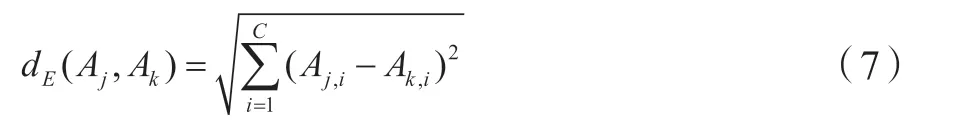

类似Liang的方法[10],加入了两个浅层的、多尺度的、采用了中心-周围差分计算的特征。这里的“多尺度”指的就是使用高斯金字塔进行尺度变换,这些金字塔逐步对输入图像进行低通滤波和二次采样,生成九张尺度图,增强了方法的尺度不变性。“中心-周围差分计算”根据视觉神经元的相关原理[1],把金字塔中的低层级图像的像素点看成“中心”,把高层级图像的对应像素点看成“周围”。然后把高层级图像通过内插至与低层级图像相同的比例,最后,把两个图像对应像素点的某种特征的值,进行逐点相减。这种计算可以提取中心和周边背景信息反差对比强烈的区域。我们用浅层特征来捕获局部信息,假设有两个光谱向量Aj,Ak,我们计算他的两种距离:欧几里得距离以及光谱角距离:

这两种距离可以反映光谱向量之间的相似度,得到的特征图反映了局部信息。将浅层特征和深度特征相结合可以综合全局和局部的光谱特征,得到图像完整的光谱空间特征。将1.2.3节中得到的材料特征图与欧几里得距离图、光谱角距离图进行线性组合,就得到了最终的显著图。

1.2.5 显著目标检测

为了方便观察,我们将得到的显著性图转化为表示出显著物体的矩形框。首先我们对显著图进行二值化,采用OTSU(大津)算法,此算法由日本学者大津(OTSU)于1979年提出,使用最大类间方差法来找到最佳阈值[19]。记T为前景与背景的分割阈值,前景点数占图像比例为ω0,平均灰度为u0,背景点数占图像比例为ω1,平均灰度为u1。T的值从最小灰度值到最大灰度值遍历,当T使得方差值,即最大时,T即为分割的最佳阈值。以此阈值对显著图进行二值化,用矩形框表示出值为1的区域,即为显著性物体。

1.3 实验结果

1.3.1 实验数据

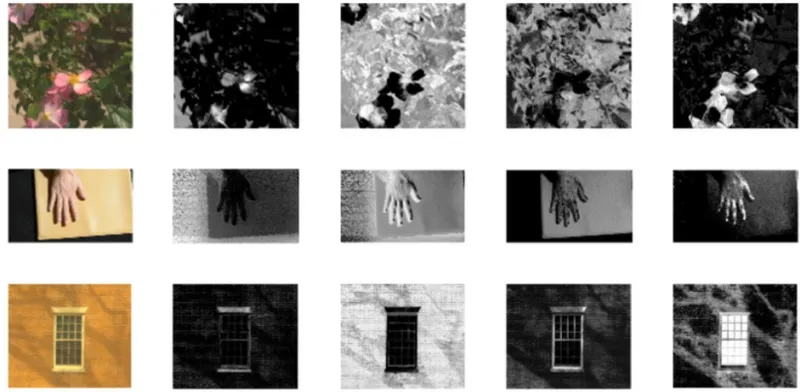

我们数据集共43张,一部分来自[18]中的使用的数据集,一部分由我们自己采集并标注,波段数从16到81不等。数据集包括日常目标,例如水果,魔方,水渍,花朵、窗户、车辆等。每个图像包含颜色相似但材料不同的混合对象。图5展示了一些典型的样本,例如,图5中第一行第一张图片,只有下方的魔方是真实的,上方的魔方都是打印图案;第二张展示了真实水果和真实水果中的塑料水果,第三张展示了墙壁上的水渍等等。数据集标注为手动矩形框标注。

图5 数据集示例(和高光谱图像对应的彩色图像)

1.3.2 对比指标

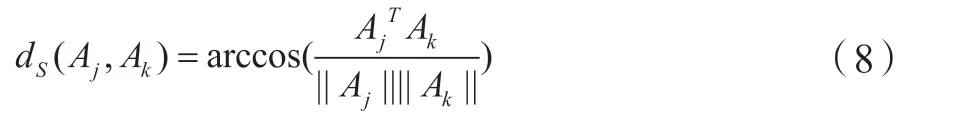

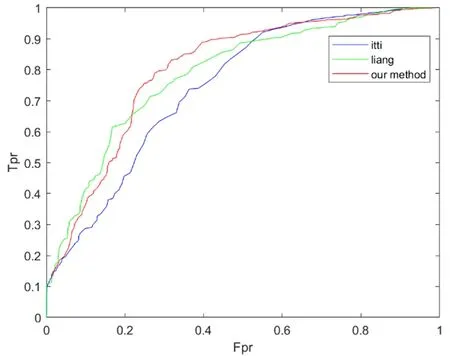

(1)PR曲线:PR曲线是以recall(召回率)为横坐标,precision(精准率)为纵坐标绘制的曲线。

我们知道,把正例正确地分类为正例,表示为TP(True Positive),把正例错误地分类为负例,表示为FN(False Negative)。把负例正确地分类为负例,表示为TN(True Negative),把负例错误地分类为正例,表示为FP(False Positive)。precision是指分类正确的正样本个数占分类器判定为正样本的样本个数的比例,recall是指分类正确的正样本个数占真正的正样本个数的比例,即:

只用某个点对应的精确率和召回率是不能全面地衡量模型的性能,只有通过P-R曲线的整体表现,才能够对模型进行更为全面的评估。

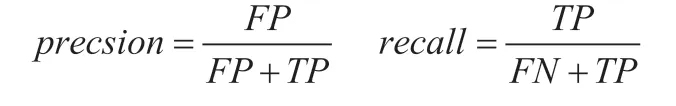

(2)ROC曲线及AUC值:ROC曲线是以假正例率(False Postive Rate,FPR)为横轴,是真正例率(True Postive Rate,TPR)纵轴绘制的曲线。

FPR代表分类器预测的正类中实际负实例占所有负实例的比例;TPR代表分类器预测的正类中实际正实例占所有正实例的比例,即:

AUC表示ROC曲线下的面积,主要用于衡量模型的泛化性能,即分类效果的好坏。AUC是衡量二分类模型优劣的一种评价指标,表示正例排在负例前面的概率。AUC越大,模型性能越好

(3)IoU:IoU是交并比(Intersection over Union),适用于在输出中得出一个预测范围(bounding box)的任务。IoU是两个区域重叠的部分除以两个区域的集合部分得出的结果,用于测量真实和预测之间的相关度,相关度越高,该值越高。

1.3.2 对比方法

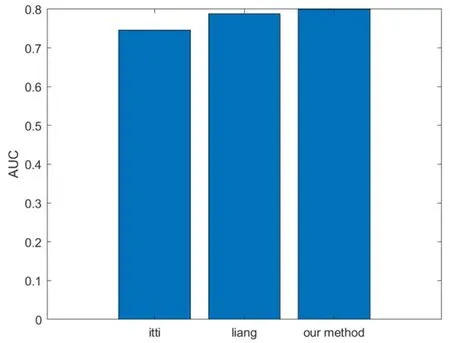

(1)定量分析。我们对比了Itti、Liang以及我们的方法,Itti模型是最经典的彩色显著性检测模型,而Liang的方法是基于高光谱图像来做的显著性检测工作,我们将3种方法应用于我们的数据集上,进行了定量实验,得到了PR曲线、ROC曲线、AUC值以及IoU值。

由于显著图的取值范围为[0,255],我们将阈值thresh从0到255遍历,得到了256组Precision、Recall、Fpr、Tpr、IoU值。256组Precision以及Recall值可以画出PR曲线;同样的,256组Fpr以及Tpr值可以画出ROC曲线,计算曲线下面积可以得到AUC值。而IoU(Intersection over Union)指的“预测的边框”和“真实的边框”的交集和并集的比值,可以较好地反映预测结果是否准确,我们在实验中由256组IoU值取平均得到最后的评价值。

图6 PR曲线

图7 ROC曲线

图8 AUC值

图9 IoU值

(2)定性分析。

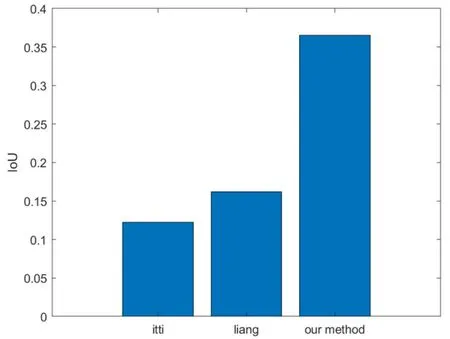

①深度解混的结果。我们通过图4的网络进行盲解混,得到端元数量不等的解混结果,图10展示了一些图片的解混结果。可以看到第一行的丰度图区分了背景、叶子、花朵;第二行的丰度图区分了背景、手、黄布;第三行的丰度图区分了窗沿、墙壁、窗框、玻璃。

图10 深度解混结果示例

②材料显著性提取。通过解混得到的丰度图和端元向量,我们使用光谱的空间分布方差来提取材料显著性,得到的材料显著图,如图11所示,这是综合了全局和局部信息的结果。

图11 材料显著图示例

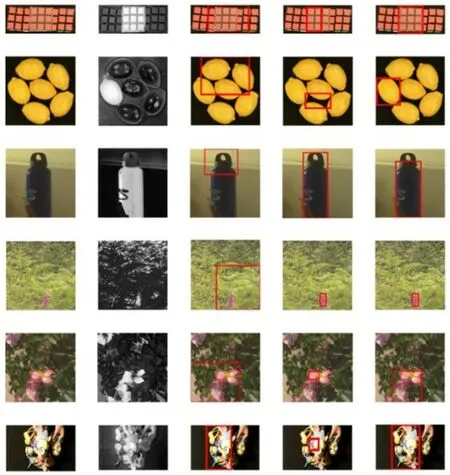

③显著性目标检测。我们对比了Itti、Liang以及我们的方法,我们将3种方法应用于我们的数据集上,得出了对比结果。

第一列为彩色图像,第二列为HD-detector生成的显著图,第三列为Itti模型的检测结果,第四列为Liang的模型的检测结果,第五列为我们的方法的检测结果。

由图12可以看见在检测外形相似,材料组成与背景不同的目标时,我们的方法展现了很大的优势。在第一行的图像中,中间的魔方为打印出来的魔方图案,两侧为真实魔方,由于纸质图案颜色和真实魔方仍有差距,所以Itti模型和Liang的模型都可以识别出目标物体的一部分,但效果误差较大,而我们的方法可以准确识别出纸质魔方的轮廓。对于第二行的真水果和塑料水果图像,由于颜色和轮廓都十分相近,Itti和Liang的模型都无法检测出正确的目标物体,而我们的方法由于对材料显著性进行了提取,所以准确识别出了与周围环境材料组成不同的真水果。

图12 对比实验

而对于目标的颜色、形状与背景差异较大的情况,我们的方法并没有很大优势,如第三行的图像,水杯和后景的颜色差异巨大,所以我们的方法效果并不突出。当图像的材料组成复杂,纹理轮廓繁杂时,我们的方法展现了优势。在第四、五行的图像检测中,Itti和Liang的模型检测的结果出现了检测结果是真实值的一小部分或包含了太多无关像元的情况,而我们的方法能较好地从复杂的场景中识别出正确的目标。

由此可得,我们的方法在定性和定量指标上均有出众的表现。

2 结论

我们的方法将深度学习、神经网络与基于高光谱图像的近距离显著性目标检测结合起来将浅层局部手工特征与深层全局材质分布特征结合,充分利用高光谱图像含有的大量信息。首先利用深度展开技术进行解混并使用光谱空间分布方差提取材质分布特征,引入L1/2约束半阈值算法保证更好的稀疏性。然后利用多尺度的中心周围差分运算提取空间结构特征。将深度特征和浅层特征结合,全局特征与局部特征结合,更好地提取了图像的显著性,更有效地进行显著目标检测。实验结果表明,我们的方法在(1)目标和背景轮廓、颜色、纹理相似,但材料组成不同的情况下;(2)图像的材料组成太复杂的情况下有出色的效果,有效地检测出显著性目标。未来我们将把深度学习技术引入高光谱近距离显著性检测的整个过程,不仅部分应用于解混这一步骤,以进行更强大的显著性检测。