情绪调节系统的研究与设计

2021-06-29四川信息职业技术学院软件学院周建儒

四川信息职业技术学院软件学院 周建儒

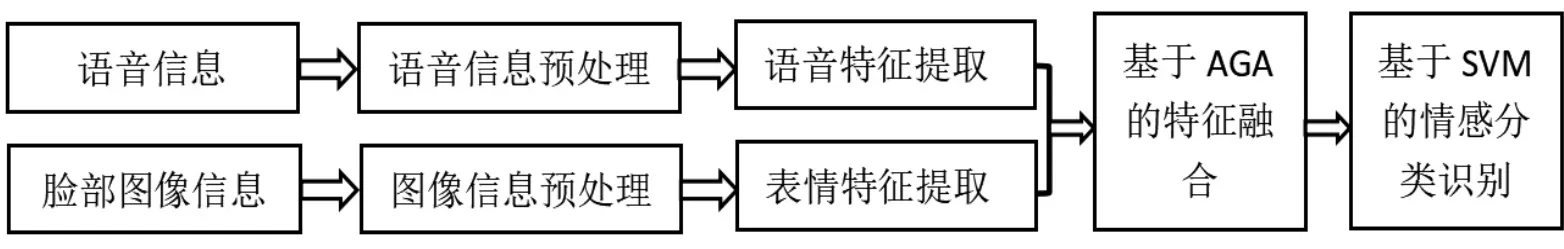

情绪调节系统通过获取用户的语音和脸部图像识别用户的情绪,并且在适当的时候会帮助用户调节负面情绪。人类情感的表达形式是复杂而多样的,基于单一语音信号或人脸表情图像的情感识别具有一定的局限性,为了提高情感识别的准确率,探索了基于自适应遗传算法(AGA)将语音信号特征与人脸表情图像特征相融合,然后采用支持向量机(SVM)进行情感识别。

上世纪初,英国医生费里斯和德国心理学家斯沃博特同时发现了一个奇怪的现象:有些患有头疼、精神疲倦等症状的病人每隔28天就来治疗一次,于是他们就将这种现象称为“情绪周期”,28天称为“情绪定律”。人的情绪周而复始地变化着,一般28天为一个周期。每个周期的前半期为“高潮期”,后半期为“低潮期”,高潮期向低潮期过度的时间叫“临界期”,一般为两三天。当人处于临界期时,情绪不稳定。

了解情绪变化的周期,人们就可以更好地控制自己的情绪。人们在心情愉悦的时候,可以承受更大的工作压力,从事难度较大的工作,接受较繁琐的任务。在心情低落的时候,可以找人倾诉,或者进行体育运动,或者借助一些可以调节情绪的软件,及时调整个人的心情,使自己的情绪尽快恢复到良好的状态,从而避免不良事情的发生。

情绪调节系统正是为了调节人的情绪而设计的一款适用于手机的情绪自动识别与调节软件,当用户在使用手机进行通话或者工作的时候,只要开启这个软件,它就能够自动获取语音信息和脸部表情信息,然后进行情绪识别,识别出用户的情绪状态,如果用户处于负面情绪的状态,这个软件会在设定的时间播放能够舒缓情绪的音乐,帮助用户调节情绪,使其更快的恢复到良好的情绪状态。

1 情绪调节系统的功能需求

情绪调节系统主要有三个功能,语音情感识别、人脸图像情感识别、播放音乐。只要用户打开该系统,并设定系统获取用户语音数据和脸部图像数据的起止时间,系统就会在设定的时间段内实时获取用户的语音和正面的脸部图像,然后进行情绪识别,系统会统计用户负面情绪出现的时间和数量,自动分析用户负面情绪出现的频率和分布的时间,然后综合评估用户的情绪状态,并在适当的时间提醒用户注意调节情绪,在征得用户同意后,系统会为用户播放可以舒缓情绪的音乐,帮助用户调节负面情绪。

用户在通话过程中采集语音数据,保存在语音库中,对每一段语音进行预加重、分帧、加窗、端点检测等预处理,在采用MFCC方法进行语音特征提取,然后在基于SVM进行语音识别,识别出用户的情绪状态。

情绪调节系统对脸部表情识别有两种方式,图像识别和实时视频识别。图像识别方式,先开启摄像头,每间隔0.5s拍一张照片,拍摄的如果是正面人脸的照片就保存在图像库中,否则就丢弃;实时视频识别方式,每间隔0.4s采集5帧图像,采集的图像使用OpenCV进行预处理,挑选出人脸面部图像保存。对图像库中的图像进行情绪状态识别。

用户将自己喜欢且可以起到舒缓情绪的音乐上传到手机,单独保存在某个固定的路径中。当情绪调节系统检测到用户处于负面情绪状态的时候,系统可以从这个路径中随机选取音乐播放,调节用户的情绪。情绪调节系统功能逻辑如图1所示。

图1 情绪调节系统功能逻辑图

2 情绪调节系统的功能模块

2.1 语音情感识别

语音情感识别(Speech emotion recognition,SER)是指计算机可以自动识别语音信号的情感状态。SER技术主要分为语音信号采集、特征提取和情感识别三个阶段,其中关键技术是语音特征提取和语音情感识别。

语音信号是模拟信号,在对语音信号进行预处理之前必须通过采样将其转换成数字信号,预处理的目的是消除语言信号中的无用信息,获得稳定的语音信号。预处理之后的语音信号有相同的数据格式,可以降低特征提取的难度。

语音情感特征主要包括韵律特征、音质特征、基于谱的相关特征,这些特征在语音情感识别中起到关键作用,所以,语音特征的选取和提取直接决定了语音情感识别的准确率。语音情感识别模型有支持向量机(SVM)、隐马尔可夫模型(HMM)、高斯混合模型(GMM)、卷积神经网络(CNN)、递归神经网络(RNN)等。其中卷积神经网络在语音识别和图像识别领域取得了成功。黄晨晨将连续多帧的语音情感特征合并为一个高维特征,在利用深度信念网络自动提取语音情感特征,然后输入SVM分类器中进行分类。

语音情感识别的分类算法之一是支持向量机(SVM),由Vapnik等人在1995年提出,这是一种基于统计学习理论基础的机器学习方法,具有良好的性能指标。通过学习算法,SVM能够自动寻找出对分类有较好区分能力的支持向量,并构造出分类器,它可以寻找各种类样本点之间的最宽距离,区别归属各种类别样本的数据,具有较好的适应能力和较高的分类准确率。

2.2 人脸情绪识别

人脸情绪识别有四个步骤:人脸图像采集、图像预处理、人脸检测与定位、人脸情绪识别。

图2 基于语音和人脸图像的情感识别图

通过摄像头采集人脸图像,可以是照片也可以是视频,如果是视频就要获取每一帧图像,把所有的图像转换为数字图像格式方便进行预处理。从视频中采集到的图像由于受到拍摄角度、位置、灯光等因素的影响,可能会导致人脸识别不准确,所以必须通过灰度化、几何变换、图像增强的流程对图像进行预处理,使得人脸图像具有标准的大小、位置、灰度等级。

人脸检测是判断图像中是否存在人脸以及人脸在图片中的位置。定位人脸位置的方法有很多,其中Viola和Jones使用一种基于脸部地理信息的人脸检测方法,对脸部的眼睛、鼻子、嘴巴等关键部位进行定位,根据人脸纹路的分布改变人脸图像的像素密度,通过自适应增强的方法去掉图像中不重要的节点,进而定位人脸在图像中的位置。

人脸表情情绪识别是针对检测到人脸的面部表情进行情绪识别。近年来基于深度学习的卷积神经网络的表情识别技术成为该领域的研究热点。Song等人设计了一个具有65000个神经元的五层CNN网络模型,使用dropout技巧削弱了训练过程中过拟合的问题,并且该模型可以部署在智能手机上。

2.3 播放音乐调节情绪

当情绪调节系统检测到用户处于负面情绪状态,并且有必要借助该系统进行情绪调节的时候,当获得用户允许后,系统会自动从音乐文件中随机挑选音乐播放,帮助用户舒缓情绪,起到调节负面情绪的作用。

为了让情绪调节系统能够在没有网络的环境中运行,该系统不支持播放网络中的音乐文件,同时为了提高系统在手机上的运行速度,该系统不支持对音乐情绪特征的识别,主要是因为音乐情绪特征的识别过程占用的内存较大,特征提取过程的计算量较大,不适合在手机上进行计算,所以,音乐的选择根据用户主观爱好,自己分类并传入手机即可。

3 构建基于语音和人脸图像的多模态情感融合模型

基于语音和人脸图像的多模态情感识别是情绪调节系统的核心模块,在整个系统研究中占有重要的作用,核心工作是构建多模态情感识别模型。

国内的很多学者对多模态的情感识别进行了深入的研究,其中闫静杰采用交叉模态因子分析(KCMFA)方法对语音和脸部图像进行特征降维和特征融合,再利用隐马尔可夫模型对情感类型进行识别。王晓华提出了基于时空局部二值模式矩方法的双模态情感识别算法,有效的解决了视频情感识别中运算复杂的问题。本文采用了自适应遗传算法(AGA)对人脸表情、语音两个特征进行融合,然后采用支持向量机进行情感分类识别,如图2所示。

结语:目前,情感识别是人机交互领域的研究热点,本文探索了基于语音和人脸图像多模态情感识别的方法,并基于此研究设计了情绪调节系统,目的是帮助处在负面情绪状态中的人们借助这个系统调节自己的情绪,从而避免对身心造成伤害。