基于生成对抗网络的步态特征提取与识别

2021-06-22文佳敏沈永良

文佳敏,沈永良

(黑龙江大学 电子工程学院,哈尔滨 150080)

0 引 言

生物识别技术是利用人体生物特征实现身份认证的一种现代技术,广泛应用于身份鉴别、信息保护等领域。人脸识别、指纹识别和虹膜识别等生物特征识别技术已日渐成熟,在人体身份信息认证中取得了良好表现[1]。但在案件侦破、安全监控、市场营销等领域表现出能力不足。步态识别技术作为生物特征识别领域的另外一个重要分支,克服了人脸识别、指纹识别和虹膜识别等识别技术的局限性,仅使用摄像机就能在远距离捕获目标并采集特征信息。通过对监控视频中人物的步态分析可快速锁定目标,经过相关数据库的信息比对获取目标的相关信息。步态识别技术优良特性在案件侦破、安全监控、市场营销等领域具有巨大的潜力和研究价值[2-3]。

李超[4]利用深度卷积神经网络求解SMPL人体模型参数与相机参数以实现人体三维姿态感知,针对角度因素的影响提出结合深度卷积特征与联合贝叶斯的解决方法,并在OULP数据集和CASIA-B数据集上进行验证。于凯强[5]利用卷积神经网络和类能量图的步态识别方法,完成了多组单种能量图和多种能量图信息融合的跨视角和跨形态的步态识别研究,并验证其有效性。Zhang X等[6]基于视频传感器建立DeepGait网络模型,与其他传统的识别网络相比,该网络不需要手动调整,在不同数据集的不同状态下均能获得较好的识别效果。Shiraga K等[7]基于卷积神经网络建立GEINet模型,该模型以步态能量图作为输入,在OUISIR数据集有良好的识别效果。Wu Z等[8]提出通过深度卷积神经网络直接学习步态图之间的相似度,通过卷积神经网络提取步态图的特征。Yu S等[9]利用自动编码器去除大衣、手持包等因素对模型识别效果的影响。Choi Y等[10]提出使用StarGAN网络实现多个领域图像到图像的转换。Yoo D等[11]在传统生成对抗网络的基础上引入了新的域鉴别器,确保生成的图像与输入图像之间的相关性。

人的行走方向是随机的,视角、服装等因素的变化会使人的外观产生变化,影响模型的识别效果。可通过构建视图转换模型解决跨视角识别问题。He Y等[12]建立了Multi-Task GANs生成对抗网络, 并提出了周期能量图PEI(Period Energy Image),实现了跨视角的步态识别。瞿斌杰等[13]基于视角转换的多视角步态识别,使用VTM-GAN网络将不同视角下的步态能量图映射到保留步态信息最丰富的侧面视角,打破了步态识别中多视角的限制。翟宇飞等[14]提出了一种多视角的生成对抗网络模型,能够将不同状态、不同角度的步态图转化为正常状态的步态图集合,尽可能多地保留原始的特征信息,使识别精度有了很大的提升。Makihara Y等[15]使用奇异值分解的方法对步态能量图视角的不变特征进行计算,实现了视图之间的转换。Zheng S等[16]提出了一种基于鲁棒的视图转换模型,该方法与现有方法相比找到了一个共享的线性相关低秩子空间,使视图转换模型对视角变化、服装和携带条件变化具有鲁棒性。大多数与VTM相关的方法,只能实现视图在特定视角下的转换,对所估计的视角精度具有较强的依赖性。

为克服外界因素对模型的影响,提高步态识别准确率,本文提出了一种基于生成对抗网络的步态识别算法。该算法首先通过编码器将真实的步态图像抽象到另一个空间,以便于捕获真实步态图像的个体特征属性;然后将捕获的步态特征馈送到解码器中进行反卷积,得到生成的步态图像。此外,为提高生成步态图的真实性,使生成图包含较多的语义信息,在编码-解码网络之后增加真假判别器与身份判别器。网络训练时将编码-解码损失、真假判别损失、语义损失3种损失相结合,多次迭代逐渐降低损失,以使网络达到最好的识别效果。

1 基于生成对抗网络的步态特征提取与识别

1.1 步态能量图

步态特征涵盖整个步态周期,在人行走过程中呈现周期性变化。识别时仅使用单个步态轮廓图像无法对步态特征进行完整表达。GEI鲁棒性强、计算效率高,是一种被广泛使用的步态特征,可以保留行走过程中的特征信息,因此本研究使用步态周期合成的步态能量图(GEI)[17]作为输入的步态模板,通过对步态序列中一个步态周期的轮廓进行平均,可获得该序列的GEI。GEI的形成过程见图1。

图1 步态能量图生成过程Fig.1 Gait energy image generation process

1.2 生成对抗网络

生成对抗网络(GAN)主要包含生成器和判别器两个主要部分。生成器通过将图像从小维空间映射到像素级图像空间,最小化随机噪声生成逼真的图像。判别器对生成器所生成的图像进行判别,当输入为真实图像时,判别器输出为1;当输入为生成图像时,判别器输出为0。

网络训练时分别以从训练集中抽取的n个样本为真实样本,以生成器根据随机噪声生成的n个噪声样本为假样本训练判别器D,使其尽可能分辨样本真假。固定判别器的参数,使用真假样本训练生成器G,使生成的图像逐渐趋近于真实图像,从而扰乱判别器的判别。经过多次迭代训练,生成器所生成的图像与真实图像的差距越来越小,使得判别器无法辨别输入是来自真实的训练样本还是来自生成器生成的图像,此时认为生成模型的能力已足够强大,训练停止。生成器与判别器目标函数可以表示为极大极小化目标函数

(1)

(2)

1.3 步态特征提取与识别

生成对抗网络能够将不同状态、不同视角的步态特征图转换为正常服饰、不携带物体的90°侧视图,同时保留了受试者的身份信息,消除了不同视角、不同状态对生成对抗网络模型识别效果的影响。视角转换见图2。

图2 视角转换Fig.2 View angle conversion

转换器是端到端的可训练的网络,主要由编码器和解码器组成。转换器能够将源图像(所有视角、衣服和携带物变化的GEI)转换为90°正常行走的GEI目标图像,具体结构见表1。

表1 转换器结构

真假判别器可以对输入图像是生成图像还是源图像进行判断,使生成的图像更加真实。若真假判别器的输入为3种正常行走状态90°的真实步态能量图,真假判别器输出为1;若真假判别器的输入为通过生成器生成的步态能量图,真假判别器输出为0。身份判别器被训练生成的图像中包含源图像的语义信息。若身份判别器的输入为相同的个体,身份判别器输出为1;若身份判别器的输入为不同个体,则身份判别器输出为0。真假判别器和身份判别器的结构见表2和表3。

表2 真假判别器结构

表3 身份判别器结构

2 实验与分析

2.1 数据集

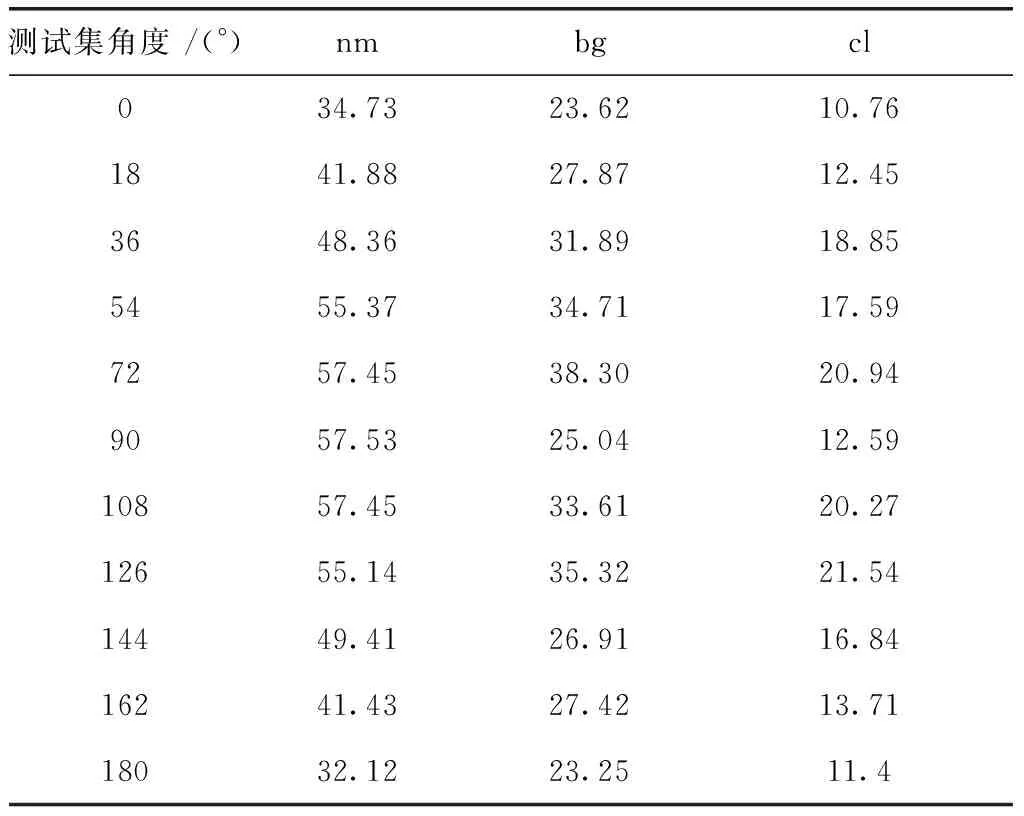

基于CASIA-B步态数据集对建立的模型进行评估。CASIA-B步态数据库是中科院自动化所2005年采集的大规模、多视角的步态库,共包含124名受试者(31名女性和93名男性)与11个不同的视角(0°,18°,36°,54°,72°,90°,108°,126°,144°,162°,180°)。每个受试者包含6个正常行走序列(nm-01,nm-02,nm-03,nm-04,nm-05,nm-06)、2个带包行走序列(bg-01,bg-02)、2个穿大衣行走序列(cl-01,cl-02)共10个序列。正常行走受试者在11个不同视角下的样本图像见图3。

图3 CASIA-B数据集11个视图的行走序列Fig.3 Walking sequence of 11 views in CASIA-B dataset

2.2 实验设计

设置网络的学习率为2×10-4,使用训练集的步态数据训练所建立的生成对抗网络,2 300次迭代之后模型性能逐渐趋于稳定。将训练完保存的权重信息加载到测试集中进行模型性能的评估。实验基于Intel i7-9750H处理器,NVIDIA GeForce GTX 1660Ti,内存8 G,并采用Pytorch深度学习框架。CASIA-B训练集、验证集和测试集的划分见表4。

表4 实验设计

2.3 实验结果与分析

为了验证网络模型的有效性,在不同视角、不同衣着和不同手持物3种状态下测试网络模型的识别准确率。对识别结果进行分析后发现:正常行走情况下,模型的识别效果优于背包状态与穿大衣状态,整体识别效果较好;背包状态下,模型的识别准确率受视角影响小,在72°时识别准确率最高;在穿大衣情况下,模型的识别效果较低。网络模型在3种行走状态下的平均rank-1准确率见表5。

表5 3种行走状态下的平均rank-1准确率

选取了54°,90°,126° 3个典型角度在测试集进行分析。生成对抗网络在3个典型角度的识别准确率见图4。由图4可见,当验证集角度与测试集角度相同时,模型的识别准确率最高,90°时模型的识别效果最好,正常状态下的最高识别率可达99.18%。由于90°时,模型所提取的腿部信息最多, 随着两腿间的跨度逐渐增大, 网络模型可以提取的有效信息逐渐减少, 导致不同视角下的识别率存在较大的差异。

图4 3种典型测试集角度的识别率Fig.4 Recognition rate of three typical test set angles

为了体现提出算法的有效性,分别与GEI+PCA[17]、baseline[18]进行了比较,对比结果见图5。由图5可见,提出的算法在正常状态下的识别效果与baseline和GEI+PCA相似;背包状态下的识别准确率与baseline相等并优于GEI+PCA模型;穿大衣状态下的识别效果优于baseline与GEI+PCA模型。结果表明,该算法能有效提取步态特征,并取得了较好的结果。

图5 CASIA-B数据集上无视角变化时的平均识别率Fig.5 Average recognition rate without perspective change on the CASIA-B dataset

从图像生成效果的角度对生成对抗网络的性能进行分析。将网络生成的步态图像与数据集中的真实步态图像进行对比,将不同视角、不同状态的GEI通过转换器网络转换成正常服饰、不携带物体的90°(侧视图)GEI,对比效果见图6。图6中仅展示了一组示例,每一组分别包含生成器生成的步态图像、实际步态的90°图像和非90°步态图像。由图6可见,生成对抗网络的性能较好,可根据源图像生成较逼真的GEI图像。

图6 模型生成效果Fig.6 Model generation effect

3 结 论

本文提出了一种基于生成对抗网络的步态特征提取与识别算法,通过将不同视角的步态特征转换到步态信息最丰富的90°状态,能够有效缓解不同视角、不同衣着和不同手持物等因素对识别效果的影响。基于CASIA-B数据集的实验结果表明,提出的算法具有较高的识别准确率,与其他算法相比,该算法综合性能最高,鲁棒性更强,对大数据集和复杂背景有较强的泛化能力。