多路径特征融合的遥感图像超分辨率重建算法

2021-05-18张艳卢宣铭刘国瑞刘树东孙叶美

张艳,卢宣铭,刘国瑞,刘树东,孙叶美

(天津城建大学 计算机与信息工程学院,天津 300384)

0 引言

遥感图像作为地表信息的重要数据,在遥感领域有着关键作用。高分辨率(high resolution,HR)的遥感图像不但具有丰富而细致的纹理,而且其所包含的关键信息在物体识别[1]、目标检测[2-3]、土地覆盖分类[4-6]等工作中有着不可取代的价值。然而,因为受到成像设备以及图像传输条件的限制[7-8],所获得的卫星图像往往是低分辨率(low resolution,LR)图像。因此,采用超分辨率(super-resolution,SR)重建技术来增强遥感图像的分辨率具有重要的应用价值。

随着计算机视觉的发展,卷积神经网络(convolutional neural network,CNN)在自然图像超分辨率重建领域广泛应用。Dong等[9]提出的SRCNN(super-resolution convolutional neural network)算法,利用三层卷积完成图像特征提取、特征非线性映射,获得了较好的重建效果,但由于层数过少,导致提取的特征有限。Kim等[10]提出的算法加深了网络层数,通过加入残差学习提高了学习速度和特征提取能力;他们还提出了一种具有短跳连接的递归卷积网络[11],将所有训练结果进行监督,避免了梯度消失的问题,另外加入了残差的思想,提高了图像重建的效果。Tai等[12]提出的深度递归残差网络采用参数共享的策略,缓解了过深的网络导致梯度消失的问题,但由于网络比较庞大,增加了运行计算的时间。刘树东等[13]提出的对称残差卷积神经网络采用块内对称短跳连接和块外长跳连接的方式,弥补了深度网络图像细节退化严重的损失,但无法充分学习到遥感图像的深层特征,重建性能有限。

在遥感图像的超分辨率重建方面,Lei等[14]利用深度卷积神经网络学习遥感图像中的多层次特征信息来提高遥感图像的重建效果,但随着网络加深,梯度消失也越明显。Ma等[15]结合小波变换和递归残差网络,充分使用不同频段的遥感图像补充图像细节,但网络复杂,加大了训练的难度。He等[16]把拉普拉斯金字塔加入遥感图像超分辨率算法中,采用级联的方式逐步细化,取得了不错的效果,但难以满足实时应用的需要。Xu等[17]提出的深度记忆连接算法,利用跳跃连接和残差连接加快了网络收敛速度。Gu等[18]的深度残差激励算法,利用残差模块和激励模块的组合,使不同层次的局部特征信息得到更好的融合,提高了网络的鲁棒性和重建能力,但模型在加深网络的同时,也加大了网络计算量和内存消耗等问题。

由于遥感图像内容复杂、细节信息丰富,在超分辨率重建方面仍然存在一些困难。通常,遥感图像中的目标具有比较广泛的尺度,所以在设计模型上应考虑局部和全局的特征信息,从而使模型能够学习到多层次的特征,提高重建效果。为了解决上述问题,本文提出一种基于多路径特征融合的遥感图像超分辨率重建算法。该算法模型由3个部分组成:浅层特征提取模块、特征融合模块和图像重建模块,如图1所示。其主要特点是:引入多路径特征融合网络结构,可充分融合各卷积层的特征内容,从而学习到足够的细节信息,增强了特征利用率;模型的轻量化设计,在提高模型重建性能的同时,减少了内存的占用和计算时间。

图1 多路径特征融合的遥感图像超分辨率重建算法模型

1 多路径特征融合网络构建

1.1 浅层特征提取模块

浅层特征提取模块由2个3×3的卷积层构成,其中每层卷积的特征维度为64。浅层特征提取模块用于提取LR图像中的特征信息。该模块用式(1)表示。

S=F(ILR)

(1)

式中:ILR表示网络的输入;F表示浅层特征提取模块的函数;S表示输出的特征。

由于带泄露线性整流(leaky recitiffied linear unit,LReLU)函数可以缓解网络训练中神经元死亡的问题,因此,在相应的卷积层后加入LReLU替代ReLU,以此增强网络训练的稳定性。LReLU的计算方法如式(2)所示。

(2)

式中:x为输入信息;α为设置的参数,本文设置为0.05。

1.2 特征融合模块

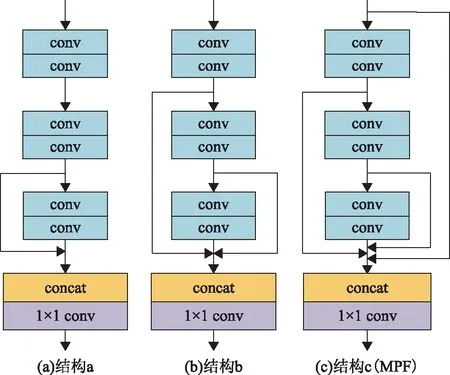

特征融合模块是本网络的核心模块,由4个多路径特征融合模块(multi path fusion,MPF)组成。MPF模块包含增强融合单元和蒸馏单元,模块图如图2所示。增强融合单元由3个基本单元组成,每2层卷积层可以看作一个基本单元。通过多条路径的连接,充分融合了不同网络层丰富的特征,使网络能够学习更多的细节信息,增强了特征利用率,从而使重建的图像细节部分更为清晰。为了减少模型的尺寸,减少了基本单元中卷积层的通道数,将通道数分别设置为48和64,从而减少参数,提高了重建的速度。蒸馏单元由1×1的卷积层组成,用来蒸馏信息。MPF模块如式(3)所示。

(3)

图2 MPF模块网络结构图

1.3 图像重建模块

图像重建模块由一个1×1的卷积层、一个转置卷积层以及一个3×3卷积层组成。首先,利用1×1卷积层减少输出特征图的数目,从而降低计算成本;然后,通过转置卷积层来放大图像,为了进一步加强网络的有效性,根据2、3和4倍不同放大系数将转置卷积的内核分别设置为4×4、5×5和8×8,这样既提高了模型的效率,而且有助于提高重建图像的质量;最后,利用3×3卷积层生成高分辨率图像。

1.4 损失函数

图像重建使用最广泛的损失函数为均方误差(mean square error,MSE),但使用平均绝对误差(mean absolute error,MAE)损失函数有时能获得比MSE损失函数更好的效果。所以模型先利用MAE损失函数进行训练网络,然后用MSE损失函数对网络进行微调。MAE和MSE的计算如式(4)、式(5)所示。

(4)

(5)

式中:N表示训练样本的数量;xi表示第i个样本的实际值;xk为第i个样本的预估值。

2 实验分析

为了验证本文算法的有效性,在NWPU-RESISC45和UC Merced 2个遥感数据集上,对模型结构进行了消融实验,并将本文算法(multi fusion convolution network,MFCN)与Bicubic、SRCNN、FSRCNN、VDSR、DRRN、SymRCN 6种算法[19]进行比较。采用峰值信噪比(peak signal to noise ratio,PSNR)与结构相似度(structural similarity index,SSIM)[20]来衡量图像重建质量,其定义如式(6)、式(7)所示。

(6)

(7)

式中:Y和Y*表示原始高分辨率图像和重建图像;M和N表示图像的尺寸;μY和μY*分别表示原始图像的和重建图像的平均灰度值;σY和σY*分别代表原图与重建图像的方差;σYY*代表原图与重建图像的协方差;C1、C2代表常数。PSNR和SSIM的值越大表示重建图像效果越好,与原始图像更加接近。

实验测试的硬件环境为搭载Intel(R) Xeon(R) CPU E5-1650 v4@3.6 GHz×12处理器,配置Tesla K20c GPU,内存为64 GB的计算机,软件环境为Linux操作系统、Matlab R2016a软件、caffe深度学习框架、CUDA Tookit 8.0开发包。

实验中将带泄漏线性整流函数的斜率设为0.05,对于网络的初始化,采用文献[21]所使用的方式,并且用Adam算法对模型优化。最小批量大小和权重衰减分别设置为64和10-4,网络学习率设置为10-4,并且在迭代2×105后降低为10-5。

2.1 数据集设置

本实验使用的训练数据集包含了700幅遥感图像,其中100幅图像来自文献[22]的NWPU-RESISC45数据集,另外600幅图像来自文献[23]的UC Merced数据集,并且从上述数据集中另外挑选了100幅遥感图像用于实验测试。为了实现学习样本的多样性,本文算法对训练数据集中的图像进行了数据扩充,得到了28 000幅训练图像。由于人眼的视觉对亮度的感受较为敏锐[24],而且在Y通道上进行映射并不影响重建的水平[9],因此实验仅在Y通道上做训练,在其他通道上只是使用插值放大操作,这样在减轻计算量的同时也确保了图像重建的质量[25]。

使用双三次插值法以因子m(m=2,3,4)倍对原始高分辨率图像进行下采样,从而生成了相应的低分辨率图像,然后将获得的低分辨率图像裁剪成h×h大小的子图像,以相同的方法将原始高分辨率图像裁剪成mh×mh的子图像。由于当采样因子变大时,裁剪过大的子图像无法获得足够的图像信息,所以为了充分利用图像中的信息,根据m(m=2,3,4)倍采样大小,将低分辨率图像和高分辨率图像分别裁剪为352/702,252/752,192/762。

2.2 消融实验及分析

如图3所示,针对不同路径连接的模型进行了对比实验。图3中,结构a中仅采用了单一的短路径和长路径连接;结构b在结构a模型上,多增加了中路径的特征信息;结构c模型在结构b模型的基础上,把输入的信息也融合到了网络中,充分利用了不同卷积层的特征。

表1 在NWPU-RESISC45数据集上3种结构的特征融合模型的PSNR和SSIM对比

图3 路径模块的局部图

在NWPU-RESISC45数据集上对3种结构模型进行不同采样因子的重建实验,PSNR和SSIM平均值如表1所示。可以看出,结构c模型的PSNR值和SSIM值的平均值高于结构a和结构b,分别提高0.08 dB和0.03 dB,表明多路径特征融合模块提取了更多的特征,提高了模型的重建性能。

2.3 本文算法和经典算法的对比分析

为进一步验证本文算法,将本文算法与Bicubic、SRCNN、FSRCNN、VDSR、DRRN、SymRCN算法进行比较。表2给出了各算法在NWPU-RESISC45和UC Merced数据集上的PSNR和SSIM平均值。可以看出,双三次插值算法的PSNR和SSIM平均值最低。SRCNN和FSRCNN作为早期的超分辨率重建算法,虽然算法性能有一定的提高,但重建的图像效果仍然欠佳。本文算法相较于VDSR、DRRN、SymRCN算法在PSNR平均值上分别提升了0.57 dB、0.42 dB和0.14 dB,在SSIM平均值上分别提高了0.032 7、0.021 3和0.002 2。该实验进一步证明了本文算法引入的MPF模块,充分利用了不同网络层的特征,在评价指标上相较其他算法均有不同程度的提升。

表2 在NWPU-RESISC45和UC Merced数据集上不同超分算法的平均PSNR和SSIM

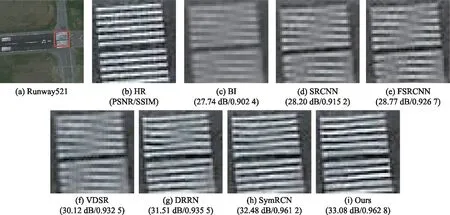

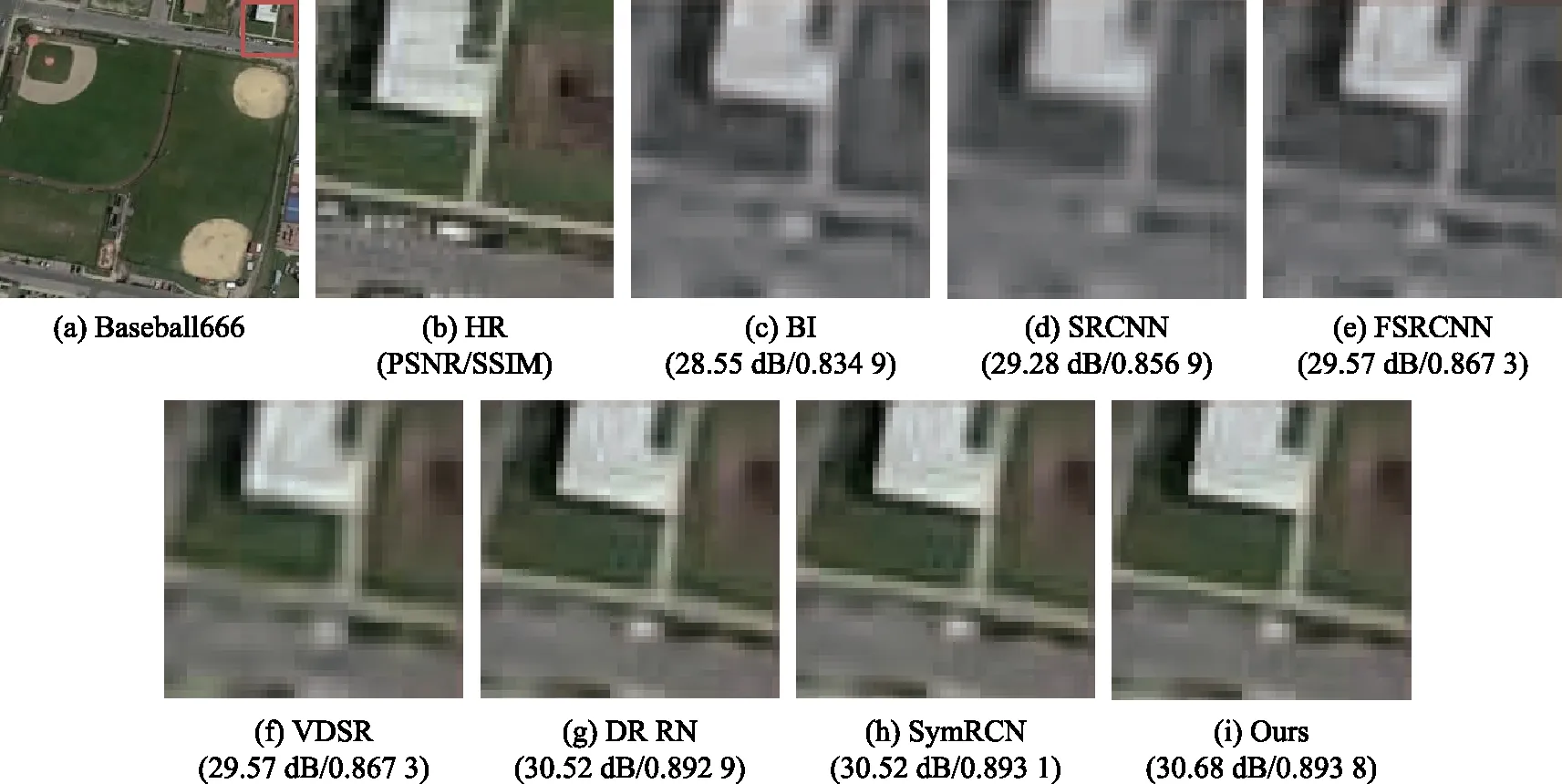

图4为采样2倍情况下,NWPU-RESISC45数据集中Runway521图像的各算法重建图像。图5为采样2倍情况下,UC Merced数据集中Denseresident91图像的各算法重建图像。图6为采样3倍情况下,NWPU-RESISC45数据集中Baseball666图像的各算法重建图像。图7为采样4倍情况下,UC Merced数据集中Airplane94图像的各算法重建图像。

图4 NWPU-RESISC45中的Runway521采样2倍的重建对比图

图5 UC Merced中的Denseresident91采样2倍的重建对比图

图6 NWPU-RESISC45中的Baseball666采样3倍的重建对比图

图7 UC Merced中的Airplane94采样4倍的重建对比图

从图4至图6可以看出,Bicubic算法所重建的图像较为模糊且信息丢失严重,重建的效果较差。SRCNN、FSRCNN、VDSR、DRRN和SymRCN算法虽然相较于Bicubic算法有了明显的改善,但在细节方面仍然存在相应的丢失,并且存在一些噪声,影响主观效果。而本文算法所重建的图像细节信息更加丰富,且没有明显的噪声,和原图更为接近。图7中,本文算法所重建的图像虽在评价指标上略低于SymRCN算法,但对生成的图像细节控制较好,视觉效果更好。

表3给出了不同算法在NWPU-RESISC45和UC Merced数据集上的平均测试时间。从表3可以看出,SRCNN算法和DRRN算法在平均时间上明显高于其他算法,FSRCNN算法和VDSR算法在平均时间上有所进步。MFCN算法对比其他算法在平均时间上相对较少,虽然MFCN算法的平均时间略高于SymRCN算法,但在视觉效果上表现更好。

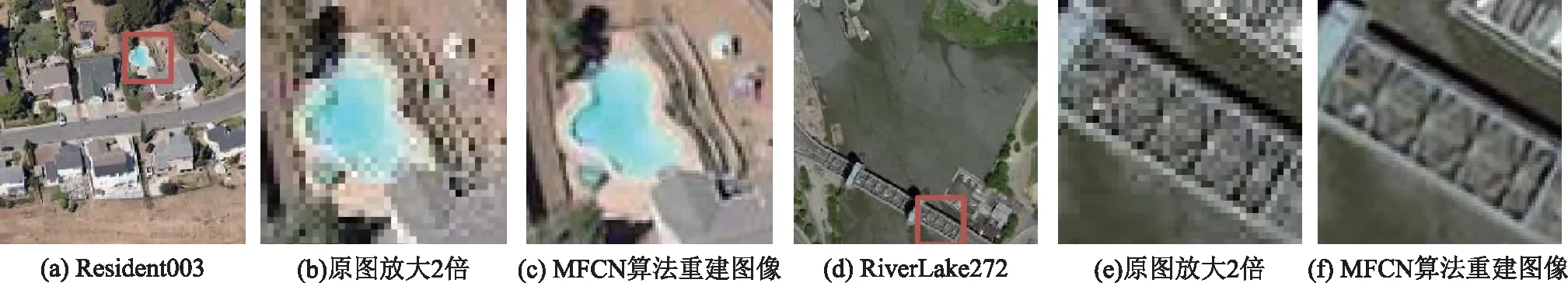

2.3 真实遥感数据对比实验

为了进一步验证MFCN算法的鲁棒性,本文对真实遥感图像数据集RSSCN7中4张分辨率较低的遥感图像进行了不同倍数的重建。为清晰对比MFCN算法重建后的图像与原始模糊的遥感图像的纹理细节,本文将原始模糊的遥感图像放大,与重建后的图像尺寸大小一致,重建结果如图8至图9所示。

由图8可以看出,放大2模型重建的图像细节信息丰富,边缘清晰,视觉效果较好。图9中放大3模型重建的图像边缘明显,但丢失一些细节,重建效果一般。图9中的放大4模型重建的图像边缘较为平滑,细节信息不足,重建效果不理想。由此可知,MFCN算法可以有效重建复杂的真实遥感图像,但对待图像的高倍数重建,其效果有待加强。

图8 RSSCN7中Resident003和RiverLake272实验对比图

图9 RSSCN7中Industry224和RiverLake118实验对比图

表3 在NWPU-RESISC45和UC Merced数据集上不同超分算法的平均测试时间 s

3 结束语

本文提出一种基于多路径特征融合网络的遥感图像超分辨率重建算法,通过引入MPF模块,充分提取和深度融合了不同卷积层的特征,有效弥补了由于网络加深造成丢失细节信息的问题;同时减少了卷积层的通道数以及模型的层数,提高了重建效率。

在NWPU-RESISC45和UC Merced数据集上的实验结果表明,本文算法的评价指标相较于比较算法均有提高,并且本文算法的重建图像细节信息丰富,视觉效果较好。在后续的工作中,该算法在客观评价指标上仍有提升空间,将考虑如何减少伪影和更加充分的恢复图像的纹理,从而进一步提高图像的重建质量。