基于视觉的AUV自主水下管线跟踪方法

2021-05-09王昊颜承昊任俊丽邵思扬

王昊 颜承昊 任俊丽 邵思扬

摘 要:对海下管线的检测是保证其正常运行的必要环节。文章针对海下管道巡检问题,提出一种结合状态表示学习和深度强化学习的方法,使水下机器人能够基于图像进行管线跟踪。利用无监督表征学习方法提取海底管线图像特征,结合任务情况设计了动作、状态空间和奖励函数,通过SAC算法学习一个稳健的跟踪控制策略。最后搭建仿真环境进行试验,证明了所提出方法的有效性和泛化性。

关键词:AUV;海底管线跟踪;状态表示学习;深度强化学习

中图分类号:TP242 文献标识码:A文章编号:2096-4706(2021)20-0016-05

Vision-based AUV Autonomous Underwater Pipeline Tracking Method

WANG Hao, YAN Chenghao, REN Junli, SHAO Siyang

(School of Information Engineering, Dalian Ocean University, Dalian 116023, China)

Abstract: The detection of subsea pipelines is a necessary link to ensure its normal operation. For the subsea pipeline inspection problem, this paper proposes a method combining state representation learning and deep reinforcement learning, so that the underwater robot can track the pipeline based on image. The unsupervised representation learning method is used to extract the image features of submarine pipelines. Combined with the task situation, the action, state space and reward function are designed. A robust tracking control strategy is learned through SAC algorithm. Finally, a simulation environment is built to test the effectiveness and generalization of the proposed method.

Keywords: AUV; subsea pipeline tracking; state representation learning; deep reinforcement learning

0 引 言

海底管道、线缆是各国之间实现石油、天然气等资源运输的重要手段。作为海底基础设施,海底管线在国际信息传输、海上资源开发、海岛开发等领域发挥着重要作用。海底管线一般距离长,影响范围大[1]。近年来,随着海洋资源的不断开发和海底管线的持续建设,海底管线的数量和安装深度也在不断增加[2]。海底管线长期运行于复杂的海底环境中,受海水冲刷、压力等因素影响,容易形成疲劳损伤导致破裂、泄露[3-5],海底管线的稳定性极大地保证了其在整个运营周期内的安全和经济效益。因此,定期对海底管线进行监测和检查是一个必不可少的环节,而监测过程中的层层障碍使其成为一项极具挑战性的任务。

当前,我国海底管线主要铺设于水下200~300米这一区间,导致一般的人工潜水检测无法实现[6],通常采用遥控水下机器人(Remote Operated Vehicle, ROV)和自主水下机器人(Autonomous Underwater Vehicle, AUV)进行作业[7-9]。ROV通过脐带缆进行通信实现控制和数据传输,AUV无须线缆即可通信,因此ROV在一定程度上受线缆长度和操作员经验水平的限制,而AUV可自主跟踪检测管线。考虑到实际应用中深海中的环境复杂,AUV的精确动力学模型很难获得,因此AUV的定位和导航是公认的难题,如何利用有限的感知数据信息实现管线跟踪是研究的重点和难点。深度强化学习(Deep Reinforcement Learning, DRL)是深度学习(Deep Learning, DL)和强化学习(Reinforcement Learning, RL)的结合,深度强化学习作为当前先进的人工智能技术已广泛应用于机器人的控制任务中[10,12]。相较于传统的基于模型的方法,深度强化学习方法因其与环境交互进行自主学习的特性,无须建立精确的动力学模型。此外状态表示学习(State Representation Learning, SRL)作为学习高维数據特征的有效方法,其与深度强化学习的结合改善了无模型强化学习低采样效率的缺陷[13],使得深度强化学习的方法能够灵活应对海下环境复杂、充满未知变数的管线自主跟踪任务。

综上,本文采用状态表示学习和深度强化学习相结合的SRL-DRL方法,使用AUV搭载的摄像头所拍摄的图像作为状态感知数据,通过变分自编码器(Variational Auto-Encoder, VAE)将高维、连续的像素状态观测编码压缩成低维矢量,有效减少计算量,最终利用强化学习算法学习低维状态矢量和动作之间的映射,实现管线自主跟踪控制。最后通过两个实验案例验证所使用方法的有效性和泛化性,实验结果表明,所使用方法所需的传感器少、效率高、成本低、适应性强。

1 AUV管线跟踪方法

1.1 状态表示学习和深度强化学习

深度强化学习是深度学习与强化学习的结合,深度强化学习无须像监督学习一样事先对训练数据进行标记,而是通过让智能体与复杂、未知的环境进行交互,并引入奖励信号不断纠正引导智能体从环境中学习最佳策略,深度强化学习的最终目标是使累计奖励最大化。强化学习基本模型如图1所示。

近年来,深度强化学习已经在诸多领域取得了令人瞩目的成就。DQN(Deep Q Network)算法第一次将卷积神经网络与强化学习算法Q-learning相结合,并在诸多Atari游戏中达到了与人类相当的水平。但其只适用于离散的动作空间,而现实的机器人控制中大多采用连续的动作空间。

状态表示学习是特征学习的一个特殊案例,状态表示学习的目标是将观测数据转化为压缩的状态向量,其中包含最具代表性的特征组,让压缩的状态可以满足有效的策略学习。例如,水下机器人传感器(如相机)提供了高维的数据,而机器人的状态(如方向、角度、距离等)可能包含在一个更低维的空间中。这种低维状态剔除了原始高维数据的不相关特征,能够极大地提高机器人完成任务的效率,这对于真实环境中的机器人实验是至关重要的。

1.2 Soft Actor-Critic算法

SAC(Soft Actor-Critic)[14]算法是目前最先进的深度强化学习算法之一,且被广泛应用于機器人控制任务中。

SAC是一种基于最大熵无模型的离策略(off-policy)深度强化学习算法,解决了无模型深度强化学习中高样本复杂性和脆弱收敛性的问题。SAC算法基于最大熵强化学习框架,最大熵策略增强算法的探索性和鲁棒性。训练的目的不仅是使预期奖励最大化,也是使策略的熵最大化,从而使得策略在完成目标的同时保持尽可能大的随机性。SAC目标函数为:

其中,π为策略,H(π(·|st))为熵,α为温度系数,控制策略的随机程度以及熵在总奖励中的比例。主要目的是使策略随机化,分散动作概率分布,增强智能体的探索性。

本文使用VAE和SAC,将DRL和SRL结合起来,将高维的图像观测数据降维成包含关键特征的状态向量,然后通过将状态向量映射到动作,确保自主管线跟踪任务的实现。

1.3 状态空间

管线跟踪任务主要是控制AUV跟踪海底管线,并借助搭载的摄像机拍摄管道的状态。考虑到实际深海环境下一些常用于陆地定位导航的传感器受限,无法正常使用,AUV的精确位置亦无法获得。摄像机拍摄是用于获取状态信息的一种方便且廉价的方式,尤其是能够在复杂、非结构化的环境中获得机器人的基础状态。因此本文中只采用摄像头,并将其所拍摄的图像作为感知数据进行跟踪控制策略的学习。

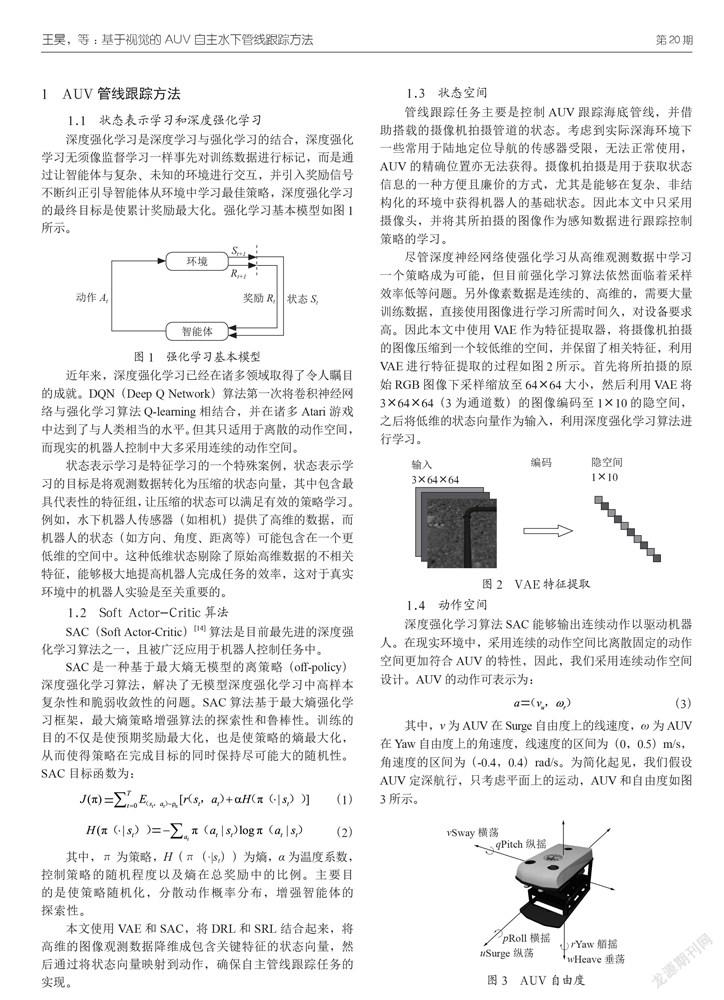

尽管深度神经网络使强化学习从高维观测数据中学习一个策略成为可能,但目前强化学习算法依然面临着采样效率低等问题。另外像素数据是连续的、高维的,需要大量训练数据,直接使用图像进行学习所需时间久,对设备要求高。因此本文中使用VAE作为特征提取器,将摄像机拍摄的图像压缩到一个较低维的空间,并保留了相关特征,利用VAE进行特征提取的过程如图2所示。首先将所拍摄的原始RGB图像下采样缩放至64×64大小,然后利用VAE将3×64×64(3为通道数)的图像编码至1×10的隐空间,之后将低维的状态向量作为输入,利用深度强化学习算法进行学习。

1.4 动作空间

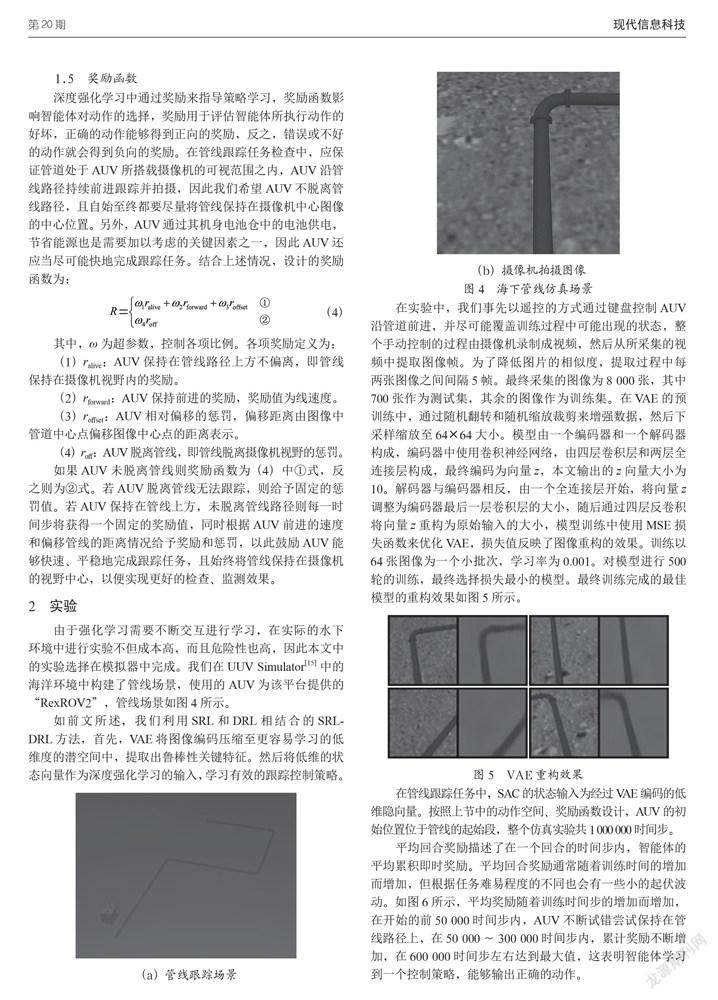

深度强化学习算法SAC能够输出连续动作以驱动机器人。在现实环境中,采用连续的动作空间比离散固定的动作空间更加符合AUV的特性,因此,我们采用连续动作空间设计。AUV的动作可表示为:

其中,v为AUV在Surge自由度上的线速度,ω为AUV在Yaw自由度上的角速度,线速度的区间为(0,0.5)m/s,角速度的区间为(-0.4,0.4)rad/s。为简化起见,我们假设AUV定深航行,只考虑平面上的运动,AUV和自由度如图3所示。

1.5 奖励函数

深度强化学习中通过奖励来指导策略学习,奖励函数影响智能体对动作的选择,奖励用于评估智能体所执行动作的好坏,正确的动作能够得到正向的奖励,反之,错误或不好的动作就会得到负向的奖励。在管线跟踪任务检查中,应保证管道处于AUV所搭载摄像机的可视范围之内,AUV沿管线路径持续前进跟踪并拍摄,因此我们希望AUV不脱离管线路径,且自始至终都要尽量将管线保持在摄像机中心图像的中心位置。另外,AUV通过其机身电池仓中的电池供电,节省能源也是需要加以考虑的关键因素之一,因此AUV还应当尽可能快地完成跟踪任务。结合上述情况,设计的奖励函数为:

2 实验

由于强化学习需要不断交互进行学习,在实际的水下环境中进行实验不但成本高,而且危险性也高,因此本文中的实验选择在模拟器中完成。我们在UUV Simulator[15]中的海洋环境中构建了管线场景,使用的AUV为该平台提供的“RexROV2”,管线场景如图4所示。

如前文所述,我们利用SRL和DRL相结合的SRL-DRL方法,首先,VAE将图像编码压缩至更容易学习的低维度的潜空间中,提取出鲁棒性关键特征。然后将低维的状态向量作为深度强化学习的输入,学习有效的跟踪控制策略。

在实验中,我们事先以遥控的方式通过键盘控制AUV沿管道前进,并尽可能覆盖训练过程中可能出现的状态,整个手动控制的过程由摄像机录制成视频,然后从所采集的视频中提取图像帧。为了降低图片的相似度,提取过程中每两张图像之间间隔5帧。最终采集的图像为8 000张,其中700张作为测试集,其余的图像作为训练集。在VAE的预训练中,通过随机翻转和随机缩放裁剪来增强数据,然后下采样缩放至64×64大小。模型由一个编码器和一个解码器构成,编码器中使用卷积神经网络,由四层卷积层和两层全连接层构成,最终编码为向量z,本文输出的z向量大小为10。解码器与编码器相反,由一个全连接层开始,将向量z调整为编码器最后一层卷积层的大小,随后通过四层反卷积将向量z重构为原始输入的大小,模型训练中使用MSE损失函数来优化VAE,损失值反映了图像重构的效果。训练以64张图像为一个小批次,学习率为0.001。对模型进行500轮的训练,最终选择损失最小的模型。最终训练完成的最佳模型的重构效果如图5所示。

在管线跟踪任务中,SAC的状态输入为经过VAE编码的低维隐向量。按照上节中的动作空间、奖励函数设计,AUV的初始位置位于管线的起始段,整个仿真实验共1 000 000时间步。

平均回合奖励描述了在一个回合的时间步内,智能体的平均累积即时奖励。平均回合奖励通常随着训练时间的增加而增加,但根据任务难易程度的不同也会有一些小的起伏波动。如图6所示,平均奖励随着训练时间步的增加而增加,在開始的前50 000时间步内,AUV不断试错尝试保持在管线路径上,在50 000~300 000时间步内,累计奖励不断增加,在600 000时间步左右达到最大值,这表明智能体学习到一个控制策略,能够输出正确的动作。

图7显示了训练过程中,平均回合长度随时间的变化曲线。回合长度为回合内AUV在不偏离管线路径的情况下累计航行的时间,反映了AUV在单回合内的航行长度。在前50 000步内,平均回合长度小于200,这一时期智能体的学习是随机的,而在300 000时间步的迭代后,回合长度不断增加,这和奖励值保持一致,表明AUV学习到有效的策略,能够在更长的时间内不偏离管线路径,保持跟踪拍摄。

为了验证训练所学策略的有效性和泛化性,设计了两个测试实验,两个实验场景中所使用的管线都不同于训练场景,其中一个场景中包含一个有6个不同角度拐角的管道,另一个为更细一些的弯曲线缆,测试场景如图8所示。

测试使用训练之后固定参数的模型,在两个测试案例中AUV均能够顺利且高效地完成管线跟踪任务。顺利体现在AUV能够全程跟踪覆盖管线而不偏离,高效体现在AUV总是能够以较为平滑和相对较短的路线完成跟踪任务。表明在训练环境中习得的控制策略能够完成管线跟踪任务,具有很好的泛化性。两个测试案例的AUV轨迹通过Rviz可视化软件绘制,如图9所示。

3 结 论

本文将状态表示学习与深度强化学习相结合,用于实现海下管线跟踪任务。结合实际情况设计了动作空间、状态空间和奖励函数,以确保AUV在跟踪拍摄过程中能够保持在管线上方,并且加速训练过程,减少不必要的运动,以减少能源消耗,获得更好的检查监测画面。与传统深度强化学习方法相比,本文结合使用的自监督状态表征学习方法只使用了少量的样本进行训练,VAE的预处理提高了样本效率,促使深度强化学习算法以更少的样本、更快的速度学习。同时该方法对于设备性能的要求较低,能够应对真实场景下AUV算力较低、能源有限的条件限制。最后搭建仿真环境进行仿真试验,最终验证了所使用方法的有效性和泛化性。

参考文献:

[1] 黄潘阳,来向华,胡涛骏,等.海底电缆管道廊道规划初步构想 [J].海洋开发与管理,2020,37(3):8-11.

[2] ZHAO X H,WANG X,Du Z S. Research on Detection Method for the Leakage of Underwater Pipeline by YOLOv3 [C]//2020 IEEE International Conference on Mechatronics and Automation (ICMA).Beijing:IEEE,2020:637-642.

[3] 董绍华,段宇航,孙伟栋,等.中国海底管道完整性评价技术发展现状及展望 [J].油气储运,2020,39(12):1331-1336.

[4] 王文龙,熊指南.声学探测技术在海底石油管线铺设后调查中的应用 [J].海洋科学,2021,45(7):110-120.

[5] 丁安.声纳图像水下管线检测与跟踪技术研究 [D].镇江:江苏科技大学,2019.

[6] 陈浩.水下巡线机器人管线识别与运动控制算法研究 [D].青岛:中国石油大学(华东),2018.

[7] 韩银锋.基于机器视觉的ROV水下管线自动跟踪方法 [J].计算机测量与控制,2015,23(2):539-541.

[8] 黄子明,贺继林.面向水下管网的视觉检测系统研究 [J].电子测量与仪器学报,2021,35(6):79-87.

[9] 黄明泉.水下机器人ROV在海底管线检测中的应用 [J].海洋地质前沿,2012,28(2):52-57.

[10] 闫皎洁,张锲石,胡希平.基于强化学习的路径规划技术综述 [J].计算机工程,2021,47(10):16-25.

[11] 李茹杨,彭慧民,李仁刚,等.强化学习算法与应用综述 [J].计算机系统应用,2020,29(12):13-25.

[12] 孙玉山,王力锋,吴菁,等.智能水下机器人路径规划方法综述 [J].舰船科学技术,2020,42(7):1-7.

[13] GUPTA A,KHWAJA A S,ANPALAGAN A,et al. Policy-Gradient and Actor-Critic Based State Representation Learning for Safe Driving of Autonomous Vehicles [J].Sensors,2020,20(21):5991.

[14] HAARNOJA T,ZHOU A,ABBEEL P,et al. Soft actor-critic: Off-policy maximum entropy deep reinforcement learning with a stochastic actor [C]//International conference on machine learning. Stockholm:PMLR,2018:1861-1870.

[15] MANH?ES M M M,SCHERER S A,VOSS M,et al. UUV simulator: A gazebo-based package for underwater intervention and multi-robot simulation [C]//OCEANS 2016 MTS/IEEE Monterey.Monterey:IEEE,2016:1-8.

作者简介:王昊(1996—),男,汉族,安徽桐城人,硕士研究生在读,研究方向:水下机器人、强化学习;

颜承昊(1998—),男,汉族,辽宁大连人,硕士研究生在读,研究方向:水下机器人、强化学习。

任俊丽(1996—),女,汉族,河南商丘人,硕士研究生在读,研究方向:计算机视觉;

邵思扬(1997-),女,汉族,辽宁本溪人,硕士研究生在读,研究方向:水下机器人、强化学习。