浅谈人工智能——人工智能时代的管制措施

2021-04-21王剑卢扬帆王袁鹏吴佳豪钟赛龙

◆王剑 卢扬帆 王袁鹏 吴佳豪 钟赛龙

浅谈人工智能——人工智能时代的管制措施

◆王剑 卢扬帆 王袁鹏 吴佳豪通讯作者钟赛龙通讯作者

(江西科技学院信息工程学院 江西 330000)

人工智能只有短短一百年不到的历史,历经半个多世纪的发展,已经渗透到各个领域,与我们的生活息息相关。本文简要回顾了人工智能的发展历程,罗列分析了近年来人工智能的应用及出现的忧患风险,并设想根据人工智能、项目管理等相关知识对此提出相应的管制措施。

人工智能;超级智能;人机交互;监管

人工智能在发展过程中,在不断与传统行业结合带来巨大变革的同时,各种负面事件也显露出来,大部分科学家认为还需数十年,才能达到人工智能的奇点。尽管如此,防患于未然仍是有必要的,但不管是DeepMind的“可中断”理念还是IBM的信任透明原则,抑或是亚马逊、谷歌、微软、IBM等几个硅谷人工智能巨头公司发起的人工智能联盟,都是企业在努力“规划”安全的人工智能未来,而民众、政府或者国际社会还没有在其中找准自己的定位以及所扮演的角色。

1 人工智能的发展历程

人工智能Artificial Intelligence英文缩写为AI,于1956年提出,源自雨果·德·加里斯的著作,字面意思就是人造的智能,“智能”一词在中国最早由荀子提出,意味智慧和能力的总称。如今,智能往往意味着一种运用知识本领在不同复杂环境下做出相应反应对策的能力,人的智能就体现在思考和理解反应的能力上。早在春秋战国,聪明的古人就开始了对人工智能的向往和追求,列子在《列子·汤问》中记载的一位名叫偃师的工匠制作了一个能歌善舞还会思考具有独立意识的人偶献给周穆王,而这样的故事层出不穷。

二十世纪初,数理逻辑和关于计算的新思想冲击着智能界,不管是人工智能之父图灵(Turing)在其基础上创立的自动机理论还是麦卡洛克(McCulloch)和皮茨(Pitts)提出的“拟脑机器”,都在人工智能的萌芽时期为人工智能奠定了坚实的基础。1956年被誉为机器学习之父的迈克尔·乔丹(Michael I. Jordan)在一次学会上正式提出了“人工智能(AI)”这一理念,而绝大多数参会的学者后来都成为了著名的人工智能专家,为以后的AI研究和发展做出了杰出贡献。其后不管是六七十年代引起新一轮热潮的“专家系统”还是八十年代霍普菲尔德(Hopfield)关于神经网络模型的正式提出,都加速了人工智能的发展。而二十一世纪的现在,随着人工智能三大学派——符号主义、连接主义、行为主义的诞生以及深度学习的引入和发展,人工智能将走向一条光明的康庄大道,古人的梦想也将在超越时代的科技帮助下得以实现。

2 人工智能时代的风险忧虑

然而,随着人工智能的飞速发展,一些缺陷和隐患也逐渐显现出来,人工智能将面临与未来法律制度结合的困境,大数据的隐私保护、风险问题、担保责任问题以及知识产权的归属都将使其进入两难境地,这将给社会制度产生一定的影响。去年的AI换脸软件“zao”刷爆了朋友圈,人们在换脸的同时殊不知不仅失去了自己的肖像权还将在未来面临可能发生的权益纷争,还有更早之前的AI软件Deep Nude,种种不合时宜的人工智能出现在我们的视野里恰好说明其监管体系尚未成熟。不光如此,一旦人工智能发展成熟,罪犯就可以开发出各种相关系统为其服务。一套完备的语音合成系统、人脸合成系统,这之间牵涉的种种都给人类敲响了警钟,人类还没有做好接纳人工智能的准备,也还没学会对待和使用人工智能。

事实上2016年微软推出的人工智能Tay就显现出人工智能更深层次的忧患,它作为一个聊天机器人在仅仅在不到一天的时间里就变成了一个种族歧视者,这充分说明AI是趋势工具,人可以创造AI却不能保证它的发展不出现一丝偏差。如今的一些人工智能靠着机器学习深度学习来提升自我水平,由于神经网络的布线和初始化的突触权重都是随机的,所以未经训练的神经网络的答案也是随机的[1]。这些人工智能通过各种函数框架模型和逻辑回归线性回归等算法从海量样本里进行特征的自动提取来建立神经网络,然而样本数据本身就反映人的主观意识,人工智能无法辨别这些数据对其本身的形成过程是否有害或者是否违背了其作为创造者的初衷。使用者或研究者也无法确保人工智能在形成过程中只学习他们认为对的事物,并在正确的认知下对这些事物做出正确的反应。事实上正确与否都只是人类自己的评判标准,所以小说以及影视作品中不乏人工智能通过种种契机形成灭绝人类才能创造完美世界的潜意识,不知未来创造者是否真的能通过代码程序将人工智能管控在阿西莫夫机器人三大条框之下。

现如今,人工智能逐步或者正在取代人类完成某些特定工作导致这些人员失业的现象似乎已经开始出现,牛津大学教授曾对超过700份的工作进行了分析,结果却发现几乎一半都能由现在或未来的计算机人工智能来完成,而其中不乏需要相当深度的知识及能力的高薪职业,换言之不管是低脑力还是高脑力的就业岗位,在可见的未来里都面临着被人工智能取代的危险。

然而更大的危险是,人类自身也即将面临被取代的窘境,随着技术理论的不断发展补足,凭借着不断更新的传输介质以及持续发展的计算力,人工智能正在不断逼近并将最终超越人类。人工智能设计之初是仿造人脑,通过像神经元一样的物质传输信息,人脑神经元之间传递信号的最快速度约为100米/秒,而铜线中电信号的传播速度大约为2.3*10^8米/秒,超过光速的一半,理论上如果有一个完全基于人脑的广义人工智能,那么它的运行处理速度就已经是人脑的200万倍[2]。

现如今的人工智能大多都只是某一领域内超越人类,不管是正式统治围棋界的AlphaGo还是进化后从零开始仅用三天就以100:0将其碾压的AlphaGo-Zero,它们都只能完成一个比较狭窄的目标,而通用人工智能的研究将会打破这一常理,进而触发“智能爆炸”。早在上世纪六十年代,英国数学家谷德(I.J.Good)就提出并预言了“智能爆炸”,当一个超级智能机器可以设计出比它更出色的机器,那么带来的将是“指数级”的“智能爆炸”。事实上五十年代,现代计算机之父冯诺依曼(John von Neumann)就曾说过,技术正以前所未有的速度增长,我们正在朝着某种类似奇点的方向发展,一旦超越了这个奇点,人类社会将会大不相同。而这个奇点就是“智能爆炸”。如果超级智能真的来临,那么届时它将以远超人想象的智能凌驾于人类这一种族之上,而后果尚未可知。人脑中大脑新皮层所占比例是黑猩猩的两倍,凭借着这份智力人类繁衍出70亿人口并根据自己的意愿改造地球,而黑猩猩只剩30万只,并且这个物种是否会灭绝几乎完全取决于人类的行为,超级智能将比人类聪明几个数量级,因此人类未来的命运,将会取决于超级智能的决策和行为[2]。

必须指出的是,想要人类放弃研究人工智能是不可能的,人工智能目前以及在可见的未来所带来的红利已经不是一两句禁令就能抵消的,况且目前人类已经依赖很多人工智能系统,简单粗暴的停止人工智能研究将导致人工智能无法应对未来多变的世界,但一直放任人工智能的发展将不利于未来社会的安定,因而想要确保人工智能的发展一直处于可控阶段,合理有效的管制措施非常必要。

3 管制措施

3.1 AI监管者

创造一个AI监管者,人类无法实时查看源代码,实时调控手上的人工智能程序,况且成本可能会是个天文数字。这个监管者类似断路器,代替人类作为人工智能活动的管理者,拥有判断和中断任何相关活动的权限。DeepMind作为前沿人工智能企业曾在2017年12月发布过一份研究报告,实现了监管者在中断人工智能后继续启用程序不影响之前的工作,已经证实这在理论和技术上是可行的。因而国际上应该借此尽快建立一套强大的人工智能监管系统,通过建立神经网络模型来实时监视被它管控的其他人工智能系统模型,当这些人工智能出现偏差或风险时及时报告并中断它们的活动,使其得到有效控制,如期望般发展。

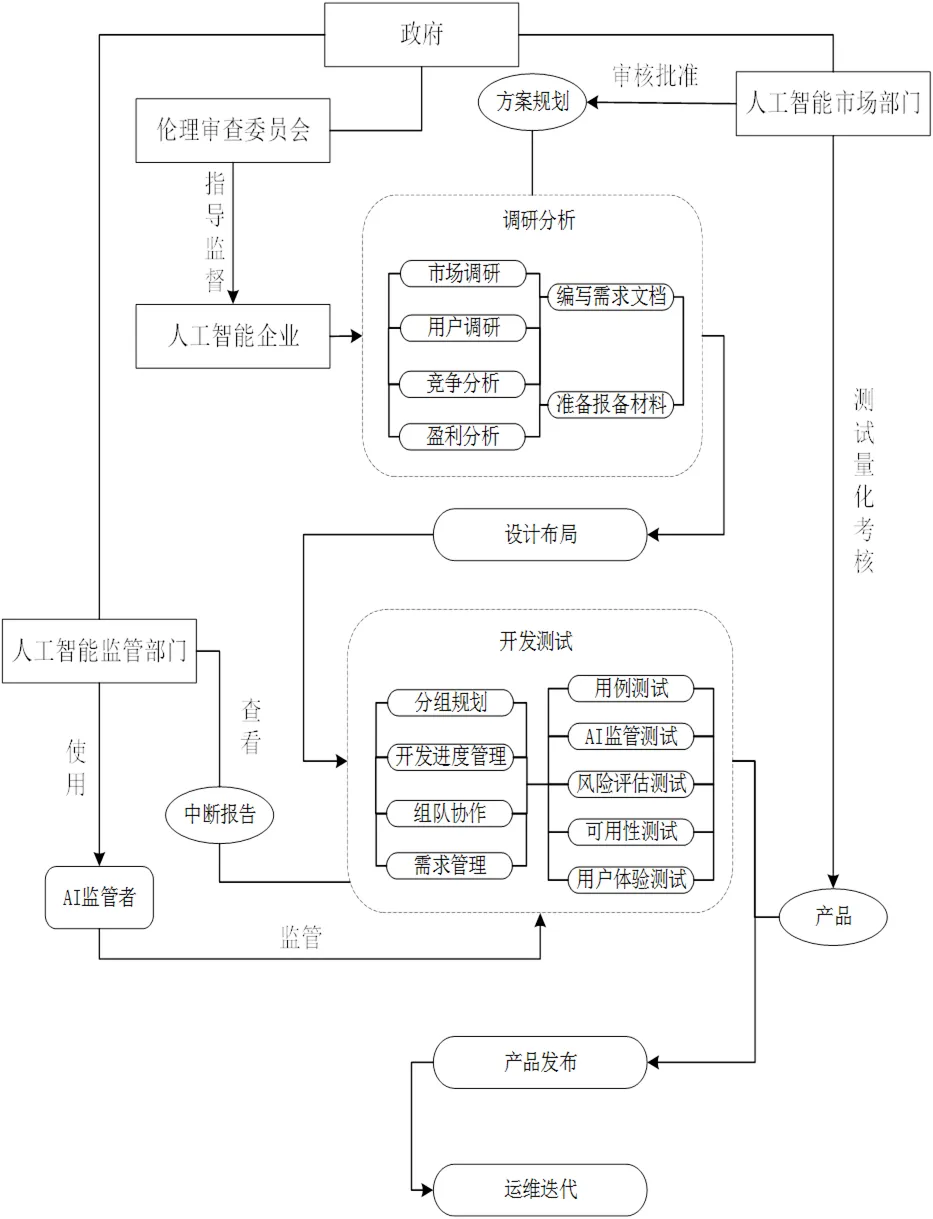

3.2 人为监管

提高人为监管力度,建立相关组织及监管部门,国际或政府应建立人工智能方面的监管部门,对企业人工智能源代码及对应表现进行定期监管,确保人工智能开发者在一个安全的环境内测试他们的设计并收集相关数据,定期查看AI监管者中断报告来判断项目风险等级。使用注意机制,专门设计神经网络模型来复制和跟踪其他人工智能模型的轨迹,便于监管机构能够做出更加明智的审核决策,同时建立伦理审查委员会,对人工智能进行系统的安全和伦理评估。建立人工智能市场部门,对测试和量化方案进行制度化,保证人工智能按照既定的计算机算法运行,所有企业在研发使用之前都应备案批准,每年定期对相关企业进行核检,同时在企业对应产品即将进入社会前进行详尽的测试以及评估,规范审批流程,建立完善人工智能政府监督体系,确保人工智能从开发到投入使用每个环节都做到可控可追溯问责。

3.3 政府投入

加大人工智能领域相关资源投入。如今世界各国高度重视人工智能的发展,美国将其上升到国家战略层面并视为二十一世纪的阿波罗登月计划,我国也在2017年正式印发《新一代人工智能发展规划》,但我国目前还是强调技术与应用,对人力资源、教育、标准、数据环境方面还是不够重视。政府应该加大投入,构建利于研究的环境基础,制定人工智能相关人才的教育和培训计划,同时确定知识产权的归属,积极推动有关措施的落实,培养并管理一大批未来的人工智能领域基础层人才及高端研发人才,从源头上规范人工智能的开发。

3.4 行业规标

制定完善相关行业规范标准和指导方针,人工智能界应该确定相关共识,当人工智能出现进化的趋势或者给出相关的警告时,各国相应的研究应该放缓。同时国际人工智能联合会议应制定相关准则,建立行业规范标准,同时为人工智能研发和审查人员制定伦理守则,发布伦理标准,不断更新和完善阿西洛马人工智能原则,呼吁督促全世界在研发人工智能的同时恪守这些原则。同时还应该限制人工智能的运用,避免人工智能的滥用,规定企业及个人相关的权限许可限制,与其他国际组织如公共交通国际联会、国际劳工组织等展开相关合作,共同制定最高准则,避免各国各企业研究院研发的人工智能与传统行业无限制的结合发展。

图1 人工智能政府治理监管体系粗略模型

3.5 司法体系

制定完善相关法律制度,形成人工智能法律体系,现如今人类和人工智能之间复杂的关系、未来可能会打响的法律战以及政策与伦理问题正接踵而来,人工智能对当前的伦理道德标准、法律制度、社会秩序和意识形态差异提出了不可避免的挑战,必须用科学的方法处理人工智能所产生的问题,将人工智能限制在法律道德层面,以确保人工智能的规范化发展。国家应该积极出台相关法律,规定人工智能事故的相关判断标准及运用人工智能犯罪的相关处罚条例。建立责任担保归属制度和安全责任体系,规定企业必须提供相关安全信息,建立详细的问责条例,同时人们必须积极了解,学会正确看待和对待人工智能,积极运用法律来面对未来可能发生的纠纷,并且知法守法。

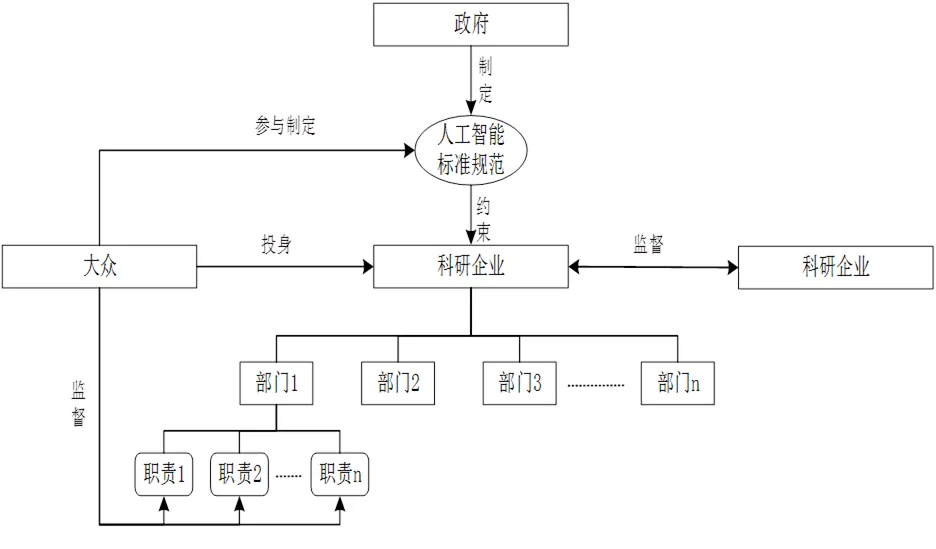

图2 人工智能社会治理监督体系模型

3.6 各司其职

面对即将到来的人工智能时代,不管是国际政府、市场还是普罗大众都应该在其中找准自己的定位、各司其职。作为社会稳定的必要因素,政府应该牢牢把控人工智能的发展方向,确立一系列的标准和规范来保证社会的稳定和安全。而作为研发人工智能的科技企业,应该主动承担相应的社会责任,自我监督,恪守政府的相关规定和原则,同行之间形成监督,并按照伦理道德的标准进行自我约束。最后,作为社会的基层,普罗大众应该做好监督人,积极参与规则的制定与协商,积极投身于人工智能的研发及监管,最终形成人工智能自上而下多角度多主体的治理监督体系。

4 结语

纵观历史,每个时代都会有新技术新事物的产生和发展,石器时代、火药时代、蒸汽时代、电气时代等等,还有如今的信息时代包括未来的人工智能时代,每项技术变革都会经历一个甚至多个时代的研究发展和管控。事实上美国人工智能协会已经开始评估关于“人类失去对计算机智能的掌控”的可能性,人工智能作为一个不算新颖的新鲜事物,逐步的“管控”确实应当提上日程。但人类不必因此过于担心。1950年图灵发表了一篇论文提出了图灵测试预言到2000年将有足够聪明的机器通过该测试,但直到2014年才有一台英国的超级计算机机缘巧合之下通过了,而这比图灵预测的足足晚了14年,可见对于一日千里的计算机技术,人工智能的发展并没有像预期的那样取得突飞猛进的效果[3],事实上人工智能只是一种形式化的方法,它是在严格遵守某种规则下的“思维”,固然其执行的速度比人类智能的速度更快,但是人类思维是多样化的,有形象思维、直觉思维、创造性思维等非逻辑思维方法,这些都是目前人工智能所不及的,也许在可见的未来,人工智能真的可能发展到这一步,但人类非常善于制定与时俱进的规则,他们通过错综复杂的法律规则和不成文的道德规范建立起了这个有着七十亿庞大人口的社会,尽管这个社会里依然存在着冲突和反抗,但不可否认这个社会体系正如日中天的发展进化着,我们拥有着远超任何时代的科技和成就,而在不久的未来,我们有理由相信通过建立不断更新的规则来约束将带来划时代革命的人工智能,能使其像蒸汽电力甚至核能一样可控地给人类社会提供巨大的助力,去迎接下个时代的辉煌。

[1]Ray Kurzweil.The Singularity Is Near:When Humans Transcend Biology [M].李庆陈,董振华.北京:机械工业出版社,2016:162

[2]Calum Chace.Surviving AI:The promise and peril of artificial intelligence[M].张尧然.北京:机械工业出版社,2017:112-114

[3]周志敏,纪爱华.人工智能:改变未来的颠覆性技术[M].北京:人民邮电出版社,2017:37