论人工智能在法律判断领域的应用

2021-03-13王亦伟

王亦伟

(北京韬安律师事务所,北京 100123)

伴随第三次人工智能革命的到来,人工智能在自动驾驶、图像识别、智能家居、机器翻译、医疗服务、电子竞技等领域的应用随处可见,有关人工智能的话题不断涌现。2017年以来,法学领域有关人工智能的讨论越发活跃。在此背景下,人工智能在法律判断领域的应用以及基于此技术在法院判决中实践的假想制度也不时成为讨论对象。

事实上,有关人工智能的研究很早就涉及法律判断这一应用领域。早在1970年,Buchanan等[1]便发表了《关于人工智能和法律推理若干问题的考察》一文。在20世纪,以人工智能在法律领域应用为主题召开的国际会议,有ICAIL(International Conference on Artificial Intelligence and Law)和JAC(Jurix Annual Conference)[2]。人工智能主题研究大都基于人工智能发展的第一次热潮(20世纪50年代到60年代)、第二次热潮(20世纪80年代到90年代)和第三次热潮(2006年至今)展开。有关人工智能在法律判断领域的应用研究在第二次热潮期兴盛起来。这一时期,备受世界瞩目的人工智能技术是关于“知识表示学习(Knowledge Representation Learning)”的技术,其与现今第三次热潮中广为人知的“机器学习(Machine Learning)”完全不同。探讨人工智能在法律判断领域的应用时,不仅需要着眼于现时流行的机器学习,而且需要关注那些所谓“过时”的基于“知识表示”的推理技术。只有梳理多方面的研究,才能把握人工智能技术发展与变迁的实质。因此,笔者拟整理各国以法律判断为对象的人工智能应用研究的历史和现状,并在此基础上提出法学领域在接受这些研究时可以采取的基本立场。

一、传统的尝试:知识表示学习

(一)知识表示学习和机器学习的区别

所谓知识表示学习模型,是指将“知识”符号化后输入计算机系统,而后由推理系统从“知识”中导出有意义的信息,最终由判断系统基于前述信息作出一定的决策智能行动[3]。在此,“知识”是指可由推理系统方便处理的、具备特定形式的数据,与机器学习中使用的单纯数据完全不同。如前所述,知识表示学习模型是在第二次热潮中流行的研究主题,但事实上至少在法律判断领域,目前依旧有关于此主题的研究。依据使用的知识种类,法律判断的知识表示学习模型大致可以分为规则基础型和判例基础型两种类型[4],笔者将结合研究实例阐述这两种模型。

(二)规则基础型系统

规则基础型系统是以执行演绎推理的知识表示学习系统为基础的系统,使用的是具有“如果……,那么……”这类形式的“知识(规则型知识)”,通过将输入的信息与这些规则型知识相匹配导出结论(进行判断)。也可以将这种形式的系统视为第一次热潮时已获成功的“自动定理证明系统(关于一定范围的数学定理,自动构成对其的证明的系统)”的衍生系统来捕捉其意义。

基于这种“规则型知识”进行法律判断,似乎是件极其自然的事情。因为法律规范一般具有“如果满足‘某项法律构成要件’,则发生‘某种法律效果’”这样的典型结构,系统便是基于制定法的规则型知识,依据上述逻辑对法律问题给予回答的推理结构。

伦敦帝国学院Sergot等开发的一个系统,将1980年《英国国籍法》(BritishNationalityAct1980)的各项条文作为命题,将其程序化后可对有关《英国国籍法》的多种问题给出答复[5],这是制定法判断系统研究方面的一个典型实例。Sergot等在该系统中采用了逻辑编程语言Prolog(Programming in logic)。

Prolog是将程序作为Horn子句逻辑的集合来表现的编程语言。命题的集合一般被称为理论(theory),Prolog是将程序理解为一种理论,作为从中证明命题的尝试来表示程序执行的语言。总而言之,如果《英国国籍法》的各项条文可以通过Prolog来表达,Prolog就可以在此基础上对有关《英国国籍法》的问题,以该问题项目是否可以从《英国国籍法》“证明”的形式给出回答。笔者将针对《英国国籍法》具体条文,以“如果A就B”的形式简单地呈现Prolog的表现形式(如表1所示),与标准的Prolog程序相比,下述内容较为简略。

表1 Prolog对《英国国籍法》的表现形式

上述第二项规则中包含了 “只要不能证明在英国境外出生,便视为在英国境内出生”的含义,由此不仅引入了逻辑非(logical negation),还导入了失败即否定(negation as failure)的表现形式。分别使用这两种否定形式,可以很容易地呈现法条的结构。该研究的一大特征是将制定法的逻辑分析直接作为人工智能来开发。从20世纪50年代开始,制定法逻辑分析的主要目的是对去除制定法的句法歧义(syntactical ambiguity)的尝试[6]。

在亚洲,日本国立信息科学研究所的计算机专家佐藤健等尝试开发了根据要件事实理论进行法律判断的PROLEG[7]。PROLEG是作为前述Prolog的扩展语言所构建的程序语言,采用的是“如果是‘要件事实’,则得出‘效果’并且追加了‘原则/例外’”这样的双重结构,以此记述要件事实理论。PROLEG可以根据以此方式表达的规则型知识和关于当事人的主张和证明的信息(事实基础)来引导该案件中的判决(接受/驳回当事人的诉讼请求)。

与Sergot等的研究不同,佐藤健等研究的特殊点在于将审判这一实际法律适用场景中含有的证明责任规范的要件事实理论作为对象。值得一提的是,PROLEG过去始终专注于民事诉讼方面的定义,但近年来也尝试向刑事诉讼扩展[8]。

(三)判例基础型系统

基于判例数据的法律判断系统是以执行类推的知识表示学习系统为基础,使用过去的类似判例知识,在“类案类判”的大原则前提之下,通过借用类似判例的结论来进行判断。这里所关注的是根据过去的判例知识,以及以过去判例的类似性为理由(或以非类似性为理由)导出与该判例相同的结论(或导出相反的结论)。

此类研究的一个实例:美国匹兹堡大学计算机专家Ashley开发了一种系统——HYPO,该系统以美国《商业秘密保护法案》(TradeSecretLaw)为材料,模拟各方当事人之间的主张与答辩。HYPO是使用因次(dimension)展现的判例知识来进行类推的结构。这里所说的因次,简而言之是构成案件的各个要素,表现了有关在认定构成商业秘密的判例中的某些特定事实(例如,对该秘密采取了一定的保密措施等)。各个判例中的每个因次都存在一个连续值,表明它在多大程度上可以成立,由此构成该判例的一个总特征值。如果将判例知识同样以因次这种表现形式输入,HYPO便会开始检索过去的类似判例,利用这样的知识构建当事人可能作出的主张,并对此进行模拟。HYPO还有几个后续系统,比如由Alevan等开发的CATO就是其中之一[9]。

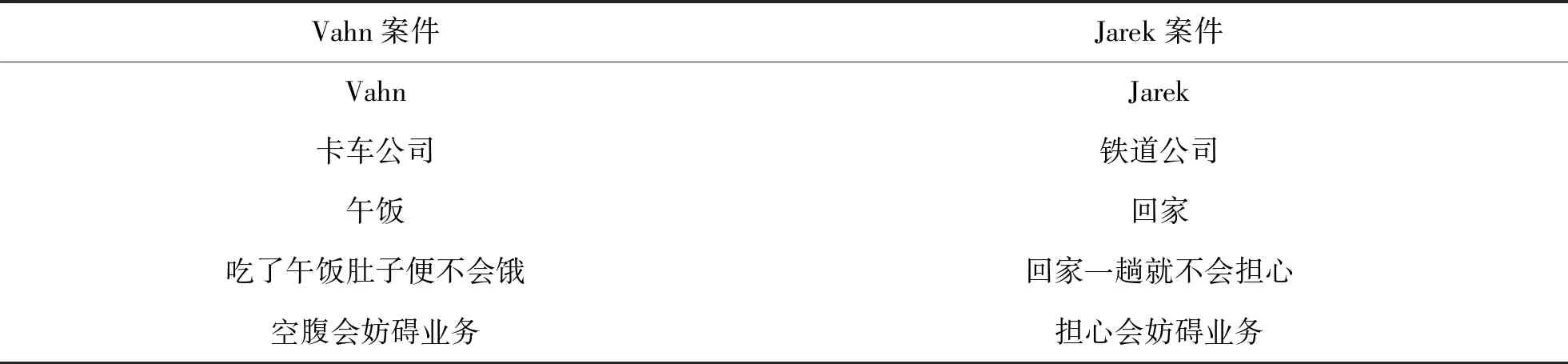

同样,美国德克萨斯大学的Branting博士则开发了一个以工伤事故判例为研究对象的系统——Grebe[10]。其中一个工伤判例的描述为:在卡车公司工作的Vahn被允许在运输过程中去吃午饭,但在去餐馆的路上发生了事故。针对前往餐厅的行为是否为工作中的行为双方有所争议,法院着眼于以下事实认定其为工作中的行为:(1)Vahn是卡车公司的员工;(2)公司认可可以吃午饭;(3)Vahn吃了午饭;(4)吃了午饭就不会饿;(5)不吃午饭饿了会妨碍正常工作;(6)Vahn在去餐厅吃午饭的过程中受伤。假设这里发生了新的案件(Jarek案),该案中铁路公司的Jarek收到需夜间工作的紧急命令,因为离家很近,他被允许去告知妻子这件事,在归宅途中受了伤。同样将该事件拆分为各种要素,并与上述Vahn事件的判例规则的条件进行类似判断,如果认定的要素相似度较高,则判断Jarek的行为同属于工作中的行为。Grebe对工伤判断的表现形式如表2所示。

表2 Grebe对工伤判断的表现形式

在亚洲,日本东京工业大学的计算机专家新田克己等研究开发了HELIC-Ⅱ系统,该系统是依据日本法律和日本判例对各方之间的主张与答辩进行模拟[11]。但与HYPO不同,HELIC-Ⅱ是一种混合型系统,其还是一种使用制定法相关知识的规则基础型推理系统,当事人的主张基本上由该规则基础型推理系统构建,判例推理系统则是在前述规则推理不能充分发挥作用的情况下才会被使用。也就是说,规则知识常常包含“抽象的概念”,在与案件相关的具体记述之间可能会产生隔阂,因此,使用判例推理来对规则推理进行补充。

在HELIC-Ⅱ系统中,判例分为“状况记述”和“判例规则”两种表现形式。大体上可以认为前者是对客观事实的一种认定,后者则是判例固有的一些规则(法律解释和经验规则等)。HELIC-Ⅱ原本便是基于该“判例规则”构建的语义网络,计算判例之间的类似性,并据此在制定法相关知识和具体判例的记述之间架起桥梁的结构。HELIC-Ⅱ也有几个后续项目,例如,搭载了语音识别技术等进行诉讼模拟的系统MrBengo就是其中之一[12]。

(四)小结

由以上研究可以看出,知识表示学习模型极其朴素,但是,其至少与对法律判断的直率理解相辅相成。例如,法律判断有演绎推理和类推推理两种类型,前者对应制定法知识,后者对应判例知识,二者很容易相互结合。另外,在本文介绍的范围内,规则基础型系统都是实现“推理”的系统;与此相对,判例基础型系统则只是对案情讨论的模拟。这是因为,相比基于类推推理的判例基础型系统,基于演绎推理的规则基础型系统更容易导出唯一的结论。此外,由上面介绍的HELIC-Ⅱ是混合结构的系统也可以看出,规则基础型系统和判例基础型系统不是二选一的关系,而是可以根据适合的情形任意分开或组合使用。例如,在第二次热潮期开发的“法律专家系统”也和HELIC-Ⅱ一样,以基于制定法的规则基础型系统为基础,并用判例基础型系统来补充[13]。

二、现代的尝试:机器学习

(一)机器学习、分类问题和法律判断

机器学习模型是在第三次热潮中备受关注的主题。这一时期的研究将机器学习和分类问题作为基本事项,并探究如何将其应用于法律判断。机器学习是指从一定的数据中构建具有普遍性的判断标准的技术。这种具有普遍性的判断标准模型被称为学习模型,构筑模型的过程称为学习或泛化(generalization)。所谓学习,是指从有限的信息中推导出具有普遍性模型的泛化处理,就如同人类或其他生物一样从经历中掌握普适性规律[14]。知识表示学习模型使用的是对于推理系统而言可用的,经过特殊筛选与处理的数据(即知识)来开发人工智能;而机器学习则是让系统在数据中通过泛化自动构筑具有普遍性的模型来开发人工智能。使用这种机器学习时遇到的典型问题之一,就是“分类问题(classification problem)”。分类问题是指将输入值按其特征分配给合适的小组。对输入值进行分类的系统(分类器)很多情况下是通过机器学习完成的,一般来说,机器学习适合对比较繁杂的问题进行分类。将人工智能应用于法律判断时,采用机器学习就是将法律判断作为一个分类问题并加以公式化。也就是说,将法律判断看作是将输入的信息集合分为“接受”“驳回”等类别,建立解决分类问题的系统。

(二)判例的自然语言处理和判决的“预测”

使用自然语言处理技术对判决进行“预测”的研究,是基于该种形式的人工智能的一个应用实例。如果以上述公式化为前提,那么,所谓判决的“预测”可以被定义为将不包括判决结论部分的信息归类为法院将认定的判决类别的问题;而且,由于判决是一种文本数据,这类任务的一种单纯的具体化过程便是将不包含与判决结论相当部分(例如判决理由部分)的文本用于表示其结论的类别(例如“接受”或“驳回”)。谢菲尔德大学计算机专家Aletras等[15]使用支持向量机(Support Vector Machine,SVM)这一机器学习算法,通过让人工智能学习欧洲人权法院的判决书,验证人工智能能进行判决预测的准确度。实验仅针对违反《欧洲人权公约》第3.6.8条构成侵权的判例,通过十折交叉验证法(stratified 10-fold cross validation)验证使用这些判例的文本信息(词袋和主题信息)学习后的SVM算法模型的预测准确度。当使用文本信息和主题信息,特别是“circumstances”(即其中有关诉争情况的部分)进行预测时,准确度达到了79%。

在使用自然语言处理的预测研究中,可以有多种变化。例如,Aletras 等在研究中使用的SVM算法模型擅长使用相对少数数据,研究中用于训练的数据集数量只有250个左右。而Aletras等在后续进行的另一项研究中,尝试使用神经网络作为学习模型,使之学习相对大量的数据(大约2 500个)[16]。与针对特定条文并预测侵权/非侵权这一课题的研究不同,该研究没有预先确定适用的条文,而是要求系统先如法院一般判定是否构成侵权。如果认定构成侵权,则需要继续判断是依据第几款法条作出的认定,其特点在于尝试了更为复杂的预测任务(多级分类问题)。

(三)小结

上述研究是通过将法律判断中输入的信息总体分类为判决中对应的各项类别而建立的公式化系统。与之前已经确认的知识表示学习模型在法律判断上比较直接的逻辑相比,将分类问题加以公式化在技巧上显得有些不协调。特别是在法律判断中,基于制定法或判例等“法律渊源”的判断是必要的。从上述研究中可以看出,这样的构造并没有出现在机器学习这一方式中。

三、人工智能能否独立进行法律判断

综上所述,已有多种形式的人工智能被应用于法律判断领域。可以说,上述研究的初心都是希望人工智能在某种程度上代替司法裁判中的法官,并对相关法律问题作出独立判断。事实上,早在1977年,美国学者D′Amato[17]就提出了“人类法官能否以及应否被机器法官所取代”的问题,我国也有不少学者对此问题进行了探讨。学者们普遍认为,人工智能仅能作为辅助法官或律师的手段,而不能完全取代法官或律师。

(一)法律本身具有不周延性

法律的形式理性希望法律达到一种确定性的状态,在这种状态下,人们能对各种社会行为作出一个预先的规范要件判断,以便在出现争议时不必借助其他手段而仅通过三段论的法律逻辑推理得到一个确定的结果。但是,无论是大陆法系国家的制定法还是英美法系国家的判例法,都具有迟滞性,无法及时回应社会上某些新兴事物引发的法律问题。此外,某些法律条文的含义也可能存在有争议或者模糊不清的情况。此种情形下,人类法官必须借助法律的各项基本原则,甚至是道德、宗教、政治、经济上的因素去作出判断。相应地,在没有预设的、明确具体的规范可以参照的情形下,人们显然不太确信人工智能可以作出正确的、符合正义的判决[18]。

(二)法律判断是一种价值判断

有学者认为,即使人工智能法律系统通过了图灵测试,能做到像人一般思考,也不能独立替代法官的地位。其列举了1968年美国“人民诉柯林斯案”以及“17世纪詹姆斯一世与英格兰首席大法官柯克一段谈话”两个例子来证明上述观点。在前一个例子中,根据证人证言,一名白人女性袭击并试图抢劫一名老年妇女后,乘一辆非裔美国男子开的轿车从现场逃离。随后,符合其描述的一名白人女性和一名非裔美国男性被送交审判。控方在刑事案件中引入并使用数学上的盖然性证据,运用“乘积规则”,将一系列相互独立事件发生的可能性以百分比的形式归纳出来,相乘之后的积,被认为是各事件并发的可能性。检方将这一乘积定律应用于案件事实,进而得出了一个盖然性结论:一对男女同时具有两被告明显特征的概率只有一千二百万分之一,由此凭借计算对这两位在押嫌疑人进行指控。在后一个例子中,当国王提出希望参与审判的想法时,柯克大法官回答道:“不错,上帝的确赋予陛下极其丰富的知识和无与伦比的天赋;但是,陛下对于英格兰王国的法律并不精通。法官要处理的案件动辄涉及臣民的生命、继承、动产或不动产,只有自然理性是不可能处理好的,更需要人工理性。法律是一门艺术,在一个人能够获得对它的认识之前,需要长期的学习和实践。”[19]学者通过这两个例子证明,法律判断不应仅仅是主观的单纯概率判断的问题,法律也不局限于法律专业知识本身,还会涉及政治学、经济学、社会学、哲学等其他学科。如果一个人只懂得法律,其作出的判断往往会背离司法所需要的真正正义[20]。也就是说,司法判决绝对不是单纯的理性裁判过程,还有道德、习惯、文化、社会观念等方面内容,这些内容往往需要和法官的感性判断挂钩,这正是人工智能所不具备的[21]。

(三)小结

根据上述理由,笔者认为,应该依据人工智能的发展水平对其有所区分对待。例如,当人工智能已经达到通过图灵测试的级别时,无论法律本身是否具有不周延性,抑或法律是一种价值判断的问题,已经具有类似人类思考能力的人工智能当然不会局限于法律本身作出机械、僵硬的判断。这或许正如日本学者駒村圭吾[22]所言:“如果从法治其根本目的便是为了排除人治这一点来考量的话,人工智能的支配在排除人治这一点上不也有着异曲同工之妙,并且即使是法治,其中也有一半是由作为人的法官所独占。所以,为了全面实施法治,甚至可以说人工智能的支配更为彻底。”

诚然,法条只有经过法官的解释方得以适用。在此过程中,人不免会受到自身价值观的影响,甚至是朝着自身所希望的结论去解读[23]。但是,法治和人治并不是完全对立的。法治是使用一种具有明确性、可预期性的规则去指导、约束社会的方方面面,这个过程中也无法脱离人的因素。各国的上述研究也在诸多环节上体现了人对于人工智能的干涉。如在知识表示学习模型中使用的数据,数据本身就是经过人为挑选后而输入的,机器学习模型中算法的学习逻辑也是由人决定的。更为重要的是,人工智能对于某个法律问题的判断逻辑本身就是基于法官、法学家等法律从业者对于法律的解释而适用的。

四、人工智能在中国法律判断领域的困境与进路

近年来,我国的研究人员也开发了一些将人工智能应用于法律判断的系统。例如,早在1993年,武汉大学法学院教授赵廷光便开发了电脑辅助量刑软件;同年,中山大学学生胡钊、周宗毅、汪宏杰等合作研制了“Loa律师办公自动化系统”[24]。在2016年世界互联网大会智慧法院网络法治论坛上,最高人民法院周强院长提出,“将积极推动人工智能在司法领域的应用”[25]。2017 年,武侠律师打造的“法律机器人”上线,欲借助互联网、人工智能的优势构建法律服务平台。该系统可根据当事人选中需要咨询的问题,拆分问题点,引导当事人逐一进行回答,最后系统将在1秒内生成上万字的法律咨询意见和预判报告。第十二届全国人民代表大会第三次会议审议通过的《最高人民法院工作报告》中指出,人民法院将加快建设智慧法院,综合运用云计算、大数据等技术,研究构建司法人工智能系统,为审判体系和审判能力现代化注入新动力,为司法改革和法治中国建设提供有力支撑。在最高人民法院积极推进下,全国各地法院纷纷响应,各自推出了名称不同的人工智能法律系统,如北京法院的“睿法官”智能研判系统,上海法院的“206”刑事案件智能辅助办案系统,苏州法院的“智慧审判苏州模式”等。

尽管我国已经有了较为成功的实践,但从整体上看,我国司法裁判领域的人工智能依旧处于起步阶段。除上文提到的人工智能本身所具有的共性问题外,在中国,人工智能的发展还面临着许多独有的困境。笔者将逐一分析这些困境,并探寻应对的方法。

(一)困境

人工智能法律判断在中国的发展面临如下困境:

第一,技术上存在障碍。中国目前的人工智能在系统上表达不够标准,逻辑建构不够确定,场景设计高度同质化[26]。另外,算法的设计还比较粗糙,大部分公司使用的只是“神经网络深度学习”算法,没有结合填充了丰富细节后的“知识图谱”,使得其对于案件的判断结果往往较为粗浅与模糊。

第二,研究领域过于集中,研究点与现实需求相偏离。目前,我国对于人工智能在法律判断领域应用的研究主要集中在刑事案件领域,而在民事案件领域中研究的重点则是合同文本自动生成及部分内容可视化表达、智能类推等[27]。事实上,我国85%的案件均为民事案件,需求也远不止合同文本的生成,因此,客观原因也造成了有关民事法律问题判断的研究进展缓慢。

第三,数据的搜集整理不足。在我国,使用人工智能进行分析时,主要的数据来源是法院的裁判文书,但我国发布在网上的裁判文书可能仅有实践中案例的50%,半数的案件都没有被收录[28]。

第四,相关人才储备薄弱。人工智能的持续推进需要法学人才和技术人才共同努力。然而,目前我国法学人才对于大数据、算法和人工智能的理解普遍较弱;技术人才又对法律行业感知不深,往往注重眼前利益,对还在发展阶段的人工智能投入较少[29]。

第五,司法公信力缺失。从古至今,我国民众都十分强调实体正义,注重情理与法理兼顾,对如包拯、海瑞这样清正廉洁的官员天然具有一种信赖感。中华人民共和国成立以来,同样有像马锡五、宋鱼水、陈燕萍这样具有高度人格魅力的法官,他们以人际关系的信任为基础,推行亲民式的审判方式,以打消百姓对于司法判决正当性的质疑或担忧[30]。此外,法官与当事人之间的良好沟通、法官的着装、法庭的布置、开庭的程序,这些都会让当事人感受到司法过程的公信力以及增加对法官的信任感。然而,如果将人工智能运用在法律判断领域,则容易产生完全相反的效果。一是大部分人会觉得人工智能就是一个冰冷的机器,其缺少人的温情,也不会主动和当事人沟通交流。二是人工智能本身就是一个黑箱。由于缺乏专业知识,大部分普通中国百姓难以理解人工智能的运转原理,也无法亲眼亲耳去见证判断过程,自然会对其作出的判决充满不信任感。因此,如果当事人对人工智能不够信任,那么,无论是由多么优秀的人工智能作出的判决,当事人都会对判决的合理性表示怀疑,进而可能导致上诉率增加或产生其他问题,反而无法达到提升司法效率的目的。

(二)解决路径

第一,在技术上,应当坚持知识图谱和深度学习相结合的思路,并逐步优化算法。具体而言,可以使用非单调推理,多用思维导图,将区块链技术加入算法的设计中等。可以让法学专家参与到算法的编写中,以起到监督的作用。应加快更多领域技术解决方案的开发,将适用范围扩展到裁判的各个方面。

第二,在数据上,应当建立完善的数据管理系统,并扩大数据来源,积极推进司法电子化。推进法院案例资源上网,并努力实现法院、检察院、公安、社会中公司等机构之间的数据共享。对于既有资源,应当加强管理,实现要件提取标准化、类案标注科学化、类案问答交互化。

第三,在人才储备上,应当加强法学人才与技术人才之间的交流合作,鼓励法官等一线法律工作者在办案过程中形成思维导图、规范的办案流程、规范的裁判用语等便于机器归纳与学习的材料。

第四,人工智能的算法应具备一定的公开性和可解释性。正如我国司法机关将裁判文书公示在网上,推进网上庭审直播等,要使公众信任司法判决,就需要将司法过程展现在公众的视线中。同理,人工智能对于法律问题的判断逻辑、方法原理等也应该公之于众。但是,仅仅公开并不当然能使公众信服人工智能所作出的判断,唯有让公众理解其算法,才能使得公众相信人工智能。然而,越是具有判断准确性的人工智能,一般其算法也越是具有复杂性。为增强人工智能的司法公信力,需要在判断准确性与可解释性之间进行平衡[31],这是有待解决的重要问题。

目前,人工智能在我国法律判断领域的应用尚不成熟,基础性的资源、相应的技术和人才储备等方面都存在一定的问题。要解决这些问题,除了需要调整观念和方向外,还需要一定的时间。技术的进步会逐步改变人们的习惯与认知,随着人工智能在法律判断领域的应用不断升级,可被方便识别的电子法律数据的积累、机器学习等算法模型的迭代效率程度及优化效率也将呈指数级加速。无论人们是否愿意接受,司法裁判中的相当一部分工作都正在逐步转移给人工智能,未来人工智能所承担工作的比重会逐渐增大,人们对于人工智能的认知也会更加深入,但未来也将面临新的困境与挑战。