基于实值RBM 的深度生成网络研究*

2021-02-25丁世飞张成龙

张 健,丁世飞,丁 玲,张成龙

1(中国矿业大学 计算机科学与技术学院,江苏 徐州 221116)

2(矿山数字化教育部工程研究中心,江苏 徐州 221116)

3(中国矿业大学 徐海学院,江苏 徐州 221008)

近年来,深度学习引起了广泛关注.基于概率图和神经网络的受限玻尔兹曼机(restricted Boltzmann machine,简称RBM)、变分自编码(variational autoencoder,简称VAE)和生成对抗网络(generative adversarial network,简称GAN)被广泛应用于图像分类和图像生成任务中[1,2].与此同时,近年来对RBM 的研究遇到了一些困难[3,4],其原因在于,其他方法、特别是GAN 在实践中效果更好.事实上,RBM 及其衍生模型一般都有足够的特征表达能力来学习复杂的数据分布,其应用和拓展上的困难往往出现在训练过程中,RBM 训练需要显式的激活概率和梯度表达式.因此对于RBM 而言,在保证显式梯度前提下构建有效的方法来学习数据分布是比较困难的.为了建模实值数据,人们提出了多种实值RBM 模型[5-7].但是RBM 模型的特征表达问题和深度拓展问题一直没有得到很好的解决.具体而言,RBM 最常用的训练算法是基于Gibbs 采样的对比散度算法(contrastive divergence,简称CD)算法,而在CD 算法中,可见层单元的状态x˜总是从条件概率p(x|h)中采样得到,因此,一个充分参数化且易学习的条件概率p(x|h)对于建模数据分布而言是非常重要的.通常我们希望可见层单元的边缘概率和条件概率具有足够的表达能力,从而最大程度地拟合数据分布.然而在大多数RBM 中,隐藏层单元是二值的,二值隐藏层单元限制了RBM 对可见层单元条件概率的参数化能力,因为可见层单元的条件概率是由基于二值隐藏层单元的高斯分布的组合确定的.

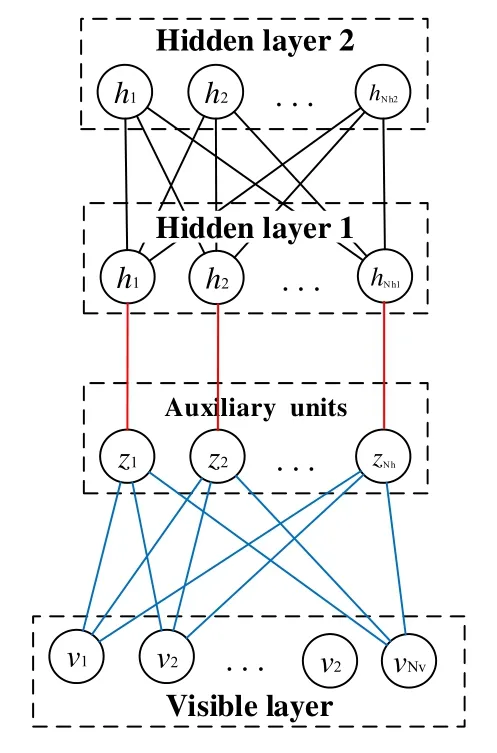

为了有效地参数化可见层单元的激活概率并建模数据中的流形结构,本文在可见层单元和隐藏层单元之间增加二值的辅助单元从而实值化可见层单元和隐藏层单元,并在RBM 的能量函数中引入了Laplacian 正则化项来构建特征化的隐藏层单元表达,由此提出了基于辅助单元的受限玻尔兹曼机(restricted Boltzmann machine with auxiliary units,简称ARBM).具体而言,假设ARBM 中的可见层单元和隐藏层单元服从截断高斯分布,模型参数化截断高斯分布中的期望和协方差.基于实值隐藏层单元,可见层单元的条件激活概率可以看作是无限数量的截断高斯分布的加权和,从而能够拟合复杂的数据分布.在ARBM 中,基于二值辅助单元和图正则化项,当样本靠近数据流形时,它有更高的概率被映射为参数化的截断高斯分布;反之,远离流形的样本更可能被映射为高斯噪声.辅助单元的另一个作用是缓解过拟合问题,过拟合在神经网络和RBM 的训练中普遍存在,而dropout方法是缓解过拟合问题的常用方法.在基于dropout 方法的RBM 模型中,可见层和隐藏层中的部分单元被随机屏蔽,这可能会影响RBM 的特征提取能力和图像重构能力[8-10].而在ARBM 中,辅助单元控制可见层单元和隐藏层单元的激活概率,并在一定程度上保留了单元的随机性.当辅助单元被激活时,ARBM 的可见层单元和隐藏层单元以参数化的条件概率形式被激活.当辅助单元灭活时,可见层单元和隐藏层单元的条件概率退化为高斯噪声.此时类似于dropout 方法,基于ARBM 的神经网络的训练过程可以也看作是一个去噪过程.为了建立深度生成模型并获得锐利的生成图像,本文基于ARBM 提出了基于附加单元的实值深度置信网(real-valued deep belief net with auxiliary units,简称ADBN).本文首先验证了ARBM 的性能优于常用的RBM 模型,然后利用ADBN 提取的深度特征作为条件,生成对抗网络(conditional generative adversarial net,简称CGAN)的条件输入,构建了一个深度生成神经网络.我们称该模型为基于辅助深度特征的条件生成对抗网络(conditional GAN with auxiliary deep features,简称ACGAN).本文的主要贡献可以概括如下:

(1) 在可见层和隐藏层之间引入二值附加单元,提出了ARBM 模型.基于能量函数中的图正则化项和附加单元,,靠近数据流形的样本有更高的概率被参数化为截断高斯分布的形式,远离流形的样本有更高的概率被映射为高斯噪声,因此,ARBM 可以有效地学习数据中的流形结构,并将其表示为隐藏层的参数化特征;

(2) 为了构建有效的深度生成模型,本文将ADBN 提取的深度特征用作CGAN 的附加输入,提出了ACGAN模型.与传统的随机噪声相比,这些深度特征能为GAN 提供更稳定有效的初始状态,从而生成高质量的图像、缓解GAN 模型训练不稳定的问题.

本文第1 节介绍基础理论,包括RBM 和CGAN.第2 节详细介绍ARBM 及其相应的深生成模型ADBN 和ACGAN.在第3 节中,本文通过实验验证所提出模型的有效性.最后一部分是结论和展望.

1 相关工作

1.1 受限玻尔兹曼机

典型的RBM 模型由可见层x和隐藏层h组成,RBM 的联合概率可以通过能量函数来定义,RBM 模型及其基于Gibbs 采样的训练过程示意图可以表示为图1 的形式.

Fig.1 Topology of an RBM and its training process图1 RBM 的拓扑结构及其训练过程

在图1 中,W是可见层和隐藏层之间的权值矩阵.如果可见层单元和隐藏层单元是二值的,那么能量函数可以定义如下:

其中,a和b是RBM 的偏置,x表示可见层向量,h表示隐藏层向量,W是权值矩阵.基于能量函数E(x,h),联合分布可以表示为p(x,h)=Z-1exp(-E(x,h)),可见层单元和隐藏层单元的激活函数可以表示如下:

典型RBM 模型的目标是最大化其边缘分布p(x)的log 似然,这个目标函数可以表示为

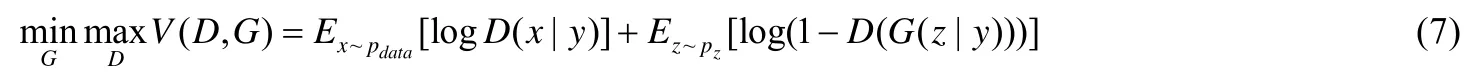

根据极大似然估计,似然函数关于参数的梯度可以表示如下:

将公式(5)表示为期望的形式,可以得到:

如公式(6)所示:等式右边的第1 项称为模型期望,第2 项称为数据期望,两个期望的差值决定了似然函数关于参数的梯度.直观上看,数据期望给出了参数迭代的起始条件,模型期望提供了迭代的终止条件.随着迭代的进行,数据期望和模型期望逐渐接近,RBM 的训练随迭代趋于稳定.此时,RBM 模型建模了输入样本的分布特性.然而在大样本下,精确地计算这两个期望是非常困难的,尤其是模型期望.因此,为了降低RBM 训练的复杂度,需要对似然函数的梯度做近似.为此,Hinton 等学者提出了对比散度算法(contrastive divergence,简称CD)来近似似然函数的梯度.除了对比散度算法,还有其他一些类型的方法可以用于近似计算RBM 的梯度[11-13].

1.2 条件生成对抗网络

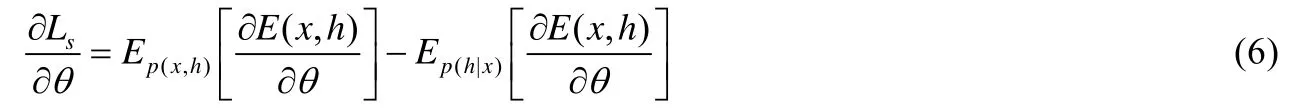

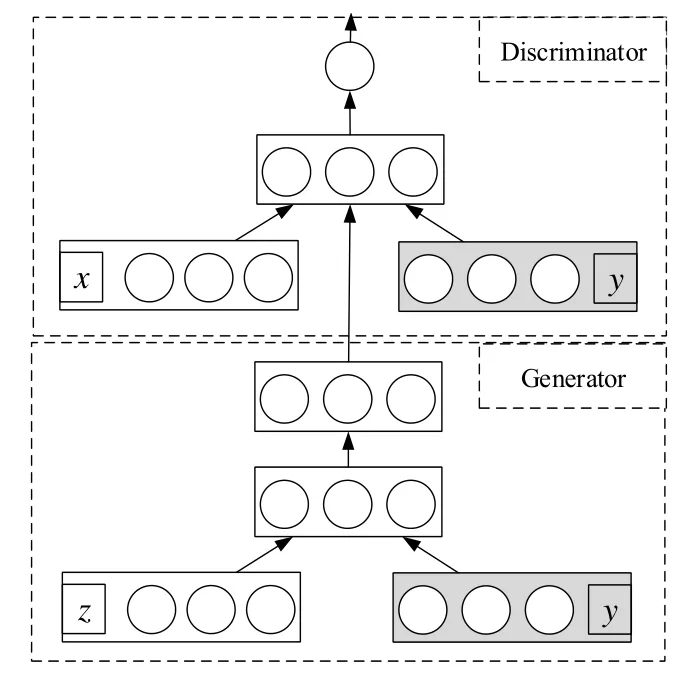

作为近些年最受关注的生成模型,生成对抗网络(generative adversarial net,简称GAN)得到了广泛的应用.GAN 的优势在于可以回避难以直接计算的基于模型分布的积分函数,只使用反向传播就可以根据梯度训练生成模型,不需要推理.此外,当生成器和判别器在某些额外的条件y的约束下,可以将GAN 扩展到条件模型:条件生成对抗网络(conditional generative adversarial net,简称CGAN).其中,y可以是任何类型的辅助信息,例如类标签或来自其他模态的数据.可以通过将y作为附加输入传递给判别器和生成器来执行该条件[14].CGAN 的目标函数可以用公式(7)表示:

图2 是一个典型的CGAN 的网络结构.

Fig.2 Structure of a CGAN图2 CGAN 的结构图

作为一个CGAN 模型,其输入的条件y是非常重要的.模型可以根据条件y所包含的信息完成特定的任务,不仅可以将CGAN 用于监督和半监督任务,本文还使用深度特征作为条件输入,从而增强模型在图像生成任务中的有效性.

2 基于附加单元的受限玻尔兹曼机及其深度神经网络扩展

2.1 基于附加单元的受限玻尔兹曼机

首先,我们通过直观的方式分析二值单元在RBM 特征表达方面存在的不足.为了方便表述,假设模型有一个隐藏层单元,且只考虑单个样本的情形.根据模型的独立性假设,在此基础上,可以很方便地推广到多样本多隐藏层单元的情形.二值RBM 不能有效地建模实值数据,是因为对实值数据二值化的过程中,数据中一些重要的相关性信息可能会丢失.为了建模实值数据,传统的Gaussian-binary RBM 假设其可见层单元的条件概率服从 高斯分布,其隐藏层单元为二值的.基于极大似然估计,目标函数可以表示为L= logp(x) = log ∑ip(x,hi),其中,h是二值单元.基于二值隐藏层单元h,可见层单元的条件概率p(x|h)可以表示为两种形式:p(x|h=0)和p(x|h=1).因此,RBM 可见层单元的边缘概率可以进一步分解为p(x)=p(x|h=0)p(h=0)+p(x|h=1)p(h=1),其中,p(x|h=0)和p(x|h=1)为高斯分布.基于二值的隐藏层单元,可见层单元的边缘分布可以看作是p(x|h=0)和p(x|h=1)的加权和.这个过程可以表示为图3 的形式.

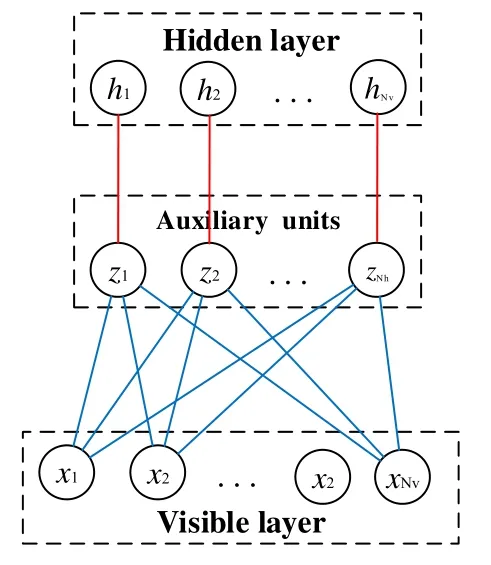

如果一个分布的密度函数p(y)可以写成p(y) =∑ip(yi),当i→∞且p(yi)是高斯分布的时候,p(y)可以用于拟 合任何连续分布函数.然而在传统的实值RBM 中,图3 中p(x|h=0)和p(x|h=1)的组合(两个高斯分布的加权和)很难拟合一个复杂数据分布;而当RBM的隐藏层单元也是实值单元时,可见层单元的边缘概率可以看作是无数 高斯分布的加权和p(x) =∫p(x|h)p(h)dh,理论上可以拟合一个复杂连续的数据分布.因此,本文将RBM 的隐藏 层单元由二值单元拓展为实值单元.然而,高斯分布形式的激活函数在BP 算法中具有较高的计算复杂度且不稳定,因此我们假设可见层单元和隐藏层单元服从截断高斯分布,并由此近似神经网络中的ReLU激活函数.为了建模嵌入在数据中的流形结构,本节在可见层和隐藏层之间增加辅助单元,然后将图正则化项引入到能量函数中.基于二值辅助单元和图正则化项,流形上的数据有更高的概率被映射为参数化的截断高斯分布;同时,远离流形的数据更可能被映射为高斯噪声.ARBM 的结构如图4 所示(其中,可见层单元和附加单元之间的连接值为权值W,二值辅助单元和实值隐藏层单元之间是一一对应的关系).

Fig.3 A sketch map of Unweighted marginal distribution of the visible units in a Gaussian-binary RBM图3 Gaussian-binary RBM 中可见层单元未加权的边缘分布示意图

Fig.4 Structure of the ARBM图4 ARBM 的结构图

ARBM 的能量函数可以表示如下:

其中,x和h被截断在区间[0,+∞],diag(α)和diag(β)是对角矩阵,c是偏置,ε是当前样本与其所在mini-batch 内其他样本之间的图相似性系数.图相似性系数可以使用高斯扩散核(Gaussian diffusion kernel)的形式计算:

其中,d(i,j)是欧氏距离;σ是用于平衡数量级的超参数;Σ是N×N的矩阵,且 ε(i) = (1/N)∑j∑(i,j).基于公式(9),联 合概率和条件概率可以表示为

其中,I(·)是示性函数,NT表示截断高斯分布,辅助单元用于控制隐藏层单元和可见层单元的激活概率.基于公式(12)和公式(13),可见层单元和隐藏层单元的条件概率可以表示为截断高斯分布,实值隐藏层单元可以为可见层单元的条件概率提供更灵活的期望.接下来,本文从理论上讨论流形学习和辅助单元的作用.

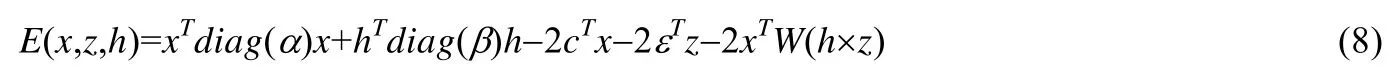

命题1.在ARBM 中,可见层单元和隐藏层单元都是条件独立的,为了方便表述,我们假设样本和特征都是一维的.给定一个mini-batch 的样本,截断高斯分布的期望是β-1(xWz)+β-1(f(0)/S(0)),协方差是β-1-β-1(xWz) (f(0)/S(0))-β-2(f(0)/S(0))2,其中,f(h)=p(h|z,x),S(h)=1-P(h|z,x).对于一个样本而言,当它靠近数据流形时,其对应的 隐式表达具有更高的概率密度,并且该样本以近似为p(z=1|x)的概率被映射到以β-1vW为中心、为邻域 的区间内;反之,当样本点远离流形时,它以p(z=0|x)的近似概率被映射为高斯噪声N(0,β-1).

证明:假设一个mini-batch 包含N个样本,基于公式(9),如果样本x(i)位于流形附近,其相似性系数ε(i)则会相对较高.与x(i)对应的附加单元z(i)以概率p(z(i)=1|x)激活,与相似性系数ε(i)正相关.因此,流形上的样本对应于p(z(i)=1|x)的高条件概率.当z(i)=1,隐藏层单元的条件概率可以表达为NT(β-1(xW),β-1).根据高斯分布置信区间的概念,从高斯分布中获得的样本以超过99.74%的概率位于区间[μ-3σ,μ+3σ].因此在本文中,对于截断高斯分布,这个概率大于99.74%,本节假设这个概率可以近似为1.因此,样本以近似概率p(z=1|x)被映射到区间[μ-3σ,μ+3σ],且μ=β-1xW.如果x(j)不在流形附近,其相似性系数ε(j)会偏小,其对应的附加单元z(j)更可能以p(z=0|x)激活.当z=0,隐藏层单元的条件概率可以表示为NT(0,β-1).因此,基于公式(12),样本x(j)在近似概率p(z(j)=0|x(j))下被映射到高斯噪声NT(0,β-1).截断高斯分布的期望可以表示为

其中,μ=β-1(xWz),f(0)=p(h=0|z,x),σ2=β-1.根据期望和协方差的关系可知,h的协方差是Var(h|h>0)=E(h2|h>0)-E(h|h>0)2,期望E(h2|h>0)可以表示为

因此,Var(h|h>0)=σ2-μσ2(f(0)/S(0))-(σ2(f(0)/S(0)))2.

基于命题1,在ARBM 中,如果样本位于流形附近,则更有可能映射到参数化概率,并且可以学习到流形特征保留在隐藏层中;反之,如果样本远离流形,则更有可能退化为隐藏层的高斯噪声.

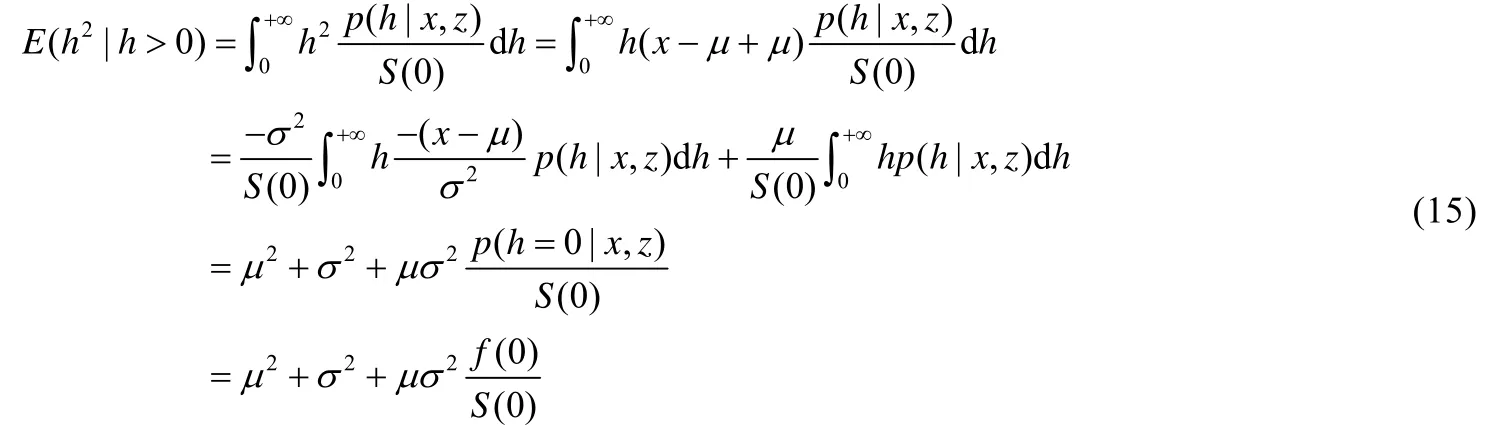

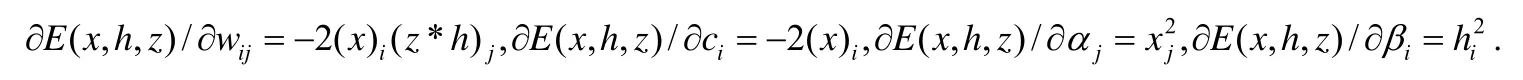

ARBM 可以用CD 算法训练,似然函数关于参数的梯度可以表示为

能量函数的梯度可以表示为

在ARBM 中,为了计算截断高斯分布下的期望值,借鉴高斯图模型,本章采用文献[15,16]中的方法.ARBM还可以经过逐层堆叠构建深度置信网,本文将其称为基于附加单元的深度置信网(deep belief net an auxiliary units deep belief net,简称ADBN).

2.2 基于ARBM的深度生成模型

ARBM 本身作为一种概率图模型,既可以用于判别任务,也可以用于生成任务.本文关注的重点是基于ARBM 的生成模型.由于ARBM 本身是一种单隐藏层神经网络结构,其特征表达能力有限,因此我们需要根据ARBM 模型构建相应的深度神经网络结构.

首先,我们构建了一个基于ARBM 的深度置信网,该神经网络含有2 个隐藏层,本文称其为基于附加单元的实值深度置信网(real-valued deep belief net with auxiliary units,简称ADBN),该ADBN 的网络结构如图5 所示.

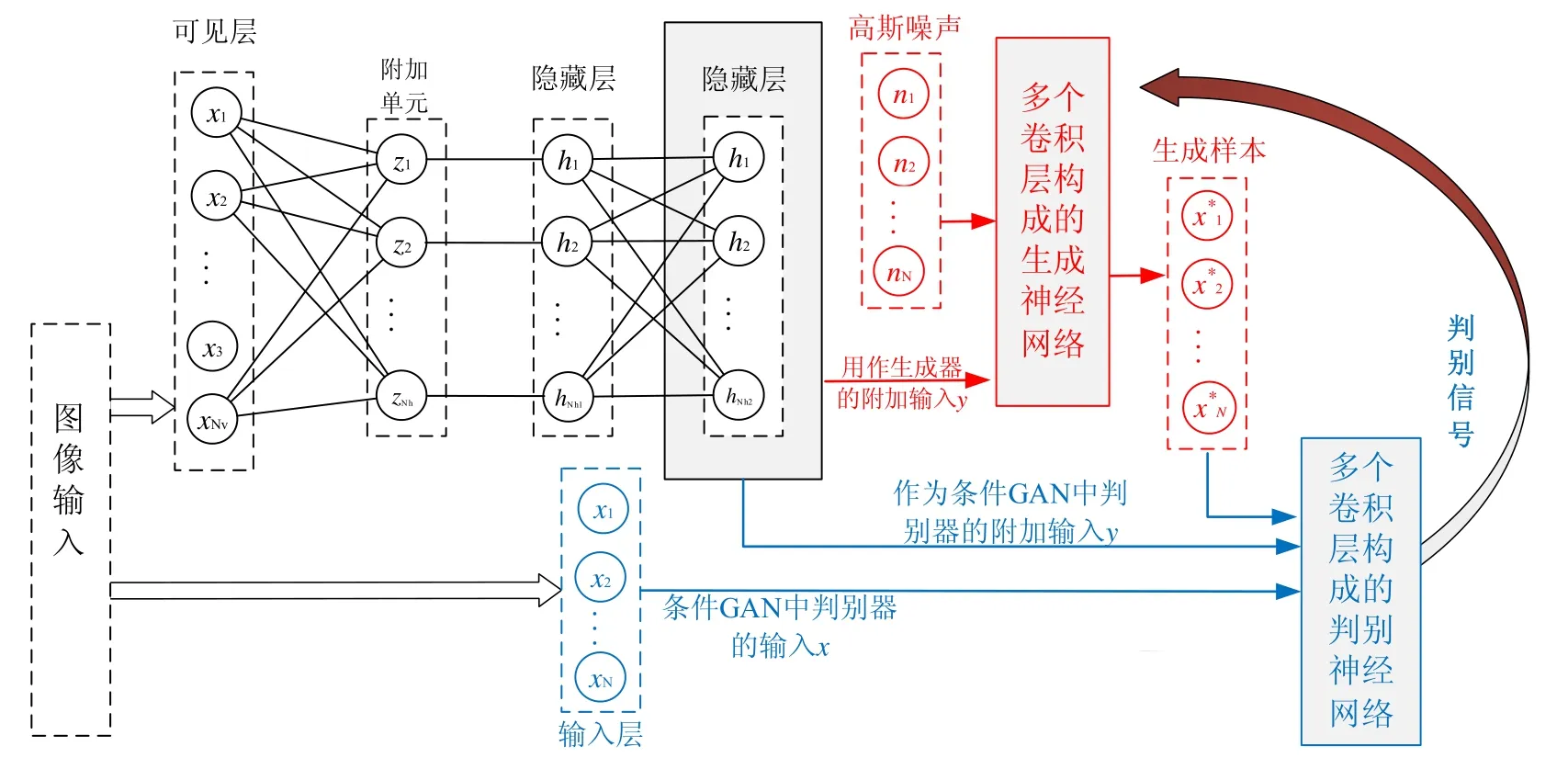

Fig.5 Structure of an ADBN图5 ADBN 模型的结构图

ARBM 和ADBN 可以直接用于图像生成和图像分类任务,但由于RBM 训练过程中的标准卷积运算和最大池化运算是不可逆的,因此ARBM 很难与卷积神经网络相结合构建深度神经网络结构.为了建立更强大的深度神经网络,我们利用ADBN 提取的深层特征作为条件GAN(CGAN)的条件输入数据,建立深层生成神经网络.GAN 被训练以最小化数据分布与模型分布之间的距离,而不是最大化似然函数.然而GAN 训练是不稳定的,通常观察到具有相似结构和超参数的生成器在不同的训练批次中表现出显著不同的行为.虽然RBM 训练需要使用基于采样的算法,但RBM 的优势在于不存在模式丢失问题且RBM 训练是稳定的.为了充分利用ARBM 的优势,并结合卷积操作生成清晰锐利的图像,本文利用ADBN 提取的深度特征作为CGAN 的条件输入y,建立卷积深度生成神经网络,与传统的随机噪声相比,这些深层特征能为GAN 提供更稳定的初始状态.我们称这种深度生成神经网络为基于辅助深度特征的条件生成对抗网络(conditional GAN with auxiliary deep features,简称ACGAN),其模型结构如图6 所示.

Fig.6 Structure of an ACGAN图6 ACGAN 模型的结构图

图6 是ACGAN 的模型结构图,模型的训练分为两部分:首先,根据输入图像训练一个ADBN 模型,在训练好的ADBN 模型基础上,将输入图像传递给ADBN 得到特征;该特征用作CGAN 的附加输入y传递到CGAN 的生成器和判别器,同时,图像输入也用作CGAN 判别器中的真实样本.模型的目标函数可以表示为

其中,x来自于数据集.ADBN(x)是由ADBN 得到的特征,该特征作为CGAN 的附加输入.接下来,本文通过实验验证ARBM,ADBN 和ACGAN 的有效性.

3 实验分析

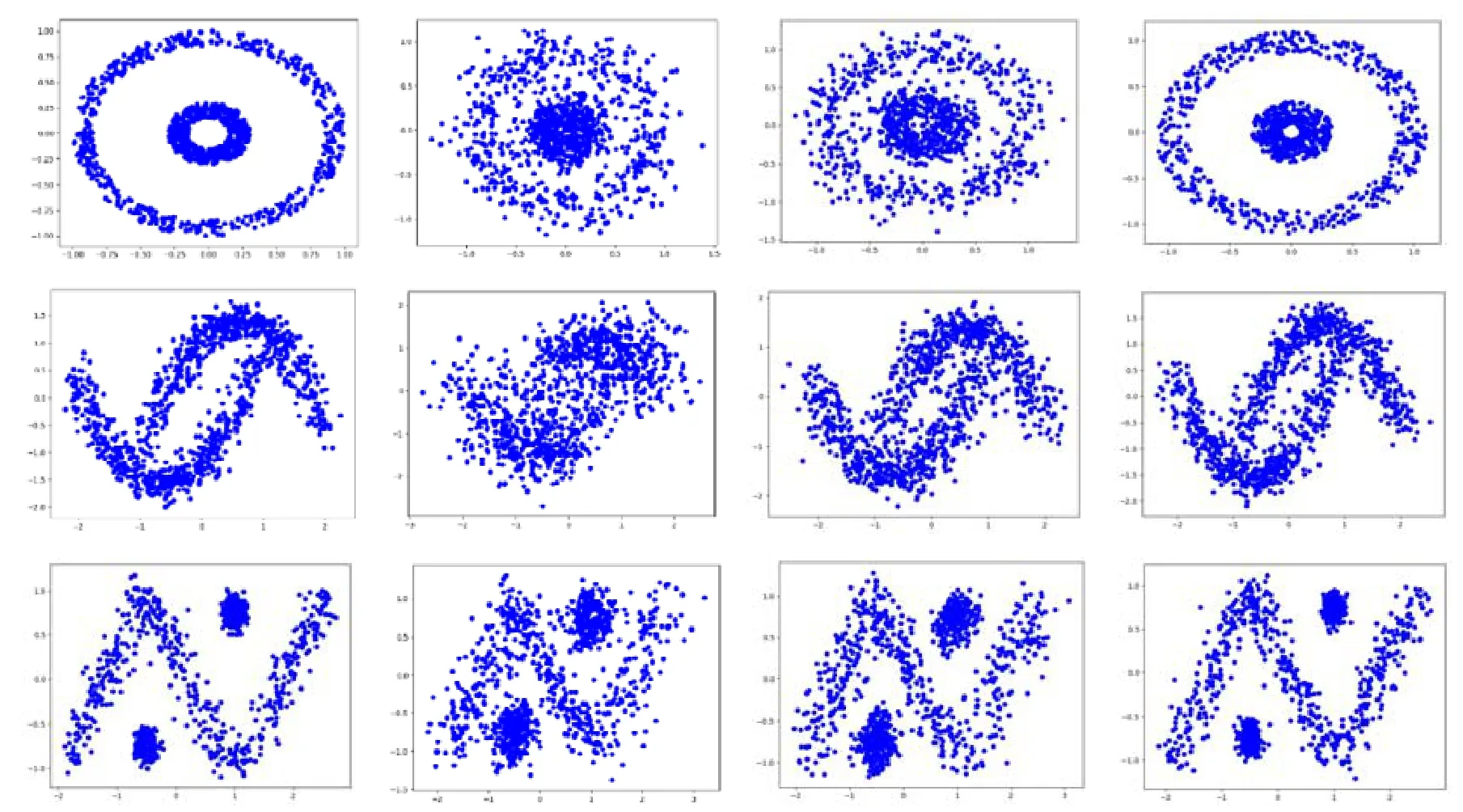

在实验中,我们尝试验证基于ARBM 的模型在图像生成和图像重构任务中的有效性.实验主要分为两部分:一部分是图像重构,另一部分是图像生成.为了验证ARBM 能够学习数据分布的流形结构,我们首先在3 个人工数据集上进行对比实验,其中使用的基于RBM 的模型具有完全相同的网络结构.结果如图7 所示.

Fig.7 Comparison of ARBM with other models on three artificial datasets图7 3 个人工数据集上ARBM 与其他模型的比较

图7 由4 列样本组成,其中,

• 第1 列样本是原始数据;

• 第2 列样本是由Gaussian-binary RBM 重构得到的,Gaussian-binary RBM 是一种可见层单元为实值、隐藏层单元为二值的RBM 模型;

• 第3 列样本由受限截断高斯图模型(RTGMM)重构得到.RTGMM 是在2017 年提出的一种无向概率图,其可见层单元和隐藏层单元都是实值的.不同于ARBM,RTGMM 由一个可见层和一个隐藏层组成,其可见层单元和隐藏层单元是直接连接的;

• 最后一列样本由ARBM 重构得到.

如图7 所示,标准的Gaussian-binary RBM 更倾向于把模型密度散布在其支撑数据集上.而不同于Gaussian- binary RBM,ARBM 能够学习这3 个数据集的分布特征,并识别出数据分布上的流形结构.

接下来,本实验在真实数据集上测试 ARBM 和 ADBN 的图像重构能力.数据集有 MNIST,small Norb,Fashion 和Cifar-10.数据集的属性见表1.

Table 1 Attributes of data sets表1 数据集的属性

MNIST 数据集是由250 名来自不同人群的实验人员完成的手写数字数据集,其中包括MNIST 基本数据集、MNIST back-rand 数据集和MNIST back image 数据集等.Norb 是一个由灰度化的双视角玩具图像组成的数据集,包含5 类玩具(人、动物、汽车、飞机、卡车),在不同的光照条件下,由相机系统从不同的角度进行成像.本节实验将两幅立体图像的原始分辨率从108×108×2 降低到32×32×2,以加快实验速度.Fashion 数据集包含了10 个类别的图像,分别是t-shirt,trouser,pullover,dress,coat,sandal,shirt,sneaker,bag,ankle boot.Cifar-10 是常用于目标识别的计算机视觉数据集,它是8 000 万个微型图像数据集的一个子集,由60 000 个32×32 分辨率的彩色图像组成,包含10 对象类,每个类有6 000 个图像.

本实验在MNIST,small Norb 和Cifar-10 上测试了这些模型的图像重构能力,原始图像如图8 所示.

Fig.8 Original images of MNIST,small Norb,and Cifar-10图8 MNIST,small Norb 和Cifar-10 的原始图像

与GAN 不同,ARBM 和ADBN 的模式塌陷问题并不严重.然而,似然函数过平滑的问题阻碍了模型生成锐利的图像.为了保持多模态特征并产生清晰的图像,本文将提取的ADBN 特征作为CGAN 的条件输入,测试了ACGAN 的生成能力.第1 个实验在MNIST 数据集上测试了所提出的ARBM,ADBN 的图像重构能力以及ACGAN 的图像生成能力.所用的ARBM 具有1 000 个隐藏层单元,重构和生成的图像如图9 所示.

Fig.9 Reconstructed images and generated images on MNIST图9 在MNIST 上的重构图像和生成的图像

在图9 中,左数第1 张图像是由ARBM 重构的图像,第2 张图像是由ADBN 重构的图像.如图9 所示,本文提出的ARBM 算法能够提取手写体图像的边缘特征,得到平滑的图像.此外,ADBN 重构的图像相比于ARBM而言与原始图像更为相似.第3 张图像是由深度卷积生成对抗网络(deep convolutional generative adversarial network,简称DCGAN)生成的[17],DCGAN 是一种引入了深度卷积结构的深度对抗生成网络,其目标函数是最小化数据分布和模型分布之间的JS 散度.第4 张图像是由WGAN-GP[18]生成的,WGAN-GP 将JS 散度替换为Wasserstein 距离并优化求解方式,从而解决了JS 散度中距离度量问题,是目前非常常用的图像生成算法.第5 张图像是由ACGAN 生成,可以看出,ACGAN 生成的图像在细节上更接近原始图像.

接下来,本文测试了所提出的模型在 small Norb 数据集上的图像重构能力和图像生成能力.实验中,ACGAN 中的生成器有2 个全连接层和2 个反卷积层,判别器有2 个卷积层和2 个全连接层.生成器和判别器均采用leakyReLU 激活函数以及Batch-Norm.DCGAN,LSGAN 和WGAN-GP 具有与ACGAN 相同的网络结构.生成器和判别器的初始学习率为8e-5.图10 展示了模型在small Norb 上的重构图像.

Fig.10 Reconstructed images and generated images on small Norb图10 small Norb 上的重构图像和生成图像

在图10 中,左数第1 张图像由RTGMM 重构得到.RTGMM 可以看作是一种实值单元的RBM 模型,能够很好地结合到神经网络中.第2 张图像由ARBM 重构得到,第3 张图像由ADBN 重构得到.可以看出:相比于传统的RBM 方法,ARBM 和ADBN 在small Norb 数据集上重构的图像更清晰.第4 张图像是由DCGAN 生成的,第5 张图像是由WGAN-GP 生成的,最后一张图像由ACGAN 生成.可以看出,ACGAN 生成的图像相对于其他常用的以GAN 为基础的生成模型更为清晰、更接近于原始的图像.接下来,我们测试了模型在Fashion 数据集上的图像重构和图像生成能力,得到的图像如图11 所示.

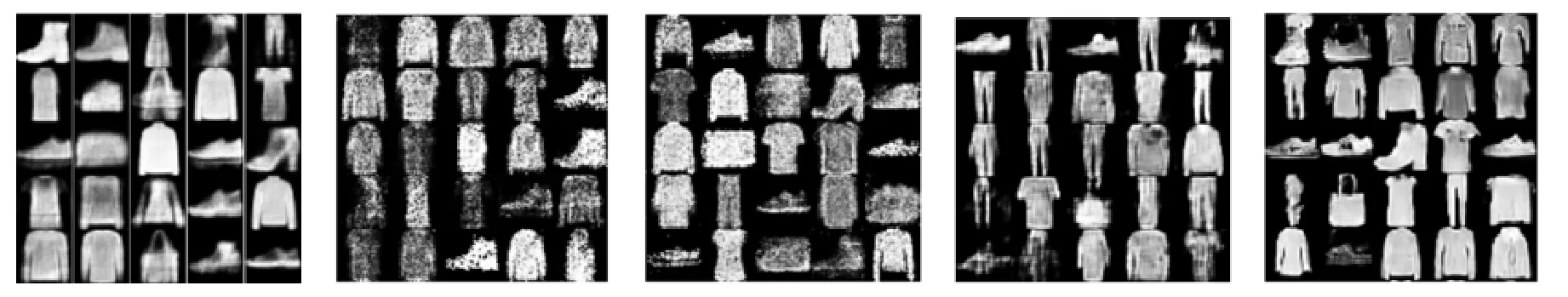

Fig.11 Reconstructed images and generated images on Fashion图11 Fashion 上的重构图像和生成图像

在图11 中,第1 张图像是由ADBN 重构得到的.第2 张图像由DCGAN 生成.第3 张图像由LSGAN 生成,LSGAN 是一种深度对抗生成网络,其中,目标函数被替换为均方误差的形式.第4 张图像由WGAN-GP 生成.最后一张图像由ACGAN 生成.可以看出,ACGN 生成的Fashion 图像更清晰、更接近原始图像.

Cifar-10 对于32×32 分辨率的图像生成任务而言是困难的,因为Cifar-10 是彩色的,其背景也更复杂.特别是对于没有卷积结构的浅层网络(如ARBM),很难生成Cifar-10 数据.本节尝试使用两个隐藏层的ADBN 来学习Cifar-10 数据集.在ADBN 中,第1 隐藏层有5 000 个单元,第2 隐藏层有1 500 个单元.ADBN 重构的图像和生成的图像如图12 所示.

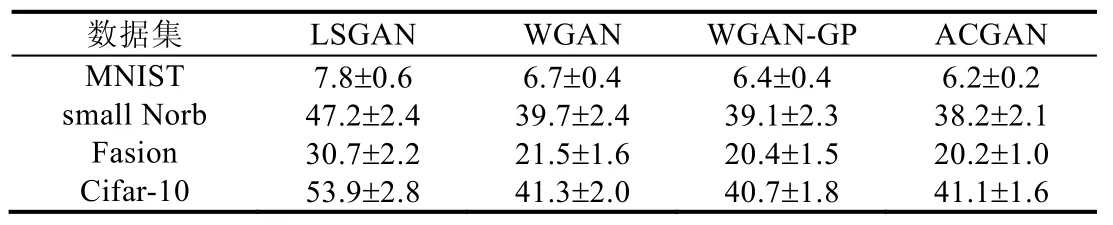

如图12 所示:尽管ADBN 提取输入图像能够可视化边缘特征,但生成的图像过于平滑和模糊.我们认为,导致图像模糊的主要原因是卷积运算难以加入RBM 模型.因为在RBM 训练过程中,卷积和池化运算是不可逆的.为了建立一个有效的基于ADBN 的深度卷积生成神经网络,我们利用ADBN 提取的深度特征作为CGAN 的条件输入数据提出ACGAN 模型,我们将ACGAN 生成的图像与现有模型(例如DCGAN,WGAN-GP 和Real-NVP模型)生成的图像进行比较[19].Real-NVP 模型是一个非对抗性可逆生成神经网络.在本实验中,为了生成彩色图像,我们首先利用ADBN 模型生成Cifar-10 图像,然后通过max-pooling 操作将生成的图像下采样到16×16,8×8和4×4 分辨率的特征图像.这些特征被用作不同分辨率ACGAN 的条件输入.从图12 可以看出:尽管ACGAN 与其他模型相比生成相对清晰的图像,但是生成图像的颜色和部分轮廓受到条件输入的影响,并且所有生成的图像都不够清晰.如何在Cifar-10 上生成清晰的图像,仍然是我们未来研究的重点.最后,我们定量分析了ACGAN模型生成图像的质量,所使用的指标是FID,结果见表2.

Fig.12 Generated images of DBM,real NVP,DCGAN,WGAN-GP,and ACGANmodels on cifar-10 dataset图12 DBM,Real NVP,DCGAN,WGAN-GP,以及ACGAN 模型在Cifar-10 数据集上的生成图像

Table 2 FID of ACGAN and commonly used generative models表2 ACGAN 和常用生成模型的FID

从表2 可以看出:相较于常用的生成模型,ACGAN 生成的图像具有相对更低的FID.

4 总结和展望

本文将辅助变量和流形正则项引入到能量函数中,并使用实值隐藏层单元来模拟可见单位的概率.我们验证了ARBM 和ADBN 在图像生成任务中的有效性.为了融合卷积深度神经网络生成清晰锐利的图像,本文提出了一种ACGAN 模型.实验验证了该模型的有效性.但是,ARBM 仍然存在一些问题,传统的算法(PCD 算法和改变Gibbs 采样)在训练ARBM 时是非常耗时的.目前,无向图的训练算法主要有变分法、马尔可夫链和基于对抗损失的训练方法.优化无向图的训练算法仍然是我们未来研究的重点.