基于深度学习的水稻表型特征提取和穗质量预测研究

2021-02-02杨万里段凌凤杨万能

杨万里,段凌凤,杨万能

1.华中农业大学工学院,武汉 430070; 2.华中农业大学作物遗传改良国家重点实验室,武汉 430070

我国是世界上最大的稻米消费国[1],为提高我国稻米的自给率,水稻单产的持续增加一直是育种和栽培研究的重要目标[2-3],精准的产量预测可以加快育种的速度并为粮食的种植提供指导[4]。水稻穗部的表型特征、穗数、稻穗的投影面积等与产量有着极为密切的关系[5],而且穗部表型特征的识别在水稻的病虫害检测、营养分析、抽穗期的检测具有重要的指导意义[6-7]。因此,水稻稻穗准确识别和分割是水稻产量预测和表型研究的关键。

随着近年水稻功能基因组学的发展,准确快速获取大规模群体表型数据对水稻的育种和改良具有重要意义[8-9],而传统的表型数据获取往往需要进行大量的人工实验且费时费力,自动化快速的表型提取方法可以突破传统水稻表型技术的瓶颈,加快水稻育种速度。现有研究通过图像颜色特征分割果穗[10-12],但是这种方法分割的准确度不高且容易产生噪声,不能满足复杂环境下稻穗分割的要求。随着深度学习的快速发展,其在作物果穗的识别和分割上得到广泛应用。Ghosal等[13]提出一种基于卷积神经网络的高粱穗的计数方法;Xiong等[14]提出一种基于卷积神经网络的Panicle-SEG网络进行水稻稻穗分割,针对复杂环境具有很好的适应性;Sadeghi-Tehran等[15]提出一种基于简单线性迭代聚类和深度卷积神经网络的田间小麦穗自动技术的系统DeepCount;段凌凤等[16]对多个大田稻穗分割模型进行比较,得出基于SegNet的卷积神经网络分割效果与耗时的性价比最高。部分研究基于土壤性质[17]、气温、降水[18]等因素并结合遥感技术预测大田水稻产量,但该方法无法预测单株水稻产量。由于水稻产量预测可以更好地为生长发育、遗传育种等研究提供数据支持,因此,精确提取水稻整株和穗部的表型特征数据及产量预测,是未来水稻育种和表型组学研究的重要内容。

本研究使用卷积神经网络SegNet[19]和Faster R-CNN[20]对盆栽水稻稻穗分别进行分割和穗数计数,基于分割后稻穗图像,提取穗部图像的表型特征,结合整株水稻的颜色纹理等表型特征,构建盆栽水稻稻穗鲜质量、干质量预测模型,旨在为水稻穗质量预测提供新的思路和方法,进一步提高水稻穗质量预测的准确性。

1 材料与方法

1.1 图像采集系统

图像采集系统如图1A所示,采用自动化工业流水线表型检测平台获取图像[8],盆栽水稻通过送检线运送到旋转台,按照等角度旋转13次共360°,位于水稻侧面的可见光工业相机(AVT Stingray F-504)在每次旋转的间隙拍摄,每盆水稻共采集13张侧视png格式的RGB图片,图像的分辨率为2 452像素×2 056像素,自动采集图像并储存至工作站,检测完毕的水稻通过出检线送出。

1.2 试验材料与数据

本试验的水稻品种为华粳295,试验基地位于华中农业大学盆栽场,水稻种植于塑料盆中。盆钵规格为下部直径16 cm、上部直径19.5 cm、盆高19 cm,每盆均装入5.0 kg风干土壤,添加适量水将水稻幼苗种植其中,共83盆,试验期间适时追肥、人工除草和病虫害防治。在水稻蜡熟期采集了1 079张RGB图像,图像获取后,人工统计每株水稻的穗数,并将穗部剪下称质量,记作穗鲜质量(FW),烘干后再次称质量,记作穗干质量(DW)。Faster R-CNN模型训练数据集材料,共322盆水稻,生长环境与华粳295相同,共采集了4 186张RGB图片。

1.3 基于Faster R-CNN的穗数计数模型

使用Faster R-CNN目标检测网络对稻穗进行计数[20]。Faster R-CNN网络主要包括:特征提取网络CNN、区域建议网络RPN、特征金字塔网络FPN以及目标区域池化ROI pooling层、分类和回归层。特征提取网络CNN采用ResNet101残差网络结构,其中包括卷积层、激活层和池化层,其作用是在训练过程中对输入CNN网络的图片进行特征提取并输出特征图;FPN结构将不同卷积层的特征图生成一个特征图金字塔,将特征图金字塔输入区域建议网络RPN得到候选区域;目标区域池化层将每个候选区域映射到特征图上,然后对每个区域进行最大池化得到区域建议特征图;分类和回归层根据输入的区域建议特征图输出候选区域的类别和检测框。

训练数据集使用322盆水稻拍摄的4 186张2 452 像素×2 056像素的盆栽水稻图片,每张图片中的水稻均抽穗。首先利用labellmg软件对目标稻穗进行标注,生成xml格式的文件,再转化为json格式的文件,4 186张图片和json文件按照3∶1的比例随机划分为训练集和验证集,随后进行模型训练,模型训练采用的是PyTorch框架,使用GPU训练,参数设置学习率为0.01,学习的动量因子为0.9,权重衰减weight_decay为0.000 1,epoch为1 000,训练后得到稻穗检测的模型。

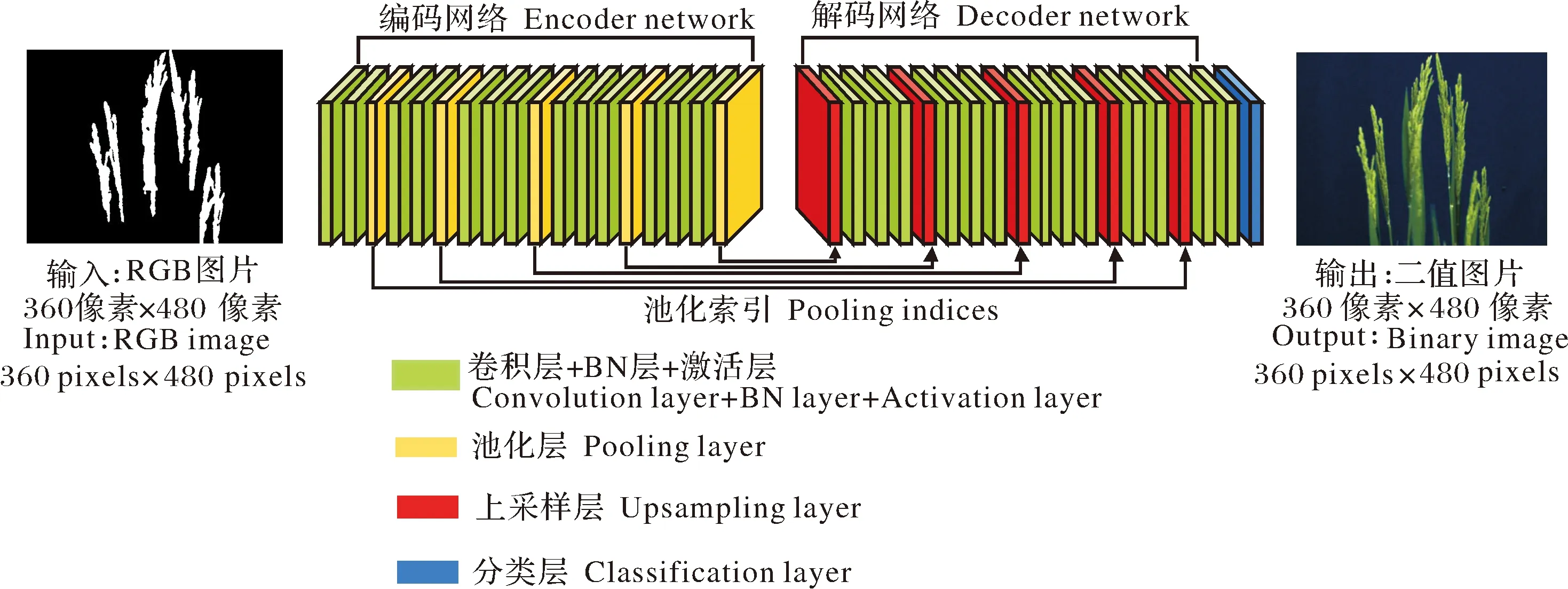

1.4 基于SegNet的稻穗分割模型

稻穗分割使用的是SegNet网络,SegNet是由剑桥大学研发的开源图像分割项目[19],网络结构如图2所示。在FCN网络结构上,搭建编码解码网络结构,从而实现从端到端的逐像素图像分割,图2中绿色部分为卷积层+BN层+激活层,黄色为池化层,红色为上采样层,蓝色为分类层。由于本研究只需要分割出稻穗,属于二分类问题,只有前景点和背景点两个类别,所以需要把SegNet最后1个输出层通道数改为2,得到本研究的网络结构。

图2 SegNet网络结构示意图

网络训练。第一步,训练数据集准备。使用Photoshop对70张2 452像素×2 056像素(高×宽)的盆栽水稻图片进行人工标注,将背景点标注为0,稻穗像素点标注为1。第二步,数据扩增。由于盆栽图片中稻穗部分前景点的像素占比很小,因此需扩大前景点样本量以保持样本平衡,首先进行图片裁剪,有稻穗的区域,使用360像素×480像素(高×宽)和480像素×360像素(高×宽)的框在该区域上、下和左、右共4个方向采用滑动窗口的形式裁剪出子图,只有背景的区域随机框出20%并裁减;对所有稻穗区域的子图进行旋转镜像实现数据扩增,得到3 960张360像素×480像素(高×宽)的子图。第三步,数据集划分。将3 960张子图按照83∶17的比例随机划分训练集和验证集,得到3 304张训练集样本和656张验证集样本,标签图采用同样的方式处理使之与子图一一对应。

由于训练样本较少,在模型训练的过程中很容易导致过拟合,所以本研究使用网络结构相似的大田稻穗分割模型PanicleNet进行网络初始化[16],以提高模型的分割精度、缩短训练时间。基于caffe平台随机梯度下降法训练,学习率设置为0.001,epoch为100即所有样本训练100次,训练集的batchsize为4,验证集的batchsize为2,学习的动量因子为0.9。

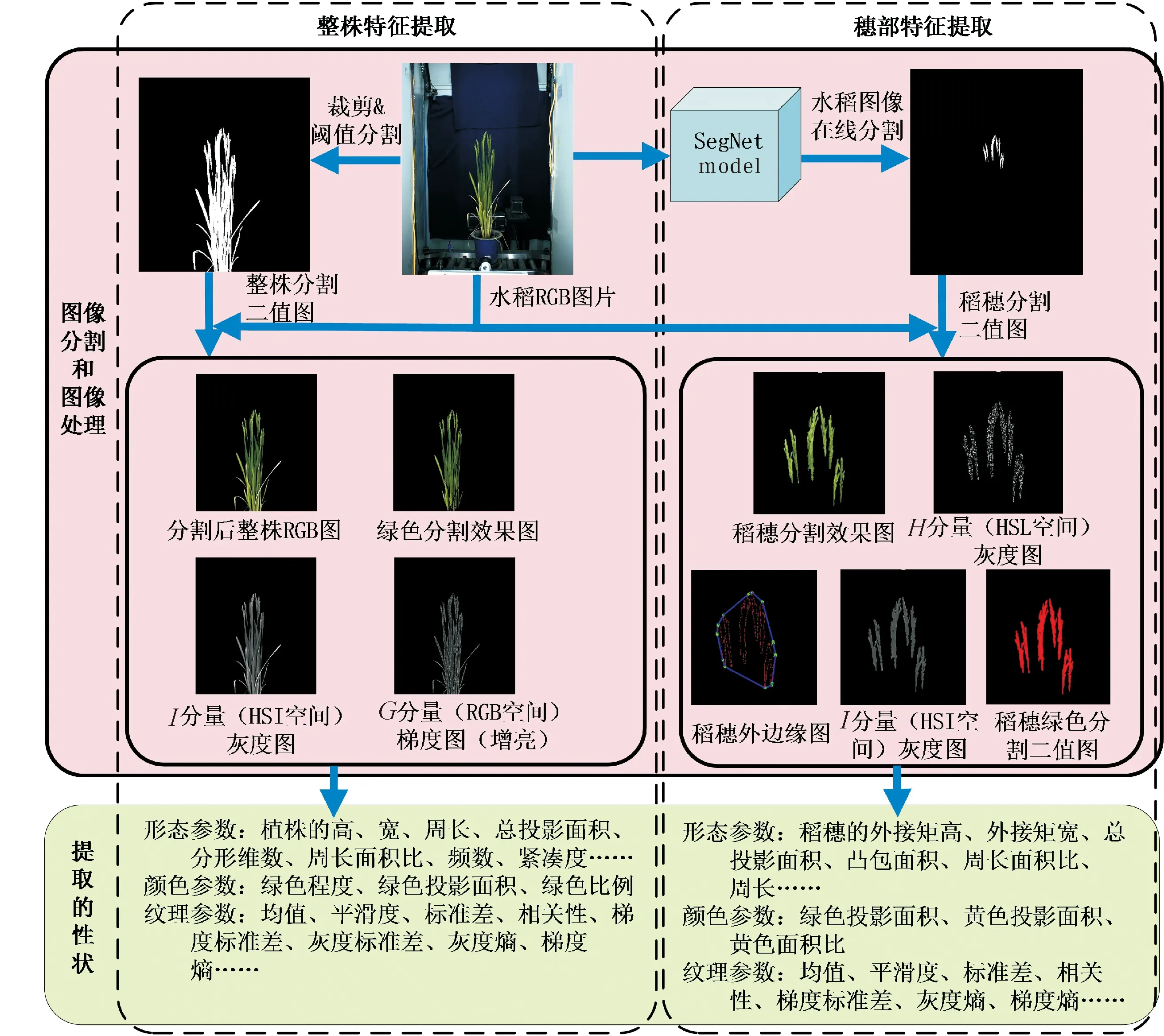

1.5 图像分割、处理及特征提取

1)整株特征提取。图3左侧为整体特征提取部分,主要处理过程如下:①预处理。对ROI区域进行裁剪。②二值化。将彩色RGB图进行阈值分割,公式为:2G-R-B≥N(其中,G为像素点的绿色分量,R为红色分量,B为蓝色分量),N=20为阈值,得到水稻植株的二值图,将整株分割的二值图与RGB图片进行掩膜得到整株分割图像。③提取绿色部分分量。使用裁剪过的植株RGB图像,利用绿色和红色分量,如果像素点绿色分量大于阈值Egthreshold并且红色分量小于阈值ERthreshold则判定为绿色部分,与原图掩膜得到绿色分割效果图,Egthreshold=0.3,ERthreshold=0.15。④将预处理的RGB图转化为HSI图像,然后提取I分量得到的灰度图像与二值图掩膜,得到最终的灰度图。⑤将预处理的RGB图转化为HSL图像,然后提取G分量的梯度图。

基于以上的图像处理过程可以提取51个整株水稻特征。高(H):植株形态参数,植株外接矩形的高度;宽(W):植株形态参数,植株外接矩形的宽度;周长/面积(PAR):植株形态参数,植株的周长与植株投影面积的比值;总投影面积(TPA):植株形态参数,植株所占的像素点个数;面积/外接矩形的面积(TBR):植株形态参数,总投影面积(TPA)与外接矩形面积的比值;高/宽(HWR):植株形态参数,外接矩形高(H)与宽(W)的比值;分形维数(FDNIC):植株形态参数,预处理裁剪后RGB图的分形维数;分形维数(FDIC):植株形态参数,植株外接矩形裁剪后RGB图的分形维数;频数(F1~F13):植株形态参数,每盆水稻每次拍摄在360°范围内拍摄13张侧视图片,统计在13张图片中每个相同位置像素点出现前景点的频数,不考虑频数为0的点,F1为13张图中相同位置只出现1次前景点的像素个数,以此类推,得到F1~F13;紧凑度(PC1-PC6):植株形态参数,反映植株的紧凑程度;绿色程度(GCV):植株颜色参数,图片中绿色部分所有像素点R分量数值的平均值;绿色投影面积(GPA):植株颜色参数,绿色部分像素点个数;绿色比例(GPAR):植株颜色参数,绿色投影面积与整株投影面积的比值;I分量灰度直方图:植株纹理参数,均值M_I、平滑度SE_I、标准差S_I、三阶矩MU3_I 、一致性U_I、熵E_I;灰度-梯度共生矩阵特征(T1~T15):植株纹理参数,包含了像素的灰度信息和梯度信息,T1~T15分别表示相关性、小梯度优势、大梯度优势、能量、灰度分布不均匀性、梯度分布不均匀性、灰度均值、梯度均值、灰度熵、梯度熵、混合熵、差分矩、逆差分矩、灰度标准差、梯度标准差。

图3 特征提取流程

2)穗部特征提取。如图3,主要处理过程:①将所有待分割的水稻盆栽图片裁剪为360像素×480像素(高×宽)的子图,输入训练好的Rice-PanicleNet模型,得到分割的二值水稻子图。将这些图片拼接得到整株的稻穗分割图,将其与原图掩膜,得到分割后的RGB稻穗图。②RGB稻穗分割效果图处理后得到H分量灰度图、稻穗外边缘图 、I分量灰度图、稻穗绿色分割二值图,图3只显示穗部区域。

基于以上图像处理过程,共提取33个穗部特征。稻穗纹理参数:均值P_M_I、平滑度P_SE_I、标准差P_S_I、三阶矩P_MU3_I 、一致性P_U_I、熵P_E_I、灰度-梯度共生矩阵特征(P_T1~P_T15);稻穗形态参数:总投影面积P_TPA、外接矩高P_H、外接矩宽P_W、总投影面积/外接矩面积P_TBR、凸包面积P_HA、投影面积/凸包面积P_THR、周长/面积P_PAR、分形维数P_FDIC、周长P_P;稻穗的颜色参数:黄色投影面积P_YPA、绿色投影面积P_GPA、黄色面积比P_YTR。

1.6 稻穗计数和稻穗分割模型的评价标准

稻穗计数模型评估,将模型统计穗数与人工统计的实际穗数进行比较,误差越小,相关性越高,则模型的计数效果越好。主要的稻穗分割评价指标有4种:交并比(IOU)、精度(Precision)、召回率(Recall)和F值(F-measure),其中,交并比(IOU)表示分割结果与实际的一致性,取值范围为[0,1],交并比值越大表示分割效果越好,一般认为IOU达到0.7以上,表明分割结果比较准确。精度表示分割为稻穗的像素点中真实样本的比例,精度越高分割效果越好。召回率是真实稻穗像素点被分割出来的比例,数值越大表示分割的完整性越好。F值是一个综合性能指标,由于实际情况中,分割精度越高,召回率就越低,两者存在矛盾,故提出由两者计算得到的F值作为一个指标,F值越大,表示分割效果越好。具体公式如下:

(1)

(2)

(3)

(4)

式(1)~(4)中,SP表示预测和真实标签都为前景点的像素个数,SF表示预测为前景点而真实标签为背景点的像素个数,TP表示预测为背景点而真实标签为前景点的像素个数,TF表示预测和真实标签都为背景点的像素个数。

2 结果与分析

2.1 基于Faster R-CNN的水稻穗数计数模型准确性评估

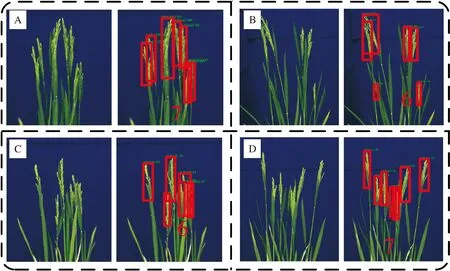

在试验过程中,人工统计了每盆水稻稻穗的穗数。在测试阶段阈值设置为0.5,利用训练好的Faster R-CNN模型,在线输入待检测的1 079张原始RGB图片,输出检测图。效果示意图见图4。图4中稻穗部分用红色矩形框标出,同时在图中显示稻穗个数。每盆水稻每次拍摄13张图片,所以检测出13个稻穗的数值,考虑到不同角度拍照时存在遮挡及稻穗重叠的现象,取13张图片中检测到稻穗数目最大值作为检测结果,记做穗数(PN)。

A、B、C、D为4组稻穗检测示意图,左边是原始图片的局部示意图,右边是检测结果输出图片。A,B,C and D are four groups of schematic diagram of rice panicle detection,the left is the local schematic diagram of the original picture,and the right is the output picture of the detection result.

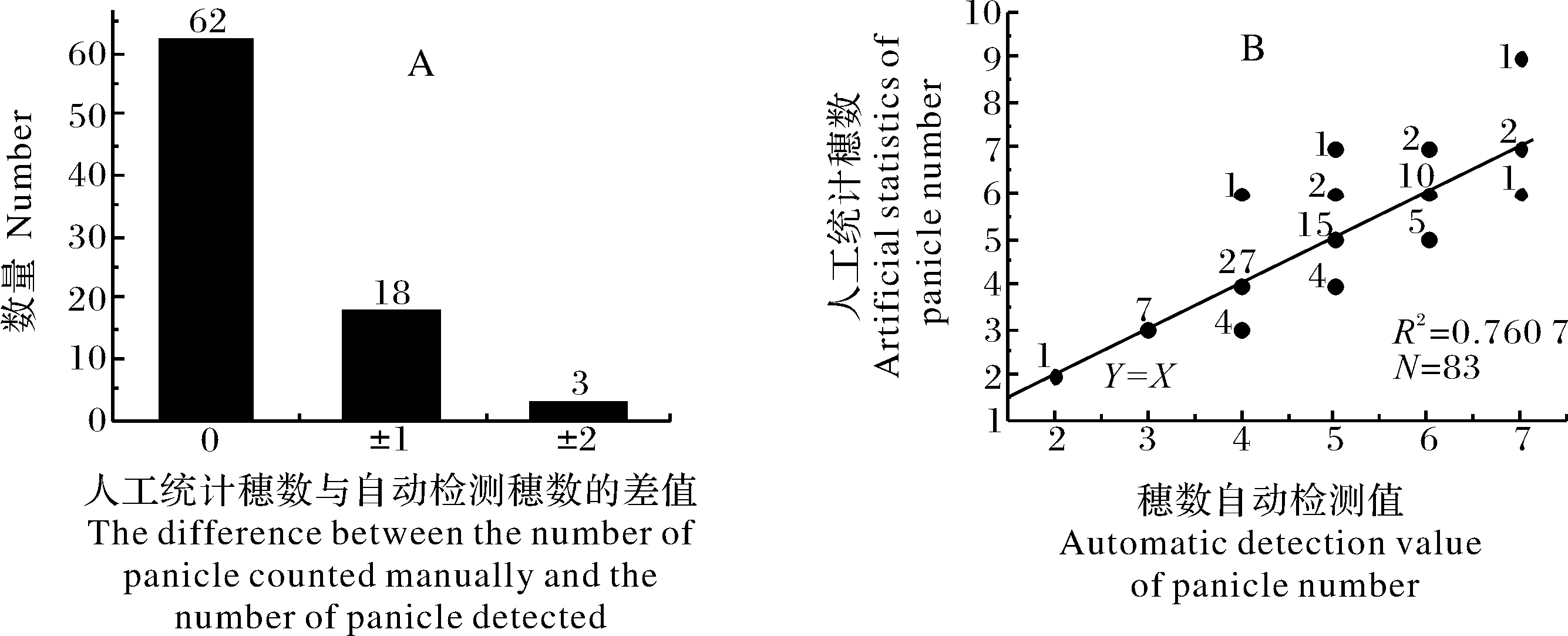

图5A为Faster R-CNN模型自动检测穗数与人工统计的每盆水稻穗数的误差。从图5可以看出,自动检测与人工统计穗数误差为0的有62盆,穗数误差为1的有18盆,穗数误差为2的有3盆;可以得出检测完全正确的盆数占总数75%,误差在±1以内的占总数96%。图5B为穗数自动检测值与人工统计穗数的散点图,每个点左侧数字为该点的数据个数,红色线为Y=X的直线,共83个数据,相关系数R2=0.760 7。

图5 穗数自动检测值与人工统计值的相关性分析

2.2 基于SegNet的稻穗分割模型准确性评估

首先,将1 079张彩色RGB原图输入训练好的SegNet模型,输出得到二值化的分割效果图,然后,随机挑选6张彩色RGB原图作为测试集,使用Photoshop人工制作标签,原始RGB图片中的稻穗用白色填充,所有的背景像素用黑色填充,得到人工二值图。将人工二值图和SegNet模型分割二值结果图进行对比,计算出每张图的IOU、Precision、Recall、F-measure。根据这些数据计算平均数。从表1可以看出,6张图片的4个评价标准的值都在0.8以上,平均值分别为0.970、0.861、91.168%、0.838,其中,综合评价参数F值达到91%以上,最能反映分割准确度的交并比平均值达到0.83以上。

表1 分割效果评估 Table 1 Segmentation effect evaluation

2.3 水稻穗质量预测模型的建立

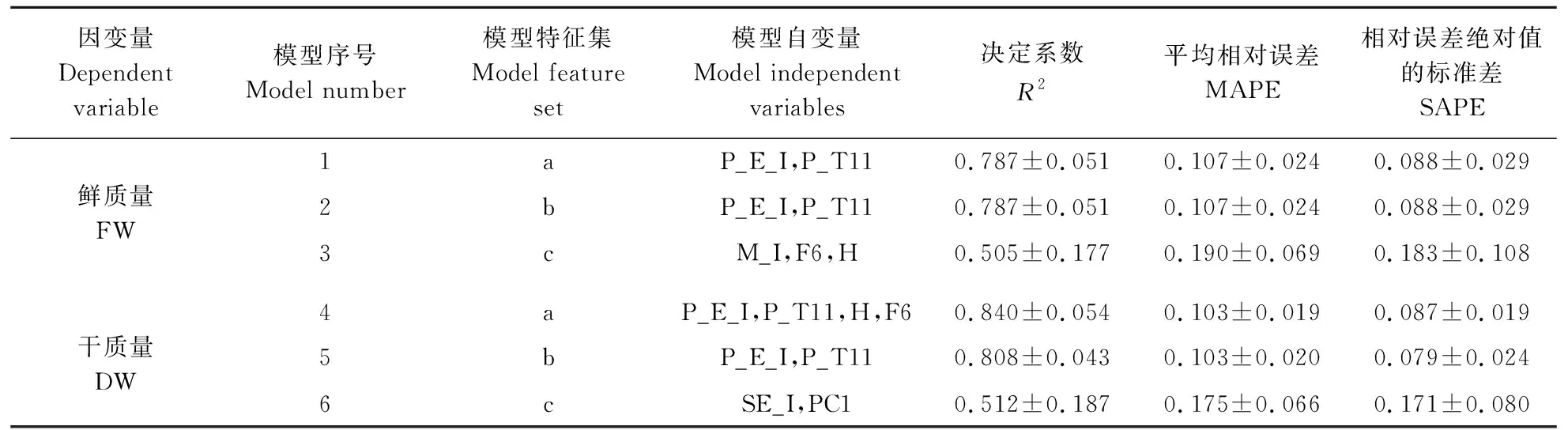

本研究提取了整株水稻51个特征数据和穗部33个特征数据,以及Faster R-CNN网络检测得到穗数(PN),共85个特征,人工统计测量得到穗数(MN)、干质量(DW)、鲜质量(FW)共3个数据。每张图片85个特征数据,每盆水稻13张图像,计算13张图片特征数据的平均值,所有数据全部归一化处理。模型分别使用干质量和鲜质量作为因变量,自变量从3种不同特征数据集中筛选:整株和穗的所有85个特征数据、Faster R-CNN网络检测得到的穗数(PN)和穗部33个特征、整株水稻的51个特征。用这些自变量分别与因变量鲜质量、干质量数据建立预测模型,使用SPSS软件进行逐步线性回归分析,若挑选出来的特征VIF低于10表示特征之间的共线性较弱,特征的Sig小于0.05表示显著,当所挑选的特征满足VIF低于10和Sig小于0.05,则用于预测模型。为了验证模型的性能,避免产生过拟合的现象,采用K折交叉验证的方法,这里K取数值5,首先将所有的数据集随机划分为5份,每次选取其中的1份作为测试集,其余4份为训练集,以此建立5个预测模型并测试,记录每次的评估参数,取平均值并计算标准偏差。本研究使用R2、MAPE和SAPE作为模型的评价指标,R2为决定系数、MAPE为平均相对误差、SAPE为相对误差绝对值的标准差,R2越高越接近于1预测效果越好,MAPE和SAPE越小表示模型越稳定拟合效果越好,建立的6个模型的拟合效果评估见表2。

由表2可知,稻穗鲜质量的3个预测模型中,穗部特征熵(P_E_I)和灰度-梯度共生矩阵特征混合熵(P_T11)作为自变量建立的模型预测效果最好,R2为0.787±0.051、MAPE为0.107±0.024、SAPE为0.088±0.029。模型1和2对比,使用所有特征和仅使用穗特征时,挑选的模型自变量一样,而模型3仅使用整株特征预测的R2为0.505±0.177,表明穗部特征作为自变量鲜质量的预测效果最好。

稻穗干质量的3个预测模型中,模型4使用所有特征预测效果最好R2为0.840±0.054、MAPE为0.103±0.019、SAPE为0.087±0.019。对比模型4和5,在没有整株特征时模型5的R2达到0.808±0.043,与模型4的R2很接近,而模型6仅使用整株特征预测时,R2为0.512±0.187,这表明当穗部特征和整株特征都作为自变量时稻穗干质量的预测效果最好。

表2 稻穗鲜质量和干质量的多个预测模型五倍交叉验证性能评估 Table 2 Five times cross validation performance evaluation of multiple prediction models for fresh and dry weight of rice panicle

6个模型拟合效果表明,对于水稻稻穗鲜质量的预测,使用穗特征预测效果较好,而使用整株特征时预测效果相对较差;对于水稻稻穗干质量的预测,穗部特征和整株特征都作为自变量预测效果最好,仅使用整株特征预测效果相对较差。

3 讨 论

本研究提出了一种针对室内盆栽水稻特征提取和穗质量预测的新方法,对比传统的表型特征获取方法,可以实现高通量并且快速的水稻特征提取。通过稻穗分割,提取了传统方法难以获取的穗部特征,然后使用特征数据对稻穗的鲜质量、干质量进行预测。本研究基于卷积神经网络Faster R-CNN实现了盆栽水稻穗数的自动检测,基于SegNet网络框架训练模型对盆栽水稻稻穗进行分割。利用RGB和HIS等颜色空间对整株水稻图片和分割后稻穗图片进行阈值分割,经过图像处理,提取了51个整株水稻特征和33个穗部特征。根据提取的85个特征数据,建立多个盆栽水稻稻穗鲜质量和干质量预测模型,使用五倍交叉验证对模型进行评估,结果表明穗部特征的预测效果最好,仅使用整株特征预测相对效果最差。水稻稻穗鲜质量预测模型中R2最高达到0.787±0.051,稻穗干质量预测模型中R2最高达到0.840±0.054。

盆栽水稻产量预测对大田产量研究具有一定的指导性,由于大田水稻生长环境的复杂性,生长过程不可控制,产量预测具有一定的误差。研究预测盆栽水稻质量,生长环境可控,因为盆栽可移动性,提取的表型数据多且数据更加精准,通过盆栽种植水稻预实验,挑选出与产量相关性高的表型特征,在研究大田水稻时关注高相关性特征,可以大幅度提高实验效率,减少实验工作量,从而快速挑选出高产品种。