拓扑自适应谐振理论在数据聚类中的应用

2020-12-07朱颖雯

朱颖雯

摘 要: 将自适应谐振理论(Adaptive Resonance Theory)与拓扑学习神经网络相结合,研究了一种新的无监督神经网络用于非平稳数据稳定在线聚类。并引入自组织增量神经网络(Self- Organising Incremental Neural Network),同时学习两种反映不同层次细节的表现方法。此网络即对噪声低敏感,又适合于解决实际问题的应用。

关键词: 在线学习; 拓扑学习; 自适应谐振理论; 聚类

中图分类号:TP391 文献标识码:A 文章编号:1006-8228(2020)11-39-04

Abstract: This paper combines ART (Adaptive Resonance Theory) with topological learning neural network to study a new unsupervised neural network for stable online clustering on non-stationary input data. In particular, SOINN (Self-Organizing Incremental Neural Network) is introduced, so that two representations to reflect different levels of detail are learnt simultaneously. The network is low sensitivity to noise, and is suitable for solving real-world problems.

Key words: on-line learning; topology learning; ART; clustering

0 引言

許多任务如基因异常诊断[1],人形机器人的交互式教学[2],以及蛋白质的显性定位[3],采用单独训练、验证和测试的传统离线学习方法均无法解决。因此增量式在线学习近年来变得越来越流行,这类机器学习技术可逐步完成知识且适应于非平稳的输入分布。

本论文研究了一种基于增量式快速在线聚类与拓扑学习相结合的新型神经网络TopoART,可以创建稳定的数据表示,并同时保持学习新数据的能力,对噪声低敏感,创建反映不同细节输入分布的层次化表示,更适合于实际应用。

1 相关工作

大多广泛使用的聚类方法,例如K-Means、谱聚类、矩阵分解,均需设置聚簇个数。聚类方法一般可分为两类:聚类趋势分析方法[4~6]和聚类验证方法[7~12]。第一种方法通过模式的相邻关系来确定数据集中的聚簇个数,而第二种方法通过评估不同聚簇的结构。两种方法均很慢,无法扩展到大规模数据聚类。K-Means算法[13]作为典型的数据聚类算法将输入分布划分为k个聚簇。每个聚簇由一个向量表示。算法中确定所需聚簇个数是关键问题。算法不考虑输入数据的拓扑结构。1982年,文献[14]提出了自组织特征映射(SOFMs),它将输入数据映射到神经元网格。参考向量被神经元的权重编码。网格具有预定义的拓扑结构,其维数通常小于或等于输入空间的维数。如事先未知输入分布,则很难选择合适的格点结构。增长型神经气(GNG)算法[15]解决了此问题。它允许新神经元的增量合并,并通过添加和删除不同神经元之间的边来学习输入分布的拓扑。但其输入分布表示不稳定,输入数据的持续呈现,即使已经被学习,也会导致神经元的权值(即参考向量)和网络拓扑持续适应。因此,已经获得的知识会因进一步的学习而丢失,称为“稳定-可塑性困境”。如果输入分布很复杂或输入数据顺序的微小变化都可能引起。

自适应谐振理论(ART)网络用于解决“稳定-可塑性困境”。此网络学习自上而下的期望并与自下而上的输入相匹配。这些期望称为类别,它将输入数据集汇总成聚簇。ART网络的类别呈现出不同的形状,如超球形[16],椭圆形[17],矩形[18]。与SOFMs和GNG相比,ART网络不能捕获输入数据的拓扑。此外,其稳定学习的能力导致了对噪声的敏感性增加。

2006年,自组织增量神经网络(SOINN)被提出[19]。与GNG类似,SOINN递增地增长神经元节点对输入数据进行聚类,神经元的权值用参考向量表示,并通过节点之间的边表示拓扑。它还有一些特性,首先,SOINN具有两层结构,表示不同级别的输入分布。这种结构降低了对噪声的敏感。第二层是在第一层训练完成之后进行的。其次,基于自适应阈值进行新颖性检测。第三,每个神经元都有一个单独的学习率,当它所代表的输入样本数量增加时,学习率就降低。通过这种方式,可以得到相对稳定的表示。但神经元的权值并没有完全稳定下来。此外,SOINN每层需要8个参数控制成为它的缺陷。

TopoART结合了ART[20-25]和拓扑学习的优点。并继承其祖先ART算法快速和稳定的在线学习能力。其类别被边管理扩展,反映输入分布的拓扑结构,可得到任意形状的聚簇。采用了SOINN在不同细节层上表示输入数据的能力;但又与SOINN不同,TopoART同时学习了两个层。

2 拓扑自适应谐振网络

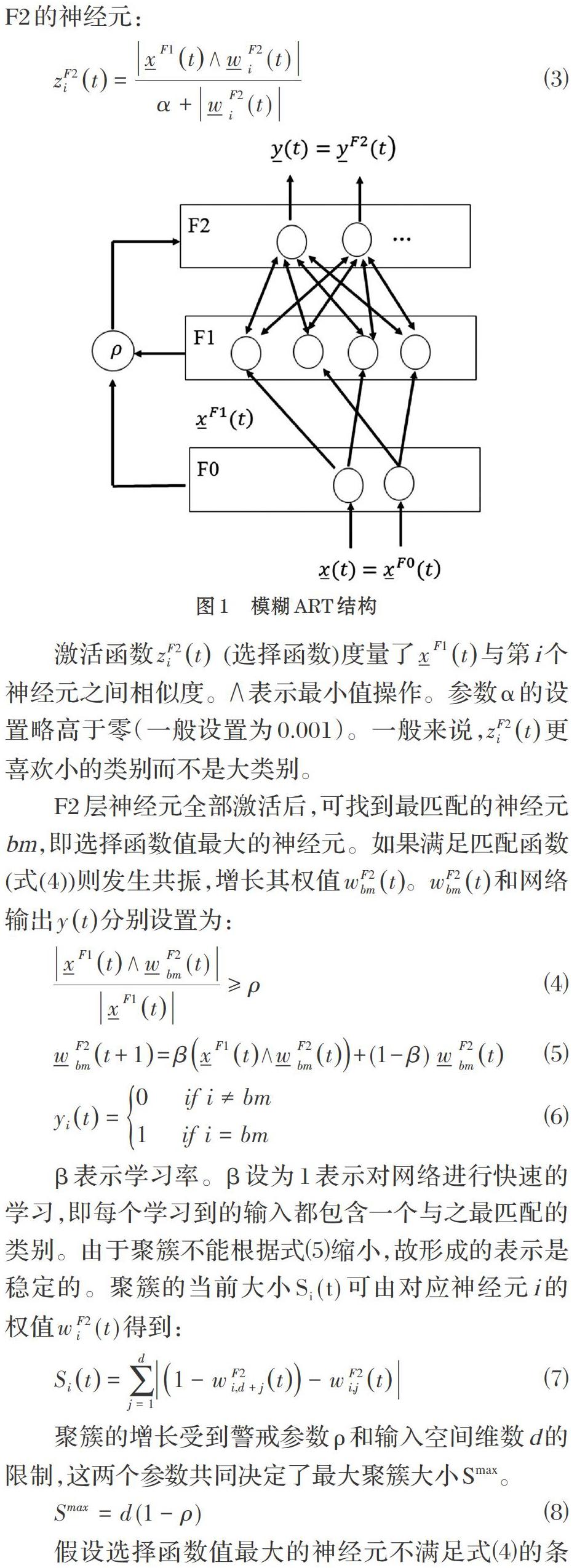

TopoART的基本结构和计算框架与模糊ART[18]密切相关。模糊ART由三层神经网络组成。初始层F0包含输入I,使用补码对输入向量[xt]进行编码。经过编码的输入向量用[xF1t]来表示,由于使用补码,输入向量[xt]的每个分量[xit]必须位于区间[0,1]。如图1所示。

输入向量[xF1t]传输到比较层F1,就激活代表层F2的神经元:

激活函数[zF2it] (选择函数)度量了[xF1t]与第i个神经元之间相似度。[∧]表示最小值操作。参数α的设置略高于零(一般设置为0.001)。一般来说,[zF2it]更喜欢小的类别而不是大类别。

F2层神经元全部激活后,可找到最匹配的神经元bm,即选择函数值最大的神经元。如果满足匹配函数(式(4))则发生共振,增长其权值[wF2bmt]。[wF2bmt]和网络输出[yt]分别设置为:

β表示学习率。β设为1表示对网络进行快速的学习,即每个学习到的输入都包含一个与之最匹配的类别。由于聚簇不能根据式⑸缩小,故形成的表示是稳定的。聚簇的当前大小[Si(t)]可由对应神经元i的权值[w F2 i(t)]得到:

聚簇的增长受到警戒参数[ρ]和输入空间维数d的限制,这两个参数共同决定了最大聚簇大小Smax。

假设选择函数值最大的神经元不满足式⑷的条件,则它的激活被重置。重新选择一个使选择函数值次大的神经元作为新的最佳匹配节点。如果均没有找到合适,则产生一个新的神经元节点,用输入向量[xt]表示,并发生共振。

TopoART由两个模糊ART(组件a和组件b)组成,使用共同的F0层进行补编码,如图2所示。但与模糊ART不同,F2层的每个神经元节点i都分别使用一个计数器[nai]和[nbi]来记录它所学习的样本数。带编码的输入向量只有在组件a中发生共振且[nabm??]时才传播到组件b中。每一轮[τ]学习循环后,所有计数器小于[?]的神经元被移除,这种神经元被称为候选节点。一旦[ni]等于或超过[?]时,它就不再被移除,这种神经元称为永久节点。通过此过程,网络对噪声变得不敏感,且仍然可以学习稳定的表示。

为了实现快速在线学习,学习率[βbm]用于调整最匹配神经元的权值,且总是设置为1,得到:

除了确定最匹配神经元bm并修改其权重,满足式⑷激活度第二的神经元sbm根据式⑽进行更新。[βsbm]应该小于1,因为神经元sbm与神经元bm相比,只是部分学习[xF1t]。

这一过程导致模型对噪声的敏感性进一步降低,因为聚簇更有可能在输入空间的相关区域增长。

如果[?=1]并且[βsbm=0],插入的节点立即成为永久节点,所有输入向量传播到组件b,在一个学习周期中只更新最匹配神经元bm的权值。这种情况下,组件a和组件b的聚簇分别等于快速学习模式下以警戒参数[ρa]和[ρb]训练的模糊ART的聚簇。

为了使TopoART能学习拓扑,如果能找到次最佳匹配神经元sbm,则在bm和sbm神经元之间建立边的连接。边连接定义了拓扑结构,不用于激活其他神经元。如果神经元bm和sbm已经连接一条边,则保持不变,与SOINN和GNG相比,这些边没有年龄参数。如果相邻的神经元中有一个被移除,那它们就会被移除。因此永久节点之间的边是稳定的,新的边仍可以被创建。这种机制构成了模糊ART解决“稳定-可塑性困境”的一种扩展,使新的输入空间表示能够同时保留已经学习的表示。

為了用组件b来细化组件a的表示,[ρb]应大于[ρa]。[ρb]根据式⑾确定,使最大聚簇大小Smax减少50%。

这样,组件b学习了一个更详细的表示,且受噪声影响较少。组件a聚簇之间的连接可以在组件b中分割,从而产生对输入数据的层次表示。

两个TopoART组件的输出[yt]均可用模糊ART的方法计算。从一个未标记的神经元开始,所有连接的神经元收到一个特定的标记来标记簇。然后,搜索一个新的未标记神经元。这个过程不断重复,直到没有未标记的神经元存在为止。向量[ct]提供了所有F2层神经元的簇标签。由于稳定性的原因,[yt]和[ct]的计算只考虑永久节点。通过这种方式,聚簇可以增长和融合,但它们被阻止收缩。

3 小结

TopoART成功结合了ART和拓扑学习方法的特性,聚簇通过边连接,可以形成任意形状的簇。此外,过滤机制降低了对噪声的敏感性。与SOINN相似,呈现出不同程度细节的表示。但与SOINN不同的是,其在两个层次上并行学习,仅需要设置4个参数[(βsbm,?,ρa,τ)],与SOINN相比,减少了75%,而创建的表示更稳定。

尽管要设置的参数已经很少,但TopoART仍需使用有关输入数据分布的先验来进行选择。这本身非常困难,特别是TopoART是一个在线算法。为了解决此问题,可以利用TopoART的层次结构,因其提供了输入数据分布的备选聚簇。通过学习过程中的交互,可以根据当前任务或其他标准对这些聚簇进行评价。

TopoART算法捕捉层次关系和呈现数据拓扑结构的能力对许多任务均有帮助,例如:在机器人中表示复杂的感觉和语义信息。TopoART甚至可以扩展为更全面地捕获层次关系的多层次结构。

参考文献(References):

[1] Vigdor, B., Lerner, B.: Accurate and fast off and online fuzzy ARTMAP-based image classification with application to genetic abnormality diagnosis. IEEE Transactions on Neural Networks,2006.17(5):1288-1300

[2] Goerick, C., Schm¨udderich, J., Bolder, B., JanBen, H.,Gienger, M., Bendig, A., Heckmann, M., Rodemann, T., Brandl, H., Domont, X., Mikhailova, I.: Interactive online multimodal association for internal concept building in humanoids. In: Proceedings of the IEEE-RAS International Conference on Humanoid Robots,2009:411-418

[3] Tscherepanow, M., Jensen, N., Kummert, F.: Anincremental approach to automated protein localisation. BMC Bioinformatics,2008.9(445).

[4] J. C. Bezdek and R. J. Hathaway, “VAT: A tool for visualassessment of (cluster) tendency,” in Proc. Int. Joint Conf. Neural Netw.,2002.5:2225-2230

[5] I. J. Sledge, J. M. Huband, and J. C. Bezdek, “(Automatic)cluster count extraction from unlabeled data sets,” in Proc. Int. Conf. Fuzzy Syst. Knowl. Discovery,2008.10:3-13

[6] L. Wang, C. Leckie, K. Ramamohanarao, and J. Bezdek,"Automatically determining the number of clusters in unlabeled data sets," IEEE Trans. Knowl. Data Eng.,2012.21(3):335-350

[7] W. Wang and Y. Zhang, "On fuzzy cluster validity indices,"Fuzzy Sets Syst.,2007.158(19):2095-2117

[8] J. Liang, X. Zhao, D. Li, F. Cao, and C. Dang,"Determining the number of clusters using information entropy for mixed data," Pattern Recognit.,2012.45(6):2251-2265

[9] C. A. Sugar and G. M. James, "Finding the number of clusters in a dataset:An information-theoretic approach," J. Amer. Statist. Assoc.,2003.98(463):750-763

[10] H. Sun, S. Wang, and Q. Jiang, "FCM-based model selection algorithms for determining the number of clusters," Pattern Recognit.,2004.37(10):2027-2037

[11] R. Kothari and D. Pitts, "On finding the number of clusters," Pattern Recognit.Lett.,1999.20(4):405-416

[12] J.-S. Lee and S. Olafsson, "A meta-learning approach for determining the number of clusters with consideration of nearest neighbors," Inf. Sci.,2013.232(5):208-224

[13] MacQueen, J.: Some methods for classification and analysis of multivariate observations.In:Proceedings of the Berkeley Symposium on Mathematical Statistics and Probability,1967.1:281-297

[14] Kohonen, T.: Self-organized formation of topologically correct feature maps. Biological Cybernetics,1982.43(1):59-69

[15] Fritzke, B.: A growing neural gas network learnstopologies. In: Neural Information Processing Systems,1994:625-632

[16] Anagnostopoulos, G.C., Georgiopoulos, M.: Hypersphere ART and ARTMAP for unsupervised and supervised incremental learning.In:Proceedings of the International Joint Conference on Neural Networks,2000.6:59-64

[17] Anagnostopoulos, G.C., Georgiopoulos, M.: Ellipsoid ART and ARTMAP for incremental clustering and classification. In: Proceedings of the International Joint Conference on Neural Networks,2001.2:1221-1226

[18] Carpenter, G.A., Grossberg, S., Rosen, D.B.: Fuzzy ART:Fast stable learning and categorization of analog patterns by an adaptive resonance system. Neural Networks,1991.4:759-771

[19] Furao, S., Hasegawa, O.: An incremental network for on-line unsupervised classification and topology learning. Neural Networks,2006.19:90-106

[20] Tscherepanow M, Kortkamp M, Kammer M, et al. 2011 Special Issue: A hierarchical ART network for the stable incremental learning of topological structures and associations from noisy data[J]. Neural Networks,2011.24(8):906-916

[21] Silva L E, Elnabarawy I, Wunsch D C, et al. A survey of adaptive resonance theory neural network models for engineering applications[J]. Neural Networks,2019:167-203

[22] G. A. Carpenter and S. Grossberg, "A massively parallel architecture for a self-organizing neural pattern recognition machine," Comput. Vis., Graph., Image Process.,1987.37(1):54-115

[23] G. A. Carpenter and S. Grossberg, "ART 2: Self-organization of stable category recognition codes for analog input patterns," Appl. Opt.,1987.26(23):4919-4930

[24] G. A. Carpenter, S. Grossberg, and D. B. Rosen, "ART2-A: An adaptive resonance algorithm for rapid category learning and recognition," Neural Netw.,1987.4:493-504

[25] G. A. Carpenter and S. Grossberg, "ART 3: Hierarchicalsearch using chemical transmitters in self-organizing pattern recognition architectures,"Neural Netw.,1990.3(2):129-152