扩展现实(XR)关键技术研究

2020-10-26武娟刘晓军徐晓青

[武娟 刘晓军 徐晓青]

1 引言

扩展现实,英文为“Extended Reality”或者“Cross Reality”,常见的缩写简称为“XR”或“ER”等,是指通过计算机技术和可穿戴设备产生的一个真实与虚拟结合、可人机交互的环境。扩展现实技术可以看作一种涵盖性术语,包含了虚拟现实VR、增强现实AR、混合现实MR及其他因技术进步而可能出现的新型沉浸式技术。

XR是随着计算机图形与仿真技术的不断发展而产生,沉浸式技术就是其发展的基石。首先诞生的是虚拟现实技术VR,随着VR的发展又衍生出增强现实AR、混合现实MR等。区别于传统的超文本、平面图像等二维媒介及传统3D图像/视频,沉浸式技术依托跨媒介、非结构化的视、听、触等多感官刺激途径,进一步解放人的感性思维,激发创造性思维。而在技术深度融合的大背景下,更具包容性的扩展现实横空出世,将VR、AR、MR等诸多人们所熟悉的沉浸式交互技术融合在一起,以实现虚拟世界与现实世界之间的无缝转换。

本文基于作者多年来对XR技术的追踪和研究,从技术角度全面剖析其业务形态、技术架构、关键技术等。其中第2节相关XR业务形态,讲述VR、AR和MR的三大产品形态;第3节讲述XR相关的终端、网络、平台和应用四部分构成的技术框架;第4节XR关键技术研究,重点讲述XR终端相关显示、追踪、识别等关键技术;第5节最后小结全文,分析技术走向和未来趋势。

2 业务形态

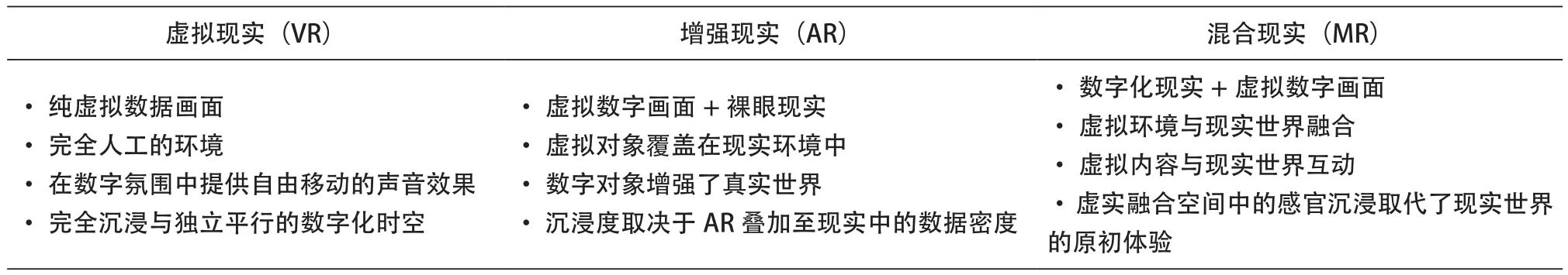

从哲学角度讲,扩展现实是创造人类 “虚实融合”的新世界模式,尤其强调在拓展现实中人类的自由意志活动。XR作为沉浸式虚拟与现实融合技术总称,从中演绎出VR(虚拟现实)、AR(增强现实)、MR(混合现实)等不同的技术分支。VR能让人完全沉浸在虚拟环境中;AR能创建一个叠加虚拟内容的世界,但不能与真实环境交互; MR则是虚拟与现实的混合体,它能创造出可以与真实环境交互的虚拟物体。

虚拟现实VR,以声音和视觉为主导,通过计算机模拟虚拟环境而给人以环境沉浸感,是一种多源信息融合的、交互式的、三维动态实景和实体行为的系统仿真。在此仿真系统中,用户必须头戴VR眼镜或者VR头显才能获得一个模拟世界360度视图。

增强现实AR,是一种实时根据现实世界的位置和角度,并加上相应的虚拟图像、三维物体的技术,说简单点就是在真实空间里叠加虚拟物体,把虚拟信息,如物体、图片、视频、声音等映射在现实环境中。

混合现实MR,是对VR和AR的进一步发展,指的是现实世界数字化,并与虚拟世界融合所产生的新世界,虚拟物体和现实世界的对象共存并且可以实时交互。

根据上述概念可知,MR和AR的区别在于,在MR的世界里,呈现在真实世界里的虚拟物体,并不会因为玩家位置改变而发生位移,它们的位置其实是相对固定的;在高级的MR世界里,用户很有可能分不清哪一个是虚拟物体,哪一个是现实物体。综上所述,有关VR、AR、MR相关对比情况,如表1所示。

表1 VR、AR、MR对比表

不过在实际产品中,AR发展的高端层次,也是要将真实世界虚拟数字化处理,因此MR和AR有时是浑然一体的,而且MR中的关键技术都是以AR技术为基础。从这个角度来看,XR从技术本质上来讲,可以分为虚拟沉浸式技术的VR和将虚拟与现实结合的AR(包括MR)两种常见的业务形态。

3 XR技术架构

XR技术框架包括终端、网络、平台和应用四部分组成,其整体技术框架如图1所示,其中终端侧,主要通过内置各种传感器、摄像头、显示屏等元器件,实现本地化的XR应用显示、位置追踪与定位、多种操控方式及本地化运行的逻辑运算和图形渲染等;网络侧为平台和终端构建畅通的传输通道,主要实现XR低时延交互、全景视频等应用内容大带宽下发等;平台侧,按照是否实现XR应用上云作为依据,分为通用功能和云化功能两类;应用侧,采用XR应用开发框架,并结合通用的图形开发引擎,完成XR应用的研发。

图1 XR技术架构图

(1)终端:作为XR服务的用户端设备入口,主要实现XR服务的显示、定位与追踪、操控等功能以及本地化的逻辑运算、图形渲染等功能。

① 高清显示:采用全景拼接/FOV裁剪等画面显示技术,双目渲染/注视点渲染/增强渲染等图形渲染及光场显示等技术,实现高清显示功能。

② 位置追踪与定位:主要通过内置终端的磁力仪、加速度计、陀螺仪、深度摄像头等,实现针对当前位置和周边环境或虚拟空间物体之间相对关系的确定。技术实现方式包括激光定位、红外光学和可见光定位等。

③ 拟人式操控:包括键鼠操控、遥控器操控、语音识别、手势识别和脑波识别等多种操控技术。

④ 本地运行相关功能:在XR服务本地化运行模式下,需要在终端实现XR应用导入、逻辑处理和图形渲染输出等功能。

(2)网络:为了满足XR超低时延交互,需要提供低时延的传输保障;为了满足XR全景画面等传输需求,需要提供大通道的网络传输机制。同时包括为了实现精致的XR内容和降低网络传输压力,所采用的创新边缘计算部署等。

(3)平台:从服务角度,提供XR的用户管理、应用管理、终端管理、运维管理等运营服务,应用部署、渠道分发等营销服务及支付计费、内容接入、终端适配等能力服务。XR云化模式,还需提供云化移植、云端运行、图形渲染等云端XR功能

(4)应用:主要是指各种XR应用的内容研发,包括XR专属的开发框架及通用的图形开发引擎等,通过二者的结合,实现各种XR应用的逻辑编程、图形渲染和定位操控等开发工作。

4 XR关键技术

XR当前还是以终端运行为主,因此XR终端测的处理技术尤为重要,本章将聚焦XR相关终端的关键技术。XR终端以三维高清显示技术,构建沉浸式的视觉体验;以精准追踪定位技术,构建拟人式的操作体验;以精准识别技术,构建现实与虚拟之间无缝衔接的桥梁。

4.1 XR显示技术

XR中的显示技术要服务于XR显示的结果,即具有真实世界的色彩、情景化的感官体验。显示效果直接决定了用户的体验,包括全景拼接、FOV、全息投影、3D立体技术等关键技术。

4.1.1 全景拼接技术

全景拼接技术,通过相机的平移或者旋转拍摄的一组和多组具有部分重合的照片拼接成一个360度的全景平面图像,然后通过计算机技术实现全方位互动式观看真实场景的技术。目前,全景图像可分为柱面、立方体、球面等形式。

① 柱面全景图,将全景图像投影到以相机视点为中心的圆柱体内表面,由于圆柱体的图特性,这种全景图可以实现水平方向360度的连续旋转。柱面全景图因其技术简单,发展成熟成为大多数构建全景图虚拟场景的基础。

② 立方体全景图,全景图投影到一个由6个平面投影组成的立方体内表面上,以实现水平方向360度旋转、垂直方向180俯仰的观看视线。但是立方体全景图的采集和相机的标定难度较大,需要采用特殊的拍摄装置,依次在水平、垂直方向拍摄照片以获得六张用于无缝拼接立体全景图的照片。

③ 球面全景图,全景图投影到一个以相机视点为中心的球体内表面,可以实现水平方向360度、垂直方向180度俯仰的观察视线。但是因其需要将平面图投影成球面图像,而球面为不可扩展曲面。因此球面全景图的拼接相比柱面全景图更为的复杂。

全景拼接一般包括以下几个步骤。

(1)图像获取

全景拼接由于利用的是部分重合的图像进行拼接,因此拍摄照片的镜头焦距、倾斜、方位角差异必须一致,此外还要经过图像坐标变换、图像畸变矫正等操作处理后,以得到利于后续全景拼接的图像。最后将处理好的图像以图像投影变换的方式投影到统一的空间面上,如平面体、圆柱体、立方体和球形表面等。

(2)图像匹配

在统一的空间对相邻图像利用非特征的匹配、基于特征的匹配等方法进行对比,以确定图像匹配的区域位置,为后续融合做好区域基础。

(3)拼接融合全景图像

基于以上步骤得到的图像匹配关系,进行全景图像拼接操作,图像拼接的关键步骤是拼接和融合。

① 拼接

拼接的目的是根据几何运动模型,将图像注册到同一个坐标系中,采用几何运动模型主要有:平移模型、相似性模型、仿射模型和透视模型。若相机仅仅产生了平移运动,则可以采用平移模型;若相机除了产生平移运动,还发生了旋转运动,则可以采用相似性模型。

② 融合

图像拼接之后,需要对图像重合部分进行融合处理。融合结果最终决定了全景图像拼接质量。融合技术一般可分为非多分辨率技术和多分辨率技术两类。在非多分辨率技术中主要有平均值法、帽子函数法、加权平均法和中值滤波法等。多分辨率技术主要有高斯金字塔、拉普拉斯金字塔、对比度金字塔,梯度金字塔和小波等。

(4)均衡亮度和颜色

因为拍摄时光照强度的差异,导致拼接后的图像亮度不均匀,从而影响用户的感观。处理过程中必须依赖均衡亮度和颜色操作,通过相机的光泽模型,矫正图像内的光照不均匀,再建立相邻图像之间直方图映射表,根据映射表对图像做整体映射变换,最终达到整体亮度和颜色的一致性。

4.1.2 FOV技术

FOV(Field Of View),指视场角。根据应用场景不同,其定义也不尽相同。在光学仪器中,是指以被测目标的物像通过镜头的最大范围的两条边缘构成的夹角, FOV的大小决定了光学仪器的视野范围。

根据显示效果不同,VR的核心在于全景显示,根据VR设备的不同,VR全景显示对FOV的要求也不同。

无论是VR设备还是AR设备,FOV技术都是支撑其达到完美效果显示的不可或缺的技术,不同之处在于VR一体机头显需要大于120度的视场角;VR移动设备需要与之尺寸匹配的视场角;而AR讲究增大视场角的同时,需保证AR设备能够全天舒适佩戴。

4.1.3 全息投影技术

全息投影技术(front-projected holographic display)是一种基于光的干涉和衍射原理,并利用投影设备将不同角度的影响内容投影拼接至全息图上,以此还原物体真实三维图像的技术,呈现出的三维立体图形为XR环境提供具有视觉感知性功能。因为在原始光场中,由于原始物体的缺失不复存在时,相片是无法直接保存到相位信息,通过引入参考光波与物光波产生干涉,把相位信息保存在条纹中;用参考光波照射全息图,就可以再现(衍射)出物光波。全息投影技术包括拍摄和成像两步骤,相关观察如图2所示。

图2 全息投影实现过程

全息投影技术是使用一种激光光源来记录图像,并组成各种排列方式,常见的排列方式是激光束被分成两束,一束被称为目标光束,另一束被称为参考光束。拍摄过程是利用光的干涉原理,将目标光束照射被摄物体,以形成满射式的物光束。参考光束照射到全息投影胶片上与物光束叠加产生干涉信息,利用干涉条纹间的反差和间隔将物体光波各点的相位信息、振幅信息和光强信息记录下来。记录着干涉条纹的底片经过显影、定影等处理程序后,便成为一张全息图度。

4.2 XR定位技术

由于XR是模拟、修改现实,所以需要准确地追踪对象是如何在现实中移动,并映射在XR环境中,产生相应的效果。实现XR场景里的空间定位以及更多的人机交互,精度高、延迟低的追踪定位技术是目前的主流。目其主要技术流派包括:外向内追踪OutSide-in和内向外追踪Inside-out。

4.2.1 外向内追踪技术(OutSide-in Tracking)

外向追踪技术,是依靠外接各种定位设备(如基站、信标、追踪塔或摄像头)的追踪定位方式。outside-in具有高定位精度和低延迟等特点,是目前XR追踪定位技术的主流,但因其固定的外接设备,限制了可移动范围,XR沉浸感也被限制。目前outside-in定位技术又可分为北斗定位技术、光学定位技术、WiFi定位技术、低功耗蓝牙定位技术和超声波定位技术等。

(1)北斗定位技术,利用55颗工作卫星发射信号,确定待测点的位置。北斗定位系统覆盖全球,系统比较完善,但是因为其信号受建筑物的影响,且定位精度相对较低的缺点,导致在XR领域中的应用非常有限。

(2)光学定位技术,根据利用的光学和标记发光点技术不同,可分为激光定位、红外光定位、可见光定位等。基于光学的追踪定位技术实现产品化,并逐步应用在XR终端产品、线下门店、体验馆等商业场景中。目前outside-in追踪定位的主流技术是光学定位技术。

激光定位最具代表性的技术是Lighthouse(俗称:灯塔),灯塔是由Vavle推出VR定位技术,并将该定位技术运用到了Vavle开发的steamVR系统中,该系统可以让用户佩戴VR头盔并在15*15米的空间范围内自由移动,该空间范围可以根据实际空间大小进行调整。Lighthouse定位技术的原理是利用房间中由基站发射出的密度极大的非可见光,来探测室内佩戴VR设备玩家的位置和动作变化,并将其模拟在虚拟现实空间中。

红外光定位技术是通过外部放置摄像头,拍摄头盔或者控制器上的光点,来推算出设备的位置,而其中最具代表性的红外光定位技术是Oculus Rift的红外主动式光学技术。

(3)WiFi定位技术,利用手机无线局域网接入点来推断用户的位置信息。依据无线AP MAC地址的唯一性,设备在开启WiFi时,即可扫描并接收其周围的AP信号。随后设备将收集的AP信息传输到位置服务器,服务器根据之前存入的AP位置信息,并结合每个AP信号的强弱程度,利用不同的算法,计算出设备的位置并返回给用户设备。WiFi定位具有大范围定位、方便组网、便于扩展等优势,但是由于其需要知道大量固定AP的位置,需定期更新位置服务器库,不便于维护。

(4)低功耗蓝牙定位技术,通过在固定区域安装蓝牙局域网接入点,把网络配置成基于多用户的基础网络连接模式,用以发射蓝牙信息,再利用装配了低功耗蓝牙通讯功能的设备,如手机,接收发射出的蓝牙信息,以此实现定位功能。此定位技术用于小范围定位,定位精度不高,但是成本低,功耗低。

(5)超声波定位技术,依据超声波测距方法,通过安装在被测物体上的主测距器,向固定于室内环境中的接收器发射超声波,接收器接收后又反射传输给主测距离,利用反射式测距法和三角定位等算法计算出物体的位置。超声波定位技术主要用于室内定位,且整体定位精度很高,达到了厘米级,但是超声波在传播过程中衰减较大,影响其定位的有效范围。同时受多径效应和非视距传播的影响,导致精确计算分析需要很多底层硬件设备,成本较高。

4.2.2 内向外追踪技术(Inside-out Tracking)

相比outside-in技术,inside-out定位技术是不用依赖于外部硬件,而是通过内置环境感知摄像头、深度摄像头和传感器的头戴式设备实时拍摄外部图像,读取环境深度信息,从而获取位置数据。简便安装、无可移动范围限制、移动性增加和更高自由度的Inside-out定位技术更符合未来XR追踪定位技术的要求,但是也存在定位精度不高,有一定延迟等缺点。也因为不依赖于外接设备进行运算,而对头戴式设备的要求更高。虽然存在以上缺陷,但是由内向外的追踪定位技术正逐步取代由外向内的技术,成为目前XR追踪定位所研究的核心方向。

4.3 XR识别技术

人与虚拟环境的互动是XR中很重要的一部分,即人体动作的融入、虚拟环境对人体的动作产生声觉、视觉、光觉的反馈作用。所以交互的前提是精准实现到对人体各种状态的识别以及对真实物体的识别。对人体状态的识别技术目前有两种方式,一种是基于硬件的识别方式,如佩戴数据手套,第二种是基于计算机视觉技术的识别方式。

4.3.1 基于硬件的识别方式

基于硬件的识别方式,将集成传感器的可穿戴姿势输入设备与用户肢体连接,从而获取用户的肢体运动信息。目前基于硬件的识别大多数采用的是数据手套,数据手套是指在手套内集成弯曲传感器,采集手部运动数据的硬件设备。数据手套实现采集现实中手部姿势的关键在于通过覆盖手部所有关键位置的传感器和手部各关节运动自提的对应关系,对人体手部姿势的建模。

数据手套基于真实还原人体手部自然的动作,同时由于传感器的抗遮挡性和抗干扰性高,动作识别精度高。但操作者需要穿戴繁琐的设备,这种方式限制了用户和设备的自然交流,且设备的价格昂贵,难以推广使用。

4.3.2 基于计算机视觉技术的识别方式

基于计算机视觉的识别方式是利用摄像头捕捉用户的手势,并传输到计算机,计算机对手势信息进行分析处理。而对真实物体的识别大多数采用计算机视觉技术,该方法具有方便、直观、成本低等优势,因此应用于XR领域中。

基于计算机视觉技术的识别流程,如图3所示。借助摄像头将用户姿态或真实物体转换成图像信息,然后利用计算机视觉技术进行图像分析、建模和识别,最终向XR应用提供处理识别后的信息,如手势、姿态、物体信息、物体位姿信息等。

图3 基于计算机视觉技术的识别流程图

基于计算机视觉技术的识别主要步骤:

(1)图像预处理:将摄像机拍摄获取到的包含人体姿态或物体信息的视频资源分割成许多静态的图片,方便计算机对内容的分析和提取。随后处理静态图片中的冗余信息,并利用平滑、滤波等手段对图像进行处理。

(2)图像分析:对处理好的图像进行分析建模,结合数学模型和图像处理技术分析底层特征和上层结构,用以获取具有一定智能性的信息。

(3)图像识别:对处理好的图像特征进行提出和分析,并利用不同的算法进行计算,同时将计算后的信息与系统设定的图像信息进行对比,从而完成图像的识别。

5 结束语

本文简要概括了扩展现实(XR)基础概念、业务形态等相关内容;随后分析和研究了囊括终端、网络、平台和应用等四方面的总体技术架构;最后重点研究XR终端相关的显示、定位和识别等关键技术。XR行业的发展,还需破除终端门槛较高、用户体验尚需提升等问题,需要通过业务上云、终端精准定位与识别等方面不断完善,才能满足规模产品化的要求。