协同关系下多媒体运动与采摘机器人匹配设计研究

2020-10-19彭天娥

彭天娥

(重庆电子工程职业学院,重庆 401331)

0 引言

随着科技的发展,机器人的研究已经较为成熟,许多行业中已经采用机器人替代人力进行劳作。采摘机器人的主要功能是替代人力进行采摘工作[1],由于采摘目标具有随机分布性,且易被树枝树叶等遮挡,造成采摘机器人目标识别与定位效果差[2],加大了采摘机器人手臂运动的难度。

以往采摘机器人大多通过机器视觉技术划分每个机械臂的作业区间,并利用编码器对每个机械臂进行编码,完成多机械臂的协同作业,此类方法对图像边缘提取过程中模糊区域的边缘提取效果较差,导致采摘效率低。目前,手机、摄像机、电脑等多媒体设备被广泛地应用,利用多媒体技术分析运动视频,获取运动特征,为运动的教学提供优秀教材[3]。将多媒体运动捕捉系统内较强的图像特征提取功能与采摘机器人的视觉系统相匹配,结合机械臂协同运动控制算法,可提升采摘机器人的目标识别能力。为此,提出协同关系下的多媒体运动与采摘机器人匹配方法,实现采摘机器人准确、快速的采摘运动,以提高采摘质量。

1 多媒体运动与采摘机器人匹配控制

1.1 多媒体运动与采摘机器人图像边缘检测匹配

获取运动比赛视频帧动作,汇总动作特征内的技术动作信息,得到运动动作的多媒体数据。采摘机器人进行采摘工作时,最关键的步骤是自动定位采摘目标[4],因此需要具备功能完善的视觉系统。将多媒体运动动作特征获取技术与采摘机器人自主定位技术相匹配,使得采摘机器人在确定采摘目标时使用多媒体运动动作特征获取技术,获得采摘目标的特征,完成自主采摘工作。

在多媒体资源中获取运动动作时,获取的动作通常为运动的视频序列,此序列为运动赛场上的视频设备得到的随时间而发生改变的图像。式(1)中描述的是依照固定的时间段落获取图像与时间之间的变化相关性,即

{g(x,y,t0),g(x,y,t1),…,g(x,y,tB-1)}

(1)

其中,g(x,y)、B、t、ti-ti-1分别表示图像、总帧数、采集图像时对应的实时时刻和时间间隔。无特定条件时,相邻图像的时间间隔一致,相比于静态图像获取动态图像得到的信息更为饱满。边缘检测时,图像获取是最关键的步骤,主要功能是得到图像潜在的信息,具体过程包括滤波、增强、检测和定位[5]。

当传感器实时采集图像时,动作速度过快导致采集图像中噪声干扰较强,因此需要滤波过程降低噪声[6];采用梯度算法使滤波后图像的梯度发生变化,增强图像模糊区域的清晰度,获取图像边缘中较为清晰的部分;对于图像边缘不清晰的部分,利用边缘检测无法获取图像边缘点,因此需设置梯度阈值,鉴定图像边缘,完成边缘检测,最终获取图像边缘的准确方位。通过上述过程得到图像的边缘,详细流程如图1所示。

图1 边缘检测的流程图Fig.1 Flow chart of edge detection。

检测边缘图像的梯度波动最大值,利用梯度值优化降低噪声干扰,实现图像边缘为准的准确定位时边缘检测算法的核心作用[7]。在边缘检测过程中采用Canny算法,在完成图像滤波的基础上检测图像最大梯度值,实现图像边缘的准确定位。检测过程中,需处理图像使之达到平滑状态,在此基础上求导。二维高斯函数为

(2)

其中,σ为高斯变化量。

用m表示一特定方向,则二维高斯函数的一阶方向导数为

(3)

(4)

(5)

其中,m和H为表示方向矢量和梯度矢量;θ为变化角度。

卷积处理图像g(x,y)与二维高斯函数的一阶方向导数,并变换m所表示的方向,在Hm·g(x,y)为最大值的条件下,得到边缘检测方向同n之间的关系为正交,那么边缘梯度为

(6)

(7)

(8)

(9)

其中,S(x,y)和φ分别为获取实时图像(x,y)点处的边缘强度和法向矢量,对H(x,y)设置一个阈值确定图像局部梯度的最大值点,以提升检测图像边缘的准确性。

图2描述的是采摘机器人采摘目标边缘检测与识别的流程设计。在对图像实施边缘检测过程中,首先获取图像边缘梯度最大值;其次设置阈值,以阈值为标准,将高于阈值的点和低于阈值的点分析进行保存和0设定;最终获取图像边缘[8],为采摘机器人采摘目标定位提供数据依据。

图2 采摘机器人采摘目标边缘检测与识别流程Fig.2 Edge Detection and Recognition Procedure of Picking Target for Picking Robot。

通过本小节所描述的过程实现多媒体运动与采摘机器人视觉图像边缘检测的匹配[9],获取采摘机器人采摘目标的精确定位;在此基础上,通过协同关系下采摘机器人运动控制算法,实现采摘机器人双臂协同控制。

1.2 协同关系下基于约束的采摘机器人运动控制算法

采摘机器人定位到采摘目标后,通过运动控制算法实现机器人采摘运动的合理控制时,应对采摘机器人设置封闭的运动链,完成采摘机器人双臂对应位姿无变化条件下的双臂协同运动[10]。详细的过程如下:

(10)

[n(ql),s(ql),a(ql)]T[n(qf),s(qf),a(qf)]=W

(11)

(12)

其中,v和u分别为采摘机器人手臂末端的线速度和角速度。

对式(10)等号两侧实施时间求导,并与式(12)相结合,获取采摘机器人两手臂末端协同运动时线速度的关系为

(13)

采摘机器人协调运动时,两手臂的角速度相同,由于两手臂末端无相对位移,即ul=uf,结合式(12)得

(14)

将式(13)与式(14)相结合,获取协同运动时主从手臂关节速度间的相关性为

(15)

实现采摘机器人双臂协同运动时,根据采摘目标定位的运动轨迹确定主动手臂的运动状态,再采用运动学反解方程确定从动手臂的初始关节位移。利用式(15)计算从动手臂的初始关节速度,当协同运动启动后,得到全部从动手臂的关节位移。当采摘机器人运动时,根据明确的主动手臂实时关节速度和式(15),确定从动手臂的关节速度,实现采摘机器人双臂协同运动。

2 实验结果与分析

为了实验验证协同关系下多媒体运动与采摘机器人匹配方法的可行性,测试了控制过程中采摘机器人采摘某果园中苹果时图像识别和定位准确率,结果如表1所示。由表1可知:本方法进行10次苹果采摘测试的图像识别准确率平均值和定位准确率平均值分别为98.35%和98.44%。这说明,本方法可准确识别图像并定位图像,进而说明了本方法控制采摘机器人的可行性。

表1 采摘机器人采摘性能测试Table 1 Picking Performance Test of Picking Robot %。

为测试本文方法对于苹果图像的识别效率,在相同的实验环境中,对比本文方法、基于编码器的采摘机器人控制方法和基于并联绳牵引的采摘机器人控制方法的图像识别效率,结果如表2所示。由表2可知:本文方法识别图像时所花费的平均时间为2.43s,基于编码器的采摘机器人控制方法和基于并联绳牵引的采摘机器人控制方法识别图像时所花费的平均时间分别为5.03s和5.20s;3种方法相比较,本文方法所花费的时间不足另外两种方法的1/2。这说明,本文方法能够有效提升采摘机器人的图像识别效率。

表2 不同方法识别图像的时间对比结果Table 2 Time comparison results of different methods for image recognition s。

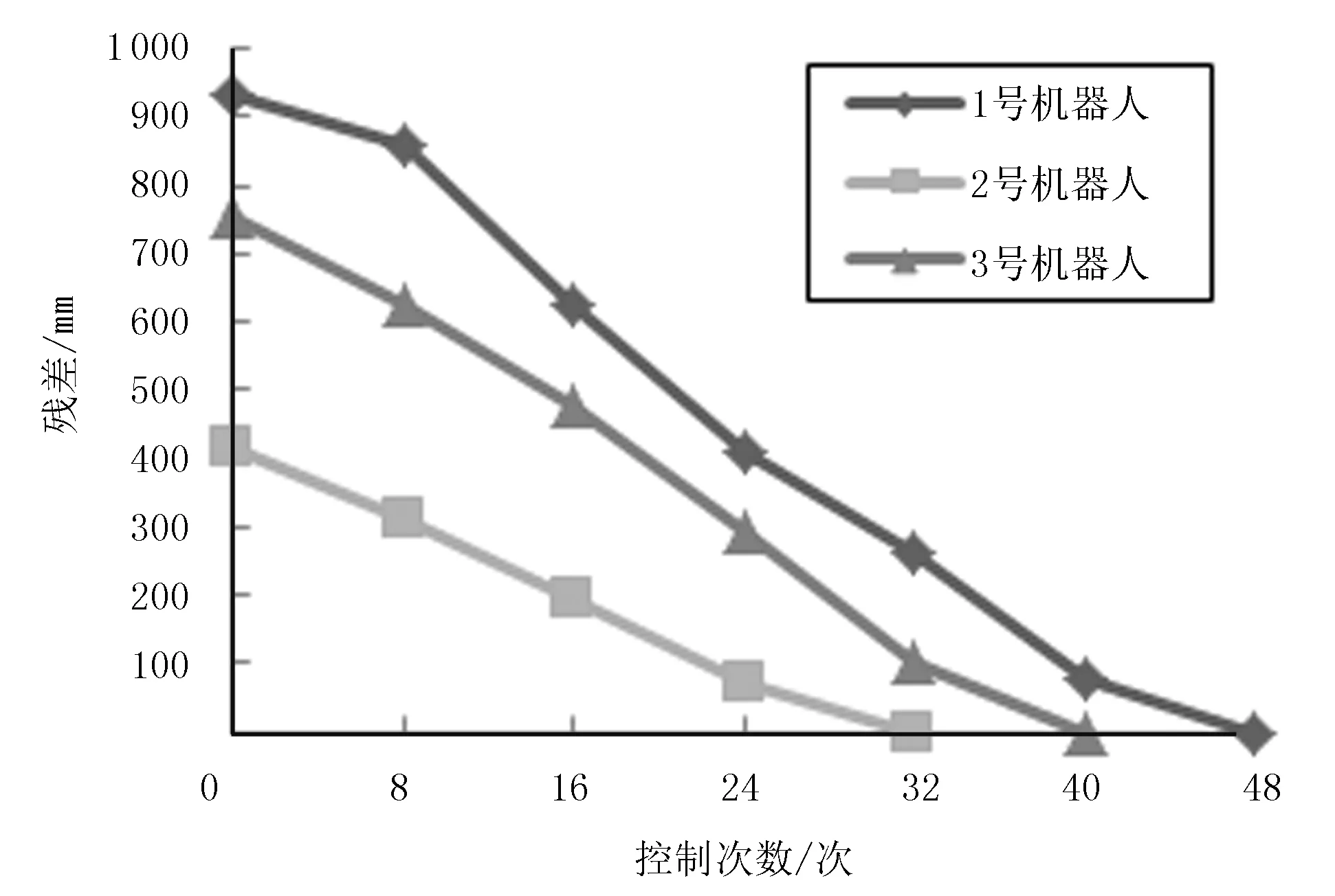

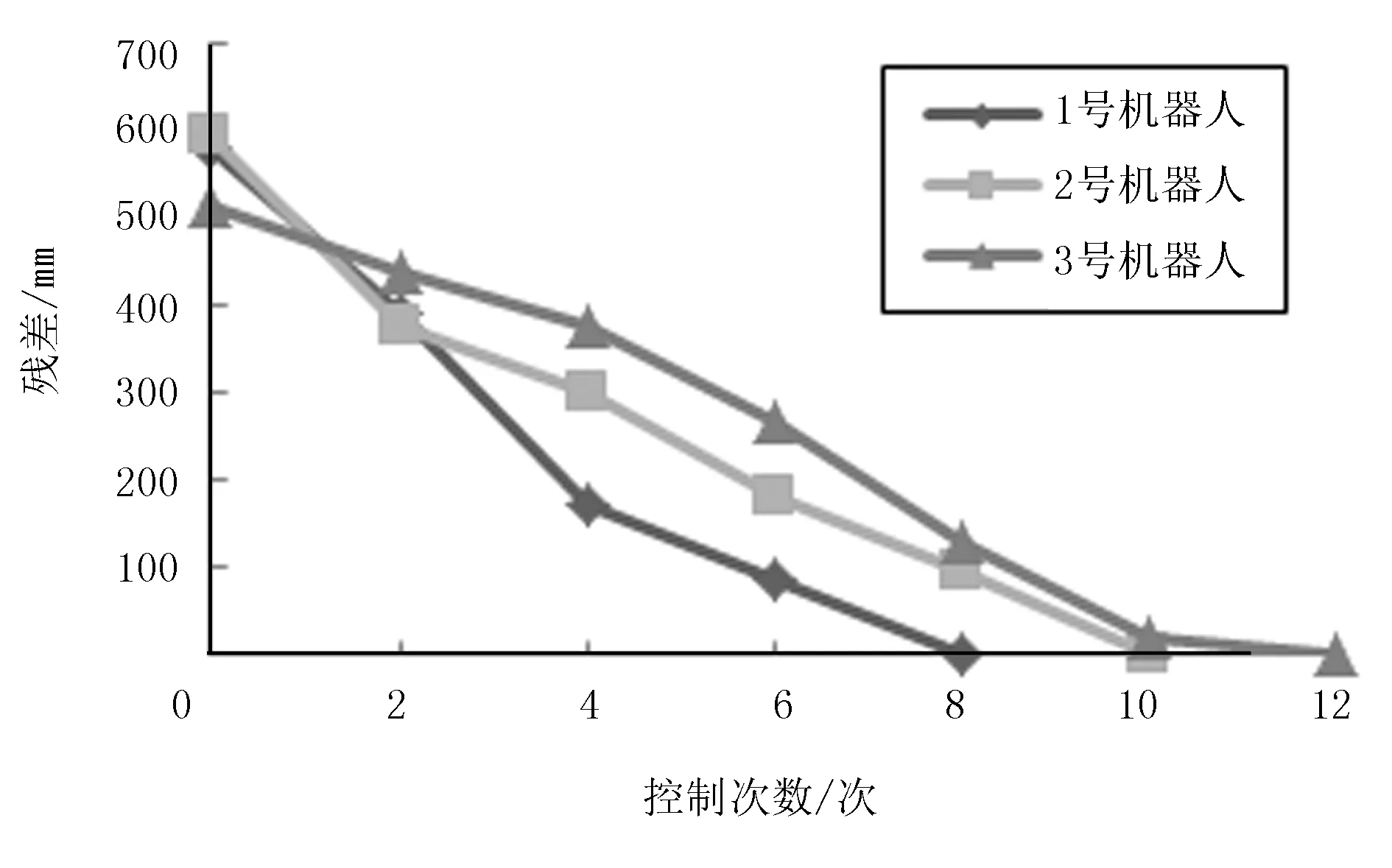

测试相同实验环境下,3种不同方法控制下采摘机器人双臂进行采摘工作时的控制误差,验证本文方法的控制精度,结果如图3~图5所示。分析图3~图5可知:基于编码器的采摘机器人控制方法控制下的3个机器人在30次控制操作内将控制误差降低至最低状态;基于并联绳牵引的采摘机器人控制方法控制下的3个机器人若将控制误差将至最低则需要32~48次控制操作,而本方法只需10次左右的控制操作即可将控制误差降至最低。同时,3种方法相比较,本文方法的控制残差明显低于另外两种方法。

图3 基于编码器的控制方法的控制误差测试Fig.3 Control Error Testing Based on Encoder Control Method。

图4 基于并联绳牵引的控制方法的控制误差测试Fig.4 Control Error Test Based on Parallel Cable Traction Control Method。

图5 本文方法的控制误差测试Fig.5 Control error test of this method。

为验证本文方法的采摘效率,采用3种不同方法进行采摘效率测试。设置统一的初始点,将采摘目标设置为20个,统计3种方法控制下的采摘机器人到达指定采摘地点并完成采摘任务共花费的时间,结果如图6所示。

图6 不同方法的采摘效率对比Fig.6 Comparison of picking efficiency of different methods。

由图6可以看出:在基于编码器的采摘机器人控制方法控制下,采摘20个目标所需的平均时间约为41.84s;在基于并联绳牵引的采摘机器人控制方法控制下,采摘20个目标所需的平均时间约为46.25s;在本文方法控制下,所需的平均时间与其他两种方法相比分别降低了12.07s和16.48s。实验表明:本文方法可降低采摘过程所需的时间,大幅提升采摘效率。

3 结论

论文提出了协同关系下的多媒体运动与采摘机器人匹配方法,将运动动作捕捉技术与采摘机器人视觉定位方法相匹配,根据运动动作捕捉的边缘检测与特征提取方法改进采摘机器人的视觉定位方法,以提高采摘机器人目标识别与定位精度。在高精度的目标识别与定位的基础上,采用基于约束的运动控制算法,基于采摘机器人双臂运动中位置、姿态及各关节速度间的约束关系,完成采摘机器人精确的双臂协同运动,可提高采摘质量。