ETL数据治理在高校信息化建设中的研究与应用

2020-08-04陈锋

陈锋

摘 要:文章首先对ETL数据处理及应用价值进行了定义和表述,并就ETL数据处理工作在高校内的具体应用场景和所面临的问题进行介绍;其次对当前高校开展ETL数据处理工作的几个主流解决方案进行了剖析,并围绕ETL数据治理工作中的ETL数据技术平台建设、ETL数据规范及从业人员队伍的整合优化等问题进行了详细阐述与分析;最后对开展ETL数据治理的意义进行了总结。

关键词:ETL;数据处理;数据治理;数据规范

中图分类号:G647;TP311.13 文献标志码:A 文章编号:1673-8454(2020)13-0068-03

ETL即Extract-Transform-Load,是指将数据从数据来源端经抽取(extract)、转换(transform)、加载(load)至数据目的端的处理过程。在大数据、移动应用技术蓬勃发展的今天,高校信息化建设正由信息管理向提供优质信息服务方向转变,当前制约高校信息化发展的瓶颈不在于智能化的多终端数据采集,不在于图形化个性化的数据展现,而在于如何对数据进行精准快速处理。ETL数据处理作为院校在信息管理、信息化服务中的一项最基本最重要的工作,它的时效性、准确性及可重用性将直接影响高校信息化服务的质量与效能。

一、ETL数据处理在高校当前的应用场景和所面临的问题

在高校信息化建设进程中,问题最多、工作量最大的环节就是从各种数据源抽取、转换和加载数据的操作,高校信息化建设中沉淀产生的数据来自不同时期、不同硬件平台、不同操作系统,数据源的多样性造成“脏数据”的大量存在。这些“脏数据”给学校教学、科研、管理等各项工作的开展都带来一定困难。

1.高校的各种数据统计报表离不开ETL數据处理

数据报表工作主要包括数据的收集、加工和上报三个工作环节,数据报表工作的本质就是一次ETL闭环过程。高校数据报表既有反映全校概况的,如高基报表、财务预决算报表;也有客观展现学校具体工作的,如专业评估报表、教科研报表等。总体来说高校报表具有专业性强、指标体系复杂、时效性高等特点。在报表工作中,由于高校业务数据库之间缺乏统一的标志,表示同一对象的数据库记录的ID不唯一;此外,用户在输入数据时,也会出现手工录入错误。这就要求报表人员要掌握计算机数据处理相关技术和方法。

2.高校的信息业务逻辑离不开ETL数据处理

ETL数据处理工作与高校信息系统的业务逻辑密不可分,如学工部门的奖勤助贷管理要根据学生家庭经济状况、个人成绩等指标进行量化赋分换算;财务部门的缴费管理要与学工系统、教务系统进行数据交换。以往这些业务数据工作由学校业务部门独立完成。由于缺乏必要数据处理规范,不同数据库对同一数据类型的实现形式不同,不同组织采用不同格式表示数据,从而导致业务部门各自的业务数据逻辑无法实现共用,其建立的计算机数据处理过程无法被复制调用。

3.高校内部的信息系统集成离不开ETL数据处理

随着高校数字校园信息平台的逐渐成熟与完善,业务信息系统与信息平台的集成需求也越来越多。信息系统的集成主要包括认证集成、门户集成和数据集成,其中数据集成是信息系统集成的核心建设内容。业务系统与数据中心集成过程中需要先修改数据标准,按其数据标准进行数据建模,最后依据数据模型来完成数据集成。这种传统的数据集成方式开发周期过长,且在业务集成过程中,学校的建设成本很大,业务系统数据集成工作往往不会一蹴而就,随着业务信息系统迭代升级,信息集成面临的困难也会越来越多。因此,如何根据业务系统集成需要,高效快速创建ETL数据处理过程,缩短数据集成开发工期,降低建设成本,是高校所面临的难点问题。

二、当前高校开展ETL数据处理所采用的技术方案

1.利用Excel完成ETL数据处理工作

Excel提供了很多数据处理和分析方法。目前常见的应用于数据处理的方法有排序、筛选、分类、汇总、合并计算及各类数据处理函数,此外,Excel还提供均值判断、概率统计、回归分析、时间序列等数据分析方法。Excel工具简单易学,目前仍是高校开展数据处理工作的主流技术手段,但Excel自身在ETL数据采集、数据加载环节上没有优势,所以一般通过VBA宏编程等手段辅助完成。

2.利用专业的ETL数据处理工具

如IBM公司的DataStage、Oracle的Warehouse Builder、Microsoft公司的DTS都能够独立完成多数据源的抽取、转换和数据维护。但这些专业ETL数据处理工具,一般需要DBA级别的数据库技术专家参与才能完成复杂的数据加工处理过程,对于一些数据需求不稳定、时效性要求高的数据转换任务,仅依靠专业的ETL数据处理工具还是难以胜任的。

综上所述,使用一种或几种技术解决方案完成学校的ETL数据处理工作有较大的局限性,只有在顶层数据治理框架下通过建立数据处理标准规范,开发数据处理系统,科学调配人员分工,才能提高学校数据处理工作的时效性、可靠性与准确性,才能让高校的计算机数据处理工作得到共享和复用。

三、高校ETL数据处理规范的制定

ETL数据处理就是把数据从数据源中抽取出来,经过清洗、转换、加载到目标数据集的过程,在信息技术中称之为一次工程(project)。一个完整的ETL数据处理工程由数据抽取、数据转换、数据加载、日志系统四个模块组成。同时,每个模块下,又由很多具体的ETL操作指令组合而成。每个具体的ETL操作,则称之为一个任务(task)。为保证每一个ETL数据处理工程(project)都能够被规范化设计、实施和维护,就必须制定出高校自己的ETL数据处理规范。

高校ETL数据处理规范主要包括设计规范、开发规范及维护规范。其中设计规范包括数据源的规范化定义和表述,目标数据集的规范化定义和表述,数据抽取、转换规则的定义,数据处理流程的规范化描述;ETL数据处理规范一般采用标准XML文档来进行描述和约束。即每一项ETL数据处理工程(project)都由一份完整的XML文档进行描述:XML文档中会包含一个名为“Project ”的根元素,“Project”元素下包含“Extract”、“Transform”、“Load”和“Log”四个子元素,这四个元素标签分别对应于ETL project的数据抽取、数据转换、数据加载和日志四个系统模块。

每个ETL数据处理工程的基本XML文档格式如图1所示。

其中高校ETL数据处理规范的开发规范是指数据处理过程在开发过程中所遵循的章程和约束。开发规范包括命名规范、功能定义规范和结构规范,由于ETL技术平台的支撑,用户在图形界面下可视化搭建数据处理作业,技术平台能够自动生成开发规范文档,从而省去了大量工作。维护规范是指数据作业提交并执行后,系统所产生的日志、报告以及其他相关技术文档。数据作业的维护文档也同样由技术平台自动生成。ETL数据处理过程的规范化,为数据处理作业代码可读、维护和可复用提供了必要保證。

四、高校ETL数据处理信息平台的建设

ETL数据处理技术平台能够为高校用户实现轻量级数据传输和数据交换,可以帮助校方将数据从一个系统按照一定的业务规则准确无误地转换到其他业务系统或报表中。数据处理技术平台提供基于Web架构的可视化数据操作页面,允许用户通过拖拽数据处理元件完成数据的抽取、转换、清洗、加载等工作任务;同时,严格的事务控制策略和数据工作流引擎能够保证数据的安全性和可靠性。ETL数据技术处理平台自身具有数据处理技术平台的多层体系架构的特性,如图2所示。

第一层是ETL数据处理组件库。组件库包括数据连接池组件、数据清洗规则库组件、数据转换规则库组件及数据加载池组件。其中数据连接池和数据加载池组件能分别实现Access、CSV、Excel、Oracle 、MySQL等多种类数据库、数据文件导入与导出;数据转换组件能实现SQL解析、XSL转换、值映射、排序等数据转换操作,并允许用户根据需求自定义扩充转换规则;数据清洗组件可实现数据排序合并、记录关联、连接、分组、采样等记录集操作,也可实现字符串替换、校验、补全拆分等数据字段级操作,并允许用户根据需求自定义扩充数据清洗规则。

第二层是ETL数据任务执行引擎。该层根据用户提交的数据处理作业进行解析并执行;服务器根据数据作业任务量与当前可用资源自动均衡计算负载,保证多个数据作业能并发执行。

第三层是ETL数据作业编辑。该层提供计算机数据处理的可视化编辑与设计界面,用户通过简单拖拽操作就可把底层ETL数据处理组件装配成完整的数据处理作业并保存,用户无须掌握编程技术即可完成数据作业开发与维护。

第四层是ETL 作业调度及监控。ETL数据任务执行引擎将并行过程中数据作业的执行情况反馈至ETL作业调度及监控层中,系统管理员可以根据实际需求对多处并发执行的多个数据作业进行资源分配,也可以对执行中的数据作业进行暂停、恢复和中断操作。

五、高校ETL用户角色岗位分工

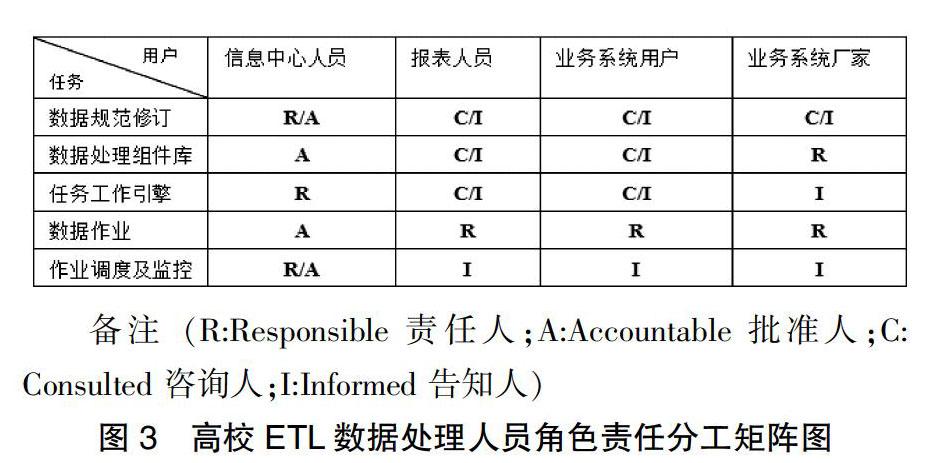

高校ETL数据处理工作主要来自于高校数据报表、内部业务部门的数据流转及业务系统的数据集成。高校从事计算机数据处理工作的人员按类别可大致分为报表填报人员、业务部门的数据流传处理人员、负责信息系统集成的校方技术人员及学校信息中心的平台维护技术人员等。为了能够优化人力资源,避免重复性劳动,要在学校数据治理层面上对ETL数据处理用户角色及岗位进行整合优化,图3是高校ETL数据处理人员角色责任分工矩阵。

高校ETL数据处理具有跨部门、跨专业的工作特性,高校ETL数据处理工作人员角色责任分工矩阵的建立,有利于ETL数据处理工作的任务分解和责任界定;角色责任分工矩阵的创建,能够帮助高校梳理ETL工作任务的性质和特点,能够更有效地分解工作任务;高校各部门也可按照责任矩阵中的角色认领工作任务,将工作落地实施;同时,高校也可按照ETL数据处理人员角色责任分工矩阵对责任部门设定可度量的绩效考核目标,进行考核评价;通过对高校ETL用户角色岗位的合理分工与整合,各单位在各个工作环节之间衔接得更加紧密、高效和顺畅。

六、结束语

基于全校总体数据治理设计框架的全局ETL数据整合方案,能够将以往高校内部各部门分散的数据处理工作整合起来,将凌乱无序的数据处理技术方法通过ETL数据处理技术平台统一起来;此外,ETL数据整合方案确定了数据处理从业人员的角色分工,让全校数据处理工作人员都能人尽其职、人尽其能,充分挖掘调动智力资源,避免了人力浪费;基于校标的ETL数据处理技术规范保证了每一份处理作业的质量和时效性。规范化标准化的数据处理作业具备可维护性、可移植性、可复用性,能够大大减少基层数据处理人员的重复性劳动,能够大幅提升高校的数据质量和信息服务水平。

参考文献:

[1]王卓昊,杨冬菊,徐晨阳.基于ISE算法的分布式ETL任务调度策略研究[J].计算机科学,2019(12):1-7.

[2]赵志.教育大数据统计分析平台设计与研究[D]. 西安:西安理工大学,2019.

[3]王梦洁.基于ETL的数据集成平台的设计与实现[D].西安:西安电子科技大学,2019.

[4]范江波.基于Oracle ESB建设校园服务体系的实践与探索[J].中国教育信息化,2016(19):57-60.

[5]潘彬.改进的ETL框架及其数据清洗方法研究[D].南充:西华大学,2019.

[6]周宇.基于模型转换的ETL代码生成方法研究及应用[D].重庆:重庆邮电大学,2018.

[7]周春红.ETL在BI项目中的设计与实现[D].上海:东华大学,2016.

[8]姚志鹏.数据抽取、转换、加载描述规范的研究与应用[D].青岛:青岛大学,2013.

(编辑:王天鹏)