基于神经网络的HEVC帧间预测

2020-07-04王洋高文

王洋 高文

摘要:高效视频编码标准HEVC是最新的数字视频编码标准,其中,帧间预测在去除时域相关性方面扮演重要角色。在传统的帧间预测方法中,因为仅仅利用了时域信息,所以帧间预测的准确性是有限的。在本文中,提出了利用时域-空域信息的基于神经网络的HEVC帧间预测算法。具体来讲,在本文提出的算法中,首先设计了一个包含全连接网络(fully connected network,FCN)和卷积神经网络(convolutional neural network,CNN)的神经网络结构。其次,时域相邻像素和空域相邻像素输入到FCN网络,FCN网络输出的结果和当前预测块输入到CNN网络中,CNN网络生成最终的当前块的更准确的预测块。实验结果表明,与HEVC参考软件HM 16.9在通用测试条件Low Delay P(LDP)下编码,本文提出的算法能够带来平均1.7%(高达8.6%)的BD-rate节省。

关键词: HEVC; 帧间预测; 神经网络; 卷积神经网络; 全连接网络

【Abstract】 HEVC is the latest video coding standard, in which inter prediction plays an important role to reduce the temporal redundancy. The accuracy of inter prediction is limited since only temporal information is used in conventional algorithms. This paper proposes a neural network based inter prediction algorithm for HEVC by using the spatial-temporal information. In the proposed algorithm, first a neural network architecture is designed consisting of a fully connected network (FCN) and a convolutional neural network (CNN). Then the spatial neighboring pixels and the temporal neighboring pixels are inputted into FCN. The output of FCN and the prediction of current block are inputted into CNN, which will generate the more accurate prediction of current block. Experimental results demonstrate that the proposed method can achieve average 1.7% (up to 8.6%) BD-rate reduction in low delay P test condition compared to HM 16.9.

【Key words】 HEVC; inter prediction; neural network; CNN; FCN

0 引 言

随着通信技术、互联网技术的发展和移动终端、智能设备的普及,作为信息载体的视频在人们生活的方方面面都扮演着不可或缺的角色。数字广播电视、互联网视频、视频会议、远程医疗、远程教育等传统多媒体应用一直影响和改变着人们的工作学习和生活娱乐的方式。视频数据呈爆炸式增长,给数据存储和网络传输带来巨大挑战,如何稳定高效地存储和传输海量的视频数据成为目前亟待解决的问题。为了高效地压缩高清和超高清数字视频,国际标准组织制定了相应的数字视频编码标准。国际的视频编码联合协作组JCTVC制定的高效视频编码标准HEVC于2013年1月正式发布,相比于上一代数字视频编码标准H.264/AVC,在获得相同主观质量的条件下,HEVC能够节省大约50%的码率,极大地提高了视频编码的压缩性能。HEVC中的帧间预测方法中,能够很好的处理视频中的平移运动。然而,自然视频中的运动类型种类多样、复杂性高,简单的平移运动并不能涵盖所有的情况。自然视频中会包含许多复杂的运动,如非线性的亮度变化、缩放和模糊等。

1 提出的基于神经网络的HEVC帧间预测算法

在本节中,将详述本次研究所提出的基于神经网络的HEVC帧间预测算法。首先,简要讨论了HEVC的帧间预测和本文所用的基础网络VRCNN;其次,介绍提出的算法的网络结构;再次,给出了本文设计的网络的训练策略;最后,将本文提出的算法集成到HEVC以提高其压缩性能。

1.1 HEVC帧间预测及VRCNN

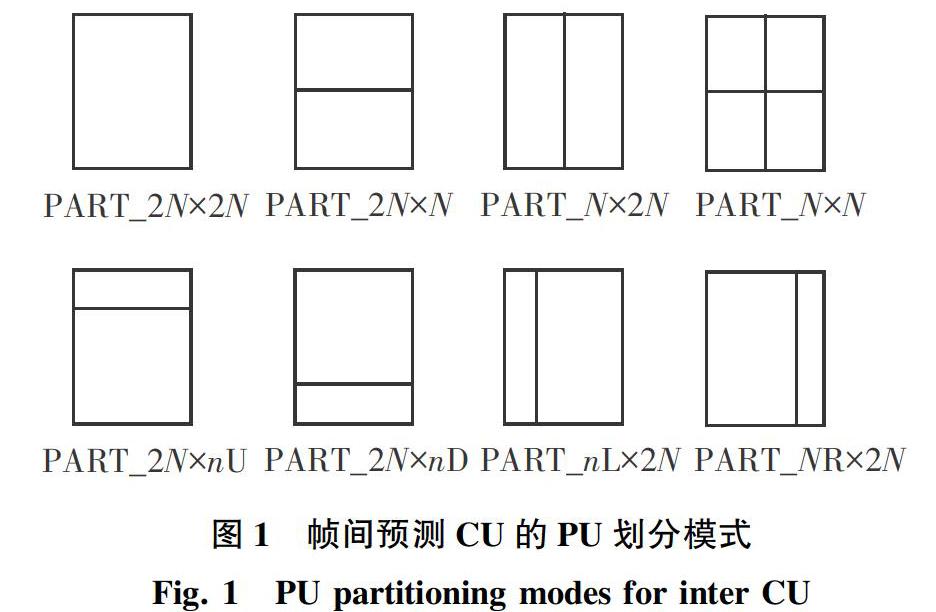

帧间预测在HEVC中发挥着重要作用,可以通过提高帧间预测的准确性,从而提高HEVC的压缩性能。编码单元(Coding Unit,CU)是HEVC中编码的基本单位,每个CU都被设定为一种预测模式:帧内预测或帧间预测。每个CU都包含了一个或多个预测单元(Prediction Unit,PU)。 如图1所示,对于帧间编码的CU,一共有8种PU划分模式。

HEVC中使用帧间预测进行编码和解码的简化框图如图2所示。在编码端,帧间预测用于生成当前块的预测,或者使用常规的帧间预测模式,或者使用Merge模式。常规的帧间预测模式中,运动估计用来获取运動矢量(motion vector,MV),这个MV在运动补偿中用来生成最终的预测值。之后,变换、量化、熵编码用来生成最终的码流。在解码端,从熵解码阶段获取MV和残差,通过将残差与预测值相加获取重构视频。

本文的网络结构中利用了文献[1]提出的VRCNN网络,VRCNN用来去除HEVC帧内编码产生的噪声。研究可知,VRCNN的结构。见表1。VRCNN中有4个全卷积层,其中第二层和第三层采用了可变滤波尺寸,不同的滤波尺寸卷积层产生的特征图聚合到一起,并输入到下一层。第一层和最后一层不使用可变的滤波尺寸。VRCNN采用了最近发明的残差学习技术[2],因此网络的输出加上网络输入为最终的结果。

由图5(a)可知,在HEVC编码的过程中,NNIP用在帧间预测之后。研究发现,与相邻像素、时域相邻像素和当前块的预测值输入到NNIP网络,NNIP网络的输出是提升后的当前块的预测值。由图5(b)可知,在HEVC的解码过程中,NNIP也是应用在帧间预测后用来生成当前块更加准确的预测块。

本文提出的NNIP算法能够提高HEVC帧间预测的准确性。首先,空域相邻像素和是与相邻像素通过FCN学习得到相互之间的相关性;其次,这个结果和当前块的预测值相加,相加的结果用CNN进一步提升性能。在本文中,只有HEVC的亮度分量用NNIP来提升性能,NNIP算法仅应用在常规帧间预测、Merge模式和Skip模式的2N×2N的PU划分的CU上。考虑到一些简单的纹理使用传统的帧间预测方法能够很好地获取当前块的预测值,因此对于使用一个CU级别的标志位来表示这个CU是否使用NNIP方法,是否使用NNIP方法通过率失真优化(rate distortion optimization,RDO)来决定。

2 实验结果及分析

在本节中,研究进行了大量的实验来验证提出的基于神经网络的HEVC帧间预测算法的有效性。对此可做研究分述如下。

2.1 实验配置

本文提出的NNIP算法集成到HEVC的参考软件HM 16.9中,实验中遵循HEVC的通用测试条件[4]配置編解码器,使用LDP配置来验证NNIP在HEVC上的性能。一共18个8位深的视频测试序列用来验证结果,编码其中的前64帧,用到的测试序列为:Class A (2 560×1 080,4 K×2 K)、Class B ,(1 920×1 080,1 080P)、Class C(832×480,WVGA)、Class D(416×240,QWVGA)、Class E(1 280×720,720P)。实验中使用的QP为22、27、32、37。使用的机器的配置是主频为3.4 GHz的Intel i7-6700QP处理器和64 GB的内存,操作系统为Microsoft Windows Server 2012 R2。HM 16.9和提出的NNIP算法都使用Microsoft Visual Studio 2013编译,当把NNIP集成到HEVC时,NNIP网络的前馈操作使用GPU版本的Caffe来实现。

2.2 NNIP的压缩性能

使用双三次插值的Bjontegaard失真率(BD-rate)[15]来评估NNIP的压缩性能。对于BD-rate,负数表示相同质量下比特率节省,正数表示相同质量下比特率增加。和HM 16.9相比,NNIP的压缩性能见表2。由表2可知,本文提出的算法在亮度分量上,能够获得平均1.7%(最大达8.6%)的性能提升,验证了本文算法的有效性。

由表2可知,对于所有的测试序列,本文提出的NNIP算法都能够带来性能的提升。但是,对于不同的测试序列,压缩性能的提升变化比较明显,表明提出的NNIP的算法受视频序列内容的影响比较大。本文提出的NNIP算法对于运动剧烈或者纹理丰富的视频序列能够带来比较好的压缩性能,如BasketballDrive、BQTerrace、BQMall。此外,对于会议视频,如Class E,NNIP的压缩性能也是十分可观的。尽管研究中使用了3个HEVC的视频序列来训练网络,但是这三个序列的压缩性能并没有比其它序列的性能获得显著提升。在将来的工作中,研究会扩展训练集并且去除HEVC的测试序列,用以有效验证提出的NNIP算法的有效性。

为了进一步验证提出的NNIP算法的压缩性能,研究也比较NNIP和传统帧间预测方法的主观视觉效果。如图6所示,无论对于低码率视频QP = 37、还是高码率视频QP = 27,本文提出的NNIP算法都能够获得更好的主观视觉效果。

由表3可知,使用NNIP算法时,编码时间平均增加了3 444%,解码时间平均增加了2 022%。如此高的计算复杂度主要来源于2个方面,对此则可表述如下:

(1)对于所有不同尺寸的CU的所有帧间预测模式都要进行率失真代价决策计算,会导致计算复杂度数倍地增加。

(2)相比HEVC本身算法来讲,提出的网络的前馈操作具有较高的计算复杂度。在未来的研究工作中,将会考虑开展降低算法计算复杂度方面的研究。

3 结束语

在本文中,设计研发了一种基于神经网络的HEVC帧间预测算法。研究中,提出了一种融合全连接网络和卷积神经网络的神经网络结构,其中空域相邻像素、时域相邻像素、当前块的预测值作为网络的输入。本文提出的网络能够提高HEVC中帧间预测的准确性。实验表明,所提出的NNIP算法可以获得平均1.7%(高达8.6%)的BD-rate节省。在未来的研究工作中,将探索NNIP算法在其他帧间模式的效果以及降低网络的计算复杂度。

参考文献

[1] DAI Y, LIU D, WU F. A convolutional neural network approach for post-processing in HEVC intra coding[M]// AMSALEG L, GUMUNDSSON G, GURRIN C,et al.MultiMedia Modeling. MMM 2017. Lecture Notes in Computer Science. Cham: Springer, 2017,10132:28.

[2]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition( CVPR). Las Vegas, Nevada, USA:IEEE, 2016:710.

[3] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Delving deep into rectifiers surpassing human-level performance on ImageNet classification[C]//2015 IEEE International Coference on Computer Vision(ICCV). Santiago, Chile: IEEE, 2015:1026.

[4] BOSSEN F. HM10 Common test conditions and software reference configurations[C]// 12th Joint Collaborative Team on Video Coding Meeting.Geneva:[s.n.], 2013:JCTVC-L1100.

[5]JIA Yangqing, SHELHMER E, CONAHUE J, et al. Caffe: Convolutional architecture for fast feature embedding[J]. ACM Multimedia, 2014,2:675.

[6]KINGMA D P, BA J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv:1412.6980,2014.

[7]BJNTEGAARD G. Improvements of the BD-PSNR Model, document VCEG-AI11, ITU-TVideo Coding Experts Group (VCEG)[Z].Berlin, Germany:Heinrich-Hertz-Institute, 2008.

[8] SULLIVAN G J, OHM J R, HAN W J, et al. Overview of the high efficiency video coding (HEVC) standard[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(12):1649.

[9]WIEGAND T, SULLIVAN G J, BJNTEGAARD G, et al. Overview of the H.264/AVC video coding standard[J].IEEE Transactions on Circuits and Systems for Video , 2006, 13(7):560.

[10]YIN P, TOURAPIS A M, BOYCE J. Localized weighted prediction for video coding[C]//International Sysmposium on Circuits and Systems(ISCAS 2005). Kobe, Japan:dblp,2005,5:4365.

[11]JEONG S, PARK H. Offset compensation method for skip mode in hybrid video coding[J].IEEE Transactions on Circuits and Systems for Video Technology ,2014, 24(10):1825.

[12]ZHANG Na, LU Yiran, FAN Xiaopeng, et al.Enhanced inter prediction with localized weighted prediction in HEVC[C]//2015 Visual Communications and Image Processing (VCIP). Singapore:IEEE,2015:1.

[13]DONG C, LOY C C, HE Kaiming,et al. Learning a deep convolutional network for image super-resolution[C]// European Conference on Computer Vision. Cham:Springer, 2014:184.

[14]DONG C, DENG Y, LOY C,et al.Compression artifacts reduction by a deep convolutional network[C]// 2005 IEEE International Conference on Computer Vision(ICCV). Santiago, Chile:IEEE, 2015:576.

[15]WANG Zhongyang, LIU Dong, CHANG Shiyu, et al. D3: Deep dual-domain based fast restoration of JPEG compressed images[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas, NV, USA:IEEE, 2016:2764.