基于改进的Harris角点的机载红外图像电子稳像

2020-07-01王施鳗许文海董丽丽

王施鳗,许文海,董丽丽,徐 周

基于改进的Harris角点的机载红外图像电子稳像

王施鳗,许文海,董丽丽,徐 周

(大连海事大学 信息科学技术学院,辽宁 大连 116026)

飞机飞行过程中产生的颠簸、晃动会使得采集到的红外图像序列存在抖动,影响后续对红外图像的观察,不利于对红外图像目标的识别、定位与跟踪。本文提出了一种基于改进的Harris角点法对机载红外图像进行实时电子稳像的方法。首先采用改进的Harris角点响应函数结合距离约束条件进行角点检测,该方法保证即使对图像质量较差的红外图像,也能检测出数量足够且分布均匀的角点;然后基于检测出的角点利用提出的关键帧参考方式结合多尺度的金字塔光流算法进行跟踪匹配,完成运动估计,进而实现对机载红外图像的电子稳像。用该方法对多组含有抖动的640×512尺寸的红外图像序列进行稳像处理,实验表明,本文提出的算法与传统的Harris角点检测算法相比有更好的检测效果,能够很好地去除红外机载图像序列的抖动,且能够满足50fps采集速率下的实时处理。

电子稳像;机载红外稳像;Harris角点检测;距离约束条件

0 引言

由于在高空中气流变化不均,飞机航姿不同等原因使得机载红外采集设备存在不同程度的振动,虽然稳定平台已经从机械的形式上减少了平台的振动,但不能完全将振动消除,这就使获得的红外视频图像序列随成像系统的振动而产生抖动的现象,影响后续对红外图像的观察,不利于对红外图像目标的识别、定位与跟踪。因此,使用快速有效的稳像算法去除机载红外视频图像序列中的抖动具有重要的实用价值。

电子稳像技术是利用图像处理的方法对图像序列的帧间偏移量进行补偿,消除图像序列中的随机抖动,保留主动运动,得到稳定的易于观看的视频。电子稳像算法分为3个步骤:运动估计、运动滤波和运动补偿[1-3]。为了保证稳像效果,必须使运动估计尽可能准确地计算出两帧图像间的偏移量,常见的运动估计方法有:块匹配法、灰度投影法、光流法和特征点匹配法。其中块匹配法能够检测出平移运动分量,但涉及到旋转和尺度变化的情况下块匹配的精度会受到影响,无法准确检测出复杂的抖动分量[4-5];灰度投影法是对整幅图像的行、列灰度值进行累加,以达到降维处理的目的,但无法避免前景运动物体对运动估计的影响[6];光流法具有很强大的数学理论基础,但对图像中的每一个像素点都计算其光流失量,计算量巨大,无法做到实时稳像处理[7]。特征点匹配法可以与仿射变换模型或透视变换模型结合,检测复杂的运动分量,也可以与光流法结合,以特征点代表图像信息,只求取特征点处的光流失量,大大减少了计算量,此外对光流法加入约束条件,可以剔除前景物体的光流,故特征点匹配法在当前的稳像算法研究中得到了广泛的应用。特征点匹配法中常采用的特征点有Harris角点,SIFT特征点,SURF特征点等。

文献[8]对电子稳像算法中的SIFT特征点进行了研究,文献[9-10]对SURF特征点进行了研究,研究表明,提取SIFT特征点与SURF特征点的稳像速度比提取Harris角点慢1~2个数量级。

文献[11]利用Harris角点自相关矩阵的迹生成低维描述子,降低算法复杂度,在存在亮度变化、较小的视角变化和旋转缩放的情况下,利用Harris角点进行快速图像匹配,实验证明了Harris角点的匹配效果好,但是对于小范围内存在大量角点的情况并未进行约束,角点代表性不好也增加了后续角点匹配的计算量。

目前,相关的电子稳像技术大多集中于对可见光视频序列的处理。基于红外视频图像序列的稳像方法研究较少。机载红外图像的成像质量低,所有像素点与其邻域内的像素点灰度值接近,灰度梯度差较小,能够提取的特征点少。红外探测器的图像采集帧频为50fps,而传统的可见光视频图像的帧率范围为25~30fps,更高的图像帧率对稳像算法的实时性有更高的要求,在常见的特征点中,Harris角点的提取速度最快,能够满足红外探测器图像采集实时稳像的要求。

为了解决传统Harris角点检测算法对于成像质量较低的红外图像无法检测出数量足够且均匀分布的角点,本文提出了一种基于改进的Harris角点法对机载红外图像进行实时电子稳像的方法。通过分析Harris算子的基本原理,提出采用改进的Harris角点响应函数结合距离约束条件来检测角点的方法,并对检测出的角度进行进一步的位置坐标校正,然后利用提出的关键帧参考方式结合多尺度的金字塔光流算法进行跟踪匹配,完成运动估计。实验证明,该方法在处理红外图像时易于实现,能够实时地进行稳像处理,且在工程实践中得到应用。

1 机载红外平台稳像算法设计

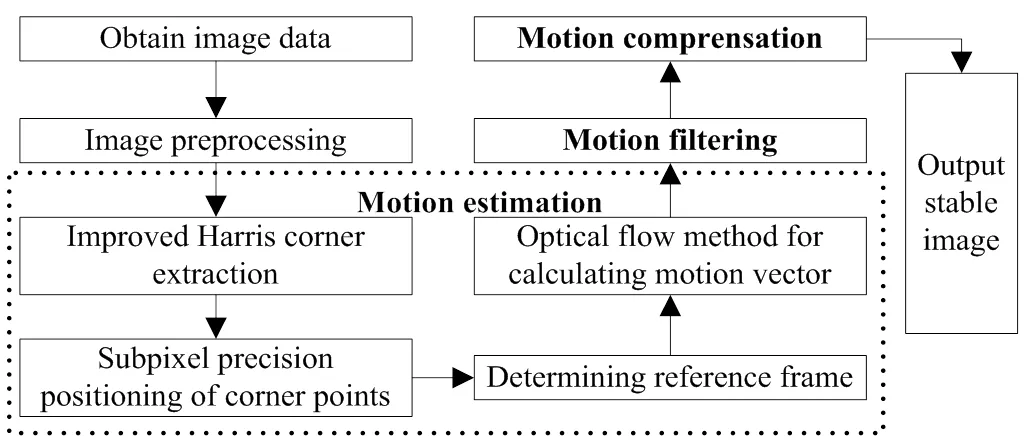

基于改进Harris角点的机载红外图像的电子稳像算法流程如图1所示,稳像算法由运动估计、运动滤波、运动补偿3个阶段组成,其中运动估计的准确性是稳像精度的重要保障。

Harris角点提取算法是寻找在邻域内水平方向和垂直方向上灰度变化剧烈的像素点,也就是灰度梯度的局部最大值点。角点数量与分布是影响运动估计准确度的一个重要因素,当角点数量过少时,角点不能很好地代表图像的特征,无法得到准确的帧间变换参数;为使得运动估计具有全局性,要利用整幅图像的特征信息,需要角点相对均匀地分布在整幅图像上,不要集中于小区域,且过多角点集中于小区域会增加后续匹配和计算帧间变换矩阵的计算量,影响算法的实时性。

图1 基本算法框架

1.1 传统的Harris角点提取

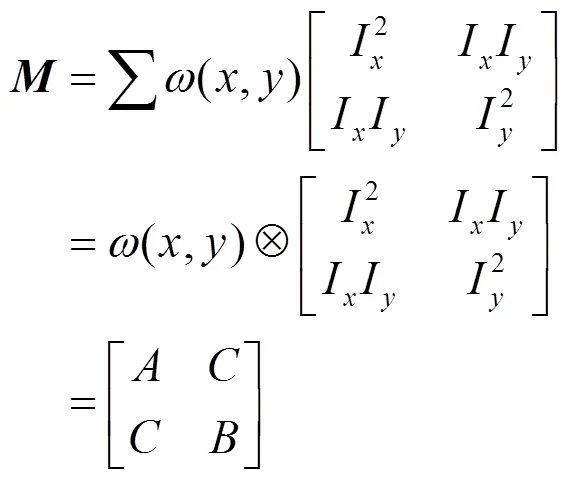

Harris角点的提取主要依赖描述像素邻域梯度分布的二阶矩,其形式如下:

式中:I,I分别代表图像(,)在方向和方向的偏导数;(,)表示高斯函数。二阶矩矩阵有两个特征值1,2,利用这两个特征值通过公式(2)计算出角点响应函数,当计算的角点响应函数的值大于给定阈值,再通过在3×3的邻域内进行非最大值抑制处理,得到的局部最大点为角点:

=1×2-×(1+2)2(2)

式中:1×2和1+2分别表示二阶矩矩阵的行列式和迹;为一个取值范围是0.04~0.06的系数[12]。

1.2 改进的Harris角点提取

由于红外图像的成像质量较低,所有像素点与其邻域内的像素点灰度值接近,灰度梯度差较小,若使用式(2)计算角点响应函数,很多情况下即使将阈值设置的很低,也无法检测出足够数量且分布均匀的角点,所以本文对Harris角点提取算法进行改进,改进了角点响应函数计算方法,加入距离约束条件,使其可以自适应地检测出足够数量的分布均匀的角点,能够很好地代表图像的特征,保证运动估计的准确性。

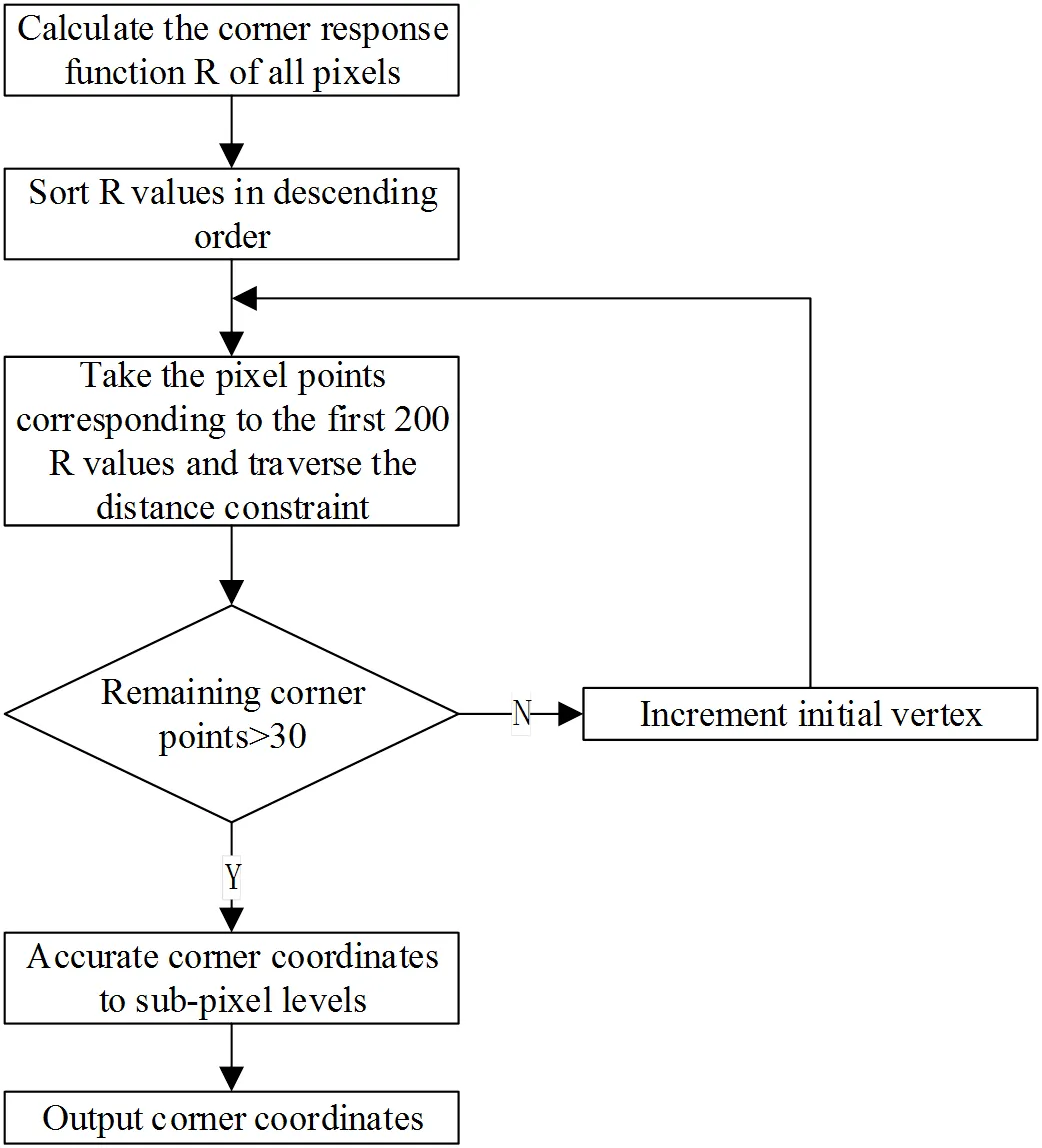

图2是改进的自适应Harris角点提取方法的流程图,首先通过公式(3)比较二阶矩矩阵的两个特征值1、2直接进行分类,求出每个像素点的较小的特征值记为角点响应函数:

=min(1,2) (3)

依据文献[13],角点响应函数值越大的点,角点的代表性越好,角点越稳定,为了筛选出符合条件的代表性最好的角点,要对角点响应函数降序排列。然后构造一个归一化的矩形窗口,窗口中的一个像素的距离相当于距离约束条件中的最小容忍距离个像素的距离,取前200个值对应的像素点标记为预选角点依次遍历,若在预选角点的四邻域内,存在已被标记为角点的点,则比较两点间的距离,若距离小于最小容忍距离个像素的距离,由于先确定为角点的像素点的值更大,角点代表性更好,故舍弃当前的像素点,否则将当前像素点标记为角点。

本文从统计学的角度出发,对包括海面大目标图像、海面小目标图像、纯海面图像以及飞机起飞时的地面图像在内的200幅中红外相机采集得到的红外图像进行实验,不断调整阈值,比较结果发现,角点数目减少到30左右时仍能较好地完成运动估计进而完成稳像,此时角点数目若再减少,人眼观看的稳像效果就有较大程度的减弱。故以30作为角点提取时数量的基准值,当真正角点个数小于30时,预选角点数递增,再次筛选真正角点。

图2 改进的Harris角点提取流程

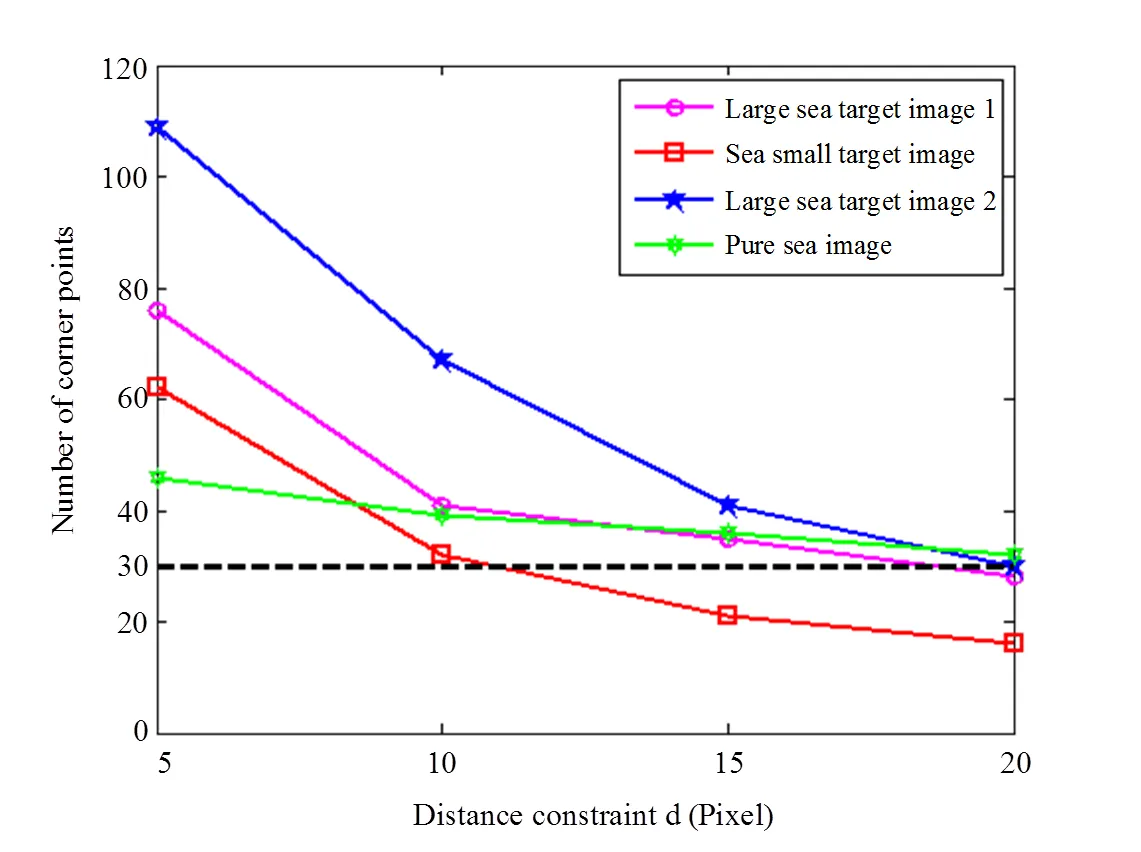

为保证角点的总数,不同图像尺寸,选择不同大小的容忍距离,一般来说图像尺寸越大,选用的越大;相同尺寸的可见光图像与红外图像,可见光图像选取的值大于红外图像。为使检测出的改进后角点的数量不小于30,对4组640×512尺寸的红外图像进行角点检测实验,结果如图3所示,可以看出取10个像素的时候,较容易达到角点数目为30的标准,且不会在较小范围内聚集很多特征点,若再增加的大小,会使角点数目减少。当增加为15个像素的时候可以看到海面小目标图像中检测到的角点数目小于30,不满足角点数量上的要求,而在海面遇险目标搜寻的过程中,海面小目标是最常见的情况,所以在距离约束时,本文取10个像素。

距离约束条件使最终提取到的角点分布均匀,不存在小区域角点聚集的情况。

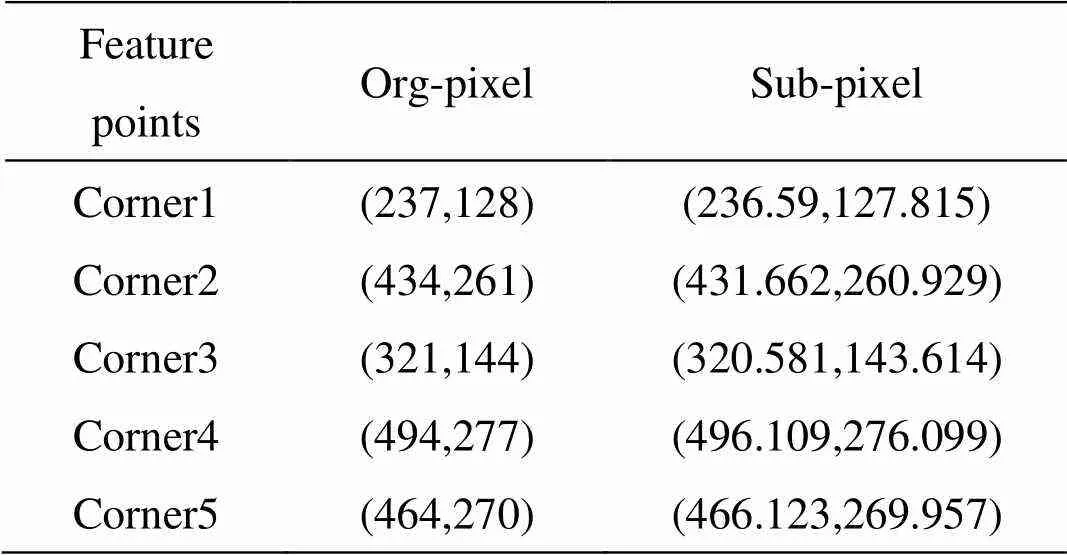

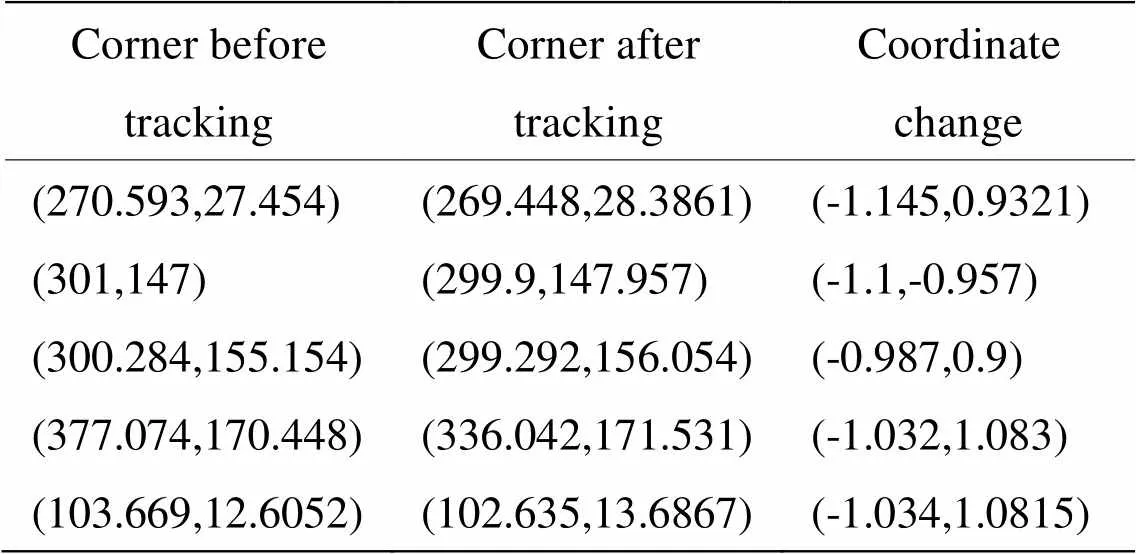

1.3 亚像素级角点定位

经过上述角点提取,会获得满足要求的角点在图像上的坐标,数字图像中像素点的位置坐标是整数的形式,为了计算更加精确的帧间光流失量,需要将角点的整数坐标精确到浮点数。亚像素级定位就是计算角点在图像中更加精确的真实坐标,而真实坐标通常不在像素所在的整数坐标位置上,而在像素的内部。本文利用向量正交性和特征点附近的灰度梯度信息,采用迭代插值的方法,通过整数角点坐标计算亚像素级角点的位置坐标。每次迭代结束后,计算本次迭代计算得到的角点与前一次迭代运算得到的角点之间的距离,若距离小于设定的误差精度阈值或迭代次数达到设定的阈值,则迭代终止。迭代终止后计算得到的坐标点与初始的整数角点之间的差值,判断迭代过程的收敛性,若迭代过程中的收敛性不好,则不使用计算得到的亚像素级角点,仍然使用初始的整数角点。表1列出一些特征点的位置坐标。

图3 角点数量与距离约束条件的关系

表1 亚像素特征点定位

1.4 关键帧参考方式

Harris特征不生成对应的描述向量,只能使用光流法跟踪下一帧对应点坐标,跟踪成功即视为成功匹配。跟踪前首先要确定参考帧,目前主要有固定参考帧和相邻参考帧两种方式:①固定参考帧方式是选择一帧作为参考帧,以后的各帧图像的运动估计都以选定的参考帧为参考。这种方式适合相机没有主动运动的场景,当主动运动存在时,参考帧与当前帧中能够跟踪成功的特征点会越来越少,以至于无法进行准确的运动估计。②相邻参考帧方式是以前一帧图像作为参考帧,即使在存在主动运动的场景中,当前帧和参考帧中也始终存在着很大的重叠区域,能够克服固定参考帧方式不适合扫描运动的缺陷。

由于红外相机的采集速率快,相邻两帧之间位移小,且要求的稳像处理速度快,在实验中我们结合已有的两种参考帧选择方式,提出了关键帧为参考帧的处理方法。每10帧更新一次关键帧,只提取关键帧图像的角点,实验证明,这种关键帧为参考帧的方式不会影响运动估计的精度和稳像后的视觉效果,并且有利于加快稳像处理的速度。

2 实验结果分析

为了验证本文方法的有效性,采用3个典型的海面红外图像序列:海面小目标红外图像、海面大目标的红外图像、纯海面红外图像进行实验,图像分辨率都为640×512。本实验的计算机采用Intel奔腾处理器,CPU主频4.00GHz,操作系统是64位的Windows系统。开发平台是Microsoft Visual Studio 2013,算法使用C++实现,调用Opencv2.4.9完成红外图像的处理如读入、拷贝、创建矩阵以及调用相关图像处理算法。

2.1 特征点提取及匹配实验

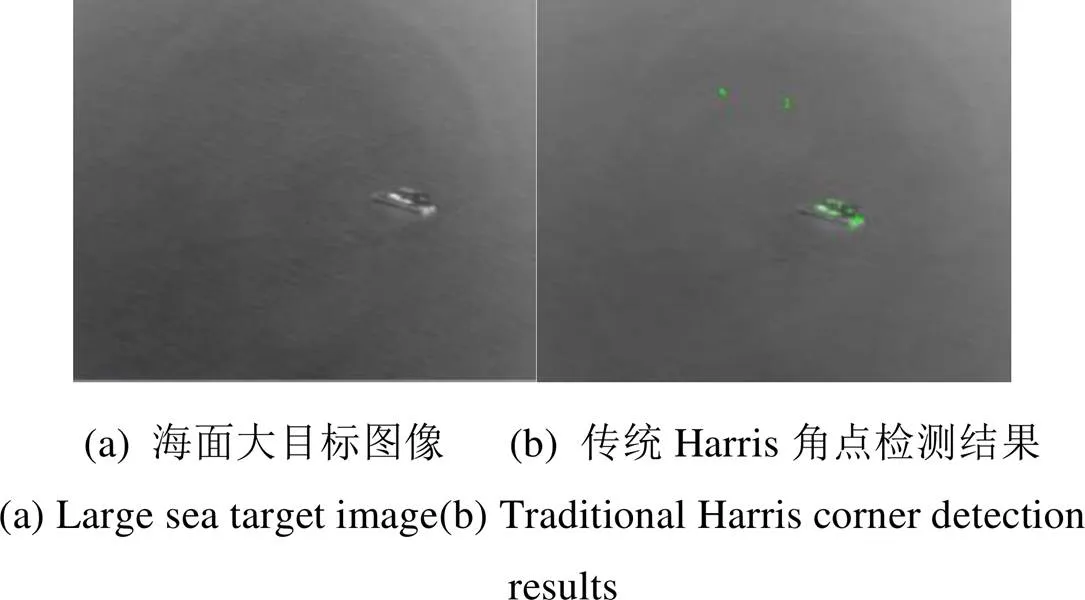

图4(a)是海面大目标红外图像,图4(b)是传统的Harris角点检测算法的提取结果,在检测过程中,计算出的角点响应函数的值如图4(c)中圆形空心标记点所示,实心三角形标记点为3×3的邻域内进行非最大值抑制处理后得到的局部最大点,也就是角点。在检测角点时,阈值通常设置为角点响应函数最大值max的倍,一般取0.005~0.015,当取0.005时,图4(a)中检测出的角点个数为14个,降低阈值的取值,取为0.0001,是一般情况下值的1/50倍,检测出的角点个数为20个。从图4(b)中可以看出,传统的Harris角点提取算法提取到的角点位置集中,分布不均匀;图4(c)中可以看出,传统的Harris角点提取算法无法对红外图像提取出足够数量的角点。

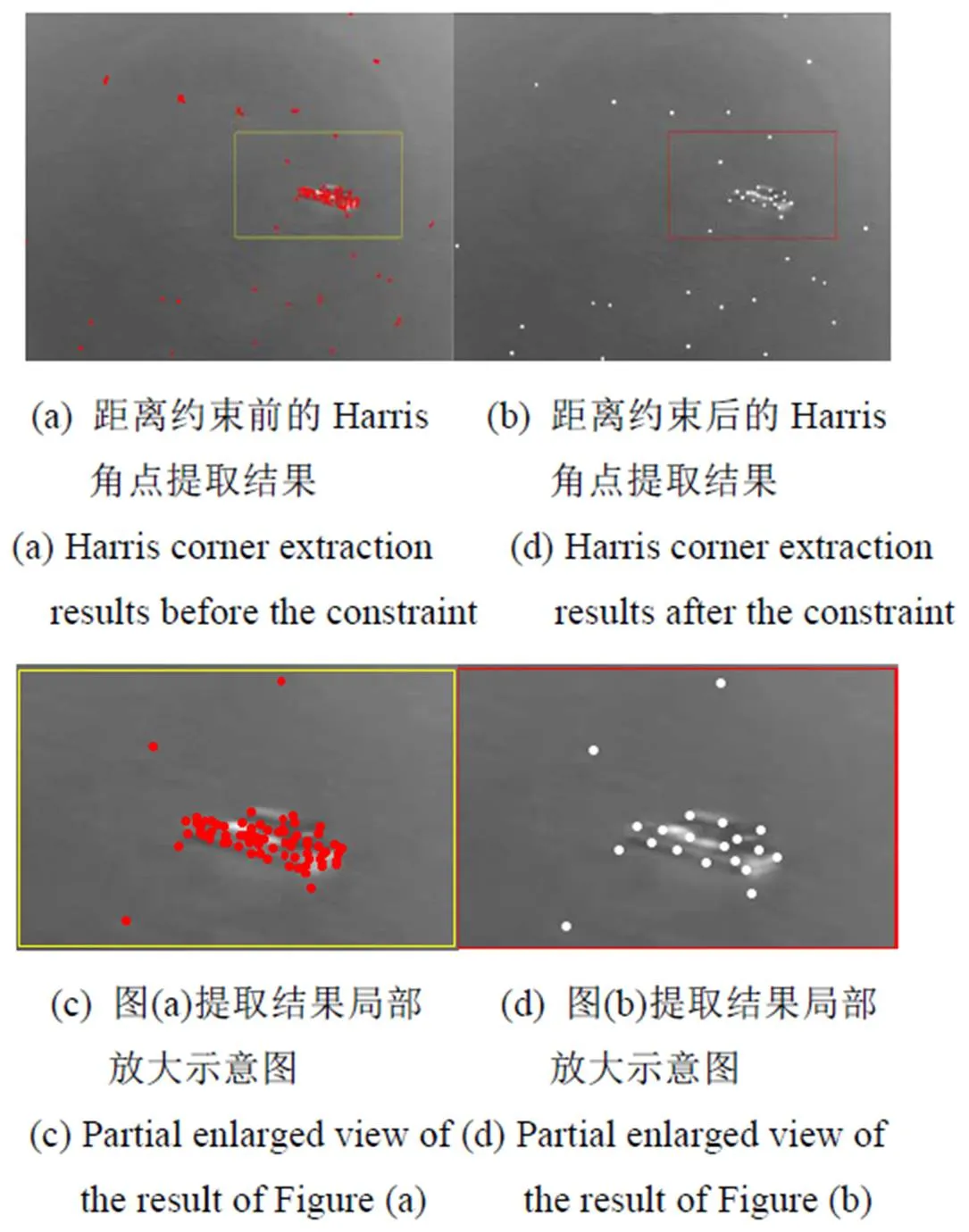

图5(a)为加入距离约束前提取到的200个改进的Harris角点,可以看到,角点都聚集在一起,图5(c)是海面目标的局部放大图,图5(b)为加入距离约束后提取到的41个改进的Harris角点,可以看到角点分布相对均匀,角点之间彼此独立,图5(d)是海面目标的局部放大图。

图5 角点提取结果对比

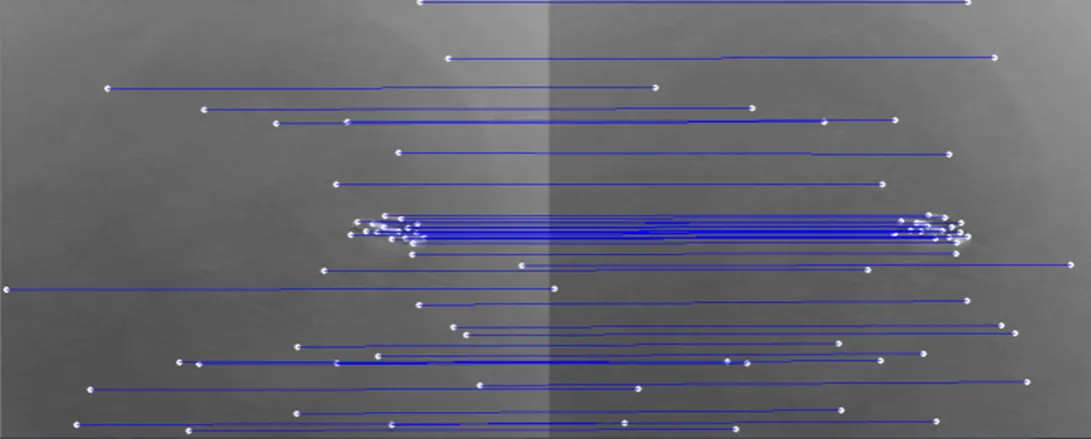

图6所示的是基于图5(b)提取到的角点进行光流跟踪匹配的结果,在匹配连线中,连线基本平行不相交。这说明使用角点特征检测并结合光流跟踪匹配能够很好地获得帧间的对应关系,能够为后面求取帧间对应的几何关系提供可靠的数据支撑。

图6 使用KLT光流跟踪匹配结果

2.2 稳像效果

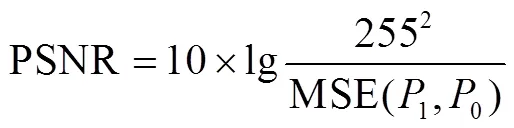

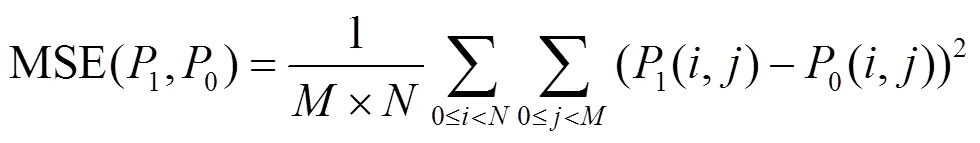

本文采用峰值信噪比(peak signal-to-noise ratio, PSNR)来测试算法的有效性,其定义为[14]:

式中:MSE(1,0)为均方误差(mean-square error, MSE),定义为:

式中:为图像的高度;为图像的宽度;0为参考帧;1为稳像后与0对应的帧。

由式(3)可知,当参考帧与补偿帧的结果越相近,稳像效果越好,均方误差MSE(1,0)的值越小,在理想情况即得到了完全补偿时MSE(1,0)的值为0。由式(4)可知,PSNR与MSE成反比,即PSNR值越大稳像效果越好。

取视频的前200帧图像计算稳像前后的PSNR,对比图如图7(a)所示。稳像前的视频图像序列平均PSNR值为36.3346,稳像后视频的平均PSNR为39.6939,提高3.3593。可以看出采用本文算法进行电子稳像,稳像后的图像序列的PSNR高于原始图像序列,说明本文提出的算法对于红外图像的抖动视频序列具有较好的稳像效果。为了更直观地展示稳像效果,图7(b)、(c)给出了海面大目标图像序列连续3帧图像稳像前后的对比。图中红色横线为添加的对比辅助线,用来对比船头(标记点)在稳像序列中的位置,以此来衡量本文稳像算法的效果。从图中可以看出,稳像处理很好地去掉了抖动干扰,保留了相机的主动运动。

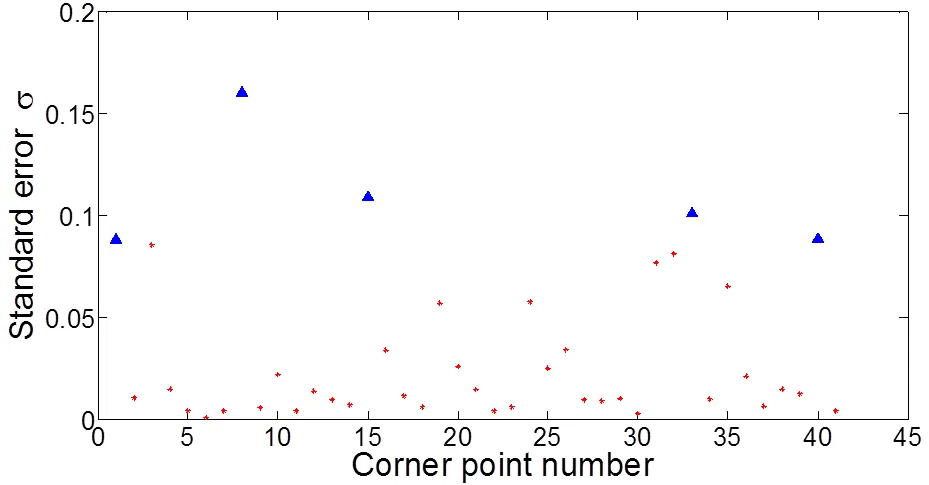

2.3 运动估计准确性实验

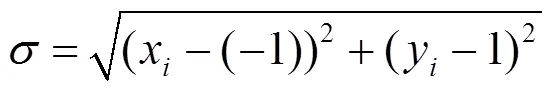

为了测试本文算法运动估计的准确性,将图5(a)进行固定像素大小偏移,偏移量为(-1,1),即向左平移一个像素,向下平移一个像素,然后进行特征点检测与光流金字塔跟踪。图8给出了全部41个特征点跟踪结果的标准误差,其中最大的5个标准误差用实心三角形标记。标准误差是偏移量(-1,1)与跟踪前后坐标变化量由式(5)计算获得的:

式中:xi是跟踪前后横坐标的变化量;yi是跟踪前后纵坐标的变化量。

图8 跟踪精度

表2中列出了标准误差最大的5个特征点的跟踪结果。标准误差的平均值=0.069,表明本文采用的方法的运动估计精度可以达到亚像素级别。

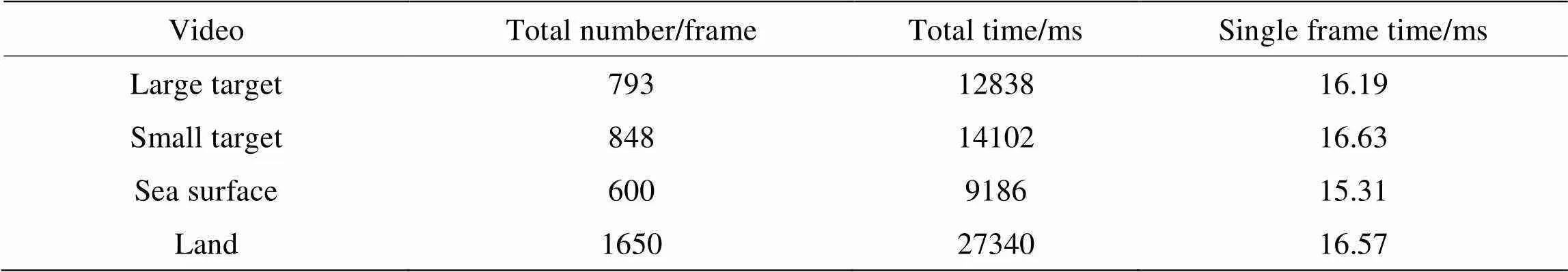

2.4 稳像速度

对海面大目标图像序列、海面小目标图像序列、纯海面图像序列以及飞机起飞时的地面图像序列进行稳像速度实验,结果如表3所示,4组实验数据的单帧处理时间都小于20ms,证明本文的算法能够满足红外图像50fps采集速率下的实时处理。

表2 跟踪结果

表3 稳像时间

3 结论

本文以含有抖动的机载红外图像序列为研究对象,进行了基于改进Harris角点的电子稳像算法研究。改进了传统Harris角点的提取方法,取两特征值中的最小值为值,保证了角点检测的数量,加入距离约束条件,避免了小范围内出现大量的角点,保证了角点分布的均匀性,本文算法能够自适应地检测出数目足够且分布均匀的角点,并且将角点的定位准确度提高到亚像素级别,保证了运动估计的准确性。

实验结果表明,本文所采用的方法能够对帧频为50fps的红外图像序列进行实时处理,并且运动估计精度可以达到亚像素级别。获得的去除抖动后的稳定视频,减轻了人眼观看时的不适的感觉,为后续红外图像目标的识别、定位与跟踪的顺利进行提供保障。

[1] 熊晶莹, 戴明, 赵春蕾. 红外激光车载云台去抖动设计[J]. 红外与激光工程, 2018, 47(1): 295-301.

XIONG Jingying, DAI Ming, ZHAO Chunlei. Dejitter design for infrared laser vehicle cloud platforms[J]., 2018, 47(1): 295-301.

[2] Ton-Thi K, Nguyen T, Hong M. Video stabilization algorithm using a moving alpha-trimmed mean filter window[C]//2014: 1-2.

[3] Yousaf A, Khurshid K, Khan M J, et al. Real time video stabilization methods in IR domain for UAVs—a review[C]//, 2017: 1-9.

[4] Puglisi G, Battiato S. A robust image alignment algorithm for video stabilization purposes[C]//, 2011, 21(10): 1390-1400.

[5] Umrikar D P, Tade S L. Implementation of video stabilization algorithm using block based method[C]//, 2017: 1-4.

[6] LIU Lu, DU Weitao. The vehicle-borne electronic image stabilization system based on Gray Projection Algorithm[C]//, 2011: 4687-4690.

[7] SHI X, KANGK, CAO Y. An iterative method for optical flow estimation with motion blur[C]//, 2016: 1-4.

[8] WANGJ M, CHOU H P, CHENS W, et al. Video stabilization for a hand-held camera based on 3D motion model[C]//, 2009: 3477-3480.

[9] AGUILAR W G, ANGULO C. Robust video stabilization based on motion intention for low-cost micro aerial vehicles[C]// 11,, 2014: 1-6.

[10] Sultan B, Ahmed J , Jalil A , et al. Translation and rotation invariant video stabilization for real time applications[C]//, 2017: 479-484.

[11] 唐永鹤, 陶华敏, 卢焕章, 等. 一种基于Harris算子的快速图像匹配算法[J]. 武汉大学学学报: 信息科学版, 2012, 37(4): 406-409, 414.

TANG Yonghe, TAO Huamin, LU Huanzhang,. A fast image matching algorithm based on Harris operator[J].: Information Science Edition, 2012, 37(4): 406-409, 414.

[12] 张立亭, 黄晓浪, 鹿琳琳, 等. 基于灰度差分与模板的Harris角点检测快速算法[J]. 仪器仪表学报, 2018, 39(2): 218-224.

ZHANG Liting, HUANG Xiaolang, LU Linlin,. Fast Harris corner detection based on gray difference and template[J]., 2018, 39(2): 218-224.

[13] SHI Jianbo, Carlo Tomasi. Good features to track[C]//, 1994: 593-600.

[14] 尹丽华, 李范鸣, 刘士建. 基于区域分割与融合的全景稳像算法[J]. 红外与激光工程, 2018, 47(9): 391-400.

YIN Lihua, LI Fanming, LIU Shijian. Panoramic image stabilization algorithm based on region segmentation and fusion[J]., 2018, 47(9): 391-400.

Electronic Image Stabilization of Airborne Infrared Images Based on Improved Harris Corner Detection

WANG Shiman,XU Wenhai,DONG Lili,XU Zhou

(,,116026,)

Bumps and sloshing generated during aircraft flights disrupt the capture of a sequence of infrared images. This affects the subsequent observation of the images, as well as the identification, location, and tracking of the target. In this paper, a method for real-time electronic image stabilization of airborne infrared images is proposed based on an improved Harris corner method. First, an improved Harris corner response function was combined with a distance constraint to perform corner detection. This method ensures that a sufficient number of corner points with uniform distribution can be detected, even for infrared images with poor image quality. The proposed key-frame reference method was then combined with the multi-scale pyramid optical flow algorithm; furthermore, the detected corner points were applied to the aforementioned combination, thereby achieving tracking matching and motion estimation. Consequently, electronic image stabilization of the airborne infrared images was realized. Using this method, multiple sets of jittery infrared image sequences were processed; the image size was 640´512. Experimental results show that the proposed algorithm exhibits a better corner detection effect than the traditional Harris corner detection algorithm. It can remove jitter from the airborne infrared image sequence and ensure real-time processing at an acquisition rate of 50fps.

electronic image stabilization, airborne infrared image, Harris corner detection, distance constraint

TP751

A

1001-8891(2020)06-0573-07

2019-11-15;

2020-06-09.

王施鳗(1995-),女,辽宁人,硕士研究生,主要研究方向为图像处理、电子稳像。E-mail:wangshiman1995@163.com。

国家自然科学基金(61701069);中央高校基本科研业务费专项资金(3132019340,3132019200)