边缘计算可信协同服务策略建模

2020-06-09乐光学戴亚盛杨晓慧刘建华游真旭朱友康

乐光学 戴亚盛 杨晓慧 刘建华 游真旭 朱友康

(嘉兴学院数理与信息工程学院 浙江嘉兴 314001)

随着云计算、大数据、物联网等技术的迅速发展和智能移动设备的普及应用,开启了以边缘计算为基础的万物互联时代,网络边缘设备量及其产生的数据均在快速增长.高清视频、直播、物联网、虚拟现实和增强现实等大流量、大连接等应用已成为通信网络流量的主要业务[1].文献[2-4]指出到2020年全球数据总量将超过40 ZB,边缘计算将处理其中45%的物联网数据.据思科视觉网络指数(Cisco visual networking index, VNI),从2016年开始更多的流量从蜂窝网络卸载到WiFi,到2021年时全球移动数据流量中仅视频流量将达到78%以上,全网流量中IP视频流量将达到82%,85%的流量为视频、游戏和多媒体数据流,其中内容分发网络(content delivery network, CDN)流量将占据全网流量的71%[5].据中国互联网络信息中心(China Internet Network Infor-mation Center, CNNIC)第42次《中国互联网络发展状况统计报告》,我国网络用户数已达到8.02亿,其中手机网民规模达7.88亿,74.1%的网民使用短视频,仅网络直播用户规模达到4.25亿[6].由于受数据处理的实时性、带宽、能耗、安全等约束,以集中式处理为核心的云计算模式将不能满足高效处理边缘设备产生的数据需求[2-4].研究表明以云计算为核心的边缘计算是解决该问题的有效方法之一[7-8].文献[2]指出由于边缘计算是移动设备位于无线接入网内,通过边缘服务器或移动设备提供信息和云计算服务的一种新的网络结构,具有高带宽、低延迟和安全性强的特点.由于边缘计算将计算任务下推至靠近数据源的位置,甚至迁移至数据源到云计算中心的链路节点上,边缘计算面临三大挑战:

1) 服务发现.由于计算服务请求者具有动态性,相对静态的域名服务协议(domain name system, DNS)服务发现机制不能满足大规模动态边缘计算需求[9].如何准确发现周边服务是边缘计算面临的关键问题之一.

2) 快速配置.用户和计算设备的动态无约束性,计算设备的随意上下线导致大量服务迁移,引起浪涌式网络流量[10].如何快速自适应服务快速配置是边缘计算面临的关键问题之二.

3) 负载均衡.边缘服务器提供服务时,其边缘设备同时产生大量数据[2].如何动态有效地调度这些数据实现高效边缘计算服务是边缘计算面临的关键问题之三.

1 相关研究

万物互联与云计算和大数据技术相融合产生了边缘计算新技术.其核心思想是赋予边缘设备执行计算任务和数据分析处理使命,为实现负载均衡、低延迟和低开销的目的,构建以云计算为中心、边缘计算为辅的轻耦合混合计算模式,将云计算中心的计算任务适当迁移至边缘设备,以解决云计算集中式服务日渐形成的瓶颈问题,提高计算任务数据处理效率,有效保护用户数据安全及隐私.文献[11]指出当边缘计算特别是移动边缘计算在处理大吞吐量数据和数据频繁交互、位置和延迟敏感的实时业务服务请求时明显力不从心,如何进行边缘计算服务资源动态调度,实现协同服务、负载均衡和低延迟开销是边缘计算的关键问题;文献[12]提出一种无线通信资源与边缘计算资源协同调度算法,在移动边缘计算场景下通过优化频谱分配,提高频谱利用率,同时节能效果显著;文献[13]采用博弈论的方法以分布式方式实现高效的卸载计算,并应用于多径无线竞争信道的多用户计算迁移场景;文献[14]提出融合移动边缘计算的5G移动通信网络架构,自适应支持多通信模式,基于虚拟化技术实现资源高效共享;文献[15]以服务重要性指标分级,基于时空约束和虚拟机调度策略,研究边缘计算任务调度方法,保证服务提供的公平性,并利用Lyapunov框架求解最大时间约束的优化问题,均衡多运营商和设备所有者的收益.

文献[16]综述了移动边缘计算的演化和发展,对比分析了基于能耗优化管理的移动边缘计算模型;文献[17]以计算时间和能耗为目标,将计算迁移建模为凸优问题,提出了一种基于拉格朗日的计算迁移能耗优化策略;文献[18]将任务迁移权重引入协同盟员调度和构建负载均衡适应函数,提出一种在多约束条件下边缘计算可信协同任务迁移策略.

文献[19]针对关联性任务数据引起大量迁移的问题,从日志信息入手,挖掘任务数据的依赖关系,通过优化数据存储、迁移调度尽可能减少了系统开销;文献[20]针对边缘设备与基站关联及基站睡眠优化问题,提出一种基于超密集网络的移动边缘计算框架(computing offloading framework based on mobile edge computing and ultra dense network, COMED),基于联合计算卸载、基站睡眠和用户-基站关联(joint computing offloading base station sleeping and user-base-station association, JOSA)的任务调度方法实现能耗优化;文献[21]研究移动边缘编排优化协同缓存处理,在多场景下应用证明了该方法能够有效地将移动边缘计算应用于5G网络;文献[22]针对移动边缘计算中高频内容刷新导致能耗高、计算服务效率低的问题,提出基于Markov的能耗优化模型,提高内容刷新效率以降低计算能耗;文献[23]根据用户请求的地理分布,用整数线性规划对时变的业务需求进行建模,优化分布式缓存部署策略;文献[24]设计实现了一种移动云计算模型的卸载和委托框架,进行计算卸载和数据绑定,在资源一定的条件下提高了系统性能;文献[25]提出了一种移动边缘计算最优资源分配策略,将资源分配转化为一个凸优化问题求解,以计算延迟为约束实现能耗最小化,通过设置任务迁移阈值实现多用户任务迁移资源优化分配,有效降低系统整体能耗;文献[26]提出一种基于近邻传播的迁移聚类(transfer affinity propagation, TAP)算法,基于源域与目标域的相似性,通过近邻特征学习改进消息传递机制,实现在特征数据稀疏时具有较好的迁移性能;文献[27-29]分别研究了Web服务CDN网络、蜂窝移动网络、流视频网络下,通过云端卸载至边缘,优化用户体验的问题.

文献[30]针对集群服务器中负载均衡问题,提出基于集群架构的边缘流媒体服务器,构建了缓存替换算法(multilevel cache and load balance supported, MCLBS),有效提高缓存命中率和降低服务带宽消耗;文献[31]提出了最小化终端的传输延迟和最大化其满意度的分布式算法,优化缓存文件分配,提高分发性能;文献[32]针对分布式并行处理架构中数据分布不均、数据流实时动态变化且不可预知等导致负载不均衡的问题,提出通过Key粒度迁移和元组粒度拆分进行轻量级均衡调整以保证系统负载均衡.

文献[33]指出恶意用户、误操作、漏洞、不安全资源等是弹性移动云计算面临的主要安全威胁,针对该问题提出了相应的防御措施;文献[11]从边缘计算隐私与安全保障角度出发,聚焦信任度构建、资源调度和协同问题,构建综合信任评估体系,保障边缘计算资源管理与协同优化,构建多层自适应统一计算模型,实现对应用场景动态匹配;文献[34]基于用户群体感知机制,利用布隆过滤和二元内积运算估计用户间相似度,形成匹配用户联盟保护个人隐私;文献[35-38]分别研究了在Web服务网络、P2P网络、机会网络和无线Mesh网络场景下的节点信誉度的建模方法,构建基于信誉评价的节点协同机制,通过信誉奖惩监测和管理节点行为,有效保障了协同服务的安全性.

本文基于“负载平衡”理论,融入节点特征属性构建边缘计算协同服务池,为边缘计算中服务快速发现和计算迁移提供一个解决方案.当边缘服务器(本文称为盟主)负载达到设定阈值时,启动网络资源聚合机制,将邻近节点扩展为协同服务节点,构建一个动态虚拟边缘计算协同服务池,实现计算迁移,服务完成后系统释放资源,自行解散.这样不仅可解决拥塞、延迟和抖动的问题,而且可大幅提高边缘计算服务效率和服务质量,其中协同服务盟员节点的选取策略是关键.

2 边缘计算协同服务盟员节点组织策略

2.1 协同服务盟员节点选择策略

为保障边缘计算服务效用,构建自适应协同服务系统是一种有效方法.其核心是当边缘计算服务负载达到设定的阈值时,根据自愿、公平的原则和激励策略,启动资源聚合机制,将边缘资源有机整合,动态自适应构建可信协同服务系统[39-40].为用户提供安全可信、灵活鲁棒的边缘计算服务.协同盟员节点具有2个主要特点[41-45]:

1) 自主性.盟员节点对其提供的共享资源和协同服务具有完全控制决定权.

2) 任务驱动性.基于任务迁移需求,盟主根据策略选取满足需求的节点为盟员,确定边界和约束条件,自主融合构建边缘计算协同服务系统.协同任务完成,释放资源,解除协同关系.

分析发现任务驱动性与自主性实际上是互斥的.完全自主性,有可能导致协同服务质量和效率不高的问题,甚至无法实现协同融合.

在实际构建边缘协同服务时,一般通过折中策略兼顾其目标驱动性和自主性特征,使构建的协同服务系统达到预期的效率.启动协同服务时,盟主节点在保持盟员节点自主性的基础上,根据任务需求启动网络资源聚合机制动态选取协同盟员节点,定义约束条件、控制策略,确定边界、盟主与协同服务盟员间的主从关系,盟主节点对协同服务系统实施管理、监控和动态调整,保障协同服务系统的正常运行[46].

设边缘计算协同服务系统有n个节点和m条连接边,其连接矩阵E=(eij),eij=1表示节点i和节点j相连,连接关系强度矩阵A=(ρij),ρij表示节点i和节点j的连接关系强度:

(1)

其中,Rtt(i,j)为节点i到节点j的网络延迟.

设观察周期为T,在第k个观察期节点i向节点j提供协同服务成功和失败的次数分别为Sij,Fij;构造节点j对节点i在第k个观察期的局部信任度函数Trust(i):

Trust(i)=(1-μ)Sij(Sij+εFij),

(2)

ε=ε+Fij(Sij+εFij),

s.t.ε|t=0=0, 0<μ<1,Trust(i)|Sij+εFij=0=0,

其中,ε为节点不诚信任务迁移处罚因子;μ为局部信任度控制因子.

根据节点的协同交互操作,构建节点i对节点j的吸引力函数F(i):

F(i)=ρijf(i)Q(i)Trust(i)edmin,ij+1,

(3)

构建盟主节点影响力G(i)模型:

(4)

其中,αi为离散化因子.

算法1.协同服务集构建算法.

Step1. 设初始边缘计算网络节点均为协同服务盟员,盟主对候选盟员分辨阈值系数λ,λmin≤λ≤λmax,令λ=λmax,0<λ≤1.

Step2.

① 如果Gi≥λ(i≠j,i,j≤n),标记节点i和节点j彼此为盟友,将节点j划入节点i的备选盟员集中.

② 否则,转Step3.

Step3.λ=λ-,为系数.

① 转Step2,将边缘计算节点划分为m个不相交的协同服务盟员集.

② 如果某个节点j不属于任何协同服务盟员集,则加入相邻节点中影响力Gi最大的节点i所在的协同服务盟员集中.

③ 调整.在划分的协同服务盟员集中,将影响力小的节点加入到相邻节点对其影响力Gi最大的节点i协同服务盟员集中.

Step4.

① 边缘计算网络节点集无划分操作,转Step3.

② 边缘计算网络节点集被划分为2个以上协同盟员服务子集,则停止分解,令λ=λmin.

③ 将划分的协同盟员服务子集视为1个新边缘计算网络,令λ=λmax,转Step2.

④ 直到所有的协同盟员服务子集不能被再划分为止.

Step5. 构建协同盟员服务子集间的关系映射图,标识各协同盟员服务子集分辨系数阈值λ的界.

2.2 协同服务机制分析与建模研究

边缘计算协同服务的工作原理为:当盟主节点发起协同任务时,依据任务需求定义协同服务内容、协同服务目标、控制策略、协同边界和约束条件等参量,遴选适宜、有效的协同服务盟员节点,定义协同服务模式和协议,建立其特征、顺序、从属等相互间的映射关系,启动网络资源聚合机制,快速完成盟员节点间的聚合,构建边缘计算协同服务系统.

利用状态机描述边缘计算协同服务模型TCSEC为DTCSEC:

DTCSEC=(Q,Γ,δ,q0,F).

(5)

其中:

1)Q是有穷状态集,Q={边缘计算协同服务的状态集合};

2)Γ是状态转移条件产生式;

3)δ是状态转移函数,Q×Γ→Q;

4)q0∈Q,是起始状态,由盟主产生;

5)F⊆Q,是结束状态集,F={结束}.

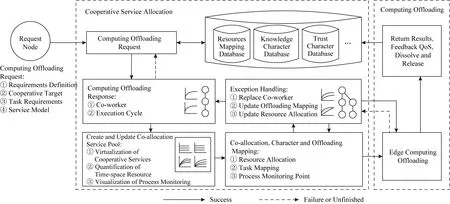

DTCSEC状态转换如图1所示:

Fig. 1 Trust cooperative service model for edge computing图1 边缘计算可信协同服务模型

Fig. 2 State transition model for cooperative service event图2 一次协同服务状态转移模型

协同服务的业务事件状态以Ti表示,利用状态机描述其业务事件处理机制CSE(cooperation service event)为DCSE:

DCSE=(Q,Γ,δ,q0,F).

(6)

其中:

1)Q是有穷状态集,Q={T0,T1,T2,T3,T4,T5,T6,T7};

2)Γ是状态转移条件产生式;

3)δ是状态转移函数,Q×Γ→Q;

4)q0∈Q,是起始状态,由盟主产生;

5)F⊆Q,是结束状态集,F={T7}.

一次协同操作过程:

Step1. 发布协同服务需求,选取满足需求的候选协同服务节点.

Step2. 确定协同服务目标、边界、约束条件和策略.

Step3. 定义协同服务协议和建立角色映射关系.

Step4. 启动聚合机制构建协同服务系统.

Step5. 返回协同服务结果,更新特征属性数据库.

协同服务的业务事件处理机制[36]如图2所示.

由于目标计算任务分布不均,引起边缘计算协同服务请求分布不均,边缘计算协同服务节点可能会出现服务瓶颈,导致协同服务质量下降,若计算任务迁移和边缘节点调度策略不完善、节点抖动等引起边缘计算服务不稳定甚至终止服务,则进一步加剧计算任务分布的不合理,导致网络的抖动,造成协同服务性能下降.

当节点状态和性质发生改变,无法满足协同服务需求时,通过服务迁移动态调整节点承载的计算任务,可有效加强系统服务性能.在构建的边缘计算协同服务中,当边缘计算协同服务需要执行任务迁移时,根据相关需求及约束策略启动任务迁移机制,将计算任务迁移至目标盟员,协同完成计算任务,这一过程对用户而言是透明无隙的.

协同服务迁移的业务事件状态以Ti表示,利用状态机描述其协同服务任务迁移状态为

Dtask-offloading=(Q,Γ,δ,q0,F).

(7)

其中:

1)Q是有穷状态集,Q={边缘计算任务迁移状态集合};

2)Γ是状态转移条件产生式;

3)δ是状态转移函数,Q×Γ→Q;

4)q0∈Q,是起始状态,由盟主产生;

5)F⊆Q,是结束状态集,F={T5}.

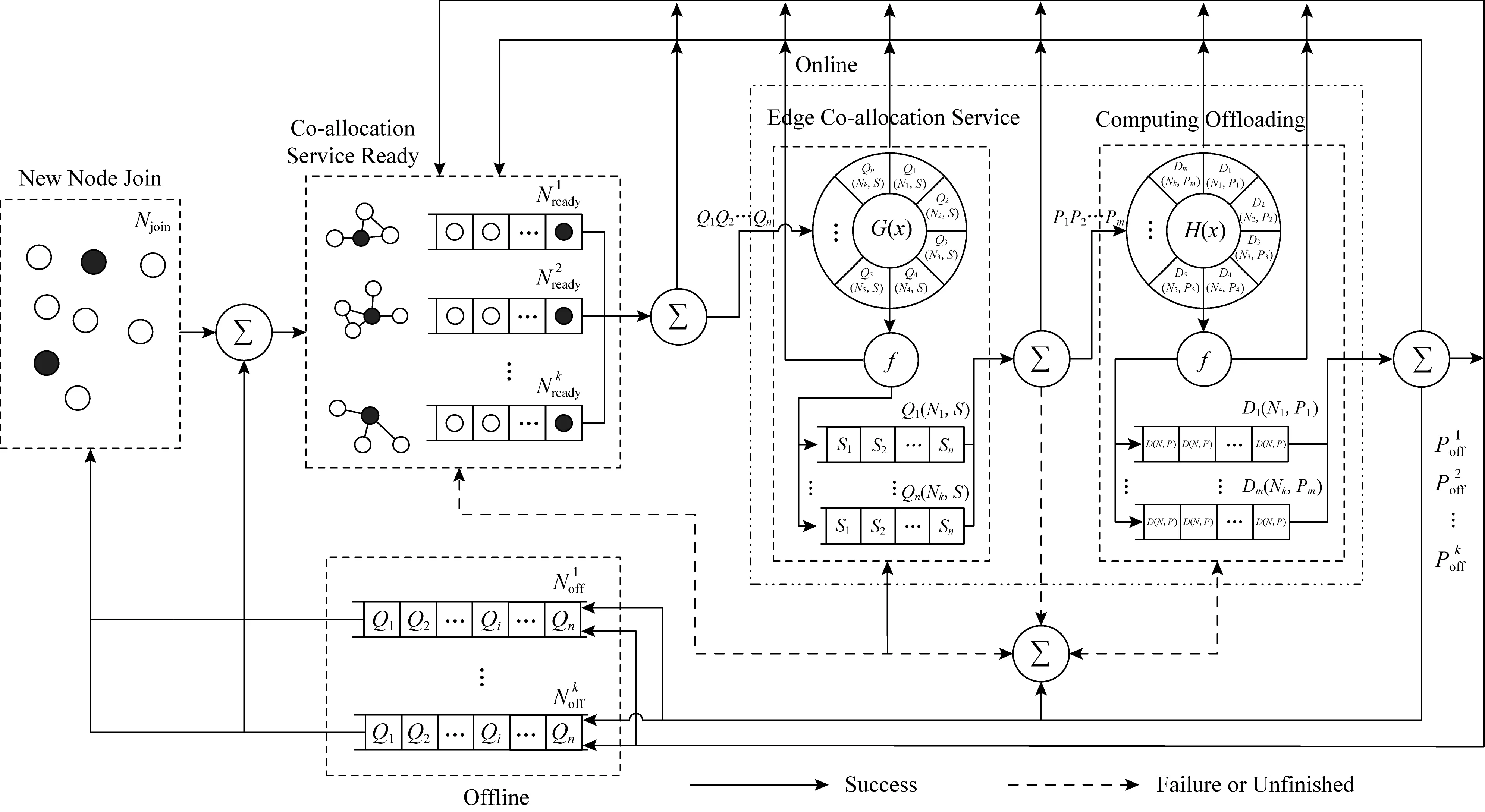

边缘计算协同服务任务迁移过程如图3所示:

Fig. 3 State transition model for offloading task图3 任务迁移状态转移模型

3 边缘计算协同服务系统建模与性能分析

构建边缘计算协同服务需遵循6条规则[47-51]:

规则1.构建的边缘计算协同服务系统是完备的,当且仅当协同服务盟员节点集不为空.

规则2.以协同盟员节点间特征属性为约束条件,按影响力择优原则在候选协同服务盟员节点集中选择协同服务盟员节点.

规则3.定义盟主节点、协同盟员节点间的逻辑约束、主从关系和职责.

规则4.盟主节点负责对边缘计算协同服务中的协同资源、状态进行监管和调度,定义协同服务盟员节点间的协同服务协议和约束条件,依据策略动态调整协同盟员角色,过滤性能差的协同盟员节点.

规则5.协同服务任务完成后,盟主节点对该盟员节点的协同服务质量和信任度做出公正的评价,更新特征属性数据库;释放资源,解除盟主节点和协同盟员节点间的协同服务关系.

Fig. 4 System model of TCSEC图4 边缘计算协同服务执行模型

根据策略规则,构建基于边缘计算可信协同服务系统模型TCSEC如图4所示.其中,为聚合、判断、状态转移机等,为策略、映射机制.

TCSEC共享流服务系统状态表征:

MTCSEC-streaming-service=(Q,Γ,δ,qstart,qaccept).

(8)

其中:

1)Q是有穷状态集,Q={加入,就绪,在线,协同,离线},其中,在线状态∈{边缘计算协同服务,计算任务迁移};

2)Γ是状态转移条件产生式;

3)δ是转移函数,δ=(Q×Γ)→;

4)qstart是起始状态,qstart={加入状态},qstart∈Q;

5)qaccept是接受状态,qaccept⊆Q.

在线边缘计算协同服务系统为服务请求节点提供服务策略:

1) 当节点获得服务后,节点以概率P选择离开边缘计算协同服务系统,进入离线阶段,或以1-P的概率选择留在TCSEC,进入就绪阶段.

2) 因异常原因,节点直接进入离线阶段.如果节点在系统允许的会话时间段τ内恢复正常则节点直接进入到异常断点,继续相应服务操作.

3) 当服务请求端异常或中断服务请求时,TCSEC提供端撤销提供的任务迁移服务队列,节点进入就绪状态.

协同服务质量评价策略.在时间窗τ系统接收用户对服务质量的评价:

1) 接收用户对服务质量的正常评价.

2) 拒绝同一用户在时间周期τ内对同一服务质量进行多次评价,并标记该用户,系统以1-Trust(i)的概率对用户信任做负面评价.

3) 以Trust(i)的概率接收同一用户对协同服务质量评价,并标记该用户.

由上可知,系统具有很强的抗攻击和抑制协同作弊的能力.

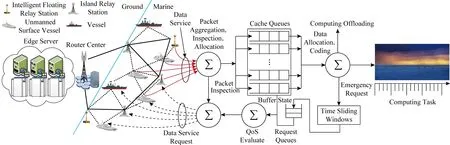

以近海港口为例构建一个边缘计算服务系统,如图5所示.

用户节点以轻量级泛洪在网络中搜索目标流数据,按就近服务的策略返回搜索结果,用户节点依据搜索结果与合适的邻居节点建立连接,邻居节点将自己缓存的计算任务转发给用户节点,用户端对获得的流数据进行可用性检测,TCSEC系统通过联合协同方式为用户节点提供流数据实现流式服务,用户节点同时接受来自网络其他节点的流服务请求,并将自己缓存的流数据共享给相应的邻居节点.其中,为聚合、判断、状态转移机等.

Fig. 5 State transition model of TCSEC offloading task stream图5 边缘计算协同任务迁移流数据状态转移模型

TCSEC服务系统中节点获取服务状态表征:

MTCSEC-request=(Q,Γ,δ,qstart,qaccept).

(9)

其中:

1)Q是有穷状态集,Q={服务请求,数据包有效性检测,数据包聚集与分配,进入缓存区,编码与调度,播放超时重传请求,内容转发,服务质量评价等};

2)Γ是状态转移条件产生式;

3)δ是转移函数,δ=(Q×Γ)→;

4)qstart是起始状态,qstart={服务请求},qstart∈Q;

5)qaccept是接受状态,qaccept={计算任务},qaccept⊆Q.

由式(9)可得,节点进入TCSEC系统获得服务的过程描述为:

Step1. 以轻量级泛洪方式搜索目标计算任务数据.

Step2. 系统返回搜索结果列表,通过服务协商,用户节点选择合适邻居节点建立连接关系,构成协同服务联盟.

Step3. 系统联合协同节点为用户节点提供自己缓存的任务数据.

Step4. 用户节点实施数据包汇聚、可用性检测和分配到相应的缓冲区队列.重新请求不可用的流数据,发表缓冲区状态.

Step5. 数据编码和调度,实施计算服务.如果出现任务缺失、计算异常等,则发起紧急调度请求,等待任务流数据.

Step6. 服务质量评价,请求流数据;接受邻居节点服务请求,转发本地缓冲的流数据.

4 实验与分析

由分析可知:边缘计算协同服务盟主以节点的信任度、影响力、可用带宽、链路质量等特征指标作为选择盟员的约束条件,以最小开销构建边缘计算协同服务池.对于小规模边缘计算协同服务,其构建开销可以忽略;一旦边缘计算协同服务节点达到一定规模,其开销必增,占用网络资源,降低服务质量.因此,在构建协同服务池生成规则中设定规模上下界,当其规模不满足设定域时,启动边缘计算协同服务簇分裂或合并机制,形成新的协同服务池.

近海港口构建的通信网络是一个典型的边缘计算服务应用场景,本文仿真实验场景如图5所示.

实验中假设3个条件成立:

1) 每个服务节点周围可能存在一个小规模的亚可信边缘计算协同服务节点集,其信任初始值均设为0.5,这些亚信任节点曾经与盟主服务节点构成协同服务,以形成一定的信任协同关系,这种原始的亚可信边缘计算协同节点其信誉度随服务节点在网络中存活的时间、协同服务质量等而动态变化.

2) 盟主节点按相关策略从其候选协同服务盟员集中选取,以构建边缘计算协同服务.

3) 通信网络以岸基数据中心、岸基站为中心,由岛礁中继站、智能浮台中继站、船舰节点、智能移动节点等构成.

网络仿真环境:

1) 基于Router View公开数据集,构建边缘计算系统服务簇;Router View公开数据集节点数为6 474,连接边数为13 895,平均度为4.292 6,基尼系数为0.608,相对边缘分布熵为0.854,聚类系数为0.959%;

2) 岸基站为根节点,与7个中继基站组建骨干网络,1个岸基网络数据中心服务器为源服务发起节点,节点间自由交互;

3) 以每个基站为初始簇头,构建可信协同服务集.当边缘计算协同服务簇节点规模小于设定的下界时进行合并操作,原盟主节点降为盟员节点;当簇节点规模大于上界时,按策略选择盟员成为新的盟主节点,进行分裂操作;

4) 边缘计算可信协同服务系统由岸基数据中心服务器集群(edge server, ES)、岸基站(router center, RC)、中继基站(router node, RN)、盟主节点(leader node, LN)、盟员节点(edge node, EN)等组成;

5) 节点通信制式符合IEEE 802.11协议簇标准.

系统仿真环境:

服务器为Intel Xeon E5,4核16线程、2.5 GHz,RAM为4 GB,WinServer2010,虚拟机带宽1 MBps;

客户机为Intel Core i5,2核4线程、2.7 GHz,RAM为8 GB,Win7系统;

服务端为JDK1.8+Apache Tomcat 8.0,Mysql 5.7;

客户端为Chrome浏览器;

编程语言为Java,JavaScript;

开发工具为Eclipse Oxygen 3a;

后端框架为JSP,JavaBean,JDBC;

前端可视为SVG绘图库,Ajax异步前后端交互.

4.1 TCSEC骨干网络系统性能测试分析

Fig. 7 Topology of static edge computing cooperative service图7 静态边缘计算协同服务拓扑结构

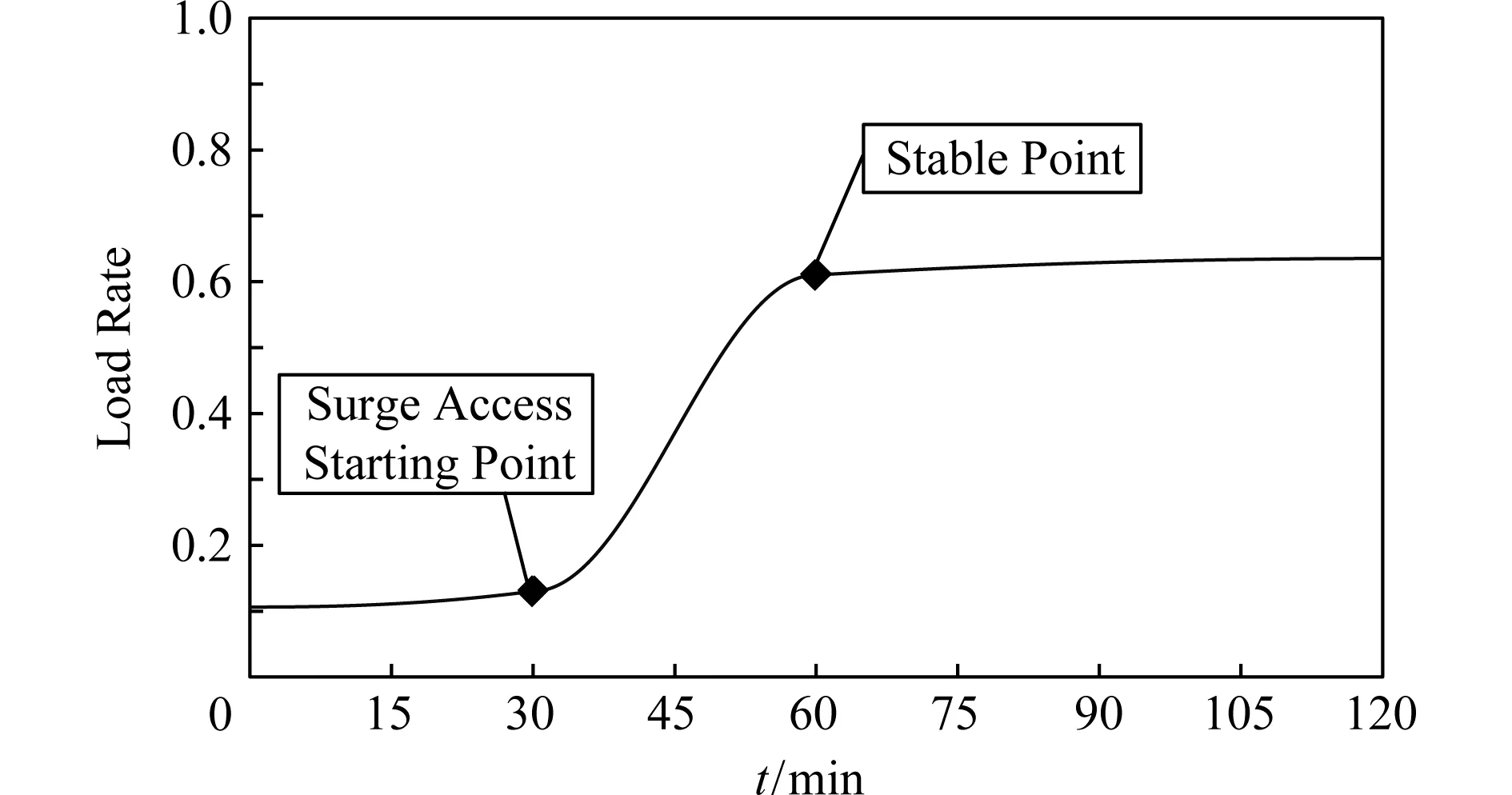

为保证骨干网络的鲁棒性,对骨干网络实施负载压力测试.测试时间为120 min,观察周期为30 min.设定岸基数据中心服务器集群的负载率达到60%启动边缘协同服务负载均衡机制;在30 min时对岸基数据中心服务器集群实施突发浪涌式服务请求,60 min时服务请求达到其负载率60%,系统启动边缘协同服务负载均衡机制,按策略将相应计算任务卸载至其协同盟员边缘服务盟主节点执行,系统基本稳定在其负载率的63%.如图6所示.实验表明,TCSEC模型的骨干网络具有很好地鲁棒性和负载均衡能力.

Fig. 6 Load rate of edge server图6 数据源服务器负载率

4.2 TCSEC模型系统聚类性能测试分析

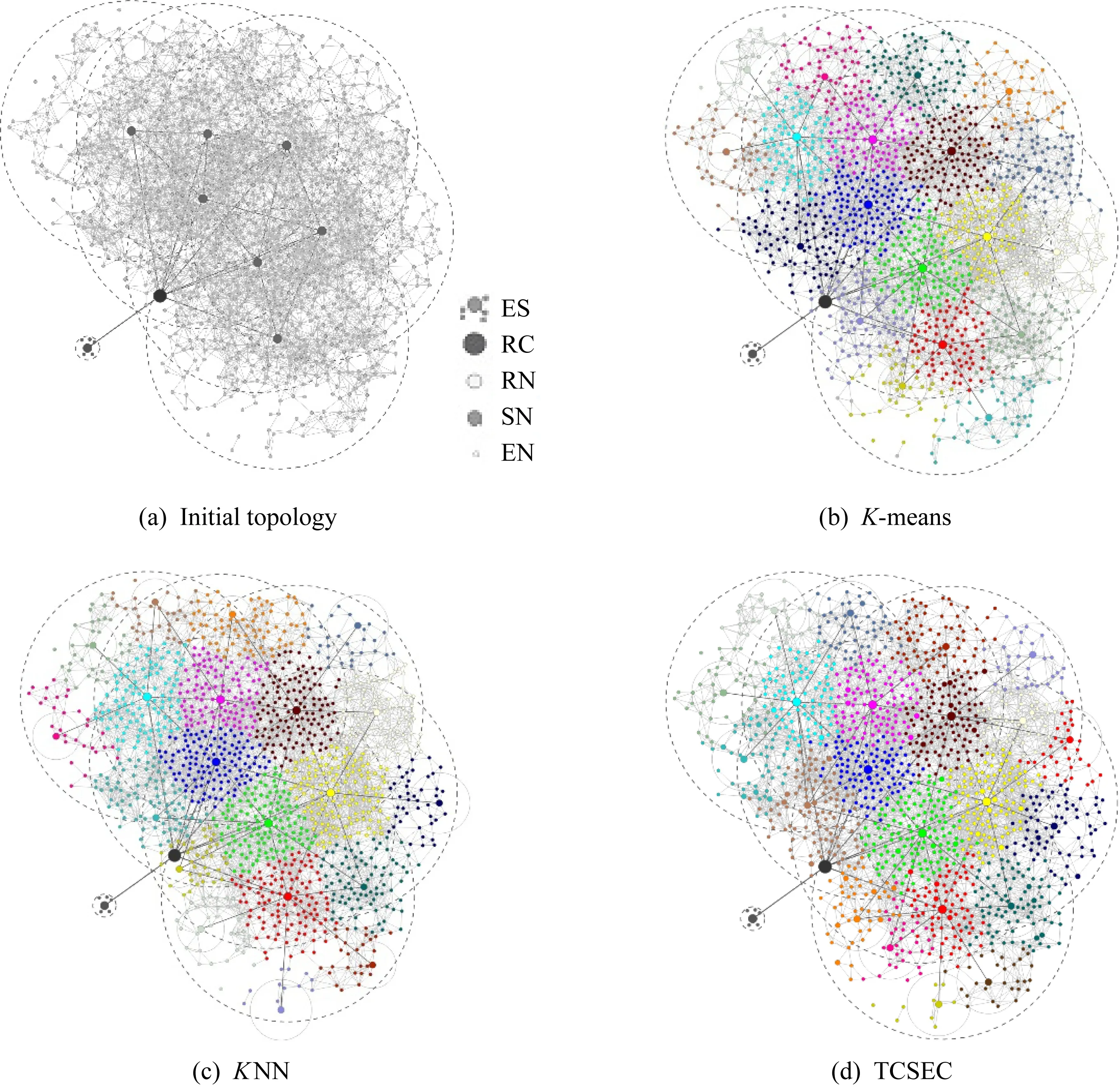

为分析边缘计算协同服务性能,以聚类效率、服务流量、响应延迟、服务效率等为评价指标.从静态和动态2种网络拓扑状态将本文提出的协同服务池算法TCSEC与K-means[52],KNN[53]对比分析.

4.2.1 静态协同服务

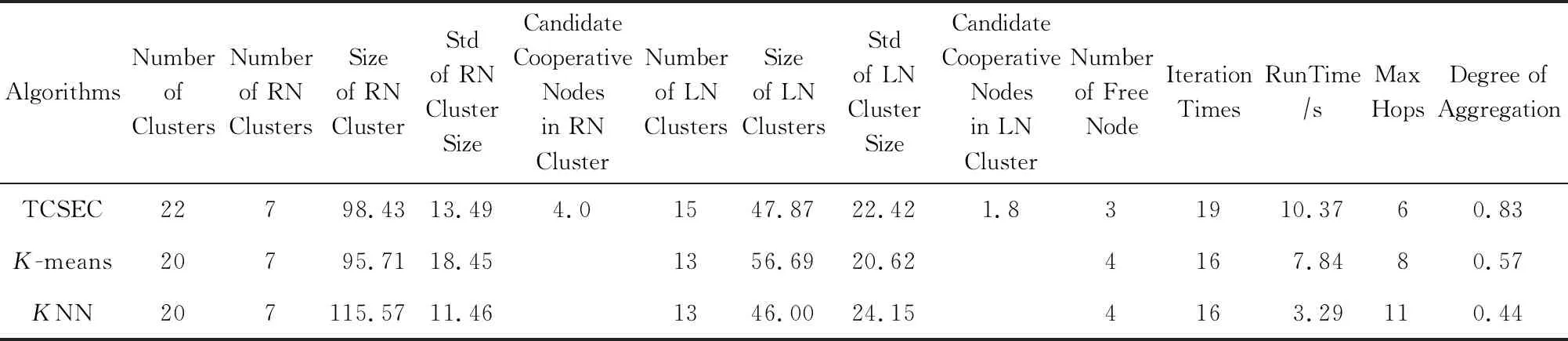

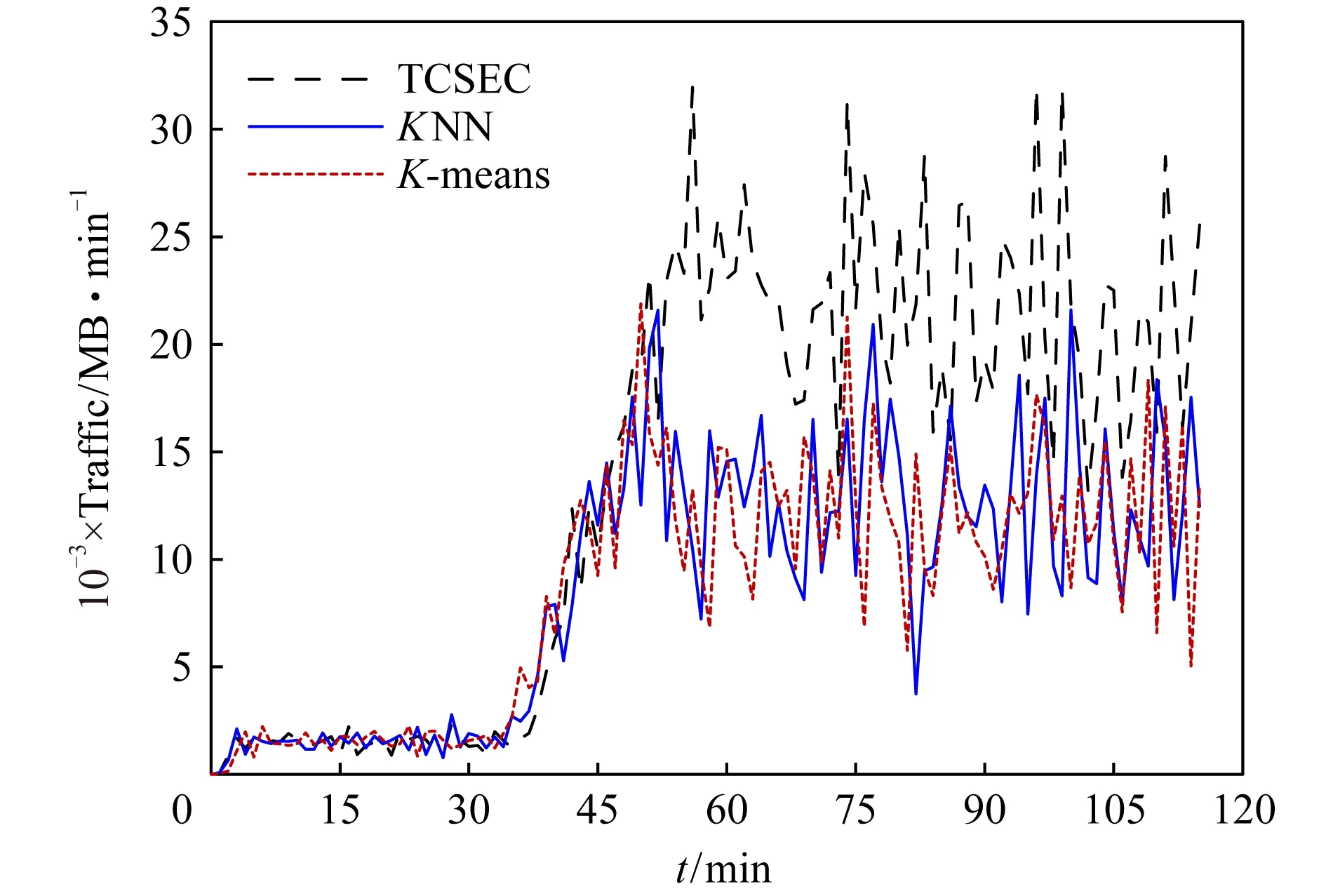

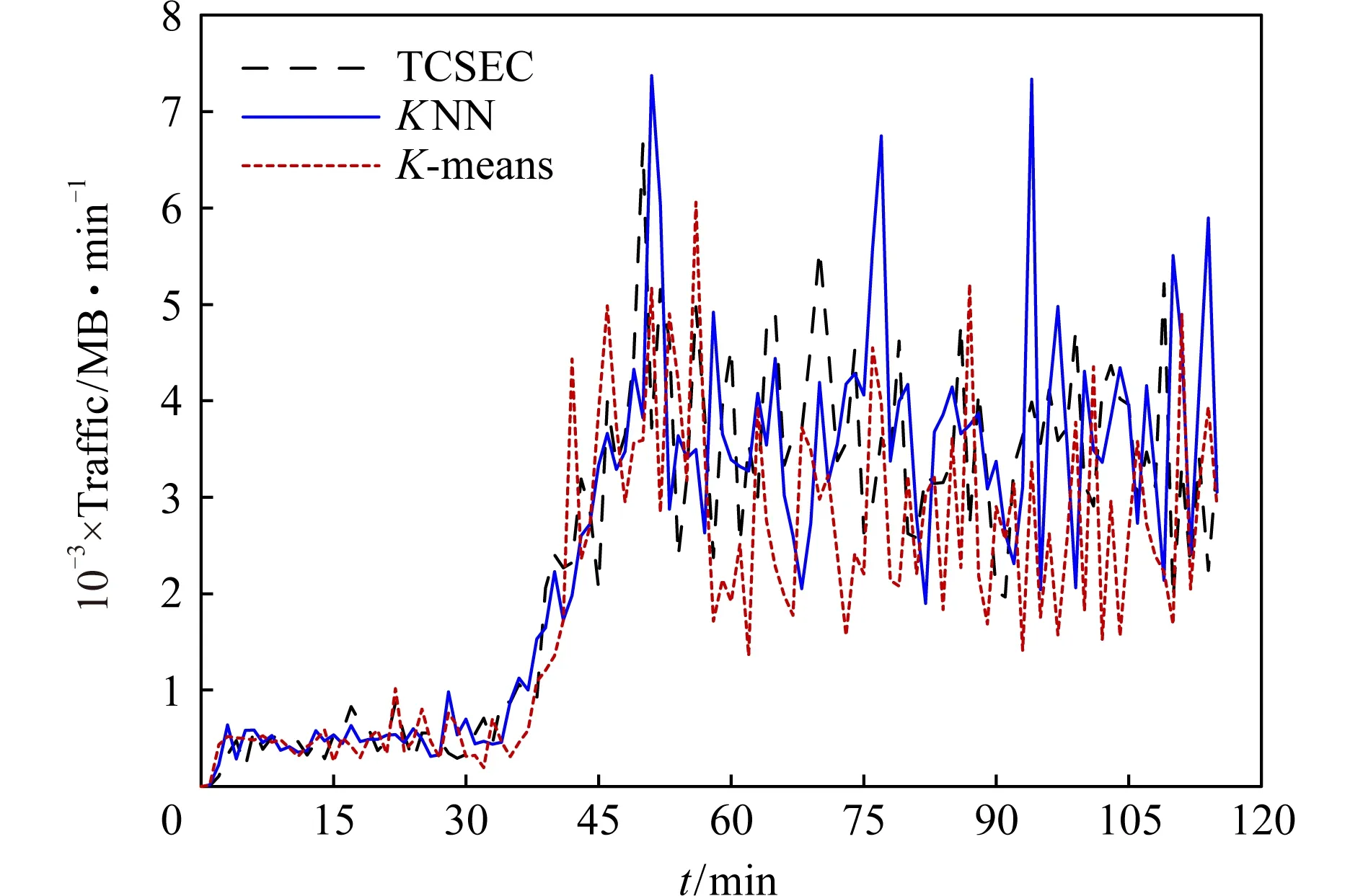

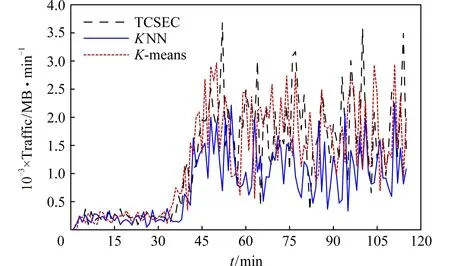

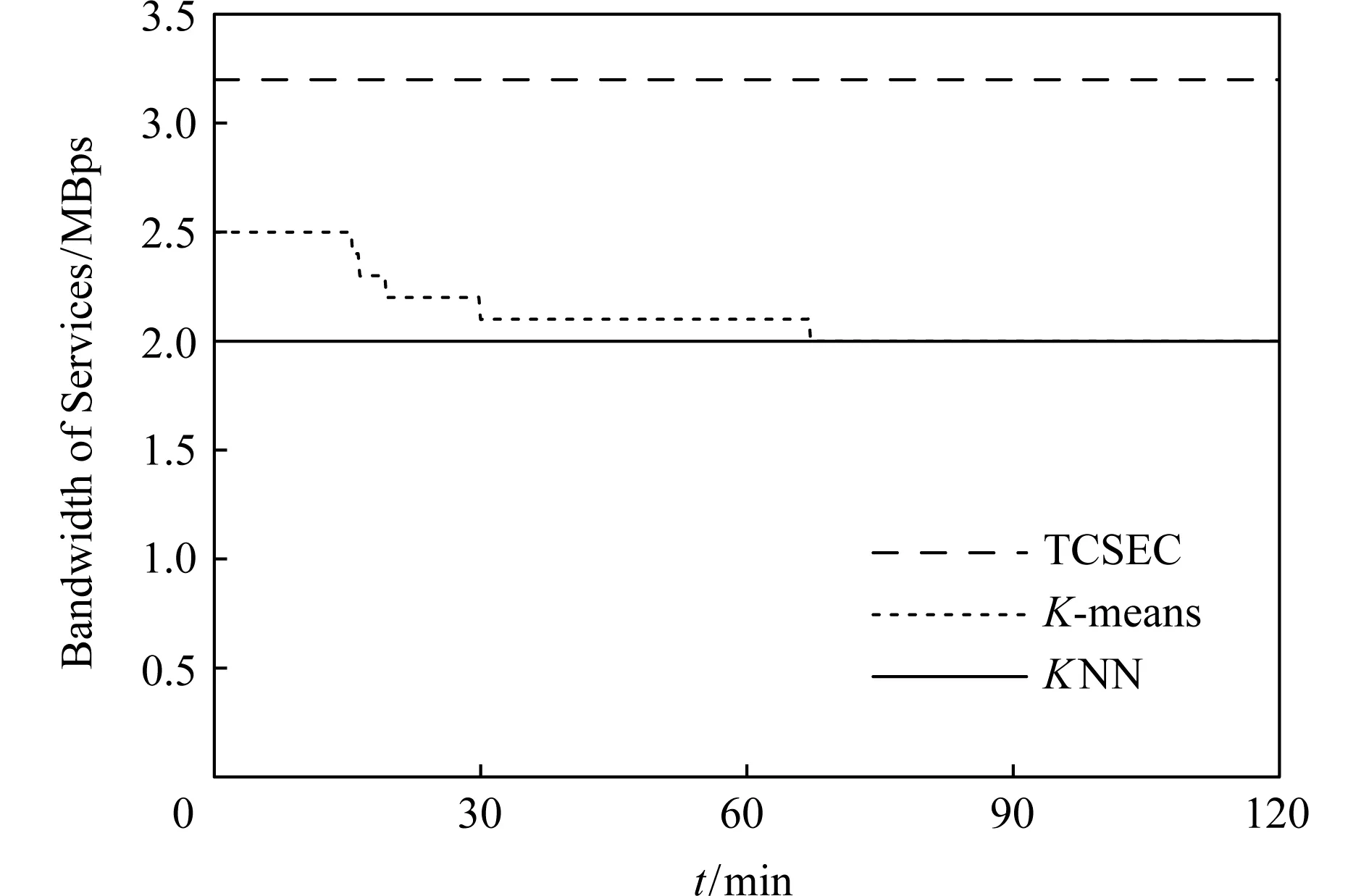

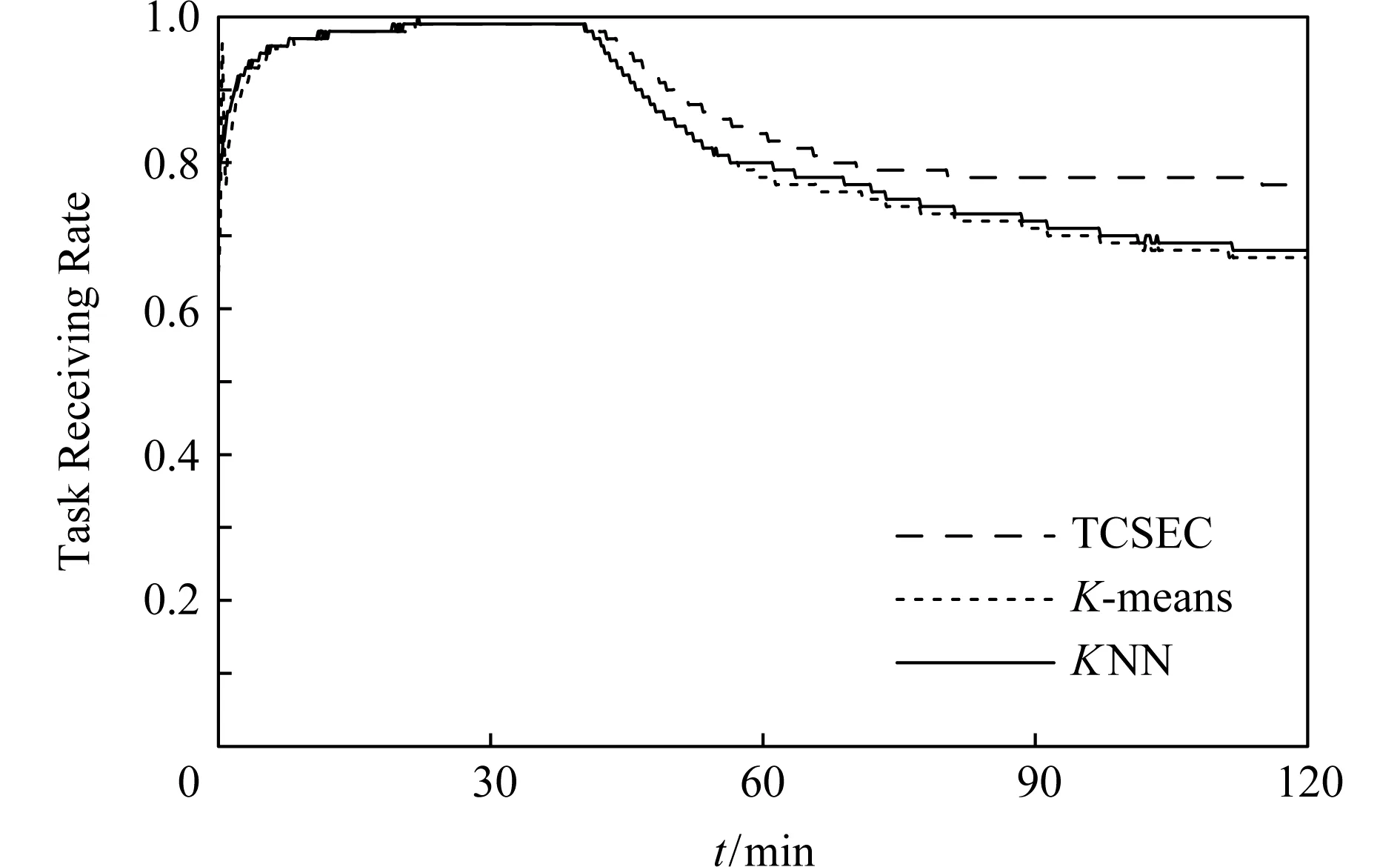

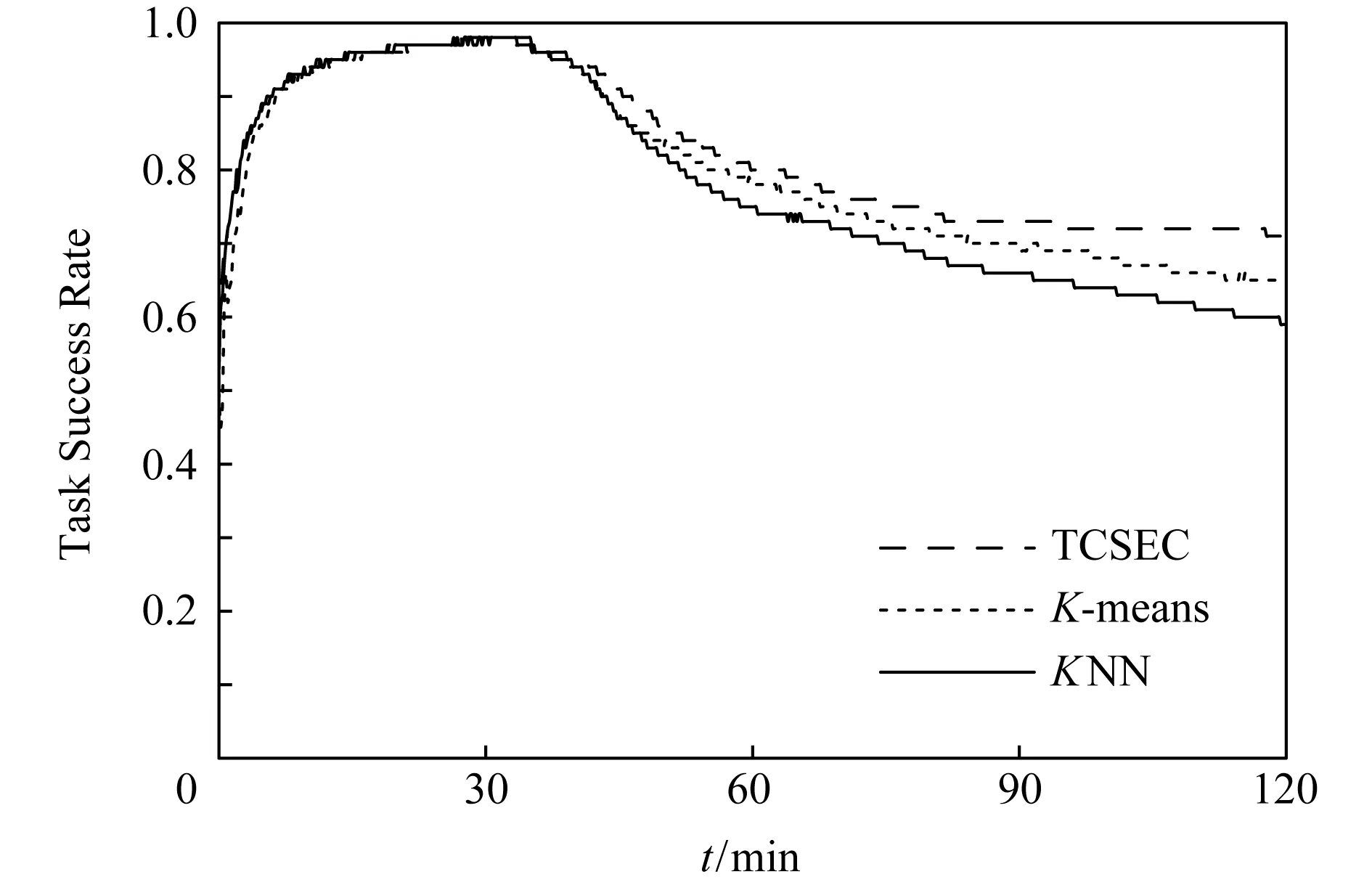

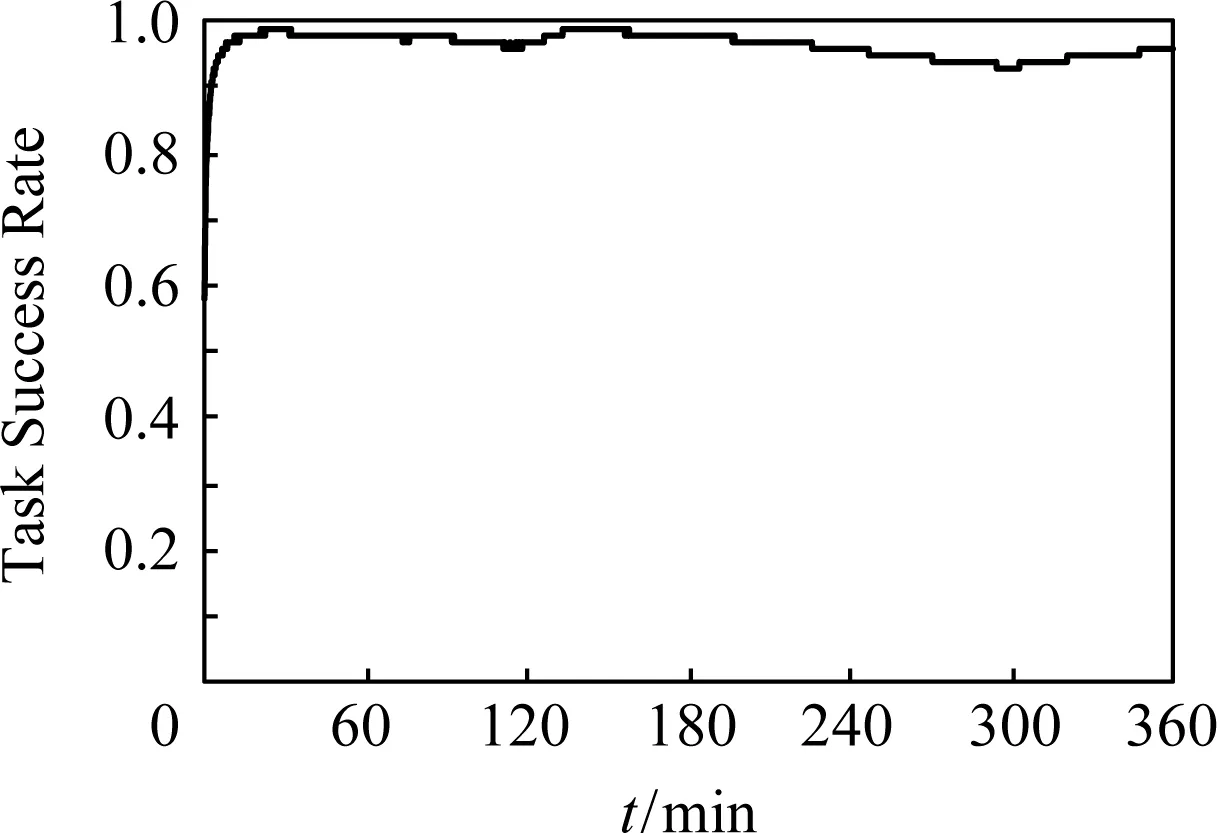

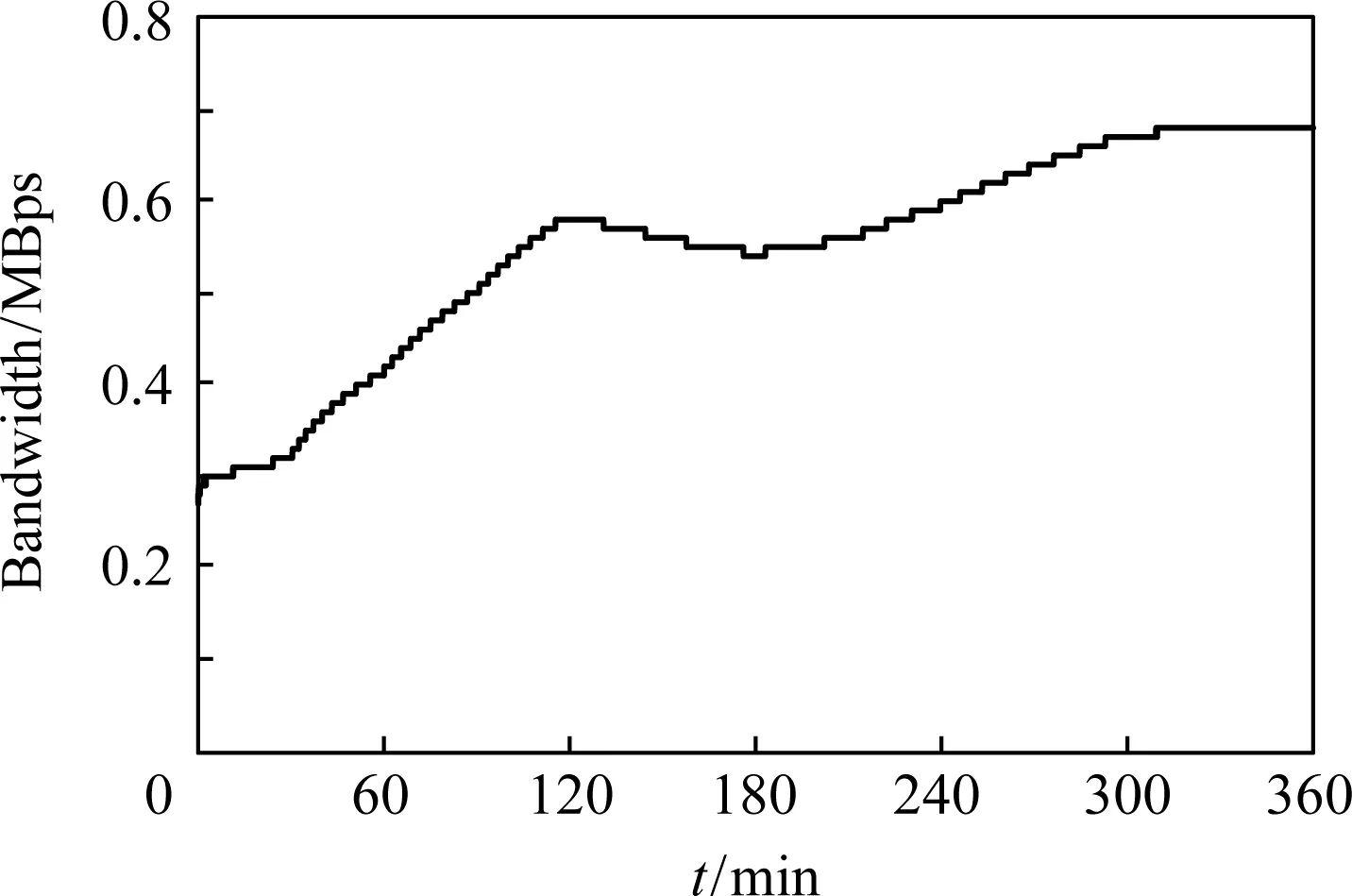

协同服务池一旦构建完成并稳定后,不再进行合并和分裂操作.其中节点颜色表示节点参与构建边缘计算协同服务系统的意向,节点大小表示节点的服务能力,其边缘计算协同服务拓扑如图7所示,聚类算法评价参数如表1所示,边缘计算协同服务池性能评价参数如表2所示,协同服务簇、中继基站、盟主节点平均流量如图8~10所示,协同服务带宽如图11所示,任务接受率如图12所示,协同服务成功率如图13所示,协同服务响应延迟如图14所示.

Table 1 Performance Parameters of Static Edge Computing Cooperative Service Clustering Algorithm表1 静态边缘计算协同服务聚类算法性能参数

Note: Std means standard deviation.

Table 2 Performance Parameters of Static Edge Computing Cooperative Service Pool表2 静态边缘计算协同服务池性能参数

Fig. 8 Cooperative service cluster traffic for static edge computing图8 静态边缘计算协同服务簇平均流量

Fig. 9 Relay node traffic for static edge computing图9 静态边缘计算协同服务中继基站流量

Fig. 10 Leader node traffic for static edge computing图10 静态边缘计算协同服务盟主节点流量

Fig. 11 Bandwidth of static edge computing service 图11 静态边缘计算协同服务带宽

Fig. 12 Task receiving rate of static edge computing service图12 静态边缘计算协同服务任务接收率

Fig. 13 Task success rate of static edge computing service图13 静态边缘计算协同服务成功率

Fig. 14 Response delay of static edge computing service图14 静态边缘计算协同服务响应延迟

静态边缘计算协同服务具有5个特征:

1) 超级节点聚类具有相似趋同性和马太效应,能力和性能相当的节点会聚在一起;为了保证系统服务提供的服务能力基本一致,能力相对弱的热心节点所构建的协同服务簇的簇内节点数相对较多.

2)KNN,K-means算法形成13个超级节点,构成20个边缘计算服务池,分别耗时3.29 s和7.84 s;TCSEC算法形成15个超级节点,构成22个边缘计算服务池,耗时10.37 s;所构建边缘计算服务池平均规模在46.00~56.69之间,网络平均延迟分别为43 ms,30 ms,19 ms,池内交互平均延迟41 ms,39 ms,7 ms.

3)KNN,K-means算法构建边缘计算服务池时分裂13次,没有合并.聚合度分别为0.44和0.57,协同效率分别0.45和0.58.

4) TCSEC算法构建边缘计算服务池时执行20次分裂,合并5次,聚合度0.83,协同效率0.80.

5) 执行协同服务,60 min边缘计算协同服务池趋于稳态,TCSEC,KNN,K-means算法平均并发数分别达53,41,39,平均服务流量分别为20 973.83 MB/min,10 254.34 MB/min,9 770.61 MB/min.

实验结果表明:

1) 盟主节点均由热心边缘服务器节点形成,协同服务池构建具有马太效应.

2) TCSEC算法构建的边缘计算协同服务池能有效均衡基站和盟主节点的负载,能有效平滑浪涌效应.

3) TCSEC算法构建的边缘计算协同服务池网络平均延迟分别比KNN,K-means算法减少55.81%和36.67%;边缘计算协同服务池内平均延迟TCSEC算法分别比KNN,K-means算法减少82.93%和82.05%.

4) TCSEC算法的协同效率分别比KNN,K-means算法的提高77.78%和37.93%.

5) TCSEC算法基站、盟主节点服务带宽分别比KNN,K-means算法提高3%,21.30%和32.25%,45.50%,系统平均并发数提高35.90%和29.27%,平均服务流量提高1.15倍和1.05倍.

4.2.2 动态构建协同服务

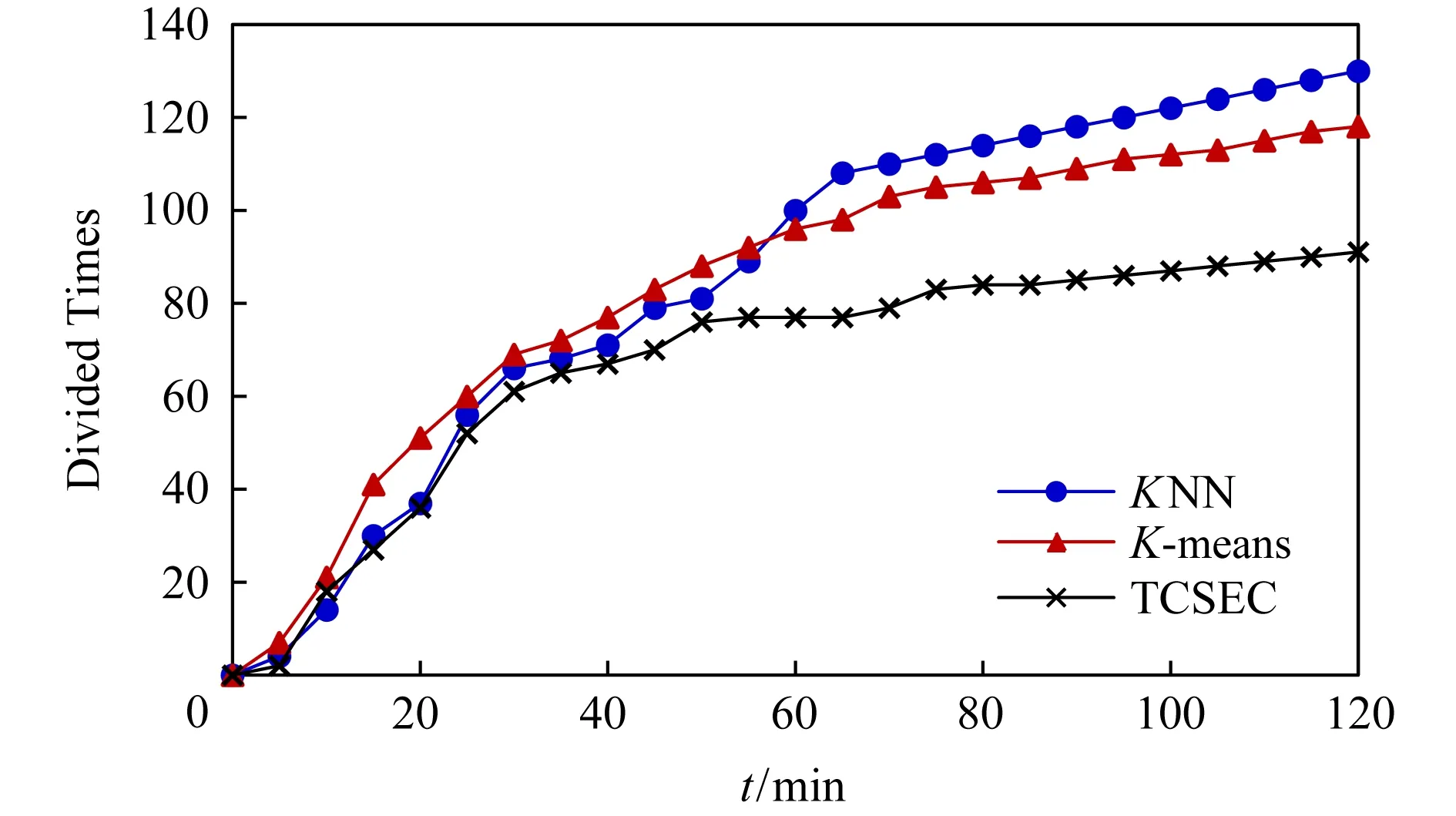

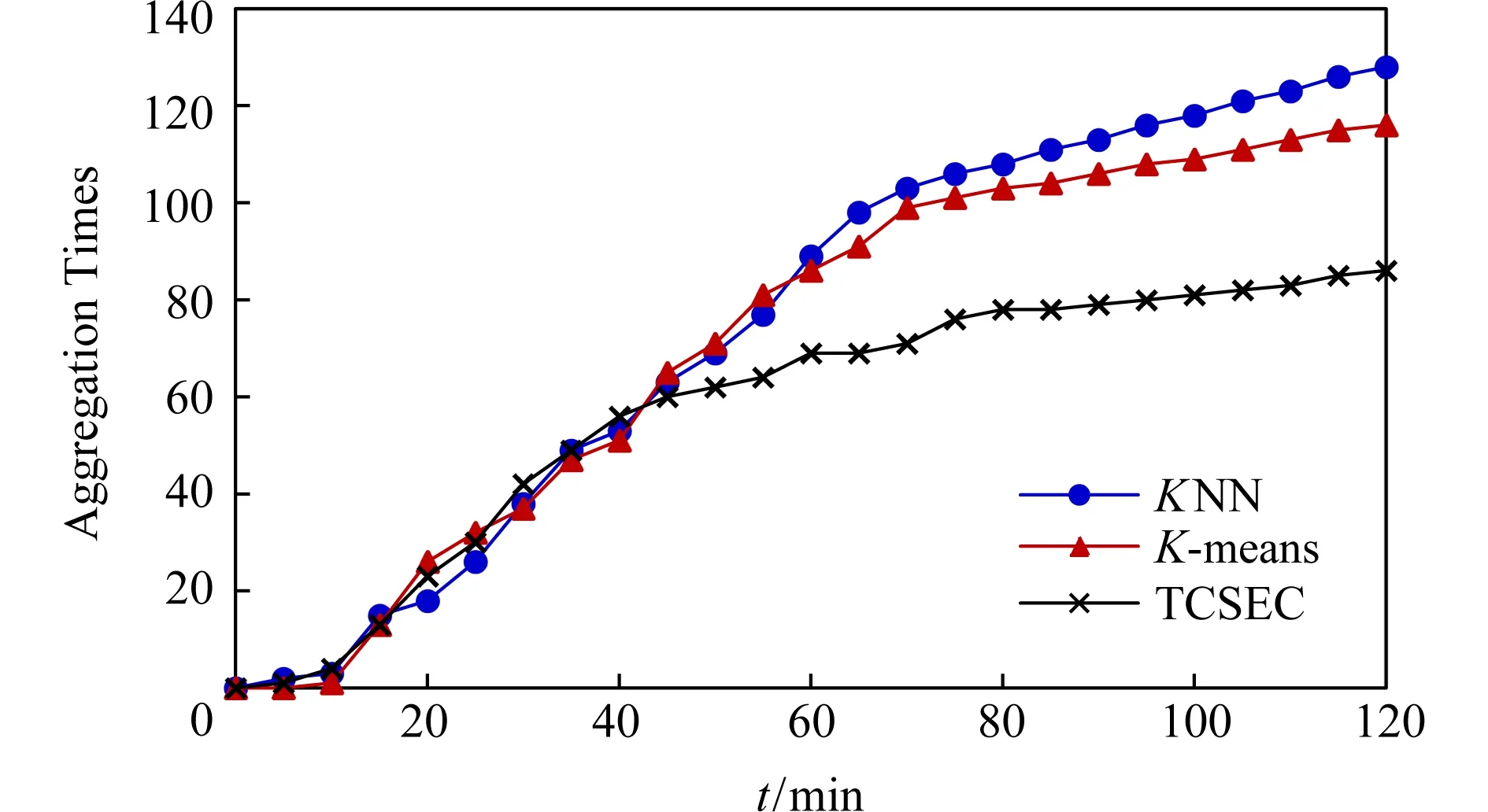

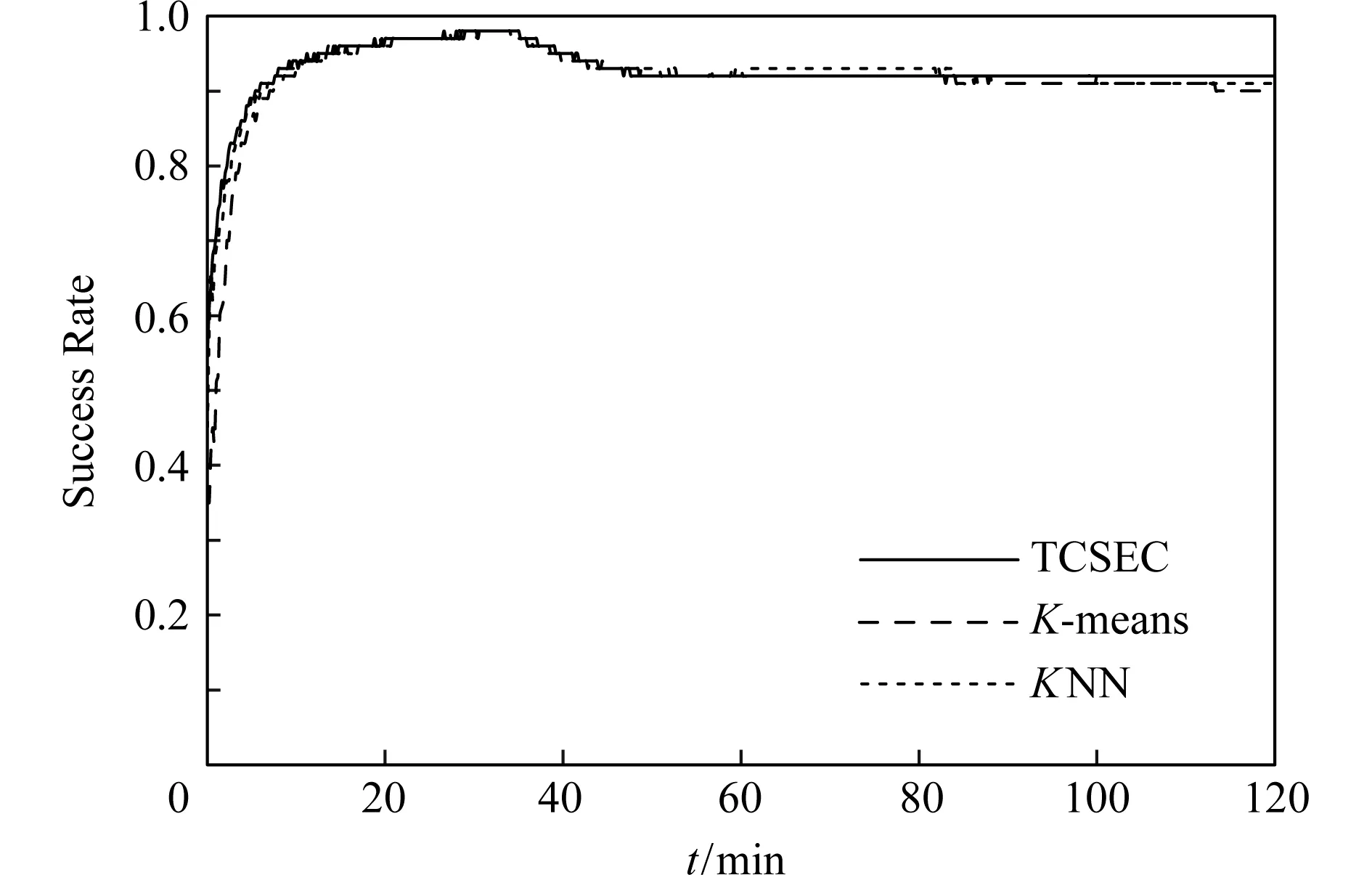

协同服务池构建完成后,系统根据虚拟服务池的协同工作状态进行动态合并和分裂操作.其边缘计算协同服务拓扑如图15所示,聚类算法评价参数如表3所示,边缘计算协同服务池性能评价参数如表4所示,协同服务簇平均流量如图16所示,盟主节点数如图17所示,协同服务池分裂、聚合次数如图18~19所示,任务接受率如图20所示,协同服务成功率如图21所示,协同服务响应延迟如图22所示.

Fig. 15 Topology of dynamic edge computing cooperative service图15 动态边缘计算协同服务拓扑结构

Table 3 Performance Parameters of Dynamic Edge Computing Cooperative Service Clustering Algorithm表3 动态边缘计算协同服务算法性能参数表

Note: Std means standard deviation.

Fig. 16 Cooperative service cluster traffic for dynamic edge computing图16 动态边缘计算协同服务簇平均流量

Fig. 17 Number of leader nodes in dynamic edge computing图17 动态边缘计算协同服务盟主节点数

Fig. 18 Total divided times of dynamic edge computing图18 动态边缘计算协同服务总分裂次数

Fig. 19 Total aggregation times of dynamic edge computing图19 动态边缘计算协同服务总聚合次数

Fig. 20 Task receiving rate of dynamic edge computing图20 动态边缘计算协同服务任务接收率

Fig. 21 Task success rate of dynamic edge computing图21 动态边缘计算协同服务成功率

Fig. 22 Response delay of dynamic edge computing图22 动态边缘计算协同服务响应延迟

动态边缘计算协同服务具有3个特征:

1)KNN,K-means算法在70 min达到稳定状态,分别形成20和15个盟主节点,构成27和23个虚拟服务池,平均规模分别为44.53和48.27.TCSEC算法在60 min达到稳定状态,形成23个超级节点,构成30个虚拟服务池,平均规模为36.25.

2)KNN,K-means,TCSEC算法聚合度和协同效率基本一致,但其分裂数分别为110,103,77次,合并数分别为103,99,69次;中继基站平均服务带宽为3 549.61 MB/min,3 587.86 MB/min,4 016.54 MB/min,盟主节点平均服务带宽为2 593.29 MB/min,2 610.50 MB/min,2 909.53 MB/min,网络平均延迟分别为63 ms,61 ms,20 ms,协同服务池内交互平均延迟为19 ms,21 ms,20 ms.

3) 边缘计算协同服务池进入稳态工作后,TCSEC,KNN,K-means算法平均服务流量分别为38 900.53 MB/min,21 196.40 MB/min,20 900.53 MB/min.

实验结果表明:

1) TCSEC,KNN,K-means算法在达到相同聚合度和协同效率状态下,TCSEC算法收敛时间比KNN,K-means快14.29%,TCSEC算法分裂合并总次数比KNN,K-means算法分别减少31.46%和27.72%;

2) TCSEC算法超级节点服务带宽分别比KNN,K-means算法提高12.19%和11.46%,协同服务池平均服务流量提高83.52%和86.12%;

3) TCSEC算法构建边缘计算协同服务的网络平均响应速度分别比KNN,K-means算法快68.25%和67.21%.

小结:

1) 动态与静态构建边缘计算协同服务系统相比,TCSEC算法聚合度达到0.97,协同服务系统总平均服务流量提高41.53%,协同效率提高18.98%,协同服务成功率提高28.17%;

2) TCSEC算法综合性能明显优于KNN,K-means算法.

4.3 TCSEC模型系统仿真分析

为分析边缘计算协同服务系统交互特征,以访问量、流量、负载、信誉度、任务接收率、协同成功率等为评价指标,基于TCSEC动态聚类对边缘计算协同服务系统进行仿真.

设数据源边缘服务器(edge service, ES)集群存在100个待迁移计算任务,每个迁移计算任务量500≤M≤1 024,对目标计算任务所在边缘服务器ES进行浪涌式服务请求测试.用户请求频率f≤4次/s,每次请求5个连续的计算任务,实验测试时间6 h,访问量、流量采样周期为30 s,信誉度、任务接收率、协同成功率采样周期为5 s.

4.3.1 TCSEC模型系统访问量分析

为分析浪涌访问下,边缘计算协同服务访问量变化特征,数据源边缘服务器ES,中继基站RN和盟主节点LN的访问量变化如图23所示:

Fig. 23 Visits of cooperation service for edge computing图23 边缘计算协同服务访问量

由图23可知,边缘计算协同服务访问量具有2个特征:

1) 34 min系统出现第1次浪涌请求,ES与RN,LN的访问量峰值分别达到9 919和9 920,平均访问量为7 745和7 673;71 min系统出现第2次浪涌请求,ES与RN,LN的访问量峰值分别达到14 567和15 353,平均访问量为9 498和11 433;106.6 min系统出现第3次浪涌请求,ES与RN,LN的访问量峰值分别达到12 994和22 671,平均访问量为9 441和15 791;124 min达到系统设定的访问量上限,触发协同服务池分裂和聚合,135 min结束第1阶段浪涌访问测试.

2) 180 min时开始实施与第1阶段相同的浪涌访问.在185.0 min时,出现第1次浪涌请求,ES与RN,LN的访问量快速上升,系统启动边缘计算协同服务机制,实施浪涌访问均衡,ES与RN,LN的访问量峰值分别为6 982和7 734,平均访问量为3 111和3 814;230 min时,出现第2次浪涌请求,ES与RN,LN的访问量峰值分别为6 982和11 765,平均访问量为4 265和7262;280 min时,出现第3次浪涌请求,ES与RN,LN的访问量峰值分别为6 477和16 475,平均访问量为3 704和10 913;340 min结束浪涌访问测试.

TCSEC模型系统访问量实验结果表明:

1) 第1阶段测试时,第1次浪涌请求,ES与RN,LN的访问量在可承受范围内,访问量差异不大.第2次浪涌请求,数据源边缘服务器访问量超过了阈值12 000次,任务迁移触发,ES与RN,LN构建边缘计算协同服务系统,并将大量任务迁移分发至中继基站和盟主节点,访问量逐渐表现出差异.第3次浪涌请求,RN,LN的访问量超过了阈值18 000次,ES的访问量超过了阈值12 000次,系统触发分裂聚合协同操作,进行协同服务资源再度融合和边缘计算协同服务系统重构,18 min后达到稳定.

2) 第2阶段测试时,实施浪涌访问均衡,再次面临相同的浪涌请求时,ES的访问量将维持稳定,RN,LN的峰值访问量比第1阶段平均下降21.31%,平均访问量下降30.89%.

3) 计算任务服务节点提供的计算任务因“新鲜”被访问节点传播吸引更多的节点访问,使计算任务服务节点的访问量随着访问节点的增加而增加,当访问量达一个极大值时,由于目标计算任务的“新鲜”度开始下降,访问节点随之减少,访问量下降.

4) ES与RN,LN构建协同服务后,其访问量变化具有联动放大效应.通过访问请求迁移分发和构建边缘计算协同服务,能够有效抑制访问拥塞.

4.3.2 TCSEC模型系统性能分析

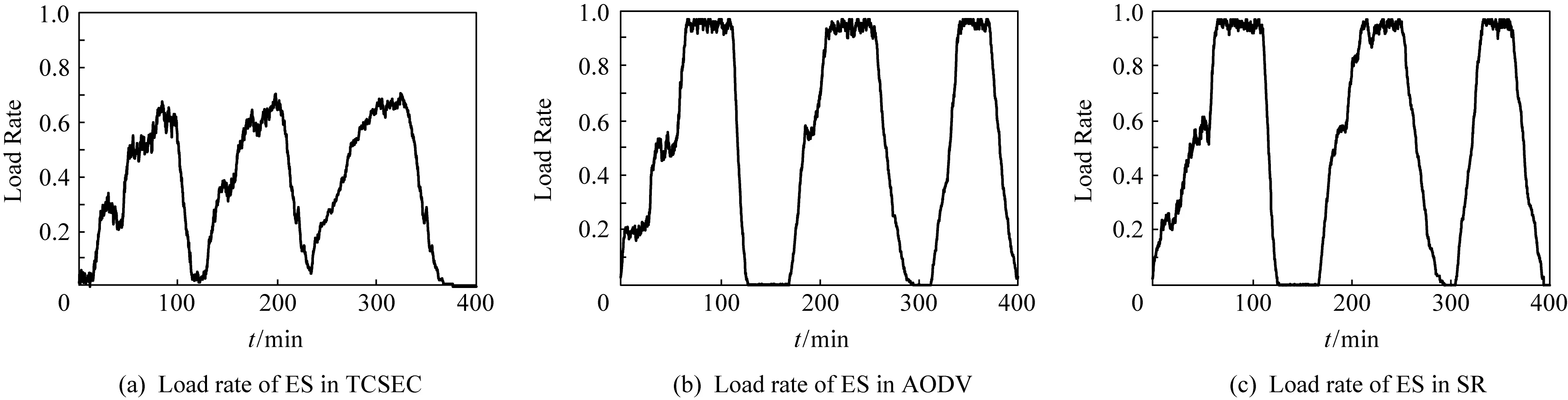

为分析浪涌访问下,边缘计算协同服务系统的服务能力及均衡性,ES,RN,LN节点的负载率如图24所示,实时流量如图25所示.

Fig. 25 Traffic of node in TCSEC图25 TCSEC模型系统节点实时流量

由图24、图25可知TCSEC模型系统节点流量具有3个特征:

1) 第1次浪涌请求,ES峰值带宽峰值流量达到15 554.17 MB/min,平均流量为7 642.50 MB/min;RN节点和LN节点的峰值流量分别为1 373.71 MB/min和797.81 MB/min,平均流量为525.04 MB/min和521.01 MB/min.第2次浪涌请求,ES带宽峰值流量达到20 919.72 MB/min,平均流量为11 746.31 MB/min;RN节点和LN节点的峰值流量分别为1 970.95 MB/min和1 368.94 MB/min,平均流量为660.36 MB/min和651.31 MB/min.第3次浪涌请求,ES峰值流量达到26 926.74 MB/min,平均流量为14 416.21 MB/min;RN节点和LN节点的峰值流量分别为1 670.90 MB/min和1 307.68 MB/min,平均流量为810.70 MB/min和699.44 MB/min.

2) 构建边缘计算协同服务系统,启动边缘计算协同服务后,ES峰值流量为3 070 MB/min,平均流量为1 758.08 MB/min;RN节点和LN节点峰值流量为1 045.81 MB/min和924.62 MB/min,平均流量为307.66 MB/min和302.78 MB/min.

3) ES,RN,LN流量分别于41 min,52 min,62 min达到任务迁移阈值,启用请求服务转发迁移.65 min时,ES流量超过额定阈值,ES与RN,LN构建骨干网络边缘计算协同服务系统.124 min,RN,LN在自治域内构建网络边缘计算协同服务系统.

TCSEC模型系统节点负载和流量实验结果表明:

1) 第1阶段浪涌访问测试,ES,RN,LN是系统服务的主要提供者,第2阶段浪涌访问测试,以RN和LN为盟主构建的边缘计算协同服务是系统服务的主要提供者.

2) ES负载达到设定阈值时,启用构建边缘计算协同服务,将任务迁移至盟员RN和LN,其流量增速降低69%,当RN和LN触发构建边缘计算协同服务后,ES负载率降低51%并趋于稳定.

3) 边缘计算协同服务盟主节点的流量波动,将直接带动其从属节点产生相同的流量波动,所构建的边缘计算协同服务具有马氏效应.

4) 所有节点均具有优先与综合性能优的节点连接趋势,盟员节点因综合性能差异而聚集到不同的边缘计算协同服务中,形成边缘计算协同服务的综合性能参数和服务质量也不尽相同.

5) 普通盟主节点聚类构建的边缘计算协同服务,由于其节点综合性能较弱,因此其边缘计算协同服务的服务能力也相对较弱.这类边缘计算协同服务在系统中主要承担保障网络连通性和为局域提供服务的作用.

4.3.3 TCSEC模型系统信誉度验证

为验证边缘计算协同服务系统信誉度的有效性,RN节点、LN节点、EN节点信誉度如图26所示.协同服务系统节点信誉度具有3个特征:

1) RN节点和LN节点信誉度分别在8.6 min和8.7 min达到0.8,此时RN节点和LN节点间信任关系初步建立,在22.0 min和20.8 min时达到0.9,此时RN节点和LN节点间的主从关系得到确立.

2) 在60~120 min和180~240 min,浪涌请求访问量达到极大值时,RN节点和LN节点信任关系稳定于0.92~0.94.

3) 第1阶段浪涌访问测试,边缘服务器协同节点于50 min信誉度开始逐步上升,在130 min时达到稳定.第2阶段浪涌访问测试,边缘服务器节点于190 min信誉度开始逐步上升,于300 min稳定于0.94.

Fig. 26 Trust of node in TCSEC图26 TCSEC模型系统节点信誉度

TCSEC模型系统节点信誉度实验结果表明:

1) 节点的平均在线时长、服务能力、可用带宽、信誉度和链路延迟对边缘计算协同服务的综合性能产生重要影响.

2) RN节点和LN节点平均信誉度相对稳定,有效激励了协同服务盟员参与协同的热情,高效完成协同任务.

4.3.4 TCSEC模型系统用户服务质量评价

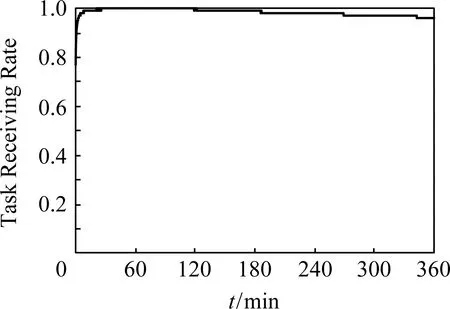

为分析浪涌访问下,用户服务质量服务参数,通过任务接收率、协同服务成功率、链路重寻次数、用户服务带宽、协同服务响应延迟和协同传输丢包率进行评价,如图27~31所示.

由图27~31可知,边缘计算协同服务参数具有2个特征:

Fig. 27 Task receiving rate图27 任务接收率

Fig. 28 Task success rate图28 交付成功率

Fig. 29 Frequency of link retrievals of EN图29 盟员链路平均重寻次数

Fig. 30 Average service bandwidth of EN图30 盟员平均服务带宽

Fig. 31 Average packet loss rate图31 平均丢包率

1) 边缘计算协同服务任务接收率在第8 min稳定于0.99,协同成功率在第10 min稳定于0.97,丢包率在第4 min稳定于0.3.

Fig. 32 Load rate of ES in edge computing cooperative service图32 边缘计算协同服务数据源服务器负载率

2) 第1阶段浪涌访问测试,节点获得服务速率由0.29 MBps提高至0.58 MBps,链路平均重寻次数为0.启动协同服务机制,RN节点和LN节点构建边缘计算协同服务系统,节点获得服务速率由0.56 MBps提高至0.68 MBps,链路平均重寻次数0.02.

节点信誉度实验结果表明:

1) 当信誉体系建立完成后,在浪涌访问下,边缘计算协同服务系统任务接收率稳定于0.99,协同成功率稳定于0.97.

2) 随着边缘计算协同服务系统协同规模扩大,链路重寻率上升2%,系统的服务效率提升1.95倍.

通过服务迁移和构建边缘计算协同服务系统,能够有效解决无线网络中存在高拥塞、单点失效、低数据分发效率问题,提高服务质量,实现负载均衡,为大规模可信边缘计算服务提供保障.

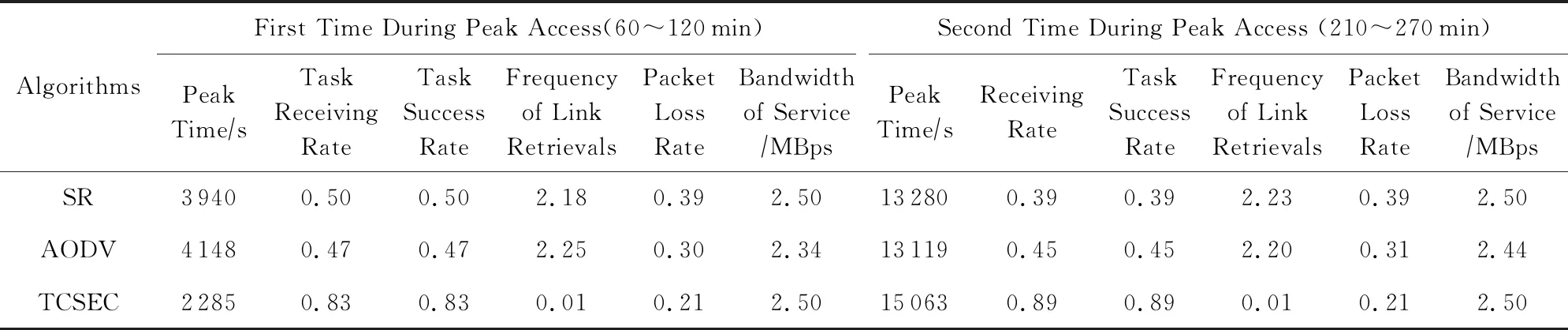

4.4 TCSEC模型系统性能对比

为对比边缘计算协同服务系统性能,以流量、负载、信誉度、任务接收率、协同成功率等为评价指标,基于TCSEC动态聚类,将本文提出的TCSEC与随机游牧(stochastic routing, SR)[54]、按需协同路由(ad hoc on-demand distance vector routing, AODV)[55]进行对比分析.

设ES集群存在100个待迁移计算任务,每个迁移计算任务量500≤M≤1 024,对目标计算任务所在ES进行浪涌式服务请求测试.用户请求频率f≤6次/s,链路重寻次数≤3,每次请求5个连续的流数据文件,实验测试时间10 h,采样时间设定与4.3节实验一致.

TCSEC与随机游牧、AODV协作的ES的负载和流量如图32,33所示,中继基站RN、盟主节点LN平均流量如图34所示,信誉度实验结果如图35所示,访问高峰段系统服务参数如表5~表6,协同服务响应延迟如图36所示,协同服务任务迁移丢包率如图37所示.

边缘计算协同服务系统具有5个特征:

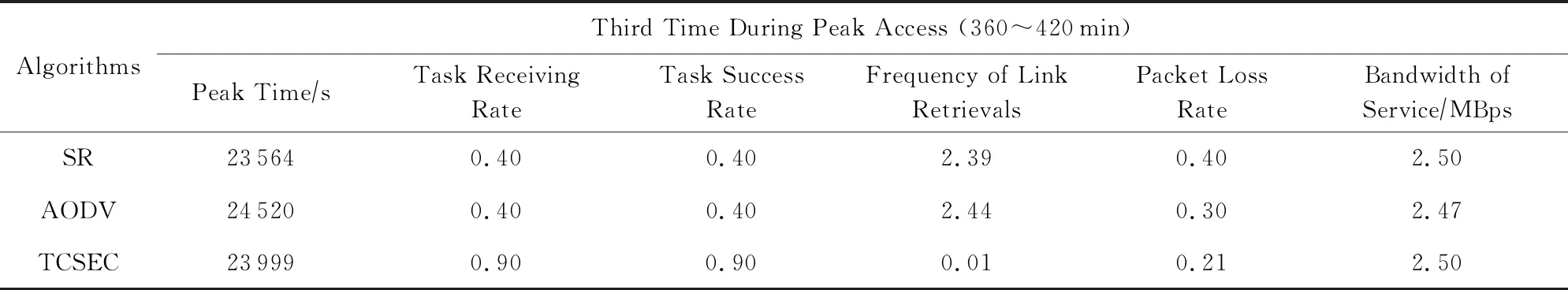

1) 第1阶段浪涌访问测试访问高峰时段60~120 min,TCSEC,SR,AODV算法ES峰值流量分别为28 201 MB/min,13 182 MB/min,15 754 MB/min,峰值负载分别为0.65,0.97,0.97,平均流量16 891 MB/min,6 491 MB/min,7 746 MB/min,平均负载分别为0.66,0.96,0.95,基站、盟主节点峰值流量分别为15 286 MB/min,19 454 MB/min,19 438 MB/min,峰值负载分别为0.74,0.97,0.97,平均流量分别为6 589 MB/min,6 579 MB/min,7 824 MB/min,平均负载分别为0.68,0.93,0.92.TCSEC,SR,AODV算法链路平均重寻次数分别为2.18,2.25,0.01,协同服务接收率和成功率均分别为0.83,0.50,0.47,丢包率分别为0.21,0.39,0.30.

2) 第2阶段浪涌访问测试访问高峰段210~270 min,TCSEC,SR,AODV算法ES峰值流量分别为10 230 MB/min,6 574 MB/min,9 633 MB/min,峰值负载分别为0.70,0.97,0.97,平均流量分别为5 179 MB/min,4 586 MB/min,5 171 MB/min,平均负载分别为0.49,0.95,0.94,基站、盟主节点峰值流量分别为7 854 MB/min,10 604 MB/min,16 890 MB/min,峰值负载分别为0.67,0.97,0.97,平均流量分别为2 020 MB/min,4 607 MB/min,5 108 MB/min,平均负载分别为0.58,0.93,0.92.TCSEC,SR,AODV算法平均链路重寻次数分别为2.23,2.20,0.01,协同服务接收率和成功率均分别为0.74,0.70,0.45,丢包率分别为0.21,0.39,0.31.

3) 第3阶段浪涌访问测试访问高峰段360~420 min,TCSEC,SR,AODV算法ES峰值流量分别为12 700 MB/min,4 258 MB/min,2 961 MB/min,峰值负载分别为0.70,0.97,0.97,平均流量分别为6 714 MB/min,795 MB/min,870 MB/min,平均负载分别为0.48,0.94,0.94,基站、盟主节点峰值流量分别为9 752 MB/min,10 546 MB/min,15 459 MB/min,峰值负载分别为0.65,0.97,0.97,平均流量分别为1 610 MB/min,3 962 MB/min,3 899 MB/min,平均负载分别为0.61,0.93,0.92;TCSEC,SR,AODV算法平均链路重寻次数分别为2.18,2.25,0.01,协同服务接收率和成功率均分别为0.89,0.39,0.45,丢包率分别为0.21,0.40,0.30.

4) 实验测试20 min,TCSEC,SR,AODV算法信誉度均为0.92.访问高峰时段,TCSEC 算法RN,LN的信誉度稳定于0.97~0.98,而SR,AODV算法RN,LN的信誉度趋于0.

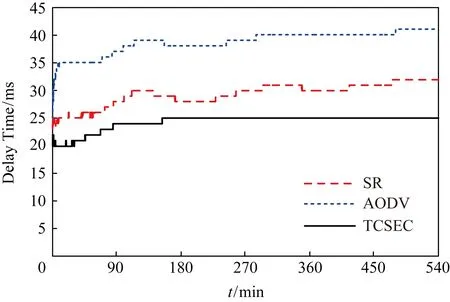

5) 系统边缘计算协同服务达到稳定后,TCSEC,SR,AODV算法已获得服务的盟员平均带宽分别为2.5 MBps,2.5 MBps,2.41 MBps,平均访问延迟分别为24 ms,37 ms,29 ms.

Fig. 33 Traffic of ES in edge computing cooperative service图33 边缘计算协同服务数据源服务器流量

Fig. 34 Average traffic of RN and LN in TCSEC,AODV and SR algorithms图34 TCSEC,AODV,SR算法中继基站和盟主节点平均流量

Fig. 35 Average trust of RN and LN in TCSEC,AODV and SR algorithms图35 TCSEC,AODV,SR算法中继基站和盟主节点平均信任度

Table 5 Performance Parameters of Cooperation Service for Edge Computing During Peak Access Time

Table 6 Performance Parameters of Cooperation Service for Edge Computing During Peak Access Time

Fig. 36 Access delay in edge computing cooperative service图36 边缘计算协同服务访问延迟

Fig. 37 Packet loss rate in edge computing cooperative service图37 边缘计算协同服务平均丢包率

实验结果表明:

1) 信誉评价与节点的负载、协同成功率相一致,能够有效反映协同节点实时状态.信誉度迅速下降直接反映了系统出现高拥塞、访问过载等现象.

2) TCSEC能够在浪涌式访问请求测试实现负载均衡,有效地完成协同任务,SR,AODV算法则因负载过大发生雪崩效应.

3) 在访问高峰时段,TCSEC与SR,AODV算法相比,ES峰值负载平均降低31.0%,平均负载平均降低40.6%,基站、盟主节点峰值负载降低27.7%,平均负载平均降低27.3%.

4) TCSEC与SR,AODV算法相比,协同任务接收率分别提高29.1%,36.4%,协同成功率分别提高29.0%,36.3%,协同传输丢包率分别降低18.3%,9.3%.

5) TCSEC与SR,AODV算法相比,平均服务带宽基本一致,请求接收率分别提高29.1%,36.4%,任务成功率分别提高29.1%,36.4%,接收延迟分别降低35.1%,17.2%.

小结:TCSEC与SR,AODV算法相比,在负载均衡能力上提高29%,系统服务能力分别提高29%和36%,服务质量分别提高35%,17%.TCSEC算法能够在浪涌式访问请求下有效地完成协同任务.

5 总 结

以数据源边缘服务器、岸基中心基站、岛礁/智能浮台中继基站、盟主节点、船舰、智能移动节点等构建的近海港口边缘计算协同服务面临网络拓扑动态、资源受限、抖动、搭便车、盲区效应、策略和恶意节点等诸多挑战,导致网络服务质量、容量和带宽的不稳定性,使网络效用下降.为保障网络服务效用,构建自适应协同服务系统是一种有效方法.从负载平衡的角度出发,根据边缘计算协同服务的负载情况,动态构造由协同服务盟员组成的边缘计算协同服务来解决目前近海港口边缘计算协同服务中存在拥塞、单点失效、盲区、效率和服务质量不高的问题.提出了一种基于盟主的边缘计算协同服务组织模型TCSEC,模型运用节点的信任度、贡献度、容量和带宽、链路质量等作为表征节点的特征属性,以任务驱动方式,由盟主节点基于节点的服务能力和相似性来选择协同服务的节点,构建边缘计算协同服务.给出了构建边缘计算协同服务的数学模型、约束条件和构造规则,并进行了较为详细的分析.仿真实验表明,通过构建边缘计算协同服务,能有效解决边缘计算服务提供节点过载的问题,实现了协同服务、资源共享、负载均衡的目的,提高了近海港口环境下边缘计算协同服务的服务质量.