一种基于亚像素匹配的高精度视觉定位方法

2020-06-08高嘉瑜袁苏哲

高嘉瑜,袁苏哲,李 斌

(中国电子科技集团公司第二十研究所,西安 710068)

0 引言

近年来,无人机系统能力不断提升,在城市反恐侦察、灾害监测、物流配送、交通疏导等军事和民用领域崭露头角,应用前景尤为广阔。无人机定位是无人机遂行动态任务的必要环节,也是无人机自主能力的重要体现。视觉导航技术具有高自主性、无源性、低成本性等特点,近年来被广泛应用。

基于视觉的景象匹配是实现自主导航的有效手段之一。景象匹配导航源于巡航导弹景象匹配(Scene Matching Navigation System,SMNS)末端制导技术,其工作原理是:事先获取飞行器预定飞行区域的地物景象作为基准图像,并标注真实地理信息,存于飞行器机载计算机中作为基准图数据库;当飞行器飞到预定区域时,机载图像传感器实时获取当地景象作为实测图像传送到机载计算机中和基准图像进行匹配,由于基准图像的地理坐标位置是已知的,根据与实测图像的匹配位置,即可以确定当前飞行器的准确位置。因此,景象匹配导航是一种实现飞行器自主导航的绝对定位技术。无人机景象匹配定位方法通过使用预先存储的包含精确地理信息的导航地图,利用一帧实拍图像与导航地图匹配即可实现飞行器的绝对定位。

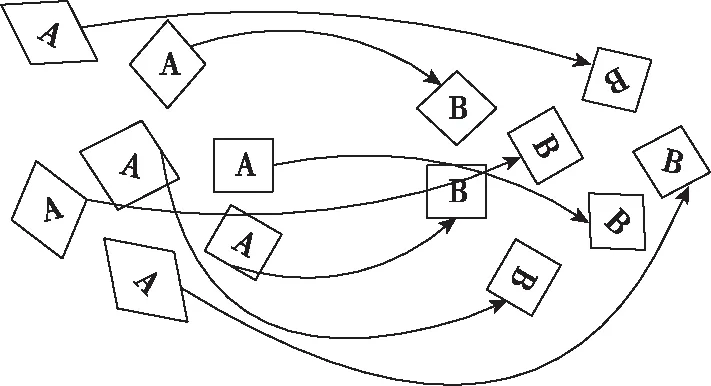

目前常用的是基于特征点像素级匹配的方法来实现景象匹配,通过检测图像中目标的特征来实现匹配。常见的特征描述算子有SIFT特征描述算子、SURF特征描述算子以及ORB特征描述算子。SURF特征描述算子是对SIFT特征描述算子进行了改进,基本代替了SIFT特征描述算子。SURF算法具有较强的鲁棒性,但是计算速度较慢;ORB算法有着较快的计算速度,并且具备较好的匹配效果。基于视觉的景象匹配定位示意图如图1所示。

图1 基于视觉的景象匹配定位示意图Fig.1 Schematic diagram of vision-based scene matching and positioning

图像匹配是无人机视觉导航过程的核心技术之一,其匹配的速度和精度对导航系统的准确度和效率有着直接影响。目前,大多数图像匹配算法是在某个离散化空间上估计一个视差集合,如整数像素视差,这对于只需要少量特征点的应用场合是足够的。而无人机视觉导航中往往需要处理超高分辨率的航拍图像,图像间存在光照条件、视角和尺度差异,并且要求亚像素级定位精度[1]。因此,鲁棒性好且具有亚像素级精度的图像匹配是提高无人机视觉导航系统整体性能的一个关键问题。

在亚像素级图像匹配领域,国内外已经有一系列的研究成果。大致可以分为四类:1)扩展相位相 关法:该类方法是对相位相关法的改进,不仅对灰度差和窄带噪声不敏感,而且还保留了相位相关法的优点,可分为时域求解法和频域求解法[2-3]。在频域求解时匹配精度高,计算量小。2)基于插值的方法:该类方法主要通过灰度内插实现亚像素级匹配精度,分为相似性函数内插法和图像灰度直插法[4-5]。该类方法的优点是精度高。3)最优化法:该类方法选用适当的数学模型,通过迭代对参数进行优化,通过逐步优化得到亚像素级精度的匹配[6-8]。该类方法能够支持各种变换模型,匹配精度也比较高。4)基于特征点的方法:该类方法主要基于图像中的显著性特征(如点特征、线特征和区域特征),通常结合内插法或相位相关法使配准精度达到亚像素级[9-12]。该类方法在保持鲁棒性的同时具有较高的匹配精度,因此被广泛应用于亚像素图像配准。但无论哪种方法都各有优势和不足:1)扩展相位相关法只能处理固定形式的图像变化,对于更复杂的非线变换无法达到匹配效果;2)插值法的缺点是计算量大,且匹配精度依赖于内插算法的质量;3)最优化法中寻找全局最优化的概率有待提高;4)基于特征点的方法不适用于图像视角变化较大的情况。

综合以上研究与分析发现,各种方法在匹配精度、运行时间和因图像之间差异性造成的鲁棒性方面,存在较大的差异。因此,将图像匹配精度提高到亚像素级,减少算法复杂度,降低误匹配率,同时增强算法对图像差异的鲁棒性,仍然是一个大的挑战。

本文提出了一种基于亚像素匹配的高精度视觉定位方法。首先选择具有仿射不变性的特征点来表征图像,提取边缘特征,结合高斯亚像素拟合原理及特征描述符简化方法,并采用渐进采样一致性(Progressive Sampling Consensus, PROSAC)算法剔除误匹配点,最终实现亚像素级的图像匹配定位。算法的工作流程如图2所示,该算法的基本思想是:首先对输入图像进行仿射变换模拟,并提取边缘特征点;其次,对边缘特征点的灰度差值进行高斯曲线拟合,以获取亚像素级特征点;接着,拟采用特征向量夹角作为特征的相似性度量;最后,根据夹角与阈值的关系判断特征点是否为一个匹配对。解决了微小型无人机视觉导航对图像匹配算法高精度的需求。

图2 软件平台工作流程图Fig.2 Software platform working flow chart

1 图像预处理

1.1 仿射不变性模拟

无人机在视觉导航中常常会出现图像之间存在较大视角差异,这种情况下图像匹配性能会急剧下降,对无人机定位和环境构建的准确性产生严重影响。仿射不变特征由于抗视角变换能力强,被越来越多地应用在图像差异较大时的图像匹配。因此,这里采用具有仿射不变性的特征点来表征图像,本文受ASIFT 模拟思想的启发,通过模拟摄像机位置变化产生的形变克服这一缺陷,提出了一种完全仿射不变的匹配算法。

仿射模型含有6个自由度,其中2个平移变量tx和ty,1个相机旋转变量ψ,1个均匀缩放系数s,另外2个变量用于定义相机主光轴方向,称为经度φ和纬度θ。通过改变相机主光轴方向的经度和纬度这2个角度参数来模拟不同的视场,然后对获取的所有模拟图像对利用某一尺度不变方法进行特征提取与匹配,将生成许多不同经纬度参数下的模拟图像,足以模拟不同视点下的仿射形变图像,保证了尺度一定下的仿射不变性。

对每一幅图像进行仿射变换模拟由于摄像机位置变化产生的仿射形变。图像的仿射形变主要取决于经纬度的变化,因此在对原始图像做仿射变换时只对摄像机的经纬度进行模拟,为了模拟出尽可能多的形变图像,在对经纬度采样时按照如下规则进行:

1)纬度角θ和倾斜程度t满足一一对应关系,即θ=arccos(1/t),t的采样值选为t=1,a,a2,…,an。其中,指数n为仿射变换的模拟次数,该值越大则模拟出的仿射变换的情况越多。

2)经度角φ通过一组采样数据来实现模拟:φ=0,b/t,…,kb/t(kb/t<180°),即一个t对应多个经度角。选择b为角度数,k为一个满足(kb/t<180°) 的最大整数。

图3 图像仿射变换示意图Fig.3 Schematic diagram of image affine transformation

在得到一系列的(φ,θ)之后,通过仿射变换模型即可得到对应于近似图像A的模拟图像。

2 亚像素特征提取

2.1 对模拟图像提取边缘特征点

在模拟后的图像进行特征提取,可以得到具有抗视角变换能力的像素级边缘特征。相较于传统的特征提取算法,该算法在图像存在光照变化、尺度变化和较大视角差异时,仍然能够对图像特征进行准确、充分地提取。

采用中值滤波法对图像进行噪声去除,以除去孤立的点。采用SUSAN 算法提取图像边缘轮廓, 边缘轮廓是图像最基本的特征,蕴含了丰富的内在信息。SUSAN 算子是一个简单有效的边缘检测算法,算法效率较高,而且抗噪声能力强。因此,采用SUSAN 算法提取图像边缘轮廓。

2.2 亚像素级特征提取

由于边缘提取算法只能获取像素级精度的特征点,意味着整数像素点之间的信息丢失了。因此需要在此基础上进行亚像素级特征提取,从而获得更高的精度。该算法在本环节中,拟采用以下步骤实现:

首先,沿着粗定位边缘点(即上一步骤获取的像素级边缘特征)的梯度方向寻找距离为L的邻近点(并非都是整像素点),当梯度方向与水平方向夹角小于45°时,L=1/cos(θ);

然后,对邻近点进行灰度线性插值处理,通过邻近点的灰度值计算粗定位边缘点的灰度差值,根据高斯亚像素拟合原理,图像边缘点灰度值变化呈高斯分布,高斯曲线的表达式为

(1)

式中,μ是中心点坐标,σ是高斯函数的标准差,u是粗定位点的灰度差值;

最后,拟采用最小二乘法拟合并计算出μ和σ,假设粗定位边缘坐标为p(x0,y0),则根据σ和求取的边缘点梯度方向夹角θ可以求出亚像素级边缘点的坐标为p′(x0+σcos(θ),y0+σsin(θ))。

3 亚像素图像匹配

3.1 构建特征向量

以亚像素边缘点为特征点(x,y),按照式(2)计算其梯度和模值

m(x,y)=

(2)

式中,L是每个特征点所在的模拟图像。在以特征点为中心的邻域窗口内进行采样,采用直方图统计邻域像素的梯度方向,并用高斯函数对直方图进行平滑。梯度直方图描述的范围是0°~360°,每10°一个柱,共36个柱,以直方图的峰值作为该特征点的主方向。

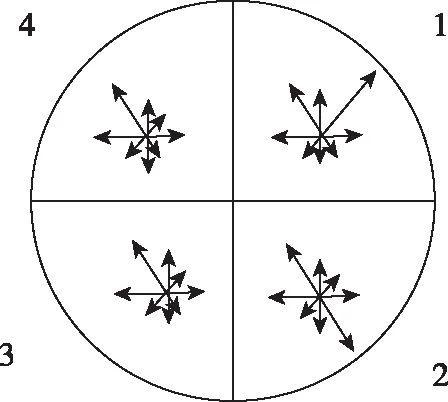

在特征点所在的尺度空间中,以关键点为中心产生一个圆形区域,计算像素梯度,将圆形区域旋转至主方向,对梯度做高斯加权。将圆形区域分为2×2 个扇形子区域,在每个扇形区域内统计8 个方向的梯度直方图如图4(b)所示。

SIFT 生成描述符时,以关键点为中心生成一个方形邻域,然后将其分为16 个子区域,在每个区域内统计8 个方向的梯度直方图如图4(a)所示,最终生成128 维描述符。尽管本文方法也需要统计梯度直方图,但是只需要在4 个扇形区域上进行统计,统计次数比SIFT少了12 次;另外本文算法的描述符维度降低了32 维,在进行描述符相似度计算时,使用该描述符可以大大降低计算量,提高匹配效率。

(a) SIFT 描述符

(b)本文算法描述符图4 描述符扇形子区域Fig.4 Descriptor sector subregion

将4 个扇形的梯度直方图合并得到32 维的描述符,然后进行归一化处理,以降低光照变化对描述符的影响。

3.2 特征向量匹配

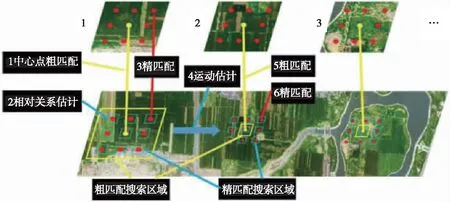

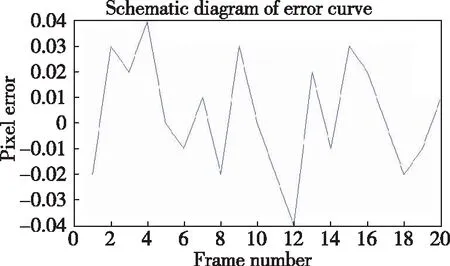

计算2幅图像中特征向量的夹角,若图像1中特征向量与图像2中特征向量的最小夹角为θmin,次小夹角为θsec,且存在(θmin/θsec) 用比值θmin/θsec对初始匹配点对进行排序并构成一个集合,比值最小的特征点对是集合的第1个元素。根据比值大小升序排序。在排好序的匹配对中选取前S个为一个数据集,在前S-1个数据集中选择3个匹配对,然后选取第S个数据,利用4个匹配点对计算单应矩阵H;将上述4组点剔除后,其他点根据单应矩阵H,计算相应投影点;计算其他点和投影点之间的误差e,并和误差极限δ进行比较,e<δ为内点,反之为外点;计算内点数目t, 并和设定内点数目阈值T进行比较,若t>T内点数目更新为t,若t≤T,则S=S+1重新进行数据选取。更新内点数目t后,再次计算单应矩阵H,以获取新的内点;若迭代次数小于给定最大迭代次数,返回单应矩阵H,反之模型不符合,剔除匹配点对。 即用比值θmin/θsec对初始匹配点对进行排序并构成一个集合,比值最小的特征点对是集合的第1个元素。每次按顺序从集合中选取4对特征点进行变换矩阵的估计。相较于传统RANSAC算法中随机选取特征点对,该算法能有效避免陷入局部最优,保证了最终图像匹配的准确度。 当无人机在飞行过程中,机载图像传感器实时获取正下视景象作为实测图像传送到机载计算机中和基准图像进行匹配。由于基准图的地理坐标位置是已知的,因此,根据与实时拍摄图像的匹配位置,即可以确定当前飞行器的准确位置。 在飞行过程中,可以利用运动的连续性确定后续图像的大致位置关系,缩小搜索空间。在第1次定位时使用较大的搜索窗口确定中心点的对应位置(图5中黄框内区域);一旦图像匹配确定了中心对应关系,可以利用运动关系对位置关系进行估计,缩小搜索区域(图 5 蓝框内区域),大大提高算法的运算效率。 无人机的飞行轨迹可以使用一些曲线进行拟合,实际飞行过程中,无人机往往保持匀速巡航,短时间内的运动可视作匀速直线运动。通过读取无人机当前的速度信息可以估计无人机下一时刻的位置。后续图像匹配搜索只需要在较小区域内进行,使得该算法的匹配效率得到明显提升。搜索窗口的尺寸大小关系如图5所示。 图5 基于视觉的景象匹配定位搜索窗口示意图Fig.5 Schematic diagram of vision-based scene matching and positioning search window 为了验证实际应用的精确性与高效性,进行了实验,并和传统的二次曲面拟合算法进行精度及效率的对比。 实验一采用某地区上空的航拍遥感影像,图像分辨率为1280 × 1920 像素,获取连续20帧遥感影像,如图6所示。 图6 实验一遥感图Fig.6 Remote sensing map of experiment one 对20 帧连续图像进行亚像素配准。在使用梯度法求解亚像素配准位置时,位移图像正是以整像素配准位置作为其一阶泰勒级数的展开位置。如图7所示: 可以看出匹配定位误差控制在0.05像素级以内。 图7 误差曲线示意图Fig.7 Schematic diagram of error curve 采用传统的二次曲面拟合法进行匹配,匹配误差精度如图8所示,误差精度为0.15像素。 图8 传统二次曲线拟合误差曲线示意图Fig.8 Schematic diagram of traditional quadratic fitting error curve 匹配时间对比如图9所示:绿色曲线为本文算法匹配时间,在0.25s以内;蓝色曲线为传统二次曲线拟合法匹配时间,在0.3s以内。可以看出,本文算法在匹配时间上优于传统二次曲线拟合匹配算法。 图9 本文算法和传统二次曲线拟合匹配算法时间曲线示意图Fig.9 The time curve of the proposed algorithm in this paper and the traditional quadratic curve fitting matching algorithm 试验二采用清凉寺公园无人机拍摄图像进行试验,图像分辨率为1080 × 720 像素,如图10所示。 图10 实验二场景图Fig.10 Scene graph of experiment two 利用无人机得到20帧序列图像,对相邻图像进行亚像素匹配,得到误差曲线如图11所示,误差不超过0.05像素。 图11 误差曲线示意图Fig.11 Schematic diagram of error curve 采用传统的二次曲面拟合法进行匹配,匹配误差精度如图12所示,误差精度为0.15像素。 图12 传统二次曲线拟合误差曲线示意图Fig.12 Schematic diagram of traditional quadratic fitting error curve 匹配时间对比如图13所示:绿色曲线为本文算法匹配时间,在0.2s左右;蓝色曲线为传统二次曲线拟合法匹配时间,在0.35s以内。可以看出,本文算法在匹配时间上优于传统二次曲线拟合匹配算法。 图13 本文算法和传统二次曲线拟合匹配算法时间曲线示意图Fig.13 The time curve of the algorithm in this paper and the traditional quadratic curve fitting matching algorithm 将此方法应用在无人机景象匹配中,目前已在虚拟场景中进行试验。当无人机飞到预定区域时,机载图像传感器实时获取当地景象作为实测图像传送到机载计算机中和基准图像进行匹配。由于基准图像的地理坐标位置是已知的,因此,根据与实测图像的匹配位置,即可以确定当前飞行器的准确位置。由于选用基于亚像素的匹配,在实时定位中可将景象匹配精度提高到亚像素级。 本文针对无人机视觉导航过程中图像失真大、匹配精度低的问题,提出了一种基于亚像素匹配的高精度视觉定位方案。算法分析与实验结果表明: 1)利用仿射不变性特征来表征图像,抗视角变换能力强,和其他特征相比具有很强的鲁棒性,能够减少因图像视角偏差较大所引起的匹配性能下降问题。 2)采用了简化描述符的方法,和SIFT算法相比,只需要在4 个扇形区域上进行统计,统计次数比SIFT少了12 次;另外本文算法的描述符维度降低了32 维,在进行描述符相似度计算时,使用该描述符可以大大降低计算量。 3)采用本文PROSAC算法剔除误匹配点,引进了将向量的最小夹角和次小夹角的比值进行排序,相较于传统RANSAC算法中随机选取特征点对,该算法能有效避免陷入局部最优,保证了最终图像匹配的准确度,且降低了运算量。 本算法创新点:用具有仿射不变性的亚像素边缘特征点来表征图像,保证了图像视角差异较大时匹配的高准确度,增强了匹配算法对视角变化的鲁棒性,并将特征的定位精度提高到了亚像素级。并与PROSAC算法相结合,提高了算法的实时性。 目前算法还处于实验室仿真阶段,距离工程应用还有差距。针对此问题,下阶段将首先搭载悬翼无人机进行飞行试验,验证算法的实时性及鲁棒性。4 基于亚像素景象匹配定位

4.1 亚像素景象匹配定位方法

4.2 匹配搜索区域估计

5 仿真验证

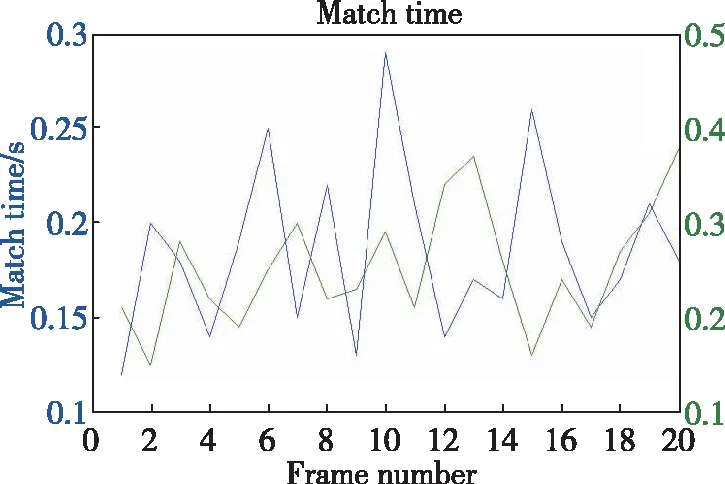

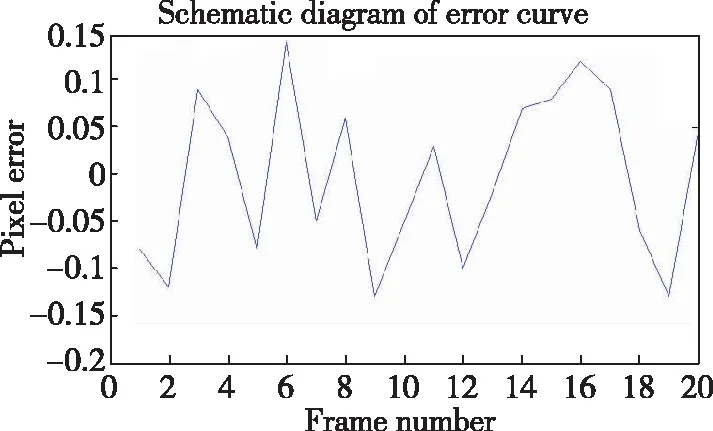

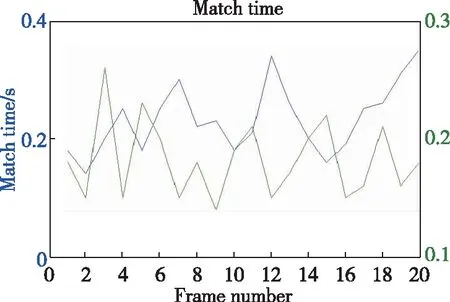

6 结论