基于Tetrolet变换的近红外与彩色可见光图像融合算法研究

2020-05-06苑玉彬陈小朋

苑玉彬,彭 静,沈 瑜,陈小朋

〈图像处理与仿真〉

基于Tetrolet变换的近红外与彩色可见光图像融合算法研究

苑玉彬,彭 静,沈 瑜,陈小朋

(兰州交通大学 电子与信息工程学院,甘肃 兰州 730070)

针对近红外与彩色可见光图像融合后出现的对比度降低、细节丢失、颜色失真等问题,提出一种基于Tetrolet变换和自适应脉冲耦合神经网络PCNN(PCNN-Pulse Coupled Neural Network)的近红外与彩色可见光图像融合的新算法。首先将彩色可见光源图像转换到各个分量相对独立的HSI空间(HSI-Hue Saturation Intensity),将其亮度分量与近红外图像进行Tetrolet分解,对分解后得到的低频系数,提出一种从给定不完备数据集中寻找潜在分布最大似然估计的期望最大算法融合规则;对分解后得到的高频系数,采用一种Sobel算子自动调节阈值的自适应PCNN模型作为融合规则;处理后的高低频图像经Tetrolet逆变换作为融合后的亮度图像,提出一种饱和度分量自适应拉伸方法来解决图像饱和度下降的问题。处理后的各个分量反向映射到RGB空间,完成融合。将本文算法与多种高效融合算法进行对比分析,实验表明,本方法取得的图像,细节清晰,色彩对比度得到提升,在图像饱和度、颜色恢复性能、结构相似性和对比度等客观评价指标上均具有明显的优势。

彩色图像融合;Tetrolet变换;期望最大算法;自适应脉冲耦合神经网络

0 引言

图像融合是将多幅具有不同特征的源图像进行融合,得到源图像的所有重要特征,能够降低信息的不确定性,扩展了图像内容,更适用于后续的识别处理和研究。近红外与彩色可见光图像融合技术能将近红外传感器获取的人眼无法观测到的细节信息同彩色可见光图像中的场景信息等结合起来,因此本研究在军事和民用领域具有重要意义[1-3]。

在近红外与可见光图像的融合方法探索中,基于多尺度几何分析的方法应用最为广泛。2010年,Jens Krommweh[4]等提出了Tetrolet变换,它是一种具有良好的方向性结构的稀疏图像表示方法,能够较好地表达图像的高维纹理特征,并具有高稀疏性,更适合在图像融合中作为融合框架。LIU[5]等利用凸度图在两幅原始图像中检测感兴趣区域ROI(ROI-Region of interest),然后在两幅红外图像上进行多尺度变换。根据ROI检测将变换得到的子带系数分为4类,并对每种系数进行了融合规则的定制。Jie[6]等应用基于非下采样剪切变换和热源浓度比的融合方法,克服了方向分解的局限性,具有更好的平移不变性。通过变换将输入分解为两部分,在低频部分采用热源浓度比和空间频率以尽可能多地保留重要信息,信息熵作为高频融合规则。Nemalidinned[7]等对分解后的低频分量采用PCNN进行融合,通过拉普拉斯激励修正神经网络经,以保持两个源图像中的最大可用信息。高频采用局部对数Gabor进行融合。Cheng[8]等将PCNN与奇异值分解应用到图像融合中,使用两种分量的图像平均梯度分别作为刺激源。将局部结构信息算子作为增强融合精度的自适应连接强度,对每个源图像进行局部奇异值分解,自适应地确定迭代次数。Zhang[9]等将Tetrolet分解后的低频采用平均融合,高频采用区域能量最大值融合分量。Zhou[10]等将Tetrolet分解后的低通子带系数采用局部区域梯度信息方法进行融合,具有更丰富的特征和更多的信息量。冯鑫[11]将Tetrolet分解后的低频采用学习字典,高频采用PCNN方法进行融合。这些方法均取得了良好的融合结果。

本文根据HSI色彩空间中3个分量不相关的特征,提出一种新的融合方法。首先采用标准模型法将彩色可见光图像转到HSI空间,对亮度分量和近红外图像进行Tetrolet分解。采用一阶范数最大值进行模板的选择,解决了原始的Tetrolet变换降低高频系数取值范围的问题,使分解后的高频分量中包含了更多的轮廓信息。从给定不完备数据集中寻找潜在分布最大似然估计,提出了一种基于最大期望算法的低频分量融合规则。为了更好地保留融合图像的细节信息,在高频分量融合时采用选取点火次数最多的神经元所对应的系数的PCNN网络作为高频分量,并利用Sobel算子自适应地控制PCNN的阈值。经过Tetrolet逆变换得到新的亮度分量。最后再将3个分量反向映射到RGB空间(RGB-Red Green Blue),完成处理。

1 算法思想

1.1 HSI空间映射

HSI空间为另外一种色彩描述方法,将颜色分成了如下3个特征:第一个特征是色调或色度(Hue),可表示RGB等各种颜色的种类;第二个特征是用来表示颜色的鲜艳程度的,即饱和度或彩度(Saturation);第3个特征是用来表明明暗的,称为明度或亮度(Intensity)。同时这3个通道具有较强的独立性并且同图像的彩色信息无关,因此这些特点使得HSI模型广泛应用于彩色图像的特性检测与处理[12]。

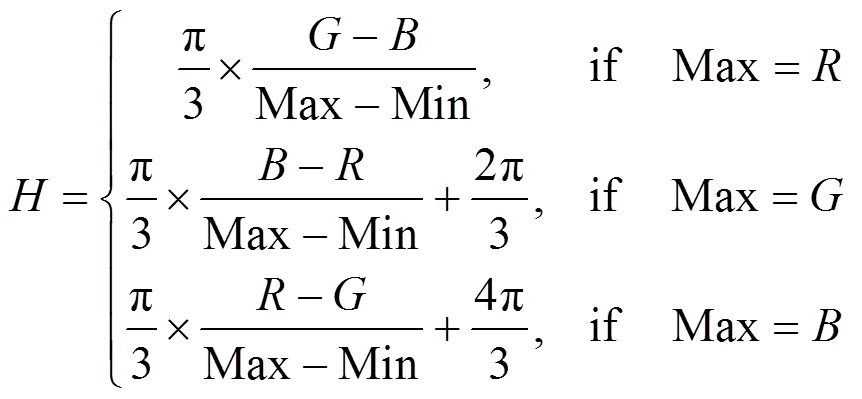

本文采用标准模型法对图像完成空间转换,方式具体如下:

=+2p, if<0 (2)

=Max-Min (3)

=(Max+Min)/2 (4)

式中:、、均为归一化数据。

1.2 Tetrolet变换

Tetrolet变换是一种Haar类的小波变换,能够根据图像特征自适应的调整四拼版的填充方式进行分解,以达到最优解,比传统的多尺度变换能够获得更多的细节信息[4]。具体如下:

Step 2 采用一阶范数的最大值进行滤波替换原始的一阶范数的最小值进行滤波,以期得到更多的边缘和轮廓信息。选择公式为:

Step 3 将低频系数重新排列,保留最优模板,得到的低频系数重新进行Step 1,直至分解完成。

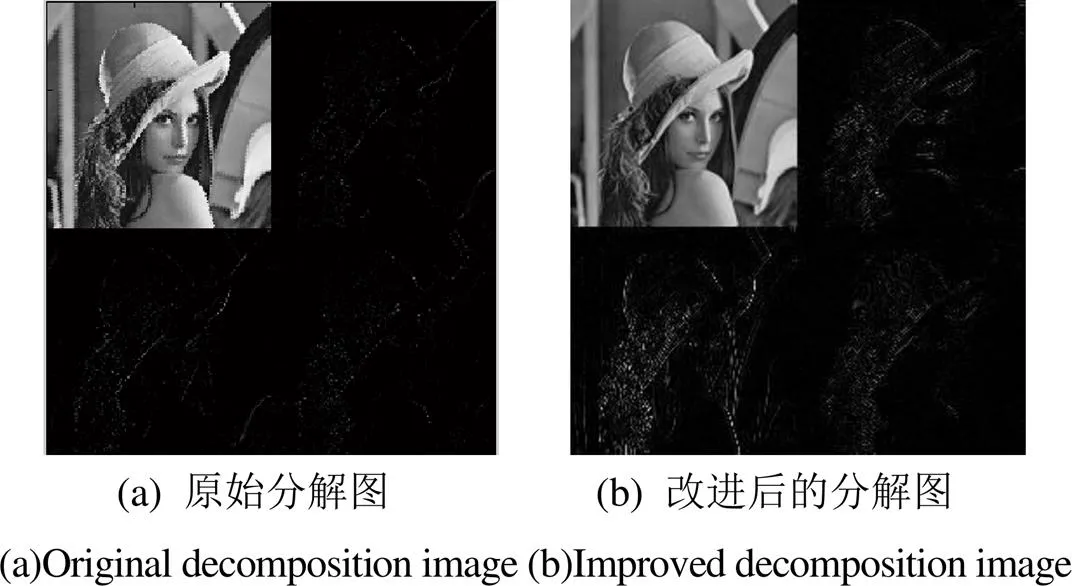

改进前后的对比如图1所示。由图可知改进的Tetrolet变换能够保存更多的轮廓和边缘细节,对融合处理更有利。

图1 原始Tetrolet变换和改进的Tetrolet变换效果对比图

1.3 PCNN模型

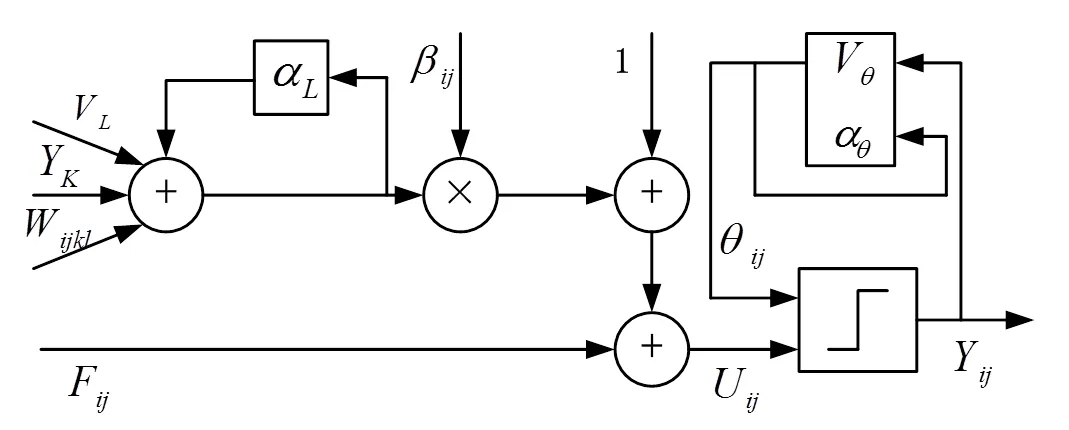

PCNN由含有输入域、调制域和脉冲产生器的多个神经元构成,图像的每个像素同PCNN神经元一一对应,输出状态有点火和不点火2种[13]。简化模型如图2所示。

图2 PCNN单个神经元简化模型图

在PCNN的处理中,输入域接收外界输入S和前一级反馈输出F,接收到的信号在调制域经过非线性调制得到活动信号U,脉冲产生器比较U与阈值的大小,U大于时,产生脉冲Y=1,点火一次,接着快速增加,直到当大于U时,输出Y=0,形成脉冲信号Y。

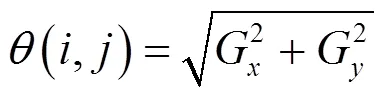

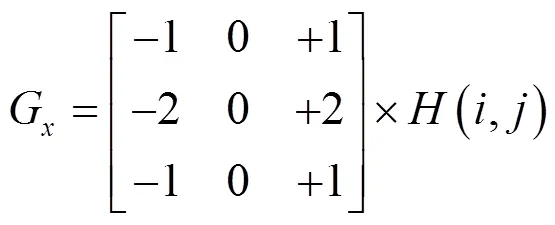

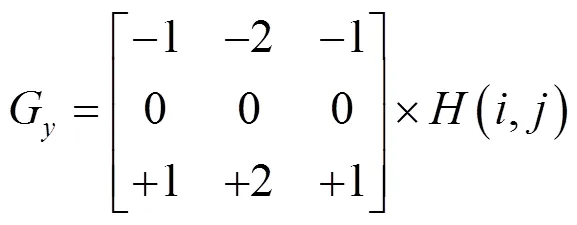

前期的图像融合算法研究中通常直接设定PCNN模型的阈值为固定值,本文提出采用Sobel算子自适应地控制PCNN的阈值[14],具体如下:

式中:(,)为高频子带系数。

2 基于Tetrolet变换的近红外与彩色可见光图像融合算法

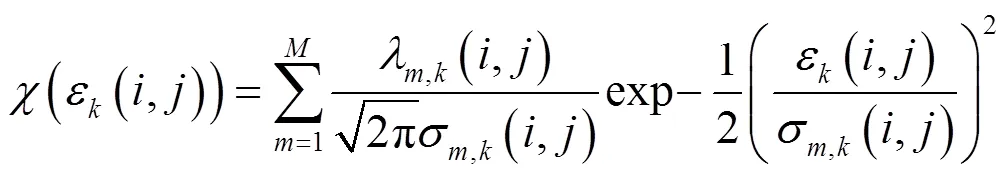

在对Tetrolet变换和自适应PCNN模型进行改进的基础上,并结合HSI图像空间各个分量相互独立的特点,提出了一种新的融合算法,具体步骤如下:

1)采用标准模型法将彩色可见光图像VI映射到HSI空间;

2)对亮度分量b和近红外图像i分别进行Tetrolet变换,低频系数bl与il采用期望最大算法进行融合,得到fl;对高频系数bh与ih采用改进的自适应PCNN进行融合,得到fh。对fl与fh进行Tetrolet逆变换,得到f作为新的亮度分量;

3)对饱和度S分量进行自适应非线性拉伸,得到S¢作为新的饱和度分量;

4)将新的亮度分量f、拉伸后的饱和度分量S¢和原始色度分量H反向映射到RGB空间,完成处理。

本文融合流程如图3所示。

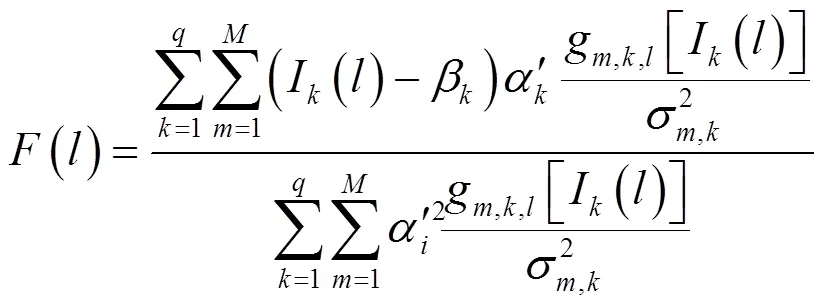

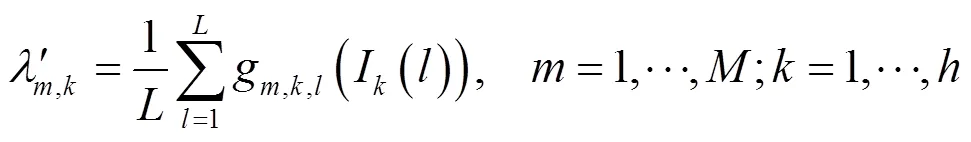

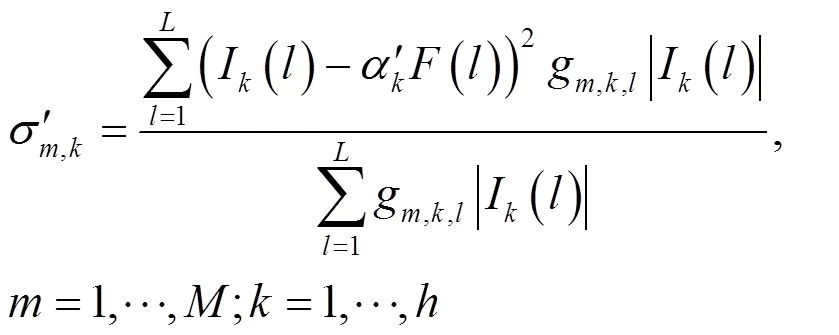

2.1 基于期望最大算法的低频系数融合规则

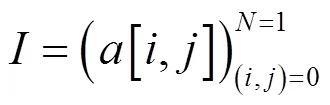

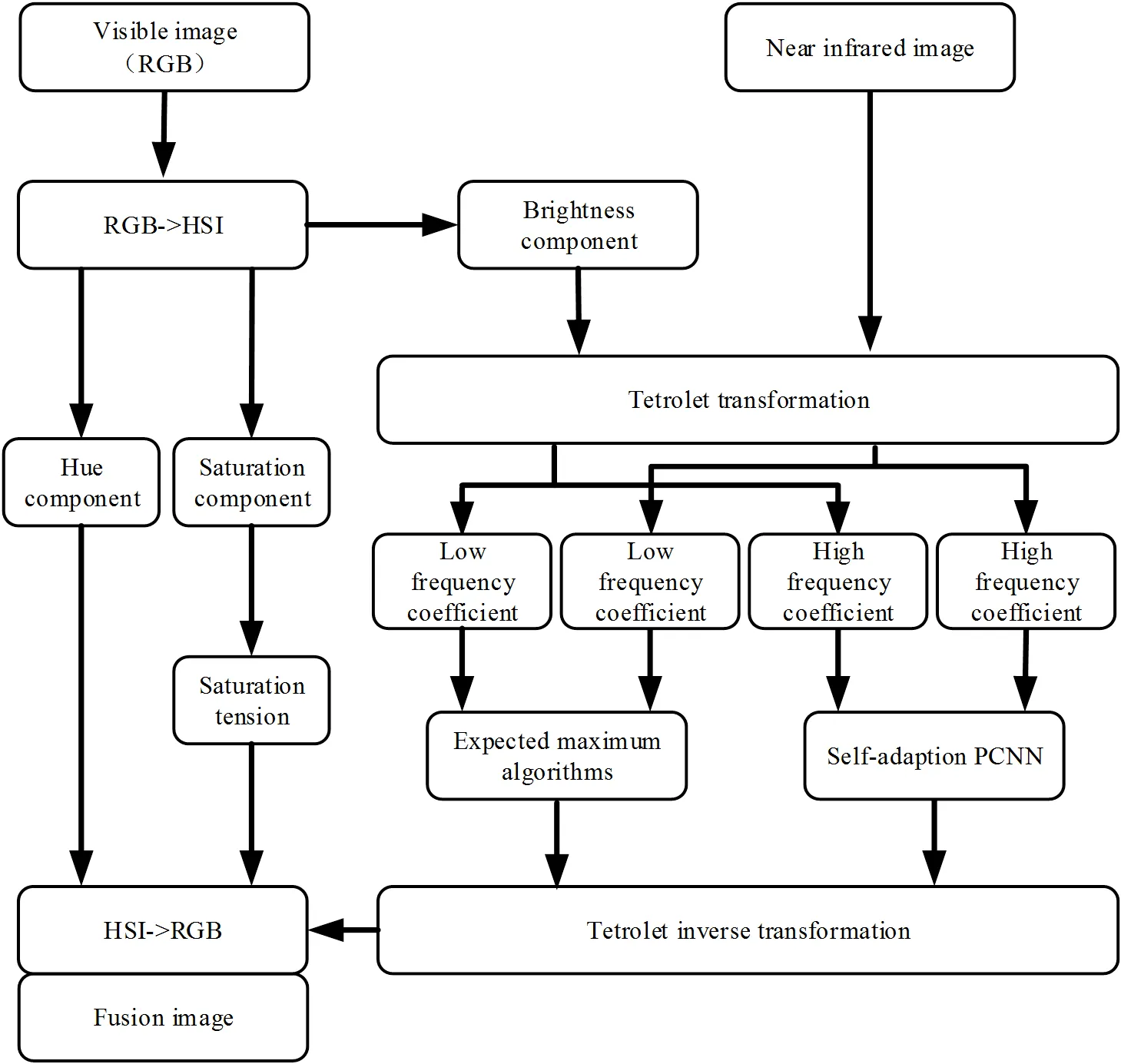

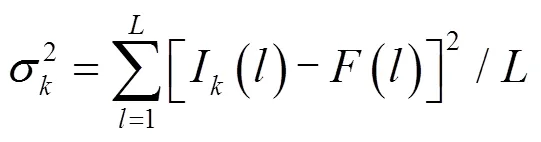

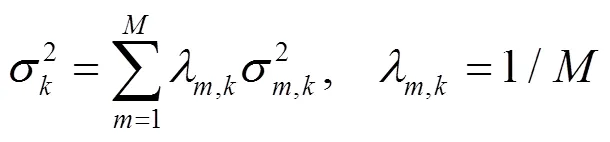

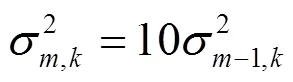

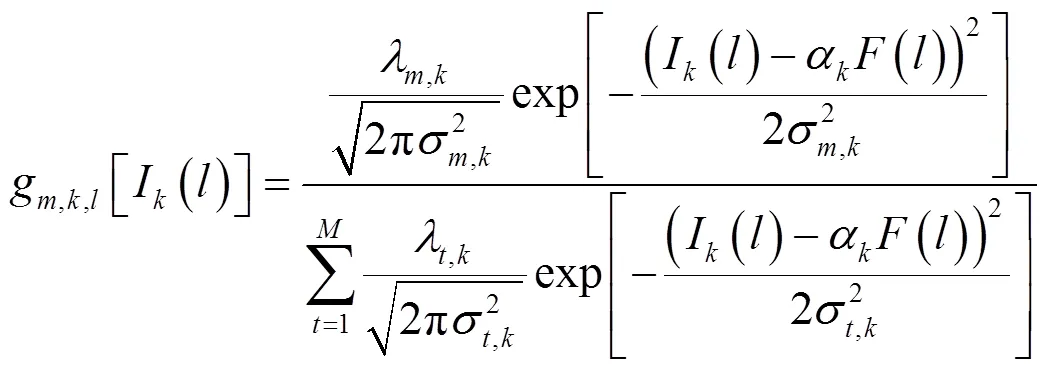

本文通过从给定不完备数据集中寻找潜在分布最大似然估计,将期望最大算法运用到低频系数图像的融合中[15]。假定待融合的幅低频图像I,∈{1, 2, …,}来自一幅未知图像(),说明数据集是不完备的。l的一个通用模型为:

I(,)=(,)()+(,) (9)

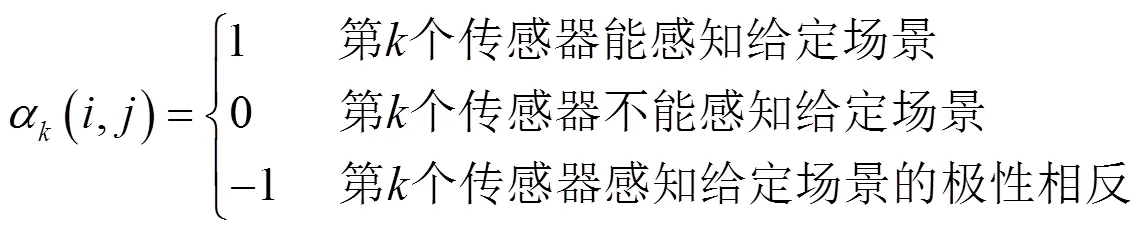

式中:(,)∈{-1, 0, 1}为传感器选择性因子;(,)为位置(,)处的随机噪声。当图像不具备同样的形态时,使用传感器选择性因子:

在低频融合中,对局部噪声(,)使用个高斯概率密度函数进行表示:

式中:,k(,)表示局部噪声的期望值;,k(,)表示局部噪声的标准差。

图3 本文算法融合流程图

低频系数的融合步骤如下:

Step 1 对图像数据进行标准化和归一化处理:

I¢(,)=[I(,)-](12)

式中:为整幅图像的均值;为灰度级。

Step 2 设定各参数初始值,假设融合后的图像为():

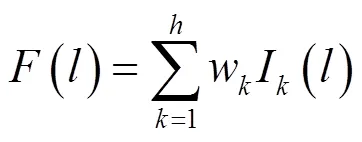

式中:w为待融合图像的权系数。

像素邻域窗口=×的总体方差为:

混合高斯模型的初始化方差为:

Step 3 计算在参数给定情况下,混合高斯分布第项条件概率密度:

Step 4 更新参数,的值在{-1, 0, 1}中选择以使式(18)的值最大:

Step 5 更新真实场景():

Step 6 更新噪声的模型参数:

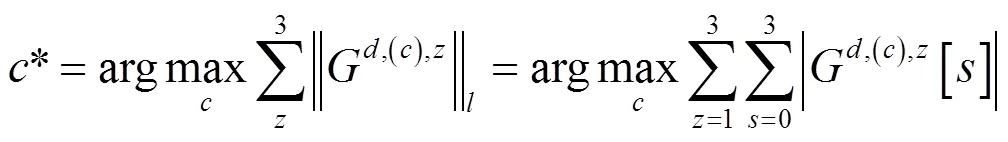

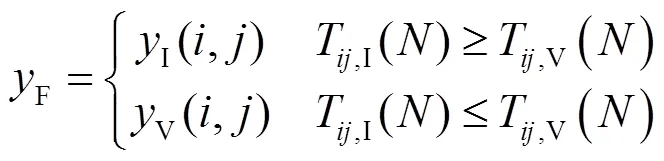

2.2 基于改进自适应PCNN的高频融合规则

PCNN的点火次数同外界刺激成正相关,表明包含细节信息的多少,因此取点火次数大所对应的Tetrolet系数。当=时,迭代停止,取初试值为0,l(,)=0,0,l(,)=0,0,l(,)=0,得到融合后的系数F为:

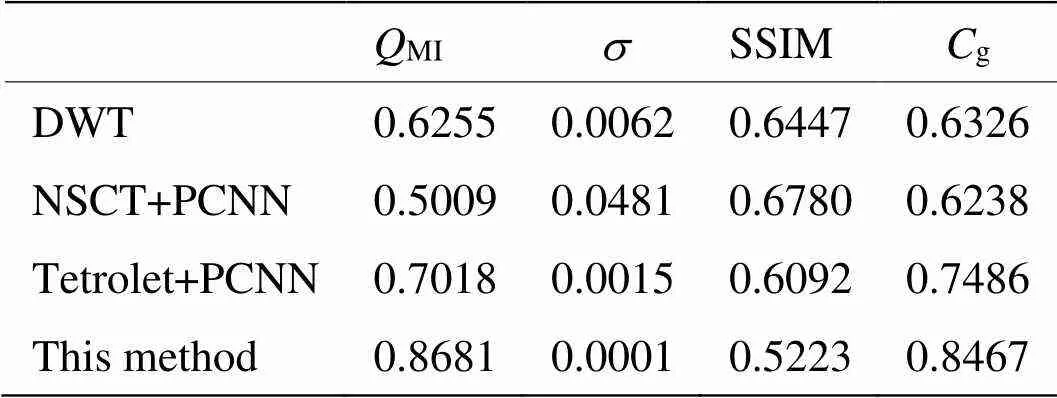

2.3 图像饱和度拉伸

若将处理后的各个分量直接转到RGB空间,将会出现颜色偏淡、对比降低、色彩不突出等问题,导致失真。为了达到提升对比度的目的,并且能够在不同情境下达到最优拉伸效果,本文提出了一种自适应对饱和度进行非线性拉伸的方法,具体如下:

式中:Max为分量像素最大值;Min为分量像素最小值。拉伸前后效果对比图如图4所示。

3 实验结果与分析

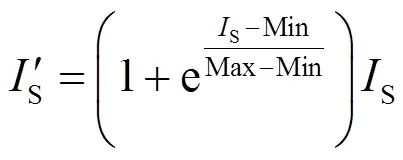

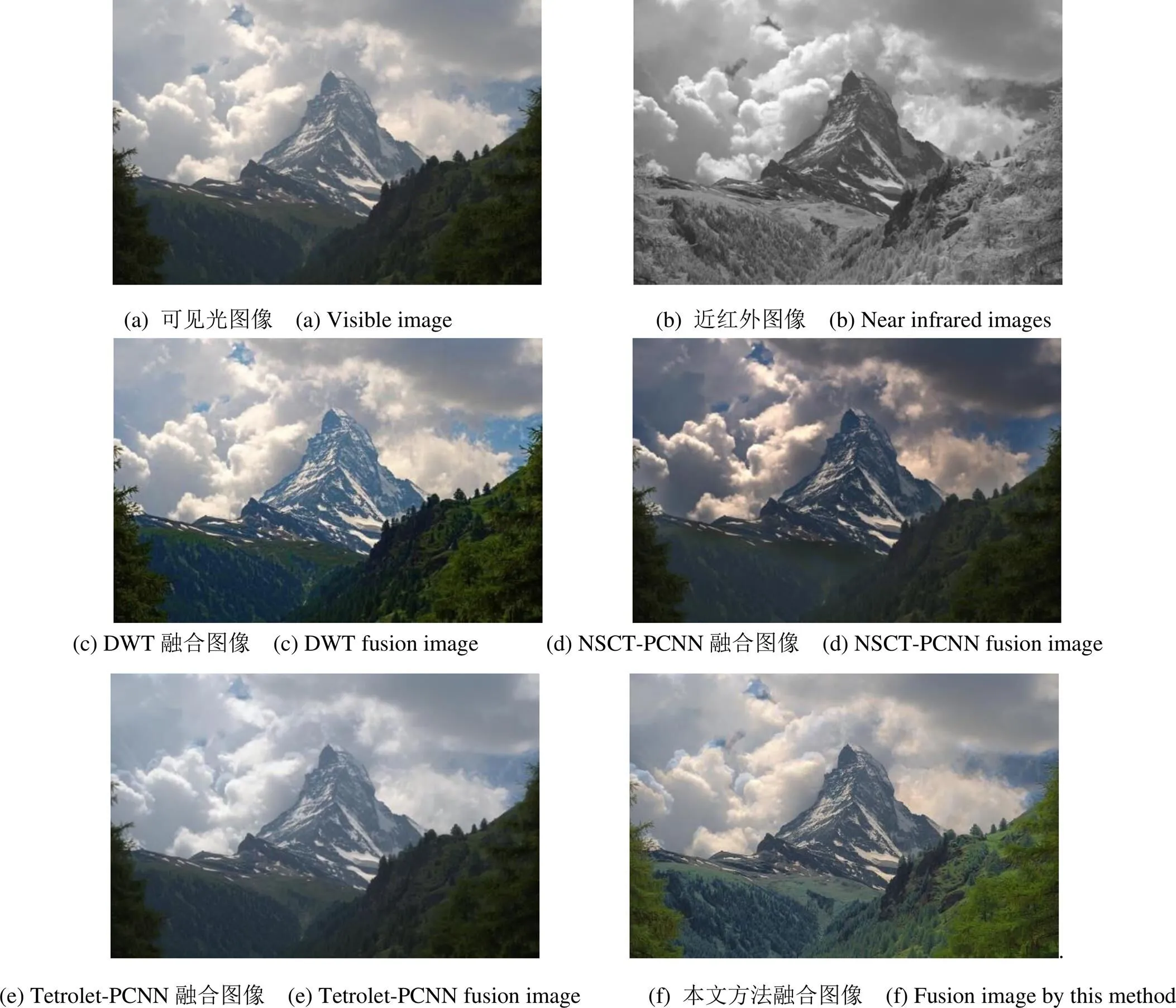

为了验证本文方法的效果,选取了3种高效算法与本文进行对比,分别为低频取均值高频采用区域能量最大融合规则的离散小波分解方法(DWT-Discrete wavelet transform,DWT)、低频分量采用期望最大高频分量采用固定阈值的PCNN的非下采样轮廓波分解方法(NSCT-Nonsampling contourlet transform,NSCT-PCNN)[16]、低频分量采用均值高频分量采用固定阈值的PCNN的Tetrolet分解方法(Tetrolet-PCNN)[11]。其中DWT分解层数为4层;NSCT-PCNN分解层数为4层,分解方向分别为4、8、8、16;Tetrolet-PCNN方法中分解层数设为4层,连接强度设为0.118,输入衰减系数设为0.145,连接幅值设为135.5;本文方法中,Tetrolet变换的分解层数为4层。运行环境为:Intel i7、3.2GHz六核处理器,1T硬盘,32G内存,Windows10操作系统,MATLAB2018a仿真平台。本文选取了分辨率为1024×680的多组图像进行比较,分别从主观与客观上对实验结果做了对比。主观对比如图5和图6所示。

图5和图6中的图(a)均是彩色可见光图像,主要捕捉场景中颜色信息和空间细节,如房屋、草地等。图(b)均为红外光图像,其主要关注点为热源物体,比如人体。图(c)~图(f)分别为各种方法的融合结果。由图5和图6知,DWT方法边缘较为模糊,颜色丢失最多,融合质量最差;NSCT-PCNN方法能够提取源图像中的空间细节信息,但是场景中的人物区域边缘还是较为模糊;Tetrolet-PCNN方法具有较好的轮廓和边界,但是色彩对比度与本文方法相比较还有差距;通过以上比较可知,本文方法能够更好地保留空间细节信息以及目标边缘信息,边缘与房屋纹理细节最清晰,色彩对比度更适合视觉感受,综合效果更好。

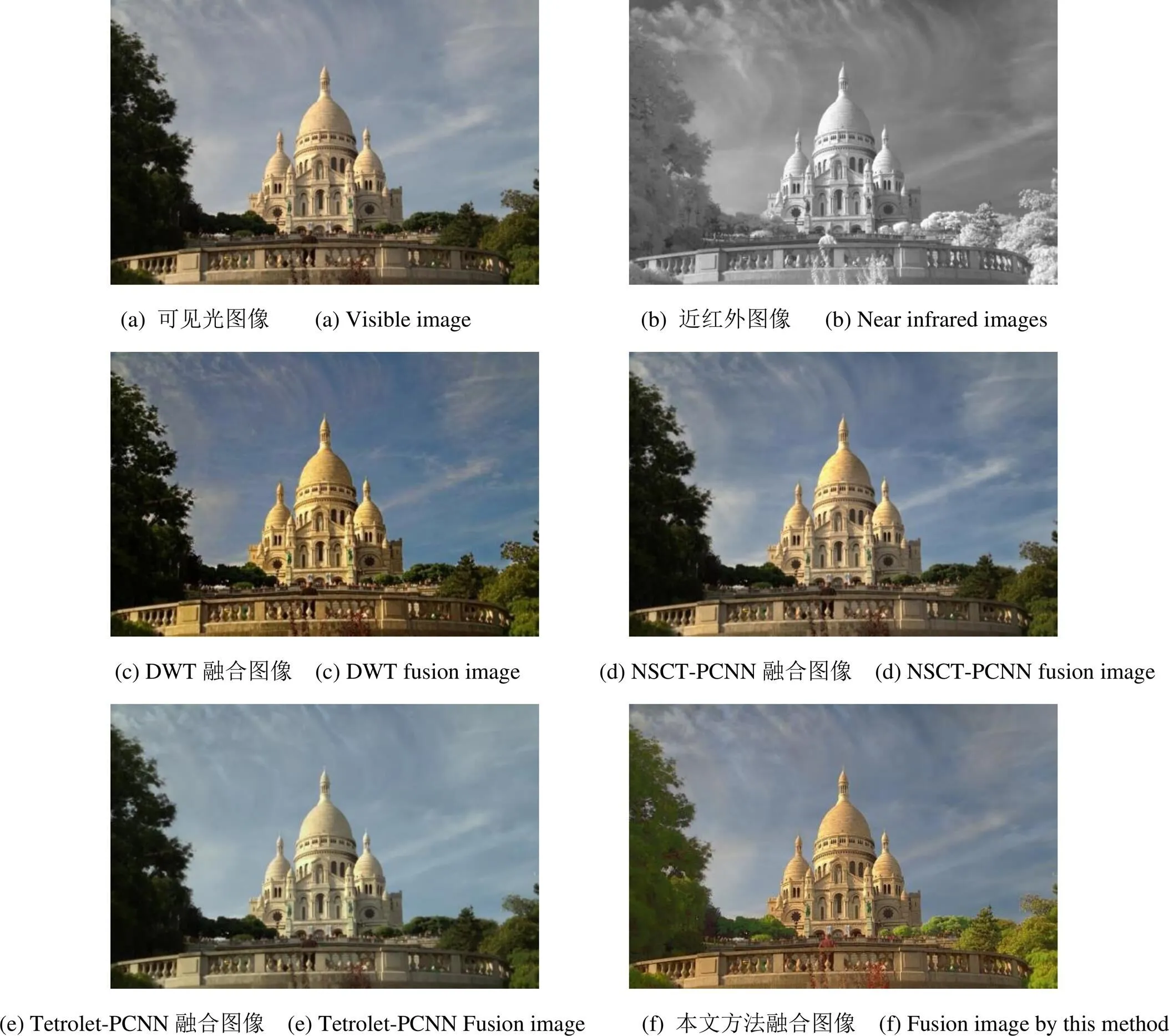

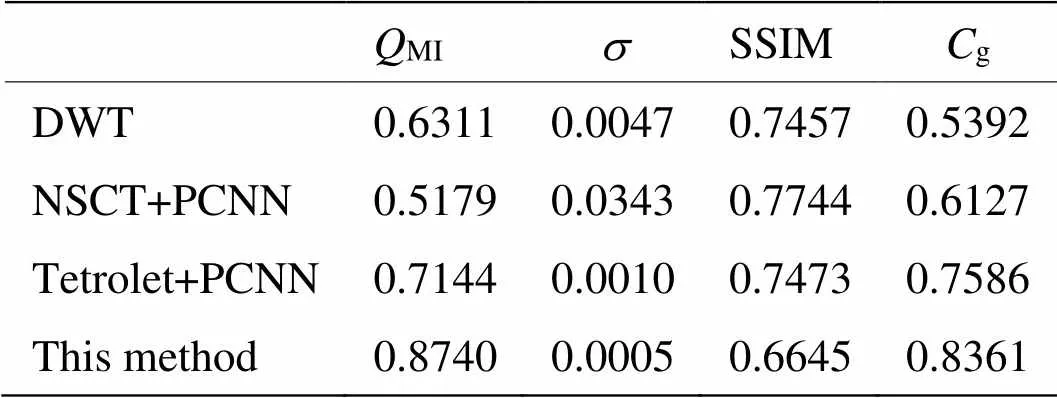

本文选用图像信息饱和度指标MI、盲评估指标、图像结构相似性评价指标SSIM(Structural similarity index)和图像对比度增益g四种评价指标对所有融合结果进行客观评价。MI用来衡量原始信息在最终融合图像中的保留情况,值越大表明保留信息越多,效果越好;盲评估指标用于评估融合算法的颜色恢复性能,越小,融合算法的效果越好;结构相似性SSIM的范围为0到1。图像完全相同时,SSIM值为1;图像对比度增益g为融合图像和源图像之间的平均对比度差,能够更直观地展示出图像对比度差异。表1和表2给出了两组图像经过各种方法对比后的指标数据。

图5 第一组图像融合结果

图6 第二组图像融合结果

表1 第一组图像客观评价指标

表2 第二组图像客观评价指标

由图5和图6及表1和表2可知,与已有方法相比,本文方法在图像饱和度、颜色恢复性能、结构相似性和对比度等客观评价指标上均具有明显的优势。

4 总结

本文提出一种新的融合算法。为了尽可能多保留颜色信息,减少颜色信息的失真,将彩色可见光图像转到3个分量互不相关的HSI色彩空间,对3个分量分开处理。同时,改进了Tetrolet变换的分解框架,使分解后的高低频系数更易于处理,融合图像的质量得到了大幅度提升。先将亮度分量与近红外图像分别进行改进的Tetrolet分解,低频采用期望最大方法进行融合,高频采用改进的自适应PCNN方法进行融合,Tetrolet反变换得到的图像作为新的亮度分量。将新的亮度分量和拉伸后的饱和度分量与原始色度分量反映射到RGB空间,完成处理。实验表明,本文获得的图像视觉效果更好,色彩对比度高,细节丰富,更有利于后续处理。

[1] Wenshan D, Duyan B, Linyuan H, et al. Infrared and visible image fusion method based on sparse features[J]., 2018, 92: 372-380.

[2] LI J, SONG M, PENG Y. Infrared and visible image fusion based on robust principal component analysis and compressed sensing[J]., 2018, 89: 129-139.

[3] LIU C H, QI Y, DING W R. Infrared and visible image fusion method based on saliency detection in sparse domain[J]., 2017, 83: 94-102.

[4] Krommweh J. Tetrolet transform: A new adaptive Haar wavelet algorithm for sparse image representation[J]., 2010, 21(4): 364-374.

[5] LIU H X, ZHU T H, ZHAO J J. Infrared and Visible Image Fusion Based on Region of Interest Detection and Nonsubsampled Contourlet Transform[J]., 2013, 18(5): 526-534.

[6] KONG W. The Infrared and Visible Light Image Fusion Based on the Non-subsample Shearlet Transform and Heat Source Concentration Ratio[C]//(INCoS), 2016: 544-547.

[7] Nemalidinne SM, Gupta D. Nonsubsampled contourlet domain visible and infrared image fusion framework for fire detection using pulse coupled neural network and spatial fuzzy clustering[J]., 2018, 101: 84-101.

[8] CHENG B, JIN L, LI G. A novel fusion framework of visible light and infrared images based on singular value decomposition and adaptive DUAL-PCNN in NSST domain[J]., 2018, 91: 153-163.

[9] ZHANG D X, YUAN B H, ZHANG J J. Research on Polarization Image Fusion Using Tetrolet Transform[J]., 2014, 713-715: 1859-1862.

[10] ZHOU X, WANG W. Infrared and Visible Image Fusion Based on Tetrolet Transform[C]//2015,, 2015: 701-708.

[11] 冯鑫. Tetrolet框架下红外与可见光图像融合[J]. 光子学报, 2019, 48(2): 76-84.

FENG X. Fusion of Infrared and Visible Images Based on Tetrolet Framework[J]., 2019, 48(2): 76-84.

[12] 孔韦韦, 雷英杰, 雷阳, 等. 基于改进型NSCT变换的灰度可见光与红外图像融合方法[J]. 控制与决策, 2010, 25(11): 1607-1612.

KONG W W, LEI Y J, LEI Y, et al. Fusion method for gray-scale visible light and infrared images based on improved NSCT[J]., 2010, 25(11): 1607-1612.

[13] Boyang C, Longxu J, Guoning L. Infrared and visual image fusion using LNSST and an adaptive dual-channel PCNN with triple-linking strength[J]., 2018, 310: 135-147.

[14] CHEN W, YU Y J, SHI H. An Improvement of Edge-Adaptive Image Scaling Algorithm Based on Sobel Operator[C]//2017 4th, 2017: 183-186.

[15] Mittel V, Singh D, Saini L M. A comparative analysis of supervised land cover classification using multi-polarized PALSAR EM image fusion[C]//, 2015: 368-393.

[16] 荣传振, 贾永兴, 杨宇, 等. NSCT域内基于自适应PCNN的图像融合新方法[J]. 信号处理, 2017, 33(3): 280-287.

RONG C Z, JIA Y X, YANG Y, et al. A Novel Image Fusion Algorithm Using Adaptive PCNN in NSCT Domain[J]., 2017, 33(3): 280-287.

Fusion Algorithm for Near-Infrared and Color Visible Images Based on Tetrolet Transform

YUAN Yubin,PENG Jing,SHEN Yu,CHEN Xiaopeng

(School of Electronic and Information Engineering, Lanzhou Jiaotong University, Lanzhou 730070, China)

To address the problems of low contrast, loss of detail, and color distortion after near-infrared and color visible image fusion, an algorithm for near-infrared and color visible image fusion based on the Tetrolet transform and pulse coupled neural network (PCNN) is proposed. First, the color visible light source image is transformed into a hue saturation intensity space, where each component is relatively independent, and its brightness component is decomposed into a near-infrared image by Tetrolet decomposition. Subsequently, a fusion rule for expectation maximization likelihood estimation of the potential distribution from a given incomplete dataset is proposed. A self-adaptive PCNN model with a Sobel operator that automatically adjusts the threshold is used as a fusion rule, and the processed high-frequency and low-frequency images are fused by Tetrolet inverse transformation as brightness images. An adaptive stretching method for the saturation component is proposed to solve the problem of image saturation decline. The processed components are mapped back to red–green–blue space to complete the fusion. The proposed algorithm was compared with several efficient fusion algorithms. The experimental results show that the image obtained by this method has clear details and improved color contrast. It has obvious advantages in image saturation, color restoration performance, structural similarity, and contrast.

color image fusion, Tetrolet transform, expectation maximization algorithm, adaptive pulse coupled neural network

TP391

A

1001-8891(2020)05-0223-08

2019-10-11;

2020-03-06.

苑玉彬(1995-),男,山东菏泽人,硕士研究生,主要研究方向为图像处理与计算机视觉。E-mail:164821193@qq.com。

国家自然科学基金项目(61861025,61562057,61663021,61761027,51669010),长江学者和创新团队发展计划(IRT_16R36),光电技术与智能控制教育部重点实验室(兰州交通大学)开放课题(KFKT2018-9),兰州市人才创新创业项目(2018-RC-117)。