云媒资系统中的存储设计与实现

2019-12-27孙强

孙 强

(太原广播电视台,山西 太原 030024)

媒资系统用于存储台内节目素材,与云制作系统共同完成节目制作生产。云媒资系统与云制作系统统一技术架构标准,媒资系统采用与云制作系统可互联互通的私有云技术架构替代解决,依靠云媒资系统来实现两个系统之间的数据交互、流转。

1 存储方案设计原则

1) 高可靠性:对于存储的高可靠性应该从几个方面来进行考虑。首先,对于磁盘存储进行较高级别的RAID冗余。其次,磁盘阵列系统本身的设计中不能存在部件的单点故障。还有,磁盘阵列与应用系统之间的连接上也不能存在单点故障。

2) 高性能:方案设计的集中存储不能以牺牲性能为代价,这需要对数据传输的各个过程具体分析性能瓶颈。

3) 可扩展性:方案的可扩展性的要求表现在以下几方面:

◆容量的可扩展性:存储系统可以在现有容量的基础上,为未来的应用提供足够的扩展空间。

◆接口的可扩展性:随着用户业务的增长,有更多的服务器可以很方便地使用存储系统,以实现数据的集中存储和备份。

◆新技术的可扩展性:方案采用的硬件设备和软件产品都是业界相关领域的开放型主流产品,采取开放性模块化设计,当新的存储技术出现后,可以通过升级相应的模块实现向新技术的扩展。

4) 兼容性:方案提供的磁盘阵列系统可以同时支持Windows、Linux、Unix等操作系统。

5) 高性价比:首先要从系统的实用性角度出发,满足不同的业务系统的实际需要和前瞻性的同时,选择最高性价比的设计方案。

2 存储设计

系统建设完成后,所有节目生产都在此系统进行,生产业务对存储的需求主要为汇聚媒体的写入、编辑工具的读写访问、媒体处理转换、媒体数据索引的读写等。网络化建设后,非编的上下载、编辑、审片、送播等关键业务都依赖存储系统的稳定性,因此,采用分布式集群存储架构,为系统提供多种数据安全策略,保证了系统核心数据的安全和系统高稳定性,同时满足灵活的编辑、扩展需求。

2.1 存储总体设计

本次存储架构设计采用目前业内成熟先进的非编制作系统素材安全解决方案——单存储架构。单存储采用IP分布式集群存储,可进行节点式扩展,为后期系统扩容提供线性增长的带宽及存储容量。在线存储支持对汇聚、生产、发布全流程的媒体访问支持,针对不同业务应用提供合适的存储容量和带宽访问。存储资源对可以为生产业务提供必要的容量和带宽支撑,并根据安全性需求提供必要的备份和切换手段

本次分布式存储采用现最先进IP集群存储,配置5个全对称节点,可实现高安全性以及带宽、容量的平滑扩展。分布式存储架构采用Scale-out存储架构,将海量数据压力分散到多个并发存储节点,数据和元数据均匀分布于各个节点上,避免资源争用,系统性能(吞吐量)按照比例扩展,并且各个存储节点之间负载均衡,有效避免单节点性能瓶颈。这种架构,不仅保持了对象存储系统高可靠、高性能的优点,而且使得分布式存储架构系统具有更好的扩展性。分布式存储架构通过Scale-out架构,轻松实现容量扩展,可实现从3节点到288节点的轻松扩容。

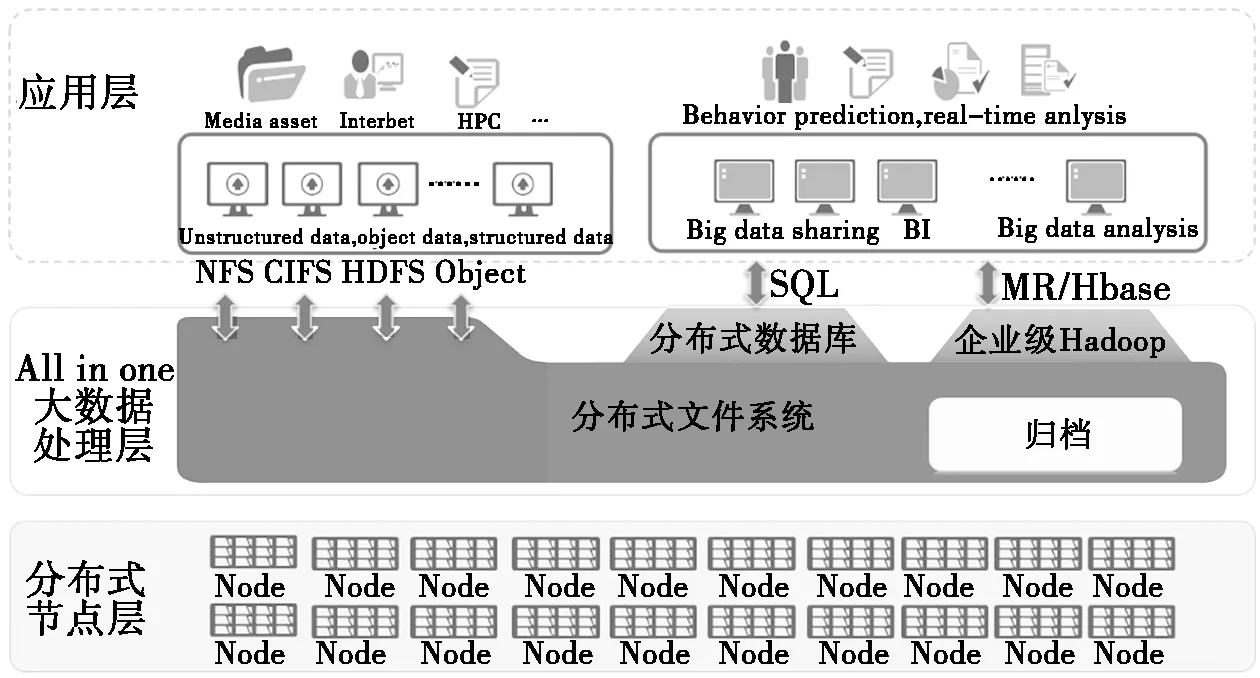

图1 分布式存储系统图

分布式存储架构能够根据业务增长进行平滑扩容,系统每增加一个存储节点,都能够自动识别,并将该存储空间加入到整系统中,并根据负载均衡的原则,优先选择新的节点存储,从而简化了系统扩容的管理,降低了操作成本。扩容时容量和性能支持线性扩展,最大可提供40PB规模的单一文件系统,真正实现“应需而变”,为业务的长期高性价比提供保障。

分布式存储系统分为三层:分布式节点层,大数据处理层及应用层。

◆分布式节点层:物理设备层,由集群存储中的所有分布式节点组成,所有节点全部采用对称式连接。

◆大数据处理层:文件系统层,实现对所有节点的元数据管理,物理数据管理,物理数据读取,写入,全部由分布式文件系统进行管理;分布式文件系统通过对外输出NFS或者CIFS文件系统,为各终端提供数据访问。

◆应用层:各个终端应用通过存储提供的NFS或CIFS文件系统对存储进行数据访问。

2.2 分布式存储逻辑架构

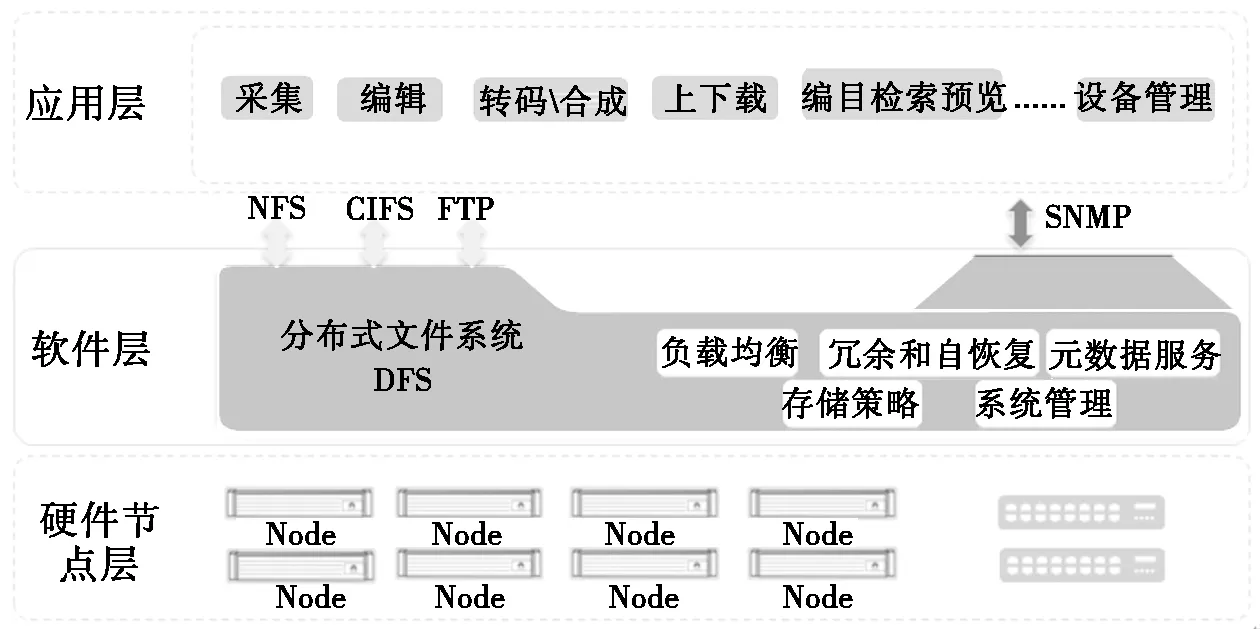

本次系统建设采用的OceanStor 9000云存储平台架构可分为硬件平台和存储软件。

◆硬件平台:包括网络和物理节点及节点内的硬盘、网卡、NVDIMM、内存等;

◆软件系统:主要是DFS分布式文件系统和多种增值特性、提供对外共享的NAS共享服务、性能负载均衡、多种策略管理、提供对整个系统统一管理的管理系统。

系统逻辑架构如图2所示。

图2 系统逻辑架构

OceanStor 9000存储系统中的核心部件是分布式文件系统OceanStor DFS,DFS将系统中所有节点的硬盘整合成一个统一的资源池,对外提供统一命名空间。同时对用户数据提供跨节点、跨机架、不同级别的数据冗余保护,可以兼顾高硬盘利用率和高可用的需求,避免了传统存储的烟囱式弊端。

OceanStor DFS支持节点动态扩展,节点数目从3~288随需而定,单一文件系统可扩容至50PB,而且节点扩展中业务不中断。随着节点数的增加,存储容量和计算能力线性增加,最终给用户提供呈线性递增的带宽、并发数。OceanStor DFS提供了全局一致的缓存,缓存容量随着节点增加而线性增长,随着节点数目的增加,越来越多的热点数据可以被缓存命中,大大减少硬盘随机I/O,提高整系统性能。

OceanStor DFS使用了NVDIMM和RDMA等技术。NVDIMM使得数据即使在缓存中也可以得到持久化保护,而RDMA则有效减少了网络传输过程中内存拷贝次数。这样在不降低可靠性的前提下,进一步提升整系统响应速度。

OceanStor DFS对外提供CIFS、NFS接入功能,并提供对CIFS、NFS的统一域名访问机制,让用户业务轻松接入存储系统。同时支持集群节点间负载均衡及管理功能。在这些功能特性基础上,由于全对称的架构设计使得OceanStor 9000每个节点都可以对外提供全局的NAS业务访问,且任何单节点故障时可自动切换。

在权限管理方面,OceanStor DFS支持AD、LDAP、NIS多种权限管理方式,可直接与域控服务器对接,对域用户访问权限进行控制。

方案组网示意图如图3。

华为OceanStor 9000存储节点后端通过10GE交换机互联,完成系统内部的数据交互。

组网说明:

OceanStor 9000使用10GE组网时,前端网络对接用户10GE以太网交换机,后端网络使用内部10GE交换机。前后端交换机冗余配置。GE交换机通过网线连接各节点的IPMI网口,仅用于设备管理。

2.3 存储容量规划

本次项目采购5个存储节点,总物理容量为700TB。存储节点之间采用N+1的数据保护设置,扣除节点间冗余,实际有效容量为460TB,在这种模式下,任何一台存储节点的故障都不会影响业务的停顿,也不会导致数据的丢失。后期可进行节点式扩展,节点扩容将提供线性增长的带宽及存储容量。

每节点提供700MB带宽,总计提供带宽3500MB。

2.4 存储带宽规划

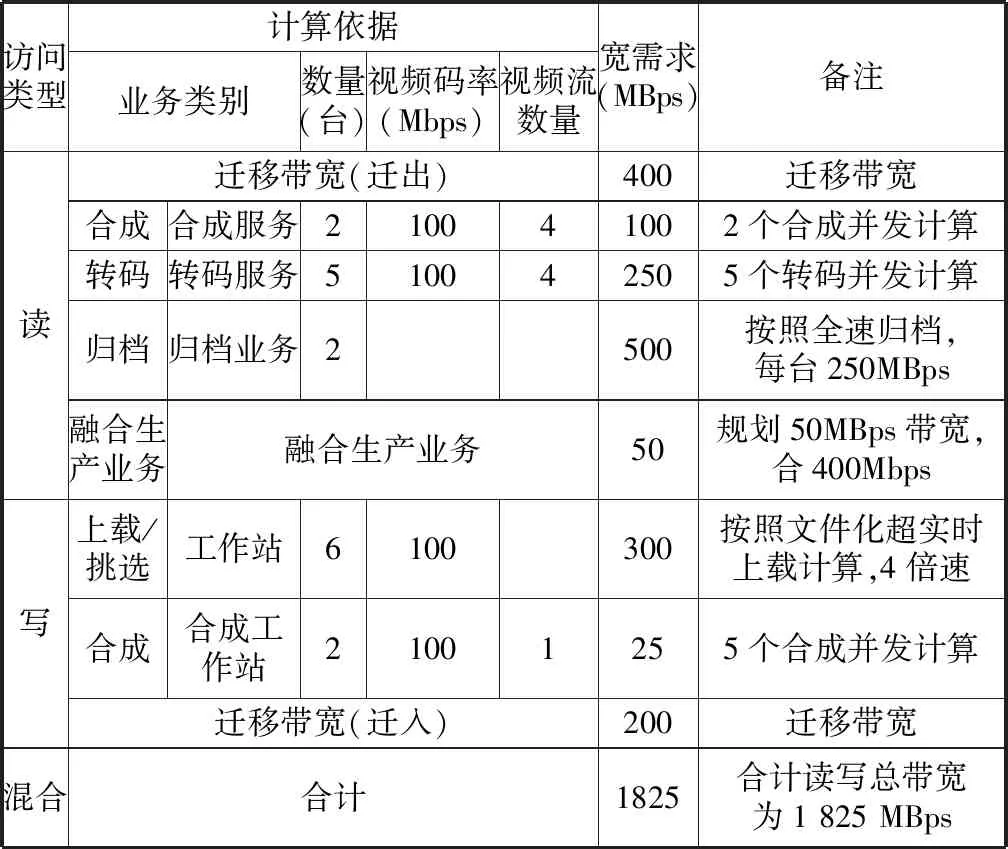

表1 系统码率带宽需求表

根据项目的规模、设备数量,得出在线存储所需带宽计算公式如下:

带宽需求(MB/s)=工作站/服务器数量(台)×单台该类型工作站单层视音频所占用的带宽(Mbps)×该类型工作站使用时所需要的平均视音频层数。

通过以上分析,按照系统最大化存储访问计算,我们可以看出,按照系统大部分模块满配置、高负荷并行运行计算,系统带宽需求为1 825 MB。本方案设计采用5个节点,每个节点可提供700 MB读写带宽,共可提供3 500 MB的稳定读写带宽,完全满足本项目所需带宽要求,并且留有充分余量。综上所述,该系统设计的带宽完全满足台内业务需求。

2.5 近线存储文件存储系统

本方案采用索尼公司ODA专业蓝光光盘库作为近线存储。

采用最新一代专业驱动器,单驱动器读性能:250 MB/s;单驱动器写性能:125 MB/s。

本次配备的单盒介质ODC3300R具备3.3TB/单盒容量42U单机柜能够叠加扩展单元,按照1个基本柜+5个101槽位扩展单元,最多可达535个光盘槽位,可实现1.7PB的大容量保存。

驱动器指标:本次项目配置,在单套42U单机柜光盘库支持2个驱动器,实现互为备份。具备后期扩充能力,最多可扩充至18个驱动器并可同时对18个光盘盒进行并发读写,且每个驱动器均可以使用库体内任意位置蓝光光盘盒。

支持驱动器冗余,单驱动器故障情况下,其余驱动器均可支撑所有业务。机械手可将光盘放到任意驱动器内。

支持单驱动器应急模式,在额外配置USB驱动器情况下,盘库系统级故障时可以将蓝光光盘盒直接放入外置USB单驱动器进行应急读取,且读出速度依旧可达到250MB/s,保障业务不停止。

对写入文件格式没有限制,支持MXF、Matrox_Avi、Riff-Avi、ODML_AVI、WAV、MP3、MP4、H.264等主流视频格式。

光盘盒具备防潮、防尘、耐高温特性,可满足读取100万次以上,室温下保存周期可保存50年。

数据采用连续记录方式,光盘盒内单片或多片(包括3片以上)光盘损坏,其余盘片内容依旧安全,可以正常读取。

光盘支持循环冗余校验,可以将误码率降低到10-24。

光盘库支持多个逻辑光盘库的划分,可对驱动器和光盘设置逻辑地址。最多支持11个逻辑光盘库的划分。

加载光盘效率在50 s内,包含机械臂抓取光盘盒效率和光盘加载到驱动器的总时间。

3 结论

媒资系统要求存储要高可靠、大容量、高带宽、低成本,而分布式存储的冗余校验可提高数据存储的安全性;私有云对存储的管理使存储的容量具有良好的可扩展性;堆叠式交换使存储的吞吐带宽大为提升;由磁盘在线存储和蓝光盘近线存储构成的两层存储构架使高速大容量和经济性得以兼顾。私有云在媒资系统的开创性应用,为节目生产和媒体融合发展注入了新的动力。