基于双微阵列与卷积神经网络的语音识别方法

2019-12-23刘伟波曾庆宁卜玉婷郑展恒

刘伟波 曾庆宁 卜玉婷 郑展恒

摘 要:为解决噪声环境下语音识别率降低以及传统波束形成算法难以处理空间噪声的问题,基于双微阵列结构提出了一种改进的最小方差无畸变响应(MVDR)波束形成方法。首先,采用对角加载提高双微阵列增益,并利用递归矩阵求逆降低计算复杂度;然后,通过后置调制域谱减法对语音作进一步处理,解决了一般谱减法容易产生音乐噪声的问题,有效减小了语音畸变,获得了良好的噪声抑制效果;最后,采用卷积神经网络(CNN)进行语音模型的训练,提取语音深层次的特征,有效地解决了语音信号多样性问题。实验结果表明,提出的方法在经CNN训练的语音识别系统模型中取得了较好的识别效果,在信噪比为10dB的F16噪声环境下的语音识别率达到了92.3%,具有良好的稳健性。

关键词:语音识别;双微阵列;卷积神经网络;噪声环境;稳健性

中图分类号:TN912.34

文献标志码:A

Speech recognition method based on dual microarray and convolutional neural network

LIU Weibo,ZENG Qingning*,BU Yuting, ZHENG Zhanheng

School of Information and Communication, Guilin University of Electronic Technology, Guilin Guangxi 541004, China

Abstract:

In order to solve the low speech recognition rate in noise environment, and the difficulty of traditional beamforming algorithm in dealing with spatial noise problem, an improved Minimum Variance Distortionless Response (MVDR) beamforming method based on dual microarray was proposed. Firstly, the gain of microarray was increased by diagonal loading, and the computational complexity was reduced by the inversion of recursive matrix. Then, through the modulation domain spectrum subtraction for further processing, the problem that music noise was easily produced by general spectral subtraction was solved, effectively reducing speech distortion, and well suppressing the noise. Finally, the Convolution Neural Network (CNN) was used to train the speech model and extract the deep features of speech, effectively solve the problem of speech signal diversity. The experimental results show that the proposed method achieves good recognition effect in the CNN trained speech recognition system, and has the speech recognition accuracy of 92.3% in F16 noise environment with 10dB signaltonoise ratio, means it has good robustness.

Key words:

speech recognition; dual microarray; Convolutional Neural Network (CNN); noise environment; robustness

0 引言

语音识别技术作为模式识别的一个重要分支,主要目的是让机器理解人类所说内容的含义,从而实现人与机器自然的交流,以摆脱现有的以文本输入形式进行交互的局限性。语音作为目前人机交互最便捷的方式,具有高效、直接、自然的特性,也是人类本身之间最方便快捷的沟通交流方式之一[1]。目前人机智能语音交互的最大意义就是可以彻底解放人的双手,降低学习成本。但是,在实际应用时,语音总会受到环境噪声或者传输介质的干扰,导致音质受损,影响其中蕴含的语言信息正常传递,所以,如何对复杂环境下的语音进行处理,减少噪声以及干扰的影响,进而提升语音识别系统的稳健性就显得至关重要[2]。

近年来,研究者在噪声环境下以及远场语音识别应用领域探索了广泛的波束形成实现方法,例如,Zhang等[3]提出了一种基于深度神经网络的麦克风阵列降噪算法,有效提高了真实噪声环境下的语音识别率;Higuchi等[4]使用基于时频掩蔽的波束形成方法應用到语音识别任务中,有效抑制了噪声干扰并提高了语音识别率;Lukas等[5]研究了广义旁瓣抵消波束形成器的三种变体结构,并应用后置滤波器来进一步增强语音信号的方法在CHiME 国际多通道语音分离与识别大赛中取得了优异的成绩。以上研究成果表明,针对噪声或干扰语音设计的麦克风阵列语音算法可以作为语音识别系统的输入端处理算法,达到提高语音质量的目的,对噪声及远场环境下的语音识别性能有一定的提升。

本文针对传统波束形成算法难以处理的空间噪声问题,提出了一种综合了最小方差无畸变响应(Minimum Variance Distortionless Response, MVDR)波束形成与对角加载的麦克风阵列语音波束形成方法,并通过后置调制域谱减法对语音进一步处理,获得了较好的降噪效果和识别准确率(该方法已申请发明专利[6])。该方法中定义了一个加权因子,对语音信号采样协方差矩阵进行对角加载处理,使得环境噪声中非相关性比較强的协方差元素得到抑制,降低噪声增益从而达到提高阵列增益的目的[7]。为了降低计算量和复杂度,本文采用了递推算法,减少矩阵求逆运算。另外,通过采用卷积神经网络(Convolutional Neural Network, CNN)从原始语音数据中提取高维隐含的特征,有力地处理数据的可变性和丰富性,减少了神经网络训练的参数。实验结果表明,该方法在噪声抑制和提升语音质量方面均取得了优于传统方法的效果,在噪声环境下的语音识别系统中具有一定的稳健性。

1 递归矩阵求逆的MVDR

1.1 双微阵列

图1所示为本文采用的双微阵列,采用KEMAR人工头模拟人耳特性。两侧分别是一个微型阵列,左右阵间距离为模拟人耳的间距,一般为12~18cm,微型阵内距离为2~4cm,此时阵间麦克风采集的噪声信号相关性较弱或者是非相关噪声,阵内麦克风采集的噪声相关性较强[8]。有研究表明,麦克风间距在12~18cm的噪声低频带相关性较强,而高频带的噪声相关性较弱,因此利用相关性算法能够达到较好的去噪效果[8]。

1.2 最小方差无畸变响应

双微麦克风阵列接收到的语音信号模型采用如下形式表示:

ym(t)=xm(t)+nm(t); m=1,2,…,M(1)

其中: t表示时间索引,M表示麦克风数量,xm(t)表示纯净语音信号,nm(t)表示加性噪声和干扰信号,ym(t)表示含噪语音信号。

对式(1)进行傅里叶变换,得到频域表示形式

Y(l,k)=X(l,k)+N(l,k)(2)

其中: l是时间索引,k是频率索引,下文为简洁起见,适当省略部分索引符号。

最小方差无畸变响应波束形成器是由Capon首先提出的一种经典的麦克风阵列自适应波束形成方法,满足目标信号无失真的条件下最小化阵列输出的约束,可以有效实现抑制噪声以及非目标方向干扰的目的[9-10]。MVDR需满足以下约束优化条件:

arg minw{WHRnW}

WHD(k)=1 (3)

其中: D(k)是期望信号导向矢量,Rn 是噪声协方差矩阵。采用Lagrange算子,定义函数[9]:

F(w,λ)=12wHRnw+λ(1-wHD(k))(4)

将该函数对w求导,并令该导数为0,得到:

F(w,λ)w=Rnw-λD(k)=0(5)

进行求解得到加权向量:

W=λRn-1D(k)(6)

代入前面式(3)的约束条件中,求得:

λ=1D(k)HRn-1D(k)(7)

把式(7)代入式(6)中可求出最优加权向量为:

WMVDR=R-1nD(k)D(k)HR-1nD(k)(8)

MVDR波束形成器要求精确的导向矢量和噪声协方差矩阵估计,而在实际应用环境中,由于麦克风接收到的信号的导向矢量存在偏差以及协方差矩阵估计不准确,使得MVDR波束形成器的性能下降,不能有效地抑制干扰。

1.3 对角加载

假设导向矢量和协方差矩阵都没有误差,考虑M个麦克风组成的双微阵列结构,假设语音信号和噪声之间互不相关,一般通过有限次快拍估计的数据协方差矩阵代替噪声的协方差矩阵[10]

R^n=1K∑Kt=1y(t)yH(t)(9)

其中K为快拍数。在实际应用时,阵列结构的导向矢量存在偏差,麦克风接收的数据里面也往往含有一部分的期望信号,这就导致无法得到理想的噪声协方差矩阵。因此本文引入对角加载的方法来抑制协方差矩阵中小特征值扰动造成偏差的输出性能的影响[10]:

Rεn=R^n+εI(10)

其中:R^n为进行对角加载前的噪声信号的协方差矩阵;Rεn为对角加载后协方差矩阵;ε为对角加载量,本文取0.01,I为单位矩阵。将协方差矩阵对角加载抑制非相关噪声,式(10)中的协方差矩阵为:

Rεn=

r11+εr12…r1N

r21r22+ε…r2N

rN1rN2…rNN+ε(11)

得到对角加载后的权向量为:

WMVDR=Rεn-1D(k)D(k)HRεn-1D(k)(12)

1.4 递归矩阵求逆

MVDR波束形成器中的加权向量是通过对协方差矩阵进行求逆运算得到的最佳权值矢量,其计算复杂度较高,运算量会随着阵元数目和采样数目的增加逐渐剧增,为了降低计算量和复杂度,本文采用了递推算法,减少矩阵求逆运算量[11-12]。假设对经双微阵列结构采集的含噪语音进行处理时,噪声与语音信号相互独立,含噪语音信号的功率谱密度为Φy=E(YYH),且满足有Φy=Φx+Φn。

对功率谱密度在时间上求平均进行估计:

Φn(l)=αnΦn(l-1)+[1-αn]Y(l)Y(l)H(13)

Φx+n(l)=αxΦx+n(l-1)+[1-αx]Y(l)Y(l)H(14)

其中:Φn为噪声的功率谱密度,Φx+n为含噪语音的功率谱密度;αn和αx为一固定常数,通过式(15)求得:

αn=1-μx

αx=1-μx(1-x) (15)

对含噪语音端点检测,检测到语音帧时μx=1,噪声帧时μx=0,其中x∈(0,1]本文取固定常数0.95。

该递推算法的基本流程[11]是:

1)计算初始噪声的相关矩阵即功率谱密度进行求逆运算,得到初始化权值;

2)开始对初始噪声段进行Woodbury更新;

3)进入语音段处理,用前一幀的求逆相关矩阵替代当前帧的相关矩阵;

4)进入噪声段处理,对2)中的相关矩阵进行Woodbury更新;

5)递推完成整个信号长度的运算。

根据矩阵求逆引理,相关矩阵求逆运算后可表示为:

Φn-1(l)=αn-1Φn-1(l-1)-

αn-1(1-αn)Φ-1n(l-1)Y(l)YH(l)Φn-1(l-1)αn+(1-αn)YH(l)Φn-1(l-1)Y(l)(16)

对式(16)进一步简化[7],令:

gn=(1-αn)Φn-1(l-1)y(l)αn+(1-αn)yH(l)Φn-1(l-1)y(l)(17)

最后递推得到MVDR波束形成器的加权向量为:

WMVDR(l)=D(k)HΦn-1(l-1)D(k)αnvD(k)HΦn-1(l)×

[Ι-gnyH(l)]WMVDR(l-1)(18)

将求得的递归矩阵求逆的MVDR的权值矢量系数与含噪双微阵列语音信号的频谱相乘即得到进行波束形成增强后的语音信号。

(l,k)=WMVDRY(l,k)(19)

2 调制域谱减法

语音增强的目标是提高噪声环境下的语音质量,这就需要在噪声抑制和引起的语音失真之间找到一个平衡点。在许多增强方法中,谱减法是一种简单而有效的方法,适用于平稳或缓慢变化的加性噪声环境,常见的功率谱谱减法,侧重于信号幅度的估计,在信号重构中采用带噪相位,即信号功率谱由含噪信号功率谱的估计值减去噪声功率谱的估计值来估计[13]。当信噪比较高时,含噪语音相位接近于纯净语音信号相位,可直接用于纯净语音的估计,但随着信噪比的降低,噪声相位在信号重构中变得不足。同时,传统谱减法引起的“音乐噪声”问题也需要解决,因此,本文引入调制域谱减法进行改善。

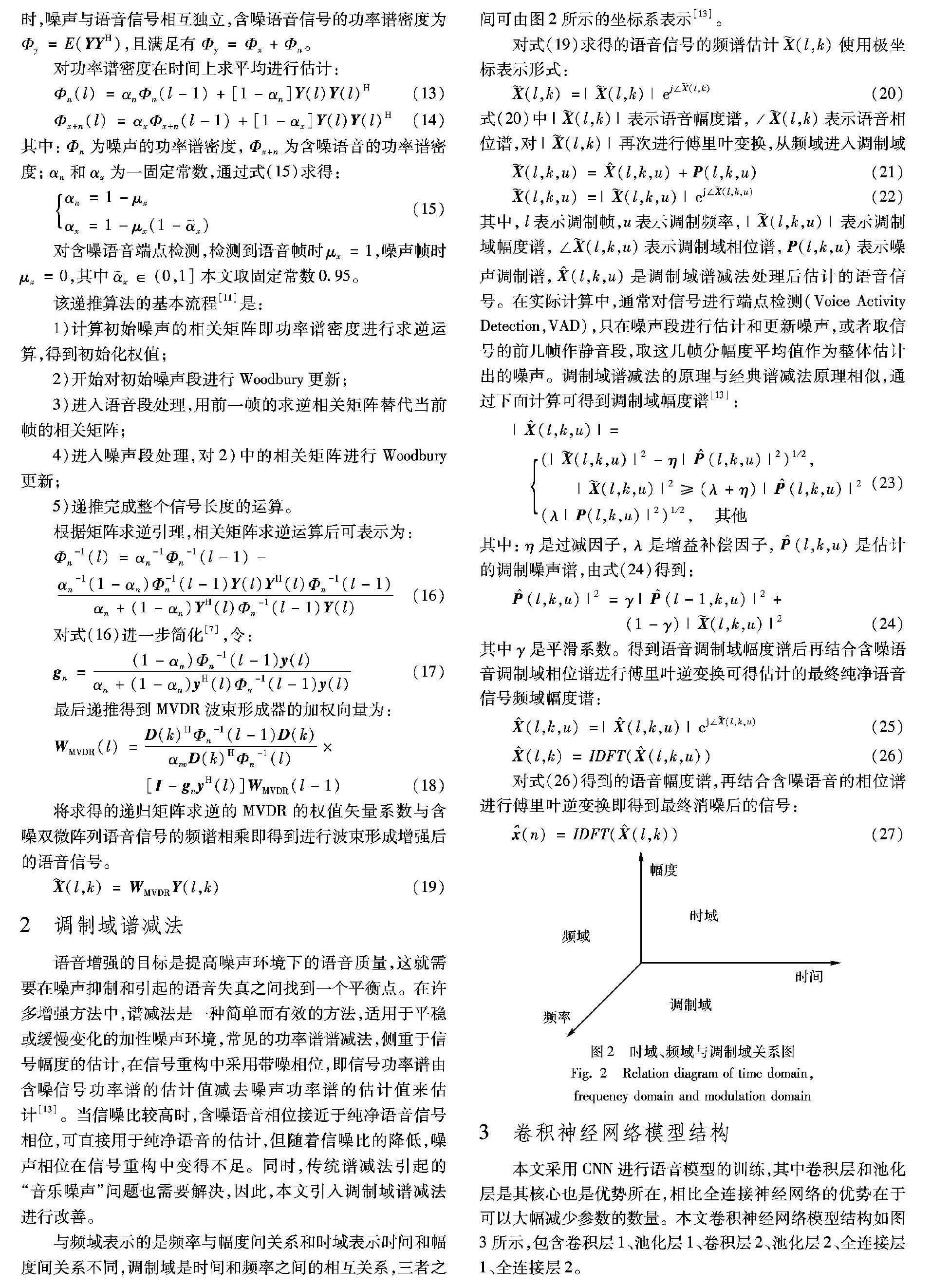

与频域表示的是频率与幅度间关系和时域表示时间和幅度间关系不同,调制域是时间和频率之间的相互关系,三者之间可由图2所示的坐标系表示[13]。

对式(19)求得的语音信号的频谱估计(l,k)使用极坐标表示形式:

(l,k)=|(l,k)|ej∠(l,k)(20)

式(20)中|(l,k)|表示语音幅度谱,∠(l,k)表示语音相位谱,对|(l,k)|再次进行傅里叶变换,从频域进入调制域

(l,k,u)=X^(l,k,u)+P(l,k,u)(21)

(l,k,u)=|(l,k,u)|ej∠(l,k,u)(22)

其中,l表示调制帧,u表示调制频率,|(l,k,u)|表示调制域幅度谱,∠(l,k,u)表示调制域相位谱,P(l,k,u)表示噪声调制谱,X^(l,k,u)是调制域谱减法处理后估计的语音信号。在实际计算中,通常对信号进行端点检测(Voice Activity Detection,VAD),只在噪声段进行估计和更新噪声,或者取信号的前几帧作静音段,取这几帧分幅度平均值作为整体估计出的噪声。调制域谱减法的原理与经典谱减法原理相似,通过下面计算可得到调制域幅度谱[13]:

|X^(l,k,u)|=

(|(l,k,u)|2-η|P^(l,k,u)|2)1/2,

|(l,k,u)|2≥(λ+η)|P^(l,k,u)|2

(λ|P(l,k,u)|2)1/2, 其他 (23)

其中:η是过减因子,λ是增益补偿因子,P^(l,k,u)是估计的调制噪声谱,由式(24)得到:

P^(l,k,u)|2=γ|P^(l-1,k,u)|2+(1-γ)|(l,k,u)|2(24)

其中γ是平滑系数。得到语音调制域幅度谱后再结合含噪语音调制域相位谱进行傅里叶逆变换可得估计的最终纯净语音信号频域幅度谱:

X^(l,k,u)=|X^(l,k,u)|ej∠(l,k,u)(25)

X^(l,k)=IDFT(X^(l,k,u))(26)

对式(26)得到的语音幅度谱,再结合含噪语音的相位谱进行傅里叶逆变换即得到最终消噪后的信号:

(n)=IDFT(X^(l,k))(27)

3 卷积神经网络模型结构

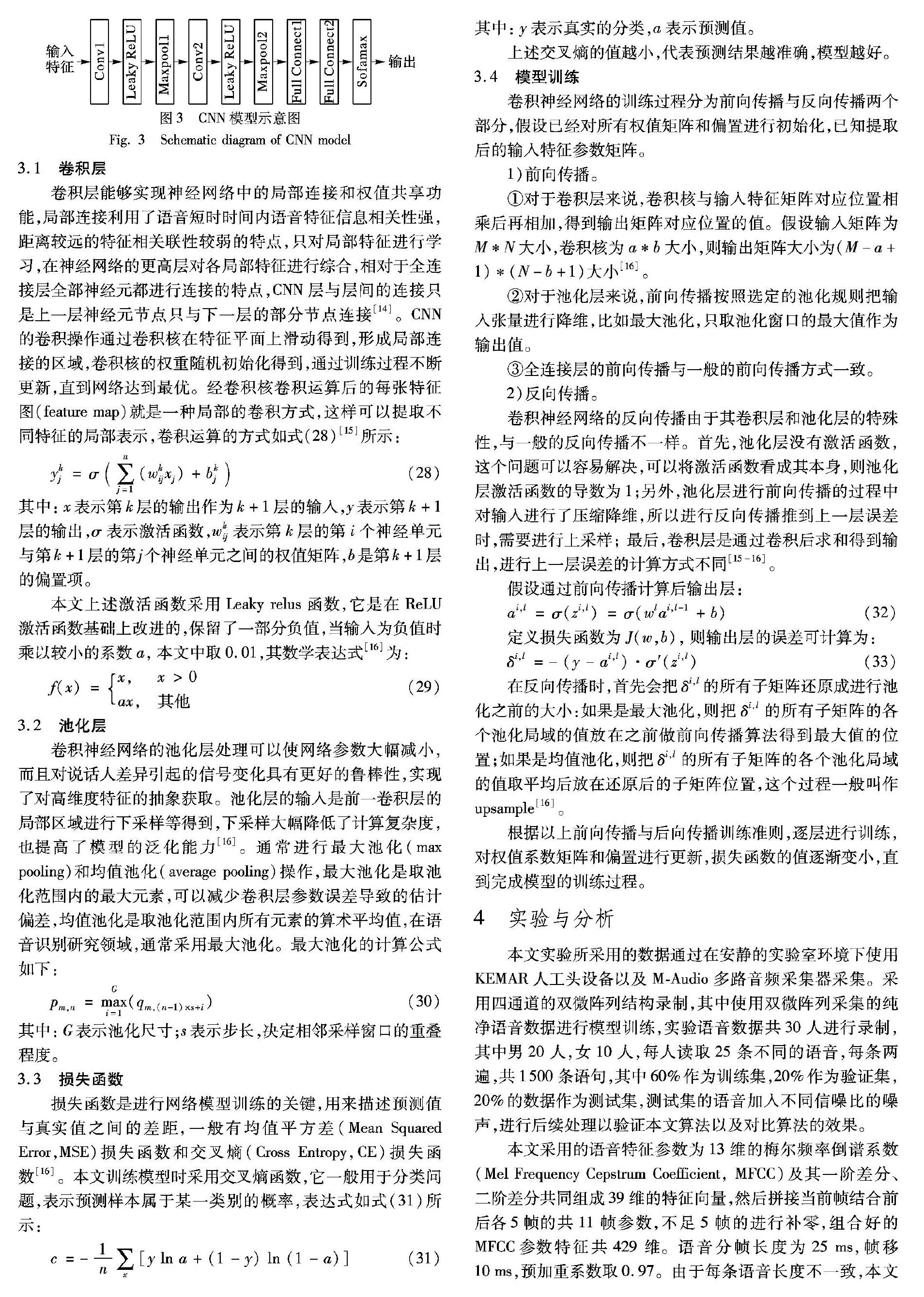

本文采用CNN进行语音模型的训练,其中卷积层和池化层是其核心也是优势所在,相比全连接神经网络的优势在于可以大幅减少参数的数量。本文卷积神经网络模型结构如图3所示,包含卷积层1、池化层1、卷积层2、池化层2、全连接层1、全连接层2。

3.1 卷积层

卷积层能够实现神经网络中的局部连接和权值共享功能,局部连接利用了语音短时时间内语音特征信息相关性强,距离较远的特征相关联性较弱的特点,只对局部特征进行学习,在神经网络的更高层对各局部特征进行综合,相对于全连接层全部神经元都进行连接的特点,CNN层与层间的连接只是上一层神经元节点只与下一层的部分节点连接[14]。CNN的卷积操作通过卷积核在特征平面上滑动得到,形成局部连接的区域,卷积核的权重随机初始化得到,通过训练过程不断更新,直到网络达到最优。经卷积核卷积运算后的每张特征图(feature map)就是一种局部的卷积方式,这样可以提取不同特征的局部表示,卷积运算的方式如式(28)[15]所示:

ykj=σ(∑nj=1(wkijxj)+bkj)(28)

其中:x表示第k层的输出作为k+1层的输入,y表示第k+1层的输出,σ表示激活函数,wkij表示第k层的第i个神经单元与第k+1层的第j个神经单元之间的权值矩阵,b是第k+1层的偏置项。

本文上述激活函数采用Leaky relus函数,它是在ReLU激活函数基础上改进的,保留了一部分负值,当输入为负值时乘以较小的系数a,本文中取0.01,其数学表达式[16]为:

f(x)=x,x>0ax,其他 (29)

3.2 池化层

卷积神经网络的池化层处理可以使网络参数大幅减小,而且对说话人差异引起的信号变化具有更好的鲁棒性,实现了对高维度特征的抽象获取。池化层的输入是前一卷积层的局部区域进行下采样等得到,下采样大幅降低了计算复杂度,也提高了模型的泛化能力[16]。通常进行最大池化(max pooling)和均值池化(average pooling)操作,最大池化是取池化范围内的最大元素,可以减少卷积层参数误差导致的估计偏差,均值池化是取池化范围内所有元素的算术平均值,在语音识别研究领域,通常采用最大池化。最大池化的计算公式如下:

pm,n=maxGi=1(qm,(n-1)×s+i) (30)

其中:G表示池化尺寸;s表示步长,决定相邻采样窗口的重叠程度。

3.3 损失函数

损失函数是进行网络模型训练的关键,用来描述预测值与真实值之间的差距,一般有均值平方差(Mean Squared Error,MSE)损失函数和交叉熵(Cross Entropy,CE)损失函数[16]。本文训练模型时采用交叉熵函数,它一般用于分类问题,表示预测样本属于某一类别的概率,表达式如式(31)所示:

c=-1n∑x[ylna+(1-y)ln(1-a)](31)

其中:y表示真实的分类,a表示预测值。

上述交叉熵的值越小,代表预测结果越准确,模型越好。

3.4 模型训练

卷积神经网络的训练过程分为前向传播与反向传播两个部分,假设已经对所有权值矩阵和偏置进行初始化,已知提取后的输入特征参数矩阵。

1)前向传播。

①对于卷积层来说,卷积核与输入特征矩阵对应位置相乘后再相加,得到输出矩阵对应位置的值。假设输入矩阵为M*N大小,卷积核为a*b大小,则输出矩阵大小为(M-a+1)*(N-b+1)大小[16]。

②对于池化层来说,前向传播按照选定的池化规则把输入张量进行降维,比如最大池化,只取池化窗口的最大值作为输出值。

③全连接层的前向传播与一般的前向传播方式一致。

2)反向传播。

卷积神经网络的反向传播由于其卷积层和池化层的特殊性,与一般的反向传播不一样。首先,池化层没有激活函数,这个问题可以容易解决,可以将激活函数看成其本身,则池化层激活函数的导数为1;另外,池化层进行前向传播的过程中对输入进行了压缩降维,所以进行反向传播推到上一层误差时,需要进行上采样; 最后,卷积层是通过卷积后求和得到输出,进行上一层误差的计算方式不同[15-16]。

假设通过前向传播计算后输出层:

ai,l=σ(zi,l)=σ(wlai,l-1+b)(32)

定义损失函数为J(w,b),则输出层的误差可计算为:

δi,l=-(y-ai,l)·σ′(zi,l)(33)

在反向传播时,首先会把δi,l的所有子矩阵还原成进行池化之前的大小:如果是最大池化,则把δi,l的所有子矩阵的各个池化局域的值放在之前做前向传播算法得到最大值的位置;如果是均值池化,则把δi,l的所有子矩阵的各个池化局域的值取平均后放在还原后的子矩阵位置,这个过程一般叫作upsample[16]。

根据以上前向传播与后向传播训练准则,逐层进行训练,对权值系数矩阵和偏置进行更新,损失函数的值逐渐变小,直到完成模型的训练过程。

4 实验与分析

本文实验所采用的数据通过在安静的实验室环境下使用KEMAR人工头设备以及MAudio多路音频采集器采集。采用四通道的双微阵列结构录制,其中使用双微阵列采集的纯净语音数据进行模型训练,实验语音数据共30人进行录制,其中男20人,女10人,每人读取25条不同的语音,每条两遍,共1-500条语句,其中60%作为训练集,20%作為验证集,20%的数据作为测试集,测试集的语音加入不同信噪比的噪声,进行后续处理以验证本文算法以及对比算法的效果。

本文采用的语音特征参数为13维的梅尔频率倒谱系数(Mel Frequency Cepstrum Coefficient, MFCC)及其一阶差分、二阶差分共同组成39维的特征向量,然后拼接当前帧结合前后各5帧的共11帧参数,不足5帧的进行补零,组合好的MFCC参数特征共429维。语音分帧长度为25ms,帧移10ms,预加重系数取0.97。由于每条语音长度不一致,本文实验中的语音时间长度均低于2s,因此假设最多可分为200帧,不足的进行补零,组成200×429的参数矩阵作为网络的输入。将参数进行归一化后,输入到卷积神经网络中进行训练,第一个卷积层采用5×5的卷积核采样窗口,步长为1,32个卷积核抽取特征,把输入和权值向量进行卷积,再加上偏置值,然后输入到激活函数为Leaky_relu函数的激活层;池化层采用2×2大小的最大池化,步长为2,提取对应窗口的最大值;第二个卷积层采用5×5的卷积核采样窗口,64个卷积核抽取特征,同样进行最大池化。最后把池化层2的输出扁平化为1维,有序连接成一个向量作为第一个全连接层的输入,同时,为了防止过拟合引入dropout机制,在不同的训练过程中随机丢弃一部分神经元,提升模型的泛化能力[17]。全连接层的节点数为1-024个节点,本文初始权值系数和偏置系数均采用截断正态分布随机数truncated_normal,该函数具有截断功能,可以生成相对比较温和的初始值。优化函数使用Adam,使用交叉熵损失函数,初始学习率为0.000-1,语音标签信息采用onehot编码,训练时一次取10条数据进行训练。

驗证本文算法对提升噪声环境下语音识别稳健性的可行性,采用三种噪声作对比实验,分别为Noisex92噪声库中的F16噪声、volvo噪声和babble噪声,信噪比分别为-5dB、0dB、5dB、10dB,并且进行同种条件下的对比实验,分别采用广义旁瓣抵消(Generalized Sidelobe Canceller,GSC),文献[18]中的最小方差无畸变响应波束形成后置改进维纳滤波算法(Minimum Variance Distortionless Response combined with Modify Wiener Filter,MVDRMWF)[18]和本文算法。图4为F16噪声环境,信噪比为0dB时,对一段语音采用本文以及对比算法进行实验得到的语音时域波形仿真。

由图4可以看出,本文算法应用在语音识别系统前,对含噪语音实现了较好的去噪效果,有效抑制了噪声对语音信息的损坏,主要因为本文算法可以充分利用麦克风阵列的方位信息,并且调制域谱减法将幅度谱补偿从频域转移到调制域减少语音畸变的产生,取得了较好的降噪效果。而对比算法的去噪效果并不明显,并且有较多的毛刺存在,经过试听可以听到明显的语音畸变。

为对比本文采用的递归求逆运算在减少算法计算复杂度方面的优劣,在Matlab 2014实验环境下采用一段不同噪声环境下的信噪比为0dB的含噪语音进行处理的运行时间对比,对比算法分别为传统MVDR算法以及本文基于递归矩阵求逆与对角加载的改进算法,运行时间情况如表1所示。可以明显看出,本文的改进MVDR波束形成算法相比传统的MVDR算法的运算时间较短,大幅降低了运算复杂度。

为了验证本文算法对噪声环境下语音识别的效果,采用上述三种算法以及不对含噪语音进行任何处理做对比实验,分别得到在F16噪声、volvo噪声、babble噪声环境下经不同算法处理后语音的识别率,如表2~4所示。

由表2~4的语音识别对比实验结果可以看出,本文算法对噪声环境下的语音识别率得到了明显的提升,相对于未经处理的含噪语音,经麦克风阵列算法处理后,在CNN模型上,语音识别率得到了明显的改善,在信噪比为10dB的F16噪声环境下语音识别率达到了92.3%,相对于对比算法和不做处理时的识别率有较大的提升,说明本文在语音识别系统前端使用双微阵列的结构进行消噪处理,来提高语音识别率的方法是切实可行的。另外,卷积神经网络的方法具有独特的优势,主要是CNN担任了特征提取器的角色,可以提取语音深层次的特征,而采用拼帧操作也较好地利用了语音信号的长时相关性。

5 结语

本文针对传统波束形成算法难以处理空间噪声问题,提出了一种改进的最小方差无畸变响应波束形成方法,并通过后置调制域谱减法对语音进一步进行处理,获得了较好的降噪效果,另外,本文采用卷积神经网络训练语音模型,实验结果表明,取得了优于对比算法的识别效果,在噪声环境下具有良好的稳健性。

在下一步的研究工作中,鉴于深度学习在语音识别领域的广泛应用,将在语音模型训练优化方面进行进一步研究,以提升噪声环境下语音识别的稳健性。

参考文献 (References)

[1] 韩纪庆, 张磊, 郑铁然. 语音信号处理[M]. 北京:清华大学出版社,2004: 1-4.(HAN J Q, ZHANG L, ZHENG T R. Speech Signal Processing[M].Beijing: Tsinghua University Press,2004: 1-4.)

[2] 宋知用. Matlab在语音信号分析与合成中的应用[M].北京: 北京航空航天大学出版社, 2013: 176-199.(SONG Z Y. Application of Matlab in Speech Signal Analysis and Synthesis[M]. Beijing: Beihang University Press, 2013: 176-199.)

[3] ZHANG X, WANG Z, WANG D. A speech enhancement algorithm by iterating single and multimicrophone processing and its application to robust ASR[C]// Proceedings of the 2017 IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway: IEEE, 2017:276-280.

[4] HIGUCHI T, ITO N, ARAKI S, et al. Online MVDR beamformer based on complex Gaussian mixture model with spatial prior for noise robust ASR[J]. IEEE/ACM Transactions on Audio Speech and Language Processing, 2017, 25(4):780-793.

[5] PFEIFENBERGER L, SCHRANK T, ZHRER M, et al. Multichannel speech processing architectures for noise robust speech recognition: 3rd CHiME challenge results [C]// Proceedings of the 2015 IEEE Workshop on Automatic Speech Recognition and Understanding. Piscataway: IEEE, 2016: 1-7.

[18] 馬金龙,曾庆宁, 龙超,等. 多噪声环境下可懂度提升的助听器语音增强[J].计算机工程与设计, 2016, 37(8):2160-2164.(MA J L, ZENG Q N, LONG C, et al. Intelligibility improved speech enhancement for hearing aids in complex noise environment [J].Computer Engineering and Design, 2016, 37(8):2160-2164.)

This work is partially supported by the National Natural Science Foundation of China (61461011), the State Key Program of National Nature Science of Guangxi Zhuang Autonomous Region (2016GXNSFDA380018), the Director Fund of Key Laboratory of Cognitive Radio and Information Processing of Ministry of Education (CRKL160107, CRKL170108).

LIU Weibo, born in 1991, M. S. candidate. His research interests include speech recognition.

ZENG Qingning, born in 1963, Ph. D., professor. His research interests include speech signal processing, image processing.

BU Yuting, born in 1995, M. S. candidate. Her research interests include speech signal processing.

ZHENG Zhanheng, born in 1978, M. S., senior experimentalist. His research interests include speech signal processing.